2018年8月4月,北京理工大學(xué)大數(shù)據(jù)創(chuàng)新學(xué)習(xí)中心與中國(guó)科學(xué)院人工智能聯(lián)盟標(biāo)準(zhǔn)組聯(lián)合主辦了為期一天的專家講座活動(dòng)------“2018深度強(qiáng)化學(xué)習(xí):理論與應(yīng)用”學(xué)術(shù)研討會(huì)。活動(dòng)現(xiàn)場(chǎng)參與人數(shù)超過(guò)600人,在線同步觀看人數(shù)超過(guò)12萬(wàn)人。學(xué)界與業(yè)界專家齊聚一堂,共同分享學(xué)習(xí)深度強(qiáng)化學(xué)習(xí)領(lǐng)域的最新研究成果。本文小編親臨現(xiàn)場(chǎng),為您揭秘深度強(qiáng)化學(xué)習(xí)在自動(dòng)駕駛技術(shù)中的應(yīng)用詳細(xì)報(bào)告。

楊明珠 大連交通大學(xué)

今天我的演講內(nèi)容主要分為四個(gè)部分:深度強(qiáng)化學(xué)習(xí)的理論、自動(dòng)駕駛技術(shù)的現(xiàn)狀以及問(wèn)題、深度強(qiáng)化學(xué)習(xí)在自動(dòng)駕駛技術(shù)當(dāng)中的應(yīng)用及基于深度強(qiáng)化學(xué)習(xí)的禮讓自動(dòng)駕駛研究。

首先是深度強(qiáng)化學(xué)習(xí)的理論,DQN做了深度的拓展,在離散型動(dòng)作中應(yīng)用效果比較好,但連續(xù)性動(dòng)作當(dāng)中表現(xiàn)效果并不好,所以做了一些改進(jìn)和發(fā)展,如Double DQN等。

在連續(xù)型動(dòng)作之中我個(gè)人比較喜歡DDPG的理念,原因有兩點(diǎn):①之前學(xué)習(xí)到的經(jīng)驗(yàn)和Policy數(shù)據(jù)放到Replaybuffer當(dāng)中,若之后的行為當(dāng)中發(fā)現(xiàn)和之前相似的地方就會(huì)直接從Replaybuffer當(dāng)中把之前的經(jīng)驗(yàn)和數(shù)據(jù)直接調(diào)用出來(lái),這樣就可以避免在重復(fù)進(jìn)行一種訓(xùn)練或者采集的方式,節(jié)省時(shí)間、提高效率;②信任域的策略優(yōu)化,簡(jiǎn)稱TRPO,其實(shí)是對(duì)之前的算法做了改進(jìn),如對(duì)狀態(tài)分布進(jìn)行處理,利用重要性采樣對(duì)動(dòng)作分布進(jìn)行的處理及在約束條件當(dāng)中,把平均KL散度代替最大KL散度。

PPO也是最近比較熱門(mén)的一種深度強(qiáng)化學(xué)習(xí)算法,分為N個(gè)Actor,同時(shí)進(jìn)行一些工作,這樣平均分配給很多個(gè)actor,合作來(lái)做的話效率會(huì)更高,而且會(huì)節(jié)省更多的時(shí)間。HER算法也是個(gè)人最喜歡的之前經(jīng)過(guò)所有訓(xùn)練,經(jīng)驗(yàn)總結(jié)出來(lái),這個(gè)工作結(jié)束以后全部消化一遍,然后做第二次實(shí)驗(yàn)或者工作的時(shí)候吸取了前面的經(jīng)驗(yàn),然后再進(jìn)行下面的訓(xùn)練或者工作的話,就會(huì)避免一些錯(cuò)誤,如無(wú)人駕駛撞車(chē)了,上次為什么撞車(chē)了呢?第二次需要避免這個(gè)錯(cuò)誤,即不讓它撞車(chē)。

自動(dòng)駕駛公司分為互聯(lián)網(wǎng)公司(如Google、百度、蘋(píng)果和Uber)及傳統(tǒng)車(chē)企(如福特和汽車(chē)配件的博世、大眾、通用、寶馬和奔馳等)。目前自動(dòng)駕駛技術(shù)有三個(gè)問(wèn)題:①感知方面也可以叫做信息的預(yù)處理,主要包括對(duì)圖像或者視頻信息的分割、檢測(cè)或者識(shí)別,如果識(shí)別的準(zhǔn)確率更高可能會(huì)對(duì)之后的決策有比較好的優(yōu)勢(shì)。運(yùn)行當(dāng)中也需要用到分割工作,如沿著車(chē)線走需要分割車(chē)線位置等。②決策方面其實(shí)是為了模仿人類(lèi),所以需要經(jīng)過(guò)很多訓(xùn)練,利用強(qiáng)化學(xué)習(xí)來(lái)做自動(dòng)駕駛即像人考駕照的過(guò)程,學(xué)習(xí)怎樣開(kāi)車(chē),最后達(dá)到上路的水平。③控制方面就是故障安全機(jī)制,遇到危險(xiǎn)的情況下來(lái)不及反應(yīng),就需要安全機(jī)制保障車(chē)內(nèi)的人身安全,我們做自動(dòng)駕駛也就是為了減少交通事故的發(fā)生率,讓更多的人可以安安全全地坐上自動(dòng)駕駛汽車(chē)。

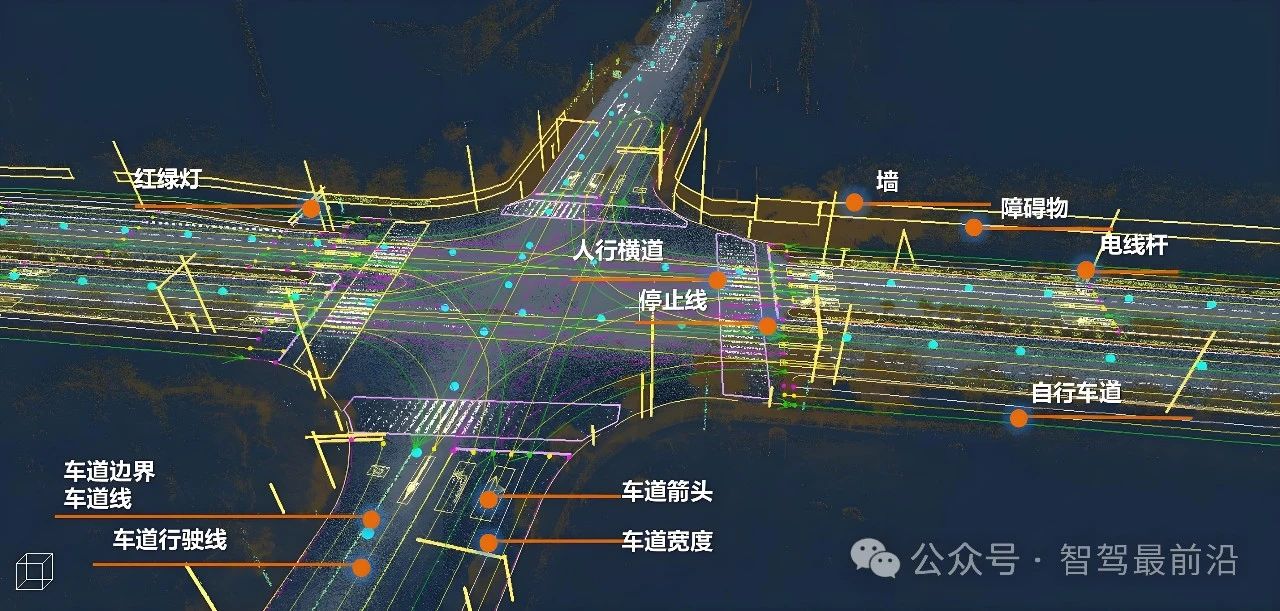

現(xiàn)在解決自動(dòng)駕駛技術(shù)問(wèn)題有兩種方法:一種是低精度定位+低精度地圖+高準(zhǔn)確識(shí)別率,另一種是高精度定位+高精度地圖+更準(zhǔn)確的識(shí)別率。

百度是有采集信息的車(chē)輛,其實(shí)也是比較辛苦的,需要采集所有全景的圖像來(lái)做上傳,最后再和百度地圖結(jié)合,這樣才能制定比較好的高精度地圖,這樣成本會(huì)非常的高。

關(guān)于深度強(qiáng)化學(xué)習(xí)在自動(dòng)駕駛當(dāng)中的應(yīng)用,有幾個(gè)團(tuán)隊(duì):WAYVE團(tuán)隊(duì)、本田研究院團(tuán)隊(duì)、堪薩斯州立大學(xué)團(tuán)隊(duì)、韓國(guó)漢陽(yáng)大學(xué)團(tuán)隊(duì)。Wayve是我個(gè)人比較欣賞的團(tuán)隊(duì),是由英國(guó)劍橋的博士畢業(yè)生創(chuàng)立的自動(dòng)駕駛。

Wayve在今年7月發(fā)布的文章是《Learning to Drive in a Day》,僅僅用了一個(gè)前景攝像頭,就是車(chē)前方的視頻作為輸入的State,輸出的Action就是保證在同一車(chē)道內(nèi)行進(jìn)距離,行駛距離長(zhǎng),reward就大;行駛距離短,reward就短。結(jié)果是只用了單個(gè)攝像頭讓自動(dòng)駕駛汽車(chē)在三十分鐘內(nèi)學(xué)會(huì)了保持在同一車(chē)道內(nèi)行駛二百五十米距離。這樣的方式我們是比較欣賞,但不太建議使用這種僅僅基于視覺(jué)的方式來(lái)做自動(dòng)駕駛,因?yàn)殚_(kāi)車(chē)肯定是眼觀六路耳聽(tīng)八方,側(cè)面或者后面出現(xiàn)任何問(wèn)題沒(méi)有辦法及時(shí)預(yù)警,沒(méi)有辦法及時(shí)處理,將來(lái)在上路的問(wèn)題上肯定是有很大的缺陷。

賓夕法尼亞大學(xué),本田研究院和喬治亞理工學(xué)院合作團(tuán)隊(duì)是采用TTC模式,能夠提前知道岔路口的狀態(tài),如何通過(guò)岔路口并且預(yù)測(cè)到達(dá)這個(gè)岔路口的時(shí)間是不是有危險(xiǎn),有沒(méi)有足夠的時(shí)間進(jìn)行制動(dòng),TTC一般都是二點(diǎn)七秒,那個(gè),該團(tuán)隊(duì)存在的缺陷因?yàn)榫褪荄QN存在的問(wèn)題,即在離散動(dòng)作當(dāng)中表現(xiàn)優(yōu)異,在連續(xù)性動(dòng)作中表現(xiàn)不好,如果是在高速行駛的情況下如何應(yīng)用,解決得并不是太好。

如何在對(duì)抗性極強(qiáng)的情況下,對(duì)碰撞避免機(jī)制的行為進(jìn)行訓(xùn)練,使系統(tǒng)進(jìn)入不安全預(yù)警狀態(tài),堪薩斯州立大學(xué)團(tuán)隊(duì)提出了一種基于深度強(qiáng)化學(xué)習(xí)的新框架,用于對(duì)自動(dòng)駕駛汽車(chē)的碰撞避免機(jī)制的行為進(jìn)行基準(zhǔn)測(cè)試,但是有一個(gè)缺點(diǎn):無(wú)感知單元的預(yù)處理過(guò)程,并且沒(méi)有在連續(xù)性動(dòng)作的決策任務(wù)。

我們將這些思想做了融合,提出了我們的一種新的自動(dòng)駕駛技術(shù),就是禮讓自動(dòng)駕駛。我們的禮讓自動(dòng)駕駛也是從三個(gè)方面來(lái)說(shuō):感知、決策和控制單元。什么叫做禮讓,包括”安全行車(chē)、禮讓三先”:先讓,先慢,先停,我不去撞別人,別人撞我的時(shí)候要先避讓一下,避免發(fā)生撞擊的情況。

感知部分是圍繞檢測(cè)、識(shí)別和圖像分割等方面,檢測(cè)當(dāng)中我們用的最多的是YOLO算法,如果車(chē)速特別快的話也需要快速的檢測(cè),然后再去做一些決策方面的,識(shí)別方面?zhèn)€人比較喜歡VCG模型,模型結(jié)構(gòu)簡(jiǎn)單而且,識(shí)別效果也是比較不錯(cuò)的。分割當(dāng)中有局部分割、語(yǔ)義分割和全景分割,現(xiàn)在應(yīng)用最多的是語(yǔ)義分割和全景分割。感知模塊我們借鑒AndreasGeiger的思想,將地圖、三維傳感器、二維傳感器中的信息給到“世界模型”(world model),我們把感知部分所有信息匯總到一個(gè)地圖當(dāng)中,做成一個(gè)Map,相當(dāng)于解除了我們對(duì)于高精度地圖的高度依賴感,同時(shí)可以理解每個(gè)時(shí)刻的不同物體,相對(duì)于地面和道路這些位置,并且可以做之后的預(yù)測(cè),相當(dāng)于之后的路徑規(guī)劃問(wèn)題。

我們采用DDPG算法改進(jìn)自動(dòng)駕駛決策的部分,同時(shí)加入禮讓的駕駛概念,就是我們?cè)谟龅絾?wèn)題的時(shí)候要首先想到先做避讓,也就是主動(dòng)避讓的情況,連續(xù)動(dòng)態(tài)的情況下可以讓自動(dòng)駕駛汽車(chē)避免發(fā)生碰撞。

那么“禮讓”這一詞最早起源于機(jī)器人,但機(jī)器人的速度會(huì)比較慢,如果轉(zhuǎn)移到車(chē)輛方面其實(shí)還是有些難度的,而且高速當(dāng)中的禮讓?xiě)?yīng)該還是比較困難的問(wèn)題,所以這也是我們?nèi)蘸蠊ぷ鞯碾y點(diǎn)。決策方面我們可能會(huì)結(jié)合PPO與HER的思想,個(gè)人比較喜歡這兩種算法,所以會(huì)結(jié)合在里面,自動(dòng)駕駛在高速運(yùn)行的情況下也會(huì)需要一個(gè)快速?zèng)Q策的過(guò)程,所以選用PPO算法使得速度能夠提升。

駕駛一段時(shí)間以后我們會(huì)在第二次自動(dòng)駕駛的時(shí)候總結(jié)第一次的經(jīng)驗(yàn),因?yàn)槿硕际窃诮?jīng)驗(yàn)當(dāng)中不斷積累,日后才能達(dá)到會(huì)開(kāi)車(chē)的水平,所以我們也在說(shuō)學(xué)習(xí)駕車(chē)的思想,然后通過(guò)HER促進(jìn)自動(dòng)駕駛車(chē)輛,總結(jié)之前的經(jīng)驗(yàn),使其在之后的駕駛過(guò)程當(dāng)中少犯錯(cuò)誤,盡量避免發(fā)生不必要的危險(xiǎn)。決策的過(guò)程當(dāng)中個(gè)人還是比較喜歡Actor-Critic機(jī)制,通用reply buffer是我們對(duì)之前駕駛的經(jīng)驗(yàn)和其所得到的Policy的存儲(chǔ)過(guò)程,之后的駕駛?cè)蝿?wù)當(dāng)中遇到類(lèi)似的問(wèn)題直接可以采用這種經(jīng)驗(yàn),不需要再做其它的改變或者訓(xùn)練。

控制方面主要還是RSS模型上面做出一些改進(jìn),因?yàn)椴豢赡苤皇顷P(guān)注到前方的避讓或者碰撞,也要關(guān)注后方,別人撞你的時(shí)候應(yīng)該怎么辦,所以采用的是雙保險(xiǎn)的機(jī)制,為了保證自動(dòng)駕駛汽車(chē)的安全。當(dāng)然如果傳感器檢測(cè)到有危險(xiǎn),或者是距離太近的情況下,自動(dòng)駕駛汽車(chē)會(huì)直接進(jìn)入安全機(jī)制,或者是作出禮讓的行為,因?yàn)槲覀冐灤┦冀K的都是禮讓自動(dòng)駕駛。

仿真平臺(tái)TORCS屬于3D賽車(chē)模擬游戲,個(gè)人比較喜歡通過(guò)這個(gè)來(lái)玩賽車(chē)游戲,做的效果是很好的,而且是世界通用的賽車(chē)游戲,也是相對(duì)有說(shuō)服力,效果會(huì)比較好一點(diǎn),但是場(chǎng)景單一,不適合在復(fù)雜場(chǎng)景下做訓(xùn)練。

結(jié)論與展望:DQN出現(xiàn)最早,改良版本最多,離散情況效果最佳,原理相對(duì)較簡(jiǎn)單,易于掌握與入門(mén)。DDPG是在DQN的基礎(chǔ)上進(jìn)行改良,原理易懂,在連續(xù)動(dòng)作中表現(xiàn)優(yōu)異,適用于自動(dòng)駕系統(tǒng)的決策研究。之后出現(xiàn)的A3C、PPO、HER等算法在連續(xù)動(dòng)作中都有很好的應(yīng)用與體現(xiàn)。目前,有很多人在將分層強(qiáng)化學(xué)習(xí)和逆向強(qiáng)化學(xué)習(xí)(模仿學(xué)習(xí))應(yīng)用于自動(dòng)駕駛技術(shù)當(dāng)中,效果有待考究實(shí)驗(yàn)。

實(shí)際上,基于時(shí)間空間的博弈動(dòng)力學(xué)研究表明,機(jī)器人在目前的實(shí)驗(yàn)與發(fā)展?fàn)顟B(tài)下不具備倫理判斷能力與決策功能。所以,將機(jī)器人置于倫理困境是超出了機(jī)器人研究的能力范圍。德國(guó)聯(lián)邦交通和數(shù)字基礎(chǔ)設(shè)施部委員會(huì)說(shuō)過(guò),自動(dòng)駕駛系統(tǒng)需要更好地適應(yīng)人之間的交流,也就是讓車(chē)輛或者機(jī)器適應(yīng)我們的生活節(jié)奏,不是我們?nèi)巳ミm應(yīng)機(jī)器應(yīng)該怎么做,或者是機(jī)器人之間的交流,總體來(lái)說(shuō)就是以人為主,包括之后發(fā)生不可避免事故的時(shí)候主動(dòng)的決定權(quán),包括最終行為的決定權(quán),必須要?dú)w人來(lái)掌握,尤其是必須歸駕駛員掌握。吳焦蘇老師的一句話讓我印象深刻:“自動(dòng)駕駛系統(tǒng)的安全性不能得到嚴(yán)格保證之前不應(yīng)當(dāng)被批準(zhǔn)量產(chǎn)”。其實(shí)這也是對(duì)我們生命的負(fù)責(zé)任,因?yàn)槿绻詣?dòng)駕駛車(chē)輛不能保證百分之百不發(fā)生事故,或者不能保證百分之百不會(huì)撞擊的話就不能上路,因?yàn)槲覀円獙?duì)自己的生命負(fù)責(zé),也要對(duì)他人生命負(fù)責(zé)。

-

自動(dòng)駕駛

+關(guān)注

關(guān)注

790文章

14339瀏覽量

170858 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5562瀏覽量

122854

原文標(biāo)題:深度強(qiáng)化學(xué)習(xí)在自動(dòng)駕駛技術(shù)中的應(yīng)用——楊明珠

文章出處:【微信號(hào):IV_Technology,微信公眾號(hào):智車(chē)科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

低速自動(dòng)駕駛與乘用車(chē)自動(dòng)駕駛在技術(shù)要求上有何不同?

卡車(chē)、礦車(chē)的自動(dòng)駕駛和乘用車(chē)的自動(dòng)駕駛在技術(shù)要求上有何不同?

新能源車(chē)軟件單元測(cè)試深度解析:自動(dòng)駕駛系統(tǒng)視角

AI將如何改變自動(dòng)駕駛?

自動(dòng)駕駛大模型中常提的Token是個(gè)啥?對(duì)自動(dòng)駕駛有何影響?

AI自動(dòng)化生產(chǎn):深度學(xué)習(xí)在質(zhì)量控制中的應(yīng)用

從《自動(dòng)駕駛地圖數(shù)據(jù)規(guī)范》聊高精地圖在自動(dòng)駕駛中的重要性

MEMS技術(shù)在自動(dòng)駕駛汽車(chē)中的應(yīng)用

GPU深度學(xué)習(xí)應(yīng)用案例

人工智能的應(yīng)用領(lǐng)域有自動(dòng)駕駛嗎

自動(dòng)駕駛HiL測(cè)試方案案例分析--ADS HiL測(cè)試系統(tǒng)#ADAS #自動(dòng)駕駛 #VTHiL

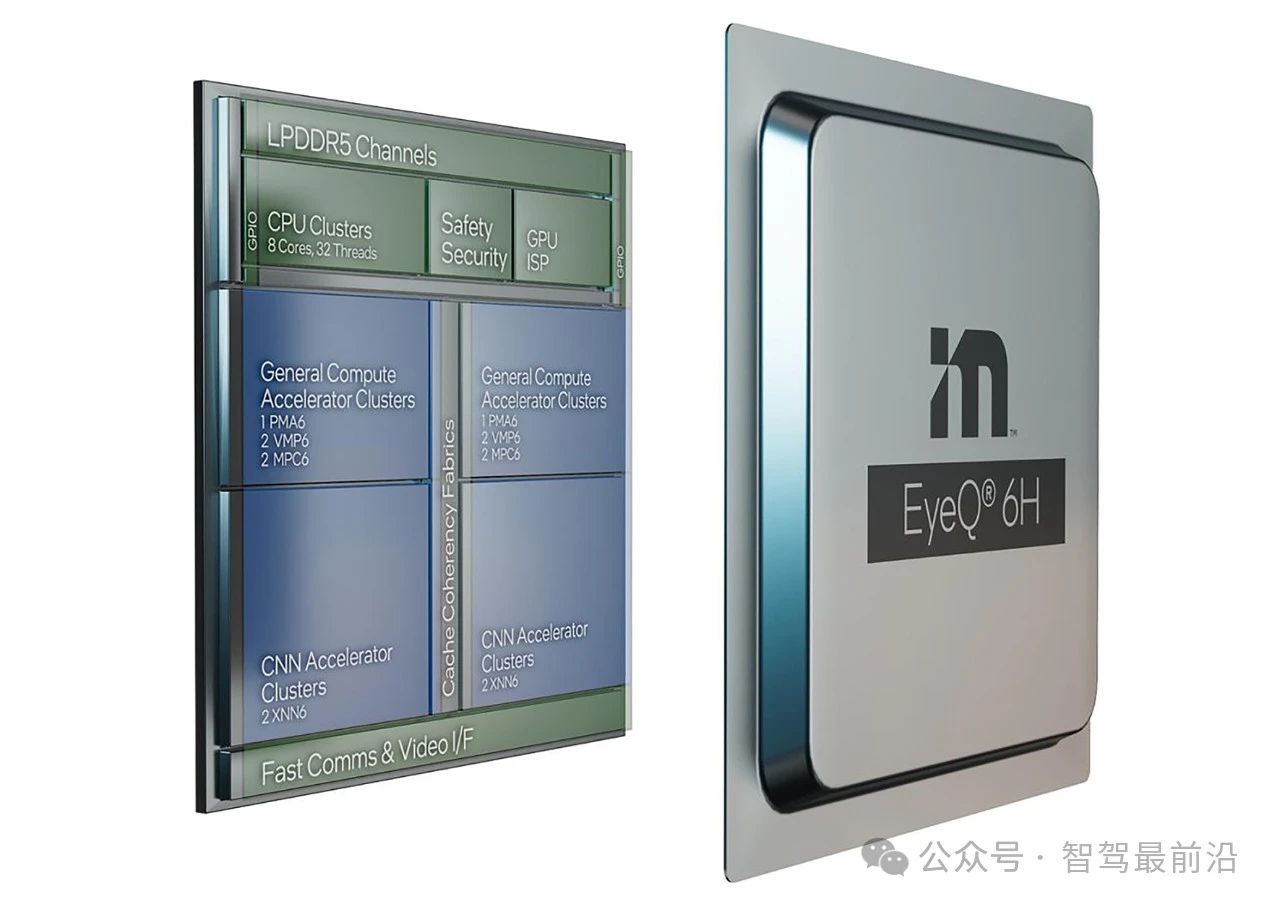

Mobileye端到端自動(dòng)駕駛解決方案的深度解析

評(píng)論