目前CPU的速度已經很快了,但是我們近年來面臨的一個大問題是想辦法最大限度地減少等待時間,快速獲取結果,從而使系統整體效率保持在最佳水平。最近的熔斷和幽靈漏洞不僅帶來了很多安全問題,從另一方面,它們也暴露了現代CPU的工作原理、優化程度以及數據損耗問題。

傳統的通過CPU優化數據流的方法已經達到了極限,目前大家開始將方向轉移到用存儲平臺運行某些計算任務。

將數據和CPU緊密結合

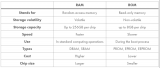

多年來,由于技術發展的限制,存儲行業只能通過緩存和自動分層來加速存儲訪問。不過這種辦法是在成本和效率之間的折中,延遲和吞吐量并不能完全滿足CPU、RAM和網絡的需求。

閃存改變了這一狀況,其延遲、吞吐量和IOPS都不是問題,閃存的出現讓數據比以往任何時候都要接近CPU。如:NVMe消除了傳統接口的復雜性和局限性,現在則可以將存儲設備直接連接到服務器的PCIe總線。

最近,隨著新型存儲設備的引入,延遲大幅降低,已經可以滿足CPU對延遲的要求。但是問題解決了嗎?并不完全是。

現在我們面臨的問題是數據大量增加,并且增長速度極快,數據在大型共享設備之間進行傳輸的時候產生了新的瓶頸,如網絡帶寬。當硬件出現故障時更會引發一系列別的問題。目前廣泛使用的仍然是橫向擴展架構,這種架構增加了延遲,并且使數據遷移變得更加復雜,成本更高。

讓CPU更接近數據

之前就有人提出將CPU任務卸載到存儲基礎架構這一概念,自從RAID控制器及其提供的數據服務興起依賴,這一概念更是得到了廣泛應用。例如卷克隆之類的功能都是通過在陣列內部復制數據來消除服務器和存儲陣列之間的流量。

現在芯片技術發展很快,通過在設備上執行一些過去在CPU上執行的一些計算任務可以減少數據遷移,節省帶寬,提高整體并行性從而提高整個系統的效率。

我們無法將最新的Intel X86 CPU和小型雙核ARM設備進行比較,但是我們可以擁有數十個小的CPU,通過足夠的RAM和連接讓他們執行許多簡單的任務。由存儲設備執行的這些操作可以將數據保持在本地,將延遲降到最低,同時可以提高整體并行性和系統效率。另外由于故障域較小,可以提高整個基礎架構的可擴展性。

OpenIO是一家計算存儲公司,它們把開源軟件運行在標準的硬件上,已經在計算存儲方面取得了巨大進展,nano-node就是一個例子。

最近,OpenIO正在與硬件公司合作,工作成果很快就可以展示出來。目前一些初創公司已經在設計旨在加速特定工作負載的計算存儲設備,不過這只是一個開始。這方面的明星創業公司包括ScaleFlux和NGD System。

Serverless成為計算存儲的關鍵

為了使計算存儲能夠廣泛使用,我們必須將它簡單化。目前最簡單的編程模型就是Serverless計算。

其函數是一小段代碼,它的運行時間很短,通常由事件觸發。它們通常對底層硬件一無所知。另外對象存儲非常適合Serverless計算。如果有支持KV存儲的SSD,就更方便了。

計算存儲的過程非常簡單。設備讀取或刪除的每個數據位都可以創建可觸發功能的事件。功能暫時存在于緩存容器中,并執行簡單的任務,如檢查數據的有效性,過濾不必要的信息,掃描特定的模式,甚至進行更復雜的操作,如圖像識別,視頻采樣等。應用程序范圍很廣,這樣就可以通過隱藏基礎架構的復雜性來解決可伸縮性問題。

開發人員只需編寫于特定文件類型、事件或操作相關聯的幾行代碼即可,存儲結構件在有需要時部署此代碼完成相應的工作。

讓CPU接近數據和讓數據接近CPU還是有很大不同的。

未來已來

目前這些設備已經可以投入使用,而且這些強大的開發軟件是開源的。

我們堅信對象存儲和Serverless計算的結合是對可擴展性,性能優化和效率問題的最好解決方案。對象存儲帶來了可靠的分布式存儲層,Serverless計算以輕量級和超級擴展的方式在本地對數據進行操作,這不止是超融合(hyperconvergence)。

可惜的是上述模型僅僅適用于非結構化數據,不過一些初創公司已經采取類似的方法在具有嵌入式計算功能的主板設備上進行計算工作。

閉環操作

計算存儲還沒有被廣泛使用,目前它只被應用于大規模基礎設施中。但是相關應用程序的數量正在迅速增長。如工業物聯網和邊緣計算需要簡單但功能強大的基礎設施,同時必須具有持久、可靠的傳感器數據存儲,還需要CPU來驗證數據,對其進行優化,同時決定應將那些內容發送到用于長期存儲,大數據分析或其他操作的云。

在不久的將來,隨著價格的降低和閃存技術的成熟,相信我們會看到越來越多的計算存儲設備和無服務器框架,納米節點、微服務器和專用PCIe卡只是一個開始。

-

cpu

+關注

關注

68文章

10855瀏覽量

211608 -

數據

+關注

關注

8文章

7006瀏覽量

88955 -

serverless

+關注

關注

0文章

65瀏覽量

4508

原文標題:把CPU放到存儲中:提升計算存儲性能

文章出處:【微信號:SSDFans,微信公眾號:SSDFans】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

一文詳解計算型存儲協議框架

華為云全域 Serverless 8 月更新盤點

內存、存儲系統和CPU的區別

EEPROM存儲器:實現數據持久化存儲的關鍵組件

佰維存儲賦能企業級SSD RAID應用,助力數據中心強化效能與安全

華為云 Serverless 應用中心:一鍵開啟 AI 文生圖新時代,引領行業創新浪潮

S7-1200 CPU 存儲卡的應用分析

鴻蒙原生應用元服務實戰-Serverless華為賬戶認證登錄需盡快適配

鴻蒙應用/元服務開發實戰-Serverless云存儲沒法創建處理方式

ram中存儲的數據在斷電后是否會丟失?

九種計算機存儲的類型及工作原理

讓CPU更接近數據 Serverless成為計算存儲的關鍵

讓CPU更接近數據 Serverless成為計算存儲的關鍵

評論