1.問題

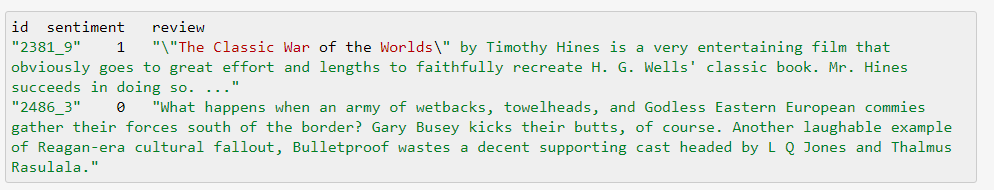

Kaggle競賽Bag of Words Meets Bags of Popcorn是電影評論(review)的情感分析,可以視作為短文本的二分類問題(正向、負向)。標注數據集長這樣:

評價指標是AUC。因此,在測試數據集上應該給出概率而不是類別;即為predict_proba而不是predict:

# random frorest result = forest.predict_proba(test_data_features)[:, 1] # not `predict` result = forest.predict(test_data_features)

采用BoW特征、RF (random forest)分類器,預測類別的AUC為0.84436,預測概率的AUC則為0.92154。

2.分析

傳統方法

傳統方法一般會使用到兩種特征:BoW (bag of words),n-gram。BoW忽略了詞序,只是單純對詞計數;而n-gram則是考慮到了詞序,比如bigram詞對"dog run"、"run dog"是兩個不同的特征。BoW可以用CountVectorizer向量化:

from sklearn.feature_extraction.text import CountVectorizer vectorizer = CountVectorizer(analyzer="word", tokenizer=None, preprocessor=None, stop_words=None, max_features=5000) train_data_features = vectorizer.fit_transform(clean_train_reviews)

在一個句子中,不同的詞重要性是不同的;需要用TFIDF來給詞加權重。n-gram特征則可以用TfidfVectorizer向量化:

from sklearn.feature_extraction.text import TfidfVectorizer vectorizer = TfidfVectorizer(max_features=40000, ngram_range=(1, 3), sublinear_tf=True) train_x = vectorizer.fit_transform(clean_train_reviews)

使用unigram、bigram、trigram特征 + RF分類器,AUC為0.93058;如果改成LR分類器,則AUC為0.96330。

競賽tutorial給出用word2vec詞向量特征來做分類,并兩個生成特征思路:

對每一條評論的所有詞向量求平均,將其平均值作為改評論的特征;

對訓練的詞向量做聚類,然后對評論中的詞類別進行計數,把這種bag-of-centroids作為特征。

把生成這種特征喂給分類器,進行分類。但是,這種方法的AUC不是太理想(在0.91左右)。無論是做平均還是聚類,一方面丟失了詞向量的特征,另一方面忽略了詞序還有詞的重要性。因此,分類效果不如tfidf化的n-gram。

大神Mikolov在推出word2vec之后,又鼓搗出了doc2vec(gensim有實現)。簡單地說,就是可以把一段文本變成一個向量。與word2vec不同的是,參數除了doc對應的詞列表外,還有類別(TaggedDocument)。結果證明doc2vec的效果還不如word2vec生成特征,AUC只有0.87915。

doc2vec = Doc2Vec(sentences, workers=8, size=300, min_count=40, window=10, sample=1e-4)

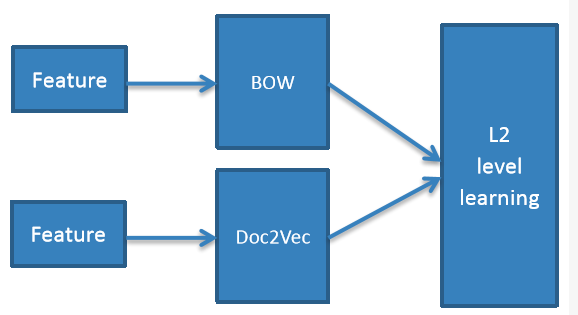

pangolulu嘗試把BoW與doc2vec做ensemble,采用stacking的思路——L1層BoW特征做LR分類、doc2vec特征做RBF-SVM分類,L2層將L1層的預測概率組合成一個新特征,喂給LR分類器;多次迭代后求平均。ensemble結構圖如下:

以上所有方法的AUC對比如下:

3.參考資料:

[1] Zygmunt Z.,Classifying text with bag-of-words: a tutorial.

[2] Michael Czerny,Modern Methods for Sentiment Analysis.

-

深度學習

+關注

關注

73文章

5562瀏覽量

122876

原文標題:【從傳統方法到深度學習】情感分析

文章出處:【微信號:AI_shequ,微信公眾號:人工智能愛好者社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

圖像分類的方法之深度學習與傳統機器學習

基于深度學習的卷積神經網絡模型分析文本的情感傾向

基于CD-RBM深度學習的產品評論情感分析

主題種子詞的情感分析方法

如何使用遷移學習的分層注意力網絡情感分析來算法的詳細資料概述

評論