1介紹

如今,道路上車輛越來越多,道路運輸系統變得越來越繁忙。為了使交通和移動更加智能化和高效,自動駕駛汽車被認為是有前途的解決方案。隨著外部傳感、運動規劃和車輛控制等方面取得顯著的成果,自動駕駛汽車的自主創新能夠很好地幫助車輛在預先設定的場景下獨立運行。

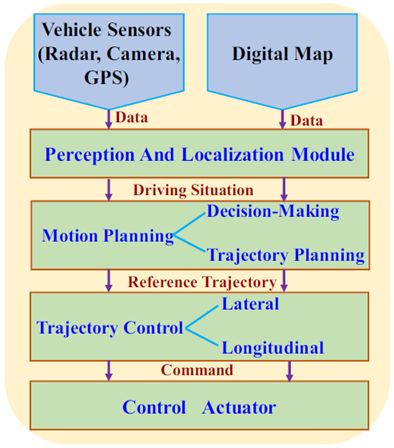

通常,自動駕駛車輛中的系統架構由三個主要處理模塊組成,參見圖1作為圖示[2]。傳感器和數字地圖提供的數據在感知和定位模塊中進行,以呈現駕駛情況的代表性特征;運動規劃模塊旨在根據給定的傳感器和地圖信息生成適當的決策策略并得出最佳軌跡;軌跡控制器模塊的目的是計算處理加速和轉向的具體控制動作,以維持現有的軌跡[ 3 ]。

圖1.通用自動駕駛汽車的系統架構[2]

決策和路徑規劃是自動駕駛汽車的關鍵技術。為了討論軌跡生成步驟,目前已經提出了幾種技術。例如,提出了一種名為“逐個學習”的數據驅動控制框架,用于從歷史駕駛數據中訓練控制器以將車輛作為人類駕駛員來操作。具體來說,人工神經網絡( ANN ) [ 4 ]和逆最優控制[ 5 ]已經被用于再現自動駕駛車輛中的人類駕駛行為。然而,當歷史數據集中沒有當前駕駛情況時,車輛無法平穩運行。作為替代方案,模型預測控制(MPC)[6]用于預測駕駛員行為并在成本函數中實施多個約束,駕駛狀態預測的精度決定了MPC方法的控制性能[7]。自動駕駛和人類駕駛員之間的最大區別是能否確保乘客的安全和舒適。如何創建可行、安全和舒適的參考軌跡仍然是一個嚴峻的挑戰。

在這項工作中,為自動駕駛混合動力電動汽車(HEV)開發了基于強化學習的預測控制框架。提出的方法是雙層的,高層是一個類似人類的駕駛模型,它可以生成約束。底層是基于強化學習( RL )的控制器,能夠提高自動駕駛混合動力汽車的能效。所提出的框架被驗證用于汽車跟隨模型中的縱向控制。結果表明,該方法能夠重現人類駕駛員的駕駛風格,提高燃油經濟性。

這項工作的貢獻包含兩個方面。首先是適應訓練數據集中不存在的當前駕駛情況。提出誘導矩陣范數(IMN)來比較當前和歷史駕駛數據之間的差異并擴展訓練數據集;其次是將軌跡生成步驟與自動駕駛HEV的能量效率改進相結合。基于從高層獲得的參考軌跡,基于RL的控制器在成本函數中實施電池和燃料消耗約束以促進燃料經濟性。

本文的其余部分組織如下,第Ⅱ節介紹了更高級別的驅動程序建模方法,第III節描述了混合動力汽車動力總成的低級RL控制器,第Ⅳ節給出了模擬結果,第V節總結了論文。

2.高層:駕駛員建模

本節展示了高層類人駕駛模型。首先,定義汽車跟隨模型中的參數;然后,介紹了駕駛員模型的訓練方法;最后,描述了未來加速度的預測過程。

A.汽車跟隨模型

在汽車跟隨模型中,自動駕駛HEV被命名為目標車輛,前方自動駕駛HEV被稱為前方車輛。定義δt= [dt,vt]是時刻t的目標車輛的狀態,其中dt和vt分別是縱向位置和速度,類似地,δft= [dft,vft]是在時刻t的前方車輛的狀態,時刻t的行駛狀況由特征ωt= [drt,vrt,vt]表示,其中drt= dft-d是相對距離,vrt= vft-v是相對速度。

在高層上,駕駛員模型旨在生成一個加速度序列At= [ At,…,At + N - 1],以指導目標車輛的運行,N = T /△T表示總時間步長,T是預測的時間間隔,而△T是駕駛員模型的采樣時間。基于該加速序列,基于RL的控制器用于導出底層的自動駕駛HEV的功率分配控制策略。

B.駕駛員模型訓練

基于歷史駕駛數據ω1 : t= [ω1,…,ωt),駕駛員模型的目標是預測接近人類駕駛員實際操作的加速度序列。對于真實的駕駛數據,人類駕駛員的控制策略被建模為隱馬爾科夫鏈( HMC ),其中mt∈{ 1,…M }是用于復制人類駕駛員演示的加速度命令。在時刻t的隱模式,ot= [ωt,at]是時刻t的觀察向量,包括駕駛情況和加速度。

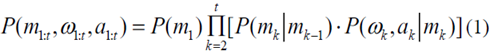

對于HMC,隱藏模式通過概率分布與觀測相關,如下所示

其中假設轉移概率P(ωk,ak| mk)符合高斯分布。特別地,HMC模型的參數包括初始分布P ( m1)、總隱藏模式M、轉移概率πij意味著從第I模式到第j模式的轉移,以及高斯分布的協方差和平均矩陣。期望最大化算法和貝葉斯信息準則被用來從歷史駕駛數據[ 8 ]中學習這些參數。

C.當前加速度的計算

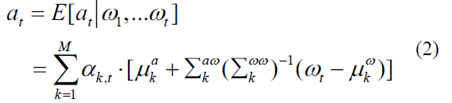

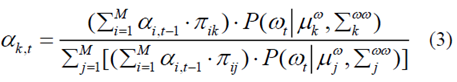

高斯混合回歸用于計算當前加速度,給出行駛情況序列ω1 : t,如下[ 3 ]

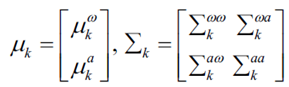

其中

αk,t表示混合系數,并且被計算為處于模式mt= k的概率[3]

D.預測未來加速度

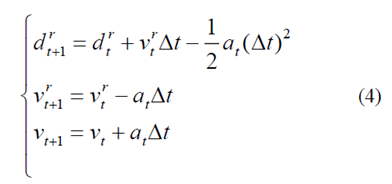

當前的行駛狀況ωt= [drt,vrt,vt],當前的加速度at和離散時間△t是先前已知的,可以通過假設前方車輛的速度恒定來計算未來的行駛狀況。

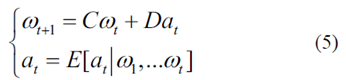

簡單來說,Eq.(4)可以重新表述為狀態空間方程

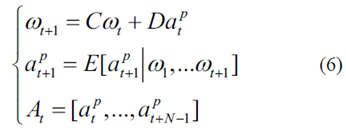

最后,可以通過迭代以下表達式來導出預測范圍T上的未來加速序列

3.底層:RL控制器

本節介紹了基于RL的節油控制器。首先,計算加速度序列的轉移概率矩陣(TPM);然后,提出誘導矩陣范數(IMN)來評估歷史和當前加速度數據之間的差異;此外,制定了自主HEV的能效改進問題的成本函數;最后,構造了RL方法框架,利用Q學習算法搜索最優控制策略。

A.加速序列的TPM

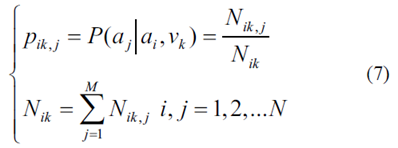

加速序列被視為有限馬爾可夫鏈(MC),其轉移概率通過統計方法計算為

其中Nik,j是從車輛速度vk發生從ai到aj的轉換的次數,Nik是從車速vk的ai開始的總轉換計數,k是離散時間步長,N是離散加速指數。加速序列的TPM P填充有元素pik,j。歷史和當前加速序列的TPM分別表示為P1和P2。

B.誘導矩陣范數

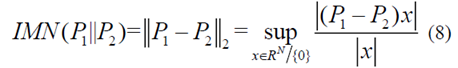

當歷史駕駛數據集不包含當前駕駛情況時,高層的駕駛員模型不能生成有效的加速命令來指導自主HEV的操作。因此,引入誘導矩陣范數(IMN)來量化歷史和當前加速度序列的TPM差異

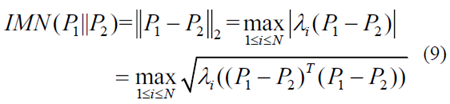

其中sup描繪了標量的上確界,x是N×1維非零矢量。方程式中的二階范數。為了方便計算,可以將(8)重新表述為以下表達式

其中PT表示矩陣P的轉置,并且λi(P)表示對于i = 1,...,N的矩陣P的特征值。注意,IMN越接近零,TPM P1與P2越相似。

C.能源效率的成本函數

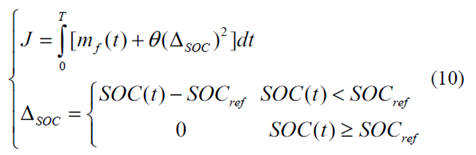

自動駕駛HEV的能效改進的目標是在部件的約束下搜索最優控制,以提高燃料經濟性,同時保持有限預測范圍內的電荷維持約束為

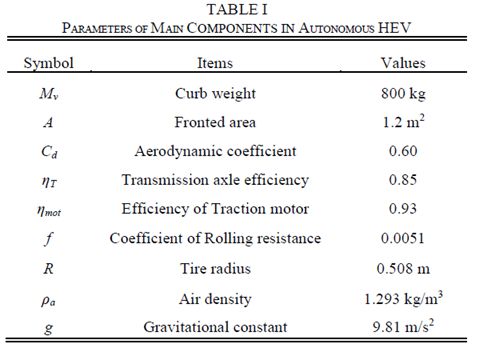

其中mf是燃料消耗率,SOC是電池的充電狀態,θ是限制SOC終端值的大的正加權因子,而SOCref是滿足電荷維持約束的預定因子[9]。表1列出了自動駕駛HEV的主要部件參數。

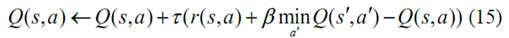

D.RL方法

預測加速度序列和車輛參數的TPM是用于最優控制計算的RL方法的輸入。在RL構造中,學習代理與隨機環境交互。交互被建模為五元組(S,A,P,R,β),其中S和A是狀態變量和控制動作集,P代表功率請求的TPM,R代表獎勵集合,β∈(0,1)表示折扣因子。

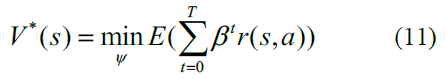

控制策略ψ是控制命令a的分布。有限預期折現和累積獎勵總結為最優值函數

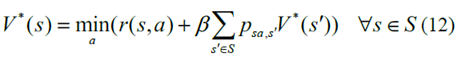

為了在每個時刻推導出最佳控制動作,Eq.(11)遞歸地重新表述為

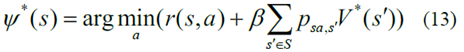

其中psa,s'表示使用動作a從狀態s到狀態s'的轉換概率。基于方程式中的最優值函數確定最優控制策略。(12)

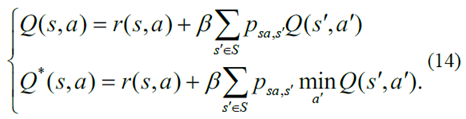

此外,動作值函數及其相應的最優度量描述如下[10]

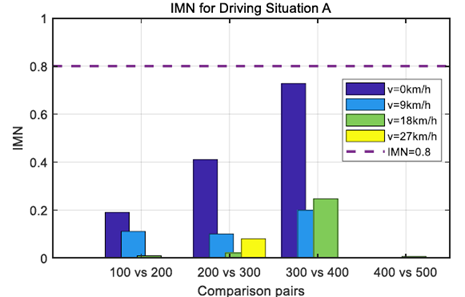

最后,Q學習算法中的動作值函數的更新標準由表示

4.模擬結果與討論

本節將對所提出的基于學習的預測控制框架進行評估。首先,討論了加速序列預測的驅動模型的性能。此外,說明了基于RL的燃料節省策略的控制有效性。

A.驗證駕駛員模型

第II節中描述的駕駛員模型用于預測不同駕駛情況下的加速序列。均方誤差(MSE)用于量化預測加速序列和實際加速序列之間的差異。圖2和圖3示出了兩個實際加速序列及其對于兩個駕駛情況A和B的預測值。對于圖2,假設自主HEV的當前駕駛風格存在于歷史駕駛數據集中。相反,圖3中的當前駕駛風格在訓練數據中不存在。

圖2.情況A的預測和實際加速度序列。

很明顯,加速度序列的預測值非常接近圖2中駕駛情況A的實際值。這表明,當歷史駕駛數據集預先遍歷當前駕駛情況A時,駕駛員模型可以達到極好的精度。然而,當當前駕駛狀況B在訓練數據中缺失時,駕駛員模型不能為自動駕駛HEV操作提供準確的指導,參見圖3作為說明。圖2中的MSE等于1.57,這在預測可用性方面優于圖3中的MSE = 4.43。

圖3.情況b的預測和實際加速度序列

B.RL控制器的驗證

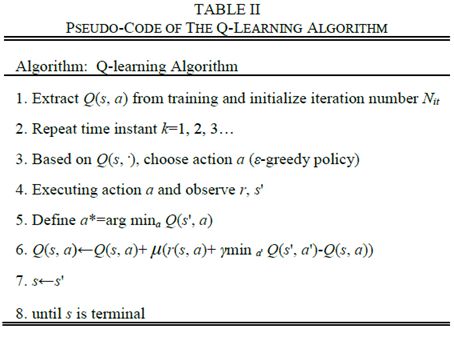

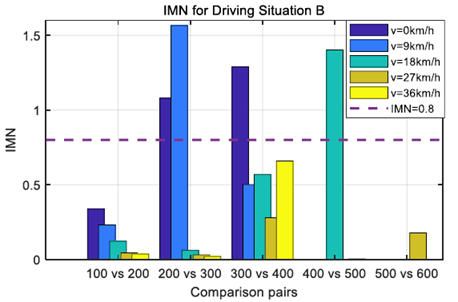

基于歷史和當前加速度序列,第III - A節中描述的TPM的計算過程被用于計算駕駛情況A和b中的加速度TPM。IMN被用于量化這兩個序列之間的差異。因為IMN值超過預定閾值,這意味著當前駕駛情況不同于歷史駕駛數據,因此預測加速度不精確。相反,較小的IMN值意味著從歷史數據中學習的預測加速度序列可能是準確的。

圖4和圖5示出了分別對應于圖2和圖3中的兩種駕駛情況的不同車速水平下的IMN值。這兩個數字表明,IMN值超過預定義閾值的時間不同。為了處理歷史駕駛數據中不存在當前駕駛情況B的情況,當IMN值超過閾值時,該駕駛數據將被添加到訓練數據集中。通過這樣做,歷史駕駛數據集能夠準確預測人類駕駛員在相同駕駛情況下的行為。

圖4.駕駛情況a的不同速度水平下的IMN值

圖5.駕駛情況b的不同速度水平下的IMN值

未來加速序列的精確TPM被進一步用于使用RL技術導出燃料節省控制。圖6描繪了沒有預測加速度信息的公共RL和具有該信息的預測RL的SOC軌跡。注意到在這兩種駕駛情況下,SOC軌跡有很大的不同。這是由未來加速序列的TPM決定的自適應控制造成的。對于駕駛情況B,由于基于IMN值的駕駛數據的擴展過程,預測RL也優于普通RL。

圖6.兩種情況下的共同SOC和預測RL的SOC軌跡

此外,圖7示出了在多個燃料節省控制中發動機的工作區域。與普通RL控制相比,所提出的預測RL控制下的發動機工作區域更頻繁地位于較低燃料消耗區域。這意味著與普通RL技術相比,預測RL方法可以實現更高的燃料經濟性。

圖7.兩種情況下發動機工作點的共性和預測性RL。

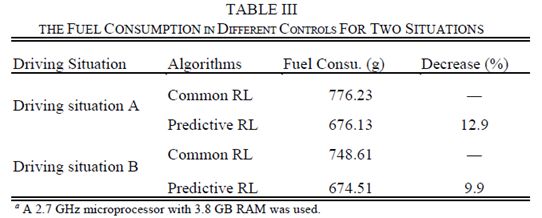

表III描述了在這兩種用于駕駛情況A和b的方法中SOC校正后的燃料消耗。顯然,預測RL控制下的燃料消耗低于普通RL控制下的燃料消耗。預測的加速序列使得基于RL的控制更加適應未來的駕駛情況,這有助于提高燃油經濟性。

5.結論

在本文中,我們通過提出一個基于雙層學習的預測控制框架來尋求自動駕駛混合動力汽車(HEV)能效的提高。高層通過使用隱馬爾可夫鏈和高斯分布來模擬人類駕駛員的行為;底層是基于強化學習的控制器,旨在提高自動駕駛混合動力汽車的能效,所提出的框架被驗證用于汽車跟隨模型中的縱向控制。模擬結果表明,所提出的駕駛員模型能夠利用誘導矩陣范數準確預測未來的加速度序列。試驗還證明,基于未來加速序列TPM的預測RL控制與普通RL控制相比,可以實現更高的燃油經濟性。未來的工作包括將提議的控制框架應用到實時應用中,并使用RL方法制定駕駛員模型來處理換道決策。

-

自動駕駛

+關注

關注

788文章

14007瀏覽量

167745 -

強化學習

+關注

關注

4文章

269瀏覽量

11369

原文標題:基于強化學習的自動駕駛汽車預測控制

文章出處:【微信號:IV_Technology,微信公眾號:智車科技】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

一個使用傳統DAS和深度強化學習融合的自動駕駛框架

FPGA在自動駕駛領域有哪些應用?

自動駕駛的到來

AI/自動駕駛領域的巔峰會議—國際AI自動駕駛高峰論壇

如何讓自動駕駛更加安全?

自動駕駛汽車的處理能力怎么樣?

深度強化學習實戰

深度學習技術的開發與應用

基于強化學習的飛行自動駕駛儀設計

深度學習技術與自動駕駛設計的結合

基于強化學習的自動駕駛預測控制技術

基于強化學習的自動駕駛預測控制技術

評論