UC Berkeley大學(xué)的研究人員們利用深度姿態(tài)估計和深度學(xué)習(xí)技術(shù),讓智能體從單一視頻中學(xué)習(xí)人物動作,并生成近乎相同的結(jié)果。更重要的是,智能體還能將所學(xué)到的技能應(yīng)用于不同環(huán)境中。以下是論智對其博文的編譯。

不論是像洗手這樣日常的動作,還是表演雜技,人類都可以通過觀察學(xué)習(xí)一系列技能。隨著網(wǎng)絡(luò)上越來越多視頻資源的出現(xiàn),想找到自己感興趣的視頻比之前更容易了。在YouTube,每分鐘都有300小時的視頻上傳成功。但是,對于機器來說,從如此大量的視覺數(shù)據(jù)中學(xué)習(xí)技能仍然困難。大多數(shù)動作模仿的學(xué)習(xí)方法都需要有簡潔地表示,例如從動作捕捉獲取的記錄。但想得到動作捕捉的數(shù)據(jù)可能也非常麻煩,需要大量設(shè)備。另外,動作捕捉系統(tǒng)也僅限于遮擋較少的室內(nèi)環(huán)境,所以有很多無法記錄的動作技能。那么,如果智能體可以通過觀看視頻片段來學(xué)習(xí)技能,不是很好嗎?

在這一項目中,我們提出了一種可以從視頻中學(xué)習(xí)技能的框架,通過結(jié)合計算機視覺和強化學(xué)習(xí)中出現(xiàn)的先進(jìn)技術(shù),該框架能讓智能體學(xué)會視頻中出現(xiàn)的全部技能。例如給定一段單目視頻,其中一個人在做側(cè)手翻或后空翻,該系統(tǒng)的智能體就可以學(xué)習(xí)這些動作,并重現(xiàn)出一樣的行為,無需人類對動作進(jìn)行標(biāo)注。

從視頻中學(xué)習(xí)身體動作的技能最近得到很多人的關(guān)注,此前的技術(shù)大多依靠人們手動調(diào)整框架結(jié)構(gòu),對生成的行為有很多限制。所以,這些方法也僅在有限的幾種情境下使用,生成的動作看起來也不太自然。最近,深度學(xué)習(xí)在視覺模擬領(lǐng)域表現(xiàn)出了良好的前景,例如能玩雅達(dá)利游戲,機器人任務(wù)

框架

我們提出的框架包含三個階段:姿態(tài)估計、動作重建和動作模擬。在第一階段,框架首先對輸入的視頻進(jìn)行處理,在每一幀預(yù)測人物動作。第二步,動作重建階段會將預(yù)測出的動作合并成參考動作,并對動作預(yù)測生成的人工痕跡做出修正。最后,參考動作被傳遞到動作模擬階段,其中的模擬人物經(jīng)過訓(xùn)練,可以用強化學(xué)習(xí)模仿動作。

動作估計

給定一段視頻,我們用基于視覺的動作估計器預(yù)測每一幀演員的動作qt。該動作預(yù)測器是建立在人類網(wǎng)格復(fù)原這一工作之上的(akanazawa.github.io/hmr/),它用弱監(jiān)督對抗的方法訓(xùn)練動作估計器,從單目圖像中預(yù)測動作。雖然在訓(xùn)練該估計器的時候需要標(biāo)注動作,不過一旦訓(xùn)練完成,估計器在應(yīng)用到新圖片上時就無需再次訓(xùn)練了。

用于估計人物動作的姿態(tài)估計器

動作重建

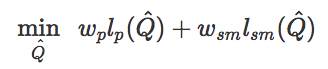

姿態(tài)估計給視頻中的每一幀都做出了單獨的動作預(yù)測,但兩幀之間的預(yù)測可能會出現(xiàn)抖動偽影。另外,雖然近些年基于是覺得姿態(tài)估計器得到了很大進(jìn)步,但有時它們也可能會出現(xiàn)較大失誤。所以,這一步的動作重建就是減少出現(xiàn)的偽影,從而生成更逼真的參考動作,能讓智能體更輕易地模擬。為了實現(xiàn)這一點,我們對參考動作進(jìn)行了優(yōu)化Q={q0,q1,…,qt},以滿足以下目標(biāo):

其中l(wèi)p(Q^)是為了讓參考動作和原始動作預(yù)測更接近,lsm(Q^)是為了讓相鄰的幀之間的動作更相近,從而生成更流暢的動作。另外,wp和wsm是不同損失的權(quán)重。

這一過程可以顯著提高參考動作的質(zhì)量,并且修正一些人工生成的痕跡。

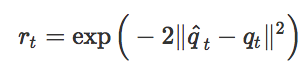

動作模擬

有了參考動作{q^0,q^1,…,q^t}之后,我們就可以訓(xùn)練智能體模仿這些動作了。這一階段用到的強化學(xué)習(xí)方法和之前我們?yōu)槟M動作捕捉數(shù)據(jù)而提出的方法相似,獎勵函數(shù)僅僅是為了讓智能體的動作和重建后的參考動作之間的差異最小化。

這一方法表現(xiàn)得很好,我們的智能體可以學(xué)習(xí)很多雜技動作,每個動作只需要一段視頻就能學(xué)會。

結(jié)果

最終我們的智能體從YouTube上的視頻中學(xué)習(xí)了20多種不同的技能。

盡管智能體的形態(tài)有時和視頻中的人物不太一樣,但這一框架仍然能逼真地重現(xiàn)很多動作。除此之外,研究人員還用模擬的Atlas機器人模仿視頻動作。

使用模擬人物(智能體)的好處之一就是,在新環(huán)境下可以用模擬對象生成相應(yīng)的動作。這里,我們訓(xùn)練智能體在不規(guī)則平面上采取不同動作,而它所對應(yīng)的原始視頻是在平地上運動的。

雖然和原始視頻中的環(huán)境大不相同,學(xué)習(xí)算法仍然能生成相對可靠的策略來應(yīng)對不同路面情況。

總的來說,我們的框架采用的都是視頻模仿問題中常見的方法,關(guān)鍵是要將問題分解成更加易處理的組合部分,針對每個部分采取正確的方法,然后高效地把它們組合在一起。但是模擬視頻中的動作仍然是非常有挑戰(zhàn)性的工作,目前還有很多我們無法復(fù)現(xiàn)的視頻片段:

這種江南style的舞步,智能體就難以模仿

但是看到目前我們實現(xiàn)的成果,還是很振奮人心。未來我們還有很多需要改進(jìn)的地方,希望這項工作能作為基礎(chǔ),為智能體在未來處理大量視頻數(shù)據(jù)的能力奠定了基礎(chǔ)。

-

計算機視覺

+關(guān)注

關(guān)注

9文章

1706瀏覽量

46623 -

智能體

+關(guān)注

關(guān)注

1文章

282瀏覽量

10994 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5557瀏覽量

122583

原文標(biāo)題:僅需一段視頻,伯克利研究者就讓智能體學(xué)會了雜技

文章出處:【微信號:jqr_AI,微信公眾號:論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

2017全國深度學(xué)習(xí)技術(shù)應(yīng)用大會

基于深度學(xué)習(xí)的異常檢測的研究方法

基于深度學(xué)習(xí)的異常檢測的研究方法

討論紋理分析在圖像分類中的重要性及其在深度學(xué)習(xí)中使用紋理分析

研究人員們提出了一系列新的點云處理模塊

谷歌發(fā)明自主學(xué)習(xí)機器人 結(jié)合了深度學(xué)習(xí)和強化學(xué)習(xí)兩種類型的技術(shù)

研究人員推出了一種新的基于深度學(xué)習(xí)的策略

研究人員開發(fā)了一種基于深度學(xué)習(xí)的智能算法

(KAIST)研究人員提供了一種深度學(xué)習(xí)供電的單應(yīng)變電子皮膚傳感器

研究人員開發(fā)出深度學(xué)習(xí)算法用于患者的診斷

基于深度學(xué)習(xí)的二維人體姿態(tài)估計方法

基于深度學(xué)習(xí)的二維人體姿態(tài)估計算法

研究人員提出將深度學(xué)習(xí)技術(shù)引入細(xì)胞成像和分析中

AI深度相機-人體姿態(tài)估計應(yīng)用

深度解析深度學(xué)習(xí)下的語義SLAM

評論