1、導(dǎo)言

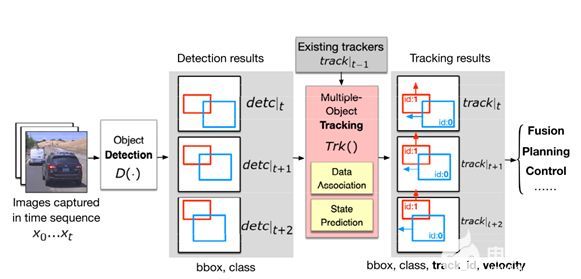

在多目標(biāo)跟蹤問題中,算法需要根據(jù)每一幀圖像中目標(biāo)的檢測結(jié)果,匹配已有的目標(biāo)軌跡;對于新出現(xiàn)的目標(biāo),需要生成新的目標(biāo);對于已經(jīng)離開攝像機(jī)視野的目標(biāo),需要終止軌跡的跟蹤。這一過程中,目標(biāo)與檢測的匹配可以看作為目標(biāo)的重識別,例如,當(dāng)跟蹤多個(gè)行人時(shí),把已有的軌跡的行人圖像集合看作為圖像庫(gallery),而檢測圖像看作為查詢圖像(query),檢測與軌跡的匹配關(guān)聯(lián)過程可以看作由查詢圖像檢索圖像庫的過程。如圖1。

圖1:把檢測圖像看作查詢圖像(query),行人軌跡中的圖像看作圖像庫(gallery),多目標(biāo)跟蹤中的匹配過程可以看作為行人重識別。

與傳統(tǒng)的行人重識別不同的是,行人多目標(biāo)跟蹤中的檢測與行人軌跡的匹配關(guān)聯(lián)問題更加復(fù)雜,具體表現(xiàn)在下面三個(gè)方面:首先,多目標(biāo)跟蹤中的目標(biāo)軌跡是頻繁發(fā)生變化的,圖像樣本庫的數(shù)量和種類并不固定。其次,檢測結(jié)果中可能出現(xiàn)新的目標(biāo),也可能不包括已有的目標(biāo)軌跡。另外,檢測圖像并不像傳統(tǒng)行人重識別中的查詢圖像都是比較準(zhǔn)確的檢測結(jié)果,通常,行人多目標(biāo)跟蹤場景下的檢測結(jié)果混雜了一些錯(cuò)誤的檢測(false-alarms),而由于背景以及目標(biāo)之間的交互,跟蹤中的行人檢測可能出現(xiàn)圖像不對齊、多個(gè)檢測對應(yīng)同一目標(biāo)、以及一個(gè)檢測覆蓋了多個(gè)目標(biāo)這些情況。如圖2中所示為ACF行人檢測算法的結(jié)果。

如何擴(kuò)展深度學(xué)習(xí)在行人重識別問題中的研究成果到多目標(biāo)跟蹤領(lǐng)域,研究適用于多目標(biāo)跟蹤問題的深度學(xué)習(xí)算法是具有挑戰(zhàn)性的問題。近年來,在計(jì)算機(jī)視覺頂級會議和期刊上,研究者從各方面提出了一些解決方案,發(fā)表了一些新的算法試圖解決這個(gè)問題。在這篇文章中,SIGAI將和大家一起對基于深度學(xué)習(xí)的視覺多目標(biāo)跟蹤算法進(jìn)行總結(jié)和歸納,以幫助理解基于深度學(xué)習(xí)框架的多目標(biāo)跟蹤算法的原理和相對于傳統(tǒng)算法的優(yōu)勢,如果對本文的觀點(diǎn)持有不同的意見,歡迎向我們的公眾號發(fā)消息一起討論。

圖2:多目標(biāo)跟蹤場景下行人的檢測結(jié)果。

綠色矩形框表示存在的檢測結(jié)果不準(zhǔn)確的情況。藍(lán)色矩形框是檢測結(jié)果基本準(zhǔn)確的示例。當(dāng)目標(biāo)特征與檢測器模型樣本分布相差較大時(shí),存在檢測失敗的情況。

2、基于深度學(xué)習(xí)的多目標(biāo)跟蹤算法分類

多目標(biāo)跟蹤算法按照軌跡生成的順序可以分為離線的多目標(biāo)跟蹤和在線的多目標(biāo)跟蹤算法。離線方式的多目標(biāo)跟蹤算法通常構(gòu)造為目標(biāo)檢測關(guān)系的圖模型,其中設(shè)計(jì)和計(jì)算檢測之間的相似度或者距離度量是決定圖模型構(gòu)造正確性的關(guān)鍵。在線方式的多目標(biāo)跟蹤算法根據(jù)當(dāng)前檢測觀測,計(jì)算與已有軌跡的匹配關(guān)系,計(jì)算合適的匹配度量決定了匹配的正確性。因此,無論是離線方式的多目標(biāo)跟蹤還是在線方式的多目標(biāo)跟蹤算法,學(xué)習(xí)檢測結(jié)果的特征并計(jì)算匹配相似度或者距離度量都是多目標(biāo)跟蹤算法的關(guān)鍵步驟。

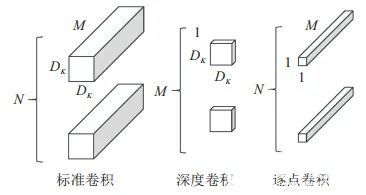

基于深度學(xué)習(xí)的多目標(biāo)跟蹤算法的主要任務(wù)是優(yōu)化檢測之間相似性或距離度量的設(shè)計(jì)。根據(jù)學(xué)習(xí)特征的不同,基于深度學(xué)習(xí)的多目標(biāo)跟蹤可以分為表觀特征的深度學(xué)習(xí),基于相似性度量的深度學(xué)習(xí),以及基于高階匹配特征的深度學(xué)習(xí)(如圖3)。

圖3:按照深度學(xué)習(xí)目標(biāo)和應(yīng)用對基于深度學(xué)習(xí)的多目標(biāo)跟蹤算法進(jìn)行分類。

利用深度神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)目標(biāo)檢測的表觀特征是簡單有效的提升多目標(biāo)跟蹤算法的方法。例如利用圖像識別或者行人重識別任務(wù)中學(xué)習(xí)到的深度特征直接替換現(xiàn)有多目標(biāo)跟蹤算法框架中的表觀特征[1],或者采用深度神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)光流運(yùn)動特征,計(jì)算運(yùn)動相關(guān)性[2]。

采用深度學(xué)習(xí)提升多目標(biāo)跟蹤算法更加直接的方法是學(xué)習(xí)檢測之間的特征相似性,比如設(shè)計(jì)深度網(wǎng)絡(luò)計(jì)算不同檢測的距離函數(shù),相同目標(biāo)的檢測距離小,不同目標(biāo)的檢測距離大,從而構(gòu)造關(guān)于檢測距離的代價(jià)函數(shù)[3]。也可以設(shè)計(jì)二類分類代價(jià),使相同目標(biāo)的檢測特征匹配類型為1,而不同目標(biāo)的檢測特征匹配類型為0,從而學(xué)習(xí)并輸出(0,1]之間的檢測匹配度[4]。如果考慮已有軌跡與檢測之間的匹配或者軌跡之間的匹配,采用深度學(xué)習(xí)方法可以用于設(shè)計(jì)并計(jì)算軌跡之間的匹配相似度,這種方法可以認(rèn)為是基于深度學(xué)習(xí)的高階特征匹配方法。采用深度學(xué)習(xí)計(jì)算高階特征匹配可以學(xué)習(xí)多幀表觀特征的高階匹配相似性[5],也可以學(xué)習(xí)運(yùn)動特征的匹配相關(guān)度[6]。

下面我們對一些基于深度學(xué)習(xí)的多目標(biāo)跟蹤算法進(jìn)行概要介紹。

3、深度視覺多目標(biāo)跟蹤算法介紹

3.1 基于對稱網(wǎng)絡(luò)的多目標(biāo)跟蹤算法

一種檢測匹配度量學(xué)習(xí)方法是采用Siamese對稱卷積網(wǎng)絡(luò),以兩個(gè)尺寸相同的檢測圖像塊作為輸入,輸出為這兩個(gè)圖像塊是否屬于同一個(gè)目標(biāo)的判別[3]。通常有三種拓?fù)湫问降腟iamese網(wǎng)絡(luò)結(jié)構(gòu),如圖4。

圖4:三種Siamese網(wǎng)絡(luò)拓?fù)浣Y(jié)構(gòu)。

第一種結(jié)構(gòu),輸入A和B經(jīng)過相同參數(shù)的網(wǎng)絡(luò)分支,對提取的特征計(jì)算他們的距離度量作為代價(jià)函數(shù),以使得相同對象的距離接近,而不同對象的距離變大。第二種結(jié)構(gòu),輸入A和B經(jīng)過部分相同參數(shù)的網(wǎng)絡(luò)分支,對生成的特征進(jìn)行合并,新的特征進(jìn)行多層卷積濾波之后輸入代價(jià)函數(shù)作為輸出。第三種結(jié)構(gòu),對輸入A和B疊加組合作為新的網(wǎng)絡(luò)輸入,通過網(wǎng)絡(luò)濾波生成輸出。

經(jīng)過實(shí)驗(yàn)表明,第三種網(wǎng)絡(luò)結(jié)構(gòu)能夠生成更好的判別結(jié)果。因此,在文獻(xiàn)[3]中,Lealtaixe等人采用第三種拓?fù)湫问降腟iamese網(wǎng)絡(luò)訓(xùn)練并計(jì)算兩個(gè)檢測的匹配相似度,原始的檢測特征包括正則化的LUV圖像I1和I2,以及具有x,y方向分量的光流圖像O1和O2,把這些圖像縮放到121x53,并且疊加到一起構(gòu)成10個(gè)通道的網(wǎng)絡(luò)輸入特征。卷積網(wǎng)絡(luò)由3個(gè)卷積層(Conv-Layer)、4個(gè)全連接層(FC-Layer)以及2元分類損失層(binary-softmax-loss)組成,如圖5。損失函數(shù)為:

其中Φ(d1,d2)表示兩個(gè)檢測d1,d2,經(jīng)過卷積之后的輸出特征。y表示是否對應(yīng)相同目標(biāo),如果d1,d2來自同一個(gè)目標(biāo)的檢測,y=1;否則y=0。

為了學(xué)習(xí)這個(gè)網(wǎng)絡(luò),作者從真實(shí)跟蹤數(shù)據(jù)中抽取訓(xùn)練樣本,從利用檢測算法得到同一個(gè)軌跡的檢測對作為正樣本,從不同軌跡中得到檢測作為負(fù)樣本,為了增加樣本多樣性,增強(qiáng)分類器的泛化能力,負(fù)樣本還包括從檢測周圍隨機(jī)采集的重疊率較小的圖像塊。

學(xué)習(xí)過程采用經(jīng)典的帶有動量的隨機(jī)梯度反向傳播算法。最小批大小選擇為128,學(xué)習(xí)率初始為0.01。通過50個(gè)回合的訓(xùn)練,可以得到較為優(yōu)化的網(wǎng)絡(luò)參數(shù)。

在Siamese網(wǎng)絡(luò)學(xué)習(xí)完成之后,作者采用第六層全連接網(wǎng)絡(luò)的輸出作為表觀特征,為了融合運(yùn)動信息,作者又設(shè)計(jì)了6維運(yùn)動上下文特征:尺寸相對變化,位置相對變化,以及速度相對變化。通過經(jīng)典的梯度下降提升算法學(xué)習(xí)集成分類器。

圖5:采用Siamese對稱網(wǎng)絡(luò)學(xué)習(xí)表觀特征相似度,并通過基于梯度下降提升算法的分類器融合運(yùn)動特征,得到融合運(yùn)動和表觀特征的相似度判別。并利用線性規(guī)劃優(yōu)化算法得到多目標(biāo)跟蹤結(jié)果。

多目標(biāo)跟蹤的過程采用全局最優(yōu)算法框架,通過對每兩個(gè)檢測建立連接關(guān)系,生成匹配圖,計(jì)算他們的匹配狀態(tài)。通過最小代價(jià)網(wǎng)絡(luò)流轉(zhuǎn)化為線性規(guī)劃進(jìn)行求解。

3.2 基于最小多割圖模型的多目標(biāo)跟蹤算法

上述算法中為了匹配兩個(gè)檢測采用LUV圖像格式以及光流圖像。Tang等人在文獻(xiàn)[2]中發(fā)現(xiàn)采用深度學(xué)習(xí)計(jì)算的類光流特征(DeepMatching),結(jié)合表示能力更強(qiáng)的模型也可以得到效果很好的多目標(biāo)跟蹤結(jié)果。

在文獻(xiàn)[2]中,作者通過觀察目標(biāo)跟蹤問題中的檢測結(jié)果,發(fā)現(xiàn)僅僅考慮兩幀之間的檢測匹配不是最佳的模型表示。如圖6,由于存在很多檢測不準(zhǔn)確的情況,同時(shí)考慮圖像之間以及圖像內(nèi)部的檢測匹配關(guān)系,并建立相應(yīng)的圖模型比僅僅考濾幀間檢測匹配的圖模型具有更廣泛的表示能力。

圖6:上圖是三幀圖像中的檢測結(jié)果,為了建立更準(zhǔn)確的匹配模型,除了建立兩幀之間的匹配關(guān)系,還需要考慮同一幅圖像內(nèi),是否存在同一個(gè)目標(biāo)對應(yīng)多個(gè)檢測的情況。下圖是構(gòu)造的幀間及幀內(nèi)連接圖模型。

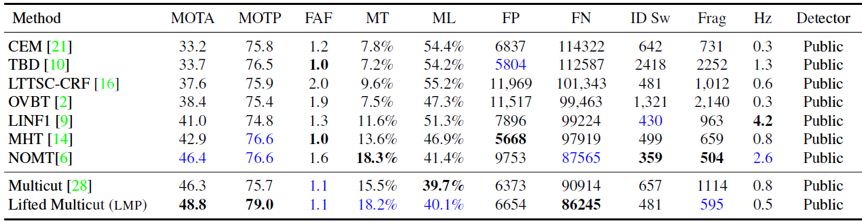

類似于最小代價(jià)流模型求解多目標(biāo)跟蹤算法,這種考慮了幀內(nèi)匹配的圖模型可以模型化為圖的最小多割問題,如下公式所示:

上式中Ce表示每個(gè)邊的代價(jià),這里用檢測之間的相似度計(jì)算。x=0表示節(jié)點(diǎn)屬于同一個(gè)目標(biāo),x=1反之。這個(gè)二元線性規(guī)劃問題的約束條件表示,對于任何存在的環(huán)路,如果存在一個(gè)連接x=0,那么這個(gè)環(huán)上的其他路徑都是x=0。即,對于優(yōu)化結(jié)果中的0環(huán)路,他們都在同一個(gè)目標(biāo)中。所以x=1表示了不同目標(biāo)的分割,因此這個(gè)問題轉(zhuǎn)化為了圖的最小多割問題。對于最小代價(jià)多割問題的求解,可以采用KLj算法進(jìn)行求解[7]。

現(xiàn)在的問題是如何計(jì)算幀內(nèi)及幀間檢測配對的匹配度量特征。作者采用了深度學(xué)習(xí)算法框架計(jì)算的光流特征(DeepMatching)作為匹配特征[8]。圖7是采用DeepMatching方法計(jì)算的深度光流特征示例。

圖7: 利用DeepMatching算法計(jì)算的深度光流特征,藍(lán)色箭頭表示匹配上的點(diǎn)對。

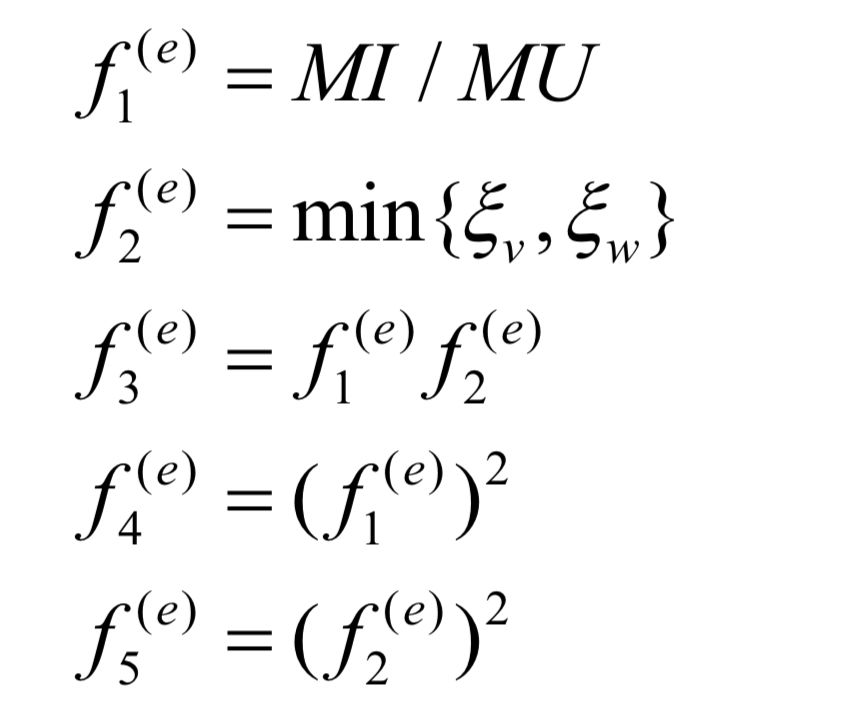

基于DeepMatching特征,可以構(gòu)造下列5維特征:

其中MI,MU表示檢測矩形框中匹配的點(diǎn)的交集大小以及并集大小,ξv和ξw表示檢測信任度。利用這5維特征可以學(xué)習(xí)一個(gè)邏輯回歸分類器。并得到是相同目標(biāo)的概率Pe,從而計(jì)算公式(2)中的代價(jià)函數(shù):

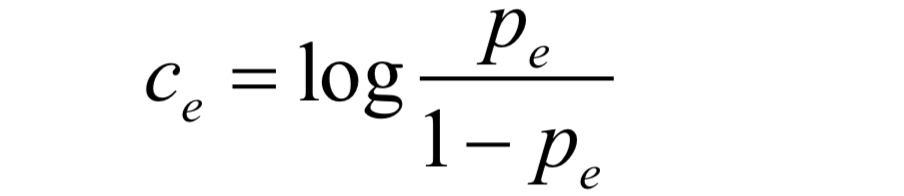

為了連接長間隔的檢測匹配,增強(qiáng)對遮擋的處理能力,同時(shí)避免表觀形似但是不同目標(biāo)檢測之間的連接,Tang等人在最小代價(jià)多割圖模型的基礎(chǔ)上提出了基于提升邊(lifted edges)的最小代價(jià)多割圖模型[9]。基本的思想是,擴(kuò)展原來多割公式(2)的約束條件,把圖中節(jié)點(diǎn)的連接分為常規(guī)邊和提升邊,常規(guī)邊記錄短期匹配狀態(tài),提升邊記錄長期相似檢測之間的匹配關(guān)系。除了原來公式(2)中的約束,又增加了2個(gè)針對提升邊的約束,即(1)對于提升邊是正確匹配的,應(yīng)該有常規(guī)邊上正確匹配的支持;(2)對于提升邊是割邊的情況,也應(yīng)該有常規(guī)邊上連續(xù)的割邊的支持。如圖8。

圖8: (a)和(c)是傳統(tǒng)的最小代價(jià)多割圖模型。(b)和(d)是增加了提升邊(綠色邊)的最小多割圖模型。通過增加提升邊約束,圖中(b)中的提升邊可以被識別為割,而(d)中的邊被識別為鏈接。

同樣,為了計(jì)算邊的匹配代價(jià),需要設(shè)計(jì)匹配特征。這里,作者采用結(jié)合姿態(tài)對齊的疊加Siamese網(wǎng)絡(luò)計(jì)算匹配相似度,如圖9,采用的網(wǎng)絡(luò)模型StackNetPose具有最好的重識別性能。

圖9: (a),(b),(c)分別為SiameseNet, StackNet, StackNetPose模型。(e)為這三種模型與ID-Net在行人重識別任務(wù)上對比。(d)為StackNetPose的結(jié)果示例。

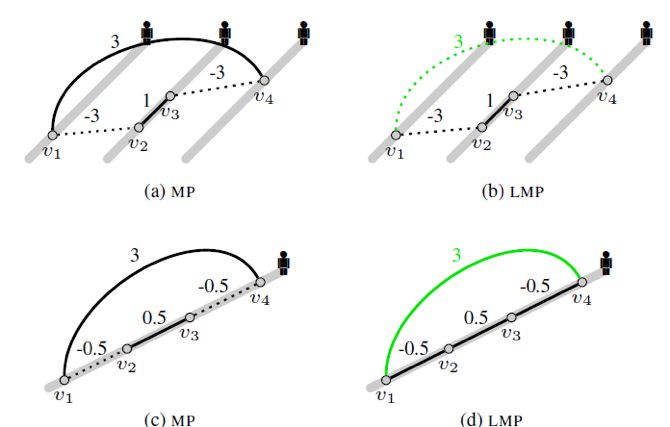

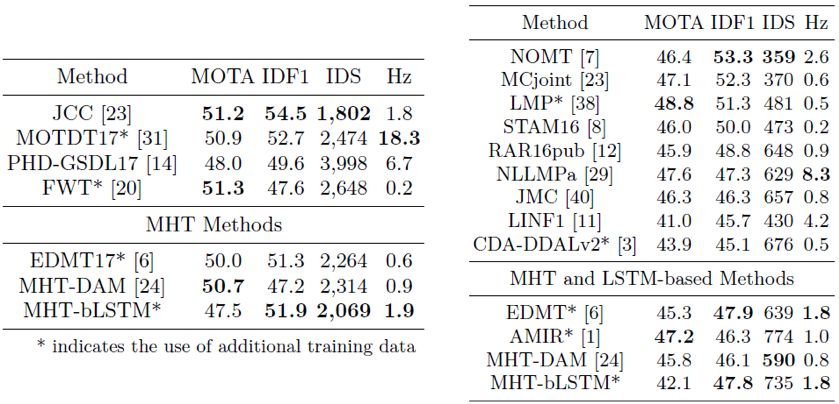

綜合StackNetPose網(wǎng)絡(luò)匹配信任度、深度光流特征(deepMatching)和時(shí)空相關(guān)度,作者設(shè)計(jì)了新的匹配特征向量。類似于[2], 計(jì)算邏輯回歸匹配概率。最終的跟蹤結(jié)果取得了非常突出的進(jìn)步。在MOT2016測試數(shù)據(jù)上的結(jié)果如下表:

表1:基于提升邊的最小代價(jià)多割算法在MOT2016測試數(shù)據(jù)集中的跟蹤性能評測結(jié)果。

3.3 通過時(shí)空域關(guān)注模型學(xué)習(xí)多目標(biāo)跟蹤算法

除了采用解決目標(biāo)重識別問題的深度網(wǎng)絡(luò)架構(gòu)學(xué)習(xí)檢測匹配特征,還可以根據(jù)多目標(biāo)跟蹤場景的特點(diǎn),設(shè)計(jì)合適的深度網(wǎng)絡(luò)模型來學(xué)習(xí)檢測匹配特征。Chu等人對行人多目標(biāo)跟蹤問題中跟蹤算法發(fā)生漂移進(jìn)行統(tǒng)計(jì)分析,發(fā)現(xiàn)不同行人發(fā)生交互時(shí),互相遮擋是跟蹤算法產(chǎn)生漂移的重要原因[4]。如圖10。

圖10:當(dāng)2個(gè)目標(biāo)的運(yùn)動發(fā)生交互的時(shí)候,被遮擋目標(biāo)不能分辨正確匹配,導(dǎo)致跟蹤漂移。

針對這個(gè)問題,文獻(xiàn)[4]提出了基于空間時(shí)間關(guān)注模型(STAM)用于學(xué)習(xí)遮擋情況,并判別可能出現(xiàn)的干擾目標(biāo)。如圖11,空間關(guān)注模型用于生成遮擋發(fā)生時(shí)的特征權(quán)重,當(dāng)候選檢測特征加權(quán)之后,通過分類器進(jìn)行選擇得到估計(jì)的目標(biāo)跟蹤結(jié)果,時(shí)間關(guān)注模型加權(quán)歷史樣本和當(dāng)前樣本,從而得到加權(quán)的損失函數(shù),用于在線更新目標(biāo)模型。

圖11:用于遮擋判別的STAM模型框架,采用空間注意模型加權(quán)檢測結(jié)果的特征,通過歷史樣本、以及圍繞當(dāng)前跟蹤結(jié)果采集的正、負(fù)樣本,來在線更新目標(biāo)模型。

在這個(gè)模型中每個(gè)目標(biāo)獨(dú)立管理并更新自己的空間時(shí)間關(guān)注模型以及特征模型,并選擇候選檢測進(jìn)行跟蹤,因此本質(zhì)上,這種方法是對單目標(biāo)跟蹤算法在多目標(biāo)跟蹤中的擴(kuò)展。為了區(qū)分不同的目標(biāo),關(guān)鍵的步驟是如何對遮擋狀態(tài)進(jìn)行建模和區(qū)分接近的不同目標(biāo)。

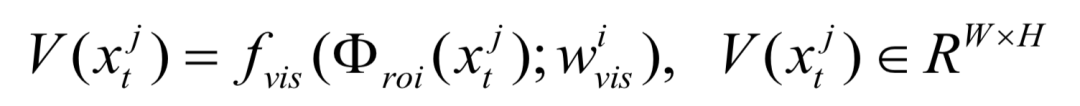

這里空間注意模型用于對每個(gè)時(shí)刻的遮擋狀態(tài)進(jìn)行分析,空間關(guān)注模型如圖12中下圖所示。主要分為三個(gè)部分,第一步是學(xué)習(xí)特征可見圖(visibility map):

這里fvis是一個(gè)卷積層和全連接層的網(wǎng)絡(luò)操作。wvisi是需要學(xué)習(xí)的參數(shù)。

第二步是根據(jù)特征可見圖,計(jì)算空間關(guān)注圖(Spatial Attention):

其中fatt是一個(gè)局部連接的卷積和打分操作。wtji是學(xué)習(xí)到的參數(shù)。

圖12:采用空間注意模型網(wǎng)絡(luò)架構(gòu)學(xué)習(xí)遮擋狀態(tài),并用于每個(gè)樣本特征的加權(quán)和打分。

第三步根據(jù)空間注意圖加權(quán)原特征圖:

對生成的加權(quán)特征圖進(jìn)行卷積和全連接網(wǎng)絡(luò)操作,生成二元分類器判別是否是目標(biāo)自身。最后用得到分類打分選擇最優(yōu)的跟蹤結(jié)果。

3.4 基于循環(huán)網(wǎng)絡(luò)判別融合表觀運(yùn)動交互的多目標(biāo)跟蹤算法

上面介紹的算法采用的深度網(wǎng)絡(luò)模型都是基于卷積網(wǎng)絡(luò)結(jié)構(gòu),由于目標(biāo)跟蹤是通過歷史軌跡信息來判斷新的目標(biāo)狀態(tài),因此,設(shè)計(jì)能夠記憶歷史信息并根據(jù)歷史信息來學(xué)習(xí)匹配相似性度量的網(wǎng)絡(luò)結(jié)構(gòu)來增強(qiáng)多目標(biāo)跟蹤的性能也是比較可行的算法框架。

在文獻(xiàn)[5]中,Sadeghian等人設(shè)計(jì)了基于長短期記憶循環(huán)網(wǎng)絡(luò)模型(LSTM)的特征融合算法來學(xué)習(xí)軌跡歷史信息與當(dāng)前檢測之間的匹配相似度。如圖13。

圖13:軌跡目標(biāo)與檢測的匹配需要采用三種特征(表觀特征、運(yùn)動特征、交互特征)融合(左),為了融合三種特征采用分層的LSTM模型(中),最終匹配通過相似度的二部圖匹配算法實(shí)現(xiàn)(右)。

文獻(xiàn)[5]中,考慮從三個(gè)方面特征計(jì)算軌跡歷史信息與檢測的匹配:表觀特征,運(yùn)動特征,以及交互模式特征。這三個(gè)方面的特征融合以分層方式計(jì)算。

在底層的特征匹配計(jì)算中,三個(gè)特征都采用了長短期記憶模型(LSTM)。對于表觀特征,首先采用VGG-16卷積網(wǎng)絡(luò)生成500維的特征?tA,以這個(gè)特征作為LSTM的輸入計(jì)算循環(huán)。

圖14:基于CNN模型和LSTM模型的軌跡與檢測表觀特征匹配架構(gòu)。

網(wǎng)絡(luò)的輸出特征?t,對于當(dāng)前檢測BBjt+1,計(jì)算同樣維度的特征?j,連接這兩個(gè)特征并通過全鏈接網(wǎng)絡(luò)層計(jì)算500維特征?A,根據(jù)是否匹配學(xué)習(xí)分類器,并預(yù)訓(xùn)練這個(gè)網(wǎng)絡(luò)(圖14)。

對于運(yùn)動特征,取相對位移vit為基本輸入特征,直接輸入LSTM模型計(jì)算沒時(shí)刻的輸出?i,對于下一時(shí)刻的檢測同樣計(jì)算相對位移vjt+1,通過全連接網(wǎng)絡(luò)計(jì)算特征?j,類似于表觀特征計(jì)算500維特征?m,并利用二元匹配分類器進(jìn)行網(wǎng)絡(luò)的預(yù)訓(xùn)練(圖15)。

圖15:基于LSTM模型的軌跡運(yùn)動特征匹配架構(gòu)。

對于交互特征,取以目標(biāo)中心位置周圍矩形領(lǐng)域內(nèi)其他目標(biāo)所占的相對位置映射圖作為LSTM模型的輸入特征,計(jì)算輸出特征?i,對于t+1時(shí)刻的檢測計(jì)算類似的相對位置映射圖為特征,通過全連接網(wǎng)絡(luò)計(jì)算特征?j,類似于運(yùn)動模型,通過全連接網(wǎng)絡(luò)計(jì)算500維特征?I,進(jìn)行同樣的分類訓(xùn)練(圖16)。

圖16:基于LSTM模型的目標(biāo)交互特征匹配架構(gòu)。

當(dāng)三個(gè)特征?A,?M,?I都計(jì)算之后拼接為完整的特征,輸入到上層的LSTM網(wǎng)絡(luò),對輸出的向量進(jìn)行全連接計(jì)算,然后用于匹配分類,匹配正確為1,否則為0。對于最后的網(wǎng)絡(luò)結(jié)構(gòu),還需要進(jìn)行微調(diào),以優(yōu)化整體網(wǎng)絡(luò)性能。最后的分類打分看作為相似度用于檢測與軌跡目標(biāo)的匹配計(jì)算。最終的跟蹤框架采用在線的檢測與軌跡匹配方法進(jìn)行計(jì)算。

3.5 基于雙線性長短期循環(huán)網(wǎng)絡(luò)模型的多目標(biāo)跟蹤算法

在循環(huán)網(wǎng)絡(luò)判別融合表觀運(yùn)動交互的多目標(biāo)跟蹤算法中,作者采用LSTM作為表觀模型、運(yùn)動模型以及交互模型的歷史信息模型表示。在對LSTM中各個(gè)門函數(shù)的設(shè)計(jì)進(jìn)行分析之后,Kim等人認(rèn)為僅僅用基本的LSTM模型對于表觀特征并不是最佳的方案,在文獻(xiàn)[10]中,Kim等人設(shè)計(jì)了基于雙線性LSTM的表觀特征學(xué)習(xí)網(wǎng)絡(luò)模型。

如圖17中,除了利用傳統(tǒng)的LSTM進(jìn)行匹配學(xué)習(xí),或者類似[5]中的算法,拼接LSTM輸出與輸入特征,作者設(shè)計(jì)了基于乘法的雙線性LSTM模型,利用LSTM的隱含層特征(記憶)信息與輸入的乘積作為特征,進(jìn)行匹配分類器的學(xué)習(xí)。

圖17:三種基于LSTM的匹配模型。(a)利用隱含層(記憶信息)與輸入特征乘積作為分類特征。(b)直接拼接隱含層特征與輸入特征作為新的特征進(jìn)行分類學(xué)習(xí)。(c)使用傳統(tǒng)LSTM模型的隱含層進(jìn)行特征學(xué)習(xí)。

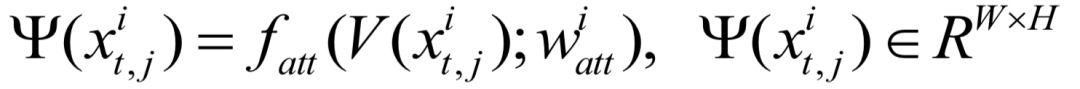

這里對于隱含層特征ht-1,必須先進(jìn)行重新排列(reshape)操作,然后才能乘以輸入的特征向量xt,如下公式:

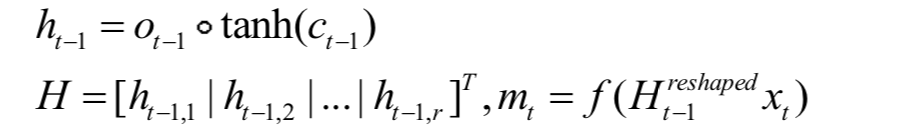

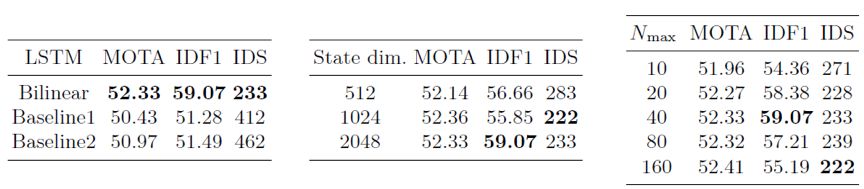

其中f表示非線性激活函數(shù),mt是新的特征輸入。而原始的檢測圖像采用ResNet50提取2048維的特征,并通過全連接降為256維。下表中對于不同網(wǎng)絡(luò)結(jié)構(gòu)、網(wǎng)絡(luò)特征維度、以及不同LSTM歷史長度時(shí),表觀特征的學(xué)習(xí)對跟蹤性能的影響做了驗(yàn)證。

表2:(左)三種網(wǎng)絡(luò)結(jié)構(gòu)對跟蹤性能的影響, Baseline1和Baseline2分別對應(yīng)圖17中的中間圖結(jié)構(gòu)和右圖結(jié)構(gòu)。(中)不同網(wǎng)絡(luò)隱含層維度對性能的影響。(右)不同歷史信息長度對跟蹤性能的影響。

可以看出采用雙線性LSTM(bilinear LSTM)的表觀特征性能最好,此時(shí)的歷史相關(guān)長度最佳為40,這個(gè)值遠(yuǎn)遠(yuǎn)超過文獻(xiàn)[5]中的2-4幀歷史長度。相對來說40幀歷史信息影響更接近人類的直覺。

作者通過對比遞推最小二乘公式建模表觀特征的結(jié)果,認(rèn)為雙線性LSTM模型對于表觀模型的長期歷史特征建模比簡單的LSTM更具有可解釋性,而對于運(yùn)動特征,原始的LSTM特征表現(xiàn)的更好。綜合雙線性LSTM表觀模型和LSTM運(yùn)動模型,作者提出了新的基于MHT框架的跟蹤算法MHT-bLSTM,得到的性能如下表:

表3:在MOT2017和MOT2016中多目標(biāo)跟蹤算法比較。在IDF1評測指標(biāo)上,MHT-bLSTM的性能最佳。

4、基于深度學(xué)習(xí)的視覺多目標(biāo)跟蹤算法討論

上文我們討論了視覺多目標(biāo)跟蹤領(lǐng)域中,深度學(xué)習(xí)算法近年來的發(fā)展。從直接擴(kuò)展行人重識別任務(wù)中深度學(xué)習(xí)算法的網(wǎng)絡(luò)模型,深度學(xué)習(xí)被證明在多目標(biāo)跟蹤領(lǐng)域中是確實(shí)可行的特征學(xué)習(xí)和特征匹配算法,對于提升跟蹤性能可以起到非常重要的作用。目前的基于深度學(xué)習(xí)的多目標(biāo)跟蹤框架在以下兩個(gè)方向取得了較好的進(jìn)展:(1)結(jié)合多目標(biāo)跟蹤場景的網(wǎng)絡(luò)設(shè)計(jì),比如在文獻(xiàn)[4]中考慮多目標(biāo)交互的情況設(shè)計(jì)網(wǎng)絡(luò)架構(gòu),這種考慮跟蹤場景的網(wǎng)絡(luò)設(shè)計(jì)對于跟蹤結(jié)果有明顯提升。(2)采用循環(huán)神經(jīng)網(wǎng)絡(luò)的深度學(xué)習(xí)應(yīng)用,比如文獻(xiàn)[5]和[10],討論歷史信息對跟蹤中軌跡特征的描述,是研究跟蹤問題的一個(gè)重要方向。

從跟蹤結(jié)果來看,即使采用簡單的重識別網(wǎng)絡(luò)特征以及光流特征,如果使用優(yōu)化的全局跟蹤框架,也能夠得到比使用復(fù)雜的網(wǎng)絡(luò)架構(gòu)更好的結(jié)果。例如使用提升邊建模長期鏈接的多割圖模型,對于跟蹤過程中目標(biāo)的檢測錯(cuò)誤和檢測不準(zhǔn)確具有很好的補(bǔ)償作用,可以提升正確檢測聚類的性能。而使用循環(huán)網(wǎng)絡(luò)模型對于運(yùn)動特征的長期匹配相似度計(jì)算也是非常有效的。比較上文中討論的兩種循環(huán)網(wǎng)絡(luò)的使用,由于缺少交互特征,基于雙線性LSTM的方法比特征融合的方法具有一定的性能損失。 因此, 嘗試在網(wǎng)絡(luò)模型中加入交互特征的建模,對于多目標(biāo)跟蹤結(jié)果具有一定的性能提升。

5、基于深度學(xué)習(xí)的視覺多目標(biāo)跟蹤發(fā)展趨勢

近年來,基于深度學(xué)習(xí)的單目標(biāo)跟蹤算法取得了長足的進(jìn)步。相對來說,深度學(xué)習(xí)在多目標(biāo)跟蹤領(lǐng)域的應(yīng)用,比較多的局限于匹配度量的學(xué)習(xí)。主要的原因是,在圖像識別領(lǐng)域中,例如圖像分類、行人重識別問題中,深度學(xué)習(xí)取得的進(jìn)展能夠較好的直接應(yīng)用于多目標(biāo)跟蹤問題。然而,考慮對象到之間的交互以及跟蹤場景復(fù)雜性,多目標(biāo)跟蹤問題中深度學(xué)習(xí)算法的應(yīng)用還遠(yuǎn)沒有達(dá)到充分的研究。隨著深度學(xué)習(xí)領(lǐng)域理論的深入研究和發(fā)展,近年來基于生成式網(wǎng)絡(luò)模型和基于強(qiáng)化學(xué)習(xí)的深度學(xué)習(xí)越來越得到大家的關(guān)注,在多目標(biāo)跟蹤領(lǐng)域中,由于場景的復(fù)雜性,研究如何采用生成式網(wǎng)絡(luò)模型和深度強(qiáng)化學(xué)習(xí)來學(xué)習(xí)跟蹤場景的適應(yīng)性,提升跟蹤算法的性能是未來深度學(xué)習(xí)多目標(biāo)跟蹤領(lǐng)域研究的趨勢。

參考文獻(xiàn)

[1] C. Kim, F. Li, A. Ciptadi, and J. Rehg. Multiple Hypothesis Tracking Revisited. In ICCV, 2015.

[2] S. Tang, B. Andres, M. Andriluka, and B. Schiele. Multi-person tracking by multicut and deep matching. In ECCV Workshops, 2016.

[3] L. Lealtaixe, C. Cantonferrer, and K. Schindler, “Learning by tracking: Siamese CNN for robust target association,” in Proceedings of Computer Vision and Pattern Recognition. 2016.

[4] Q. Chu, W. Ouyang, H. Li, X. Wang, B. Liu, N. Yu. "Online Multi-Object Tracking Using CNN-based Single Object Tracker with Spatial-Temporal Attention Mechanism", ICCV 2017.

[5] A. Sadeghian, A. Alahi, and S. Savarese. "Tracking the untrackable: Learning to track multiple cues with long-term dependencies", ICCV2017.

[6] K. Fang, Y. Xiang, X. Li and S. Savarese, "Recurrent Autoregressive Networks for Online Multi-Object Tracking", In IEEE Winter Conference on Applications of Computer Vision 2018.

[7] M. Keuper, E. Levinkov, N. Bonneel, G. Lavou′e, T. Brox, B. Andres. "Efficient decomposition of image and mesh graphs by lifted multicuts", ICCV 2015.

[8] P. Weinzaepfel, J. Revaud, Z. Harchaoui, C. Schmid. "DeepFlow: large displacement optical flow with deep matching", In ICCV 2013.

[9] S. Tang, M. Andriluka, B. Andres, and B. Schiele. Multiple People Tracking with Lifted Multi-cut and Person Re-identification. In CVPR, 2017.

[10] C. Kim, F. Li, and J. M. Rehg, "Multi-object Tracking with Neural Gating Using Bilinear LSTM", in ECCV 2018.

-

算法

+關(guān)注

關(guān)注

23文章

4607瀏覽量

92828 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5500瀏覽量

121111

原文標(biāo)題:深度多目標(biāo)跟蹤算法綜述

文章出處:【微信號:IV_Technology,微信公眾號:智車科技】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

視頻跟蹤目標(biāo)跟蹤算法簡介(上海凱視力成信息科技有限...

多目標(biāo)優(yōu)化算法有哪些

一種適用于空間觀測任務(wù)的實(shí)時(shí)多目標(biāo)識別算法分享

基于聚類融合的多目標(biāo)跟蹤算法

多傳感器多目標(biāo)跟蹤的JPDA算法

改進(jìn)霍夫森林框架的多目標(biāo)跟蹤算法

深度學(xué)習(xí):多目標(biāo)跟蹤方向調(diào)研報(bào)告

新技術(shù)可有效地使用目標(biāo)檢測的對抗示例欺騙多目標(biāo)跟蹤

新型基于深度學(xué)習(xí)的目標(biāo)實(shí)時(shí)跟蹤算法

多目標(biāo)跟蹤過程中的數(shù)據(jù)關(guān)聯(lián)技術(shù)綜述

基于卷積特征的多伯努利視頻多目標(biāo)跟蹤算法

最常見的目標(biāo)跟蹤算法

基于MobileNet的多目標(biāo)跟蹤深度學(xué)習(xí)算法

多目標(biāo)跟蹤算法總結(jié)歸納

基于深度學(xué)習(xí)的多目標(biāo)跟蹤算法技術(shù)

基于深度學(xué)習(xí)的多目標(biāo)跟蹤算法技術(shù)

評論