11月7日,在烏鎮第五屆世界互聯網大會上,小米面向智能家居的人工智能開放平臺(即小愛同學)成功入選”世界互聯網領先科技成果”,恰好我這幾天也在學習AI語音助手相關的知識,借此從時間維度談談我的一點認識。

一、AI語音助手的歷史大事記

2010年4月28日,蘋果公司完成了對Siri公司的收購,Siri從App Store中下架,并取消了所有除iOS平臺外的軟件研發;2014年4月2日至4日,在美國加利福尼亞州舊金山舉行的微軟Build開發者大會上,微軟全球副總裁喬北峰首度向公眾展示了小娜;2014年11月,亞馬遜宣布將Alexa與Echo合并;2015年9月9日,百度董事長兼首席執行官李彥宏在百度世界大會中推出度秘(Duer);2016年5月19日,Google在Google I/O大會上發布了Google Assistant;2017年7月26日,小米發布的首款人工智能(AI)音箱的喚醒詞及二次元人物形象小愛同學;2018年5月9日,Google在Google I/O大會上發布了Google Duplex;2018年8月15日,亞馬遜和微軟聯合宣布,雙方已完成各自語音助手Alexa和Cortana的整合。

二、AI語音助手的現狀——拼場景

場景一:連接硬件生態

由于語音交互核心環節上的一系列技術突破及人工智能公司提供的ToB解決方案,AI語音助手開始逐漸在技術層面上滿足人們的基本要求。

以小愛同學為例:它的語音和語義技術主要來自于多家合作伙伴,包括:Nuance、搜狗知音、思必馳、獵戶星空、聲智科技、海知智能、三角獸等。

語音識別技術(ASR)的接口,用的是思必馳、Nuance 與搜狗的(現在小米似乎是在自研)。自然語言理解(NLP)等關于語義方面的技術,由小米大腦親自來做。前端的麥克風陣列以及降噪方案,是由聲智科技提供的。語音合成技術,是由獵戶星空提供的。很大程度上,自然語言解析技術已經逐漸不再成為各家廣義智能助理產品的核心競爭力,識別用戶意圖之后所提供的服務開始成為對話機器人差異化的核心。而在這個時候,國內公司中再次抓住頭部紅利的正是小米。

不得不說雷軍真的是一個非常有大勢思維的企業家,總能恰如其分地踩上時代紅利,正如他所說:“一個人要做成一件事情,其實本質上不是在于你多強,而是你要順勢而為,于萬仞之上推千鈞之石”。

他踩著智能手機大換代、消費升級、網紅電商的紅利撐起了小米,這次他又抓住了人工智能目前布局最廣泛的智能硬件生態。

在評選世界互聯網領先科技成果獎的介紹中,小米人工智能開放平臺是這么定義的:

小米人工智能開放平臺,是一個以智能家居需求場景為出發點,深度整合人工智能和物聯網能力,為用戶、軟硬件廠商和個人開發者提供智能場景及軟硬件生態服務的開放創新平臺。

著名產品人梁寧在《產品思維三十講》中分析了小米的三級火箭模式:

一級火箭:小米手機,是小米的頭部流量,不為掙錢,雷軍也承諾小米硬件的綜合利潤率永遠不會超過5%(根據小米的上市招股說明書,雷軍在這一塊真的沒有說謊)。

二級火箭:小米手機拉動的一系列零售場景,小米商城、米家、小米之家、小米小店(小米11月18日將會在英國倫敦的Westfield mall落地在英國市場的第一家門店也是用MI8 pro打頭陣,并逐步開放其它商品和渠道)。

三級火箭:是一個高利潤產品,原文說“現在雷總還不愿意說出來”。

從小米上市招股說明書中的募集資金用途(小米計劃將30%募集資金用于研發及開發智能手機、電視、筆記本電腦、人工智能音箱等核心產品;30%用于全球擴展;30%用于擴大投資及強化生活消費品與移動互聯網產業鏈;剩下的10%用作日常經營)。

從小米高層和雷軍的發言中可以知道:小米的三級火箭應該就是AI+IOT,能真正撐起小米的利潤以及智能化未來。

根據世界互聯網大會給出的數據:

截至2018年7月,小米投資或孵化了超過220家生態鏈公司,全球已有超過1.15億智能設備與小米IoT平臺連接,小米的AI語音服務-小愛同學月活躍用戶超過3000萬,單月喚醒超過10億次

在與硬件生態的連接上,小愛同學可以說有著得天獨厚的先發優勢。

場景二:連接軟件生態

(1)打通操作系統場景

與手機操作系統MIUI的深度結合使得小愛同學能夠實現手機中的通用指令功能,并且在現有技術范圍內去發覺一些非常實用的優化功能。對于手機操作系統上的通用功能,小愛同學可以直接調用執行,比如最常見的設定鬧鐘等。

而對于不提供接口的手機APP,小愛同學可以通過虛擬按鍵操作模擬用戶執行,個人覺得最有趣的操作就是讓小愛打開微信上某人的朋友圈。你可試試對小愛同學說:“打開XXX的朋友圈”,然后可以看到手機在自動一步一步執行以下操作:

進入微信->進入搜索頁面->進入聊天頁面->進入聊天信息頁面->進入個人主頁->進入朋友圈

我在使用其他手機進行對比時是沒有辦法實現這個功能的,可見小米在打造產品的時候真的是想盡辦法在技術邊界內盡可能地滿足用戶需求。

(2)打通外部軟件接口

你可以試試對小愛同學說:“打開美團點外賣”,你會發現它可以和美團自帶的小美智能助理會進行無縫對接,在進入美團后順利讓小美來接管你的后續需求。這是在軟件生態中非常和諧的一種合作模式。

三、AI語音助手的未來

讓形象更可感——Gatebox

Gatebox是日本公司vinclu專門為宅男打造的一款全息影像人工智能管家,可以說日本人民是真的會玩,你可以去官網感受一下他們的宣傳片

第一個畫面,宅男在公司加班,Hikari Azuma通過Line發去了消息,“你記得今天是什么日子嗎?什么時候回來?”宅男說,“馬上回來!”Hikari Azuma:“好棒!”,隨手打開了家里的燈,等待主人回家。宅男回家后,Hikari Azuma立馬甜蜜問候:“歡迎回來。”然后羞答答地說:“今天是我們住在一起三個月紀念日,你記得嗎?”宅男立馬拿出了禮物,Hikari Azuma看到之后開心地鼓掌。宅男準備好食物和酒,開始慶祝時,Hikari Azuma把家里的燈光系統調節成了溫馨浪漫的風格。最后,宅男和Hikari Azuma舉起酒杯,互相感謝對方的陪伴。視頻最后的一句話寫著:Living with characters(和二次元老婆一起生活)。

不少中國同胞在youtube上呼吁雷軍趕緊把這個公司買下,在中國用感動人心的價格福利大眾,哈哈。

根據梅拉比安模型:感情表達=內容7%+語調語氣38%+表情肢體語言55%,所以僅靠語言文字遠遠不夠,甚至像Google Duplex做到分辨不出說話者是AI還是人也還不夠,長期來說,更重要的會是“多模態交互”。

在Gatebox的交互中,比如調低燈光亮度時,她會擺出朝燈呼氣的動作,詢問天氣時,她又會做出側身展示天氣預報的動作。小愛同學是首個正式發布人工智能虛擬形象的AI語音助手,“米娘”的形象也受眾多米粉們喜愛,如果真的能把成本降下來的話,相信會有蠻多人(尤其是宅男們)入坑的。

退而求其次,就算不做全息影像,做一個平面投影也是可以的嘛。

讓關系更自然——Replika

Replika是Luka Inc.公司開發的一款Chatbot,據說初衷是為了緬懷兩位創始人在車禍中失去的摯友,通過搜集他生前的社交聊天預料來創建一位虛擬人。

拋開它作為一款Chatbot與AI語音助手的需求差別,我覺得它設計得非常好的是被稱為“反芻機制”的功能,將你在和它聊天時提到的語料在一段時間間隔之后提取出來,自然地插入到交流當中,感覺就像你跟朋友提起你最近睡眠不好,過了一段時間后朋友會來關心你的近況,感覺非常的貼心。

真的有一種感覺,就像《小王子》里面有一段,小王子對小狐貍說我們一起玩啊,小狐貍回答說我現在還不能和你一起玩,因為我還沒有被馴養。

馴養是指彼此共同投入一段時間,結成一種關系,人類是AI的訓練師,但與此同時,AI其實也在訓練你如何與它進行互動。或許只有這樣,千禧一代的互聯網原住民才能跨過未來與AI原住民之間的鴻溝。小愛同學雖然沒有Chatbot的這種天然場景,但還是有很多落地點的:

智能手機消息欄的推送,比如用戶說:“我最近睡眠不太好。”,小愛會回復:“多鍛煉有助睡眠。”,那么就可以推送“我記得你和我說過你睡眠不太好,小愛為你找到了一些催眠音樂,試試對我說:我想聽催眠音樂”;小愛音箱的對話,由于無法主動開啟對話,可以選擇在識別到用戶當前意圖與語料庫中的語義信息相關時補充對話,比如用戶說:“播放音樂”,小愛會回復:“愛聽歌的人運氣都不會太差哦”,那么可以再回復“我記得你說你注意力很難集中,要不要聽聽我給你推薦的輕音樂?”。

讓對話更真實——Google Duplex

在5月9日的Google I/O大會上,Google Duplex的一句 “umms”著實讓人驚艷,5 月 11 日,谷歌母公司 Alphabet 董事長(前斯坦福校長)John Hennessy 表示,他們還達成了一項里程碑成績 ——Duplex (部分)通過了圖靈測試。

對Google Duplex不了解的朋友,如果能科學上網的話,可以到Google AI Blog上看看Google官方的介紹原文:

以下對Google Duplex的技術認知來源于蟲門科技郭靖的文章,這是我看到的對Google Duplex最深入的分析,感興趣的朋友可以點擊鏈接閱讀原文:

Google Duplex讓對話如此真實主要是體現在兩大塊——自然語言理解與對話模塊、文本轉語音模塊。

(1)文本轉語音模塊

文本轉語音模塊(即語音合成)技術比較明了,在博客中交代得比較清楚,沒有什么懸念。

We use a combination of a concatenative text to speech (TTS) engine and a synthesis TTS engine (using Tacotron and WaveNet) to control intonation depending on the circumstance.我們結合使用聯結式文本到語音(TTS)引擎和綜合TTS引擎(使用Tacotron和WaveNet)來控制語調,具體取決于環境。

(2)自然語言理解與對話模塊

在自然語言理解與對話模塊的具體實現上Google就不是很老實了,只是給了一些比較寬泛的概念。

郭靖在他的文章中給出了以下猜想:

在這個猜想的架構中,用戶的語音通過ASR識別為文字后,會通過預設的規則轉化為形式語言,將重要實體用形式模板代替。

這樣形式化后的文本與語音、上文的形式文本一起送入一個encoder模型,其將這些原始信息編碼成兩個語義信息向量,一個代表本輪用戶的語言,另一個代表上幾輪對話。

同時,通過ASR識別的文本還會與上幾輪對話的文本、通過Google Assistant傳來的條件參數(代表對話的目標,用戶本身的信息等大前提)一起進入另一個網絡,其根據輸入的信息輸出一個代表當前對話狀態信息的向量。

這一網絡很可能具備每一輪對話為一個step的循環結構,意味著這個對話狀態信息的更新會參考前一輪對話狀態的信息。

當然,在拿著錘子找釘子的當下,這一塊就太偏前沿技術了,但是對于AI,對于整個人類歷史,技術始終都是推動發展的源動力。

-

AI語音助手

+關注

關注

0文章

17瀏覽量

4009

發布評論請先 登錄

相關推薦

雷諾下一代車載語音助手Reno將引入生成式AI技術

SoundHound AI語音助手賦能歐洲汽車,引領智能駕駛新風尚

亞馬遜在語音助手的競賽中上遠遠落后

OPPO引領AI手機新時代,全面普及智能生活

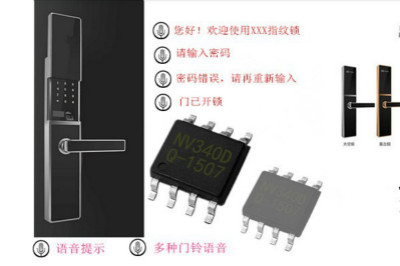

智能門鎖語音IC芯片方案:"XX智能鎖祝您生活愉快"

蘋果宣布基于生成式AI系統的Siri語音助手

蘋果將升級Siri語音助手,引入生成式AI技術

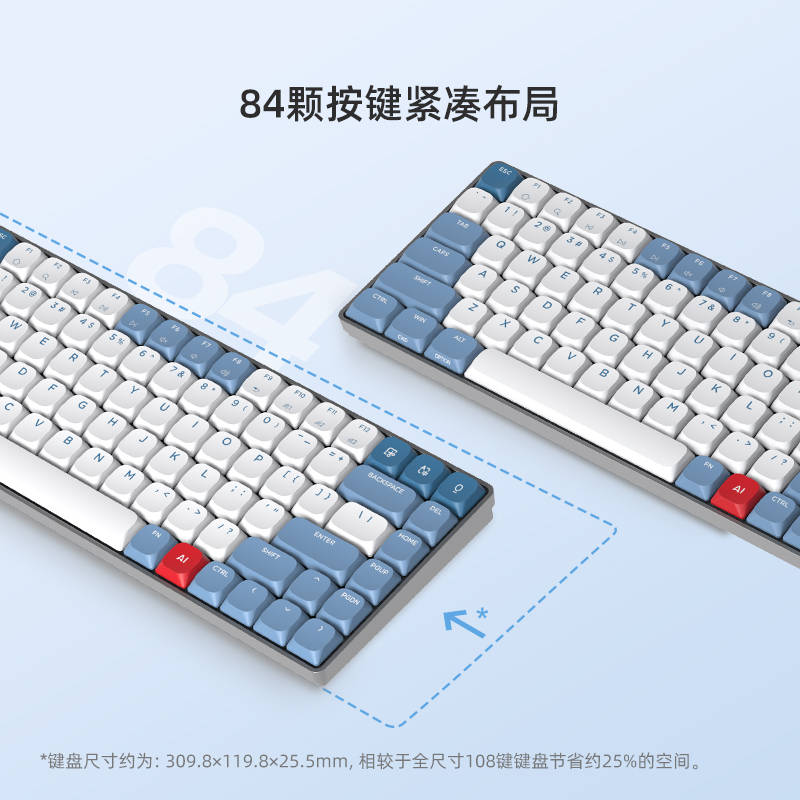

搭載星火認知大模型的AI鼠標:一鍵呼出AI助手,辦公更高效

AI語音助手,助你開啟智能生活

AI語音助手,助你開啟智能生活

評論