這篇文章來自同濟(jì)大學(xué)研究生張子豪的投稿,介紹了人工智能與信息安全的交叉前沿研究領(lǐng)域:深度學(xué)習(xí)攻防對(duì)抗。

本文介紹了如何用對(duì)抗樣本修改圖片,誤導(dǎo)神經(jīng)網(wǎng)絡(luò)指鹿為馬;對(duì) NIPS 2017 神經(jīng)網(wǎng)絡(luò)對(duì)抗攻防賽 3 項(xiàng)冠軍清華團(tuán)隊(duì)的算法模型進(jìn)行了解讀。

文章部分內(nèi)容來自 2018 CNCC 中國計(jì)算機(jī)大會(huì)—人工智能與信息安全分會(huì)場(chǎng)報(bào)告。

GAN 一點(diǎn)都不擼棒,簡(jiǎn)直不要太好騙:胖達(dá)變成猴,山誤認(rèn)為狗

對(duì)抗樣本不是僅在最后預(yù)測(cè)階段產(chǎn)生誤導(dǎo),而是從特征提取過程開始就產(chǎn)生誤導(dǎo)

NIPS 2017 神經(jīng)網(wǎng)絡(luò)對(duì)抗攻防賽中,清華大學(xué)的學(xué)霸們采用了多種深度學(xué)習(xí)模型集合攻擊的方案,訓(xùn)練出的攻擊樣本具備良好的普適性和可遷移性。

全文大約3500字。讀完可能需要好幾首下面這首歌的時(shí)間

胖虎和吳亦凡,邊界是如此的模糊

王力宏和張學(xué)友,看上去竟如此的神似

人臉識(shí)別、自動(dòng)駕駛、刷臉支付、抓捕逃犯、美顏直播…人工智能與實(shí)體經(jīng)濟(jì)深度結(jié)合,徹底改變了我們的生活。神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)貌似強(qiáng)大無比,值得信賴。

但是人工智能是最聰明的,卻也是最笨的,其實(shí)只要略施小計(jì)就能誤導(dǎo)最先進(jìn)的深度學(xué)習(xí)模型指鹿為馬。

大熊貓 = 長臂猿

早在2015年,“生成對(duì)抗神經(jīng)網(wǎng)絡(luò) GAN 之父” Ian Goodfellow 在 ICLR 會(huì)議上展示了攻擊神經(jīng)網(wǎng)絡(luò)欺騙成功的案例。

在原版大熊貓圖片中加入肉眼難以發(fā)現(xiàn)的干擾,生成對(duì)抗樣本。就可以讓 Google 訓(xùn)練的神經(jīng)網(wǎng)絡(luò)誤認(rèn)為它 99.3% 是長臂猿。

阿爾卑斯山 = 狗

2017 NIPS 對(duì)抗樣本攻防競(jìng)賽案例:阿爾卑斯山圖片篡改后被神經(jīng)網(wǎng)絡(luò)誤判為狗、河豚被誤判為螃蟹。

對(duì)抗樣本不僅僅對(duì)圖片和神經(jīng)網(wǎng)絡(luò)適用,對(duì)支持向量機(jī)、決策樹等算法也同樣有效。

那么,具體有哪些方法,可以把人工智能,變成人工智障呢?

人工智障:逃逸攻擊,白盒/黑盒,對(duì)抗樣本

逃逸攻擊可分為白盒攻擊和黑盒攻擊。

白盒攻擊是在已經(jīng)獲取機(jī)器學(xué)習(xí)模型內(nèi)部的所有信息和參數(shù)上進(jìn)行攻擊,令損失函數(shù)最大,直接計(jì)算得到對(duì)抗樣本。

黑盒攻擊則是在神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)為黑箱時(shí),僅通過模型的輸入和輸出,逆推生成對(duì)抗樣本。下圖左圖為白盒攻擊(自攻自受),右圖為黑盒攻擊(用他山之石攻此山之玉)。

對(duì)機(jī)器學(xué)習(xí)模型的逃逸攻擊,繞過深度學(xué)習(xí)的判別并生成欺騙結(jié)果,攻擊者在原圖上構(gòu)造的修改被稱為對(duì)抗樣本。

神經(jīng)網(wǎng)絡(luò)對(duì)抗樣本生成與攻防是一個(gè)非常有(zhuang)趣(bi)且有前景的研究方向。

2018年,Ian Goodfellow 再發(fā)大招,不僅欺騙了神經(jīng)網(wǎng)絡(luò),還能欺騙人眼。

文中提出了首個(gè)可以欺騙人類的對(duì)抗樣本。下圖左圖為貓咪原圖,經(jīng)過對(duì)抗樣本干擾之后生成右圖,對(duì)于右圖,神經(jīng)網(wǎng)絡(luò)和人眼都認(rèn)為是狗。

下圖中,綠色框?yàn)樨埖脑瓐D。左上角顯示了攻擊的目標(biāo)深度模型數(shù)量越多,生成的圖像對(duì)人類來說越像狗。 左下角顯示了針對(duì) 10 個(gè)模型進(jìn)行攻擊而生成的對(duì)抗樣本,當(dāng) eps = 8 的時(shí)候,人類受試者已經(jīng)把它認(rèn)成狗了。

除此之外,人工智能還面臨模型推斷攻擊、拒絕服務(wù)攻擊、傳感器攻擊等多種信息安全挑戰(zhàn)。

人對(duì)抗樣本有多好騙?

對(duì)抗樣本會(huì)在原圖上增加肉眼很難發(fā)現(xiàn)的干擾,但依舊能看得出來和原圖的區(qū)別,下圖左圖為對(duì)抗樣本,右圖為熊貓?jiān)瓐D。

對(duì)抗樣本不是僅在最后預(yù)測(cè)階段產(chǎn)生誤導(dǎo),而是從特征提取過程開始就產(chǎn)生誤導(dǎo). 下圖展示了第147號(hào)神經(jīng)元分別在正常深度學(xué)習(xí)模型和對(duì)抗樣本中的關(guān)注區(qū)域。在正常模型中,第147號(hào)神經(jīng)元重點(diǎn)關(guān)注小鳥的頭部信息。在對(duì)抗樣本中,第147號(hào)神經(jīng)元?jiǎng)t完全被誤導(dǎo)了,關(guān)注的區(qū)域雜亂無章。

同時(shí)也說明,對(duì)抗樣本不是根據(jù)語義生成的,它并不智能。而且,正如接下來講述的,對(duì)抗樣本對(duì)圖片預(yù)處理過程非常敏感,任何區(qū)域截圖、放大縮小、更換模型都很容易讓對(duì)抗樣本失效。

其實(shí),如果你把那張經(jīng)過攻擊篡改之后的大熊貓圖片稍微放大或縮小,或者直接截一部分圖,然后放到其它公開的圖像識(shí)別模型上運(yùn)行(比如百度識(shí)圖),識(shí)別結(jié)果依舊是大熊貓。

這意味著對(duì)抗樣本僅對(duì)指定的圖片和攻擊模型生效,對(duì)諸如區(qū)域截圖、放大縮小之類的預(yù)處理過程是非常敏感的。

也就是說,如果還想欺騙更多其它的深度學(xué)習(xí)模型,就要在訓(xùn)練生成對(duì)抗樣本時(shí)盡可能包含更多的已知深度學(xué)習(xí)模型。

NIPS 冠軍是怎么做的

2017 年,生成對(duì)抗神經(jīng)網(wǎng)絡(luò)(GAN)之父 Ian Goodfellow,牽頭組織了 NIPS 的 Adversarial Attacks and Defences(神經(jīng)網(wǎng)絡(luò)對(duì)抗攻防競(jìng)賽)。

清華大學(xué)博士生董胤蓬、廖方舟、龐天宇及指導(dǎo)老師朱軍、胡曉林、李建民、蘇航組成的團(tuán)隊(duì)在競(jìng)賽中的全部三個(gè)項(xiàng)目中得到冠軍。

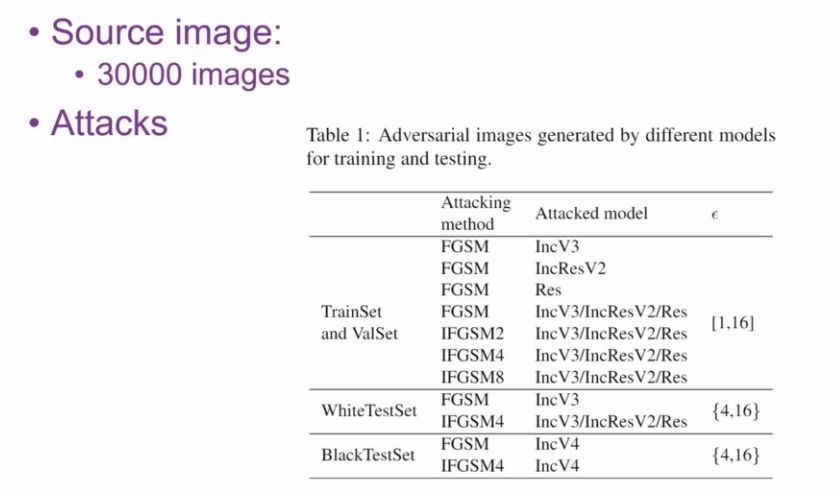

清華大學(xué)團(tuán)隊(duì)正是采用了多種深度學(xué)習(xí)模型集合攻擊的方案,通過對(duì) Image.Net 網(wǎng)站上的三萬張圖片進(jìn)行訓(xùn)練,提出七種攻擊模型。

集合攻擊考慮了 Inception V3、ResNet、Inception ResNet V2 三種已知的深度學(xué)習(xí)模型,訓(xùn)練出的攻擊樣本具備良好的普適性和可遷移性。

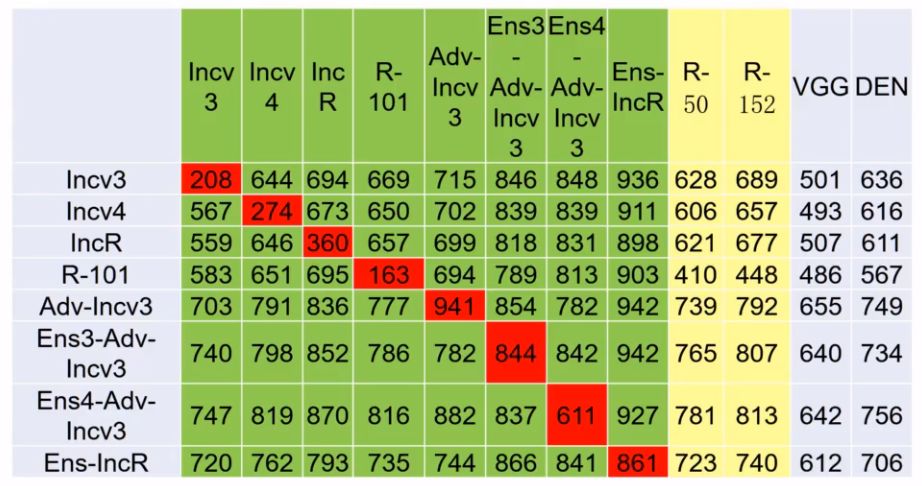

下圖展示了他們使用FGSM模型進(jìn)行攻擊的測(cè)試:

橫行為攻擊模型名稱,豎列為防守模型名稱,表格中的數(shù)字表示對(duì)于每1000張攻擊圖片,防守模型成功防守的圖片數(shù)目,數(shù)字越大,表示豎列模型防守越有效,數(shù)字越小,表示橫行模型進(jìn)攻越有效。

紅色表示用同一個(gè)模型進(jìn)行攻防(白盒攻擊)。可以看出:下面是個(gè)有序序列

白盒攻擊成功率遠(yuǎn)遠(yuǎn)大于黑盒成功率。如何提高黑盒攻擊的可遷移性,實(shí)現(xiàn)跨模型的黑盒攻擊,是一個(gè)重要問題。

由 Adv-Incv3 豎列看出,經(jīng)過對(duì)抗訓(xùn)練之后的防守模型非常強(qiáng)悍。甚至可以達(dá)到 94.1% 的防守成功率。

因此,將對(duì)抗樣本引入訓(xùn)練數(shù)據(jù)集進(jìn)行對(duì)抗訓(xùn)練是有效的防守策略,相當(dāng)于士兵平時(shí)訓(xùn)練的時(shí)候就采用真實(shí)戰(zhàn)場(chǎng)條件,上了戰(zhàn)場(chǎng)自然不慫。

由 Ens4-Adv-Incv3 豎列看出,經(jīng)過多個(gè)模型集合訓(xùn)練之后的防守模型非常強(qiáng)悍。 正所謂“用五岳他山之石攻此山之玉”、“曾經(jīng)滄海難為水”,使用多個(gè)深度模型訓(xùn)練出的防守模型必然是集眾家之長。

防御組:圖像降噪策略

對(duì)抗訓(xùn)練(把真實(shí)戰(zhàn)場(chǎng)作為訓(xùn)練場(chǎng)):在訓(xùn)練模型的時(shí)候就加上對(duì)抗樣本(對(duì)抗訓(xùn)練)。

對(duì)抗樣本隨模型訓(xùn)練的過程在線生成。雖然很耗時(shí),但訓(xùn)練出的模型魯棒性很強(qiáng)

改進(jìn)的HGD降噪算法:像素層面上的去噪并不能真正去掉噪音,傳統(tǒng)的像素去噪方法全都無效。

采用基于CNN的改進(jìn)HGD降噪算法,僅使用750張訓(xùn)練圖片,大大節(jié)省訓(xùn)練時(shí)間,且模型可遷移性好。

NIPS 冠軍是怎么做的

誤導(dǎo)汽車的語音指令

這個(gè)方式已經(jīng)被中國科學(xué)院大學(xué)教授陳愷實(shí)現(xiàn)了。通過對(duì)汽車音響播放的歌曲進(jìn)行干擾編碼,雖然人耳聽起來仍然是原曲,實(shí)際上暗中通過微信的語音,發(fā)送了“Open the door”指令。

本文作者張子豪提出另一種思路,使用樹莓派微型電腦,發(fā)射FM調(diào)頻廣播播放干擾之后的歌曲,直接干擾汽車收音機(jī)。

陳愷表示,已經(jīng)嘗試過該方式,決定干擾成功率的關(guān)鍵還是在于過濾外界噪音干擾。

直接破解本地 AI 模型

360智能安全研究院負(fù)責(zé)人李康認(rèn)為,人工智能與信息安全的下一個(gè)熱點(diǎn):深度學(xué)習(xí)模型參數(shù)被竊取的風(fēng)險(xiǎn)和數(shù)據(jù)安全。

隨著邊緣計(jì)算和智能移動(dòng)終端時(shí)代的到來,在移動(dòng)終端部署本地 AI 應(yīng)用越來越廣泛。從iPhone X的刷臉解鎖,到華為、高通部署手機(jī)端的 AI 芯片。

在移動(dòng)終端本地運(yùn)行 AI 應(yīng)用,可有效解決延遲、傳輸帶寬、用戶隱私泄露等問題,但同時(shí)也帶來本地深度學(xué)習(xí)模型的數(shù)據(jù)安全問題。

經(jīng)過簡(jiǎn)單的逆推,就可以破解很多本地的 AI 應(yīng)用,甚至可以知道其中的 Caffe 模型的基本參數(shù)。

有些開發(fā)者會(huì)采用 AES 加密把模型封裝起來,但殊不知在 AES 密鑰也得保存在本地文件中。

有時(shí)甚至根據(jù)追蹤 AI 應(yīng)用對(duì)內(nèi)存的訪問情況,就可以判斷出這個(gè)模型的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)。

所以 AI 開發(fā)者在向移動(dòng)端和嵌入式設(shè)備中部署 AI 應(yīng)用時(shí),一定要事先請(qǐng)教安全團(tuán)隊(duì),確保模型數(shù)據(jù)安全。

延伸閱讀

NIPS 2017 神經(jīng)網(wǎng)絡(luò)對(duì)抗攻防賽介紹:

比賽分組規(guī)則

比賽為三組選手互相進(jìn)行攻防

Targed Attack 組:組委會(huì)給 5000 張?jiān)瓐D和每張圖對(duì)應(yīng)的目標(biāo)誤導(dǎo)結(jié)果數(shù)據(jù)集,制定要求指鹿為馬

Non-ratgeted Attack 組:只要不認(rèn)不出是鹿就行

Defense 組:正確識(shí)別已經(jīng)被其他參賽組對(duì)抗樣本攻擊的圖片

攻擊組:對(duì)抗樣本生成策略

集合攻擊(他山之石可以攻玉):攻擊多個(gè)已知深度學(xué)習(xí)模型的集合,而不是逐個(gè)擊破。

比方說,把ResNet、VGG、Inception三個(gè)模型視作統(tǒng)一的大模型一起攻擊,再用訓(xùn)練好的模型攻擊AlexNet,成功率就會(huì)大大提高。

可以在模型底層、預(yù)測(cè)值、損失函數(shù)三個(gè)層面進(jìn)行多個(gè)模型的集合攻擊。

采用這個(gè)方法,可以大大提高對(duì)抗樣本攻擊的普適性和可遷移性。

改進(jìn)的FGSM模型:多步迭代、帶目標(biāo)、引入動(dòng)量,大大提高對(duì)抗樣本的可遷移性。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4771瀏覽量

100718 -

人工智能

+關(guān)注

關(guān)注

1791文章

47183瀏覽量

238264 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5500瀏覽量

121113

原文標(biāo)題:GAN一點(diǎn)都不魯棒?清華學(xué)霸們贏得NIPS攻防賽3項(xiàng)冠軍的絕招在這里!

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

神經(jīng)網(wǎng)絡(luò)教程(李亞非)

基于Keras中建立的簡(jiǎn)單的二分類問題的神經(jīng)網(wǎng)絡(luò)模型(根據(jù)200個(gè)數(shù)據(jù)樣本預(yù)測(cè)新的5+1個(gè)樣本)—類別預(yù)測(cè)

卷積神經(jīng)網(wǎng)絡(luò)如何使用

【案例分享】基于BP算法的前饋神經(jīng)網(wǎng)絡(luò)

【案例分享】ART神經(jīng)網(wǎng)絡(luò)與SOM神經(jīng)網(wǎng)絡(luò)

如何用卷積神經(jīng)網(wǎng)絡(luò)方法去解決機(jī)器監(jiān)督學(xué)習(xí)下面的分類問題?

如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?

基于BP神經(jīng)網(wǎng)絡(luò)的PID控制

如何使用stm32cube.ai部署神經(jīng)網(wǎng)絡(luò)?

卷積神經(jīng)網(wǎng)絡(luò)模型發(fā)展及應(yīng)用

神經(jīng)網(wǎng)絡(luò)在雷達(dá)對(duì)抗與反對(duì)抗中的應(yīng)用

神經(jīng)網(wǎng)絡(luò)如何識(shí)別圖片的內(nèi)容?

如何用對(duì)抗樣本修改圖片,誤導(dǎo)神經(jīng)網(wǎng)絡(luò)指鹿為馬

如何用對(duì)抗樣本修改圖片,誤導(dǎo)神經(jīng)網(wǎng)絡(luò)指鹿為馬

評(píng)論