年前,Alphabet 旗下人工智能部門 DeepMind 發布 AlphaZero,稱它可以自學國際象棋、日本將棋和中國圍棋,并且項項都能擊敗世界冠軍。而今天,經過同行評議,AlphaZero 一舉登上《科學》雜志封面。

據此前 DeepMind 在 AlphaZero 的論文中介紹,AlphaZero 使用了完全無需人工特征、無需任何人類棋譜、甚至無需任何特定優化的通用強化學習算法。也就是說,AlphaZero 實質上就是 AlphaGo Zero 的通用化進化版本,它繼續保持了 AlphaGo Zero 中不需要人工特征、利用深度神經網絡從零開始進行強化學習、結合蒙特卡洛樹搜索的特點,并在此基礎上,更新網絡參數,減小網絡估計的比賽結果和實際結果之間的誤差,同時最大化策略網絡輸出動作和蒙特卡洛樹搜索可能性之間的相似度。

然而,在 DeepMind 發布 AlphaZero 之際,AlphaZero 也遭到了某種程度的質疑,例如,一位 AI 研究人員就指出,DeepMind 沒有公開它的 AI 系統源代碼,因此難以檢驗和重復它公布的結果。而如今這項研究成果經過同行評議登上《科學》雜志的首頁,算是得到了證明。有趣的是,AlphaZero 的直接對手——棋手們也紛紛表達了他們的贊許:

例如日本將棋 9 段職業選手、棋史上唯一一位獲得「永世七冠」頭銜的棋士 Yoshiharu Habu 就評價道:

它的一些移動方法,比如將 King 移到棋盤的中心,就違背了日本將棋棋法。從人類的角度來看,AlphaZero 的這種做法似乎已將其置于危險的境地,但令人難以置信的是,它仍然掌控住了棋局。它獨特的下棋風格,讓我們看到了棋法新的可能性。

而前國際象棋世界冠軍 Garry Kasparov 也止不住地稱贊道:

我無法掩飾我的贊許,因為它的下棋風格靈活多變,這跟我自己的風格很像!

一個多世紀以來,象棋一直被用作人類和機器認知的羅塞塔石碑。AlphaZero 以一種獨特的方式,對古代棋盤游戲與前沿科學之間的顯著聯系帶來了新的東西。

其影響遠遠超出了我心愛的棋盤。這些自學成才的專家機器不僅表現得無比出色,而且實際上,我們人類還可以從它們產出的新知識中學習。

正如我們在前面提到的,AlphaZero 是 AlphaGo Zero 的通用化進化版本,而 AlphaGo Zero 又源自于 AlphaGo,接下來我們不妨簡單回顧一下這幾個版本:

最初的 AlphaGo 的工作原理是:

在蒙特卡羅樹搜索(MCTS)的框架下引入兩個卷積神經網絡策略網絡和價值網絡以改進純隨機的蒙特卡羅(Monte Carlo)模擬,并借助監督學習和強化學習訓練這兩個網絡,然后主要靠策略網絡和價值網絡分別預測下一步落子的點以及評估當前的局勢。

而從 AlphaGo 到 AlphaGo Zero,系統的思路和模型結構都得到了大幅度簡化,帶來的是更快的訓練和運行速度,以及更高的棋力。

在更早版本的 AlphaGo 中,策略網絡和價值網絡是兩個不同的深度神經網絡,Zero 版本中是同一個 ResNet 的兩組輸出;

AlphaGo Zero 之前幾個版本中都需要先把局面轉換為高一層的人工特征再作為網絡的輸入、需要先學習人類棋譜再轉變到自我對弈的強化學習、有一個單獨的快速走子網絡進行隨機模擬,而 AlphaGo Zero 則把局面落子情況直接作為網絡的輸入、由隨機的網絡權值直接開始強化學習、舍棄快速走子網絡直接用主要的神經網絡模擬走子。

接著從 AlphaGo Zero 到 AlphaZero,發生的變化主要體現在如下幾個方面:

第一,AlphaGo Zero 會預計勝率,然后優化勝率,其中只考慮勝、負兩種結果;AlphaZero 則會估計比賽結果,然后優化達到預計的結果的概率,其中包含了平局甚至別的一些可能的結果。

第二,由于圍棋規則是具有旋轉和鏡像不變性的,所以專為圍棋設計的 AlphaGo Zero 和通用的 AlphaZero 就有不同的實現方法。AlphaGo Zero 訓練中會為每個棋局做 8 個對稱的增強數據;并且在蒙特卡洛樹搜索中,棋局會先經過隨機的旋轉或者鏡像變換之后再交給神經網絡評估,這樣蒙特卡洛評估就可以在不同的偏向之間得到平均。國際象棋和日本象棋都是不對稱的,以上基于對稱性的方法就不能用了。所以 AlphaZero 并不增強訓練數據,也不會在蒙特卡洛樹搜索中變換棋局。

第三,在 AlphaGo Zero 中,自我對局的棋局是由所有之前的迭代過程中出現的表現最好的一個版本生成的。在每一次訓練迭代之后,新版本棋手的表現都要跟原先的表現最好的版本做對比;如果新的版本能以超過 55% 的勝率贏過原先版本,那么這個新的版本就會成為新的「表現最好的版本」,然后用它生成新的棋局供后續的迭代優化使用。相比之下,AlphaZero 始終都只有一個持續優化的神經網絡,自我對局的棋局也就是由具有最新參數的網絡生成的,不再像原來那樣等待出現一個「表現最好的版本」之后再評估和迭代。這實際上增大了訓練出一個不好的結果的風險。

第四,AlphaGo Zero 中搜索部分的超參數是通過貝葉斯優化得到的。AlphaZero 中直接對所有的棋類使用了同一套超參數,不再對每種不同的棋做單獨的調節。唯一的例外在于訓練中加在先前版本策略上的噪聲的大小,這是為了保證網絡有足夠的探索能力;噪聲的大小根據每種棋類的典型可行動作數目做了成比例的縮放。

將 AlphaGo 發展到 Alpha Zero,DeepMind 無疑是帶給了我們驚喜的。使用人工特征的 AlphaGo Fan 在出山之戰中便全勝打敗樊麾,還發出第一篇論文;運行在 50 塊 TPU 上的 AlphaGo Lee 以 4:1 的戰績擊敗李世石,還創作了紀錄片并上映;接著只用 4 塊 TPU 的 AlphaGo Master 又在烏鎮圍棋峰會上以 3:0 擊敗柯潔,打碎了人類所有擊敗 AlphaGo 幻想;再又有拋棄人工特征和所有人類高手棋局的 AlphaGo Zero 靠自學成功超越了「前輩」AlphaGo Master。而現在,DeepMind 帶來的這個更通用的、能下各種棋類的、而且在圍棋中的表現更上一層樓的通用強化學習模型——「AlphaZero」,則給我們帶來了更上一層的驚喜。

正如此前對AlphaZero 的報道中所總結的那樣:在 AlphaGo 的一路進化中,我們見證了 DeepMind 的工程師們對深度強化學習本質的思考和嘗試,也看到了不斷的優化中帶來的無需先驗知識、降低資源消耗、提高訓練速度等等可喜的技術進步。而本次 AlphaZero 登上《科學》雜志封面,也算是對他們所作出的嘗試和帶來的技術進步的一種回應。接下來DeepMind 還將讓Alpha Zero 進化到什么哪個版本呢?讓我們期待一下吧~

-

神經網絡

+關注

關注

42文章

4771瀏覽量

100719 -

人工智能

+關注

關注

1791文章

47183瀏覽量

238265 -

DeepMind

+關注

關注

0文章

130瀏覽量

10848

原文標題:AlphaZero 榮登《科學》雜志封面

文章出處:【微信號:worldofai,微信公眾號:worldofai】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

玻色量子亮相2024年《國家科學評論》物理與信息科學前沿論壇

《AI for Science:人工智能驅動科學創新》第6章人AI與能源科學讀后感

AI for Science:人工智能驅動科學創新》第4章-AI與生命科學讀后感

《AI for Science:人工智能驅動科學創新》第一章人工智能驅動的科學創新學習心得

是否能將libwebsokets移植到ESP8266上利用libwebsokets進行網絡應用開發?

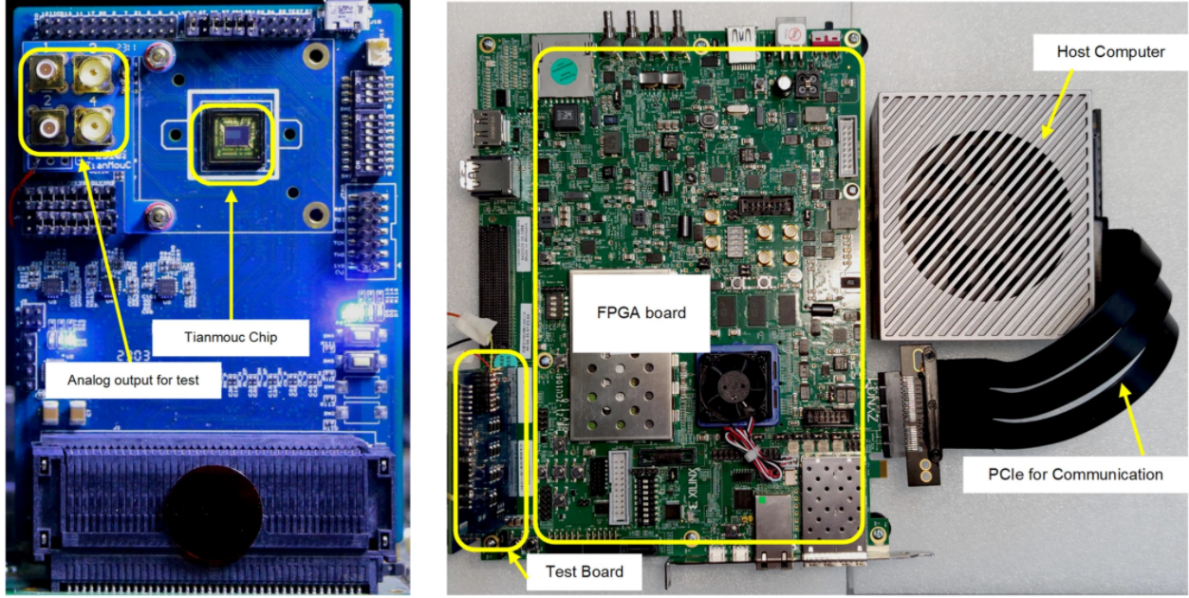

清華類腦視覺芯片取得重大突破,“天眸芯”登上Nature封面

立足河套!深開鴻一舉拿下兩項權威認證

AlphaZero一舉登上《科學》雜志封面

AlphaZero一舉登上《科學》雜志封面

評論