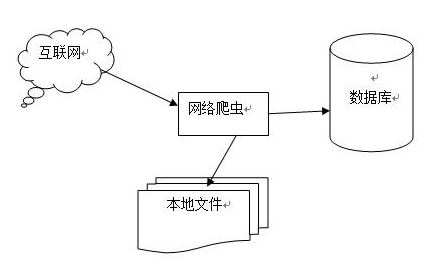

最近想在工作相關的項目上做技術改進,需要全而準的車型數據,尋尋覓覓而不得,所以就只能自己動手豐衣足食,到網上獲(竊)得(取)數據了。

汽車之家是大家公認的數據做的比較好的汽車網站,所以就用它吧。(感謝汽車之家的大大們這么用心地做數據,仰慕)

俗話說的好,“十爬蟲九python”,作為一只java狗,我顫顫巍巍地拿起了python想要感受一下scrapy的強大。。。

在寫這個爬蟲之前,我用urllib2,BeautifulSoup寫了一個版本,不過效率太差,而且還有內存溢出的問題,作為python小白感覺很無力,所以用scrapy才是正道。

嗯,開搞。

準備工作

安裝python,版本是2.7

安裝scrapy模塊, 版本是1.4.0

參考

汽車之家車型數據爬蟲[https://github.com/LittleLory/codePool/tree/master/python/autohome_spider]:這是我工程的代碼,以下內容需要參照著代碼來理解,就不貼代碼在這里了。

Scrapy中文文檔:這是Scrapy的中文文檔,具體細節可以參照文檔。感謝Summer同學的翻譯。

Xpath教程:解析頁面數據要用到xpath的語法,簡單了解一下,在做的過程中遇到問題去查一下就可以了。

初始化工程

scrapy工程的初始化很方便,在shell中的指定目錄下執行scrapy start startproject 項目名稱,就自動化生成了。

執行這步的時候遇到了一個問題,拋出了異常"TLSVersion.TLSv1_1: SSL.OP_NO_TLSv1_1",解決方法是執行sudo pip install twisted==13.1.0,應該是依賴庫版本不兼容。

目錄結構

工程初始化后,scrapy中的各個元素就被構建好了,不過構建出來的是一副空殼,需要我們往里邊寫入我們的爬蟲邏輯。

初始化后的目錄結構是這樣的:

spiders:爬蟲目錄,爬蟲的爬取邏輯就放在個目錄下邊

items.py:數據實體類,在這里定義我們爬到的數據結構

middlewares.py:爬蟲中間件(我自己翻譯的哈),在這里定義爬取前、爬取后需要處理的邏輯

pipelines.py:數據管道,爬取后的數據實體會經過數據管道的處理

settings.py:配置文件,可以在這里配置爬蟲的爬取速度,配置中間件、管道是否開啟和先后順序,配置數據輸出的格式等。

了解過這些文件的作用后就可以開始寫爬蟲了。

開始吧!

首先,確定要爬取的目標數據。

我的目標是獲取汽車的品牌、車系、車型數據,先從品牌開始。

在汽車之家的頁面中尋覓一番后,找到了一個爬蟲的切入點,汽車之家車型大全。這個頁面里有所有品牌的數據,正是我的目標。不過在觀察的過程中發現,這個頁面里的品牌數據是在頁面向下滾動的過程中延遲加載的,這樣我們通過請求這個頁面不能獲取到延遲加載的那部分數據。不過不要慌,看一下延遲加載的方式是什么樣的。

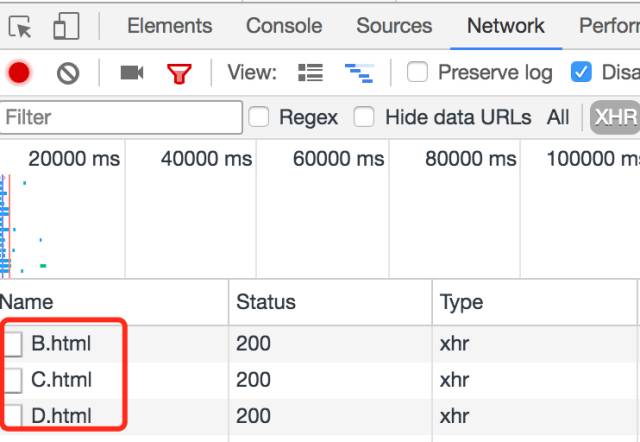

打開瀏覽器控制臺的網絡請求面板,滾動頁面來觸發延遲加載,發現瀏覽器發送了一個異步請求:

復制請求的URL看看:

http://www.autohome.com.cn/grade/carhtml/B.html

http://www.autohome.com.cn/grade/carhtml/C.html

http://www.autohome.com.cn/grade/carhtml/D.html

找到規律了,每一次加載的URL,都只是改變了對應的字母,所以對A到Z分別請求一次就取到了所有的品牌數據。

打開http://www.autohome.com.cn/grade/carhtml/B.html看下,發現頁面的數據很規整,是按照品牌-廠商-車系的層級組織的。嗯,正合我意,那就開爬吧。

編寫Spider

在spiders目錄下邊,新建一個brand_spider.py文件,在文件中定義BrandSpider類,這個類繼承了scrapy.Spider類,這就是scrapy的Spider類。在BrandSpider中,需要聲明name變量,這是這個爬蟲的ID;還需要聲明start_urls,這是爬蟲的起點鏈接;再定義一個parse方法,里面實現爬蟲的邏輯。

parse方法的入參中,response就是對start_urls中的鏈接的請求響應數據,我們要爬取的品牌數據就在這里面,我們需要從response中提取出來。從response提取數據需要使用xpath語法,參考上邊的xpath教程。

提取數據之前,需要先給品牌數據定義一個實體類,因為需要把品牌數據存到數據實體中并落地到磁盤。在items.py文件中定義一個BrandItem類,這個類繼承了scrapy.Item類,類中聲明了爬取到的、要落地的品牌相關數據,這就是scrapy的Item類。

定義好品牌實體后,在parse方法中聲明一個BrandItem實例,然后通過reponse.xpath方法取到想要的品牌ID、品牌url、品牌名稱、圖標url等數據,并設置到BrandItem實例中,最后通過yield來聚合爬取到的各個品牌數據并返回,返回的數據會進入pipeline。

編寫Pipeline

爬取到的數據接著被pipeline.py文件中定義的Pipeline類處理,這個類通常是對傳入的Item實體做數據的清洗、排重等工作,可以定義多個Pipeline,依次對Item處理。由于暫時沒有這方面的需要,就不改寫這個文件,保持默認狀態就好。經過pipeline的處理后,數據進入數據集。

輸出csv格式數據

對于爬取到的車型數據,我想以csv的格式輸出,并且輸出到指定目錄下,此時需要修改settings.py文件。

在settings.py中添加FEED_FORMAT = 'csv'和FEED_URI = 'data/%(name)s_%(time)s.csv'兩項,目的是指定輸出格式為csv,輸出到data目錄下,以”爬蟲名稱_爬取時間.csv“格式命名。

執行爬蟲

品牌數據的爬蟲編寫完成了,在項目根目錄下執行scrapy crawl brand,不出意外的話,在執行了brand爬蟲后,會在data目錄下出現一個新的csv文件,并且裝滿了品牌數據。

小心被屏蔽

不過需要注意一個問題,就是當爬蟲高頻地請求網站接口的時候,有可能會被網站識別出來并且屏蔽掉,因為太高頻的請求會對網站的服務器造成壓力,所以需要對爬蟲限速。

在settings.py中添加DOWNLOAD_DELAY = 3,限制爬蟲的請求頻率為平均3秒一次。

另外,如果爬蟲發送的請求頭中沒有設置user agent也很容易被屏蔽掉,所以要對請求頭設置user agent。

在項目根目錄下新建user_agent_middlewares.py文件,在文件中定義UserAgentMiddleware類,繼承了UserAgentMiddleware類。在UserAgentMiddleware中聲明user_agent_list,存放一些常用的user agent,然后重寫process_request方法,在user_agent_list中隨機選取user agent寫入請求頭中。

車系、車型爬蟲

車系爬蟲與上邊的品牌爬蟲類似,實現在spiders/series_spider.py中。

車型爬蟲稍微復雜一些,實現在spiders/model_spider.py中。車型爬蟲要從頁面中解析出車型數據,同時要解析出更多的URL添加到請求隊列中。而且,車型爬蟲爬取的頁面并不像品牌數據頁面那么規整,所以要根據URL的特征以及頁面中的特征來調整解析策略。因此在這里用到了CrawlSpider和Rules,具體參照Spider文檔。

總結

以上就實現了一個簡單的汽車之家的車型數據爬蟲,其中用到了scrapy中的部分元素,當然還有很多元素沒有涉及到,不過對于一個簡單爬蟲來說足矣。

Tip

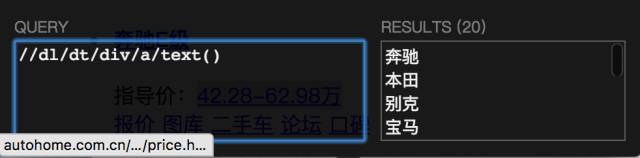

在用xpath解析頁面的時候,寫出來的xpath語句很可能與預期不符,而且調試起來很麻煩,我是用以下方式來提高效率的:

使用chrome上的XPath Helper插件。安裝好插件,打開目標頁面,按command+shift+x(mac版的快捷鍵)打開插件面板,在面板里輸入xpath語句,就能看到取到的結果了:

使用scrapy shell調試。在工程目錄下執行scrapy shell http://www.xxxxx.xx,之后就會進入python的交互終端,這時就可以進行調試了。執行print response.xpath('xxxxx')來驗證xpath語句是否符合預期。

-

瀏覽器

+關注

關注

1文章

1022瀏覽量

35330 -

URL

+關注

關注

0文章

139瀏覽量

15328 -

python

+關注

關注

56文章

4792瀏覽量

84628

原文標題:Python神技能 | 使用爬蟲獲取汽車之家全車型數據

文章出處:【微信號:magedu-Linux,微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

如何使用Python爬蟲獲取汽車之家全車型數據

如何使用Python爬蟲獲取汽車之家全車型數據

評論