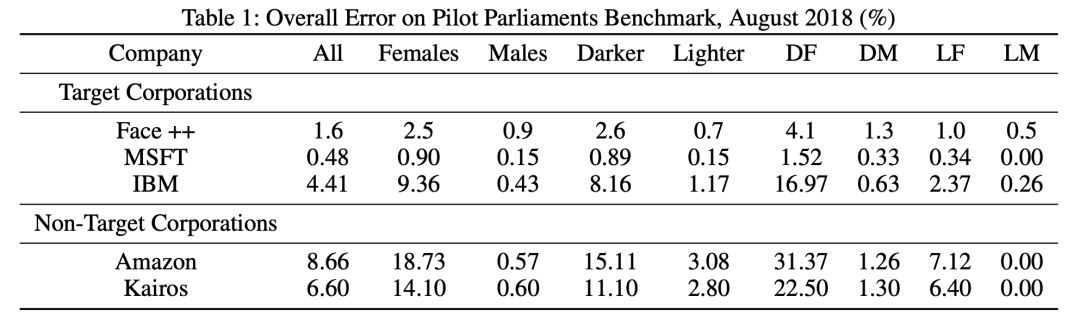

MIT的研究表明,亞馬遜與其它友商在人臉識(shí)別技術(shù)相比,誤識(shí)率較高,將黑皮膚女性識(shí)別成男性的概率高達(dá)31%。而亞馬遜方面回應(yīng)稱,他們所采用的是人臉分析,而非人臉識(shí)別,其最新Rekognition產(chǎn)品的準(zhǔn)確率很高。

根據(jù)MIT公布的一項(xiàng)研究表明,與微軟和IBM的人臉識(shí)別技術(shù)相比,亞馬遜在識(shí)別深色皮膚女性的性別方面較弱,且識(shí)別整體性別時(shí)也更容易出錯(cuò)。

論文地址:

http://www.aies-conference.com/wp-content/uploads/2019/01/AIES-19_paper_223.pdf

根據(jù)這項(xiàng)研究,亞馬遜的Rekognition軟件把女性識(shí)別為男性的概率為19%,將黑皮膚女性識(shí)別成男性的概率為31%,相比之下,微軟只有1.5%的概率。

亞馬遜辯稱是人臉分析,而不是人臉識(shí)別,作者深表懷疑

AWS人工智能總經(jīng)理Matt Wood表示,該研究的測試結(jié)果是基于人臉分析(facial analysis),而不是人臉識(shí)別。

他說,分析可以在視頻或圖像中找到人臉,并賦予其一般性屬性,比如佩戴眼鏡。而識(shí)別是將人臉與視頻和照片中的圖像相匹配。 Rekognition技術(shù)包括這兩種功能。

Wood在一份聲明中說:“基于面部分析得出的結(jié)果,我們不可能對(duì)任何用例的面部識(shí)別準(zhǔn)確性做出結(jié)論。”

Wood補(bǔ)充說:“該研究沒有使用最新版本的Rekognition。而在使用最新版本的該軟件和相似數(shù)據(jù)的情況下并沒有發(fā)現(xiàn)誤報(bào)。”

這項(xiàng)研究的兩位作者Deborah Raji和Joy Buolamwini表示,她們了解面部識(shí)別和面部分析之間的區(qū)別。

Raji說:“我們在論文中明確指出,我們選擇評(píng)估的任務(wù)是二元性別分類的面部分析任務(wù)。這就意味著,在給定一定數(shù)量需要被測的人臉時(shí),模型對(duì)它所看到的內(nèi)容能夠理解多少。”

Buolamwini提醒人們,當(dāng)公司說他們有完全準(zhǔn)確的系統(tǒng)時(shí),需要保持一個(gè)懷疑態(tài)度。

Buolamwini寫道:“Wood的公司使用了超過100萬張臉作為基準(zhǔn)來測試他們的面部識(shí)別能力,并且表現(xiàn)良好。雖然他們在這一基準(zhǔn)上的表現(xiàn)似乎值得稱贊,但我們不知道這一基準(zhǔn)的詳細(xì)數(shù)據(jù)或表型(皮膚類型)組成。沒有這些信息,我們就無法評(píng)估種族、性別、膚色或其他類型的誤差。”

“濫用”低準(zhǔn)確率的人臉識(shí)別,后果不堪設(shè)想

盡管公民自由組織、國會(huì)議員和亞馬遜自己的員工都提出對(duì)隱私問題的擔(dān)憂,但亞馬遜還是向執(zhí)法機(jī)構(gòu)提供了Rekognition。本月早些時(shí)候,一群股東還呼吁亞馬遜停止向政府機(jī)構(gòu)出售其識(shí)別技術(shù)。

根據(jù)MIT的研究,Buolamwini說亞馬遜繼續(xù)向執(zhí)法機(jī)構(gòu)出售技術(shù)是“不負(fù)責(zé)任的”。她說,面部分析技術(shù)可能會(huì)被濫用,并且應(yīng)用到許多場景中,造成大規(guī)模的監(jiān)控。此外,其識(shí)別的不準(zhǔn)確性可能會(huì)導(dǎo)致無辜的人被誤認(rèn)為罪犯。

Raji也有同感。她說:“如果該系統(tǒng)因?qū)μ囟ㄈ巳旱臏?zhǔn)確性降低而錯(cuò)誤地識(shí)別了嫌疑人,這可能會(huì)造成嚴(yán)重的危害。”

-

人臉識(shí)別

+關(guān)注

關(guān)注

76文章

4011瀏覽量

81859 -

亞馬遜

+關(guān)注

關(guān)注

8文章

2650瀏覽量

83318

原文標(biāo)題:MIT發(fā)文質(zhì)疑:亞馬遜人臉識(shí)別錯(cuò)誤率爆表,誤識(shí)率高達(dá)31%

文章出處:【微信號(hào):aicapital,微信公眾號(hào):全球人工智能】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評(píng)論請先 登錄

相關(guān)推薦

人臉識(shí)別技術(shù)的可行性在于矛盾具有什么性

人臉識(shí)別技術(shù)的優(yōu)缺點(diǎn)有哪些

人臉識(shí)別技術(shù)將應(yīng)用在哪些領(lǐng)域

人臉識(shí)別技術(shù)的原理介紹

如何設(shè)計(jì)人臉識(shí)別的神經(jīng)網(wǎng)絡(luò)

人臉識(shí)別模型訓(xùn)練流程

人臉識(shí)別模型訓(xùn)練是什么意思

人臉檢測和人臉識(shí)別的區(qū)別是什么

人臉檢測與識(shí)別的方法有哪些

人臉識(shí)別設(shè)備安裝在門上的應(yīng)用和優(yōu)勢

8寸人臉識(shí)別終端 人臉考勤門禁一體機(jī)

人臉識(shí)別終端 10寸人臉機(jī)

小區(qū)無感人臉識(shí)別門禁攝像機(jī),多人同時(shí)識(shí)別通過 #人臉識(shí)別 #智能攝像機(jī)

MIT質(zhì)疑亞馬遜人臉識(shí)別錯(cuò)誤

MIT質(zhì)疑亞馬遜人臉識(shí)別錯(cuò)誤

評(píng)論