北京時間 1 月 25 日凌晨 2 點, DeepMind 直播了他們的 AI AlphaStar 和人類頂尖的職業電競選手對戰星際爭霸 2。根據 DeepMind 介紹,AlphaStar 在 2018 年 12 月 10 日和 19 日先后以 5:0 全勝的戰績擊敗了 2 位國際頂級的人類選手,此次直播的過程中也播放了之前比賽的重放。雖然 AlphaStar 在最后一場現場直播的比賽中惜敗,但是仍然保持對人類 10 勝 1 敗的戰績。

星際在全球玩家眾多,是最流行的一款實時策略游戲之一,而 DeepMind 匯聚了全球最頂尖的人工智能科學家,似乎兩者出現在同一個場景里有些違和。大眾刻板印象里面,科學家一般都與實驗科研為伍,怎么會對玩星際感興趣呢?

其實如果大家對于 DeepMind 這個公司有所了解的話,就會發現這個世界一流的人工智能團隊實際就是一路打游戲過來的。DeepMind 的創始人 Demis Hassabis 自小酷愛國際象棋,13 歲就成為了國際象棋大師。之后他于 2010 年成立 DeepMind,專門開發能夠玩游戲的人工智能。這個時候人工智能領域大火,DeepMind 順勢推出了自己的深度強化學習 (Deep Reinforcement Learning),并于 2014 年在 Atari 游戲里面超過了人類水平。2014 年之后 DeepMind 被 Google 收購,借助 Google 的資源優勢繼續研發,從此在游戲領域一騎絕塵。2016 年和 2017 年 DeepMind 的 AI 先后戰勝圍棋世界冠軍李世石和柯潔。接著 DeepMind 又推出了 AlphaZero,完全不借助人類棋譜,幾個小時之內就在圍棋,國際象棋和日本將棋上超過了人類水平。

DeepMind 之所以對于游戲如此熱衷,除了創始人的游戲情節以外,最關鍵的還是游戲本身就是絕佳的人工智能測試環境。游戲就是人為創造的,用以幫助人來習得某個技能或者測試技能水平的工具。游戲通過提供明確的反饋,使人可以在短期內不斷重復某些行為,從而習得技能。比如很多棋類游戲的設計初衷就是鍛煉分析決策能力。當然也有專門用來讓人獲得愉悅的游戲,比如說許多網絡游戲。這些游戲一般會有很強獎勵(比如獲得金幣之類),獲得獎勵的速度也很快,這就是這類游戲容易讓人沉迷的原因。

回過頭來說星際本身。為什么 DeepMind 的科學家們看中了這么一款游戲呢?原因主要是星際爭霸有這樣兩個特點:

第一星際爭霸的動作空間和策略非常復雜。圍棋雖然每次落子的變化也很多,但是每次畢竟只是需要根據盤面挑選落子地方,還算比較簡單。相對而言,星際爭霸里面的的動作空間就很復雜,玩家需要:

1)積累資源

2)建設工廠

3)組建軍隊

4)消滅對方的工事

每一個動作之間相互有影響,許多動作產生的后果是很長期的

第二玩家沒有全部的信息。基本上來說玩家只知道顯示在屏幕上面的一小部分區域的信息。而真正的地圖是很大。所以如果他們想要知道對手的信息,需要派出專門的偵查兵

為了這次的對戰,DeepMind 其實已經準備已久。去年 DeepMind 和暴雪聯合推出了基于星際爭霸 2 的強化學習測試平臺并且發布了論文《StarCraft II: A New Challenge for Reinforcement Learning》。這次參與對戰的 AI 也是從這個平臺上訓練得到的。這里主要解答一些大家可能關心的問題。AlphaStar 的視角能夠看到的是什么信息?它的操作和人是否一樣?有沒有作弊?

AlphaStar 到底是看到的什么呢?

我們都知道人類玩家在玩星際的時候看到的是計算機屏幕的信息(如果是團戰可能還會有場下交流)。計算機屏幕上面的信息是標準的視頻流。人類玩家首先做的實際上是識別哪個士兵,哪個是工廠。在計算機視覺里面,這些被稱為物體識別和場景識別任務。值得一提的是識別這些人物本身很困難,但和策略的部分關系不大。所以 Deepmind 對問題進行了一些簡化。 AlphaStar 以圖像的方式從游戲引擎里面讀取特征信息,這些圖像直接標記了哪里是兵或者工廠。你可以想象,AlphaStar 有很多只眼睛,有的看到兵,有的看到所有的工廠。除了計算機屏幕上面的信息,AlphaStar 還可以看到一個粗略的全景地圖,可以另外知道一些全局的信息,比如當前有多少資源,多少兵力等等。AlphaStar 看到的視角實際上長得像是下面這個樣子。

那么 AlphaStar 是怎么進行操作呢?

人類玩家都知道玩星際很多時候是拼手速。操作速度快的人基本可以碾壓操作速度慢的人。人類一般一分鐘進行 30 到 300 次操作。最厲害的人類選手大概是每分鐘 500 次操作。理論上計算機的操作速度遠遠超過人類,所以如果不限定操作速度的話,比較基本上沒有意義了。在 DeepMind 發布的工具包里面,操作速度被限制為每分鐘 180 次。除此以外,DeepMind 盡量讓 AlphaStar 的操作和人的操作是一樣的。人類玩家的正常操作一般來說是一個鼠標鍵盤序列。比如說要移動兵的話,人一般會先按 m 代表進入 move 操作,再按 shift 同時點擊要移動的兵。AlphaStar 的操作也會產生類似的序列。

根據上面的信息,我們知道 AlphaStar 的輸入和輸出其實和人類選手是差不多的,并沒有特殊作弊的行為。從這次的比賽視頻來看,AlphaStar 在選擇策略上如同職業選手般嫻熟,非常令人驚嘆。那么 Deepmind 大概是用了什么樣的方法來訓練 AlphaStar 的呢?Deepmind 在賽后發布了一篇博客進行了介紹。據說相應的論文正在同行評議中,相信不久就會將看到細節。這里我結合博客內容和我自己相關的經驗進行下簡單介紹。

Deepmind AI 的深度網絡由多個模塊構成,看起來主要的網絡是一個被稱為 Transformer 和 LSTM 的網絡結構構建。這類網絡最重要的特點就是有很長的記憶能力,可以在很長的序列里面自動找到數據中的關聯,早期這類網絡是在自然語言處理里面成熟的。之所以這次使用這樣的網絡結構,我猜測主要是星際里面的很多動作的影響時間很長,比如說開始建一個工廠到真正這個工廠開始能夠提供物資需要過很久。訓練的過程和初代版的 AlphaGo 類似,結合了有監督學習 (Supervised Learning) 和強化學習 (Reinforcement Learning)。這兩種學習方法其實我們人類也常用 — 有監督學習相當于從課本上面學習,而強化學習像是從實踐中摸索。有監督學習和強化學習并用,就相當一個人先從課本上學習大概知識然后學以致用,在實踐中不斷改進。

在 AlphaStar 中,第一步的訓練是在暴雪提供的數據集上進行的有監督學習。據 DeepMind 稱,經過有監督學習,AlphaStar 對暴雪的內置 AI 能保持 95% 上的勝率。接下來很多經過有監督學習的 AlphaStar 進行聯賽 (League),相互對打,在這個過程中使用強化學習不斷提升能力。下面這個圖展示了這兩個階段水平的提升。

可以看出,有監督學習使得 AlphaStar 達到人類中的金牌水平(Gold Level),在進行了 8 天強化學習之后,AlphaStar 最終超過人類選手 TLO。14 天之后超過了人類選手 MaNa。值得一提的是,在 14 天的強化學習訓練期間,每個 AlphaStar 相當于完成了 200 年的游戲試驗。尤其是多個 AlphaStar 相互對戰,需要的計算量極其巨大。為了加快計算速度 DeepMind 使用了 Google's v3 TPU (向量計算單元)開發了一個分布式訓練系統。TPU (Tensor processing unit) 是 Google 開發的專門用于人工智能的處理器,從 2016 年推出,至今已經演進到第三代。每一個 AlphaStar 智能體使用了 16 塊 三代 TPU,這是相當驚人的計算能力 — 要知道幾個小時滅掉 AlphaGo 的 AlphaZero 在對弈的時候也不過只用了 4 塊一代 TPU。

AlphaStar 之所以能夠使用 TPU 的強大算力,得益于從 16 年起 Deepmind 將主要研究平臺轉移到了 TensorFlow 上面。TensorFlow 是 Google 開發的開源機器學習平臺,如今也是最受歡迎機器學習系統之一。TPU 就是專門為 TensorFlow 開發的硬件。除了 DeepMind 以外,Google 大部分的人工智能系統也都是基于 TensorFlow。

芯片領域有一個摩爾定律,就是計算力隨著時間是指數增長的。其實人工智能領域也有著類似的規律,比如說 AlphaGo 對陣李世石的時候人類尚可一戰,不久之后對戰柯潔人已經完全不在 一個量級。相信隨著時間的前進,AlphaStar 也會不斷的強大,同時在更多的問題上人工智能也會超過人類。許多人因此擔憂人會隨著人工智能的發展人變得多余。其實我們大可不必擔憂,雖然如今人工智能在許多地方取得了不俗的成就,但其本質仍然是人類的工具。人類歷史其實就是一個不斷的發明創造新的工具的歷史,從火的使用,到蒸汽機,再到如今的人工智能,無一不是如此。在新的時代,新的人類必然會懂得如何去使用全新的工具。AlphaStar 的星際爭霸首秀,可能是這個新的時代的又一個序章。回到文初的問題,為什么科學家們會對星際爭霸如此癡迷 — 因為這不僅是游戲里的星際,更是人類的星辰大海。

-

人工智能

+關注

關注

1791文章

47183瀏覽量

238260 -

DeepMind

+關注

關注

0文章

130瀏覽量

10848

原文標題:AlphaStar 星際首秀,人工智能走向星辰大海

文章出處:【微信號:tensorflowers,微信公眾號:Tensorflowers】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

西湖大學:科學家+AI,科研新范式的樣本

AI for Science:人工智能驅動科學創新》第4章-AI與生命科學讀后感

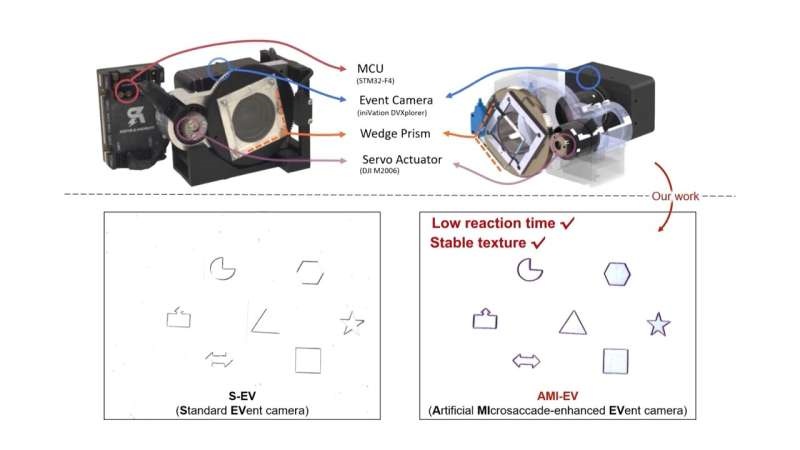

受人眼啟發!科學家開發出新型改良相機

中國科學家發現新型高溫超導體

天津大學科學家突破人類大腦器官成功驅動機器人

新華社:突破性成果!祝賀我國科學家成功研發這一傳感器!

前OpenAI首席科學家創辦新的AI公司

科學家研制出一款新型柔性X射線探測器

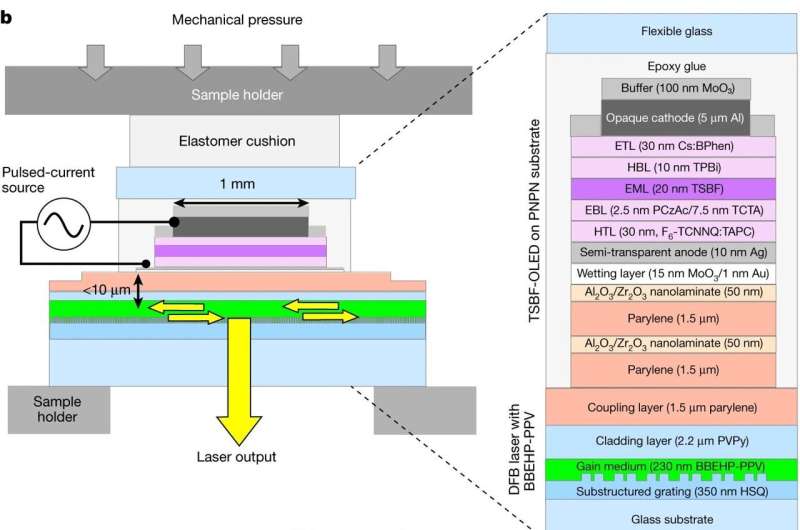

科學家開發電驅動有機半導體激光器

本源量子參與的國家重點研發計劃青年科學家項目啟動會順利召開

谷歌DeepMind推出新一代藥物研發AI模型AlphaFold 3

NVIDIA首席科學家Bill Dally:深度學習硬件趨勢

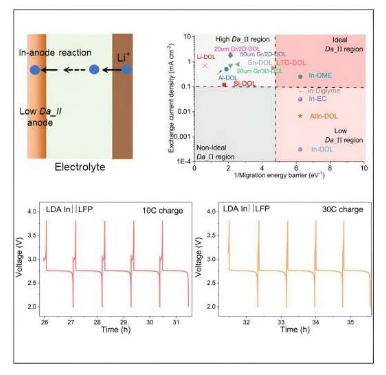

康奈爾大學科學家研制出5分鐘快速充電鋰電池

谷歌DeepMind科學家欲建AI初創公司

飛騰首席科學家竇強榮獲 “國家卓越工程師” 稱號

為什么DeepMind的科學家們對星際爭霸如此癡迷

為什么DeepMind的科學家們對星際爭霸如此癡迷

評論