摘要:我們的視覺看到什么,部分取決于大腦預(yù)測未來會(huì)看到什么。

我們的視覺看到什么,部分取決于大腦預(yù)測未來會(huì)看到什么,例如下圖中,如果你預(yù)計(jì)要看到突出的球體,那也許你就會(huì)看到,如果讓機(jī)器也具有了這樣的能力,會(huì)帶來什么了?

18年谷歌大腦提出“世界模型”(World Models)可以在復(fù)雜的環(huán)境中通過自我學(xué)習(xí)產(chǎn)生相應(yīng)的策略,例如玩賽車游戲。

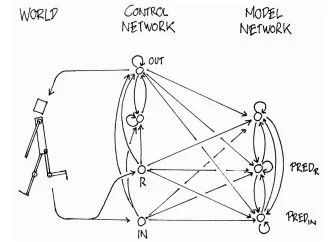

下面是世界模型的整體架構(gòu):

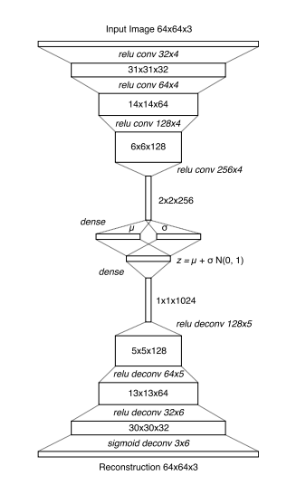

整個(gè)模型分為3個(gè)組件:視覺組件(V),記憶組件(M),控制組件(C)。視覺組件V用來壓縮圖片信息到一個(gè)隱變量z上(其實(shí)只是一個(gè)VAE編碼解碼器):

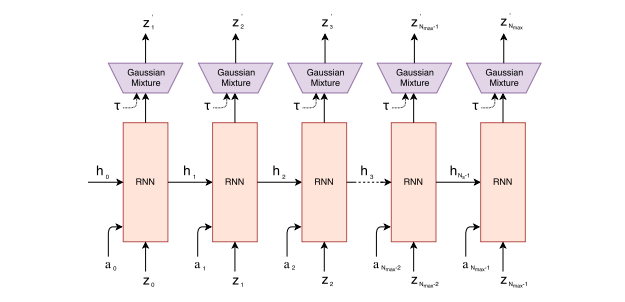

記憶組件M的輸入是一幀幀的游戲圖片(論文中的一幀圖像似乎叫一個(gè)rollout),輸出是預(yù)測下一幀圖像的可能分布,其實(shí)就是比一般LSTM更高級(jí)一些的MDN-RNN:

最后控制組件C的目標(biāo),就是把前面視覺組件V和記憶組件M的輸出一起作為輸入,并輸出這個(gè)時(shí)刻智能體agent應(yīng)該做出的動(dòng)作(action)。

在所謂的“世界模型”,其中的組件模型幾乎沒有是谷歌大腦自己創(chuàng)新研制的。但世界模型會(huì)很大提高強(qiáng)化學(xué)習(xí)訓(xùn)練穩(wěn)定性和成績 從而使其與其他強(qiáng)化學(xué)習(xí)相比有一些明顯優(yōu)勢,如下表所示;

世界模型有如下的3個(gè)特點(diǎn)

1. 模型拼接得足夠巧妙,這個(gè)巧妙的拼接模型做到所謂的世界想象能力,就是模型在學(xué)習(xí)時(shí),自身對(duì)環(huán)境假想一個(gè)模擬的環(huán)境,甚至可以在沒有環(huán)境訓(xùn)練的情況下,自己想象一個(gè)環(huán)境去訓(xùn)練。其實(shí)就是我們?nèi)祟愮R像神經(jīng)元的功能。

2. 抓住了一些“強(qiáng)視覺”游戲的“痛點(diǎn)”。記憶組件M中的RNN是生成序列的能手,所以根據(jù)之前游戲圖像再“想象”一些圖像幀應(yīng)該不成問題(RNN生成一些隱變量z,再根據(jù)隱變量z,由視覺組件VAE的decode生成的圖像幀即可)。所以對(duì)于“強(qiáng)視覺”的游戲,把RNN的記憶能力用在視覺預(yù)測和控制上是個(gè)好主意 。

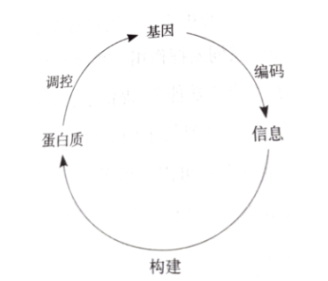

3不同于我們常見的“不可生”智能算法,例如遺傳算法和進(jìn)化策略只是強(qiáng)調(diào)了基因的“變異”與在解空間中進(jìn)行搜索,神經(jīng)網(wǎng)絡(luò)只是固定網(wǎng)絡(luò)結(jié)構(gòu);而生物界的基因卻可以指導(dǎo)蛋白質(zhì)構(gòu)成并且“生長”。如果基因可以構(gòu)造自身個(gè)體,外部環(huán)境和個(gè)體情況也可以反過來影響基因,而我們的模型都太固定呆板了,模型結(jié)構(gòu)不能隨內(nèi)部隱變量改進(jìn),當(dāng)然最佳的設(shè)計(jì)形式也許誰也不知道。而世界模型做到了讓在內(nèi)部”幻想“的環(huán)境中產(chǎn)生的策略轉(zhuǎn)移到外部世界中。

最后簡單看一下世界模型的訓(xùn)練過程:

world models代碼基于chainer計(jì)算框架,步驟如下:

1. 準(zhǔn)備數(shù)據(jù)集,隨機(jī)玩游戲生成訓(xùn)練幀(rollouts意思應(yīng)該就是多少幀):

python random_rollouts.py--gameCarRacing-v0 --num_rollouts10000

2. 訓(xùn)練視覺組件V,即前面提到的VAE:

python vision.py--gameCarRacing-v0 --z_dim32--epoch1

3. 訓(xùn)練記憶組件M,即前面提到的RNN:

python model.py--gameCarRacing-v0 --z_dim32--hidden_dim256--mixtures5--epoch20

4. 訓(xùn)練控制組件C,即前面提到的CMA-ES算法(其實(shí)就是支持更復(fù)雜輸入和更新的ES):

python controller.py--gameCarRacing-v0 --lambda_64--mu0.25--trials16--target_cumulative_reward900--z_dim32--hidden_dim256--mixtures5--temperature1.0--weights_type1[--cluster_mode]

5. 測試訓(xùn)練結(jié)果:

python test.py--gameCarRacing-v0 --z_dim32--hidden_dim256--mixtures5--temperature1.0--weights_type1--rollouts100[--record]