本文是ICLR2019入選論文《AD-VAT: An Asymmetric Dueling mechanism for learning Visual Active Tracking》的深入解讀。該論文由北京大學數字視頻編解碼技術國家工程實驗室博士生鐘方威、嚴汀沄在王亦洲老師和騰訊AI Lab研究員孫鵬、羅文寒的指導下合作完成。該研究也入選了2018騰訊AI Lab犀牛鳥專項研究計劃。

什么是主動視覺跟蹤?

主動視覺跟蹤(Visual Active Tracking)是指智能體根據視覺觀測信息主動控制相機的移動,從而實現對目標物體的跟蹤(與目標保持特定距離)。主動視覺跟蹤在很多真實機器人任務中都有需求,如用無人機跟拍目標拍攝視頻,智能跟隨旅行箱等。要實現主動視覺跟蹤,智能體需要執行一系列的子任務,如目標識別、定位、運動估計和相機控制等。

然而,傳統的視覺跟蹤方法的研究僅僅專注于從連續幀中提取出關于目標的2D包圍框,而沒有考慮如何主動控制相機移動。因此,相比于這種“被動”跟蹤,主動視覺跟蹤更有實際應用價值,但也帶來了諸多挑戰。

右圖:對比基于強化學習的端到端主動跟蹤和傳統的跟蹤方法[1]

深度強化學習方法有前景,但仍有局限性

在前期的工作[1][2]中,作者提出了一種用深度強化學習訓練端到端的網絡來完成主動視覺跟蹤的方法,不僅節省了額外人工調試控制器的精力,而且取得了不錯的效果,甚至能夠直接遷移到簡單的真實場景中工作。

然而,這種基于深度強化學習訓練的跟蹤器的性能一定程度上仍然受限于訓練的方法。因為深度強化學習需要通過大量試錯來進行學習,而直接讓機器人在真實世界中試錯的代價是高昂的。一種常用的解決方案是使用虛擬環境進行訓練,但這種方法最大的問題是如何克服虛擬和現實之間的差異,使得模型能夠部署到真實應用當中。雖然已經有一些方法嘗試去解決這個問題,如構建大規模的高逼真虛擬環境用于視覺導航的訓練,將各個因素(表面紋理/光照條件等)隨機化擴增環境的多樣性。

對于主動視覺跟蹤的訓練問題,不僅僅前背景物體外觀的多樣性,目標運動軌跡的復雜程度也將直接影響跟蹤器的泛化能力。可以考慮一種極端的情況:如果訓練時目標只往前走,那么跟蹤器自然不會學會適應其它的運動軌跡,如急轉彎。但對目標的動作、軌跡等因素也進行精細建模將會是代價高昂的且無法完全模擬所有真實情況。

讓目標與跟蹤器“斗起來”

因此,作者提出了一種基于對抗博弈的強化學習框架用于主動視覺跟蹤的訓練,稱之為AD-VAT(Asymmetric Dueling mechanism for learning Visual Active Tracking)。

在這個訓練機制中,跟蹤器和目標物體被視作一對正在“決斗”的對手(見下圖),也就是跟蹤器要盡量跟隨目標,而目標要想辦法脫離跟蹤。這種競爭機制,使得他們在相互挑戰對方的同時相互促進共同提升。

當目標在探索逃跑策略時,會產生大量多種多樣的運動軌跡,并且這些軌跡往往會是當前跟蹤器仍不擅長的。

在這種有對抗性的目標的驅動下,跟蹤器的弱點將更快地暴露隨之進行強化學習,最終使得其魯棒性得到顯著提升。

在訓練過程中,因為跟蹤器和目標的能力都是從零開始同步增長的,所以他們在每個訓練階段都能夠遇到一個能力相當的對手與之競爭,這就自然得構成了從易到難的課程,使得學習過程更加高效。

然而,直接構造成零和游戲進行對抗訓練是十分不穩定且難以收斂的。

AD-VAT概覽

如何讓對抗更加高效且穩定?

為解決訓練的問題,作者提出了兩個改進方法:不完全零和的獎賞函數(partial zero-sum reward)和用于目標的跟蹤可知模型(tracker-aware model)。

不完全零和獎賞是一種混合的獎賞結構,僅鼓勵跟蹤器和目標在一定相對范圍內進行零和博弈,當目標到達一定距離外時給予其額外的懲罰,此時將不再是零和博弈,因此稱之為不完全零和獎賞。

這么設計獎賞函數是為了避免一個現象,當目標快速遠離跟蹤器時,跟蹤器將不能觀察到目標,以至于訓練過程變得低效甚至不穩定。

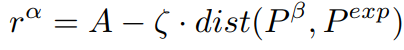

上式為跟蹤器的獎賞函數,沿用了[1]中的設計思想,懲罰項由期望位置與目標之間的距離所決定。

上式為目標的獎賞函數,在觀測范圍內,目標與跟蹤器進行零和博弈,即獎賞函數為跟蹤器的獎賞直接取負。在觀測范圍外,將在原來的基礎上得到一個額外的懲罰項,懲罰項的取值取決于目標與跟蹤器的觀測邊界的距離。

跟蹤可知模型是為了讓目標能夠針對跟蹤策略學會更優的對抗策略,所謂“知己知彼,百戰不殆”。具體的,除了其自身的視覺觀測外,還額外獲得了跟蹤器的觀測和動作輸出作為模型的輸入。

為了更好地學習關于跟蹤器的特征表示,作者還引入了一個輔助任務:預測跟蹤器的即時獎賞值。

基于以上改進,“決斗(Dueling)”雙方在觀測信息、獎賞函數、目標任務上將具備不對稱性(Asymmetric),因此將這種對抗機制稱之為“非對稱決斗(Asymmetric Dueling)”。

實驗環境

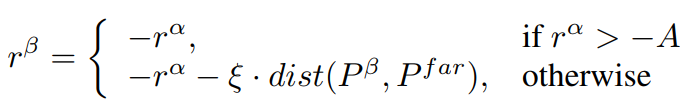

作者在多種不同的2D和3D環境開展了實驗以更進一步驗證該方法的有效性。2D環境是一個簡單的矩陣地圖,用不同的數值分別表示障礙物、目標、跟蹤器等元素。

作者設計了兩種規則生成地圖中的障礙物分布(Block, Maze)。作者設計了兩種基于規則的目標運動模型作為基準:漫步者(Rambler)和導航者(Navigator)。

漫步者是隨機從選擇動作和持續的時間,生成的軌跡往往在一個局域范圍內移動(見Block-Ram中的黃色軌跡)。

導航者則是從地圖中隨機采樣目標點,然后沿著最短路徑到達目標,因此導航者將探索更大范圍(見Block-Nav中的黃色軌跡)。

將這些不同種的地圖和目標依次組合,構成了不同的訓練和測試環境。作者只用其中的一種地圖(Block)用作訓練,然后在所有可能的組合環境中測試,從而證明模型的泛化能力。

3D環境是基于UE4和UnrealCV[3]構建的虛擬環境。作者只用一個采取域隨機技術(環境中物體表面紋理、光照條件都可以進行隨機設置)的房間(DR Room, Domain Randomized Room)進行訓練,然后在三個不同場景的近真實場景中測試模型的性能。

實驗結果

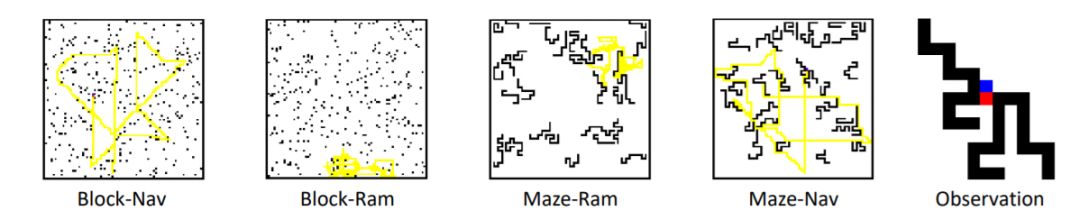

在2D環境中,作者首先驗證了AD-VAT相比基準方法能夠帶來有效提升,同時進行了消融實驗來證明兩個改進方法的有效性。

左圖為AD-VAT(藍線)和基準方法在2D環境中的訓練曲線,可見AD-VAT能夠讓跟蹤器學得更快更好。右圖為消融實驗的結果,對比刪減不同模塊后的學習曲線,作者提出的兩個改進方法能夠使對抗強化學習的訓練更高效。

作者在3D環境中的實驗更進一步證明該方法的有效性和實用性。

在訓練過程中,作者觀測到了一個有趣的現象,目標會更傾向于跑到背景與其自身紋理接近的區域,以達到一種“隱身”的效果來迷惑跟蹤器。而跟蹤器在被不斷“難倒”后,最終學會了適應這些情況。

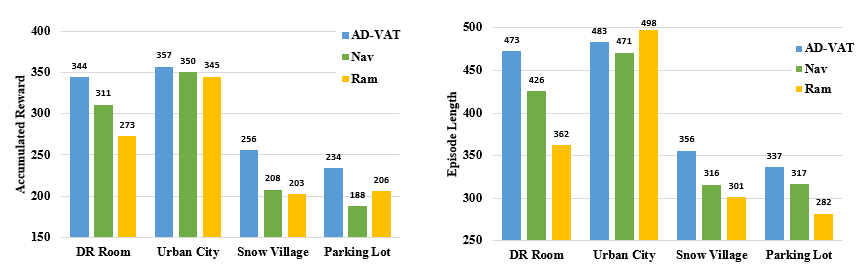

作者對比了由AD-VAT和兩種基準方法訓練的跟蹤器在不同場景中的平均累計獎賞(左圖)和平均跟蹤長度(右圖)。

其中,雪鄉(Snow Village)和地下停車場(Parking Lot)是兩個十分有挑戰性的環境,每個模型的性能都有不同程度的下降,但該論文提出的模型取得了更好的結果,說明了AD-VAT跟蹤器對復雜場景的適應能力更強。

雪鄉主要的挑戰在于地面崎嶇不平,且相機會被下落的雪花、逆光的光暈等因素干擾導致目標被遮擋:

左圖為跟蹤器第一人稱視角,右圖為第三人稱視角

停車場中光線分布不均勻(亮暗變化劇烈),且目標可能被立柱遮擋:

左圖為跟蹤器第一人稱視角,右圖為第三人稱視角

-

跟蹤器

+關注

關注

0文章

131瀏覽量

20026 -

視覺跟蹤

+關注

關注

0文章

11瀏覽量

8796 -

強化學習

+關注

關注

4文章

266瀏覽量

11247

原文標題:ICLR2019 | 你追蹤,我逃跑:一種用于主動視覺跟蹤的對抗博弈機制

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

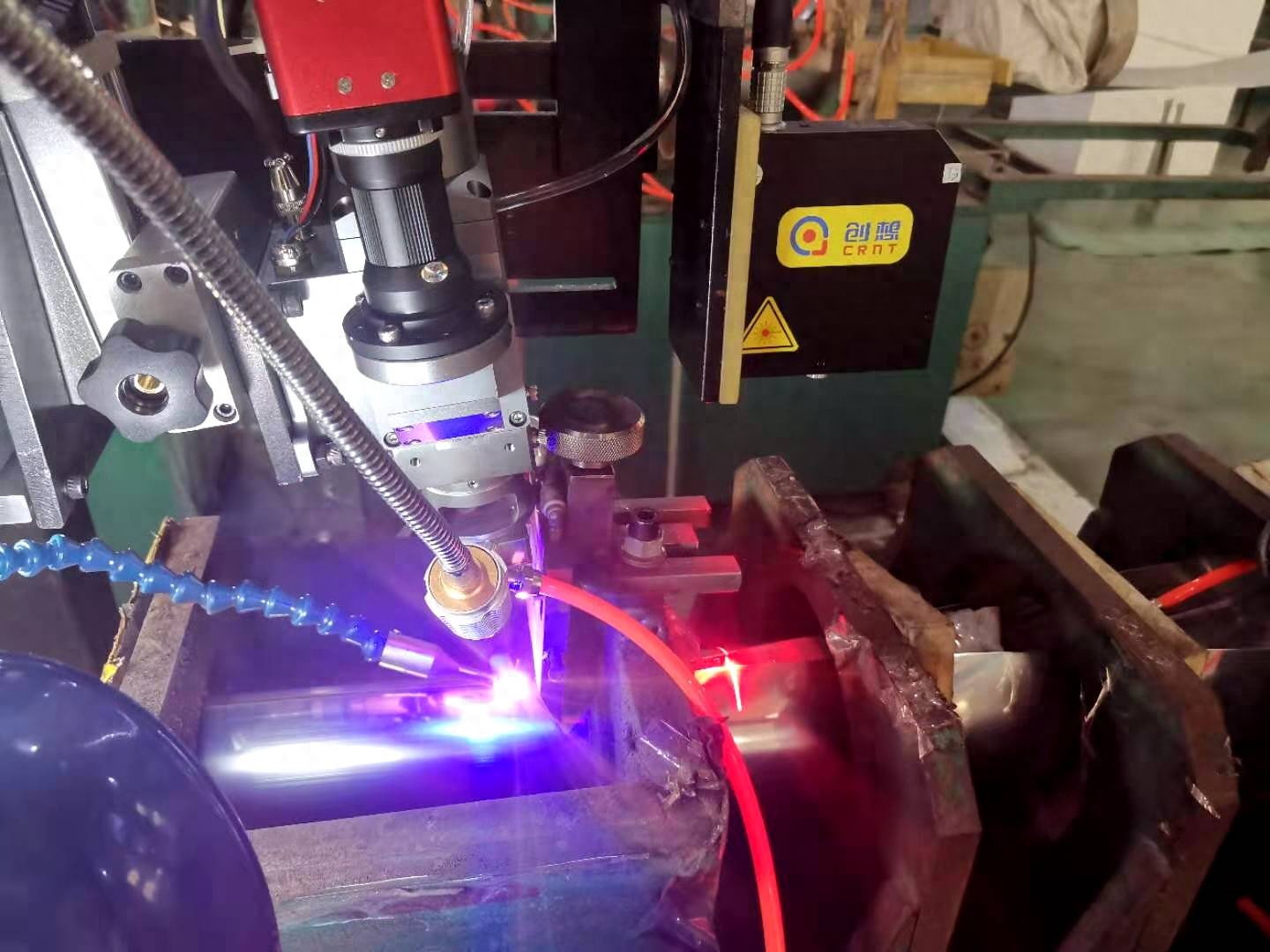

激光焊縫跟蹤器與傳統焊縫檢測方法的對比

深入解析激光焊縫跟蹤器的工作原理與應用優勢

使用TMS320C40 DSP實現單脈沖雷達的數字跟蹤器

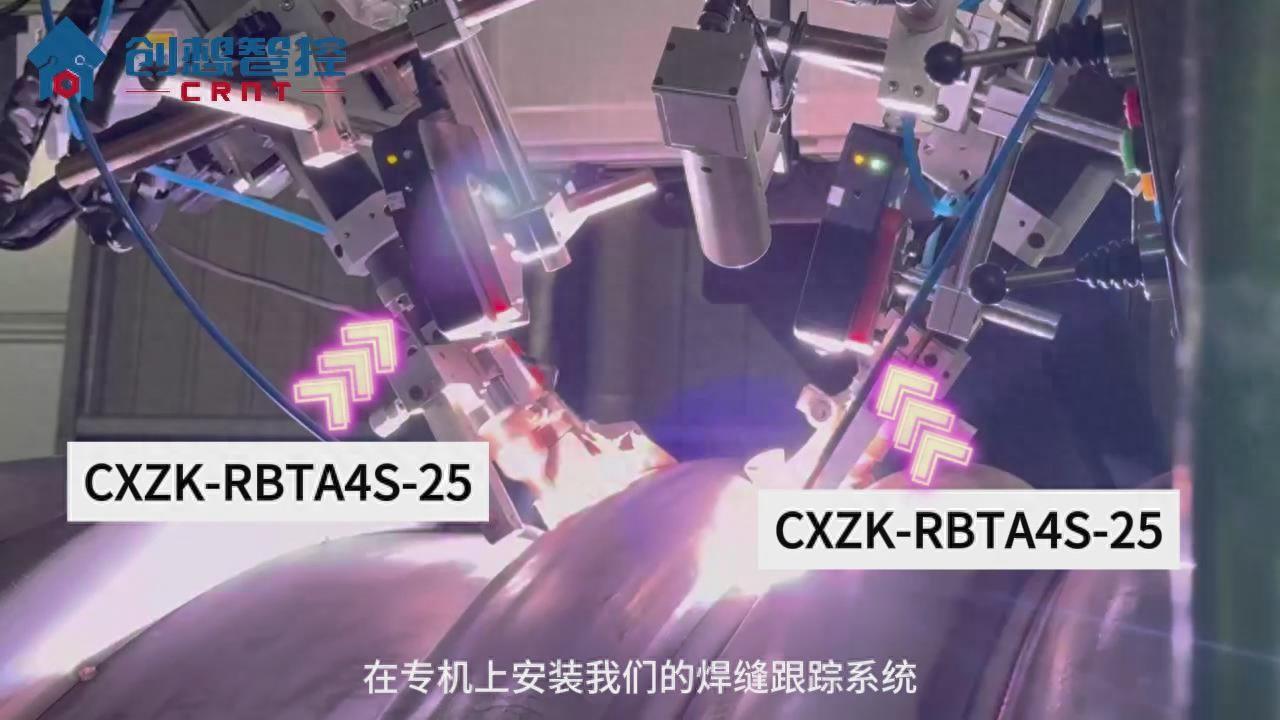

創想智控激光焊縫跟蹤器協同專機在風機高精度自動焊接的應用

光學跟蹤器接口連接方法有哪些

光學跟蹤器信號源手機怎么設置

光學跟蹤器使用的技術有哪幾種

創想智控激光焊縫跟蹤器在醫療攪拌罐反應釜自動焊接的應用

創想智控激光焊縫跟蹤器在機械法蘭盤自動掃描焊接的應用

什么是主動視覺跟蹤?讓目標與跟蹤器“斗起來”

什么是主動視覺跟蹤?讓目標與跟蹤器“斗起來”

評論