NLP方向近日各種大神工具層出不窮。然而,實踐才是硬道理,如何將它們應用到自己的模型是個關鍵問題。本文就對此問題進行了介紹。

近期的NLP方向,ELMO、GPT、BERT、Transformer-XL、GPT-2,各種預訓練語言模型層出不窮,這些模型在各種NLP任務上一次又一次刷新上線,令人心馳神往。但是當小編翻開他們的paper,每一個上面都寫著四個大字:“弱者退散”,到底該怎么將這些頂尖工具用到我的模型里呢?答案是Hugging Face的大神們開源的pytorch-pretrained-BERT。

Github 地址:

https://github.com/huggingface/pytorch-pretrained-BERT

模型簡介

近期的各種預訓練語言模型,橫掃各種NLP任務,這里我們介紹三個最火的預訓練模型:

BERT,由Google AI團隊,發表于2018年10月11日。它的文章是:BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding。

Transformer-XL, 由Google AI和Carnegie Mellon大學,發表于2019年1月9日。它的文章是:Transformer-XL: Attentive Language Models Beyond a Fixed-Length Context。

GPT-2,由OpenAI 團隊,發表于2019年2月14日,它的文章是:Language Models are Unsupervised Multitask Learners。

基本上,每一個文章,都在發表的時候,刷新當時的幾乎所有NLP任務的State-of-the-Art,然后引發一波熱潮。 當然,目前風頭正盛的是GPT-2,它前幾天剛發表。

開源實現

然而,讓小編翻開他們的paper,發現每一個上面都寫著四個大字:“弱者退散”,到底該怎么將這些頂尖工具用到我的模型里呢,Hugging Face 的大神們,緊跟前沿,將所有的預訓練語言模型都實現并開源了。更令人欽佩的是,它們還做了很多封裝,讓大家都可以才在這些巨人模型的肩膀上。

Hugging Face開源的庫叫pytorch-pretained-bert, 你可以在本文開頭找到鏈接。接下來的部分,我們介紹一下它的安裝和使用。

安裝使用

你可以直接使用 Pip install 來安裝它:

pip install pytorch-pretrained-bert

pytorch-pretrained-bert 內 BERT,GPT,Transformer-XL,GPT-2。

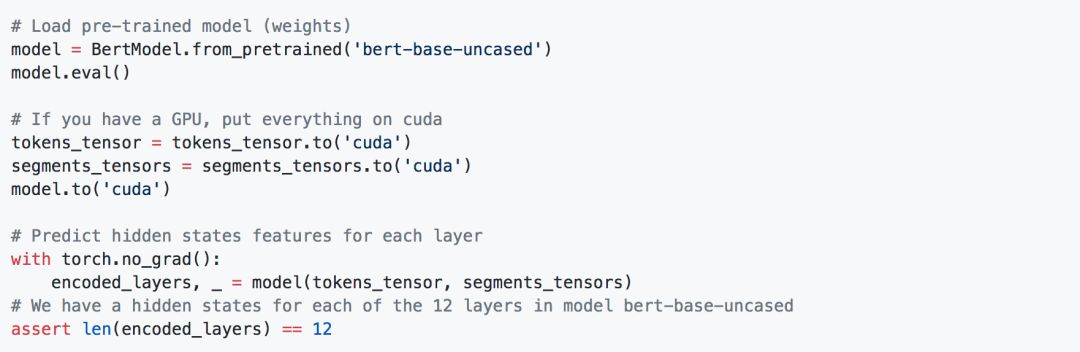

為了獲取一句話的BERT表示,我們可以:

拿到表示之后,我們可以在后面,接上自己的模型,比如NER。

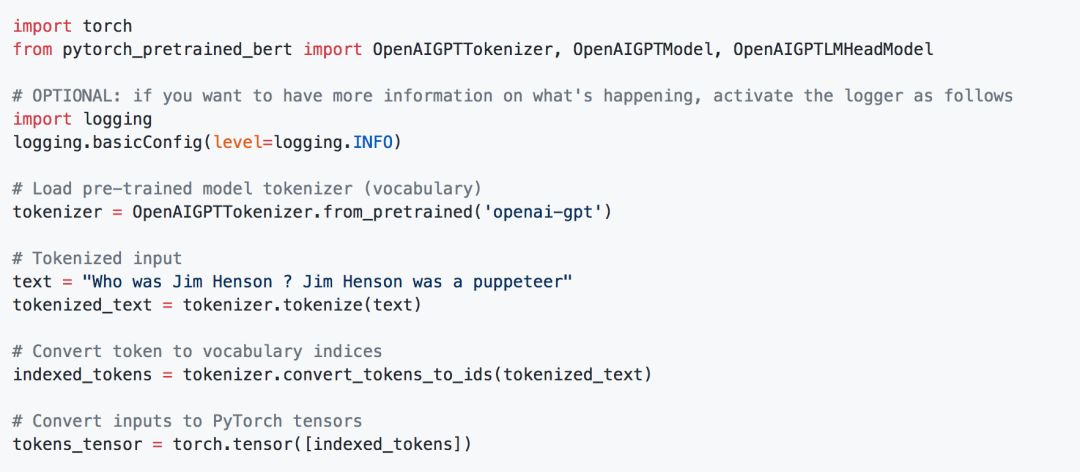

我們也可以獲取GPT的表示:

Transformer-XL表示:

以及,非常火的,GPT-2的表示:

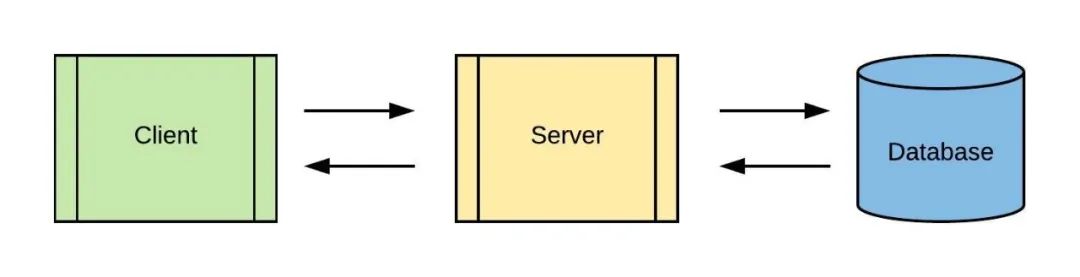

有了這些表示,我們可以在后面,接入自己的模型,比如:

文本分類

https://github.com/huggingface/pytorch-pretrained-BERT/blob/master/examples/run_classifier.py

閱讀理解

https://github.com/huggingface/pytorch-pretrained-BERT/blob/master/examples/run_squad.py

語言模型

https://github.com/huggingface/pytorch-pretrained-BERT/blob/master/examples/run_lm_finetuning.py

等等

-

開源

+關注

關注

3文章

3323瀏覽量

42475 -

語言模型

+關注

關注

0文章

521瀏覽量

10268 -

nlp

+關注

關注

1文章

488瀏覽量

22033

原文標題:BERT、GPT-2這些頂尖工具到底該怎么用到我的模型里?

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

請問AIC3206的一階濾波的頻率到底該怎么計算呢?

這些仿真工具帶有dsp模型

誰能幫我完成這些程序到我的dsPic模型上

無法獲知TIVA里到底有什么函數以及這些函數的用法?

到底什么是密鑰呢?

Env工具到底是什么?怎樣去使用Env工具呢

如何將大模型應用到效能評估系統中去

開源LLEMMA發布:超越未公開的頂尖模型,可直接應用于工具和定理證明

如何將Kafka使用到我們的后端設計中

到底該怎么將這些頂尖工具用到我的模型里呢?

到底該怎么將這些頂尖工具用到我的模型里呢?

評論