最近,OpenAI 發布了一個名為“Neural MMO”的大型多智能體游戲環境,該平臺支持在一個持久開放的任務中使用大量且數量可變的智能體。大量智能體和物種的加入導致了更好的勘探,不同的生態位形成,和更大的整體能力。

近年來,多智能體設置已成為深度強化學習的有效研究平臺。盡管取得了這些進展,多智能體強化學習仍然面臨兩大挑戰。我們需要創建具有高度復雜性上限的開放式任務:當前環境要么復雜但應用面太窄,要么開放但太簡單。持久性和大規模等屬性是關鍵,但是我們還需要更多的基準環境來量化大規模和持久性的學習進度。而這次大型多人在線游戲 (MMOs) 模擬了一個大型生態系統,該系統由數量不等的玩家在持久且廣泛的環境中進行生存競爭。

為了應對這些挑戰,OpenAI 構建了符合以下標準的神經 MMO:

1、持久性: 無需環境重置,智能體在其他學習智能體存在的情況下并發學習。策略必須考慮長期的范圍,并適應其他智能體行為中潛在的快速變化。

2、規模:環境支持大量數量可變的實體。OpenAI 的實驗考慮了在 100 個并發服務器中的每個服務器中 128 個并發智能體的最長 1 億個生存期。

3、效率:入門計算門檻很低。OpenAI 可以在單個桌面 CPU 上訓練出有效的策略。

4、擴展:與現有的 MMO 們類似,OpenAI 設計 Neural MMO 也是為了更新新內容。目前的核心功能包括瓦片地形的程序生成、食物和水的覓食系統以及戰略作戰系統。開源驅動的擴展在未來是有機會的。

在這個游戲環境中,玩家 (智能體) 可以加入任何可用的服務器 (環境),每個服務器 (環境) 都包含一個自動生成的可配置大小的瓦片地形游戲地圖。有些地磚,如可食用的森林地磚和草地磚,是可移動的。其他的,如水和固體石,則不是。智能體程序在環境邊緣的隨機位置生成。他們必須獲得食物和水,并避免戰斗傷害從其他智能體,以維持他們的健康。踩在森林地磚上或靠近水磚的地方,分別會重新填充代理的部分食物或供水。然而,森林地磚的食物供應有限,隨著時間的推移,食物會緩慢再生。這意味著智能體必須競爭食物磚,同時周期性地從無限的水磚中補充他們的水供應。玩家在戰斗中使用三種戰斗風格,代表肉搏(近戰),射手(遠程物理攻擊)和法師(遠程魔法攻擊)。

(來源:OpenAI)

這個平臺提供了一個過程化的環境生成器和可視化工具,用于實現值函數、映射訪問分布和學習策略的智能體依賴性。基線使用超過 100 個世界的策略梯度進行訓練。

作為一個簡單的基線團隊使用普通的策略梯度來訓練一個小型的、完全連接的體系結構,將值函數基線和獎勵折扣作為唯一增強。智能體不會因為實現特定的目標而獲得獎勵,而是只根據其生命周期 (軌跡長度) 進行優化——即在其生命周期中,每一次滴答聲都會獲得 1 個獎勵。團隊通過計算所有玩家的最大值 (OpenAI Five 也使用了這個技巧),將可變長度的觀察值 (比如周圍玩家的列表) 轉換為單個長度向量。源版本基于 PyTorch 和 Ray 實現,包括完全分布式培訓。

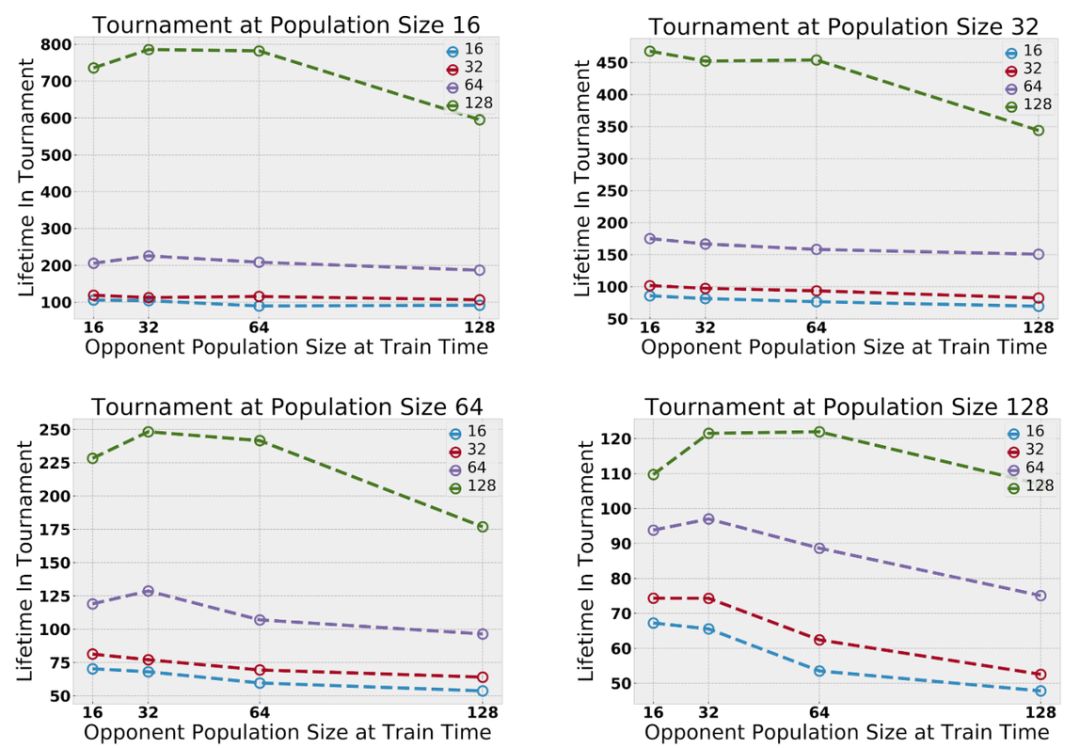

圖丨為了提高效率,策略在由 16 個智能體組成的組之間共享。在測試時,合并在成對實驗中學到的總體,并在一個固定的總體大小下評估生存期,且只對覓食進行評估,因為作戰策略更難直接比較。在更大的人群中訓練出來的智能體總是更優秀(來源:OpenAI)

智能體的策略是從多個種群中均勻采樣的——不同種群中的代理共享架構,但只有相同種群中的智能體共享權重。初步實驗表明,隨著多智能體交互作用的增加,智能體的能力逐漸增強。增加并發玩家的最大數量會放大探索;種群數量的增加放大了生態位的形成,也就是說,種群在地圖不同區域的分布和覓食的趨勢。

在老版本的 mmo 中沒有標準的程序來評估跨服務器的相對玩家能力。然而,MMO 服務器有時會經歷合并,即來自多個服務器的玩家基地被放置在單個服務器中。團隊通過合并在不同服務器上訓練的玩家基礎來實現“錦標賽”風格的評估。這使團隊能夠直接比較在不同實驗環境中學習到的策略。團隊改變了測試時間范圍,發現在較大環境中訓練的智能體始終優于在較小環境中訓練的智能體。

在自然界中,動物之間的競爭促使它們分散開來以避免沖突。OpenAI 觀察到,隨著并發智能體數量的增加,映射覆蓋率也在增加。智能體學習探索僅僅是因為其他智能體的存在提供了這樣做的自然動機。

圖丨物種數量 (種群數量) 放大了生態位的形成。探視地圖覆蓋游戲地圖;不同的顏色對應不同的物種。訓練單一種群往往會產生單一的深度探索路徑。訓練 8 個種群會導致許多更淺的路徑:種群分散以避免物種間的競爭(來源:OpenAI)

在一個足夠大且資源豐富的環境中,團隊發現不同的智能體種群分布在整個地圖上,以避免在種群增長時與其他智能體競爭。由于實體無法在競爭中勝過其人口中的其他智能體 (即與它們共享權重的代理),它們傾向于在地圖上尋找包含足夠資源以維持其人口的區域。DeepMind 在并發多代理研究中也獨立觀察到類似的效果。

圖丨每個正方形映射顯示位于正方形中心的智能體對其周圍的智能體的響應。我們展示了初始化和訓練早期的覓食圖;額外的依賴關系映射對應于不同的覓食和戰斗公式(來源:OpenAI)

OpenAI 通過將智能體固定在假想映射作物的中心來可視化智能體-智能體依賴關系。對于該智能體可見的每個位置,OpenAI 將顯示如果在該位置有第二個智能體,值函數將是什么。OpenAI 發現,在覓食和戰斗環境中,智能體學習依賴于其他智能體的策略。智能體們學習“牛眼”躲避地圖,在僅僅幾分鐘的訓練后就能更有效地開始搜尋。當智能體們學習環境中的戰斗機制時,他們開始學會適當地評估有效的交戰范圍和接近的角度。

總而言之,OpenAI 的 Neural MMO 解決了之前基于游戲環境的兩個關鍵限制,但仍有許多問題沒有解決。未來我們還能期待更多的突破。

-

可視化

+關注

關注

1文章

1195瀏覽量

20955 -

智能體

+關注

關注

1文章

152瀏覽量

10586 -

強化學習

+關注

關注

4文章

267瀏覽量

11262

原文標題:堪稱游戲 AI“養蠱”!OpenAI 發布大型多智能體游戲環境

文章出處:【微信號:deeptechchina,微信公眾號:deeptechchina】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來了

OpenAI的由5個神經網絡組成的OpenAI Five,已經開始擊敗Dota 2的業余玩家隊伍

OpenAI宣布他們的AI僅通過一次人類演示,蒙特祖瑪的復仇游戲中玩出歷史最高分

人工智能挑戰人類,OpenAI機器人打敗游戲玩家

強化學習環境研究,智能體玩游戲為什么厲害

OpenAI剛剛開源了一個大規模多智能體游戲環境

OpenAI發布了一個名為“Neural MMO”的大型多智能體游戲環境

OpenAI發布了一個名為“Neural MMO”的大型多智能體游戲環境

評論