一、介紹

朋友暑假實踐需要美團外賣APP評論這一份數據,一開始我想,這不就抓取網頁源代碼再從中提取數據就可以了嗎,結果發現事實并非如此,情況和之前崔大講過的分析Ajax來抓取今日頭條街拍美圖類似,都是通過異步加載的方式傳輸數據,不同的是這次的是通過JS傳輸,其他的基本思路基本一致,希望那些數據能幫到她吧

二、流程

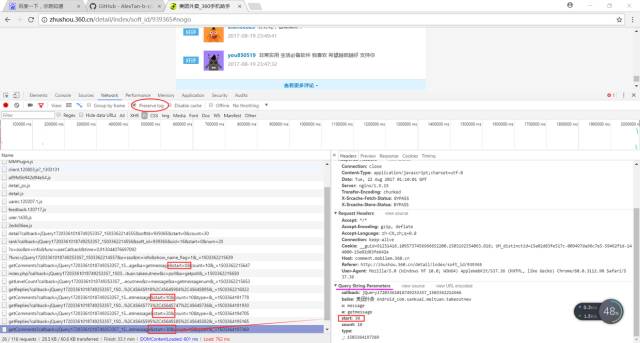

目標站點分析用瀏覽器打開美團外賣APP評論,F12

1.首先我們要找到我們想要的評論數據,在第一次“失敗”的直接抓取網頁源代碼后,我們發現它是通過Ajax加載的,我們點擊JS選項,可以發現JS項目里面的返回結果有我們想要的數據,勾選Preserve log,當點擊查看更多評論時,后臺(JS里)會出現新的Ajax請求,發現還有參數start和的變化,其他請求參數不變,start的參數變化是以10遞增的,的參數變化可就讓人摸不著頭腦(這個時候我們也不要方,因為大多情況下沒有規律的參數都是沒用的)

2.經過我們對http://comment.mobilem.360.cn/comment/getComments?callback=jQuery17203361018749253357_1503362214558&baike=%E7%BE%8E%E5%9B%A2%E5%A4%96%E5%8D%96+Android_com.sankuai.meituan.takeoutnew&c=message&a=getmessage&start=0&count=10&_=1503362215647進行分析后發現它的標準式為‘http://comment.mobilem.360.cn/comment/getComments?&baike=%E7%BE%8E%E5%9B%A2%E5%A4%96%E5%8D%96+Android_com.sankuai.meituan.takeoutnew&start=’+str(i*10),i每次增加1,就包含新的十條評論的內容,所以我們通過改變i的值就可以拿到不同的數據

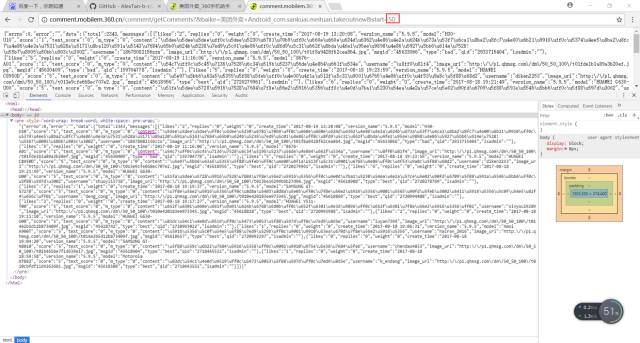

分析url的網頁源代碼,在源代碼里有我們想要的評論數據,我們可以用正則(在這里正則還是比較好用的)把我們想要的信息弄下來

開啟循環,批量抓取

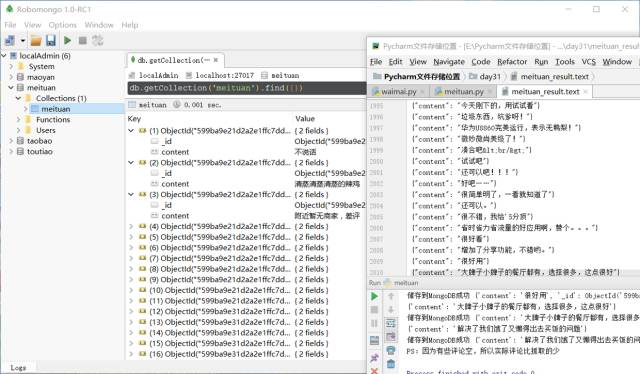

保存數據至文本和數據庫

#之前是這樣處理的:def parse_one_page(html): pattern2 = re.compile('"m_type":"0",(.*?),"username"', re.S) items=re.findall(pattern2,html) for item in items: item = "{" + item + "}" item=json.loads(item) write_to_file(item) print(item) save_to_mongo(item)#皮皮哥告訴了我他的獨家正則匹配方法可以匹配出來,這樣的確獲得的item沒有編碼問題def parse_one_page(html): pattern = '"content":".*?"' items=re.findall(pattern,html) for item in items: item =eval(item.split(':',1)[1]) write_to_file(item) print(item) save_to_mongo(item)#對一般正則寫法獲得的item進行的方法,這是從皮皮哥那里得知的,親測有效def parse_one_page(html): pattern = re.compile('rsion_name".*?"content":(.*?),"username"', re.S) items=re.findall(pattern,html) #print(items) for item in items: item = item.encode('utf-8').decode('unicode_escape') write_to_file(item) print(item) save_to_mongo(item)三、代碼

#config.pyMONGO_URL='localhost'MONGO_DB='meituan'MONGO_TABLE='meituan'

import requestsfrom requests.exceptions import RequestExceptionimport jsonimport refrom day31.config import *import pymongoclient=pymongo.MongoClient(MONGO_URL)db=client[MONGO_DB]base_url='http://comment.mobilem.360.cn/comment/getComments?callback=jQuery17209056727722758744_1502991196139&baike=%E7%BE%8E%E5%9B%A2%E5%A4%96%E5%8D%96+Android_com.sankuai.meituan.takeoutnew&start='def the_url(url): try: response = requests.get(url) if response.status_code==200: response.encoding='utf-8' return response.text return None except RequestException: print('請求出錯') return Nonedef the_total(): html=the_url(base_url) pattern1 = re.compile('"total":(.*?),"messages"', re.S) Total = re.findall(pattern1, html) Total=int(':'.join(Total)) #print(type(Total)) show='總計評論%d條'%Total print(show) write_to_file(show) return Totaldef parse_one_page(html): pattern2 = re.compile('"m_type":"0",(.*?),"username"', re.S) items=re.findall(pattern2,html) for item in items: item = "{" + item + "}" item=json.loads(item) write_to_file(item) print(item) save_to_mongo(item)def save_to_mongo(result): try: if db[MONGO_TABLE].insert(result): print('儲存到MongoDB成功',result) except Exception: print('儲存到MongoDB失敗',result)def write_to_file(content): with open('meituan_result.text','a',encoding='utf-8') as f: f.write(json.dumps(content,ensure_ascii=False)+'\n') f.close()def main(): Total=the_total() Total=int(Total/10)+2 for i in range(Total): url = base_url + str(i*10) if the_url(url)!=None: html=the_url(url) parse_one_page(html) else: print('輸完啦') ps='PS:因為有些評論空,所以實際評論比抓取的少' #這是我瞎猜的 write_to_file(ps) print(ps)if __name__ == '__main__': main()

四、最后得到的數據視圖和文件

五、總結

1.程序報錯很正常,不要一報錯就問別人,先自己思考、百度

2.在數據類型處理方面的知識還要加強

-

源代碼

+關注

關注

96文章

2953瀏覽量

68462 -

python

+關注

關注

56文章

4828瀏覽量

87017

原文標題:中午不知道吃什么?用Python爬取美團外賣評論幫你選餐!

文章出處:【微信號:magedu-Linux,微信公眾號:馬哥Linux運維】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

編譯錯誤: error: unrecognizable insn,不知道原因,請教!

【國產信創CPU全攻略】分享國產CPU品牌排行榜!從排名到避坑!

美光公司DDR,絲印4BC77 D8CJN,是什么型號

探秘京東外賣幕后:地圖&軌跡技術探尋

ADS805E測量跳躍幅度很大,不知道是為什么?

測的值不定然后開始減小直到為0,不知道怎么回事?

想用AMC1203做電流采樣,用AMC1210做SINC濾波,不知道這樣可不可行?

校園點餐訂餐外賣跑腿Java源碼

DAC7714應用于MCBSP模塊,clk與cs都是模塊內部產生的,LD信號不知道怎么給出?

華為Mate系列新品攜手美團外賣首發

關于陶瓷電路板你不知道的事

又一電工不知道,施耐德變頻器怎么復位,如果不告訴你,你知道怎么復位嗎?

評論