昨日,ICCV 2019官方推特發(fā)布消息,公布了今年大會投稿情況:共計接收投稿4328篇,與上屆相比,接收投稿數(shù)量翻倍。根據(jù)目前發(fā)布的數(shù)據(jù),中科院和清華大學(xué)超越微軟、谷歌等,投稿數(shù)量遙遙領(lǐng)先,分別為237篇和175篇。

厲害了!ICCV 2019投稿數(shù)量翻倍!

ICCV (國際計算機(jī)視覺大會),是計算機(jī)視覺方向的三大頂級會議之一,在世界范圍內(nèi)每兩年召開一次。ICCV論文錄用率非常低,是三大會議中公認(rèn)級別最高的。

昨日,ICCV 2019官方推特發(fā)布了今年接收到的論文投稿情況:

推文鏈接:

https://twitter.com/ICCV19/status/1109353497856802816

今年ICCV接收的投稿數(shù)量高達(dá)4328篇,創(chuàng)下了其有史以來的記錄!更值得注意的是,上一屆ICCV的投稿數(shù)量僅是2143篇,今年翻倍!

ICCV 2019中科院、清華投稿數(shù)量遙遙領(lǐng)先

剛剛公布完投稿總數(shù),ICCV 2019官方推特又公布了投稿單位分布情況:

推文鏈接:

https://twitter.com/ICCV19/status/1109735362757312512

新智元對其做了一下簡單的整理:

中國科學(xué)院:237篇;

清華大學(xué):175篇;

微軟:103篇;

谷歌:100篇;

蘇黎世聯(lián)邦理工學(xué)院:99篇;

華為:91篇;

Facebook:85篇;

UC伯克利:82篇;

牛津大學(xué):70篇;

斯坦福:58篇;

MIT:53篇;

Adobe:53篇;

首爾大學(xué):49篇;

韓國先進(jìn)科技學(xué)院:48篇;

百度:47篇;

卡內(nèi)基梅隆大學(xué):45篇;

伊利諾伊大學(xué)厄巴納-香檳分校:39篇;

法國國立計算機(jī)及自動化研究院:36篇;

康奈爾大學(xué):32篇;

Amazon:31篇;

maxplanckpress:29篇;

EPFL_en:25篇;

Apple:1篇。

以上是由ICCV 2019官方推特截止目前發(fā)布的各投稿單位論文投稿數(shù)量的情況。

中科院和清華大學(xué)遙遙領(lǐng)先微軟和谷歌,投稿數(shù)量分別高達(dá)237篇和175篇。國外高校投稿數(shù)量較高的是蘇黎世聯(lián)邦理工學(xué)院和UC伯克利,分別為99篇和82篇。

從企業(yè)角度看,微軟和谷歌投稿數(shù)量較多,分別是103篇和100篇。國內(nèi)企業(yè)華為投稿最多,為91篇;其次是百度,47篇。

從目前公布的投稿數(shù)量來看,中國高校和企業(yè)在今年的ICCV可謂是大放異彩。但正如剛剛提到的,ICCV的論文錄用率非常低,新智元在此也預(yù)祝中國高校和企業(yè)會有一個好的成績!

ICCV 2017大會回顧:崛起的中國

在上一屆大會(即ICCV 2017)中的各種統(tǒng)計數(shù)字中,可能最引人矚目的,是中國崛起。

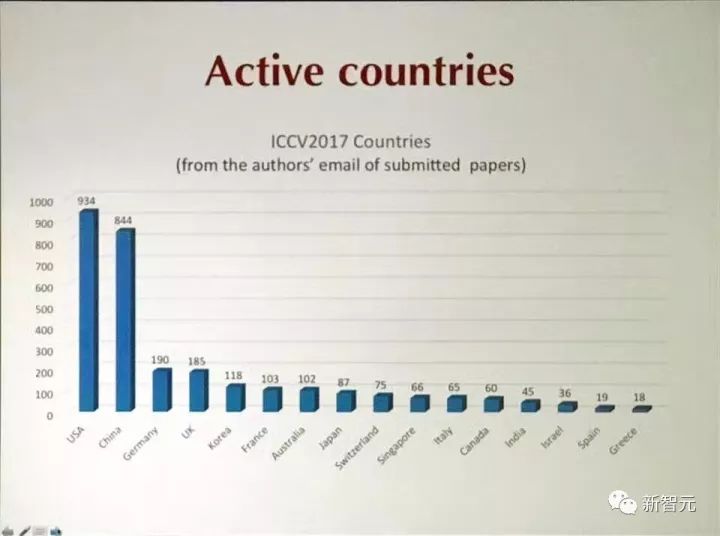

根據(jù)投稿作者的郵箱地址,有844篇論文(將近40%)來自中國,美國以934篇位居第一。看投稿數(shù)量,中美兩國也遙遙領(lǐng)先。

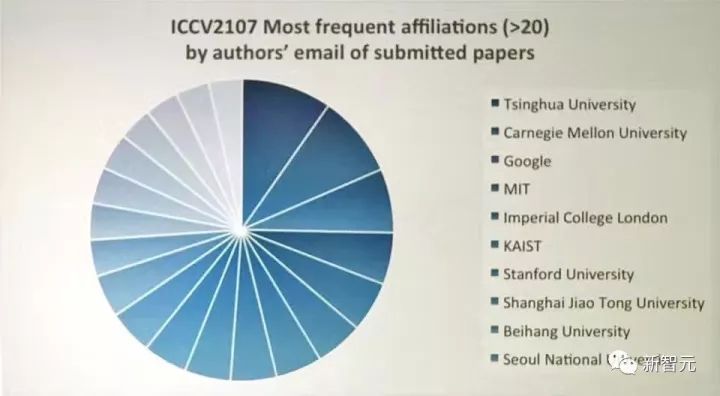

其中,投稿數(shù)量最多的機(jī)構(gòu)是清華大學(xué),超越了CMU,超越了谷歌,超越了MIT。上海交通大學(xué)和北航分別位列第八、第九。

新智元粗略統(tǒng)計,2017年ICCV 接收論文中,有40%的第一作者都是華人。

雖然不盡是華人,我們也在上屆大會主席團(tuán)隊中見到了熟悉的名字,上屆ICCV的大會主席之一是微軟亞洲研究院首席研究員池內(nèi)克史。兩位Workshop Chair,一位是微軟的Sing Bing Kang,另一位是預(yù)定出任CVPR 2019 程序主席的上海科技大學(xué)&特拉華大學(xué)教授虞晶怡。

ICCV 2017 熱詞:新智元對ICCV 2017錄用論文標(biāo)題做了詞頻統(tǒng)計,“深度學(xué)習(xí)”、GAN、識別、檢測依然是熱詞。

當(dāng)然,在上一屆ICCV中,最大的一個亮點(diǎn)無疑是何愷明包攬兩項最佳論文。

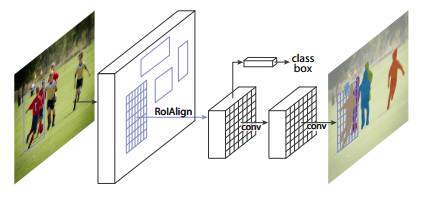

ICCV 2017的最佳論文獎(Marr prize)頒發(fā)給了Facebook AI實驗室(FAIR)何愷明等人的論文《Mask R-CNN》。

ICCV 2017最佳論文頒發(fā)給了Mask R-CNN

論文標(biāo)題非常簡潔,就是“Mask R-CNN”:

摘要

我們提出一個概念上簡單,靈活,通用的物體實例分割框架(object instance segmentation)。我們的方法能有效檢測圖像中的對象,同時為每個實例生成高質(zhì)量的分割掩膜(segmentation mask)。我們將該方法稱為 Mask R-CNN,是在 Faster R-CNN 上的擴(kuò)展,即在用于邊界框識別的現(xiàn)有分支上添加一個并行的用于預(yù)測對象掩膜(object mask)的分支。Mask R-CNN 的訓(xùn)練簡單,僅比 Faster R-CNN 多一點(diǎn)系統(tǒng)開銷,運(yùn)行速度是 5 fps。此外,Mask R-CNN 很容易推廣到其他任務(wù),例如可以用于在同一個框架中判斷人的姿勢。

我們在 COCO 競賽的3個任務(wù)上都得到最佳結(jié)果,包括實例分割,邊界框?qū)ο髾z測,以及人物關(guān)鍵點(diǎn)檢測。沒有使用其他技巧,Mask R-CNN 在每個任務(wù)上都優(yōu)于現(xiàn)有的單一模型,包括優(yōu)于 COCO 2016 競賽的獲勝模型。我們希望這個簡單而有效的方法將成為一個可靠的基準(zhǔn),有助于未來的實例層面識別的研究。

圖1:用于實例分割的 Mask R-CNN 框架

Mask R-CNN 在概念上十分簡單:Faster R-CNN 對每個候選物體有兩個輸出,即一個類標(biāo)簽和一個邊界框偏移值。作者在 Faster R-CNN 上添加了第三個分支,即輸出物體掩膜(object mask)。因此,Mask R-CNN 是一種自然而且直觀的想法。但添加的 mask 輸出與類輸出和邊界框輸出不同,需要提取對象的更精細(xì)的空間布局。Mask R-CNN 的關(guān)鍵要素包括 pixel-to-pixel 對齊,這是 Fast/Faster R-CNN 主要缺失的一塊。

最佳學(xué)生論文也出自 FAIR 團(tuán)隊之手,一作是 Tsung-Yi Lin。值得一提,何愷明也有參與,不愧為大神。

ICCV 2017最佳學(xué)生論文頒發(fā)給了FAIR的《密集物體檢測Focal Loss》

摘要

目前,最準(zhǔn)確的目標(biāo)檢測器(object detector)是基于經(jīng)由 R-CNN 推廣的 two-stage 方法,在這種方法中,分類器被應(yīng)用到一組稀疏的候選對象位置。相比之下,應(yīng)用于規(guī)則密集的可能對象位置采樣時,one-stage detector 有潛力更快、更簡單,但到目前為止,one-stage detector 的準(zhǔn)確度落后于 two-stage detector。在本文中,我們探討了出現(xiàn)這種情況的原因。

我們發(fā)現(xiàn),在訓(xùn)練 dense detector 的過程中遇到的極端 foreground-background 類別失衡是造成這種情況的最主要原因。我們提出通過改變標(biāo)準(zhǔn)交叉熵?fù)p失來解決這種類別失衡(class imbalance)問題,從而降低分配給分類清晰的樣本的損失的權(quán)重。我們提出一種新的損失函數(shù):Focal Loss,將訓(xùn)練集中在一組稀疏的困難樣本(hard example),從而避免大量簡單負(fù)樣本在訓(xùn)練的過程中淹沒檢測器。為了評估該損失的有效性,我們設(shè)計并訓(xùn)練了一個簡單的密集目標(biāo)檢測器 RetinaNet。我們的研究結(jié)果顯示,在使用 Focal Loss 的訓(xùn)練時,RetinaNet 能夠達(dá)到 one-stage detector 的檢測速度,同時在準(zhǔn)確度上超過了當(dāng)前所有 state-of-the-art 的 two-stage detector。

希望在今年的ICCV中,中國高校和企業(yè)依舊能夠大放異彩!

-

微軟

+關(guān)注

關(guān)注

4文章

6603瀏覽量

104153 -

計算機(jī)視覺

+關(guān)注

關(guān)注

8文章

1698瀏覽量

46027 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5506瀏覽量

121260

原文標(biāo)題:ICCV 2019論文投稿翻倍創(chuàng)紀(jì)錄:共計4328篇,中科院與清華遙遙領(lǐng)先

文章出處:【微信號:AI_era,微信公眾號:新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

ADS8671 datasheet里寫的是小信號輸入-3db帶寬為15KHz,是不是意味著正常信號超過10K衰減已經(jīng)很厲害了?

蘋果商城中國市場規(guī)模已翻倍

TPA3130上電一分鐘后發(fā)熱很厲害是怎么回事,如何解決?

使用雙TPA3118做雙聲道,負(fù)芯片無法識別同步,發(fā)熱厲害怎么解決?

TPA3118發(fā)熱厲害,然后電感也發(fā)熱比較厲害,是什么原因?

調(diào)試OPA541AP做的線性電流源時,OPA541AP發(fā)熱很厲害怎么解決?

用運(yùn)放OPA657作為前級跟隨,頻率增大到3M以下就開始衰減,為什么?

使用時VCA820能正常工作,但是發(fā)熱比較厲害,為什么?

光纖跳線的數(shù)量怎么計算

使用OPA1632做一個模擬信號的調(diào)理電路,發(fā)熱比較厲害的原因?

用放大器搭成的光電二極管放大電路,出來的波形信號不太好,這是為什么呢?

功放自激問題如何解決?

用stm32做的foc控制,電機(jī)空載抖動比較厲害的原因?

如何自制CAN調(diào)試器?

厲害了!ICCV 2019投稿數(shù)量翻倍!

厲害了!ICCV 2019投稿數(shù)量翻倍!

評論