我們知道邏輯回歸的損失函數(shù)cost=-ylogo-(1-y)log(1-o),其中o為模型輸出,y為樣本真實(shí)分布,為什么損失函數(shù)可以是這個(gè)形式?機(jī)器學(xué)習(xí)的終極目標(biāo)是什么?機(jī)器學(xué)習(xí)中測(cè)試集起的作用是什么?

首先我們需要知道一個(gè)概念——信息量,它指的是一個(gè)事件發(fā)生所帶來(lái)的信息。日常生活中,信息的載體是消息,比如“一個(gè)星期有7天”這條消息,它所帶來(lái)的信息量我們可以認(rèn)為是0,為什么呢?用大白話解釋就是說(shuō)了等于沒說(shuō),因?yàn)椤耙粋€(gè)星期有7天”這個(gè)事件它是確定事件。又比如說(shuō)“老板希望這個(gè)月32號(hào)發(fā)工資”,從科學(xué)的角度來(lái)講,這個(gè)消息的信息量為無(wú)窮大,因?yàn)檫@是不可能事件。而另外一條消息“埃航一架飛機(jī)墜毀了”,這個(gè)消息帶來(lái)的信息量就非常大,因?yàn)轱w機(jī)發(fā)生事故的概率很小,而墜毀的概率就更小了,因此這個(gè)事件的不確定性非常大,所以這條消息帶來(lái)的信息量很大。

題圖:保羅·高更《我們從何處來(lái)?我們是誰(shuí)?我們向何處去?》

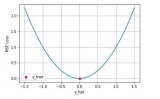

總結(jié)一下,信息量反映一個(gè)事件不確定性的程度,它在數(shù)學(xué)上有一個(gè)定義,就是I=-log(p),-log是遞減函數(shù),p越大,那么I就越小。也就是說(shuō),一個(gè)事件的確定性程度越高,它發(fā)生所帶來(lái)的信息量就越小。

不過,當(dāng)事件還沒有發(fā)生的時(shí)候,就不是直接去求信息量了,而應(yīng)該是求信息量的期望值,所以這個(gè)時(shí)候,我們要求的是信息熵,需要在信息量前面乘以該事件發(fā)生的概率,也就是信息熵H(P)=-Plog(P),所以,信息熵反映的是一個(gè)事件還沒有發(fā)生之前,它發(fā)生時(shí)候帶來(lái)信息量的期望值。在以2為底求對(duì)數(shù)的時(shí)候,信息熵的單位可以記為bit。

也可以理解為,根據(jù)真實(shí)分布,我們能夠找到一個(gè)最優(yōu)策略,該策略可以以最小的代價(jià)消除系統(tǒng)的不確定性,而這個(gè)代價(jià)的大小就是信息熵。

介紹為信息熵H(P)之后,我們?cè)賮?lái)看交叉熵,交叉熵出現(xiàn)的背景是我們想知道分布Q是否可以代表分布P,放到機(jī)器學(xué)習(xí)中,假設(shè)測(cè)試集的分布可以認(rèn)為是P,這個(gè)是確定的,因?yàn)檎?fù)樣本都是我們提前標(biāo)定好的,標(biāo)定好那一刻之后,它的分布就被唯一確定了,而分布Q則是我們訓(xùn)練好的網(wǎng)絡(luò)。現(xiàn)在,我們想知道對(duì)于測(cè)試樣本的概率分布為P的情況下,訓(xùn)練好的網(wǎng)絡(luò)的分布Q帶給我們的不確定性期望值為多少?用公式描述就是用概率分布P去乘以訓(xùn)練好的網(wǎng)絡(luò)的信息量:

H(P,Q)=-Plog(Q)

如果H(P,Q)為0,說(shuō)明我們訓(xùn)練好的網(wǎng)絡(luò)帶來(lái)的不確定性為0,也就是說(shuō)我們標(biāo)定的數(shù)據(jù)為正,網(wǎng)絡(luò)輸出也為正,標(biāo)定的數(shù)據(jù)為負(fù),網(wǎng)絡(luò)輸出也為負(fù),沒有任何懸念可言,因此,使得交叉熵H(P,Q)=0不就是我們訓(xùn)練網(wǎng)絡(luò)的終極目標(biāo)嗎?

最后,我們還要看相對(duì)熵(又稱KL散度)的概念,在用分布Q去擬合分布P的時(shí)候,我們一定會(huì)多產(chǎn)生一些無(wú)關(guān)緊要的信息熵,那么這個(gè)多余的信息熵就是用交叉熵減去真實(shí)分布熵,用公式表示就是:

D(P||Q)=H(P,Q)-H(P)

一般情況下,在標(biāo)記員標(biāo)記好數(shù)據(jù)的那一刻,P的分布就已經(jīng)確定了,H(P)可以認(rèn)為是一個(gè)常數(shù),所以優(yōu)化H(P,Q)實(shí)際上就等于優(yōu)化D(P||Q),也就是說(shuō)優(yōu)化交叉熵等同于優(yōu)化相對(duì)熵或優(yōu)化KL散度,因此我們經(jīng)常看到交叉熵、相對(duì)熵或KL散度混淆使用,原因就在這里。

那么回到邏輯回歸中,樣本要么為正,要么為負(fù),假設(shè)測(cè)試集真實(shí)標(biāo)簽為y,模型輸出為o,于是交叉熵為-ylog(o)-(1-y)log(1-o),就得到了我們開頭說(shuō)的損失函數(shù)的形式。損失函數(shù)值越小,那么用模型的輸出去逼近測(cè)試集真實(shí)的分布所消耗的額外信息熵就越小。需要注意的是,我們這里用測(cè)試集的分布來(lái)代表真實(shí)分布,因此測(cè)試集的選取是十分重要的。

-

信息

+關(guān)注

關(guān)注

0文章

407瀏覽量

35988 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4383瀏覽量

65013 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8507瀏覽量

134737

原文標(biāo)題:從信息論的角度來(lái)理解損失函數(shù)

文章出處:【微信號(hào):DeepLearningDigest,微信公眾號(hào):深度學(xué)習(xí)每日摘要】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

[1.1.1]--VR的終極目標(biāo)及當(dāng)前的實(shí)現(xiàn)形式

【DIY掃地機(jī)器人】第二篇----勘察現(xiàn)場(chǎng),制定計(jì)劃

【小e物聯(lián)網(wǎng)試用體驗(yàn)】之makefile

求一種stm32單片機(jī)按鍵消抖解決方案

工作中的C++基本原理及技巧

博通對(duì)終極目標(biāo)高通公司的收購(gòu)無(wú)果而終,今后的博通何去何從?

機(jī)器學(xué)習(xí)經(jīng)典損失函數(shù)比較

機(jī)器學(xué)習(xí)實(shí)用指南:訓(xùn)練和損失函數(shù)

人工智能的終極目標(biāo):類腦智能

英飛凌舉行各項(xiàng)質(zhì)量項(xiàng)目,向?qū)崿F(xiàn)“零缺陷”的質(zhì)量終極目標(biāo)不斷前進(jìn)。

機(jī)器學(xué)習(xí)和深度學(xué)習(xí)中分類與回歸常用的幾種損失函數(shù)

Gambetta:我們的終極目標(biāo)是建造一個(gè)大規(guī)模的量子計(jì)算機(jī)

stm32單片機(jī)按鍵消抖、長(zhǎng)按、多擊終極解決方案

評(píng)論