算法是一個黑箱。

我們可以看到它們在世間發揮作用,我們知道它們正塑造我們周遭的各種事物,但我們大多數人并不知道算法是什么——或者算法如何影響我們。

算法是不可見的代碼片段,它們負責指導計算機完成特定的任務。我們可以把算法想象成計算機的“食譜”:計算機遵照一種算法的指示便能“烹制”出特定的結果。

我們每次進行谷歌搜索、查看 Facebook 動態消息,或是在汽車中使用 GPS 導航,都是在跟算法進行交互。

倫敦大學學院(UCL)的數學家漢娜·弗萊(Hannah Fry)在其新書中提出,我們不應該把算法本身想成是好的或者壞的,而是應該更多地關注編寫這些算法的人。

從醫療到交通,從社會福利到刑事司法,算法正在我們社會的方方面面做著非常重要的決策。然而,普通人對算法幾乎一無所知,更不用說在幕后編寫這些算法的工程師和程序員了,他們也無法控制算法最終對整個社會的影響。

筆者與弗萊討論了算法如何悄然改變人們生活的規則,以及算法是否利大于弊。

以下是訪談實錄,內容略有刪減:

算法正在如何改變人們的生活?

漢娜·弗萊:說實話,方方面面都有。從我們選擇閱讀和觀看的內容到我們選擇約會的對象,算法正在發揮越來越大的作用。而且,這不僅僅體現在那些顯而易見的用例上,比如谷歌搜索算法或是亞馬遜推薦算法。

我們已經把這些算法引入了法庭、醫院和學校,并由它們代表我們做出一個個小決策,而這正在微妙地改變著我們社會的運作方式。

你認為我們對算法的信任是錯的嗎?我們把如此多的決策權交給這些程序,這是不是一個錯誤?

漢娜·弗萊:這是一個棘手的問題,我們與機器的關系非常復雜。一方面,我們有時候的確會錯誤地信任它們。在我們的預期中,它們宛如上帝,完美無缺,以至于不管它們帶領我們去向何方,我們都會盲目地跟從。

但與此同時,我們也有這樣一種傾向,即一旦算法稍微顯露出缺陷,我們就會大加貶斥。因此,假如Siri答錯了問題,或是我們的GPS應用預估錯了交通情況,我們便會認為整套機器都是垃圾,而這根本沒有道理。

算法并不完美,它們往往包含有開發人員的偏見,但算法仍然非常高效,它們讓我們的生活變得更加便捷。因此,我認為正確的態度是持中:不應該盲目地信任算法,但也無需一竿子全盤打翻。

我們通過倚重算法獲得了哪些優勢?

漢娜·弗萊:我們不擅長很多事情,我們不擅長保持一致,我們不擅長不偏不倚,我們很容易疲倦和粗心大意。

算法就沒有這些缺陷,它們始終如一,從不疲倦,而且絕對精確。問題在于,算法不理解上下文關系或細微差別,它們不能像人類那樣理解情感和產生同理心。

“我們不一定要創造這樣一個世界,由機器告訴我們要做什么或如何思考,盡管我們非常有可能淪陷在那樣的世界當中。”

你能舉一個算法犯下災難性錯誤的例子嗎?

漢娜·弗萊:我在書中寫到了弗吉尼亞州19歲男子克里斯托弗·德魯·布魯克斯(Christopher Drew Brooks)的故事,他跟一名14歲女孩發生關系而被判法定強奸罪。他們發生關系皆出于自愿,但由于女孩是未成年人,因此是非法的。

在量刑過程中,法官用到了一種算法,這種算法旨在預測一個人在服刑期滿后繼續犯罪的可能性有多大。算法評估了布魯克斯重新犯罪的分數,由于他在非常年輕的時候就有了性犯罪前科,算法認為他今后繼續犯罪的可能性非常高。因此,算法建議判處他入獄服刑18個月。

也許這個建議是公平合理的。不過,這也展示出算法有時候會有多不合邏輯。因為事實證明,本案中涉及的算法對犯罪者的年齡賦予了很大的權重——如果他的年齡是36歲而不是19歲,那么算法就會認為他對社會的威脅要低得多。但在這種情況下,犯罪者將比受害者年長22歲,我覺得任何有理智的人都會認為這要更加糟糕。

這個例子展示了邏輯完美的算法會怎樣得出奇怪的結果。在本案中,你可能認為法官會自行判斷,推翻算法的建議,但在現實中法官增加了布魯克斯的刑期,在某種程度上是受到了算法的影響。

開發這些算法的人,谷歌和 Facebook 等公司的工程師,你覺得他們完全理解自己所開發的東西嗎?

漢娜·弗萊:他們正開始認真關注這些東西的影響。Facebook 過去奉行的信條是“快速行動,破舊立新”,這也是科技界大多數人的態度。但在過去的幾年里,這種潮流發生了變化。隨著算法造成的意想不到的后果日漸清晰,很多科技界人士已經醒悟過來。

每一個社交媒體平臺,每一個成為我們生活組成部分的算法,都是這個正在展開的大規模社會實驗的一部分。全世界范圍內有數十億人正在跟這些技術互動,這就是為什么最微小的改動都可能對全人類產生非常大的影響。這些公司正開始認識到這一點并認真應對。

你說算法本身并不分好壞,但我想在這上面多說幾句。算法可以造成意想不到的后果,尤其是那些可以自我編程的機器學習算法。既然我們不可能預測出所有可能的場景,我們能不能說有些算法是壞的,即使那不是它們的設計本意?

漢娜·弗萊:這是一個很好的問題,我們得把這些技術,特別是機器學習和人工智能,更多地與電的發明去類比,而不是電燈。我的意思是,我們不知道這些東西會被人們如何使用以及在什么樣的場景和情況下使用。

但是,電本身沒有好壞之分,它只是一件擁有無限多使用方式的工具。算法也是如此,我沒有見過 100% 好或 100% 壞的算法,我認為它所處的環境和周圍的一切才起到了決定性的作用。

“對于算法能夠做什么和不能做什么,我們可以提出任何主張,即便那荒謬透頂,也沒有人能夠阻止我們那樣做。”

你是否擔心算法的大規模普及正在削弱我們思考和決策的能力?

漢娜·弗萊:在某些地方,這種事情顯然正在發生,人類的作用被排除在外,聽之任之是非常危險的。不過,我也認為,事情不一定需要演變成那樣。人類和機器并不一定要彼此對立,我們必須跟機器合作,并認識到它們跟我們一樣存在缺陷,以及它們跟我們一樣會犯錯。

我們不一定要創造這樣一個世界,由機器告訴我們要做什么或如何思考,盡管我們非常有可能淪陷在那樣的世界當中。我更希望人和機器、人和算法是合作伙伴的關系。

你是否覺得人和人工算法最終會以一種模糊兩者界線的方式結合在一起?

漢娜·弗萊:完全有可能,但那距離我們還非常非常遙遠。

舉例來說,有一個研究項目試圖復制秀麗隱桿線蟲的大腦,這是一種微型蠕蟲,其大腦中大約有200個神經元——研究人員未獲成功。即便擁有最尖端、最先進的人工智能,我們也無力模擬一種微小蠕蟲的大腦。因此,我們距離模擬更復雜的動物就更加遙遠了,更別說復制人腦。

所以,這些討論很有意思,但它們也可能讓我們偏離眼下正在發生的事情。統領我們生活的規則和系統都在發生變化,而算法是其中很重要的一部分。

我們是否需要為算法制定更強大的監管框架?

漢娜·弗萊:絕對需要。我們一直生活在科技的狂野西部,你可以在未經他人允許的情況下收集他們的私密數據并將之出售給廣告商。我們正在把人變成商品,而他們甚至沒有意識到這一點。對于算法能夠做什么和不能做什么,我們可以提出任何主張,即使那荒謬透頂,也沒有人能夠阻止我們那樣做。

即使一種算法是行之有效的,也沒有人來評估它是否為社會帶來了好處或造成了損害,沒有人來做這些檢查工作。我們需要監管算法的“FDA”(美國食品和藥物管理局),這個機構既要能夠保護公司開發算法的知識產權,同時也要確保算法不會以任何形式傷害或侵犯公眾利益。

歸根結底,算法為人們解決的問題是不是多過了它們制造的問題?

漢娜·弗萊:是的,我認為它們解決的問題多過它們制造的問題,我對這些事情仍然保持著樂觀的態度。我已經在這個領域工作了十多年的時間,這些技術有很大的正面作用。算法正在被用于幫助預防犯罪,幫助醫生獲取更準確的癌癥診斷結果,等等等等。

對人類來說,所有這些事情都是非常非常積極的進步。我們只是需要在應用它們的方式上面保持謹慎,我們不能魯莽行動,我們不能一味快速行動,一味破舊立新。

-

谷歌

+關注

關注

27文章

6182瀏覽量

105784 -

算法

+關注

關注

23文章

4628瀏覽量

93172

原文標題:同樣是罪犯,36歲比19歲危害小,這是算法的邏輯?

文章出處:【微信號:AI_Thinker,微信公眾號:人工智能頭條】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

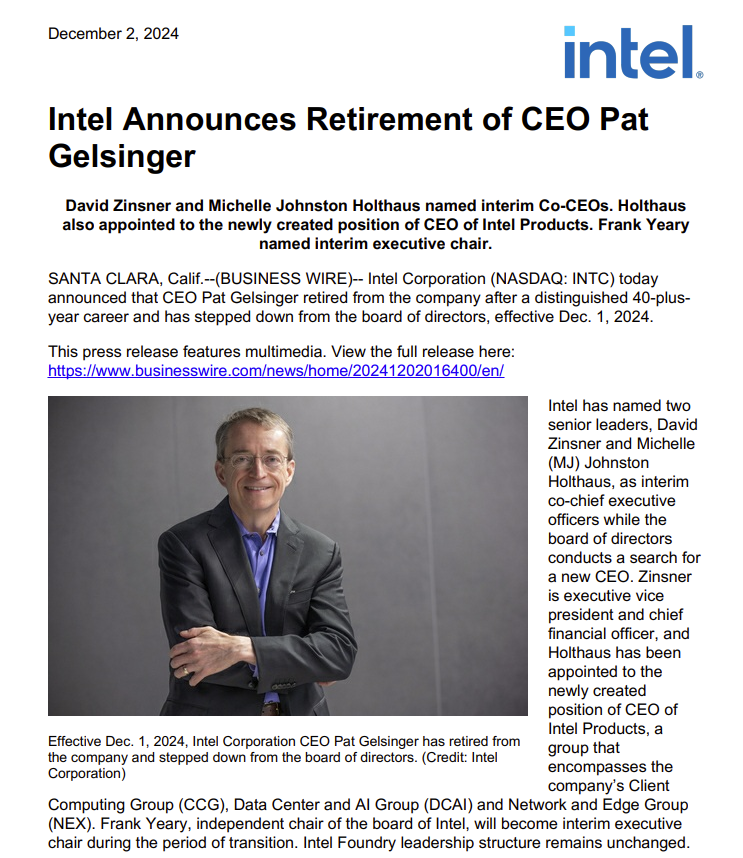

63歲基辛格退休!IDM2.0戰略失去主心骨,英特爾何去何從?

20歲用上無線呼叫器——少走50年彎路

初心不改,星辰大海丨航智7歲生日快樂

同樣是函數,在C和C++中有什么區別

使用TPA3138D2過程中,同樣做雙通道10瓦功率,12伏4歐姆比12伏6歐姆比12伏8歐姆溫度高,為什么?

FPGA算法工程師、邏輯工程師、原型驗證工程師有什么區別?

同樣是逆變器,儲能的和光伏的有啥區別?

36歲了還有必要轉行鴻蒙開發嗎?

19歲開發者推出Vision Pro適配Netflix和Prime Video客戶端

“日本半導體教父”坂本幸雄逝世,享年77歲

93歲上將院士最新論文:三十年不斷發展的MEMS慣性傳感器(推薦)

同樣是罪犯,36歲比19歲危害小,這是算法的邏輯?

同樣是罪犯,36歲比19歲危害小,這是算法的邏輯?

評論