利用進(jìn)化后的反向傳播算法實(shí)現(xiàn)快速、高效的訓(xùn)練

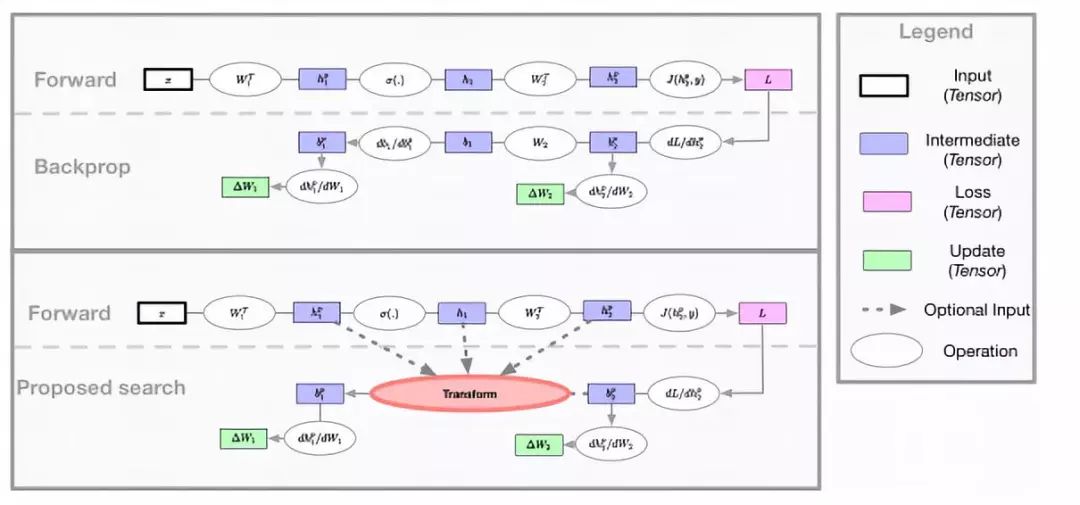

在最新的機(jī)器學(xué)習(xí)自動(dòng)搜尋方法的推動(dòng)下,一些谷歌研究人員提出了一種自動(dòng)生成反向傳播方程的方法。

新方法的工作原理:研究人員嘗試修改反向計(jì)算(流程)圖,并實(shí)現(xiàn)了一種搜索方法:找到更好的公式,生成全新的傳播規(guī)則。他們使用進(jìn)化后算法來(lái)尋找可能的更新方程。進(jìn)化控制端在每次迭代中向研究人員群發(fā)送一組修改后的更新方程以進(jìn)行評(píng)估。然后,每位研究人員使用接收到的變異方程來(lái)訓(xùn)練一個(gè)固定的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),并向控制端報(bào)告所達(dá)到的精準(zhǔn)度。

潛在應(yīng)用及影響

研究人員發(fā)現(xiàn)一些變異可以像傳統(tǒng)的反向傳播方法一樣有效。這些變化可以在短的訓(xùn)練周期內(nèi)實(shí)現(xiàn)更高的準(zhǔn)確性,因此可以用于改進(jìn)基于準(zhǔn)確性的決策算法。

由于反向傳播是深度神經(jīng)網(wǎng)絡(luò)的基礎(chǔ),利用這種新發(fā)現(xiàn)的變異可以用來(lái)增強(qiáng)對(duì)各種神經(jīng)網(wǎng)絡(luò)的訓(xùn)練。

原文:

https://arxiv.org/pdf/1808.02822.pdf

端對(duì)端的目標(biāo)跟蹤結(jié)構(gòu)

研究人員提出了一種離線型端到端訓(xùn)練的鑒別目標(biāo)跟蹤方法。在Python中可以使用PyTorch實(shí)現(xiàn),新方法是通過(guò)迭代優(yōu)化從具有辨別性的學(xué)習(xí)損失中衍生得出的。它構(gòu)成卷積層的權(quán)重以及輸出目標(biāo)分類得分。而且它還實(shí)現(xiàn)了一個(gè)預(yù)測(cè)模型,其中包括一個(gè)初始化網(wǎng)絡(luò),以便僅使用外觀(特征),就能有效地提供模型權(quán)重的初始估計(jì)。

然后由優(yōu)化模塊處理權(quán)重,同時(shí)考慮目標(biāo)和背景樣本。優(yōu)化功能是特地設(shè)計(jì)的,只包括一些可學(xué)習(xí)的參數(shù),以避免在離線訓(xùn)練期間過(guò)度擬合。在使用時(shí),預(yù)測(cè)模型就能夠泛化為不可見(jiàn)的目標(biāo),這在常規(guī)目標(biāo)跟蹤中是至關(guān)重要的。

整個(gè)跟蹤模型,包括目標(biāo)分類、邊界框預(yù)估和Backbone模塊,都可以在跟蹤數(shù)據(jù)集上進(jìn)行離線訓(xùn)練。在評(píng)估方面,它在6個(gè)跟蹤基準(zhǔn)上都達(dá)到了最新的技術(shù)水平,在運(yùn)行速度超過(guò)40FPS的情況下,在VOT2018(Visual Object Tracking Challenge全球目標(biāo)追蹤領(lǐng)域中最高水平賽事)上獲得了EAO得分:0.440(Expect Average Overlap Rate,追蹤算法評(píng)價(jià)標(biāo)準(zhǔn)之一)。

在單塊Nvidia GTX 1080 GPU上,新模型在使用ResNet-18為主時(shí),跟蹤速度為57 FPS,對(duì)于ResNet-50則為43FPS。訓(xùn)練及推導(dǎo)過(guò)程請(qǐng)見(jiàn)?

https://github.com/visionml/pytracking

潛在應(yīng)用與影響

現(xiàn)在我們有了一種辨別性的目標(biāo)跟蹤方法,而且這種方法是離線訓(xùn)練的,只需幾個(gè)優(yōu)化步驟就可以進(jìn)行穩(wěn)健型的預(yù)測(cè)。結(jié)合這一方法以及其他最近的目標(biāo)跟蹤方法,我們即將迎來(lái)下一代目標(biāo)跟蹤(方法)的進(jìn)步。

閱讀更多:

https://arxiv.org/abs/1904.07220v1

3.DG-Net:增強(qiáng)行人身份再識(shí)別(Re-Identification)

為了提高行人的再識(shí)別能力,研究人員最近提出了DG- Net,這是一個(gè)結(jié)合再識(shí)別學(xué)習(xí)和端到端數(shù)據(jù)生成的聯(lián)合學(xué)習(xí)框架。為此,DG-Net包含一個(gè)生成模塊,該模塊將特定的人分別編譯為外觀代碼和結(jié)構(gòu)代碼。它還集成了與生成模塊共享外觀編碼器的判別模塊。

因此,DG-Net中的生成模塊可以生成高質(zhì)量的交叉id合成圖像,然后在線將圖像反饋給外觀編碼器,通過(guò)切換外觀代碼或結(jié)構(gòu)代碼來(lái)改進(jìn)模型的判別模塊。在包括Market-1501、dukemtc - reid和MSMT17在內(nèi)的標(biāo)準(zhǔn)基準(zhǔn)數(shù)據(jù)集上對(duì)DG-Net進(jìn)行了評(píng)估,結(jié)果顯示,與傳統(tǒng)模型相比,DG-Net在圖像生成質(zhì)量和再識(shí)別精度方面都有顯著的改進(jìn)。

將新方法與LSGAN[29],PG2-GAN[28],FD-GAN[10],PN-GAN[31]通過(guò)基于Market-1501而產(chǎn)生的真實(shí)圖像進(jìn)行對(duì)比,放大后可以更清楚地看到圖片的表層和深層。

潛在應(yīng)用與影響

從GANs被發(fā)現(xiàn)到最近的研究進(jìn)展,判別和生成網(wǎng)絡(luò)在圖像構(gòu)建和生成任務(wù)中不斷證明自己。DG-Net是另一個(gè)當(dāng)代的方法,將會(huì)顯著和持續(xù)地提高再識(shí)別的準(zhǔn)確性。這項(xiàng)研究表明,人工智能領(lǐng)域還可以繼續(xù)更深入地研究GANs,以便找到更好的方法,來(lái)運(yùn)用生成的數(shù)據(jù)完成更多穩(wěn)健的基于圖像任務(wù)。

原文:

https://arxiv.org/abs/1904.07223v1

4 .實(shí)現(xiàn)CNNs端到端培訓(xùn)時(shí)間減少31%

通過(guò)著重關(guān)注加速訓(xùn)練,一組研究人員提出了PruneTrain,一種新的經(jīng)濟(jì)有效的方法,可以緩慢但穩(wěn)定地降低CNN的訓(xùn)練成本。與傳統(tǒng)的CNN訓(xùn)練方法不同,PruneTrain在訓(xùn)練過(guò)程中通過(guò)稀疏化過(guò)程實(shí)現(xiàn)了模型剪枝方法scratch。模型剪枝主要是在稠密模型中減少權(quán)值或參數(shù)的數(shù)量,從而在保持原有模型精度的同時(shí)降低內(nèi)存和推理成本。

PruneTrain非常實(shí)用,它使CNN的端到端訓(xùn)練成本降低了約31%。總體而言,它減少了大約一半的計(jì)算成本——對(duì)于大數(shù)據(jù)集和小數(shù)據(jù)集,它分別減少了37%到40%之間的計(jì)算成本,實(shí)現(xiàn)了31%和28%的成本降低。總的來(lái)說(shuō),這是由于計(jì)算延遲減少了37%,內(nèi)存占用減少了35%,加速器間通信減少了54%。

潛在用途及影響

在機(jī)器學(xué)習(xí)社區(qū)中,誰(shuí)不認(rèn)為這是一個(gè)好消息?人工智能研究人員和行業(yè)從業(yè)人員現(xiàn)在都可以期待使用PruneTrain進(jìn)行成本更低的CNN訓(xùn)練,并且PruneTrain將CNN架構(gòu)重構(gòu)為更節(jié)省成本的形式,同時(shí)仍然保留一個(gè)密集的結(jié)構(gòu)。為了更快地進(jìn)行推理,這樣的模型剪枝是值得深入研究的!

詳情請(qǐng)見(jiàn):

https://arxiv.org/abs/1901.09290v3

5 . 自主微型機(jī)器人的合成神經(jīng)視覺(jué)系統(tǒng)

一種新的基于嵌入式視覺(jué)系統(tǒng)的自主微機(jī)器人方法被提出,用于識(shí)別動(dòng)態(tài)機(jī)器人場(chǎng)景中的運(yùn)動(dòng)模式。該方法將基本的運(yùn)動(dòng)模式分為隱現(xiàn)(接近)、衰退、平移等運(yùn)動(dòng)。該系統(tǒng)由兩個(gè)協(xié)調(diào)子系統(tǒng)組成,其中包括蝗蟲(chóng)巨葉狀體運(yùn)動(dòng)探測(cè)器(LGMD1和LGMD2),它有四個(gè)突起神經(jīng)元,用于感知若隱若現(xiàn)和衰退。另一類是用于平動(dòng)運(yùn)動(dòng)提取的果蠅定向選擇神經(jīng)元(DSN-R和DSN-L)。

通過(guò)對(duì)開(kāi)關(guān)函數(shù)和決策機(jī)制的時(shí)空計(jì)算,圖像被轉(zhuǎn)換為峰值,從而在動(dòng)態(tài)機(jī)器人場(chǎng)景中喚起適當(dāng)?shù)谋芘觥⒏櫤吐涡袨椤?duì)多機(jī)器人的評(píng)估證實(shí)了系統(tǒng)在識(shí)別運(yùn)動(dòng)特征以進(jìn)行碰撞檢測(cè)的有效性,與現(xiàn)有方法相比有顯著改進(jìn)。

潛在用途及影響

為了在動(dòng)態(tài)場(chǎng)景中應(yīng)用合適的機(jī)器人行為,毫無(wú)疑問(wèn),更多的研究工作和行業(yè)實(shí)踐是必要的。所提出的人工神經(jīng)視覺(jué)系統(tǒng)能夠較好地識(shí)別運(yùn)動(dòng)規(guī)律。研究人員呼吁在系統(tǒng)中繼續(xù)加入其他視覺(jué)神經(jīng)元,提取更多的運(yùn)動(dòng)特征,以豐富運(yùn)動(dòng)模式,使機(jī)器人的視覺(jué)系統(tǒng)更加高效。

-

谷歌

+關(guān)注

關(guān)注

27文章

6161瀏覽量

105304 -

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4771瀏覽量

100719 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8407瀏覽量

132567

原文標(biāo)題:改進(jìn)反向傳播算法實(shí)現(xiàn)高效訓(xùn)練,端到端的目標(biāo)跟蹤結(jié)構(gòu),微型機(jī)器人的新視覺(jué)系統(tǒng) | AI一周學(xué)術(shù)

文章出處:【微信號(hào):BigDataDigest,微信公眾號(hào):大數(shù)據(jù)文摘】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

MapReduce的誤差反向傳播算法

基于反向學(xué)習(xí)的自適應(yīng)差分進(jìn)化算法

一種自動(dòng)生成反向傳播方程的方法

卷積神經(jīng)網(wǎng)絡(luò)的權(quán)值反向傳播機(jī)制和MATLAB的實(shí)現(xiàn)方法

淺析深度神經(jīng)網(wǎng)絡(luò)(DNN)反向傳播算法(BP)

利用進(jìn)化后的反向傳播算法實(shí)現(xiàn)快速、高效的訓(xùn)練

利用進(jìn)化后的反向傳播算法實(shí)現(xiàn)快速、高效的訓(xùn)練

評(píng)論