【導語】過去兩年,生成對抗網絡(GAN)取得了飛速、充分的發展,尤其是應用于圖像合成技術的模型,快到幾乎讓人跟不上,每隔一段時間,我們肯能就能看到應用在不同任務中的新變體。雖然已經被廣泛應用語研究與技術中,那是否就表示大家對 GAN 已經了解非常透徹了呢?是否還有不為大家了解的問題呢?接下來,我們就一起來看看,關于 GAN 模型我們還要可以深入了解、探討哪些問題呢?

在今天的文中,可以概括為以下 7 個問題:

1、與其他生成模型相比,GAN 的利弊是什么?

2、GAN 可以為哪種分布建模?

3、除了圖像合成,我們還能在哪些任務中應用 GAN?

4、關于 GAN 訓練的全局融合有哪些值得探討?

5、應該如何評估 GAN 及何時使用?

6、GAN 訓練如何按批量大小進行擴展?

7、GAN 與對抗性樣本之間是什么關系?

對于應該如何評價 GAN,其實還存在很多分歧。鑒于目前 GAN 在圖像合成任務中近乎飽和的應用狀態,此時思考這些問題也許正是時候。基于早前其他領域的經驗,通過領域的開放性問題來幫助確定目標,不失為一個好方法。

因此,在后續的內容中,作者也會提及一些關于 GAN 的開放性研究問題,除了幫大家梳理一些思路外,也希望這些問題能有研究者可以進行深入研究,或研究人員根據自己的研究領域也探索一些開放性問題。

首先進入第一個問題:

1、與其他生成模型相比,GAN 的利弊是什么?

除了 GAN 之外,目前還有另外兩種類型的生成模型比較流行:流(Flow)模型和自回歸(Autoregressive)模型,不過不要過于字面化理解。其實,這些常用術語都是用于描述“模型空間”中的模糊聚類的,但有些模型無法輕易歸屬到這些聚類中。在任務中它們都被認為是“不再是最先進的模型”。通俗解釋,流模型將一堆可逆變換應用于來自先驗的樣本,以便計算精確對數似然的觀測值。自回歸模型將觀察到的分布分解為條件分布,并一次處理觀察到的一個分量。(對于圖像,它們可以一次處理一個像素)最近的研究表明,這些模型具有不同的性能特征和利弊。基于此,作者提出了一個有趣的開放性問題:如何準確地描述這些利弊,它們是否是模型家族中的固有性質?

具體講的話要如何思考這個問題呢?大家可以先關注 GAN 和流模型之間計算成本的差異。 乍一看,流模型似乎會碾壓 GAN。流模型允許精確的對數似然計算和精確推理,因此如果訓練流模型和 GAN 利用相同的計算成本,那 GAN 好像就一點都不實用。因為訓練 GAN 需要花費很多精力,所以在此時就要想:流模型是否會讓 GAN 顯得很 OUT 呢?在這種情況下還堅持使用對抗訓練是否有更深層的考量與意義呢?

為了估計訓練 GAN 和流模型之間計算成本存在的較大差距,大家需要通過一些實驗進行證明與思考。比如在作者的實驗中,他們選擇看一下這兩個模型在人臉數據集上的訓練情況。GLOW 模型的訓練過程,使用了 40 個 GPU 生成 256x256 像素的名人臉,需要持續 2 周,使用參數約為 2 億個。相比之下,使用類似的面部數據集對漸進式 GAN 進行訓練,使用了 8 個 GPU,持續 4 天,需要大約 4600 萬個參數來生成 1024x1024 像素的圖像。大致計算,流模型比使用的 GPU 天數是對抗訓練模型的 17 倍、參數是其 4 倍,而生成的像素還減少了 16 倍,這么看來,真的太不 OK 了!

得到上面的數據后,作者又不禁在思考,為什么流模型效率更低呢?經過分析,作者給出了兩個可能的原因:首先,最大似然訓練在計算上比對抗訓練更難。特別是,如果訓練集的任何元素被生成模型指定為零概率,那么將會受到更加殘酷的懲罰! 第二,GAN 生成器僅間接地為訓練集元素分配零概率時會受到懲罰,并且這種懲罰并不那么嚴厲。 并且規范化流程可能會使某些功能的表達低效。

上面是對流模型和 GAN 間利弊權衡的分析,自回歸模型有如何呢?事實證明,自回歸模型可以表示為不可并行化的流模型(因為它們都是可逆的)。自回歸模型比流模型具有更高的時間和參數效率。 因此,結合 GAN 特征,可總結為:GAN 是平行、有效、不可逆的;流模型是可逆、平行、不高效的;而自回歸模型是可逆、有效,但不是平行的。由此就引出了第一個開放性問題:與其他生成模型相比,GAN 的利弊是什么?

| 平行性 | 有效性 | 可逆性 | |

| GAN | 是 | 是 | 否 |

| 流模型 | 是 | 否 | 是 |

| 自回歸模型 | 否 | 是 | 是 |

那是否可以制定某種可逆、并行、高效(參數/時間效率)的 CAP 定理類型聲明?

解決這個問題的一種方法是研究更多擁有多個模型族的混合體模型。雖然這點已被混合 GAN / 流模型考慮到了,但作者認為這種方法仍未得到充分發掘。

作者也不能確定最大似然訓練是否必然比 GAN 訓練更難。在 GAN 訓練損失下,沒有明確禁止在訓練數據點上放置零質量,但是如果發生器執行此操作,那么足夠強大的鑒別器就能做得更好,而不僅僅是巧合。這看起來似乎 GAN 是在實踐中學習低分布。

最后,作者得出初步結論:基本上,流模型在每個參數上的表達能力都不如任意解碼器函數。(在某些假設上是可證明的。)

2、GAN 可以為哪種分布建模?

大多數 GAN 研究都廣泛應用于圖像合成。特別是在部分標準圖像數據集上訓練 GAN,如 MNIST,CIFAR-10,STL-10,CelebA和Imagenet。而大家也在討論哪些數據集是最容易建模的?如果想得到這個答案,需要先在更大、更復雜的數據集上訓練,經過更龐大、嘈雜的訓練過程。如何通過一個簡單的理論解釋實驗觀察,理想情況可以查看數據集,執行一些計算而無需實際訓練生成模型,然后得出“這個數據集更容易讓 GAN 建模,而不是用 VAE”。在這方面基于作者已經取得的一些進展,進一步提出了第二個問題:給定一個分布,該如何判斷 GAN 對該分布進行建模的難易程度?同時,這個問題還涉及其他很多問題,對此作者給出兩種策略:

(1)合成數據集:研究合成數據集來探究哪些特征影響可學習性。例如,在創建合成三角形的數據集領域,我們覺得仍然探索不足。合成數據集可以結合其他特征,如連通性或平滑性,進行參數化,從而允許系統性的研究。這樣的數據集也可用于研究其他類型的生成模型。

(2)修改現有的理論結果:利用現有的理論結果并嘗試根據數據集的不同屬性修改假設。例如,獲取有關應用給定單峰數據分布的 GAN 的結果,了解當數據分布變為多峰時會發生什么。

3、除了圖像合成,我們還能在哪些任務中應用 GAN?

除了圖像轉換和領域適應性建模等應用,大多數成功應用 GAN 的都是圖像合成任務中,如果想在其他任務中應用 GAN,需要注意什么?

(1)文本:GAN 應用在離散型的文本數據類型上時更困難。因為 GAN 依賴于生成器生成的內容將來自鑒別器的信號反向傳播到生成器中。有兩種方法可以解決這個難題。:第一種方法是讓 GAN 僅對離散數據的連續表示起作用;第二種是使用實際的離散模型,并嘗試使用梯度估計來訓練 GAN。其他更復雜的處理方法也有,但就目前所知,它們都沒有產生可以與基于可能性的語言模型相競爭(在混亂度方面)的結果。

(2)結構化數據:其他非歐幾里德結構化數據怎么處理(如圖表)?對這類數據的研究稱為幾何深度學習。GAN 在這里取得的成功很有限,但其他深度學習技巧也是如此,因此很難判斷 GAN 本身的作用。 作者曾嘗試過在這個方面中使用 GAN,使生成器產生(以及鑒別器“批判”)隨機游走,其意圖是模仿從源圖中的采樣。

(3)音頻:可以說 GAN 應用于處理音頻數據任務的成功率是最接近圖像任務的了。從第一次嘗試將 GAN 應用于無監督音頻合成任務到最近的研究表明,GAN 可以在一些感知指標上超越自回歸模型。

盡管有這些不同的嘗試,但顯然圖像仍然是 GAN 應用最“得心應手”的領域。這便引出了第三個問題:如何在非圖像數據處理上同樣使 GAN 的表現良好?將 GAN 擴展到其他域是否需要新的訓練技巧,還是只需要為每個域提供更好的隱式先驗?

最終當然是希望 GAN 能夠在其他連續數據上實現和圖像合成任務一樣的成功,但這需要更好的隱式先驗。找到這些先驗前需要仔細思考其合理性,以及是否可以在給定的領域中計算。

對于如何處理結構化數據或非連續數據上還不能給出確定想法。考慮中的一種方法可能是讓發生器和鑒別器都成為經過強化學習訓練的媒介。使用這種方法可能需要大規模的計算資源。

4、關于 GAN 訓練的全局融合有哪些值得探討?

訓練 GAN 與訓練其他神經網絡不同,因為訓練 GAN 可以同時以相反的目標優化發生器和鑒別器。在某些情況下這些假設非常嚴格,因此作者也正在尋找平衡所在,可能作者離這個問題的答案已經非常接近了,這種同步優化是局部漸近穩定的。

不過關于完全通用的情況還很難給出值得討論的點。因為鑒別器/發生器的損耗是其參數的非凸函數,所有的神經網絡都有這個問題!只想要一些方法,就可以同步優化所產生問題。這也就是第四個問題:關于 GAN 訓練的全局融合有哪些值得探討?哪種神經網絡收斂結果可以應用于GAN?

在這個問題的研究上,目前取得了非凡的進展。現有 3 種算法都產生了效果,但都沒有被完全研究透:

(1)簡化假設:簡化關于生成器和鑒別器的假設。例如,如果使用特殊技術和一些其他假設進行優化簡化的 LGQ GAN(線性發生器、高斯數據和二次鑒別器 ),則簡化的 LGQ GAN 可以顯示為全局收斂。 除此之外,假設可以先學習高斯算法,然后學習方差,還可以看看逐步放松這些假設會發生什么,比如可以擺脫單峰分布。

(2)將一般神經網絡的技術引用至 GAN:第二種策略是應用分析一般神經網絡(也是非凸的)的技術來回答有關GAN收斂的問題。 例如,有人認為深度神經網絡的非凸性不是問題,隨著網絡變大,損失函數的低質量局部最小值以指數形式減少,將這種分析應用給 GAN 是否可行?從作為分類器的深度神經網絡到 GAN,似乎存在一定的啟發性。

(4)博弈論:最終策略是使用博弈論概念對 GAN 訓練進行建模。這些技巧產生的訓練程序可被證明收斂于某種近似納什均衡,但這么做要使用不合理的大容量資源約束。在這種情況下,“明顯的”下一步嘗試就是如何減少這些資源約束。

5、應該如何評估 GAN 及何時使用?

在評估GAN時,有很多建議但很少有共識。這些建議包括:初始分數和FID、MS-SSIM、AIS、幾何分數、精確和召回與技能等級。

這些只是一小部分,盡管初始分數和 FID 相對受歡迎,但評估 GAN 顯然還不是一個被解決了的問題。最終作者提出第五個問題:我們應該什么時候使用 GAN 而不是其他生成模型?又應該如何評估這其表現?

我們應該使用 GAN 做什么?如果是想要實際密度模型,GAN 可能不是最佳選擇。現在有很好的實驗證據表明 GAN 可以學習目標數據集的“低支持”表示,這意味著可能存在大量測試集被 GAN(隱性的)賦予零可能性。

不過不用過于擔心這一點,將 GAN 研究的重點放在這個不錯甚至有用的任務上也是有意義的。GAN 可能非常適合具有感知風格的任務,如圖像合成、圖像轉換、圖像填充和屬性操作等。

應該如何評估用在這些任務中的 GAN?理想狀況下會進行人為判斷,但成本和代價不免有些昂貴。一個廉價的代理方法是看分類器是否可以區分真與假數據,這種方法稱為分類器雙樣本測試(C2STs)。C2STs 的主要問題是:如果發生器存在一個跨樣本系統性的非常小的缺陷,就將主導評估結果。

理想情況下是采取不受單一因素支配的整體評估。一種方法是讓一個對主導缺陷視而不見的評論者評估。但是一旦我們這樣做,其他一些缺陷就可能占主導地位,需要一個新的評論者。如果反復這樣做,會得到一種“評論者的 Gram-Schmidt 程序”,即創建一個最重要缺陷和忽略評論者的有序列表。

不考慮成本花費,仍可以用人類進行評估,這有助于衡量真正關心的點。或通過預測人類答案并且當預測不確定時與這個人交流,可以使這種方法更便宜。

6、GAN 訓練如何按批量大小進行擴展?

大量的小批次數據有助于擴大圖像分類,這是否也可以幫助擴展GAN?乍一看,答案似乎是肯定的,畢竟大多數 GAN 中的鑒別器只是一個圖像分類器。如果在梯度噪聲上存在瓶頸,則可以更大批量的進行加速訓練。 但是,GAN 另有一個分類器沒有的瓶頸,訓練過程可能會產生偏離。 因此第六個問題便是:GAN 訓練如何根據批量大小進行擴展?梯度噪聲在 GAN 訓練中的作用有多大?是否可以修改 GAN 訓練,使其可以根據批量大小進行更好地縮放?

一些證據表明,增加小批量尺寸數據可以改善定量結果并縮短訓練時間。如果這種現象很穩健,則表明梯度噪聲是一個主導因素。然而,這尚未得到系統研究,因此這個問題也是仍未解決的。

而替代訓練程序可以更好地利用大批量數據嗎?理論上,最佳傳輸 GAN 具有比普通 GAN 更好的收斂特性,但需要大批量,它們試圖匹配批量樣本和訓練數據,因此,似乎有希望擴展到大批量。

最后,異步 SGD 可以成為使用新硬件的一個好選擇。限制因素傾向于在參數的“陳舊”副本上計算梯度更新。但實際上,GAN 似乎受益于過去參數快照的訓練,因此我們可能會詢問異步 SGD 是否以特殊方式與 GAN 訓練進行交互。

7、GAN 與對抗性樣本之間是什么關系?

眾所周知,圖像分類器受到對抗性樣本的影響:人類不易察覺的擾動會導致分類器在添加到圖像時給出錯誤的輸出。雖然現在還知道存在的可以有效學習的分類問題,但是想要穩固的學習,其難度是呈指數倍的。

由于 GAN 鑒別器是圖像分類器,人們可能擔心它遭受對抗性樣本的攻擊。盡管有大量關于 GAN 和對抗性樣本的研究,似乎并沒有太多是關于它們之間互相關系的研究。有關于使用 GAN 生成對抗性樣本的研究,但這并不是同一件事。因此提出的最后一個問題就是:鑒別器的對抗穩健性如何影響GAN訓練?

應該如何思考這個問題呢? 考慮固定的鑒別器D,如果存在正確分類為虛數的生成器樣本G(z)和小擾動 p 使得 G(z)+ p 為實數,則存在 D 的對抗性樣本。對于 GAN,關注的是發生器的梯度更新將產生新的發生器 G',其中 G'(z)= G(z)+ p。

這個問題是否現實,表明對生成模型的故意攻擊可以起作用。但擔心更多的是大家會提到的“意外攻擊”,因為這些“意外攻擊”一般被認為是小概率事件,而提出這個假設是基于以下三個論點:

(1)再次更新鑒別器之前,允許生成器進行一次梯度更新。目前的對抗性攻擊通常會進行數十次迭代。

(2)其次,發生器優化先前一批給定的樣品,該批次對于每個梯度的步驟都是不同的。

(3)最后,優化發生在發生器的參數空間而不是像素空間中。

但是,這些論點都沒有決定性地排除生成對抗性樣本的生成器。因而,作者認為這也是一個值得進一步探索的領域。

在 GAN 火熱的這兩年之后,關于 GAN 接下來更深入的研究更是需要研究者投入研究的,以上僅是作者的一些想法,僅分享給更多致力于 GAN 研究與應用,對 GAN 學習感興趣的朋友們。

-

GaN

+關注

關注

19文章

1944瀏覽量

73653 -

模型

+關注

關注

1文章

3255瀏覽量

48902 -

數據集

+關注

關注

4文章

1208瀏覽量

24727

原文標題:以合成假臉、假畫聞名的GAN很成熟了?那這些問題呢?| 技術頭條

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

專家開講:深入了解電池技術 ──Part 1

專家開講:深入了解電池技術 ──Part 2-1

專家開講:深入了解電池技術──Part 3

單片機的深入了解!

示波器的深入了解

如何深入了解目標檢測,掌握模型框架的基本操作?

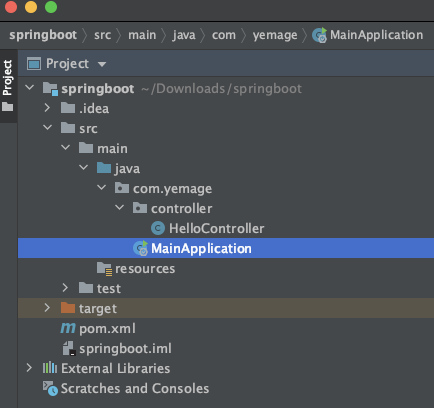

深入了解SpringBoot的自動配置原理

關于GAN模型我們還要可以深入了解、探討哪些問題?

關于GAN模型我們還要可以深入了解、探討哪些問題?

評論