【導語】ICLR 是深度學習領域的頂級會議,素有深度學習頂會 “無冕之王” 之稱。今年的 ICLR 大會將于5月6日到5月9日在美國新奧爾良市舉行,大會采用 OpenReview 的公開雙盲評審機制,共接收了 1578 篇論文:其中 oral 論文 24 篇 (約占 1.5%),poster 論文共 476 篇 (占30.2%)。在這些錄用的論文中,深度學習、強化學習和生成對抗網絡 GANs 是最熱門的三大研究方向。

今天, ICLR2019 公布了最佳論文,有兩篇論文獲得了最佳論文,在此對獲獎論文作者及團隊表示祝賀!一篇是《Ordered Neurons: Integrating Tree Structures into Recurrent Neural Networks》,在 RNN 網絡中集成樹結構,提出一種神經元排序策略,由蒙特利爾大學、微軟研究院共同研究發表;另一篇是 MIT CSAIL 的研究成果《The Lottery Ticket Hypothesis: Finding Spare, Trainable Neural Networks》。下面就為大家帶來這兩篇最佳論文的解讀。

論文一

論文地址:

https://openreview.net/forum?id=B1l6qiR5F7

摘要

自然語言可視為是一種小單元 (如短語) 嵌套在大單元 (如字句) 中的分層結構。當結束一個大單元時,內部所嵌套的小單元也將隨之關閉。盡管標準的 LSTM 結構允許不同的神經元跟蹤不同時間維度信息,但它對于層級結構建模中的各組成沒有明確的偏向。針對這個問題,本文提出神經元排序策略來添加一個歸納偏置量 (inducive bias),當主輸入向量和遺忘門結構確保給定的神經網絡更新時,后續跟隨的所有神經元也將隨之更新。這種集成樹結構的新穎循環神經網絡 ON-LSTM (ordered neurons LSTM) 在四種不同的 NLP 任務:語言建模、無監督解析、目標句法評估和邏輯推理上都取得了良好的表現。

研究動機

將樹結構集成到神經網絡模型用于 NLP 任務主要有如下原因:

學習抽象的逐層特征表征是深度神經網絡結構的一大關鍵特征

對語言的組成影響進行建模并通過 shortcuts 連接方法為反向傳播過程提供有效的梯度信息,這有助于解決深度神經網絡結構的長期依賴性問題

通過更好的歸納偏置來改善模型的泛化能力,同時能夠減少模型訓練過程對大量數據的需求

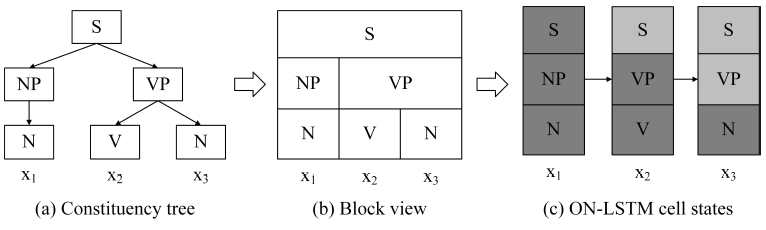

基于以上動機,該研究提出一種有序化神經元方法 (結構示意圖如下圖1),通過歸納偏置來強化每個神經元中的信息儲存:大的、高級的神經元儲存長期信息,這些信息通過大量的步驟保存;小的、低級的神經元儲存短期信息,這些信息能夠快速遺忘。此外,一種新型的激活函數 cumulative softmax (cumax) 用于主動為神經元分配長/短期所儲存的信息,有效地避免高/低級神經元的固定劃分問題。

總的來說,本文的研究集成樹結構到 LSTM 網絡中,并通過歸納偏置和 cumax 函數,構建一種新穎的 ON-LSTM 模型,在多項 NLP 任務中都取得了不錯的性能表現。

圖1 組成解析樹結構與 ON-LSTM 模型隱藏狀態的對應關系

實驗結果

在四種 NLP 任務中評估 ON-LSTM 模型的性能,具體如下。

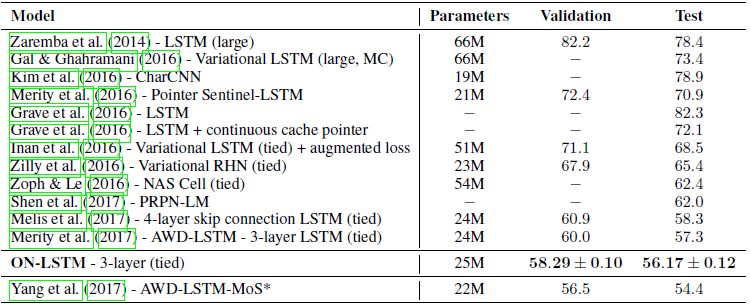

語言建模

圖2 Penn Treebank 語言建模任務驗證機和測試集的單模型困惑度

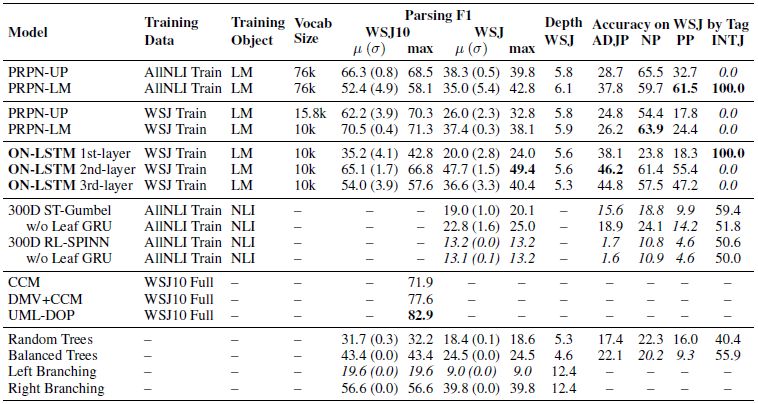

無監督句法組成分析

圖3 full WSJ10 和 WSJ test 數據集上的句法組成分析評估結果

目標句法評估

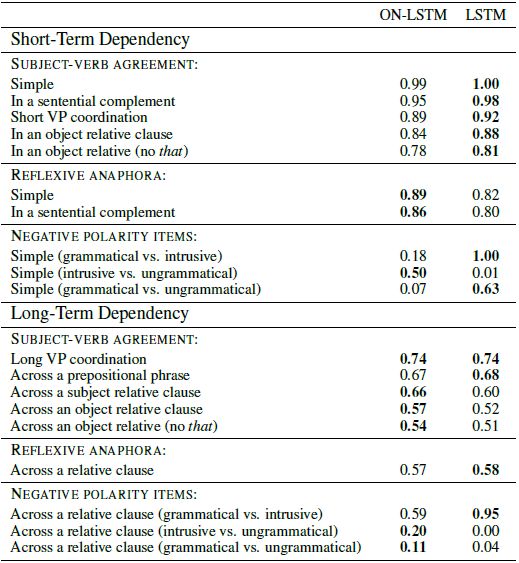

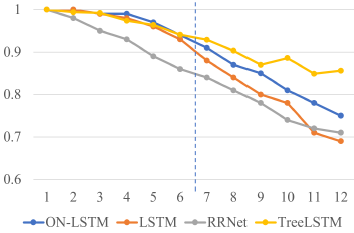

圖4 ON-LSTM 和 LSTM 模型在每個測試樣本的總體精度表現

邏輯推理

圖5 在邏輯短序列數據上訓練的模型的測試精度

論文二

論文地址:

https://openreview.net/forum?id=rJl-b3RcF7

摘要

神經網絡的剪枝技術能夠在不影響模型準確性能的情況下,減少網絡的訓練參數量,多達90%以上,在降低計算存儲空間的同時提高模型的推理性能。然而,先前的研究經驗表明,通過剪枝技術得到的稀疏網絡結構在初期是很難訓練的,這似乎也有利于訓練性能的提升。一個標準的剪枝技術能夠自然地發現子網絡結構,這些子網絡的初始化能夠幫助網絡更有效地訓練。

因此,本研究提出一種 lottery ticket hypothesis:對于那些包含子網絡 (winning ticket) 結構的密集、隨機初始化前饋網絡,當單獨訓練這些子網絡時,通過相似的訓練迭代次數能夠取得與原始網絡相當的測試性能。而這些子網絡也驗證了初始的假設:即具有初始權重的連接網絡能夠更有效地訓練。

基于這些結果,本文提出一種算法來確定子網絡結構,并通過一系列的實驗來支持 lottery ticket hypothesis 以及這些偶然初始化的重要性。實驗結果表明,在 MNIST 和 CIFAR-10 數據集上,子網絡的規模始終比幾種全連接結構和卷積神經網絡小10%-20%。當規模超過這個范圍時,子網絡能夠比原始網絡有更快的學習速度和更好的測試精度表現。

研究動機與方法

本文分析驗證了存在較小的子網絡結構,在相當的測試精度表現前提下,一開始就訓練網絡能夠達到與較大子網絡一樣,甚至更快的訓練速度。而基于此,本文提出 Lottery Ticket Hypothesis:將一個復雜網絡的所有參數作為一個獎勵池,存在一個參數組合所構成的子網絡 (用 winning ticket 表示),單獨訓練該網絡能夠達到與原始復雜網絡相當的測試精度。

對于該子網絡結構的確定,主要是通過訓練一個網絡并剪枝其中最小權重來確定子網絡,而其余未剪枝部分連接構成自網絡的結構。具體步驟如下:

首先通過隨機初始化得到一個復雜的神經網絡 f

接著重復訓練該網絡 j 次,得到網絡參數

然后對該模型按 p% 進行剪枝得到一個掩碼 m;將步驟二中的網絡參數作為參數向量,每個向量元素對應于一個 m,用于表征是否丟棄。

最后,對于存留下來的模型,在原始復雜網絡參數組合進行初始化,創建一個子網絡結構。

總的來說,本研究的主要貢獻如下:

驗證了剪枝技術能夠發現可訓練的子網絡結構,而這些網絡能夠達到與原始網絡相當的測試精度。

提出了一種 lottery ticket hypothesis,從一種新的角度來解釋這些神經網絡的組成。

證明了通過剪枝技術得到的子網絡相比于原是網絡,有著更快的學習速度、更高的測試精度和更好的泛化性能。

應用

本文的研究驗證了確實存在比原始網絡更快速、性能更佳的子網絡,這種結構能夠給未來的研究提供諸多方向:

提高模型訓練性能:由于子網絡能夠從一開始就進行單獨訓練,因此盡早進行剪枝的訓練方案值得進一步探索。

設計更好的網絡結構:子網絡結構的存在說明稀疏架構和初始化組合有利于模型的學習。因此設計出有助于學習的新結構和初始化方案,甚至將子網絡結構遷移到其他任務仍需要進一步研究。

提高神經網絡的理論理解高度:更加深入地理解隨機初始化網絡與子網絡的關系、網絡優化與泛化性能的知識等。

-

神經網絡

+關注

關注

42文章

4807瀏覽量

102795 -

神經元

+關注

關注

1文章

368瀏覽量

18755 -

深度學習

+關注

關注

73文章

5554瀏覽量

122489

原文標題:ICLR 2019最佳論文揭曉!NLP深度學習、神經網絡壓縮奪魁 | 技術頭條

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

后摩智能四篇論文入選三大國際頂會

老板必修課:如何用NotebookLM 在上下班路上吃透一篇科技論文?

美報告:中國芯片研究論文全球領先

OpenHarmony程序分析框架論文入選ICSE 2025

評論