眾所周知,人臉識別在攝像頭無法捕捉到完整面部圖像的情況下很難獲得理想的效果。最近布拉德福德大學(xué)的研究人員在不完整面部識別方面獲得了突破性進(jìn)展,實驗表明,掃描整個面部的3/4、甚至1/2的識別準(zhǔn)確率能夠達(dá)到100%!

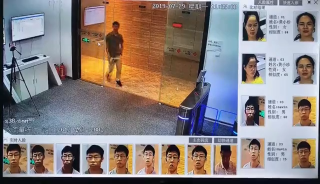

基于計算機的人臉識別已經(jīng)成為一種成熟且可靠的機制,實際上已被應(yīng)用于許多訪問控制場景,不過目前面部識別或認(rèn)證,主要使用全正臉面部圖像的“完美”數(shù)據(jù)來執(zhí)行。但實際上,有許多情況下比如閉路電視攝像機往往只能拍到臉的一側(cè),或者如果被拍攝者戴了帽子、口罩等遮擋物,就無法獲得完整的正臉。因此,使用不完整面部數(shù)據(jù)的面部識別是一個亟待開發(fā)的研究領(lǐng)域。

來自布拉德福德大學(xué)的研究團(tuán)隊的最新研究在不完整面部識別方面,取得了突破性進(jìn)展,實驗使用最先進(jìn)的基于卷積神經(jīng)網(wǎng)絡(luò)的架構(gòu)以及預(yù)先訓(xùn)練的VGG-Face模型,使用余弦相似度和線性支持向量機來測試識別率。團(tuán)隊在兩個公開可用的數(shù)據(jù)集(受控的巴西FEI和不受控制的LFW)上進(jìn)行了實驗。

實驗表明,掃描整個面部的3/4、甚至1/2的識別準(zhǔn)確率能夠達(dá)到100%!除此之外,團(tuán)隊還研究了面部的某個獨立的部位,比如鼻子、臉頰、前額或嘴巴的識別率,以及圖像的旋轉(zhuǎn)和縮放對面部識別主體的影響。結(jié)果發(fā)現(xiàn),如果只針對面部的某個獨立的部位,比如鼻子、臉頰、前額或嘴巴,識別率總是相對較低。

據(jù)悉,這是第一個使用機器學(xué)習(xí)來測試面部不同部位識別率的研究,論文已發(fā)表在Future Generation Computer Systems上。下面新智元對本次實驗進(jìn)行介紹。

人類可以不受環(huán)境影響的

識別人臉,那么計算機也可以嗎?

面部是人類生命中視覺系統(tǒng)中繪制得最多的圖片,所以大部分人類擁有卓越的面部識別能力。一般來說,我們不需要像面部識別AI那樣必須正視別人的正臉才能識別出對方,通常對于我們只要一瞥即可分辨。

普遍認(rèn)為大腦通過記住重要的細(xì)節(jié),例如與眼睛,鼻子,前額,臉頰和嘴巴相對應(yīng)的關(guān)鍵特征的形狀和顏色,對面部進(jìn)行區(qū)分。此外,人類大腦可以應(yīng)對不同光線環(huán)境下、不同面部表情,以及遠(yuǎn)處面部的顯著變化。

然而,與此相反,任何在光線、表情、姿勢和即眼鏡或胡子等等的變化,都可能對計算機的識別率產(chǎn)生巨大影響。不過,因為計算機處理海量數(shù)據(jù)的能力不斷提高,可以認(rèn)為機器算法(例如CNN)至少在面部匹配方面擁有優(yōu)異的表現(xiàn)。

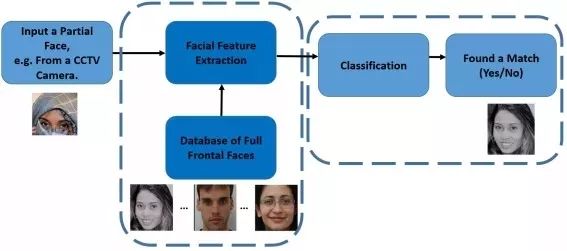

順著這個邏輯,研究團(tuán)隊使用有遮擋的不完整人臉照片作為測試集,下面是一個測試集的示例圖片,以及計算機對不完整人臉照片的識別過程。

示例圖片

識別過程

使用CNN和VGG-Face,

利用兩個分類器進(jìn)行不完整人臉的識別

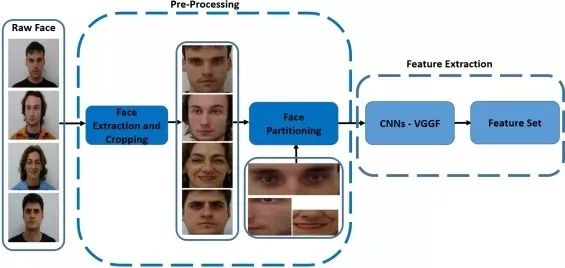

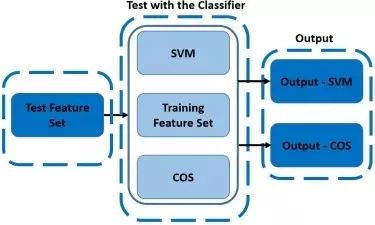

團(tuán)隊主要研究面部的不同部分如何有利于識別,以及在機器學(xué)習(xí)場景中如何在對面部照片進(jìn)行不同程度旋轉(zhuǎn)、縮放的識別。實驗使用基于CNN的架構(gòu)以及預(yù)訓(xùn)練的VGG-Face模型來提取特征。然后使用兩個分類器,即余弦相似度(CS)和線性SVM來測試識別率。下圖表現(xiàn)了特征提取步驟的概述:

遮擋臉部的示例圖片

基于VGGF的特征提取過程

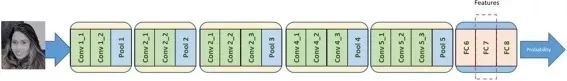

VGG-Face模型

目前最流行和廣泛應(yīng)用于人臉識別的是VGGF模型,由Oxford Visual Geometry Group開發(fā)。該模型在一個超過2.6 K個體的2.6M面部圖像的巨大數(shù)據(jù)集上進(jìn)行訓(xùn)練。

在VGGF中,其中13層是卷積網(wǎng)絡(luò),其他是ReLU、pooling的混合體,最后一層是softmax。

13個卷積層

為了確定VGGF模型中用于面部特征提取的最佳層,通常必須進(jìn)行一些試驗和錯誤實驗。在本實驗中,團(tuán)隊發(fā)現(xiàn)最好的結(jié)果來自第34層。值得注意的是,該層是完全連接的層,位于神經(jīng)網(wǎng)絡(luò)的末端,這意味著提取的特征代表代表了全臉。

特征分類:為什么使用

余弦相似度和線性SVM

本次實驗中,研究團(tuán)隊使用了余弦相似度(CS)和線性SVM分類器。做出這樣的選擇基于兩個原因:首先,團(tuán)隊測試了其他分類器后發(fā)現(xiàn)CS和線性SVM的效果最好;其次,通過實驗和分析,團(tuán)隊發(fā)現(xiàn)這兩個分類器能夠更準(zhǔn)確地分離數(shù)據(jù)。

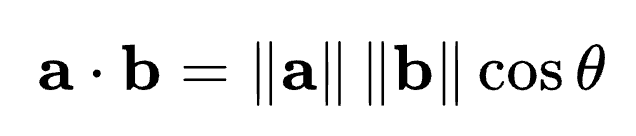

余弦相似度

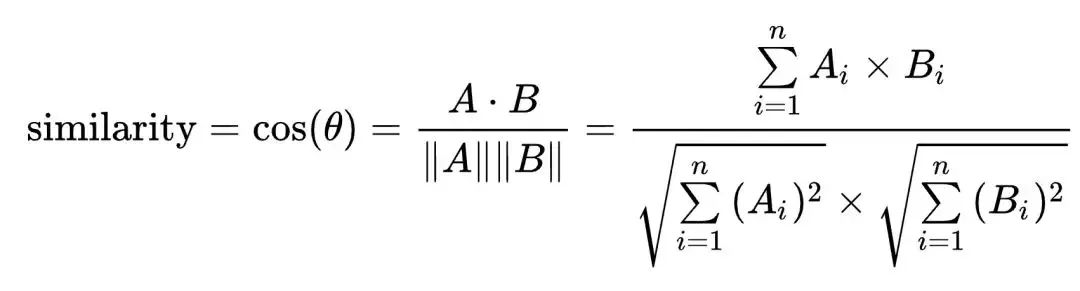

兩個向量間的余弦值可以通過使用歐幾里得點積公式求出:

給定兩個屬性向量, A 和B,其余弦相似性θ由點積和向量長度給出,如下所示:

這里的Ai和Bi分別代表向量A和B的各分量。

本次實驗需要計算CS以通過使用Eqs找到測試圖像和訓(xùn)練圖像之間的最小距離。如圖8所示:

線性SVM

SVM是一個二元分類算法,線性分類和非線性分類都支持。經(jīng)過演進(jìn),現(xiàn)在也可以支持多元分類,同時經(jīng)過擴展,也能應(yīng)用于回歸問題。在本實驗中,研究團(tuán)隊對兩種SVM都進(jìn)行了測試,發(fā)現(xiàn)當(dāng)使用部分面部作為測試集的時候,線性SVM能夠獲得更好的效果。

例如,對于右臉頰,線性SVM的識別準(zhǔn)確率達(dá)到了24.44%,而具有徑向基函數(shù)的非線性SVM的識別率僅為2.77%。

遮掉半張臉,

準(zhǔn)確率也能高達(dá)100%!

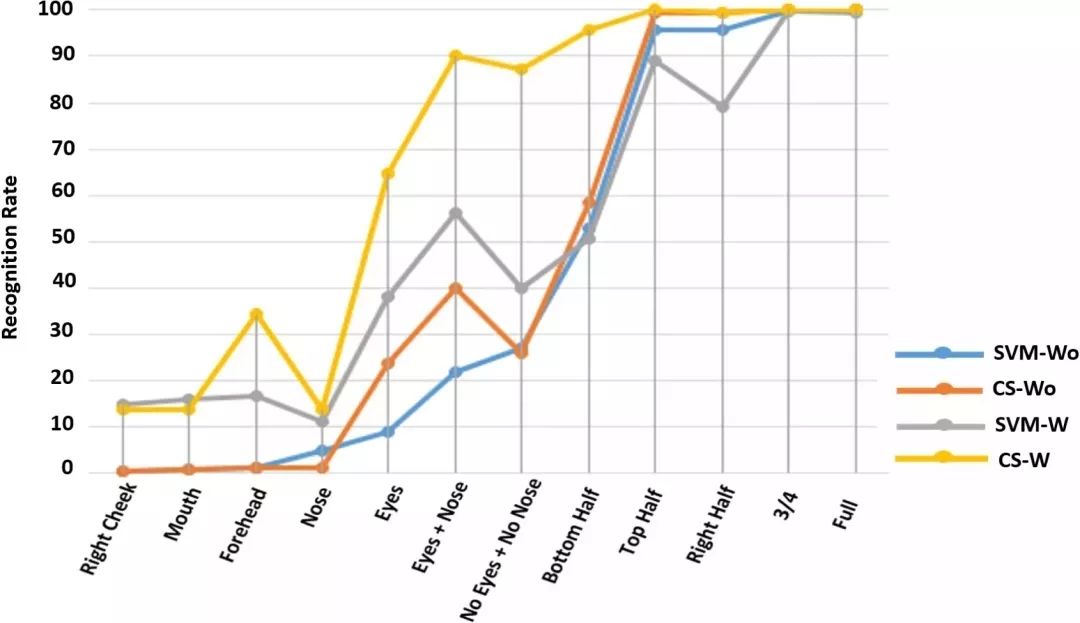

這項工作提供了一組全面的實驗,使用面部的不同部分進(jìn)行面部識別。

利用了兩個流行的人臉數(shù)據(jù)集的人臉圖像,即FEI和LFW數(shù)據(jù)集。使用級聯(lián)物體檢測器對兩個數(shù)據(jù)庫中的所有圖像進(jìn)行裁剪以盡可能地去除背景,以便提取面部和內(nèi)部面部特征。但是,對于某些具有非常復(fù)雜背景的圖像,如LFW數(shù)據(jù)庫的情況,作者手動裁剪這些面部。

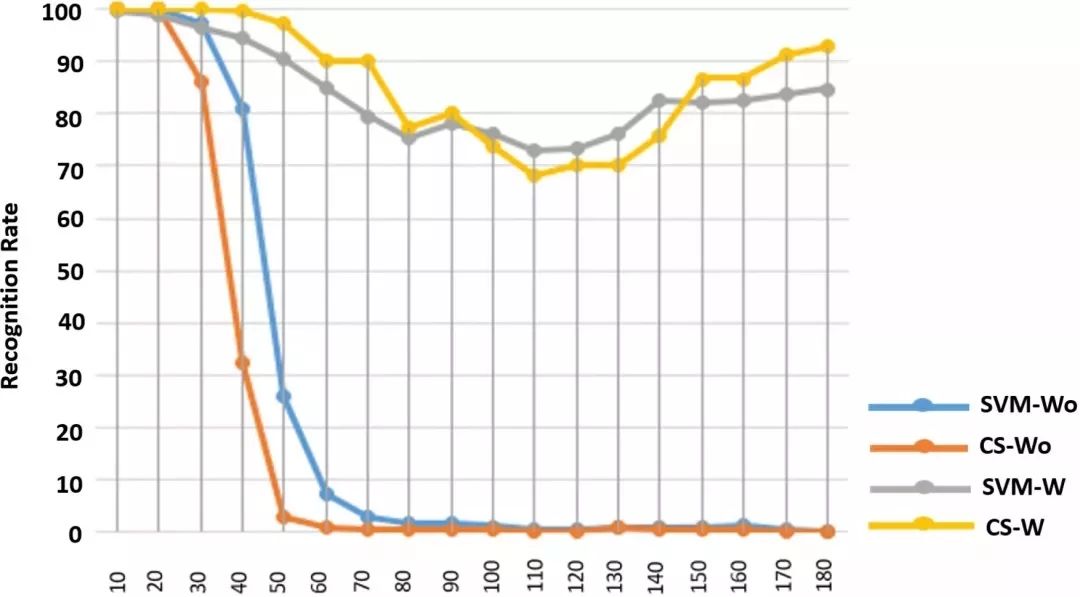

在這項工作中,已經(jīng)進(jìn)行了許多遮擋設(shè)置,以驗證該方法可以處理正常和遮擋的面部識別任務(wù)。為此,進(jìn)行了兩組主要的實驗:一組不使用局部,旋轉(zhuǎn)和縮放的面部作為訓(xùn)練面部數(shù)據(jù)的一部分,另一部分使用部分,旋轉(zhuǎn)和縮放的面部作為訓(xùn)練的一部分。

在每種情況下,使用兩個分類器進(jìn)行了14個涉及部分,旋轉(zhuǎn)和縮小人臉的子實驗。出于訓(xùn)練目的,使用了每個受試者70%的圖像,這些圖像也通過諸如填充和翻轉(zhuǎn)之類的操作來增強。在每種情況下,剩余的30%的圖像用于測試。

從FEI數(shù)據(jù)集中采樣面部數(shù)據(jù)

用于測試FEI數(shù)據(jù)集上識別率的面部部分

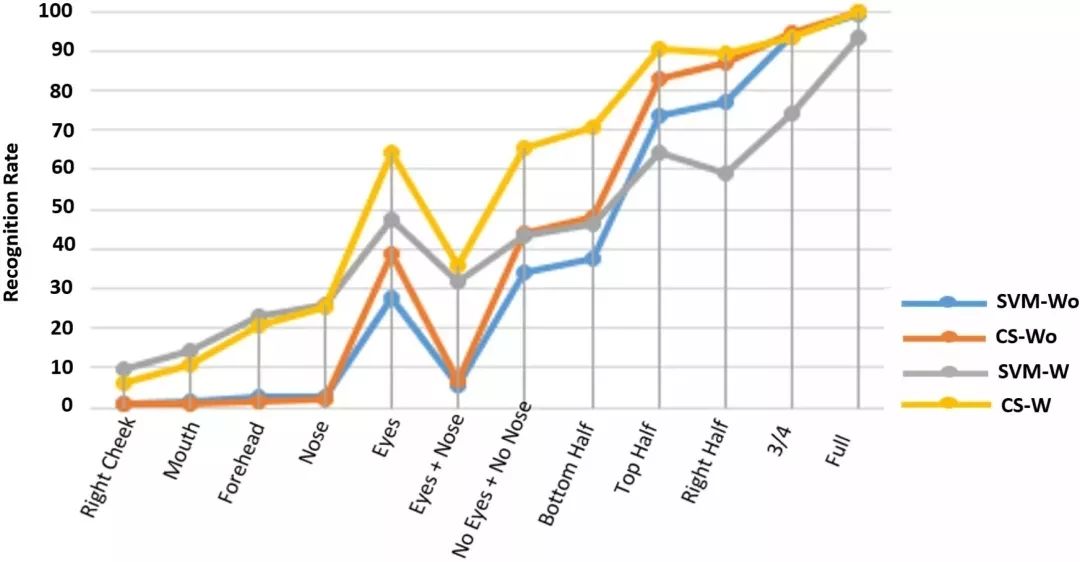

在FEI數(shù)據(jù)庫中使用基于面部部分的SVM和CS分類器的面部識別率 - 在訓(xùn)練中不使用/使用面部的面部部分

在FEI數(shù)據(jù)集上顯示面旋轉(zhuǎn)(10°到180°)

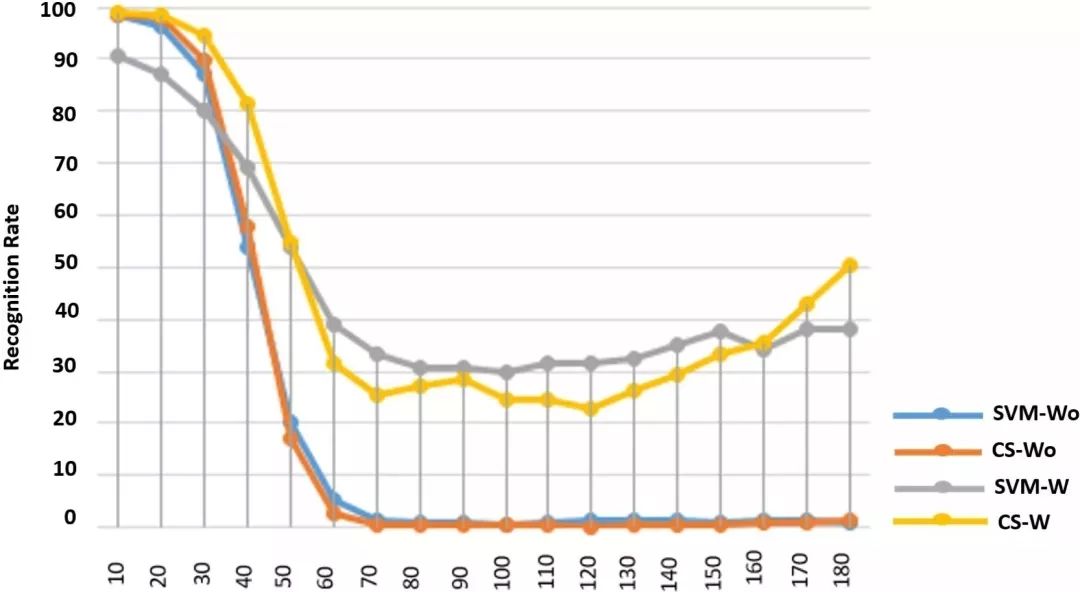

在FEI數(shù)據(jù)集上使用SVM和CS分類器的人臉識別率(基于訓(xùn)練集中沒有和有旋轉(zhuǎn)人臉圖片)

一個在FEI數(shù)據(jù)集中縮小(10%到90%)人臉的例子

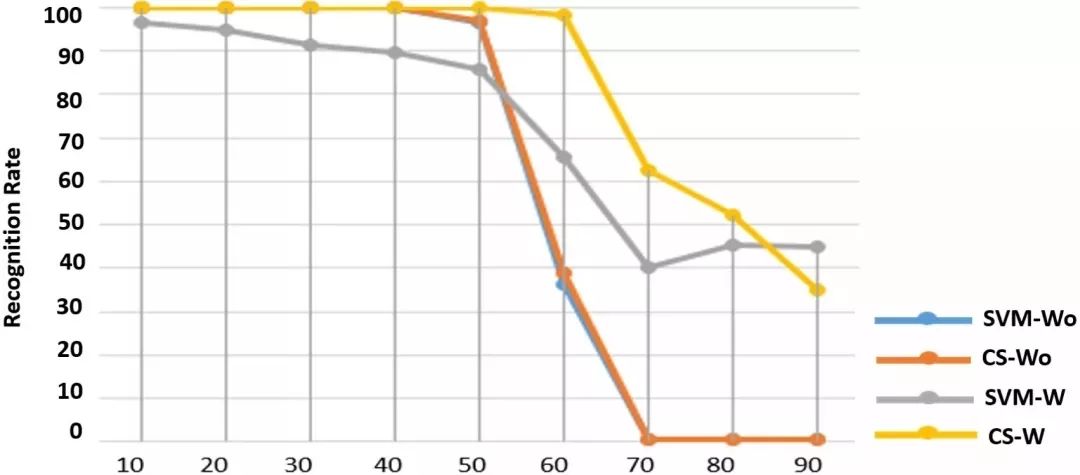

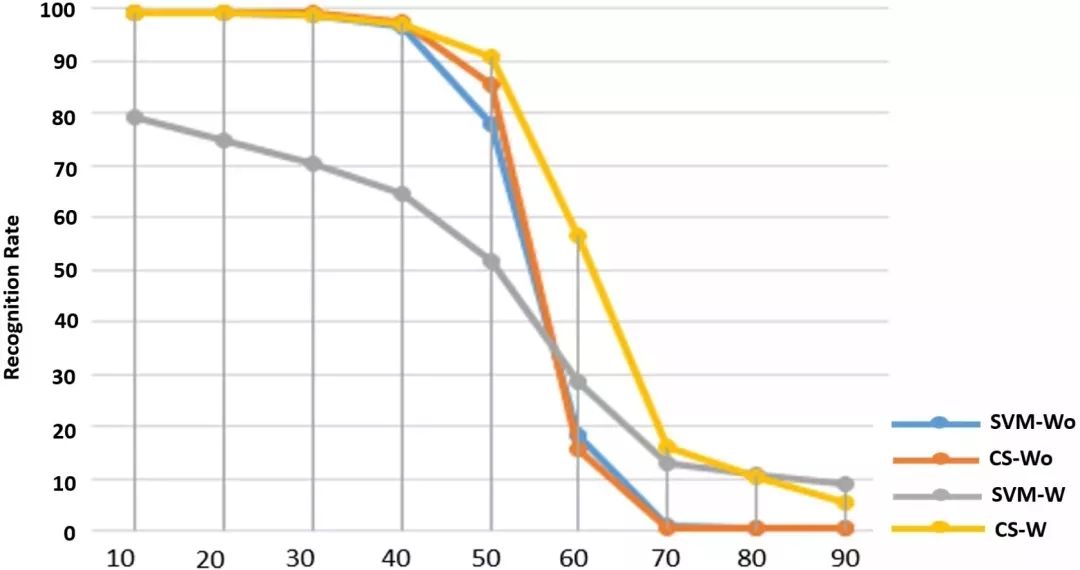

利用SVM和CS分類器對FEI中縮小后的人臉進(jìn)行快速識別

一些來自LFW數(shù)據(jù)集的人臉圖像樣本

來自LFW數(shù)據(jù)庫的面部部分樣本

在LFW數(shù)據(jù)集上,分別使用SVM和CS兩種分類器對訓(xùn)練中未使用/使用的人臉各部分進(jìn)行識別

在LFW數(shù)據(jù)集上使用基于SVM和CS分類器的人臉旋轉(zhuǎn)的人臉識別率(在沒有和使用單個旋轉(zhuǎn)面作為訓(xùn)練數(shù)據(jù)的情況下)

在LFW數(shù)據(jù)庫上,基于SVM和CS分類器的圖像縮放識別率

使用CS進(jìn)行正確匹配的結(jié)果,對于嘴的部分

使用CS測量的錯誤匹配的結(jié)果,對于嘴的部分

正確匹配的結(jié)果使用CS測量,為右臉頰

應(yīng)用前景

研究團(tuán)隊負(fù)責(zé)人Hassan Ugail教授表示這個結(jié)果展示了不完整面部識別的美好前景:“現(xiàn)在已經(jīng)證明,可以從僅顯示部分臉部的圖像中,獲得非常準(zhǔn)確的面部識別率,并且已經(jīng)確定哪些部分的識別準(zhǔn)確率更高,這為該技術(shù)應(yīng)用于安防或預(yù)防犯罪等方面,開辟了更大的可能性。”

不過Hassan Ugail教授還表示,目前實驗還需要在更大的數(shù)據(jù)集上進(jìn)行驗證。顯然,將來很可能用于面部識別的圖像數(shù)據(jù)庫也需要包含不完整面部的圖像。

-

人臉識別

+關(guān)注

關(guān)注

76文章

4011瀏覽量

81867

原文標(biāo)題:鬼都藏不住,人臉識別新突破!就算遮住半張臉也能100%被識別

文章出處:【微信號:WW_CGQJS,微信公眾號:傳感器技術(shù)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

人臉識別技術(shù)的可行性在于矛盾具有什么性

人臉識別技術(shù)的優(yōu)缺點有哪些

人臉識別技術(shù)的原理介紹

如何設(shè)計人臉識別的神經(jīng)網(wǎng)絡(luò)

人臉識別模型訓(xùn)練流程

人臉識別模型訓(xùn)練是什么意思

人臉檢測和人臉識別的區(qū)別是什么

人臉檢測與識別的方法有哪些

人臉識別門禁系統(tǒng)賦能社區(qū)安防

人臉識別門禁方案:輕松實現(xiàn)刷臉開門、閘機及考勤管理

哪些場景要使用到人臉識別門禁考勤一體機

人臉識別新突破 半張臉也能100%識別

人臉識別新突破 半張臉也能100%識別

評論