ICLR 2019過去有幾天了,作為今年上半年表現最為亮眼的人工智能頂會共收到1591篇論文,錄取率為31.7%。

為期4天的會議,共有8個邀請演講主題,內容包括:算法公平性的進展、對抗機器學習、發展自主學習:人工智能,認知科學和教育技術、用神經模型學習自然語言界面等等。

當然,除此之外,還有一大堆的poster。這些都彰顯了ICLR的規格之高,研究者實力之強大。

透過現象看本質,一位來自越南的作家和計算機科學家Chip Huyen總結了ICLR 2019年的8大趨勢。他表示。會議組織者越來越強調包容性,在學術研究方面RNN正在失去研究的光芒......

1.包容性。

組織者強調了包容性在人工智能中的重要性,確保前兩次主要會談的開幕詞邀請講話是關于公平和平等的。

但是還是有一些令人擔憂的統計數據:

只有8.6%的演講者和15%的參與者是女性。

在所有的LGBTQ+(Lesbian Gay Bisexual Transgender Queer:性別獨角獸群體)研究人員中,有2/3的研究人員并不是專業的。

所有8位特邀演講者都是白人。

來自薩沙·拉什(Sasha Rush)開幕詞的截圖

不幸的是,這位AI研究人員仍然感到毫無歉意。雖然其他所有的研討會的訂閱量爆滿,但在Yoshua Bengio出現之前,AI賦能社會(AI for Social Good)研討會一直空無一人。在我在ICLR的眾多談話中,沒有人提到過差異性,除了有一次我大力聲討地問為什么我被邀請參加這場似乎不適合我的技術活動?一位好朋友說:“有點冒犯的回答是,因為你是一個女人。”

原因之一是這個話題不是“技術性的”,因此在上面花時間將無助于你在研究領域的職業發展。另一個原因是仍然存在一些反對的偏見。有一次,一位朋友告訴我,不要理睬一位在群聊中嘲笑我的人,因為“那人喜歡取笑那些談論平等和差異性的人。”我有一些朋友,他們不會在網上討論任何關于差異性的話題,因為他們不想“與這種話題聯系在一起”。

2.無監督表征學習與遷移學習

無監督表示學習的一個主要目標是從未標記的數據中發現有用的數據,以便用于后續任務。在自然語言處理中,無監督的表示學習通常是通過語言建模來完成的。然后將學習到的表示用于諸如情感分析、名字分類識別和機器翻譯等任務。

去年發表的一些最令人興奮的論文是關于自然語言處理中的無監督學習的,首先是ApacheElmo(Peters等人)、DB2ULMFiT(Howard等人)、ApacheOpenAI的GPT(Radford等人)、IBMBert(Devlin等人),當然還有,比較激進的202GPT-2(Radford等人)。

完整的GPT-2模型是在 ICLR演示的,它的表現非常好。您可以輸入幾乎任何提示,它將撰寫文章的其余部分。它可以撰寫BuzzFeed文章(美國新聞RSS訂閱,類似于今日頭條)、小說、科學研究論文,甚至是虛構單詞的定義。但這聽起來還不完全是人類的感覺。該團隊正在研究GPT-3,會比現在更好。我迫不及待地想看看它能產生什么。

雖然計算機視覺社區是第一個將遷移學習用于工作的社區,但基礎任務-在ImageNet上訓練分類模型-仍然受到監督。我不斷從兩個社區的研究人員那里聽到的一個問題是:“我們如何才能獲得為圖像工作的無監督學習?”

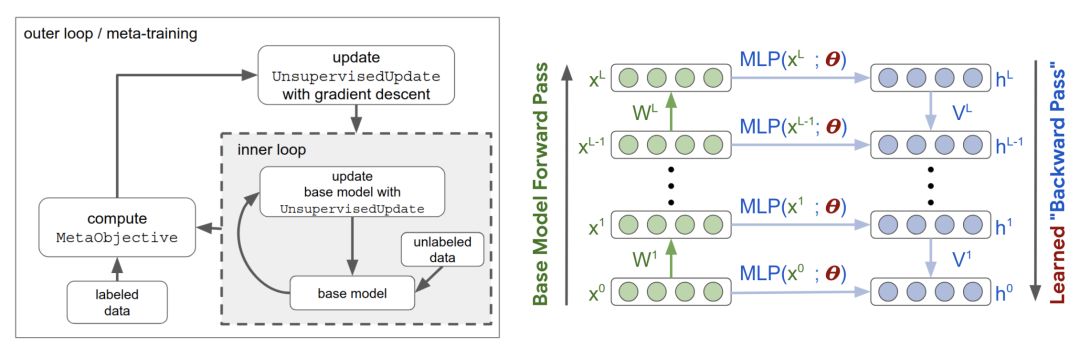

盡管大多數大牌研究實驗室已經在進行這方面的研究,但在ICLR上只有一篇論文:“元學習無監督學習的更新規則”(Metz et al.)。他們的算法不升級權值,而是升級學習規則。

然后,在少量的標記樣本上對從學習規則中學習到的表示進行調整,以完成圖像分類任務。他們找到了學習規則,在MNIST和FashionMNIST數據集上達到了70%的準確率。作者不打算發布代碼,因為“它與計算有關”。在256個GPU上,外層循環需要大約100k的訓練步驟和200個小時。

關于元學習的內層和外層循環(Metz等人)

我有一種感覺,在不久的將來,我們將看到更多這樣的研究。可用于無監督學習的一些任務包括:自動編碼、預測圖像旋轉(Gidaris等人的這篇論文是2018年ICLR的熱門文章),預測視頻中的下一幀。

3.機器學習的“復古”

機器學習中的思想就像時尚:它們繞著一個圈走。在海報展示會上走來走去,就像沿著記憶小路在漫步。即使是備受期待的ICLR辯論最終也是由先驗與結構結束,這是對Yann LeCun和 Christopher Manning去年討論的回溯,而且與貝葉斯主義者和頻率論者之間的由來的辯論相似。

麻省理工學院媒體實驗室的語言學習和理解項目于2001年終止,但基礎語言學習今年卷土重來,兩篇論文都是基于強化學習:

DOM-Q-Net:基于結構化語言(Jia等人)的RL-一種學習通過填充字段和單擊鏈接導航Web的RL算法,給定一個用自然語言表示的目標。

BabyAI:一個研究扎根語言學習樣本效率的平臺(Chevalier-Boisveret等人)-這是一個與OpenAI訓練兼容的平臺,具有一個手動操作的BOT代理,它模擬人類教師來指導代理學習一種合成語言。

AnonReviewer4很好地總結了我對這兩篇論文的看法:

“…這里提出的方法看起來非常類似于語義解析文獻中,已經研究過一段時間的方法。然而,這篇論文只引用了最近深入的RL論文。我認為,讓作者熟悉這些文學作品將會使他們受益匪淺。我認為語義解析社區也會從這個…中受益。但這兩個社區似乎并不經常交談,盡管在某些情況下,我們正在解決非常相似的問題。”

確定性有限自動機(DFA)也在今年的深度學習領域中占據了一席之地,它有兩篇論文:

表示形式語言的:有限自動機(FA)與遞歸神經網絡(RNN)的比較(Michalenko等人)。

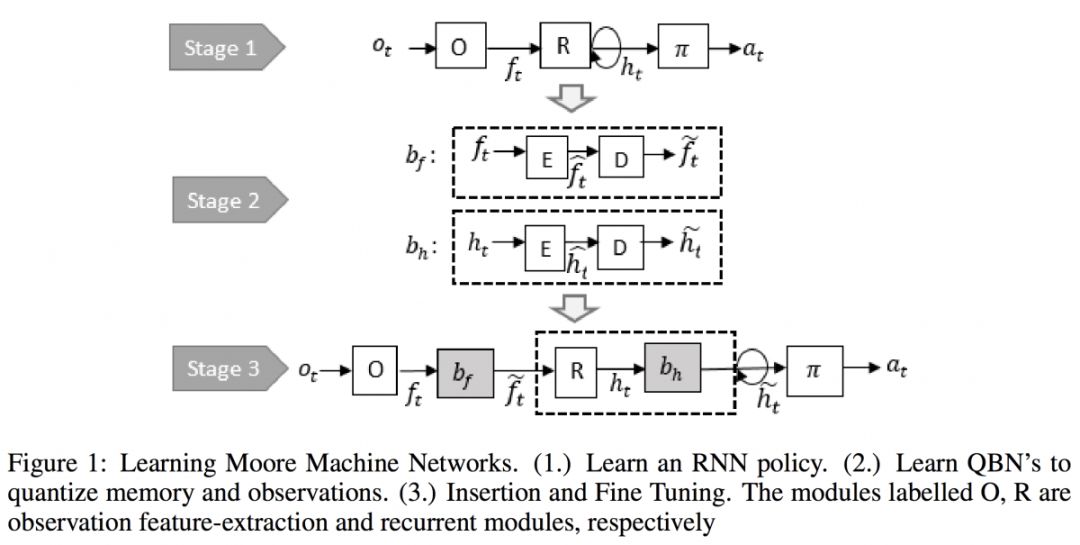

學習遞歸策略網絡的有限狀態表示(Koulet等人)

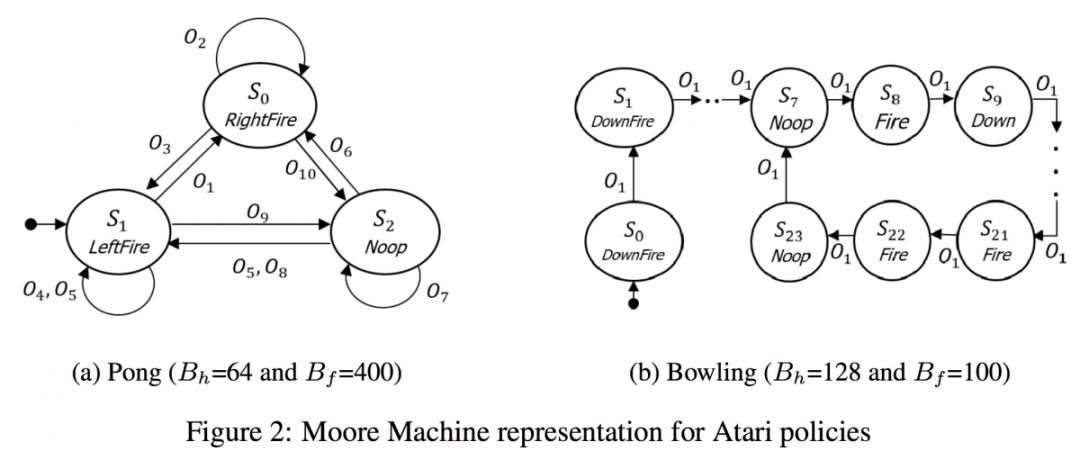

這兩篇論文背后的主要動機是,由于RNN中隱藏狀態的空間是巨大的,是否有可能將狀態數量減少到有限的狀態?我猜測DFA是否能有效地代表語言的RNN,但我真的很喜歡在訓練期間學習RNN,然后將其轉換為DFA以供參考的想法,正如Koul等人的論文中所介紹的那樣。最終的有限表示只需要3個離散的記憶狀態和10場觀察的乒乓球游戲。有限狀態表示也有助于解釋RNN。

來自RNN的學習DFA的三個階段(Koul等人)

提取的自動機(Koul等人)

4.RNN正在失去研究的光芒

2018年至2019年提交(論文)主題的相對變化表明,RNN的下降幅度最大。這并不奇怪,因為盡管RNN對于序列數據是直觀的,但它們有一個巨大的缺點:它們不能被并行化,因此不能利用自2012年以來推動研究進展的最大因素:計算能力。RNN在CV或RL中從未流行過,而對于NLP,它們正被基于注意力的體系結構所取代。

RNN正在失去光芒。圖來自ICLR 2019數據補充

這是不是意味著RNN已經over了?不一定。今年的兩個最佳論文獎之一是“有序神經元:將樹結構集成到遞歸神經網絡中”。(Shen等人)。除了本文和上面提到的兩篇關于自動機的文章之外,今年又有9篇關于RNN的論文被接受,其中大多數都深入研究了RNN的數學基礎,而不是發現新的RNN應用方向。

RNN在行業中仍然非常活躍,特別是對于交易公司等處理時間序列數據的公司來說,不幸的是,這些公司通常不會發布它們的工作成果。即使RNN現在對研究人員沒有吸引力,說不定它可能會在未來卷土重來。

5.GAN持續火熱

盡管與去年相比GAN的相對增長略有下降, 但論文數量實際上從去年的約70篇漲到了今年的100多篇。Ian Goodfellow做了一個關于GAN的特邀報告,更是受其信徒大力推崇。以至于到了最后一天, 他不得不遮住胸前的徽章, 這樣人們才不會因為看到他的名字而激動不已。

第一個海報展示環節全是關于GAN的最新進展,涵蓋了全新的GAN架構、舊架構的改進、GAN分析、以及從圖像生成到文本生成再到語音合成的GAN應用。

衍生出了PATE-GAN, GANSynth, ProbGAN, InstaGAN, RelGAN, MisGAN, SPIGAN, LayoutGAN, KnockoffGAN等等不同的GAN網絡。總而言之,只要提到GAN我就好像變成了一個文盲,迷失在林林總總的GAN網絡中。值得一提的是,Andrew Brock沒有把他的大規模GAN模型叫做giGANtic讓我好生失望。

GAN的海報展示環節也揭示了在GAN問題上,ICLR社區是多么的兩極分化。我聽到有些人小聲嘟囔著“我已經等不及看到這些GAN的完蛋啦”,“只要有人提到對抗(adversarial)我的腦瓜仁就疼”。當然,據我分析,他們也可能只是嫉妒而已。

6.缺乏生物啟發式深度學習

關于基因組學的論文為零。也沒有關于這一專題的研討會。盡管這一現象令人遺憾, 但也為對生物學感興趣的深度學習研究人員或對深度學習感興趣的生物學家提供了巨大的機會。

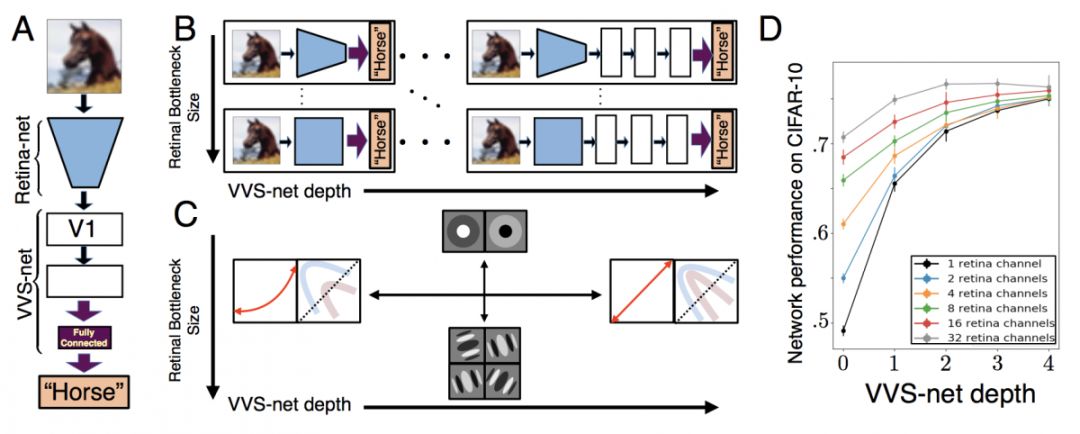

趣聞軼事:Retina論文(A Unified Theory of Early Visual Representations from Retina to Cortex through Anatomically Constrained Deep CNNs)的第一作者,Jack Lindsey,還只是Stanford的一名大四學生。真是英雄出少年啊!

7.強化學習仍舊是最受歡迎的主題。

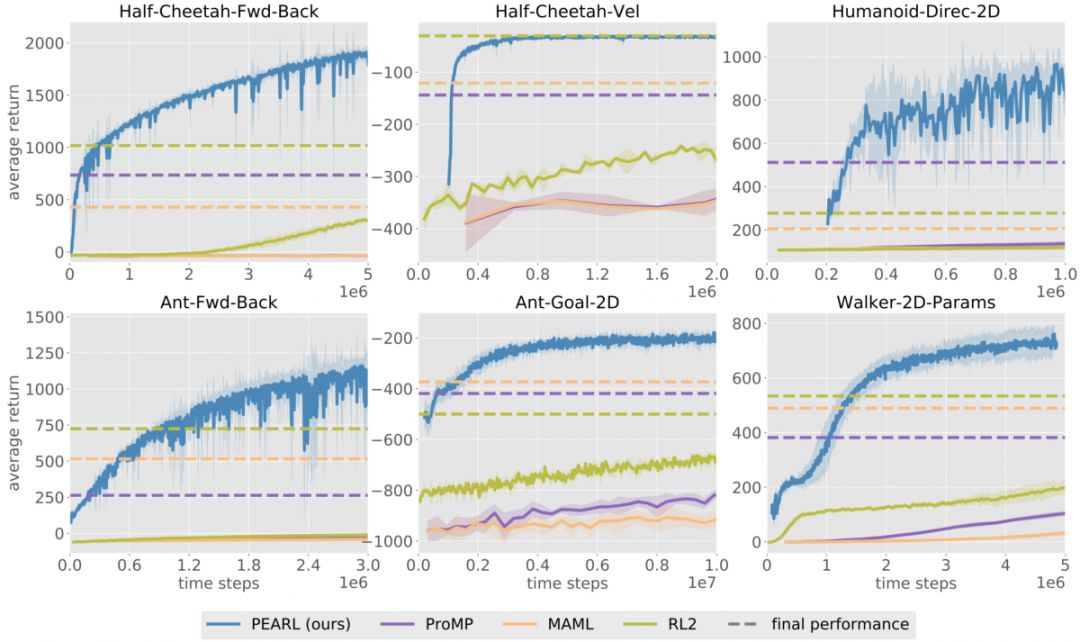

會議上的報告表明,RL社區正在從model-free 方法向sample-efficient model-based和meta-learning算法轉移。這種轉變可能是受TD3和SAC在Mujoco平臺的連續控制任務,以及R2D2在Atari離散控制任務上的極高得分所推動的。

基于模型的算法(即從數據中學習環境模型,并利用它規劃或生成更多數據的算法)終于能逐漸達到其對應的無模型算法的性能,而且只需要原先十分之一至百分之一的經驗。

這一優勢使他們適合于實際任務。盡管學習得到的單一模擬器很可能存在缺陷,但可以通過更復雜的動力學模型,例如集成模擬器,來改善它的缺陷。

另一種將RL應用到實際問題的方法是允許模擬器支持任意復雜的隨機化(arbitrarily complex randomizations):在一組不同的模擬環境上訓練的策略可以將現實世界視為另一個隨機化(randomization),并力求成功

元學習(Meta-learning)算法,可實現在多個任務之間的快速遷移學習,也已經在樣本效率(smaple-efficiency)和性能方面取得了很大的進步(Promp(Rothfuss等人)

這些改進使我們更接近“the ImageNet moment of RL”,即我們可以復用從其他任務中學到的控制策略,而不是每個任務都從頭開始學習。

大部分已被接受的論文,連同整個Structure and Priors in RL研討會,都致力于將一些有關環境的知識整合到學習算法中。雖然早期的深度RL算法的主要優勢之一是通用性(例如,DQN對所有Atari游戲都使用相同的體系結構,而無需知道某個特定的游戲),但新的算法表明,結合先驗知識有助于完成更復雜的任務。例如,在Transporter Network(Jakab et al.)中,使用的先驗知識進行更具信息量的結構性探索。

綜上所述,在過去的5年中,RL社區開發了各種有效的工具來解決無模型配置下的RL問題。現在是時候提出更具樣本效率(sample-efficient)和可遷移性(transferable)的算法來將RL應用于現實世界中的問題了。

8.大部分論文都會很快被人遺忘

當我問一位著名的研究人員,他對今年被接受的論文有何看法時,他笑著說:“大部分論文都會在會議結束后被遺忘”。在一個和機器學習一樣快速發展的領域里,可能每過幾周甚至幾天曾經的最好記錄就會被打破,正因此對于論文還沒發表就已經out了這一現象也就見怪不怪了。例如,根據Borealis Ai對ICLR 2018的統計,“每八篇里面有七篇論文的結果,在ICLR會議開始之前就已經被超越了。”

在會議期間我經常聽到的一個評論是,接受/拒絕決定的隨機性。盡管我不會指明有哪些,但在過去幾年中,確實有一些如今被談論最多/引用最多的論文在最初提交給會議的時候被拒了。而許多被接受的論文仍將持續數年而不被引用。

-

人工智能

+關注

關注

1792文章

47354瀏覽量

238814 -

rnn

+關注

關注

0文章

89瀏覽量

6895

原文標題:ICLR 2019八大趨勢:RNN正在失去光芒,強化學習仍最受歡迎

文章出處:【微信號:BigDataDigest,微信公眾號:大數據文摘】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

螞蟻集團收購邊塞科技,吳翼出任強化學習實驗室首席科學家

RNN的應用領域及未來發展趨勢

RNN與LSTM模型的比較分析

RNN在圖片描述生成中的應用

深度學習中RNN的優勢與挑戰

RNN的基本原理與實現

如何使用RNN進行時間序列預測

LSTM神經網絡與傳統RNN的區別

如何使用 PyTorch 進行強化學習

谷歌AlphaChip強化學習工具發布,聯發科天璣芯片率先采用

CNN與RNN的關系?

rnn是什么神經網絡

rnn神經網絡模型原理

什么是RNN (循環神經網絡)?

RNN正在失去光芒 強化學習仍最受歡迎

RNN正在失去光芒 強化學習仍最受歡迎

評論