本文介紹了一種基于激光雷達(dá)數(shù)據(jù)的激光網(wǎng)絡(luò)自動(dòng)駕駛三維目標(biāo)檢測(cè)方法——LaserNet。高效的處理結(jié)果來(lái)自于在傳感器的自然距離視圖中處理激光雷達(dá)數(shù)據(jù)。在激光雷達(dá)視場(chǎng)范圍內(nèi)的操作有許多挑戰(zhàn),不僅包括遮擋和尺度變化,還有基于傳感器如何捕獲數(shù)據(jù)來(lái)提供全流程信息。

本文介紹的方法是使用一個(gè)全卷積網(wǎng)絡(luò)來(lái)預(yù)測(cè)每個(gè)點(diǎn)在三維物體上的多模態(tài)分布,然后有效地融合這些多模態(tài)分布來(lái)生成對(duì)每個(gè)對(duì)象的預(yù)測(cè)。實(shí)驗(yàn)表明,把每個(gè)檢測(cè)建模看作一個(gè)分布,能獲得更好的整體檢測(cè)性能。基準(zhǔn)測(cè)試結(jié)果表明,相比其他的檢測(cè)方法,本方法的運(yùn)行時(shí)間更少;在訓(xùn)練大量數(shù)據(jù)來(lái)克服視場(chǎng)范圍目標(biāo)檢測(cè)問(wèn)題上,本方法獲得最佳性能。

LaserNet通過(guò)以下幾個(gè)步驟實(shí)現(xiàn)三維檢測(cè):

使用傳感器的固有范圍視場(chǎng)來(lái)構(gòu)建一個(gè)密集的輸入圖像;

圖像通過(guò)全卷積網(wǎng)絡(luò)生成一組預(yù)測(cè);

對(duì)于圖像中的每個(gè)激光雷達(dá)點(diǎn),預(yù)測(cè)一個(gè)類概率,并在俯視圖中對(duì)邊界框架進(jìn)行概率分布回歸;

每個(gè)激光雷達(dá)點(diǎn)分布通過(guò)均值漂移聚類進(jìn)行組合,以降低單個(gè)預(yù)測(cè)中的噪聲;

檢測(cè)器進(jìn)行端到端訓(xùn)練,在邊界框架上定義損失;

用一種新的自適應(yīng)非最大抑制(NMS)算法來(lái)消除重疊的邊框分布。

上圖為深層聚合網(wǎng)絡(luò)架構(gòu)。列表示不同的分辨率級(jí)別,行表示聚合階段。

上圖為特征提取模塊(左)和特征聚合模塊(右)。虛線表示對(duì)特征圖進(jìn)行了卷積。

上圖為自適應(yīng)NMS。在兩輛車并排放置的情況下,左邊的虛線描述了產(chǎn)生的一組可能的預(yù)測(cè)。為了確定邊界框是否封裝了唯一的對(duì)象,使用預(yù)測(cè)的方差(如中間所示)來(lái)估計(jì)最壞情況下的重疊(如右圖所示)。在本例中,由于實(shí)際重疊小于估計(jì)的最壞情況重疊,因此將保留這兩個(gè)邊界框。

上圖為在訓(xùn)練集和驗(yàn)證集上的邊界框上的預(yù)測(cè)分布的校準(zhǔn)的圖。結(jié)果表明,該模型不能學(xué)習(xí)KITTI上的概率分布,而能夠?qū)W習(xí)較大的ATG4D上的分布。

【實(shí)驗(yàn)結(jié)果】

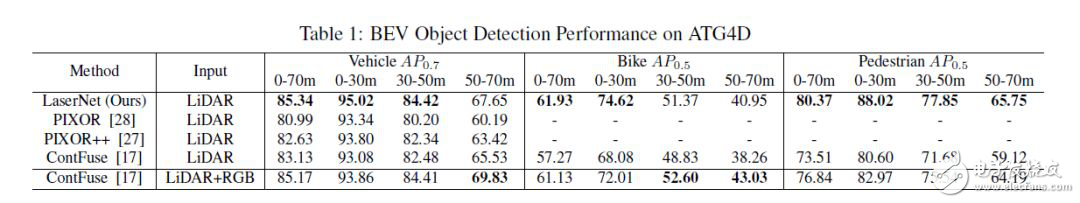

上表顯示了與其他最先進(jìn)的方法相比,LaserNet在驗(yàn)證集上的結(jié)果。像KITTI基準(zhǔn)一樣,我們計(jì)算了汽車0.7 IoU和自行車及行人0:5 IoU的平均精度(AP)。在這個(gè)數(shù)據(jù)集上,LaserNet在0-70米范圍內(nèi)表現(xiàn)優(yōu)于現(xiàn)有的最先進(jìn)的方法。此外,LaserNet在所有距離上都優(yōu)于LiDAR-only方法,只有在附加圖像數(shù)據(jù)提供最大價(jià)值的長(zhǎng)距離上,車輛和自行車上的LiDAR-RGB方法優(yōu)于LaserNet。

對(duì)ATG4D數(shù)據(jù)集進(jìn)行消融研究,結(jié)果如上表所示。

預(yù)測(cè)概率分布。預(yù)測(cè)概率分布最大的改進(jìn)是預(yù)測(cè)邊界框架的分布。當(dāng)僅預(yù)測(cè)平均邊界框時(shí),公式(6)為簡(jiǎn)單平均,公式(9)為框角損失。此外,邊界框的得分在本例中是類概率。實(shí)驗(yàn)結(jié)果表明,性能上的損失是由于概率與邊界框架的準(zhǔn)確性沒(méi)有很好地相關(guān)性導(dǎo)致的。

圖像形成:Velodyne 64E激光雷達(dá)中的激光器并不是均勻間隔的。通過(guò)使用激光id將點(diǎn)映射到行,并在傳感器捕獲數(shù)據(jù)時(shí)直接處理數(shù)據(jù),可以獲得性能上的提高。

均值漂移聚類:每個(gè)點(diǎn)獨(dú)立地預(yù)測(cè)邊界框的分布,通過(guò)均值漂移聚類將獨(dú)立的預(yù)測(cè)組合起來(lái)實(shí)現(xiàn)降噪。

非極大值抑制:當(dāng)激光雷達(dá)的點(diǎn)稀疏時(shí),有多個(gè)邊界框的配置可以解釋觀測(cè)到的數(shù)據(jù)。通過(guò)預(yù)測(cè)各點(diǎn)的多模態(tài)分布,進(jìn)一步提高了該方法的查全率。在生成多模態(tài)分布時(shí),使用具有嚴(yán)格閾值的NMS是不合適的。或者,我們可以使用軟NMS來(lái)重新評(píng)估置信度,但是這打破了對(duì)置信度的概率解釋。通過(guò)自適應(yīng)NMS算法,保持了概率解釋,并獲得了更好的性能。

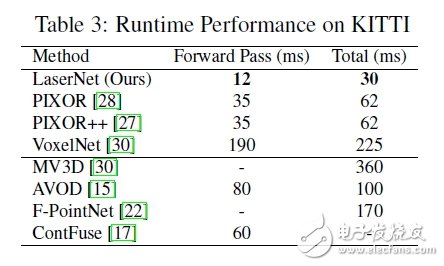

對(duì)于自動(dòng)駕駛而言,運(yùn)行時(shí)性能同樣重要。上表比較了LaserNet(在NVIDIA 1080Ti GPU上測(cè)量)和KITTI上現(xiàn)有方法的運(yùn)行時(shí)的性能。Forward Pass是指運(yùn)行網(wǎng)絡(luò)所花費(fèi)的時(shí)間,除Forward Pass外,總時(shí)間還包括預(yù)處理和后處理。由于在一個(gè)小的密集的范圍視場(chǎng)內(nèi)處理,LaserNet比目前最先進(jìn)的方法快兩倍。

使用訓(xùn)練集中的5,985個(gè)掃描點(diǎn)訓(xùn)練網(wǎng)絡(luò),并保留其余的掃描以進(jìn)行驗(yàn)證。使用與之前相同的學(xué)習(xí)時(shí)間表對(duì)網(wǎng)絡(luò)進(jìn)行5萬(wàn)次迭代訓(xùn)練,并在單個(gè)GPU上使用12個(gè)批處理。為了避免在這個(gè)小的訓(xùn)練集上過(guò)度擬合,采用數(shù)據(jù)增強(qiáng)手段隨機(jī)翻轉(zhuǎn)范圍圖像,并在水平維度上隨機(jī)像素移動(dòng)。在這樣一個(gè)小的數(shù)據(jù)集中,學(xué)習(xí)邊界框上的概率分布,特別是多模態(tài)分布是非常困難的。因此,訓(xùn)練網(wǎng)絡(luò)只檢測(cè)車輛并預(yù)測(cè)邊界框上的單峰概率分布。如上表所示,我們的方法在這個(gè)小數(shù)據(jù)集上的性能比當(dāng)前最先進(jìn)的鳥(niǎo)瞰圖檢測(cè)器差。

-

檢測(cè)器

+關(guān)注

關(guān)注

1文章

898瀏覽量

48876 -

激光雷達(dá)

+關(guān)注

關(guān)注

973文章

4249瀏覽量

193324 -

自動(dòng)駕駛

+關(guān)注

關(guān)注

790文章

14389瀏覽量

171395

發(fā)布評(píng)論請(qǐng)先 登錄

淺析自動(dòng)駕駛發(fā)展趨勢(shì),激光雷達(dá)是未來(lái)?

激光雷達(dá)是自動(dòng)駕駛不可或缺的傳感器

激光雷達(dá)分類以及應(yīng)用

激光雷達(dá)-無(wú)人駕駛汽車的必爭(zhēng)之地

成熟的無(wú)人駕駛方案離不開(kāi)激光雷達(dá)

北醒固態(tài)設(shè)計(jì)激光雷達(dá)

北醒固態(tài)激光雷達(dá)

固態(tài)設(shè)計(jì)激光雷達(dá)

激光雷達(dá)除了可以激光測(cè)距外,還可以怎么應(yīng)用?

從光電技術(shù)角度解析自動(dòng)駕駛激光雷達(dá)

自動(dòng)駕駛激光雷達(dá)新型探測(cè)器:近紅外MPPC

激光雷達(dá)成為自動(dòng)駕駛門檻,陶瓷基板豈能袖手旁觀

激光雷達(dá)如何助力自動(dòng)駕駛?

激光雷達(dá)技術(shù):自動(dòng)駕駛的應(yīng)用與發(fā)展趨勢(shì)

評(píng)論