前言

一年一度的人機交互領域國際頂級會議 ACM CHI 將于 5 月 4 號在英國格拉斯哥舉行,我的一篇文章 SmartEye: Assisting Instant Photo Taking via Integrating User Preference with Deep View Proposal Network 被會議接收,并獲得了最佳論文提名獎。(本文希望從思路上回憶自己產出這篇論文的過程,更多的描述了一個以用戶為中心的人機交互(HCI)領域的科研成果的形成過程,本文用到了計算機視覺和機器學習的相關方法,但并非一個技術文章,如果有技術方面的問題歡迎留言和我聯系)

動機

當我們看到好看的風景,有趣的小東西,可口的菜肴,可愛的小狗,我們喜歡掏出兜里的手機拍一張照。但是對著同樣的景物,有的人拍的很好看有的人拍的不那么好看,這其中的原因是什么?是構圖的區別,構圖在很大程度上決定了一張照片的美學質量。但是構圖并非一件容易的事,很多非專業的人無法掌握構圖的技巧,因此我們打算利用技術幫助人們更好的去對照片進行構圖。

專業和非專業的攝影者拍攝出來的照片效果天差地別

現有問題:現在有很多幫助人們構圖的算法,不過存在著一個很關鍵的問題就是實時性不夠強,需要先拍照,然后再離線處理,這樣會帶來兩個問題,一個是會需要額外的存儲和時間,另一個是離線算法是基于已經拍好的照片的,會極大受限于這張照片,在拍照時移動手機的過程中好的構圖很容易被錯過。

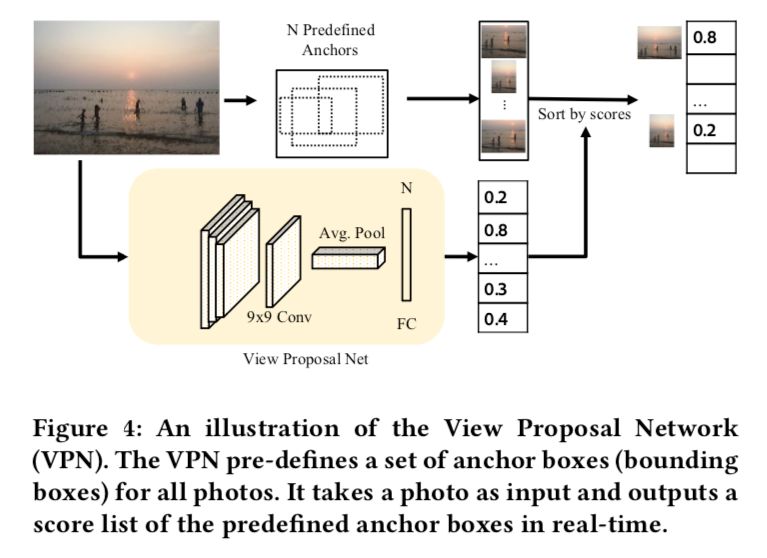

解決方案:我們利用了一個基于百萬級圖片訓練出來的深度學習模型 View Proposal Network(VPN)來幫助構圖[1],這是我們這篇文章的合作者魏子鈞博士發表在 CVPR 2018 中的一篇文章。VPN 具有 state-of-the-art 的表現,以及具有很好的實時性(基于 One-stage object detection),可以達到 75fps。其作用可以簡單的描述為:輸入一張照片,基于圖片裁剪的方式(對原圖進行各種 aspect ratio,size…… 的裁剪),生成一系列構圖候選(Composition candidate),并且對每一個構圖候選進行打分,按照從高到低的順序輸出。

構圖推薦網絡(View Proposal Network)流程圖

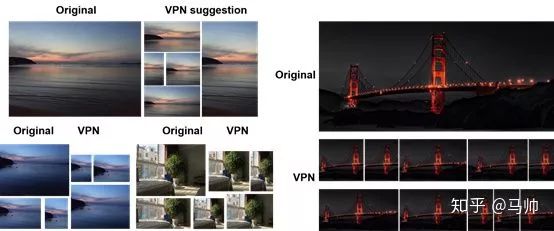

VPN 的效果圖(給定一張照片,可以給出一系列推薦構圖)。

只有算法還不夠,還需要搭配更友好的交互方式:

但是僅僅有了一個實時的深度學習模型還不夠,我們需要讓這個算法能夠友好的為用戶所使用,應用到拍照場景中去,這樣才是真正的幫助人們進行拍照構圖。

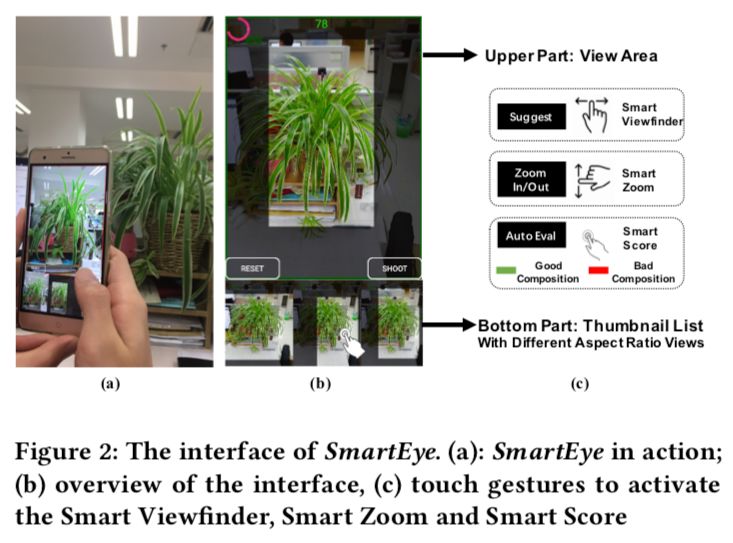

我們將 VPN 封裝為后端的算法,設計了一個 APP 來讓算法真正實用,同時設計了友好新穎的用戶界面和豐富的功能和特性來連接用戶和深度學習模型。

用戶界面圖:(a)用戶使用 SmartEye(b)主要用戶界面(c)功能和手勢支持圖

界面整體分為兩個部分,上面是一個視圖區,下面是一個縮略圖列表,視圖區就像是一個普通的拍照取景區域,有三個功能,一個是用于實時的展示 SmartViewfinder(下面會介紹)的推薦,一個是可以放大顯示下方的縮略圖,還有一個是作為用戶選定構圖之后的一個預覽窗口,下方的縮略圖列表顯示著由 VPN 推薦的各種比例的構圖推薦,可以左右滑動來切換和查看各種各樣的構圖。

我們還設計了幾種強大的功能支持:

SmartViewfinder。當我們移動手機時,基于實時的相機鏡頭捕捉到的圖像,SV 實時的提供構圖推薦,在視圖區展示最好的一個,在縮略圖列表中存放著其他的。

SmartViewfinder 實時構圖推薦

SmartScore。為當前鏡頭進行實時的打分,顯示在視圖區的最上方,鏡頭一旦移動或者鏡頭中的景物一旦變化,分數就會隨著做出改變,如果當前構圖質量很高,視圖區的邊框會變為綠色,反之紅色,用來實時的提醒用戶給用戶反饋。

SmartScore 幫助鏡頭自動打分

因顯示視頻數量限制,Demo視頻可瀏覽:

http://v.qq.com/x/page/i0884109zj4.html

SmartZoom。一個智能的縮放功能,可以幫助用戶自動的縮放到一個最合適的尺度,這個功能旨在讓縮放操作變得更容易,因為人們總是一不小心就縮放過了。

SmartZoom 實現智能縮放

除此之外我們還提供了一些其他的功能,比如自定義推薦數,用戶可以自己選擇在縮略圖列表中展示的推薦書,自由裁剪,在系統給出的構圖推薦基礎上,用戶如果有一些不滿意,可以在此基礎上拖動裁剪框,再次進行裁剪邊界的調整。APP 還提供了豐富的手勢來觸發和切換這些功能,比如左右滑來瀏覽 SmartViewfinder,手指上下滑動來進行 SmartZoom 縮放,長按來激活 SmartScore。

好不好用?

我們找了一些人來使用這個 APP,收集了大家的反應。大家都對這個 APP 持有積極的看法,但是一些用戶也提出了意見,“為什么我喜歡的構圖排在了后面”、“如果這張構圖能夠稍微向左靠一點就好了”、“盡管我可以通過裁剪加以調整,但是我希望系統能直接推薦給我我想要的”。

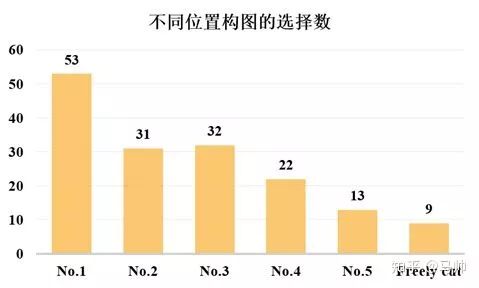

我們也發現了一些問題,VPN 按照得分高低順序推薦,但是在很多情況下,用戶并沒有選擇排在第一位的構圖,我們簡單的做了一個實驗,固定 VPN 推薦的數量為 5,邀請了 16 個被試(被試情況在后面敘述)進行了拍照,每個人拍攝 10 張照片,我們記錄了每張照片最后用戶選擇的是第幾張,結果如圖所示:

16 個被試拍攝 10 張照片的過程中,不同位置的選擇人次(No.1 代表構圖候選列表中的第一個,以此類推,Freely cut 代表用戶沒有選擇推薦構圖而是自己進行了裁剪)

可以發現盡管第一位的數量有很多,但是第二位到第五位也同樣不少,還有一些用戶選擇了自己裁剪。

新的問題:用戶偏好的存在(本文核心)

于是我們挑選了 10 張照片,每張照片由 VPN 生成 5 個推薦構圖,然后打亂順序,讓 16 個參與者分別挑選最喜歡的構圖,我們對結果做了可視化的分析,得到了一個發現,同樣一張照片,不同用戶最喜歡的構圖方式(裁剪區域)有所不同,比如下面的這個圖中,為了容易看清,我們可視化了 3 位用戶最喜歡的構圖方式,可以看到是不一樣的。

對于某一張照片三個用戶最喜歡的構圖的邊框并不相同

然后我們在每張圖片上繪制了 16 個用戶最喜歡的構圖中心點分布的 heatmap,可以發現并非所有的人都喜歡同樣的構圖。這個發現十分明確和易于理解,因為一千個人眼中有一千個哈姆雷特,每個人的審美標準都不同,構圖相對而言是一個主觀性十分強的任務(并不類似于計算機視覺中其他目標檢測任務),而 VPN 只是通過眾包數據學習到了一個通用的審美標準,所以我們認為有必要將用戶的個人偏好考慮進推薦算法中。

兩張照片中不同用戶最喜歡的構圖的中心點組成的 heatmap

如何考慮用戶偏好?

這個問題是我們這片論文的一個難點。我們的第一個考慮十分直接,就是從數據出發,VPN 既然能夠生成不同的構圖,并且給它們打分,那我們就改造一下 VPN,讓它能夠把用戶的偏好也學習進去。我們嘗試了一些方法來調整 VPN,包括 retrain 和 fine-tune,但是都因為數據量的問題以失敗告終了,因為我們很難通過少量的帶有用戶偏好的數據來調整一個已經訓練好的深度學習模型。

既然直接修改 VPN 并不容易,我們考慮加入一個模塊,能夠考慮用戶的偏好,這個模塊需要做到可以針對一張構圖生成一個打分,這樣就可以用這個新的打分來調整一個構圖最終的得分,從而調整模型最終的輸出順序。我們稱這個模塊為 Preference 模塊(P-Module),我們對 P-Module 有一些要求,一是能夠準確的對用戶偏好進行建模,而且對噪聲要有一定魯棒性;二是在分數預測方面十分高效;三是 P-Module 要比較小巧,可以用小量的數據來訓練和更新,代表著用戶偏好的圖片越多,P 模塊就理論上越能夠考慮用戶的偏好。

敲定了上述需求,P-Module 可以視為一個機器學習中的回歸問題,我們可以通過設計特征來對用戶偏好建模。

如何對偏好建模?

我們起初,直觀上覺得既然用戶的選擇來源于 VPN 的各種各樣構圖推薦,不同的構圖之間最明顯的區別是什么呀?是大小、位置、長寬比之類的啊,我們為何不能從這些方面入手,簡簡單單就可以 model 用戶偏好,豈不美哉?事實操作發現根本不怎么 work。

簡單的特征不奏效,那么我們就設計更復雜更有力的美學特征唄,于是我們通過閱讀相關的用戶偏好建模文獻,以及攝影、美學相關的文章,從中吸取了大量經驗,設計出了一個復雜的 feature set,又做了一系列特征選擇,但是發現效果并沒有多么理想,甚至在一些 test set 上還不如一開始最簡單的十來維特征有效。

那該怎么辦?用戶偏好為什么這么難以 model?我不禁問自己,總說要對偏好進行建模,那在構圖這個任務中,用戶偏好到底是什么啊?

經歷了短暫的郁悶期,我突然清醒,既然你要研究用戶偏好,為何從用戶中來,到用戶中去呢?于是我深入群眾,去探討用戶偏好是什么的問題。

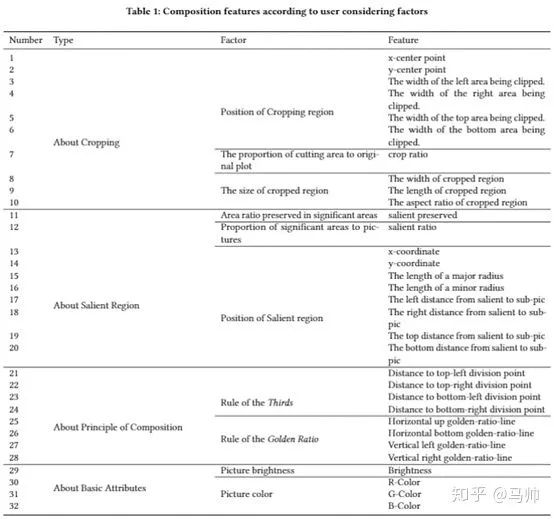

我們進行了一些前期的 User Study 工作(在 User Study 部分會有詳細描述),收集了一大波用戶反饋意見,進行了細致的整理和歸納,得到了許許多多有用的建議(在我的論文中進行了歸納和整理,為了節約篇幅這里不做描述),并且基于用戶的這些建議和之前調研的一些攝影、構圖、美學方面的知識我們設計并選擇了 4 類 32 維特征,分別是基于幾何學的、基于顯著區域的、基于構圖規則的、基于拍照的。

設計的 4 類 32 維特征

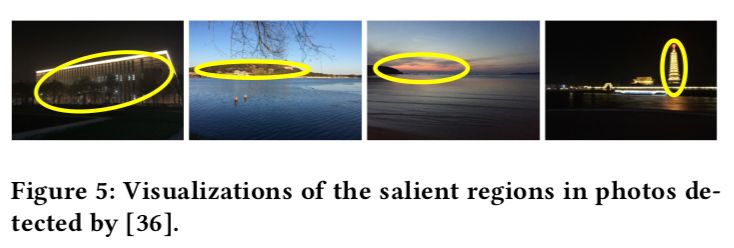

其中提取顯著區域的效果如下

圖片的顯著區域(由一個橢圓包圍)

(這里需要提一句的是:我們并不是說這些特征是最好用的,相反,我們希望其他人或者我在接下來的工作里可以通過設計新的 feature vector 從而獲得更好的結果。構建能夠為我們的任務提供非常好的性能并且可以有效計算的特征集仍然是一個有趣的開放性問題。)

特征設計完了,到底有沒有用呢?我們進行了詳細的實驗得出結論——特征顯著性和相關性都比較強,這個問題留在最后的 User Study 中敘述,我們接下來要討論的是構建模型。

如何構建 P-Module?

首先我們要確定模型類別,考慮到用戶在使用我們的 APP 時,從 N 個構圖推薦中選擇最滿意的一個點擊 “拍照” 按鈕,然后保存到本地相冊,這是一個最自然不過的打 0/1 標簽的過程(被選擇的是正樣本,其他的被隨機選擇為負樣本,避免樣本不均衡問題),所以我們暫定了 LogisticRegression 作為我們的打分模型(將 1 的概率映射為分數),而且在收集的數據中(用戶實驗部分將要描述)跑了一下結果,發現作為一個 score model,各項指標還是蠻不錯的。

給定一個構圖 來自一張照片 , 我們提取了它的特征 并且把它送進 LR 模型得到了一個標準化的用戶偏好得分。

LR 的簡單性使得 P-Module 對噪聲魯棒、易于在線交互式的更新、以及高效的預測得分。

如何將 P-Module 和 VPN 進行結合?

我們依據了一個基于記憶的算法(這個算法基于用戶過去的打分來預測現在的分數)把 VPN 打分和 P-Module 打分結合了起來。更具體的,我們動態的調整了對于一張構圖 ,VPN 的打分 和 P-Module 的打分 的權重:

其中 是一個置信度(confidence score),用來描述當前照片 和用戶過去選擇過的構圖有多么相似。我們基于一個假設:如果一個相似的圖片已經作為知識(訓練樣本)被 P-Module 學習過了,我們有理由相信最終的得分應該更依賴于 P-Module 的打分。因此,我們通過計算當前照片與已處理過的照片的構圖距離來計算置信度。當前照片與已有照片越相似,置信度越高,P-Module 的打分在最終打分中占的比重就越大。

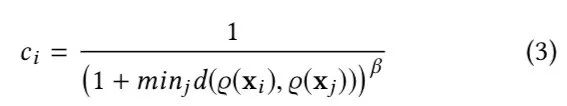

置信度的計算公式如下:

其中 是兩個構圖的特征向量 之間的歐氏距離。 是一個超參數來控制 的變異率。在本文工作中,我們固定 。值得一提的是,置信度可以簡單的描述為當前算法做出的推薦是更多依賴于 VPN 還是更多依賴于 P-Module,也就是用戶個人偏好,我們將置信度顯示在 APP 的界面中,并且進行實時的更新,在之后的用戶實驗中也證明:在這種主觀性較強的,用戶可能不是十分相信 AI 算法的任務中,如果給用戶展示一個“當前算法有多少依賴于你”,能讓用戶在查看算法給出的推薦時,更加容易做出選擇和覺得被尊重,也會讓用戶覺得系統更加人性化。

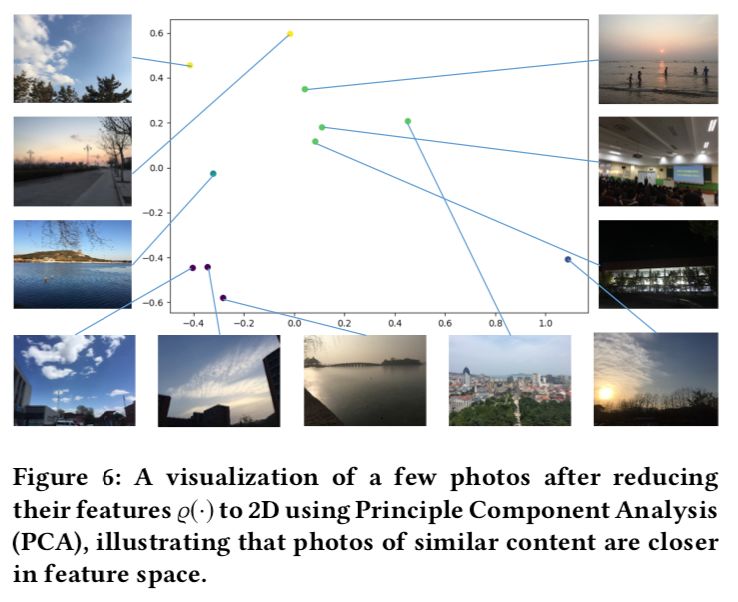

為了直觀表述兩張照片(構圖)的相似性,我們對不同照片(構圖)的特征向量進行了 PCA 降維。

不同照片(構圖)的特征向量在二維空間上的分布

算法整體流程

到此為止,我們的算法部分完全形成了,讓我們再一起回顧一下算法的流程。

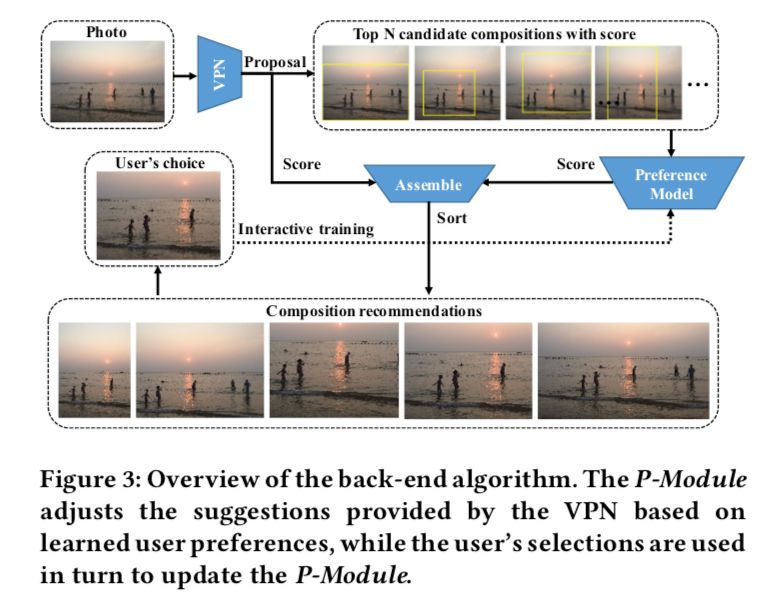

本文算法的整體流程,基于學到的用戶偏好,P-Module 調整 VPN 給出的推薦,同時用戶新的選擇也會反過頭來去更新 P-Module

給定一張照片,算法流程如下:

VPN 給出構圖建議

針對 VPN 給出的所有推薦構圖,P-Module 計算用戶偏好得分

通過插值算法動態的調整二者的權重,得到最終的得分,然后從高到低排序,展示給用戶

用戶從構圖候選中選擇一個最喜歡的,這個被選擇的構圖也會作為正樣本繼續更新 P-Module

整個算法交互式地、逐漸地學習到用戶偏好,這項技術屬于交互式機器學習(interactive Machine Learning)的范疇。

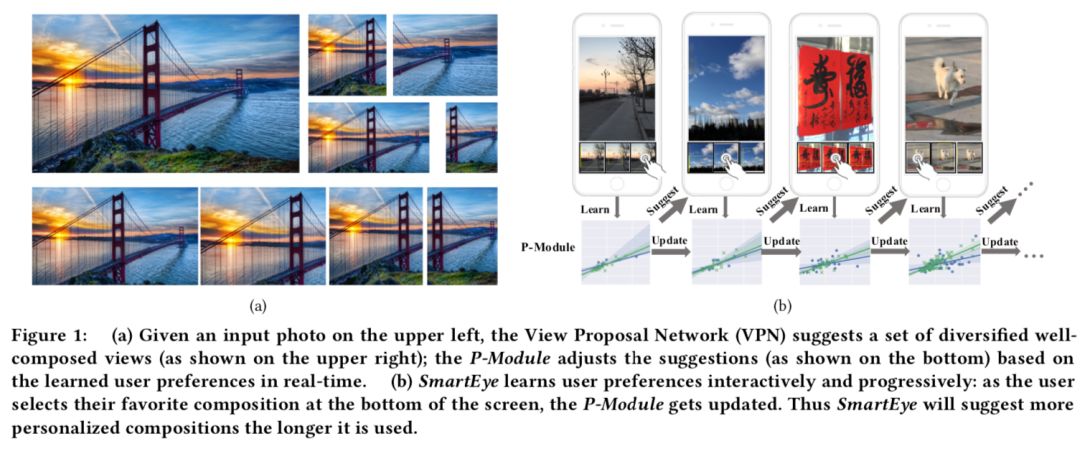

至此,整個系統可以用下面的這么一張圖來表示其核心內涵。

(a)左上角是一張輸入照片,View Proposal Network(VPN)會推薦一組多樣化的構圖(如右上圖所示); P-Module 根據所學習的用戶偏好實時調整建議(如下圖所示);(b)SmartEye 以交互方式逐步學習用戶偏好:當用戶在屏幕底部選擇他們喜歡的構圖時,P-Module 會隨之更新。 因此系統會逐漸掌握用戶偏好。

用戶實驗

來到了人機交互領域研究中相當重要的一個部分——用戶實驗(User Study)。

我們部署了兩個用戶實驗來探究如下三個問題:

1) 構圖任務的個性化偏好建模中什么特征比較重要;

2) P-Module 是否幫助模型更好地吻合用戶的選擇;

3) 用戶使用 SmartEye 時的用戶體驗如何。

我們找了 16 個參與者(在人機交互學科中成為被試),其中有 8 位男性 8 位女性,有 8 位在攝影方面沒有基礎,標為 P1-P8,有 8 位具有一定的攝影基礎,其中 5 位是大學攝影協會的,標為 P9-P13,還有 3 位專業是美術和影視專業的,標為 P14-P16。他們平均具有 4.13 年的攝影(拍照)經驗。

Study 1 Effectiveness of P-Module

為了探究 P-Module 的有效性,我們設計了兩個任務。

Task1:從 VPN 的推薦構圖打分

目的:看看該設計什么樣的特征,順便收集帶標注的數據。

這個任務也是最基礎的一個任務,涉及到特征的設計,我們在前面已有提到,在這進一步詳細說明。

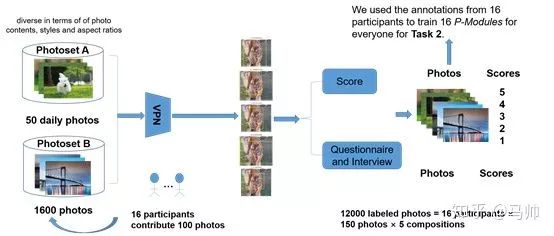

我們首先隨機收集了一個數據集 PhotoSetA,其中包含 50 張照片,以涵蓋人們通常拍攝的各種日常照片。然后,我們要求每位參與者貢獻他們拍攝的 100 張照片以形成 PhotoSetB(包括 16 位參與者拍攝的總共 1600 張照片)。這兩個數據集中的照片在內容,樣式和寬高比等方面不做任何限制。

我們用 VPN 處理了 PhotoSetA 和 PhotoSetB 中的所有照片,每張照片都有 5 個推薦的構圖。對于每個參與者,我們給了他 / 她 150 張照片(50 張來自 PhotoSetA,100 張來自 PhotoSetB 中自己拍攝的)以進行評分,我們收集了 12000 張(16 張參與者 ×150 張照片 ×5 張構圖)帶有主觀評分的照片。我們還要求每位參與者填寫調查問卷并就一些問題進行了采訪。對于參與者剛剛打分的一些照片,我們問了被試一些問題:

a) 你在進行構圖選擇時考慮了哪些因素?

b) 你為什么喜歡這一個(構圖)?

c) 你認為你選擇的這一個比其他的好在哪?

從中獲得了很多有價值的見解,這也幫助我們設計了前面提到的 feature vector。

Task1 流程圖

需要說明的是,16 個被試所標注的圖片數據將用來分別為這 16 個人訓練自己的 P-Module 用于 Task2。

Task2:從不同的算法推薦的構圖中進行挑選

目的:我們想要探究 P-Module 是否有用,是否 outperform 了其他算法。

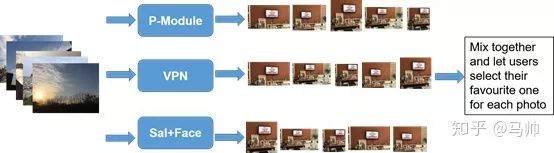

我們通過具有挑戰性的用戶實驗證明了 SmartEye 所推薦的構圖的質量,為此我們額外收集了 50 張不同風格和內容的照片。

對于每張照片,我們選擇了不同模型生成的前 5 種構圖,讓參與者選擇最佳構圖(第 1 名)。我們的實驗所用到的模型如下:1)帶有 P-Module 的 VPN;2)VPN; 3)基于顯著區域檢測和面部檢測的算法,表示為 Sal + Face。 Sal + Face 的工作原理如下:給出一張照片,Sal + Face 計算其顯著性圖并檢測面部,然后計算顯著性得分和面部得分之和,挑選具有最高得分的 5 種構圖方式推薦給用戶。我們混合了不同模型的輸出(去掉順序對結果的影響)并將它們展示給 16 個參與者。我們要求他們在每張照片中選擇他們喜歡的構圖。實驗結果在 Results 部分展示。

Task2 流程圖

Study 2: Usability of SmartEye

Task 3: 在手機上使用不同的算法進行拍照

目的:探究在實際環境下,融合了 P-Module 的 SmartEye 是否好用

我們在 Android 設備上部署了以下系統:1)搭載了 P-Module 和 VPN 的 SmartEye,2)只有 VPN 的 SmartEye,3)搭載了 Sal + Face 的 APP。我們還加入了 Android 原生相機,作為非構圖推薦系統的參考。

我們引導參與者如何使用我們的系統,并鼓勵他們在開始此任務之前嘗試所有功能。我們隨機分配了不同系統使用的順序來消除影響。參與者被要求使用每個系統拍攝至少 30 張照片。然后他們被要求填寫一個 post-task questionnaire。 此任務后調查問卷包含對被測試的算法的看法,偏好建模的效果以及對 SmartEye 中可用的支持功能的看法。

Task4:使用 SmartEye 一個月

目的:探究 SmartEye 是否可以隨著用戶越多使用,效果有越高的提升

在此任務中,我們讓每個參與者連續使用 SmartEye 一個月。每位參與者每天必須使用 SmartEye 拍攝至少 5 張照片。拍攝照片的內容和風格不受限制,這意味著用戶可以任意使用 SmartEye,只要他們每天拍攝 5 張照片。

在月底,我們收集了用戶們在這一個月內保存下來的構圖,并研究了 P-Module 隨著時間增長的進步情況。

實驗結果

Study 1

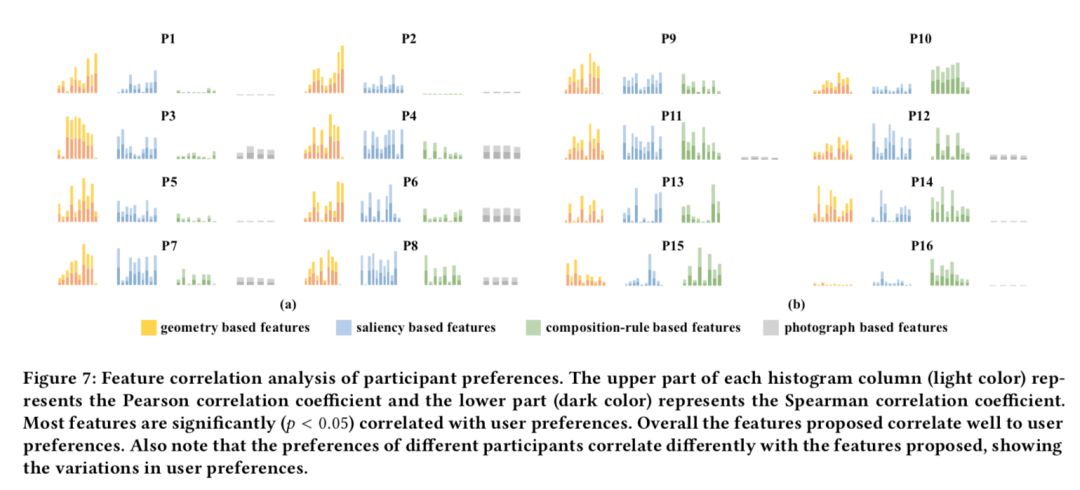

根據任務 1 中 16 位參與者的構圖選擇數據,我們計算了用戶得分與 32D 特征之間的 Spearman 和 Pearson 相關系數。相關性如下圖所示。可以看到,不同參與者的相關性有所不同。幾乎每個參與者都關注基于幾何的特征和基于顯著性的特征。同樣有趣的是,有一定攝影基礎的用戶似乎更關注基于顯著性和基于構圖規則的特征,而其他人可能更多地依賴于幾何和基于照片的特征。特征相關性的差異也反映了參與者之間構圖偏好的差異。

參與者偏好的特征相關分析。每個直方圖列的上方(淺色)表示 Pearson 相關系數,下方(深色)表示 Spearman 相關系數。大多數特征與用戶偏好顯著(p<0.05)相關。總體而言,所提出的特征與用戶偏好具有很好的相關性。另請注意,不同參與者的偏好與所提取的特征有不同的相關性,顯示了用戶偏好的差異性。

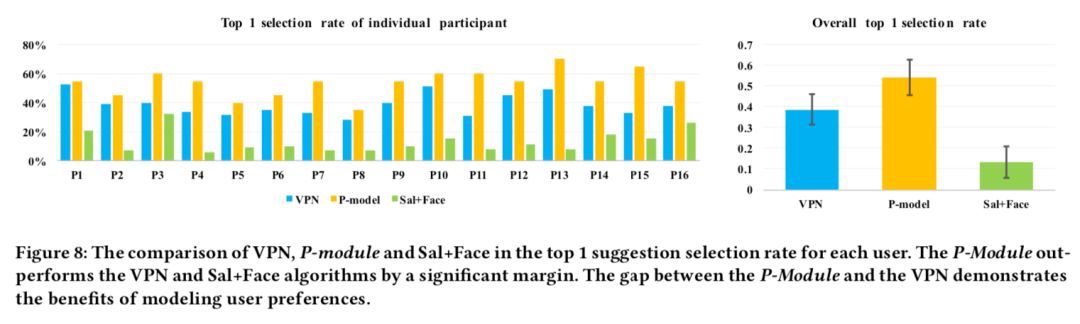

我們還評估了系統建議的第一張構圖恰好是用戶最喜歡構圖的比率。我們將此度量表示為 Top 1 selection rate。下圖顯示了基于任務 2 中收集的參與者數據的 VPN,P-Module 和 Sal + Face 的比較。我們可以看到 P-Module 在每個用戶的構圖選擇數據上表現優于 VPN,總體而言,它大幅度的超越了其他 Baseline。基于成對 t 檢驗,我們發現結果很明顯:將 VPN 與 P-Module 進行比較,T 值為 - 7.229,p <.001; 將 VPN 與 Sal + Face 進行比較,T 值為 11.597,p <.001; 比較 P-Module 和 Sal + Face,T 值為 16.318,p <.001。我們還計算了三個模型的標準偏差值,如下圖所示。

VPN,P 模塊和 Sal + Face 在每個用戶的 Top 1 selection rate 的比較。 P-Module 在很大程度上優于 VPN 和 Sal + Face 算法。帶有 P-Module 的 VPN 和純 VPN 之間的差距證明了建模用戶偏好的好處。

Study 2

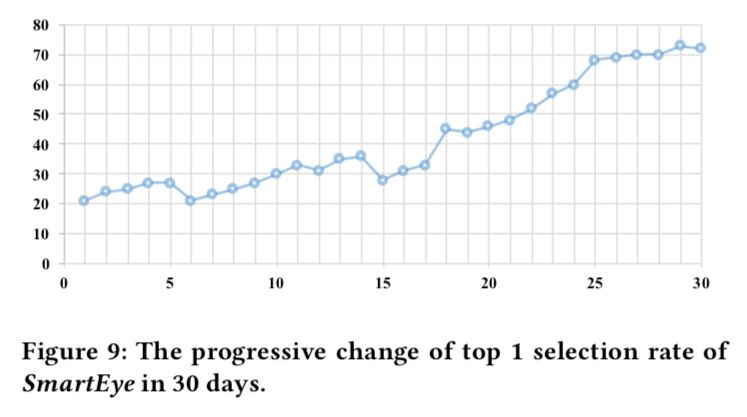

我們收集了任務 4 中各個參與者 30 天內的拍照構圖選擇,并在下圖中他們每天的平均 Top 1 selection rate。值得注意的是,總體來說,帶有 P-Module 的 SmartEye 的 Top 1 selection rate 在時間尺度上逐漸提高。它表明 SmartEye 能夠模擬用戶偏好并通過收集更多的用戶選擇數據來改進自身。在第 6 天和第 15 天,性能略有下降。我們推測這些下降可能是由于用戶偏好會隨時間在某一天有所改變。照片構圖任務與用戶的主觀判斷密切關聯,在某些時間范圍內可能發生局部下降。調查更為長期的影響可能是一項有趣的未來工作。

30 天內所有參與者每一天的平均 top 1 selection rate

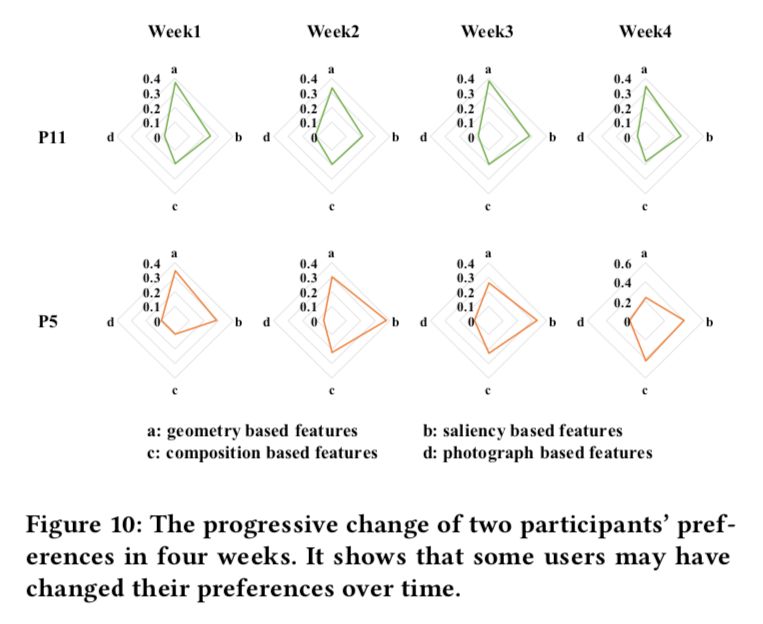

另外,下圖展示了在 30 天里每周的 4 種類型的特征和挑選出來的兩個用戶(P11 和 P5)構圖偏好之間相關系數的變化。這個結果和 Task1 中的結果共同說明了不同的用戶可能依賴于不同的構圖因素。它還表明一些用戶可能會隨著時間的推移個人喜好也會有所變化。同時,它有力的證明了為主觀任務建模用戶偏好的必要性。

兩個參與者在四周時間內偏好情況。這也表明了一些用戶的個人偏好會隨時間改變

Feedback from Interviews and Questionnaires

在這部分我們整理和收集了大量用戶的反饋意見,并進行了歸納,為節約篇幅不做描述。

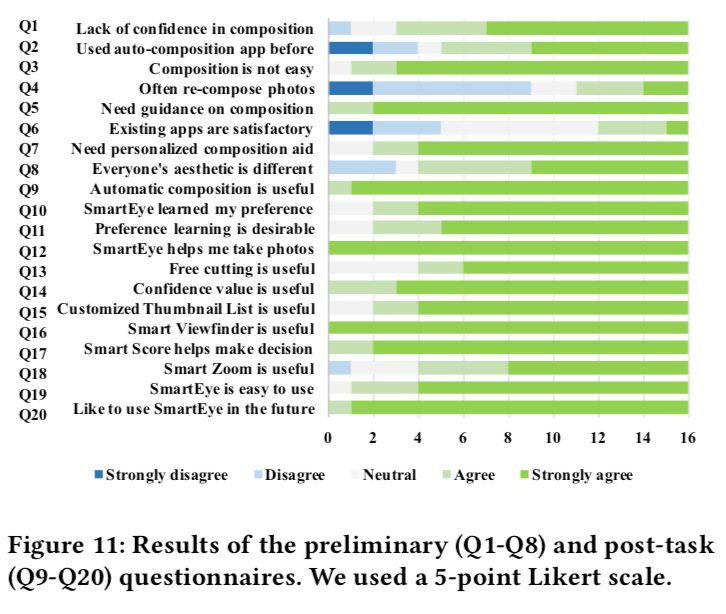

Preliminary and Post-Task Questionnaires

我們的實驗前問卷和實驗后問卷基于 5 分制,其中 5 分對應強烈同意,1 分對應強烈不同意。 下圖中的 Q1-Q8 驗證了自動構圖和個性化構圖推薦算法的有效性。Q9-Q20 顯示了關于本文提出的算法和設計的系統獲得的相關用戶反饋。總體而言,用戶對本文提出的 SmartEye 表達了相當積極的態度。

調查問卷和用戶訪談結果

討論

啟發

我們從中學習到了一些經驗教訓,以進一步改善具有個性化偏好建模的自動構圖系統的用戶體驗。我們相信這些經驗也適用于試圖將個性化偏好納入主觀任務的其他系統。

建模個性化偏好對于主觀任務很重要。根據訪談,我們發現參與者可以從系統從歷史數據中學習習慣和偏好的過程中獲益。

我們最好向用戶顯示系統如何 or 為何提出建議,而不是讓系統成為 “黑匣子”。在我們的采訪中,我們發現 Smart Score 的得分以及置信度值得到了很多積極的反饋; 它幫助用戶完成構圖任務,并使系統更加透明和可靠。在更多細節中顯示“系統為什么這么認為” 是這方面可能的未來方向。

未來工作

研究更 general 的構圖推薦模型。我們的工作基于 VPN,并通過集成 P-Module 改善用戶體驗。請注意,VPN 并非一個自動構圖的完美算法。通過采用更好的構圖推薦模型,SmartEye 可以進一步提升其性能。

使用協作過濾擴展到多個用戶。我們的偏好學習工作中的 P-Module 針對單個用戶進行了更新; 因此,該推薦僅基于他 / 她自己的構圖歷史。開發算法和交互技術以在許多用戶之間共享學習結果并以協作方式利用它們也是有趣的。

推薦手機鏡頭的移動方向。在拍照時實時地推薦手機移動方向似乎是我們的算法的直接擴展,但我們發現它在實踐中非常具有挑戰性:首先,因為一個圖像可能有多個好的建議,當系統給出移動建議,但是用戶隨著指示移動鏡頭后,發現得到的構圖不是自己想要的時候,它可能會損害用戶體驗;第二,系統必須跟蹤,平滑和記錄運動歷史,以預測下一個方向;第三,更絲滑的推薦移動方向(不讓用戶有延遲感),可能對系統響應時間有更高的要求,解決它也可能是有趣的未來工作。

解釋有關模型決策的更多信息。VPN 是一種數據驅動模型,可直接從人類數據中學習構圖知識。盡管我們有意收集了各類圖像數據用于構圖,但很難保證我們現有的推薦模型考慮到了光照、聚焦等攝影學因素。通過觀察模型的輸出,我們推測 VPN 已經隱含地考慮了這些方面。但是,在數據驅動模型的輸出中,很難明確地顯示哪個方面有多大程度的貢獻。為了明確地 model 其他方面的構圖因素,我們可以在模型的輸出之后附加模塊,這些模塊特定于這些方面,畢竟許多這些方面的現成模型已經取得了不錯的性能。

結論

我們研究了照片構圖中的用戶偏好建模的概念,并且實現了一個新穎的系統,該系統可以逐漸且交互式地學習用戶對照片構圖的偏好。

同時,我們已經證實,在構圖任務中,不同用戶之間的偏好是不同的,甚至每個人的偏好也可能隨時間而變化,這進一步表明了將用戶偏好學習應用于當前系統的必要性。 此外,我們將 P-Module 和 VPN 集成到一個交互式的實時的移動系統 SmartEye 中,具有新穎的界面和一系列實用功能,如實時智能取景器,智能分數和智能變焦。我們的用戶研究證明了 SmartEye 的有效性:我們已經證明 SmartEye 優于其他構圖算法,系統支持的交互功能很有幫助,用戶對 SmartEye 整體十分滿意。

-

機器視覺

+關注

關注

163文章

4485瀏覽量

121797 -

VPN

+關注

關注

4文章

296瀏覽量

30241 -

AI

+關注

關注

87文章

33476瀏覽量

274048

原文標題:拍照技術爛?實時在線AI構圖模型VPN,讓你變身攝影大神!

文章出處:【微信號:rgznai100,微信公眾號:rgznai100】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

評論