在2016年威海參加中國(guó)體系結(jié)構(gòu)年會(huì)的時(shí)候,孫所也說(shuō)了一句調(diào)侃的話:“現(xiàn)在的AI很火,大家都往那邊去,沒(méi)有人太關(guān)心體系結(jié)構(gòu)了,我要告訴那些追AI熱點(diǎn)的,它都死了三回了!” 的確,作為從小學(xué)馬列的中國(guó)人,我們最熟悉螺旋式上升的概念。對(duì)于計(jì)算和I/O來(lái)講,和中國(guó)經(jīng)濟(jì)調(diào)控一樣,都是“ 水多了加面,面多了加水”螺旋式上升。

Google在2017年發(fā)布了TPU V1之后,現(xiàn)在已經(jīng)有越來(lái)越多的AI startup的芯片出現(xiàn),大家基本上都是用標(biāo)準(zhǔn)的Resnet50,Googlenetv3 等網(wǎng)絡(luò)為benchmark, 一次一次地刷新性能和功耗比,個(gè)人覺(jué)得很有可能在一天,AI芯片的性能和功耗比在特定的imagenet的任務(wù)上超過(guò)人腦,現(xiàn)在AI在準(zhǔn)確率和性能上都超過(guò)了。對(duì)于AI的芯片來(lái)講,有一個(gè)指標(biāo)也是大家討論比較多的。Roofline model

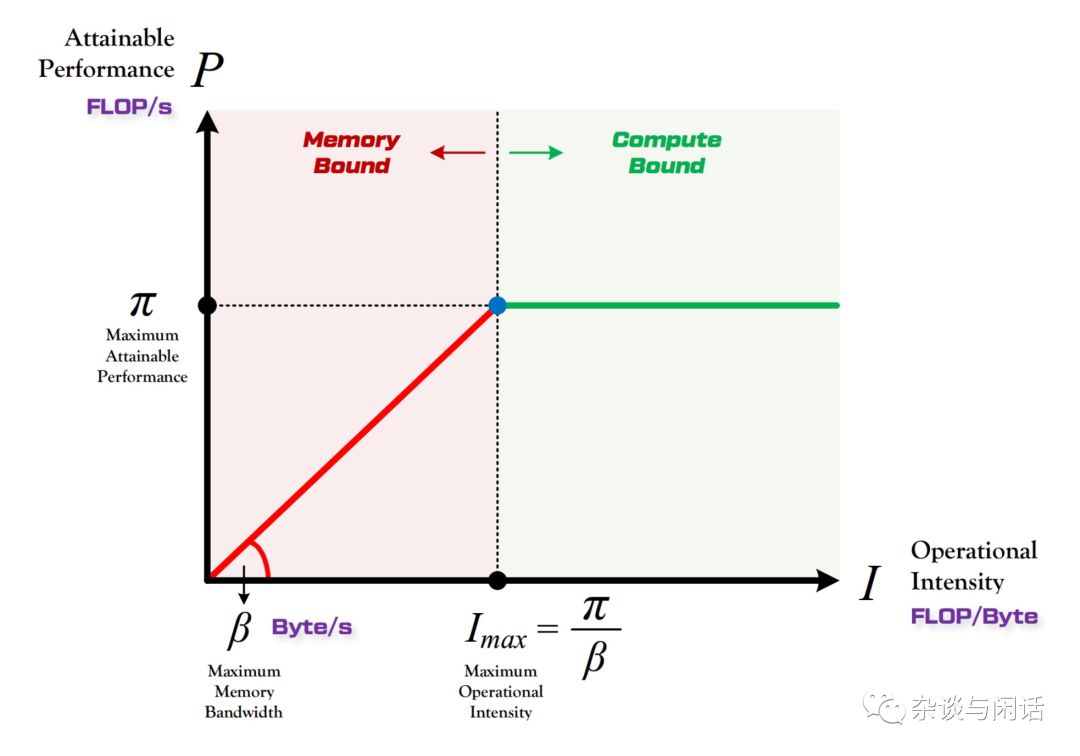

Y軸是P,代表算力,用來(lái)FLOP/s來(lái)表示,現(xiàn)在新出的AI ASIC往往在FLOP/s并不發(fā)力,因?yàn)閺墓谋鹊慕嵌壬希懔隙ú皇窃礁咴胶茫掖蠹叶己茈y高過(guò)老黃的核彈。

代表了一個(gè)特定的計(jì)算平臺(tái)的peak performance,就是最大算力。

就是特定的計(jì)算平臺(tái)的I內(nèi)存/O帶寬,這個(gè)和該計(jì)算平臺(tái)使用的DDR類型有關(guān)。

X軸是I,代表計(jì)算強(qiáng)度,就是在一個(gè)Byte上的計(jì)算量。因?yàn)閷?duì)于一個(gè)特定的平臺(tái),我可以知道它的最大算力和帶寬,我們就可以知道它的最大的計(jì)算強(qiáng)度。

因此,和圖上顯示的一樣,在點(diǎn)(Imax,),這個(gè)計(jì)算平臺(tái)達(dá)到了完美。在它的左邊,說(shuō)明memory受限,在它的右邊說(shuō)明計(jì)算受限。

因此,對(duì)于我們之前分析的Alexnet這個(gè)網(wǎng)絡(luò),我們就知道了它的總的計(jì)算量就是:

| 層 | 內(nèi)存訪問(wèn)量 | 計(jì)算量 |

| Conv1 | 770235 | 105415200 |

| Maxpool1 | 430368 | |

| Conv2 | 1057632 | 223948800 |

| Maxpool2 | 273152 | |

| Conv3 | 1057792 | 149520384 |

| Conv4 | 1521792 | 112140288 |

| Conv5 | 1036160 | 74760192 |

| Maxpool3 | 61696 | |

| FC1 | 37766144 | 37748736 |

| FC2 | 16789504 | 16777216 |

| FC3 | 4102096 | 4096000 |

| SUM | 65021158 | 724406816 |

因?yàn)閷?duì)于每一次訪存都是32位的Float Point,因此整個(gè)內(nèi)存的占用就是 260MB左右,而計(jì)算量是724MFLOPs,因此Alexnet的計(jì)算強(qiáng)度就是724/260=2.7 operation/byte。

對(duì)于一個(gè)特定的平臺(tái),比如老黃家的新的GTX2080Ti 系列來(lái)講:

對(duì)于計(jì)算性能,先不管老黃加各種Tensor Core,RTcore,從CUDA Core本身來(lái)講,他是100TLOP/s,

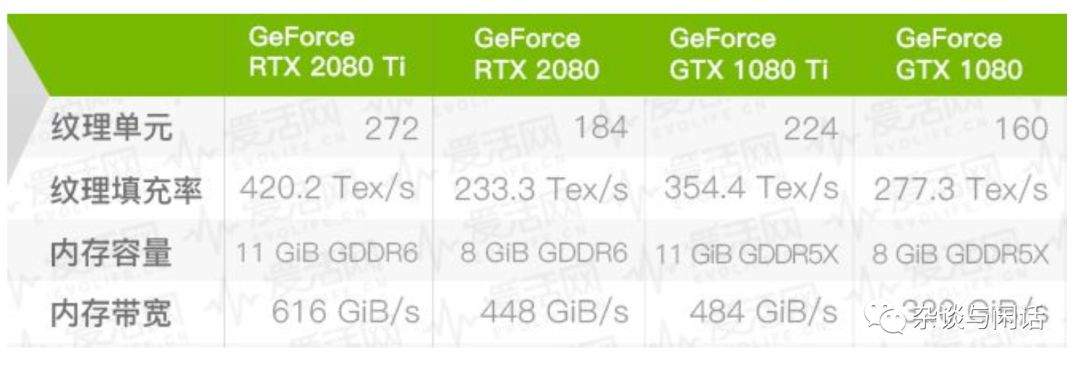

它的內(nèi)存帶寬如下:

因此,作為2080Ti, 它的Imax就是166Operation/Byte.

可能到這個(gè),就可以看出,對(duì)于Alex的2.7 來(lái)講,遠(yuǎn)遠(yuǎn)沒(méi)有達(dá)到2080ti的計(jì)算強(qiáng)度,主要是受限于內(nèi)存帶寬了。

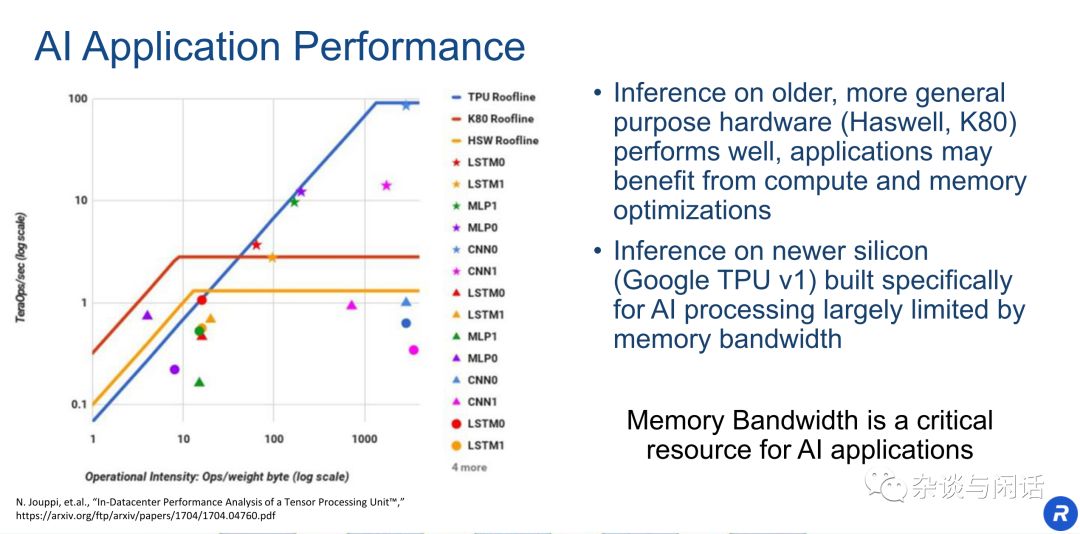

在Google的TPU中,有一個(gè)圖經(jīng)常被大家引用。

大家基本上可以看到,google的Imax差不多在1000左右,基本上沒(méi)有什么網(wǎng)絡(luò)可以完全用滿TPU的peak performance。

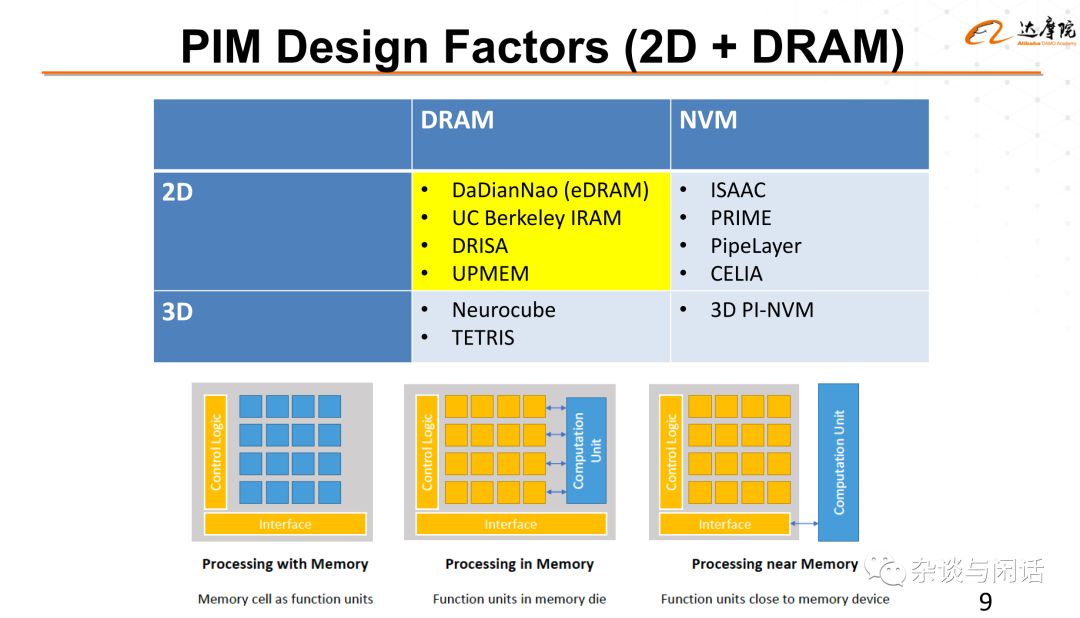

怎么辦,內(nèi)存帶寬的解決方案就是HBM,HBM2, HBM3不斷加大帶寬。記得在2017年的CNCC上,謝源教授講,他在2010年左右提出了HBM的概念,他很快就看到了AMD,Nvidia以及Xilinx和Intel都在芯片上使用了HBM,證明了這條道路的正確性。他認(rèn)為目前應(yīng)該在AI芯片上擺脫這種”水多了加面,面多了加水“,in-memory 計(jì)算應(yīng)該是下一個(gè)方向。

這個(gè)就引出了在Memory+會(huì)議上來(lái)自平頭哥的段立德博士的topic,”P(pán)rocessing Near or In memory for deep learning".

-

芯片

+關(guān)注

關(guān)注

455文章

50731瀏覽量

423197 -

AI

+關(guān)注

關(guān)注

87文章

30761瀏覽量

268905

原文標(biāo)題:什么是AI芯片“存儲(chǔ)墻”的解決方案?

文章出處:【微信號(hào):SSDFans,微信公眾號(hào):SSDFans】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AI時(shí)代的存儲(chǔ)墻,哪種存算方案才能打破?

中興通訊推出AI FWA全棧解決方案

emc存儲(chǔ)解決方案的優(yōu)勢(shì)

基于分布式存儲(chǔ)系統(tǒng)醫(yī)療影像數(shù)據(jù)存儲(chǔ)解決方案

基于CSS融合存儲(chǔ)系統(tǒng)的自動(dòng)化制造服務(wù)平臺(tái)存儲(chǔ)解決方案

憶聯(lián)SSD存儲(chǔ)解決方案亮相2024中國(guó)國(guó)際金融展

瑞薩電子推出Reality AI Explorer Tier,用于開(kāi)發(fā)AI與TinyML解決方案

EVASH Ultra EEPROM:助力ChatGPT等AI應(yīng)用的嵌入式存儲(chǔ)解決方案

宜鼎全面擴(kuò)充邊緣AI智能應(yīng)用與智能存儲(chǔ)

MK米客方德的AI智能存儲(chǔ)解決方案

risc-v多核芯片在AI方面的應(yīng)用

得一微電子:AI時(shí)代重新定義存儲(chǔ)主控芯片

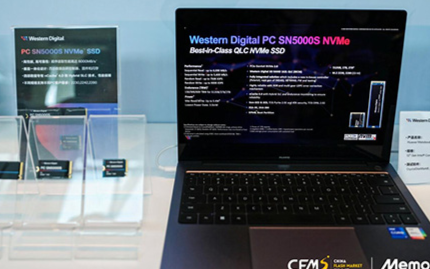

聚焦AI、汽車和PC應(yīng)用新需求,西部數(shù)據(jù)攜旗艦存儲(chǔ)產(chǎn)品亮相CFMS峰會(huì)

聚焦 | 什么是AI芯片“存儲(chǔ)墻”的解決方案?

聚焦 | 什么是AI芯片“存儲(chǔ)墻”的解決方案?

評(píng)論