剛剛,CVPR 2019最佳論文公布了:來(lái)自CMU的辛?xí)岬热撕献鞯恼撐墨@得最佳論文獎(jiǎng),最佳學(xué)生論文也由加州大學(xué)圣巴巴拉分校Xin Wang等人摘得。此外,經(jīng)典論文獎(jiǎng)授予了李飛飛等人的杰出工作ImageNet。

備受矚目的CVPR 2019正在美國(guó)加州長(zhǎng)灘舉行。作為計(jì)算機(jī)視覺(jué)和模式識(shí)別的頂級(jí)學(xué)術(shù)會(huì)議,每年的 CVPR 都匯聚了領(lǐng)域技術(shù)發(fā)展的前沿。而 CVPR 的最佳論文則更是備受關(guān)注,多有經(jīng)典。

CVPR 2019大會(huì)現(xiàn)場(chǎng)

而就在剛剛,CVPR 2019揭曉了最佳論文獎(jiǎng)以及其他獎(jiǎng)項(xiàng)。

最佳論文獎(jiǎng)授予了卡內(nèi)基梅隆大學(xué)、多倫多大學(xué)、倫敦大學(xué)學(xué)院的辛?xí)?Shumian Xin), Sotiris Nousias等人合作的論文A Theory of Fermat Paths for Non-Line-of-Sight Shape Reconstruction

最佳學(xué)生論文授予了加州大學(xué)圣巴巴拉分校、微軟研究院、杜克大學(xué)的Xin Wang, Qiuyuan Huang等人合作的論文Reinforced Cross-Modal Matching and Self-Supervised Imitation Learning for Vision-Language Navigation。

此外,經(jīng)典論文獎(jiǎng)Longuet-Higgins 獎(jiǎng)被授予了李飛飛、李佳等人的ImageNet工作。

根據(jù)CVPR官網(wǎng)的介紹,今年CVPR一共收到創(chuàng)紀(jì)錄的5165篇有效投稿,比去年的3309篇多出近2000篇。

經(jīng)過(guò)132位領(lǐng)域主席和2887位審稿人三個(gè)月的辛勤工作,最終有1294篇論文被接收,最終錄取率為25.2%。1294篇錄取論文中,有288篇被錄用為Oral論文。參會(huì)人數(shù)上,本屆CVPR也是盛況空前,超過(guò)9000人注冊(cè)。

CVPR 2019相關(guān)數(shù)據(jù)

本屆CVPR大會(huì)主席是馬里蘭大學(xué)Larry Davis教授、牛津大學(xué)Philip Torr教授,以及加州大學(xué)洛杉磯分校(UCLA)朱松純教授。本屆CVPR組織者中也不乏華人學(xué)者面孔,除UCLA朱松純教授擔(dān)任大會(huì)主席外,便利蜂 AI 研究院的華剛博士、加州大學(xué)圣地亞哥分校的屠卓文擔(dān)任程序主席。

會(huì)議的132位領(lǐng)域主席中,也有多位華人面孔,比如白翔、程明明、孫劍、賈佳亞、林達(dá)華、呂樂(lè)、馬毅、蘇昊顏水成、虞晶怡、張正友等等(不完全統(tǒng)計(jì))。

接下來(lái),新智元帶來(lái)CVPR 2019最佳論文獎(jiǎng)及其他獎(jiǎng)項(xiàng)的介紹:

最佳論文

最佳論文:

A Theory of Fermat Paths for Non-Line-of-Sight Shape Reconstruction

作者:Shumian Xin, Sotiris Nousias, Kiriakos N. Kutulakos, Aswin C. Sankaranarayanan, Srinivasa G. Narasimhan and Ioannis Gkioulekas

作者機(jī)構(gòu):卡內(nèi)基梅隆大學(xué)、多倫多大學(xué)、倫敦大學(xué)學(xué)院

論文地址:https://www.ri.cmu.edu/publications/a-theory-of-fermat-paths-for-non-line-of-sight-shape-reconstruction/

摘要:

我們提出了一個(gè)新的理論,即在一個(gè)已知的可見(jiàn)場(chǎng)景和一個(gè)不在瞬態(tài)相機(jī)視線范圍內(nèi)的未知物體之間的Fermat path。這些光路要么遵守鏡面反射,要么被物體的邊界反射,從而編碼隱藏物體的形狀。

我們證明費(fèi)馬路徑對(duì)應(yīng)于瞬態(tài)測(cè)量中的不連續(xù)性。然后,我們推導(dǎo)出一種新的約束,它將這些不連續(xù)處的路徑長(zhǎng)度的空間導(dǎo)數(shù)與表面法線相關(guān)聯(lián)。

基于這一理論,我們提出了一種名為Fermat Flow的算法來(lái)估計(jì)非視距物體的形狀。我們的方法首次允許復(fù)雜對(duì)象的精確形狀恢復(fù),范圍從隱藏在拐角處以及隱藏在漫射器后面的漫反射到鏡面反射。

最后,我們的方法與用于瞬態(tài)成像的特定技術(shù)無(wú)關(guān)。因此,我們展示了使用SPAD和超快激光從皮秒級(jí)瞬態(tài)恢復(fù)的毫米級(jí)形狀,以及使用干涉測(cè)量法從飛秒級(jí)瞬態(tài)微米級(jí)重建。我們相信我們的工作是非視距成像技術(shù)的重大進(jìn)步。

最佳論文提名

獲得最佳論文提名獎(jiǎng)的是:

Learning the Depths of Moving People by Watching Frozen People

作者:Zhengqi Li, Tali Dekel, Forrester Cole, Richard Tucker, Noah Snavely, Ce Liu, William T. Freeman

作者機(jī)構(gòu):Google Research

論文鏈接:https://arxiv.org/abs/1904.11111

A Style-Based Generator Architecture for Generative Adversarial Networks

作者:Tero Karras, Samuli Laine, Timo Aila

作者機(jī)構(gòu):NVIDIA

論文鏈接:https://arxiv.org/abs/1812.04948

最佳學(xué)生論文

最佳學(xué)生論文:

Reinforced Cross-Modal Matching and Self-Supervised Imitation Learning for Vision-Language Navigation

題目:面向語(yǔ)言視覺(jué)導(dǎo)航(VLN)的強(qiáng)化交叉模型匹配和半監(jiān)督模仿學(xué)習(xí)

作者:Xin Wang,Qiuyuan Huang,AsliCelikyilmaz,Jianfeng Gao,Dinghan Shen,Yuan-Fang Wang,William Yang Wang,Lei Zhang

Xin Wang,Yuan-FangWang,William Yang Wang 加州大學(xué)圣芭芭拉分校

Qiuyuan Huang,Asli Celikyilmaz,Jianfeng Gao,Lei Zhang 微軟研究院

Dinghan Shen 杜克大學(xué)

摘要:

視覺(jué)語(yǔ)言導(dǎo)航(VLN)是對(duì)真實(shí)智能體在真實(shí) 3D 環(huán)境內(nèi)執(zhí)行自然語(yǔ)言指令的任務(wù)。本文研究了如何解決這項(xiàng)任務(wù)的三個(gè)關(guān)鍵挑戰(zhàn):跨模態(tài)基礎(chǔ)、不適定反饋和泛化問(wèn)題。

首先,我們提出了一種基于強(qiáng)化學(xué)習(xí)的新的強(qiáng)化交叉模型匹配(RCM)方法。我們特別將匹配的批評(píng)內(nèi)容作為內(nèi)在獎(jiǎng)勵(lì),以促進(jìn)指令和智能體運(yùn)動(dòng)軌跡之間的全局性匹配,并利用推理導(dǎo)航器在本地視覺(jué)場(chǎng)景中執(zhí)行跨模態(tài) grounding。對(duì) VLN 基準(zhǔn)數(shù)據(jù)集的評(píng)估表明,我們的 RCM 模型在 SPL 上顯著優(yōu)于以前的方法,優(yōu)化幅度高達(dá) 10%,并達(dá)到了最先進(jìn)的性能。

為了提高學(xué)習(xí)政策的可泛化性,文章進(jìn)一步引入了自我監(jiān)督模仿學(xué)習(xí)(SIL)方法,通過(guò)模仿自己過(guò)去的高質(zhì)量決策來(lái)探索未見(jiàn)過(guò)的環(huán)境。結(jié)果表明,SIL 方法可以近似地獲得更好、更有效的策略,極大地降低了已見(jiàn)過(guò)和未見(jiàn)過(guò)的環(huán)境之間的成功率上的性能差距(由 30.7%降低至 11.7%)。

經(jīng)典論文:Longuest-Higgins 獎(jiǎng)

Longuet-Higgins 獎(jiǎng)是 IEEE 計(jì)算機(jī)協(xié)會(huì)模式分析與機(jī)器智能(PAMI)技術(shù)委員會(huì)在每年的 CVPR 頒發(fā)的 “計(jì)算機(jī)視覺(jué)基礎(chǔ)貢獻(xiàn)獎(jiǎng)”,表彰十年前對(duì)計(jì)算機(jī)視覺(jué)研究產(chǎn)生了重大影響的 CVPR 論文。獎(jiǎng)項(xiàng)以理論化學(xué)家和認(rèn)知科學(xué)家 H. Christopher Longuet-Higgins 命名。

2019 年的 Longuet-Higgins 獎(jiǎng)被授予了李飛飛、李佳等人的ImageNet工作:ImageNet: A Large-Scale Hierarchical Image Database。ImageNet可以說(shuō)是計(jì)算機(jī)視覺(jué)領(lǐng)域最負(fù)盛名的工作,這篇論文發(fā)表于2009 年CVPR,目前已有11508次引用。

-

成像技術(shù)

+關(guān)注

關(guān)注

4文章

290瀏覽量

31456 -

計(jì)算機(jī)視覺(jué)

+關(guān)注

關(guān)注

8文章

1698瀏覽量

45982 -

論文

+關(guān)注

關(guān)注

1文章

103瀏覽量

14956

原文標(biāo)題:CVPR 2019最佳論文重磅出爐!李飛飛ImageNet獲計(jì)算機(jī)視覺(jué)基礎(chǔ)貢獻(xiàn)獎(jiǎng)

文章出處:【微信號(hào):AI_era,微信公眾號(hào):新智元】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

南芯科技再獲vivo 2024“優(yōu)秀質(zhì)量獎(jiǎng)”與“最佳交付獎(jiǎng)”雙殊榮

商湯科技徐立論文再獲“時(shí)間檢驗(yàn)獎(jiǎng)”

基本半導(dǎo)體榮獲禾望電氣“最佳合作獎(jiǎng)”

地平線榮獲比亞迪“最佳合作伙伴獎(jiǎng)”

安波福蘇州榮獲“2024大蘇州最佳雇主”及“2024最佳HR團(tuán)隊(duì)獎(jiǎng)”

中科馭數(shù)聯(lián)合處理器芯片全國(guó)重點(diǎn)實(shí)驗(yàn)室獲得“CCF芯片大會(huì)最佳論文獎(jiǎng)”

地平線科研論文入選國(guó)際計(jì)算機(jī)視覺(jué)頂會(huì)ECCV 2024

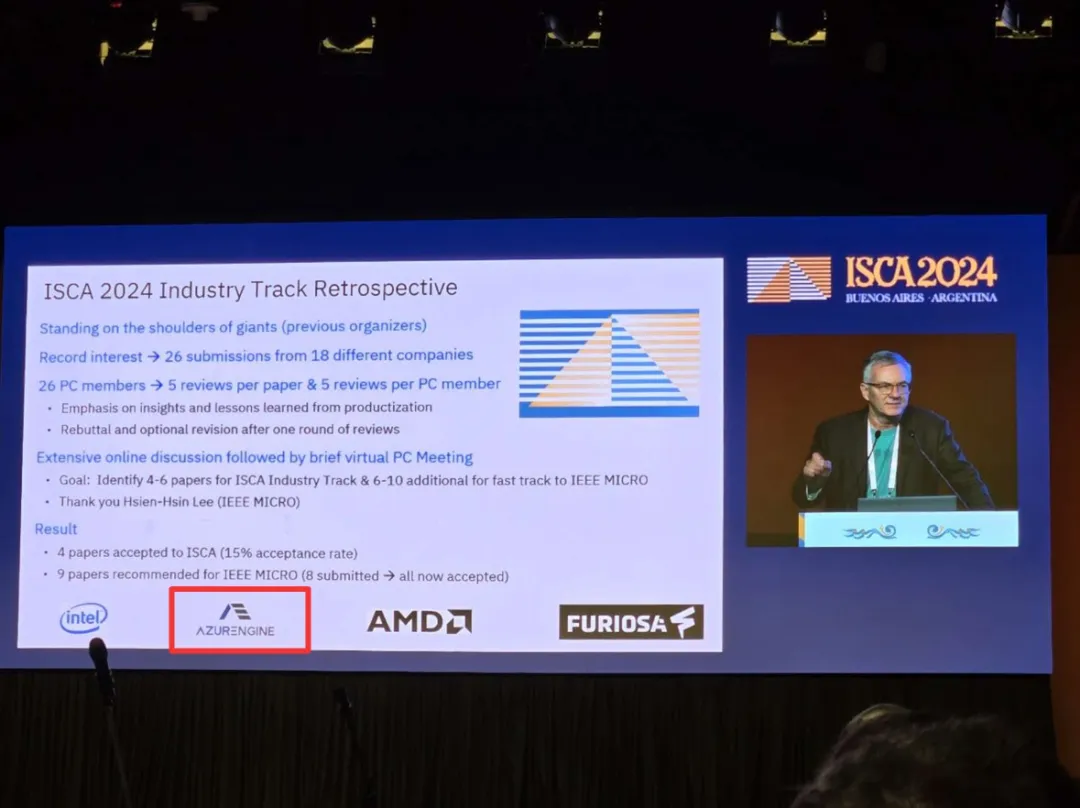

芯動(dòng)力科技論文入選ISCA 2024,與國(guó)際巨頭同臺(tái)交流研究成果

谷歌DeepMind被曝抄襲開(kāi)源成果,論文還中了頂流會(huì)議

寬帶數(shù)控延時(shí)線芯片的研制論文

熱烈恭賀|開(kāi)盛暉騰入圍APEC?ESCI最佳實(shí)踐獎(jiǎng)候選

Molex榮獲UAES聯(lián)合電子“供應(yīng)商最佳商務(wù)合作獎(jiǎng)”

芯驛電子榮獲2024京東工業(yè)“年度最佳合作伙伴獎(jiǎng)”

CVPR 2019最佳論文公布了:來(lái)自CMU的辛?xí)岬热撕献鞯恼撐墨@得最佳論文獎(jiǎng)

CVPR 2019最佳論文公布了:來(lái)自CMU的辛?xí)岬热撕献鞯恼撐墨@得最佳論文獎(jiǎng)

評(píng)論