谷歌大腦和CMU聯合團隊提出面向NLP預訓練新方法XLNet,性能全面超越此前NLP領域的黃金標桿BERT,在20個任務上實現了性能的大幅提升,刷新了18個任務上的SOTA結果,可謂全面屠榜!

近日,谷歌大腦主任科學家Quoc V. Le在Twitter上放出一篇重磅論文,立即引發熱議:

這篇論文提出一種新的NLP模型預訓練方法XLNet,在20項任務上(如SQuAD、GLUE、RACE) 的性能大幅超越了此前NLP黃金標桿BERT。

XLNet:克服BERT固有局限,20項任務性能強于BERT

本文提出的XLNet是一種廣義自回歸預訓練方法,具有兩大特點:(1)通過最大化分解階的所有排列的預期可能性來學習雙向語境,(2)由于其自回歸的性質,克服了BERT的局限性。

此外,XLNet將最先進的自回歸模型Transformer-XL的創意整合到預訓練過程中。實驗顯示,XLNet在20個任務上的表現優于BERT,而且大都實現了大幅度性能提升,并在18個任務上達到了SOTA結果,這些任務包括問答、自然語言推理、情感分析和文檔排名等。

與現有語言預訓練目標相比,本文提出了一種廣義的自回歸方法,同時利用了AR語言建模和AE的優點,同時避免了二者的局限性。首先是不再像傳統的AR模型那樣,使用固定的前向或后向分解順序,而是最大化序列的預期對數似然性分解順序的所有可能排列。每個位置的上下文可以包含來自該位置前后的令牌,實現捕獲雙向語境的目標。

作為通用AR語言模型,XLNet不依賴于數據損壞。因此,XLNet不會受到BERT受到的預訓練和微調后的模型之間差異的影響。同時以自然的方式使用乘積規則,分解預測的令牌的聯合概率,從而消除了在BERT中做出的獨立性假設。

除了新的預訓練目標外,XLNet還改進了預訓練的架構設計。 XLNet將Transformer-XL的分段重復機制和相對編碼方案集成到預訓練中,從而憑經驗改進了性能,對于涉及較長文本序列的任務效果尤其明顯。

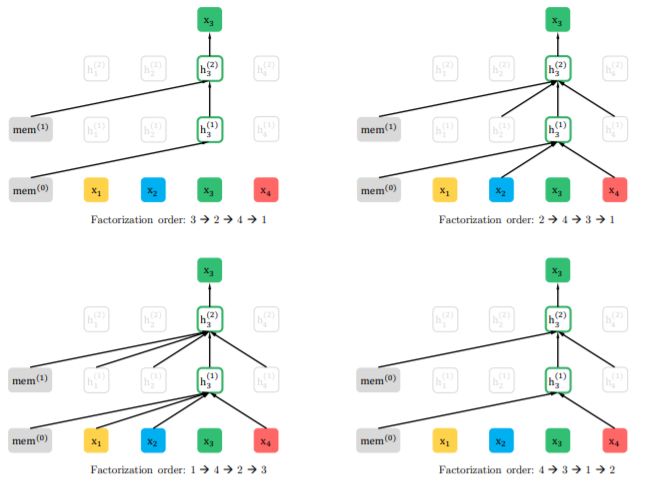

圖1:在給定相同輸入序列x,但分解順序不同的情況下,對置換語言建模目標的預測結果

圖2:(a):內容流注意力機制,與標準的自注意力機制相同。(b)查詢流注意力,其中不含關于內容xzt的訪問信息。(c):使用雙信息流注意力機制的置換語言建模訓練示意圖。

全面屠榜:大幅刷新18項任務數據集SOTA性能

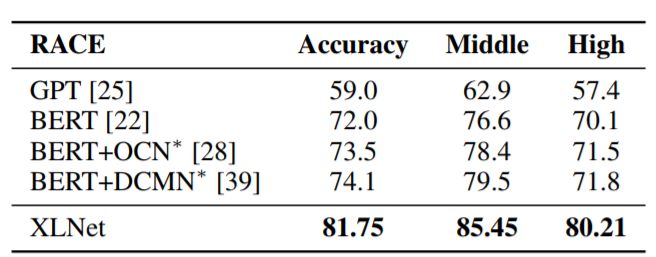

表1:與閱讀理解任務RACE測試集的最新結果的比較。 *表示使用聚集模型。 RACE中的“Middle”和“High”是代表初中和高中難度水平的兩個子集。所有BERT和XLNet結果均采用大小相似的模型(又稱BERT-Large),模型為24層架構。我們的XLNet單一模型在精確度方面高出了7.6分

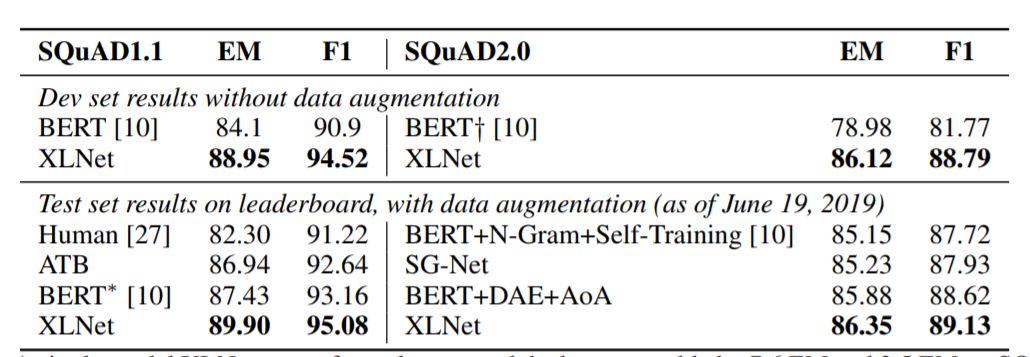

表2:單XLNet模型在SQuAD1.1數據集上的性能優于分別優于真人表現和最佳聚集模型性能達7.6 EM和2.5 EM。

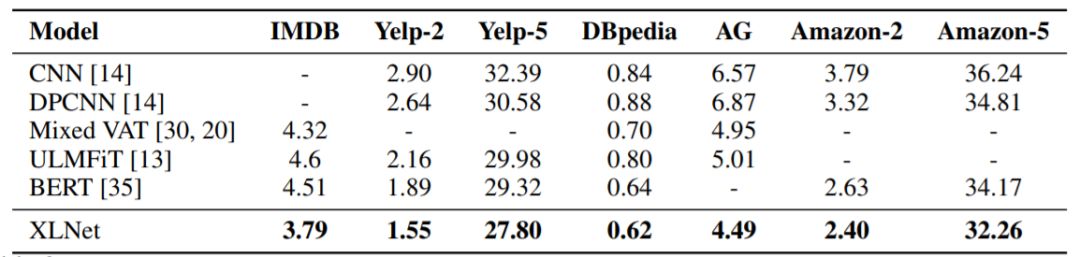

表3:與幾個文本分類數據集的測試集上錯誤率SOTA結果的比較。所有BERT和XLNet結果均采用具有相似大小的24層模型架構(BERT-Large)

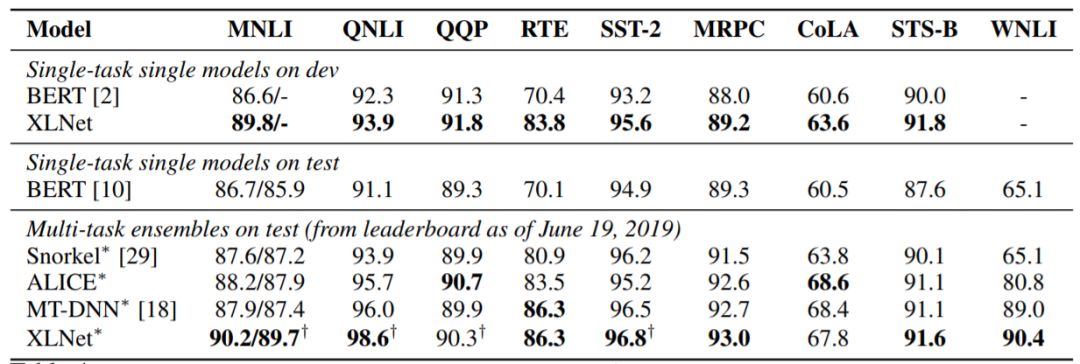

表4:GLUE數據集上的結果。所有結果都基于具有相似模型尺寸的24層架構(也稱BERT-Large)。可以將最上行與BERT和最下行中的結果直接比較。

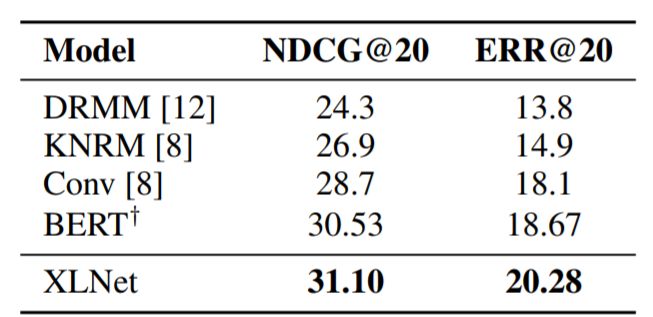

表5:與文檔排名任務ClueWeb09-B的測試集上的最新結果的比較。 ?表示XLNet的結果。

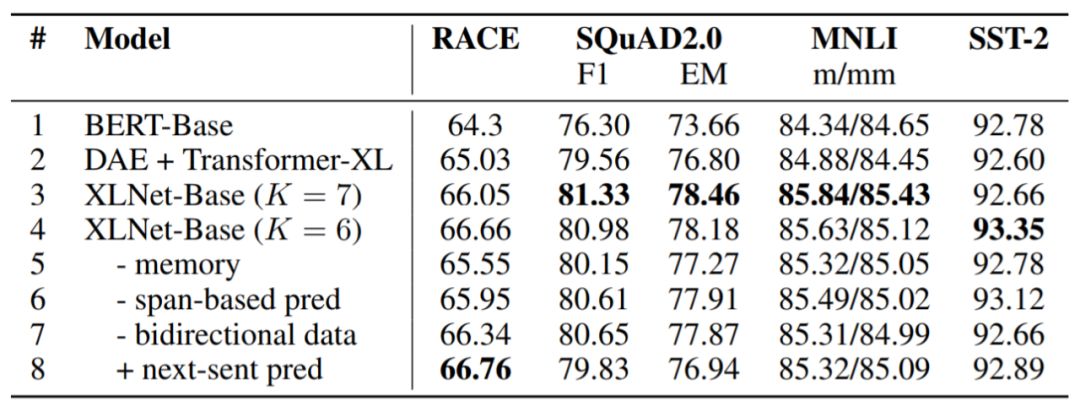

表6:我們使用BERT官方實現方案和XLNet超參數搜索空間在其他數據集上運行BERT,結果如圖所示,其中K是控制優化難度的超參數。所有模型都在相同的數據上進行預訓練。

從實驗結果可以看出,說XLNet全面超越BERT其實一點都不夸張。

知乎熱議:512TPU訓練,家里沒礦真搞不起

有熱心網友一早將這篇“屠榜”論文發在了知乎上,從網友的評論上看,一方面承認谷歌和CMU此項成果的突破,同時也有人指出,這樣性能強勁的XLNet,還是要背靠谷歌TPU平臺的巨額算力資源,“大力出奇跡”果然還是深度學習界的第一真理嗎?

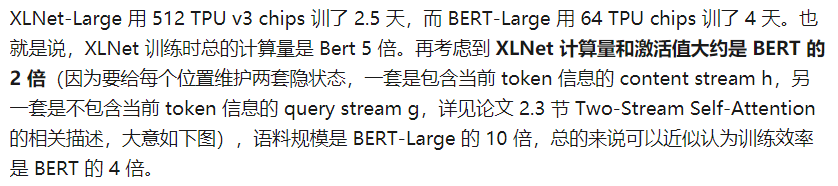

比如,網友“Towser”在對論文核心部分內容的簡要回顧中,提到了XLNet的優化方法,其中引人注目的一點是其背后的谷歌爸爸的海量算力資源的支持:

512個TPU訓練了2.5天,訓練總計算量是BERT的5倍!要知道作為谷歌的親兒子,BERT的訓練計算量已經讓多數人望塵莫及了。沒錢,搞什么深度學習?

難怪NLP領域的專家、清華大學劉知遠副教授對XLNet一句評價被毫無懸念地頂到了知乎最高贊:

目前,XLNet的代碼和預訓練模型也已經在GitHub上放出。

-

谷歌

+關注

關注

27文章

6161瀏覽量

105304 -

nlp

+關注

關注

1文章

488瀏覽量

22033

原文標題:NLP新標桿!谷歌大腦CMU聯手推出XLNet,20項任務全面超越BERT

文章出處:【微信號:aicapital,微信公眾號:全球人工智能】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

谷歌將推出Gemini大型語言模型

AWG和BERT常見問題解答

阿里云發布通義千問2.5大模型,多項能力超越GPT-4

微軟、谷歌聯手多家科技巨頭保護兒童安全

NVIDIA和谷歌云宣布開展一項新的合作,加速AI開發

谷歌發布Axion新款數據中心AI芯片,性能超越x86及云端

谷歌推出能制作旅行攻略的AI工具

谷歌宣布在醫療保健領域推出人工智能計劃

Anthropic推出Claude 3大型語言模型,在認知任務性能上創新高

谷歌模型軟件有哪些功能

谷歌模型訓練軟件有哪些功能和作用

谷歌大型模型終于開放源代碼,遲到但重要的開源戰略

大語言模型背后的Transformer,與CNN和RNN有何不同

谷歌大腦CMU聯手推出XLNet,20項任務全面超越BERT

谷歌大腦CMU聯手推出XLNet,20項任務全面超越BERT

評論