“天下武功,唯快不破”,你需要以“快”制勝。

如今,全球頂級公司的研究人員和數據科學家團隊們都在致力于創建更為復雜的AI模型。但是,AI模型的創建工作不僅僅是設計模型,還需要對模型進行快速地訓練。

這就是為什么說,如果想在AI領域保持領導力,就首先需要有賴于AI基礎設施的領導力。而這也正解釋了為什么MLPerf AI訓練結果如此之重要。

通過完成全部6項MLPerf基準測試,NVIDIA展現出了全球一流的性能表現和多功能性。NVIDIA AI平臺在訓練性能方面創下了八項記錄,其中包括三項大規模整體性能紀錄和五項基于每個加速器的性能紀錄。

表1:NVIDIA MLPerf AI紀錄

每個加速器的比較基于早前報告的基于單一NVIDIA DGX-2H(16個V100 GPU)、與其他同規模相比較的MLPerf 0.6的性能(除MiniGo采用的是基于8個V100 GPU的NVIDIA DGX-1)|最大規模MLPerf ID:Mask R-CNN:0.6-23,GNMT:0.6-26,MiniGo:0.6-11 |每加速器MLPerf ID:Mask R-CNN,SSD,GNMT,Transformer:全部使用0.6-20,MiniGo:0.6-10

以上測試結果數據由谷歌、英特爾、百度、NVIDIA、以及創建MLPerf AI基準測試的其他數十家頂級技術公司和大學提供背書,能夠轉化為具有重要意義的創新。

簡而言之,NVIDIA的AI平臺如今能夠在不到兩分鐘的時間內完成此前需要一個工作日才能完成的模型訓練。

各公司都知道,釋放生產力是一件重中之重的要務。超級計算機如今已經成為了AI的必備工具,樹立AI領域的領導力首先需要強大的AI計算基礎設施支持。

NVIDIA最新的MLPerf結果很好地展示了將NVIDIA V100 Tensor核心GPU應用于超算級基礎設施中所能帶來的益處。

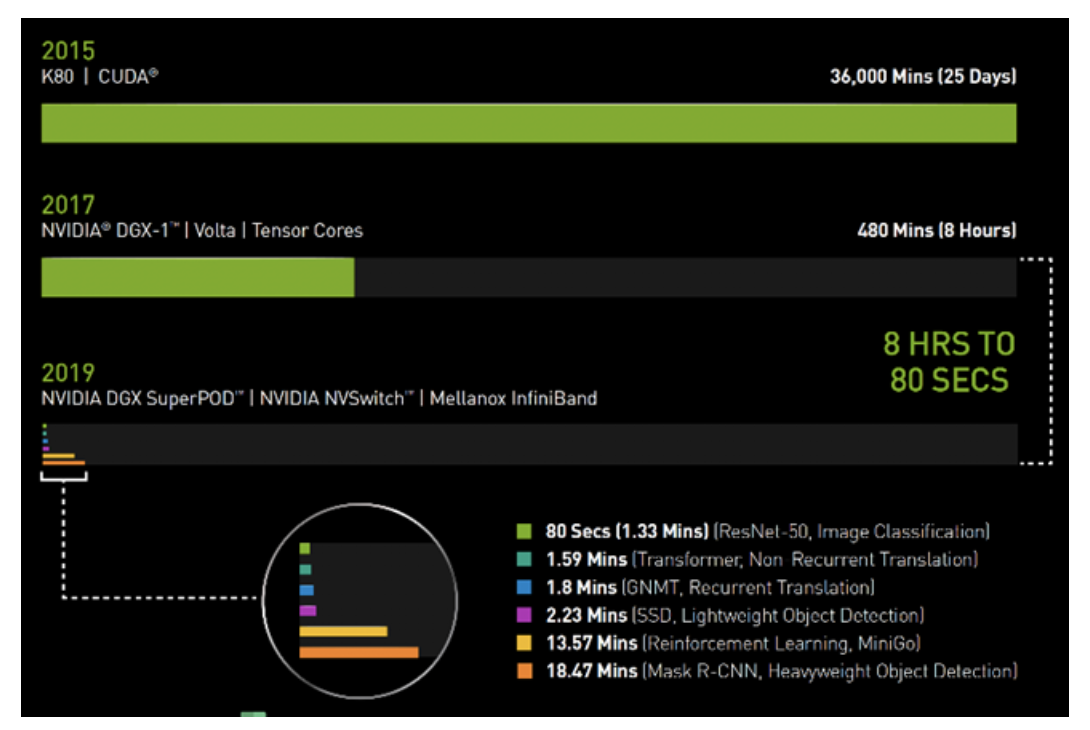

在2017年春季的時候,使用搭載了V100 GPU的NVIDIA DGX-1系統訓練圖像識別模型ResNet-50,需要花費整整一個工作日(8小時)的時間。

而如今,同樣的任務,NVIDIA DGX SuperPOD使用相同的V100 GPU,采用Mellanox InfiniBand進行互聯,并借助可用于分布式AI訓練的最新NVIDIA優化型AI軟件,僅需80秒即可完成。

80秒的時間,甚至都不夠用來沖一杯咖啡。

圖1:AI時間機器

2019年MLPerf ID(按圖表從上到下的順序):ResNet-50:0.6-30 | Transformer:0.6-28 | GNMT:0.6-14 | SSD:0.6-27 | MiniGo:0.6-11 | Mask R-CNN:0

AI的必備工具:DGX SuperPOD能夠更快速地完成工作負載

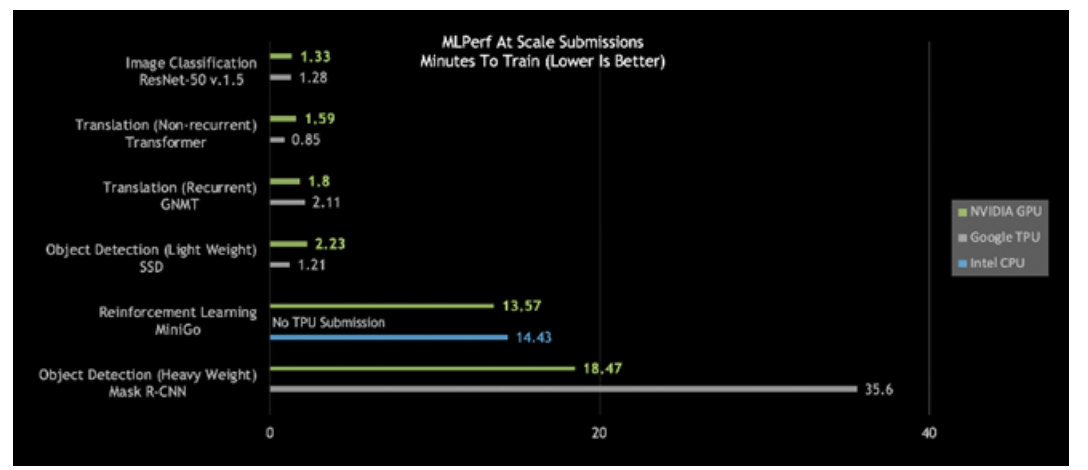

仔細觀察今日的MLPerf結果,會發現NVIDIA DGX SuperPOD是唯一在所有六個MLPerf類別中耗時都少于20分鐘的AI平臺: ?

?圖2:DGX SuperPOD打破大規模AI紀錄

大規模MLPerf 0.6性能|大規模MLPerf ID:RN50 v1.5:0.6-30,0.6-6 | Transformer:0.6-28,0.6-6 | GNMT:0.6-26,0.6-5 | SSD:0.6-27,0.6-6 | MiniGo:0.6-11,0.6-7 | Mask R-CNN:0.6-23,0.6-3

更進一步觀察會發現,針對重量級目標檢測和強化學習,這些最困難的AI問題,NVIDIA AI平臺在總體訓練時間方面脫穎而出。

使用Mask R-CNN深度神經網絡的重量級目標檢測可為用戶提供高級實例分割。其用途包括將其與多個數據源(攝像頭、傳感器、激光雷達、超聲波等)相結合,以精確識別并定位特定目標。

這類AI工作負載有助于訓練自動駕駛汽車,為其提供行人和其他目標的精確位置。另外,在醫療健康領域,它能夠幫助醫生在醫療掃描中查找并識別腫瘤。其意義的重要性非同小可。

NVIDIA的“重量級目標檢測”用時不到19分鐘,性能幾乎是第二名的兩倍。

強化學習是另一有難度的類別。這種AI方法能夠用于訓練工廠車間機器人,以簡化生產。城市也可以用這種方式來控制交通燈,以減少擁堵。NVIDIA采用NVIDIA DGX SuperPOD,在創紀錄的13.57分鐘內完成了對MiniGo AI強化訓練模型的訓練。

咖啡還沒好,任務已完成:即時AI基礎設施提供全球領先性能

打破基準測試紀錄不是目的,加速創新才是目標。這就是為什么NVIDIA構建的DGX SuperPOD不僅性能強大,而且易于部署。DGX SuperPOD全面配置了可通過NGC容器注冊表免費獲取的優化型CUDA-X AI軟件,可提供開箱即用的全球領先AI性能。

在這個由130多萬名CUDA開發者組成的生態系統中,NVIDIA與開發者們合作,致力于為所有AI框架和開發環境提供有力支持。

我們已經助力優化了數百萬行代碼,讓我們的客戶能夠將其AI項目落地,無論您身在何處都可以找到NVIDIA GPU,無論是在云端,還是在數據中心,亦或是邊緣。

AI基礎設施如今有夠快,未來會更快

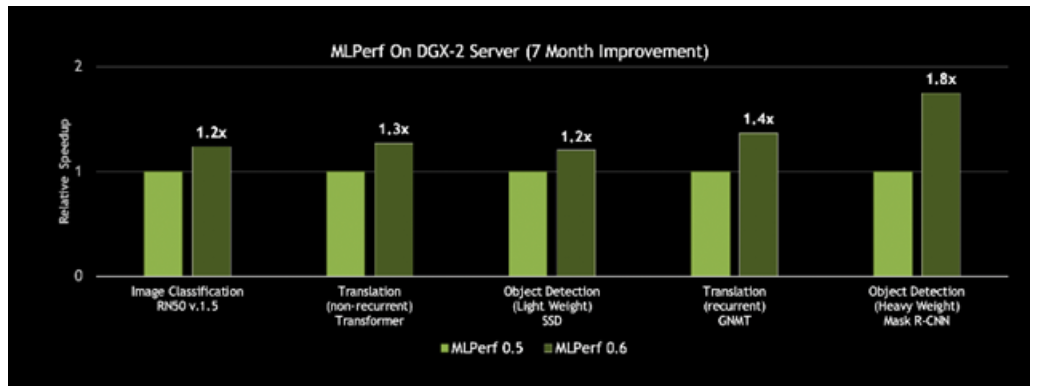

更好的一點在于,這一平臺的速度一直在提升。NVIDIA每月都會發布CUDA-X AI軟件的新優化和性能改進,集成型軟件堆棧可在NGC容器注冊表中免費下載,包括容器化的框架、預先訓練好的模型和腳本。借助在CUDA-X AI軟件堆棧上的創新,NVIDIA DGX-2H服務器的MLPerf 0.6吞吐量比NVIDIA七個月前發布的結果提升了80%。

圖3:基于同一服務器,性能提升高達80%

對單個歷元上單一DGX-2H服務器的吞吐量進行比較(數據集單次通過神經網絡)| MLPerf ID 0.5 / 0.6比較:ResNet-50 v1.5: 0.5-20/0.6-30 | Transformer: 0.5-21/0.6-20 | SSD: 0.5-21/0.6-20 | GNMT: 0.5-19/0.6-20 | Mask R-CNN: 0.5-21/0.6-20

聲明:本文內容及配圖由入駐作者撰寫或者入駐合作網站授權轉載。文章觀點僅代表作者本人,不代表電子發燒友網立場。文章及其配圖僅供工程師學習之用,如有內容侵權或者其他違規問題,請聯系本站處理。

舉報投訴

-

AI

+關注

關注

87文章

30763瀏覽量

268909 -

MLPerf基準測試

+關注

關注

0文章

1瀏覽量

1074 -

模型訓練

+關注

關注

0文章

18瀏覽量

1333

發布評論請先 登錄

相關推薦

NVIDIA通過加速AWS上的機器人仿真推進物理AI的發展

NVIDIA Isaac Sim 現在可在 Amazon EC2 G6e 實例中的 NVIDIA GPU 云實例上使用,將機器人仿真的擴展速度提高了 2 倍并加快了 AI 模型的訓練速

《算力芯片 高性能 CPUGPUNPU 微架構分析》第3篇閱讀心得:GPU革命:從圖形引擎到AI加速器的蛻變

標量、向量、矩陣的表示;從硬件實現看,不同廠商各顯神通。谷歌TPU采用脈動陣列計算單元,通過數據流向的精心編排提升計算密度;NVIDIA張量核心支持多精度計算,Hopper架構更是引入了稀疏性加速。華為

發表于 11-24 17:12

全新NVIDIA NIM微服務實現突破性進展

全新 NVIDIA NIM 微服務實現突破性進展,可助力氣象技術公司開發和部署 AI 模型,實現對降雪、結冰和冰雹的預測。

NVIDIA AI助力實現更好的癌癥檢測

由美國頂級醫療中心和研究機構的專家組成了一個專家委員會,該委員會正在使用 NVIDIA 支持的聯邦學習來評估聯邦學習和 AI 輔助注釋對訓練 AI 腫瘤分割模型的影響。

NVIDIA助力麗蟾科技打造AI訓練與推理加速解決方案

麗蟾科技通過 Leaper 資源管理平臺集成 NVIDIA AI Enterprise,為企業和科研機構提供了一套高效、靈活的 AI 訓練與推理加速解決方案。無論是在復雜的

端到端InfiniBand網絡解決LLM訓練瓶頸

ChatGPT對技術的影響引發了對人工智能未來的預測,尤其是多模態技術的關注。OpenAI推出了具有突破性的多模態模型GPT-4,使各個領域取得了顯著的發展。 這些AI進步是通過大規模模型訓練

NVIDIA Nemotron-4 340B模型幫助開發者生成合成訓練數據

Nemotron-4 340B 是針對 NVIDIA NeMo 和 NVIDIA TensorRT-LLM 優化的模型系列,該系列包含最先進的指導和獎勵模型,以及一個用于生成式 AI 訓練

NVIDIA AI Foundry 為全球企業打造自定義 Llama 3.1 生成式 AI 模型

Foundry 提供從數據策管、合成數據生成、微調、檢索、防護到評估的全方位生成式 AI 模型服務,以便部署自定義 Llama 3.1 NVIDIA NIM 微服務和新的

發表于 07-24 09:39

?706次閱讀

NVIDIA為新工業革命打造 AI 工廠和數據中心

領先的計算機制造商推出一系列?Blackwell 賦能的系統,搭載 Grace CPU、NVIDIA 網絡和基礎設施 豐富的產品組合覆蓋云、專用系統、嵌入式和邊緣 AI 系統等 產品配置豐富,從單

進一步解讀英偉達 Blackwell 架構、NVlink及GB200 超級芯片

NVIDIA NVLink,支持 FP4 AI 精度。

GB200 NVL72是一款性能卓越的計算平臺,采用更快的第二代Transformer引擎和FP8精度,可將大型語言模型的訓練速

發表于 05-13 17:16

NVIDIA將數字孿生與實時AI結合實現工業自動化

NVIDIA 軟件(Omniverse、Metropolis、Isaac 和 cuOpt)共同打造了一個 AI Gym,讓機器人和 AI 智能體能夠在復雜的工業領域中進行訓練并接受評估

基于NVIDIA Megatron Core的MOE LLM實現和訓練優化

本文將分享阿里云人工智能平臺 PAI 團隊與 NVIDIA Megatron-Core 團隊在 MoE (Mixture of Experts) 大語言模型(LLM)實現與訓練優化上的創新工作。

NVIDIA 人工智能開講 | 什么是 AI For Science?詳解 AI 助力科學研究領域的新突破

”兩大音頻 APP上搜索“ NVIDIA 人工智能開講 ”專輯,眾多技術大咖帶你深度剖析核心技術,把脈未來科技發展方向! AI For Science (亦稱 “AI In Science” ),是人工智能領域的一大熱門話題,

從8小時到80秒,NVIDIA如何實現AI訓練用時大突破?

從8小時到80秒,NVIDIA如何實現AI訓練用時大突破?

評論