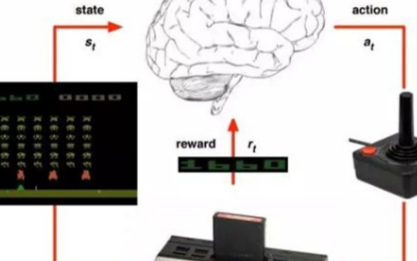

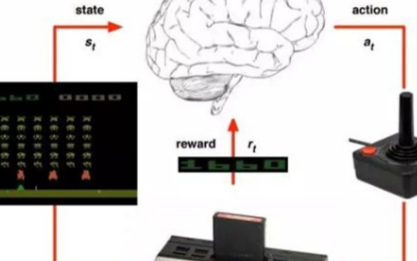

什么是深度強化學習? 眾所周知,人類擅長解決各種挑戰性的問題,從低級的運動控制(如:步行、跑步、打網球)到高級的認知任務。

2023-07-01 10:29:50 1002

1002

的一種仿生模擬。深度學習在一些應用的突破從一個側面展示了腦機理的研究對于智能技術發展的重要性。智能的本質來源于腦的工作機理,我們對于腦不斷的認識、不斷的理解,應用到我們的計算技術中,這就是腦啟發計算

2017-03-22 17:16:00

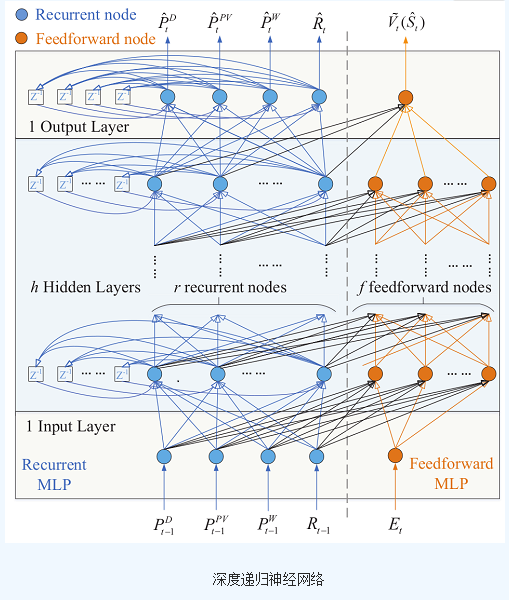

前言: 我的目的是想學習和了解微電網中逆變器的并聯控制方法,經過一段時間的查閱文獻,我了解到目前并聯控制的實現在文獻中出現頻次較高的方法是:一種是下垂控制和輸出增加虛擬阻抗的方法,使得輸出阻抗呈感性

2021-07-06 07:22:10

抄收線損管理等工作提供豐富的電網和用戶供電參數,在各供電公司建立一個經濟、實時、可靠的遠抄系統是十分必要的。手機短信是一種基于現代通訊技術的信息交流手段,由于移動通訊網絡在我國城市中已十分發達,利用手機短信來獲取分散而龐大的用戶信息成為可能。

2011-03-07 15:31:41

介紹一種一體化儀表優化交換式測量示例

2021-05-11 07:01:37

本文介紹一種基于虛擬串口的GPS/GSM遠程定位技術。

2021-05-25 07:14:20

本文將介紹一種使用WSL來編譯nodemcu固件的方法。

2022-02-15 07:34:55

本文介紹了一種可以高精度的測量電阻的方法。

2021-05-10 06:38:57

本文介紹一種基于FIFO結構的優化端點設計方案。

2021-05-31 06:31:35

介紹一種基于分級的RFID隱私保護方法

2021-05-26 06:17:01

[導讀] 本文介紹了以LPC2365為核心處理器、嵌入式實時操作系統μC/OS-II下的多串口通信編程方法。對于固定長度的短字節幀數據,通過設置合適的字節觸發深度,一次中斷完成數據接收任務;對于變長

2021-12-15 09:06:56

介紹一種無線電測向技術

2021-05-26 06:40:24

本文介紹了一種汽車無線接入技術的解決方案。

2021-05-12 06:40:56

多智能體系統深度強化學習:挑戰、解決方案和應用的回顧摘要介紹背景:強化學習前提貝爾曼方程RL方法深度強化學習:單智能體深度Q網絡DQN變體深度強化學習:多智能體挑戰與解決方案MADRL應用結論和研究

2021-07-12 08:44:43

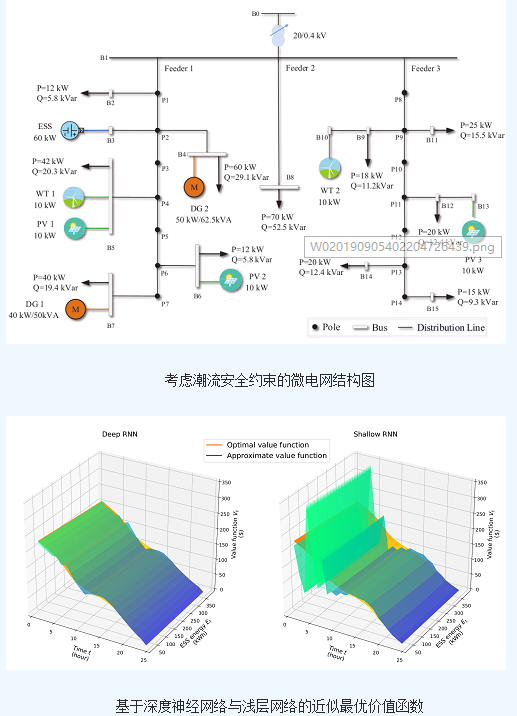

做是小型的電力系統,具備完整的發輸配電功能,可實現用側可再生能源的安全消納,同時微網本身還是一個典型的分布式發電功能系統,可通過能源之間的調度,提高終端能源的利用率。也是智能電網發展的趨勢。在實際生活

2018-09-19 14:09:52

微電網的運行方式是微電網系統研究的一個重要方向,有效獲知其實際的運行模式能夠方便后期檢索排查微電網控制系統當中的問題。微電網如何運行?請看南京研旭新能源有限公司在本文內的介紹。 微電網存在兩種典型

2018-09-18 14:30:41

微電網儲能優化研究有何意義?微電網有哪些性能?如何去選取一種微電網優化算法?什么是粒子群算法?

2021-07-06 06:34:20

) 基于多代理技術的微電網控制。該方法將計算機領域的多代理技術應用到微電網,代理的自治性、自發性等特點能夠很好地適應和滿足微電網分散控制的要求。微電網作為分布式發電優化集成的一種方式,已經成為世界各國

2018-09-20 11:27:45

等方面。微電網作為分布式發電優化集成的一種方式,已經成為世界各國研究的重點,微電網將在未來占有重要的地位。微電網雖然具有很多優點,但在大規模應用之前,還有許多問題需要解決。所以中國微電網技術的發展還將

2018-11-20 08:43:30

深度策略梯度-DDPG,PPO等第一天9:00-12:0014:00-17:00一、強化學習概述1.強化學習介紹 2.強化學習與其它機器學習的不同3.強化學習發展歷史4.強化學習典型應用5.強化學習

2022-04-21 14:57:39

一:深度學習DeepLearning實戰時間地點:1 月 15日— 1 月18 日二:深度強化學習核心技術實戰時間地點: 1 月 27 日— 1 月30 日(第一天報到 授課三天;提前環境部署 電腦

2021-01-09 17:01:54

利用ML構建無線環境地圖及其在無線通信中的應用?使用深度學習的收發機設計和信道解碼基于ML的混合學習方法,用于信道估計、建模、預測和壓縮 使用自動編碼器等ML技術的端到端通信?無線電資源管理深度強化學習

2021-07-01 10:49:03

一:深度學習DeepLearning實戰時間地點:1 月 15日— 1 月18 日二:深度強化學習核心技術實戰時間地點: 1 月 27 日— 1 月30 日(第一天報到 授課三天;提前環境部署 電腦

2021-01-10 13:42:26

的工具和方法,對推動微電網技術的發展具有重要意義。1、微電網的實時仿真是指在仿真過程中,系統的運行和響應能夠以接近實時的速度進行模擬和評估的一種技術。它可以提供更高的仿真精度和準確度,使研究人員和工程師

2023-09-26 10:22:11

關于交直流配電技術的研究成果并沒有得到實踐的檢驗,還需要不斷完善。因此,交直流微電網的應用領域目前來說還是比較有限的。南京研旭結合當前的技術背景,研發生產了面向高校新能源專業師生群體的交直流微電網控制系統

2018-10-15 10:22:38

關于交直流配電技術的研究成果并沒有得到實踐的檢驗,還需要不斷完善。因此,交直流微電網的應用領域目前來說還是比較有限的。南京研旭結合當前的技術背景,研發生產了面向高校新能源專業師生群體的交直流微電網控制系統

2018-10-23 15:14:31

,Deep Learning—遷移學習5,Deep Learning—深度強化學習6,深度學習的常用模型或者方法深度學習交流大群: 372526178 (資料共享,加群備注楊春嬌邀請)

2018-09-05 10:22:34

什么是深度學習為了解釋深度學習,有必要了解神經網絡。神經網絡是一種模擬人腦的神經元和神經網絡的計算模型。作為具體示例,讓我們考慮一個輸入圖像并識別圖像中對象類別的示例。這個例子對應機器學習中的分類

2023-02-17 16:56:59

相對成熟的技術和較好的性價比,鋰離子電池和鉛炭(酸)電池是目前儲能系統的首選技術路線。 近日,研究機構EVTank發布《微電網領域儲能行業深度分析報告(2016)》,研究報告認為隨著能源互聯網

2016-01-20 17:12:18

的清潔能源的推廣應用,智能光伏微電網的出現有效滿足這一現實需求。在本文內,南京研旭新能源科技有限公司將會就光伏微電網的技術應用來做詳細的介紹。 光伏微電網的特點:光伏微電網指的是,采用光伏發電作為白天

2018-10-18 11:07:27

分布式的能源供應系統。作為多種分布式能源的集大成者,“微電網”技術具有廣闊的發展空間和應用場景。下面我們以微電網的典型應用案例之一,光伏微電網來進行重點介紹。在一套完整的光伏微電網系統中,分太陽能作為

2018-09-27 14:33:54

,自適應處理技術; 實時分析——數據到信息的提升,優化運行方式。 二、智能微電網兩種運行模式 并網模式:正常情況下,智能微電網與常規配電網并網運行。 孤島模式:當檢測到電網故障或電能質量不滿足

2016-01-07 14:13:12

強化學習的另一種策略(二)

2019-04-03 12:10:44

在RK3399開發板上如何去實現一種人工智能深度學習框架呢?

2022-03-07 07:00:05

、監控和調節不同的資源。智能電網在發展中國家的能源支持中也發揮著至關重要的作用,因為它們可以通過實現從一次性方法向電氣化的過渡,為人口稀少的地區提供電力。定制技術和增強的數據收集有助于提高生活水平

2023-04-06 16:34:25

怎么設計實現一個微電網?

2021-09-29 06:24:59

哪一種類型的電化學分析法,都必須在一個化學電池中進行,因此化學電池的基本原理是各種電化學方法的基礎。電位法是通過測量電極電動勢以求得待測物質含量的分析方法。若根據電極電位測量值,直接求算待測物的含量,稱為

2017-10-16 10:06:07

中國科技論文在線直流微電網控制與仿真杜生輝,劉皓明,丁帥**(河海大學能源與電氣學院,南京 211100 )5摘要:微電網是解決分布式電源并網的有效途徑,但多數分布式電源發出的電能需要通過整流逆變

2021-07-12 07:17:27

本文介紹了一種PCB設計復用方法,它是基于Mentor Graphics的印制電路板設計工具Board Station進行的。

2021-05-06 07:10:13

本文介紹一種三軸正交型傳感器正交性的軟件修正方法。

2021-05-07 06:53:11

技術等眾多發展趨勢為一體的未來電網發展重要方式。智能電網相較傳統電網的優點在于可以針對網絡中的各供電節點進行實時的電力調節,對于現在大力提倡并推廣的分布式能源來說無疑是個好消息。規模化分布式能源電力

2015-07-16 11:17:07

將詳細介紹微電網多端口能量路由器的重要性和相關技術一特、點微。電網多端口能量路由器的概述微電網多端口能量路由器是一種新型的電力電子設備,它通過先進的功率電子變換技

2023-10-18 22:31:53

強化學習在RoboCup帶球任務中的應用_劉飛

2017-03-14 08:00:00 0

0 界聲譽卓著。在此前接受CSDN采訪時,楊強介紹了他目前的主要工作致力于一個將深度學習、強化學習和遷移學習有機結合的Reinforcement Transfer Learning(RTL)體系的研究。那么,這個技術框架對工業界的實際應用有什么用的實際意義?在本文中,CSDN結合楊強的另外一個身份國內人工智能創業

2017-10-09 18:23:18 0

0 請訂閱2016年《程序員》 盡管監督式和非監督式學習的深度模型已經廣泛被技術社區所采用,深度強化學習仍舊顯得有些神秘。這篇文章將試圖揭秘

2017-10-09 18:28:43 0

0 與監督機器學習不同,在強化學習中,研究人員通過讓一個代理與環境交互來訓練模型。當代理的行為產生期望的結果時,它得到正反饋。例如,代理人獲得一個點數或贏得一場比賽的獎勵。簡單地說,研究人員加強了代理人的良好行為。

2018-07-13 09:33:00 24319

24319

深度強化學習DRL自提出以來, 已在理論和應用方面均取得了顯著的成果。尤其是谷歌DeepMind團隊基于深度強化學習DRL研發的AlphaGo,將深度強化學習DRL成推上新的熱點和高度,成為人工智能歷史上一個新的里程碑。因此,深度強化學習DRL非常值得研究。

2018-06-29 18:36:00 27596

27596 薩頓在專訪中(再次)科普了強化學習、深度強化學習,并談到了這項技術的潛力,以及接下來的發展方向:預測學習

2017-12-27 09:07:15 10856

10856 針對路徑規劃算法收斂速度慢及效率低的問題,提出了一種基于分層強化學習及人工勢場的多Agent路徑規劃算法。首先,將多Agent的運行環境虛擬為一個人工勢能場,根據先驗知識確定每點的勢能值,它代表最優

2017-12-27 14:32:02 0

0 本文提出了一種LCS和LS-SVM相結合的多機器人強化學習方法,LS-SVM獲得的最優學習策略作為LCS的初始規則集。LCS通過與環境的交互,能更快發現指導多機器人強化學習的規則,為強化學習系統

2018-01-09 14:43:49 0

0 傳統上,強化學習在人工智能領域占據著一個合適的地位。但強化學習在過去幾年已開始在很多人工智能計劃中發揮更大的作用。

2018-03-03 14:16:56 3924

3924 強化學習是智能系統從環境到行為映射的學習,以使獎勵信號(強化信號)函數值最大,強化學習不同于連接主義學習中的監督學習,主要表現在教師信號上,強化學習中由環境提供的強化信號是對產生動作的好壞作一種評價

2018-05-30 06:53:00 1234

1234 自動駕駛汽車首先是人工智能問題,而強化學習是機器學習的一個重要分支,是多學科多領域交叉的一個產物。今天人工智能頭條給大家介紹強化學習在自動駕駛的一個應用案例,無需3D地圖也無需規則,讓汽車從零開始在二十分鐘內學會自動駕駛。

2018-07-10 09:00:29 4676

4676

強化學習是人工智能基本的子領域之一,在強化學習的框架中,智能體通過與環境互動,來學習采取何種動作能使其在給定環境中的長期獎勵最大化,就像在上述的棋盤游戲寓言中,你通過與棋盤的互動來學習。

2018-07-15 10:56:37 17105

17105

結合 DL 與 RL 的深度強化學習(Deep Reinforcement Learning, DRL)迅速成為人工智能界的焦點。

2018-08-09 10:12:43 5789

5789 深度強化學習的理論、自動駕駛技術的現狀以及問題、深度強化學習在自動駕駛技術當中的應用及基于深度強化學習的禮讓自動駕駛研究。

2018-08-18 10:19:57 4854

4854 強化學習作為一種常用的訓練智能體的方法,能夠完成很多復雜的任務。在強化學習中,智能體的策略是通過將獎勵函數最大化訓練的。獎勵在智能體之外,各個環境中的獎勵各不相同。深度學習的成功大多是有密集并且有效的獎勵函數,例如電子游戲中不斷增加的“分數”。

2018-08-18 11:38:57 3362

3362 強化學習是一種非常重要 AI 技術,它能使用獎勵(或懲罰)來驅動智能體(agents)朝著特定目標前進,比如它訓練的 AI 系統 AlphaGo 擊敗了頂尖圍棋選手,它也是 DeepMind 的深度

2018-09-03 14:06:30 2653

2653 直接的強化學習方法很有吸引力,它無需過多假設,而且能自動掌握很多技能。由于這種方法除了建立函數無需其他信息,所以很容易在改進后的環境中重新學習技能,例如更換了目標物體或機械手。

2018-09-05 08:54:15 9616

9616 之前接觸的強化學習算法都是單個智能體的強化學習算法,但是也有很多重要的應用場景牽涉到多個智能體之間的交互。

2018-11-02 16:18:15 21016

21016 針對提高視覺圖像特征與優化控制之間契合度的問題,本文提出一種基于深度強化學習的機械臂視覺抓取控制優化方法,可以自主地從與環境交互產生的視覺圖像中不斷學習特征提取,直接地將提取的特征應用于機械臂抓取

2018-12-19 15:23:59 22

22 OpenAI 近期發布了一個新的訓練環境 CoinRun,它提供了一個度量智能體將其學習經驗活學活用到新情況的能力指標,而且還可以解決一項長期存在于強化學習中的疑難問題——即使是廣受贊譽的強化算法在訓練過程中也總是沒有運用監督學習的技術。

2019-01-01 09:22:00 2122

2122

針對深度強化學習中卷積神經網絡(CNN)層數過深導致的梯度消失問題,提出一種將密集連接卷積網絡應用于強化學習的方法。首先,利用密集連接卷積網絡中的跨層連接結構進行圖像特征的有效提取;然后,在密集連接

2019-01-23 10:41:51 3

3 在一些情況下,我們會用策略函數(policy, 總得分,也就是搭建的網絡在測試集上的精度(accuracy),通過強化學習(Reinforcement Learning)這種通用黑盒算法來優化。然而,因為強化學習本身具有數據利用率低的特點,這個優化的過程往往需要大量的計算資源。

2019-01-28 09:54:22 4704

4704 近日,Reddit一位網友根據近期OpenAI Five、AlphaStar的表現,提出“深度強化學習是否已經到達盡頭”的問題。

2019-05-10 16:34:59 2313

2313 近年來,深度強化學習(Deep reinforcement learning)方法在人工智能方面取得了矚目的成就

2019-06-03 14:36:05 2619

2619 近幾年來,強化學習在任務導向型對話系統中得到了廣泛的應用,對話系統通常被統計建模成為一個 馬爾科夫決策過程(Markov Decision Process)模型,通過隨機優化的方法來學習對話策略。

2019-08-06 14:16:29 1836

1836 深度學習DL是機器學習中一種基于對數據進行表征學習的方法。深度學習DL有監督和非監督之分,都已經得到廣泛的研究和應用。

2020-01-30 09:53:00 5546

5546

強化學習非常適合實現自主決策,相比之下監督學習與無監督學習技術則無法獨立完成此項工作。

2019-12-10 14:34:57 1092

1092 深度學習DL是機器學習中一種基于對數據進行表征學習的方法。深度學習DL有監督和非監督之分,都已經得到廣泛的研究和應用。

2020-01-24 10:46:00 4734

4734 惰性是人類的天性,然而惰性能讓人類無需過于復雜的練習就能學習某項技能,對于人工智能而言,是否可有基于惰性的快速學習的方法?本文提出一種懶惰強化學習(Lazy reinforcement learning, LRL) 算法。

2020-01-16 17:40:00 745

745 本文檔的主要內容詳細介紹的是深度強化學習的筆記資料免費下載。

2020-03-10 08:00:00 0

0 )的研究人員聯合發表了一篇論文,詳細介紹了他們構建的一個通過 AI 技術自學走路的機器人。該機器人結合了深度學習和強化學習兩種不同類型的 AI 技術,具備直接放置于真實環境中進行訓練的條件。

2020-03-17 15:15:30 1354

1354 深度學習DL是機器學習中一種基于對數據進行表征學習的方法。深度學習DL有監督和非監督之分,都已經得到廣泛的研究和應用。強化學習RL是通過對未知環境一邊探索一邊建立環境模型以及學習得到一個最優策略。強化學習是機器學習中一種快速、高效且不可替代的學習算法。

2020-05-16 09:20:40 3148

3148 深度學習DL是機器學習中一種基于對數據進行表征學習的方法。深度學習DL有監督和非監督之分,都已經得到廣泛的研究和應用。強化學習RL是通過對未知環境一邊探索一邊建立環境模型以及學習得到一個最優策略。強化學習是機器學習中一種快速、高效且不可替代的學習算法。

2020-06-13 11:39:40 5526

5526 訓練最新 AI 系統需要驚人的計算資源,這意味著囊中羞澀的學術界實驗室很難趕上富有的科技公司。但一種新的方法可以讓科學家在單臺計算機上訓練先機的 AI。2018 年 OpenAI 報告每 3.4 個月訓練最強大 AI 所需的處理能力會翻一番,其中深度強化學習對處理尤為苛刻。

2020-07-29 09:45:38 580

580 強化學習屬于機器學習中的一個子集,它使代理能夠理解在特定環境中執行特定操作的相應結果。目前,相當一部分機器人就在使用強化學習掌握種種新能力。

2020-11-06 15:33:49 1552

1552 深度強化學習是深度學習與強化學習相結合的產物,它集成了深度學習在視覺等感知問題上強大的理解能力,以及強化學習的決策能力,實現了...

2020-12-10 18:32:50 374

374 RLax(發音為“ relax”)是建立在JAX之上的庫,它公開了用于實施強化學習智能體的有用構建塊。。報道:深度強化學習實驗室作者:DeepRL ...

2020-12-10 18:43:23 499

499 本文主要介紹深度強化學習在任務型對話上的應用,兩者的結合點主要是將深度強化學習應用于任務型對話的策略學習上來源:騰訊技術工程微信號

2020-12-10 19:02:45 781

781 強化學習( Reinforcement learning,RL)作為機器學習領域中與監督學習、無監督學習并列的第三種學習范式,通過與環境進行交互來學習,最終將累積收益最大化。常用的強化學習算法分為

2021-04-08 11:41:58 11

11 化強化學習。無模型強仳學習方法的訓練過程需要大量樣本,當采樣預算不足,無法收集大量樣本時,很難達到預期效果。然而,模型化強化學習可以充分利用環境模型,降低真實樣本需求量,在一定程度上提高樣本效率。將以模型化強化學習為核心,介紹

2021-04-12 11:01:52 9

9 利用深度強化學習技術實現路口信號控制是智能交通領域的硏究熱點。現有硏究大多利用強化學習來全面刻畫交通狀態以及設計有效強化學習算法以解決信號配時問題,但這些研究往往忽略了信號燈狀態對動作選擇的影響以及

2021-04-23 15:30:53 21

21 目前壯語智能信息處理研究處于起步階段,缺乏自動詞性標注方法。針對壯語標注語料匱乏、人工標注費時費力而機器標注性能較差的現狀,提出一種基于強化學習的壯語詞性標注方法。依據壯語的文法特點和中文賓州

2021-05-14 11:29:35 14

14 壓邊為改善板料拉深制造的成品質量,釆用深度強化學習的方法進行拉深過程旳壓邊力優化控制。提岀一種基于深度強化學習與有限元仿真集成的壓邊力控制模型,結合深度神經網絡的感知能力與強化學習的決策能力,進行

2021-05-27 10:32:39 0

0 一種新型的多智能體深度強化學習算法

2021-06-23 10:42:47 36

36 基于深度強化學習的無人機控制律設計方法

2021-06-23 14:59:10 46

46 突破.由于融合了深度學習強大的表征能力和強化學習有效的策略搜索能力,深度強化學習已經成為實現人工智能頗有前景的學習范式.然而,深度強化學習在多Agent 系統的研究與應用中,仍存在諸多困難和挑戰,以StarCraft II 為代表的部分觀測環境下的多Agent學習仍然很難達到理想效果.本文簡要介紹了深度Q

2022-01-18 10:08:01 1226

1226

來源:DeepHub IMBA 強化學習的基礎知識和概念簡介(無模型、在線學習、離線強化學習等) 機器學習(ML)分為三個分支:監督學習、無監督學習和強化學習。 監督學習(SL) : 關注在給

2022-12-20 14:00:02 828

828 電子發燒友網站提供《ESP32上的深度強化學習.zip》資料免費下載

2022-12-27 10:31:45 0

0 本文介紹了強化學習與智能駕駛決策規劃。智能駕駛中的決策規劃模塊負責將感知模塊所得到的環境信息轉化成具體的駕駛策略,從而指引車輛安全、穩定的行駛。真實的駕駛場景往往具有高度的復雜性及不確定性。如何制定

2023-02-08 14:05:16 1440

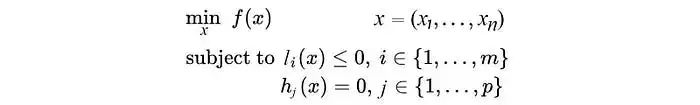

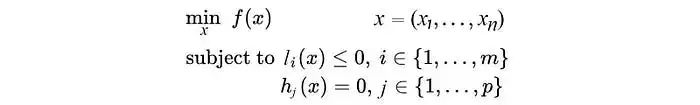

1440 優化是機器學習中的關鍵步驟。在這個機器學習系列中,我們將簡要介紹優化問題,然后探討兩種特定的優化方法,即拉格朗日乘子和對偶分解。這兩種方法在機器學習、強化學習和圖模型中非常流行。

2023-05-30 16:47:17 1335

1335

,可以節省至多 95% 的訓練開銷。 深度強化學習模型的訓練通常需要很高的計算成本,因此對深度強化學習模型進行稀疏化處理具有加快訓練速度和拓展模型部署的巨大潛力。 然而現有的生成小型模型的方法主要基于知識蒸餾,即通過迭

2023-06-11 21:40:02 356

356

來源:DeepHubIMBA強化學習的基礎知識和概念簡介(無模型、在線學習、離線強化學習等)機器學習(ML)分為三個分支:監督學習、無監督學習和強化學習。監督學習(SL):關注在給定標記訓練數據

2023-01-05 14:54:05 419

419

摘要:基于強化學習的目標檢測算法在檢測過程中通常采用預定義搜索行為,其產生的候選區域形狀和尺寸變化單一,導致目標檢測精確度較低。為此,在基于深度強化學習的視覺目標檢測算法基礎上,提出聯合回歸與深度

2023-07-19 14:35:02 0

0 摘 要:點云分割是點云數據理解中的一個關鍵技術,但傳統算法無法進行實時語義分割。近年來深度學習被應用在點云分割上并取得了重要進展。綜述了近四年來基于深度學習的點云分割的最新工作,按基本思想分為

2023-07-20 15:23:59 0

0 訊維模擬矩陣在深度強化學習智能控制系統中的應用主要是通過構建一個包含多種環境信息和動作空間的模擬矩陣,來模擬和預測深度強化學習智能控制系統在不同環境下的表現和效果,從而優化控制策略和提高系統的性能

2023-09-04 14:26:36 295

295

強化學習是機器學習的方式之一,它與監督學習、無監督學習并列,是三種機器學習訓練方法之一。 在圍棋上擊敗世界第一李世石的 AlphaGo、在《星際爭霸2》中以 10:1 擊敗了人類頂級職業玩家

2023-10-30 11:36:40 1050

1050

電子發燒友App

電子發燒友App

評論