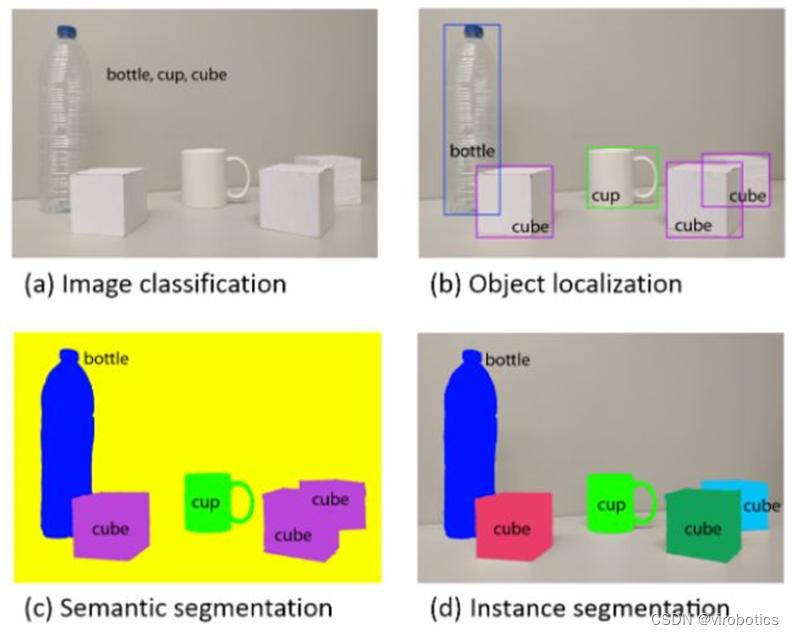

使用LabVIEW實現(xiàn)Mask R-CNN圖像實例分割

2023-03-21 13:39:50 1309

1309

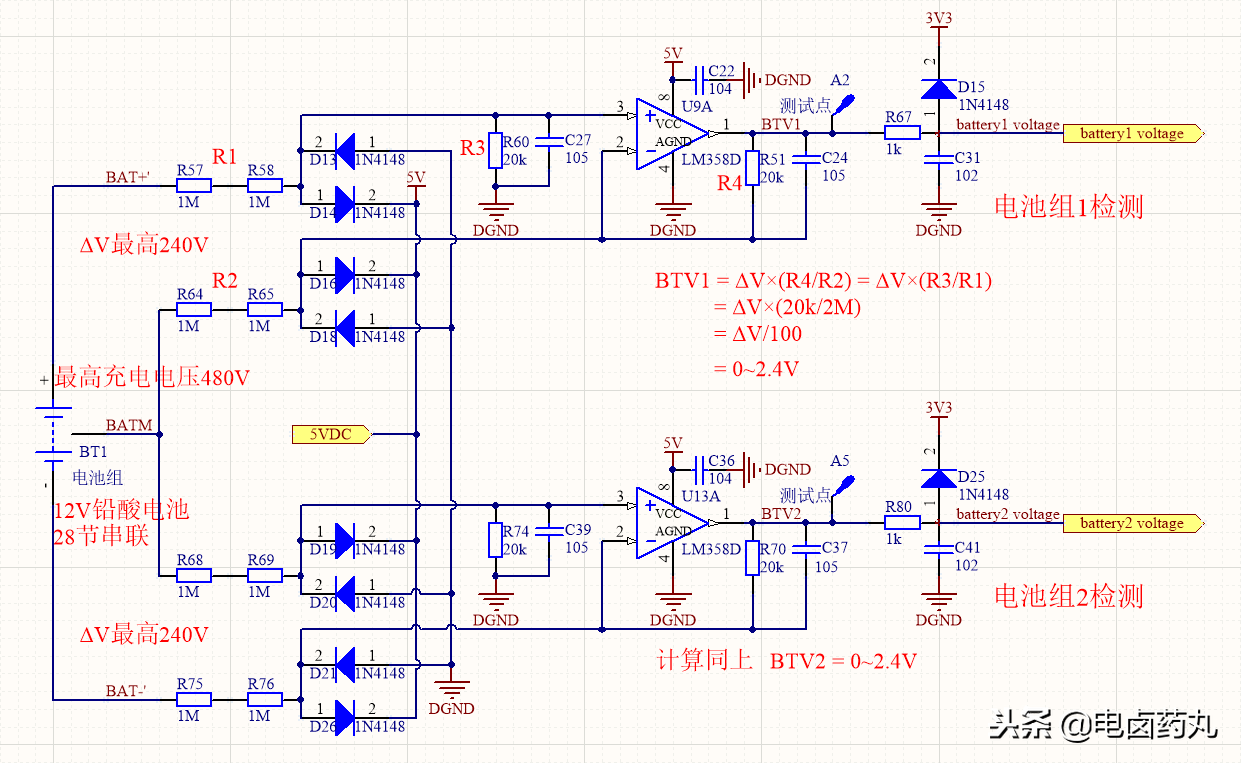

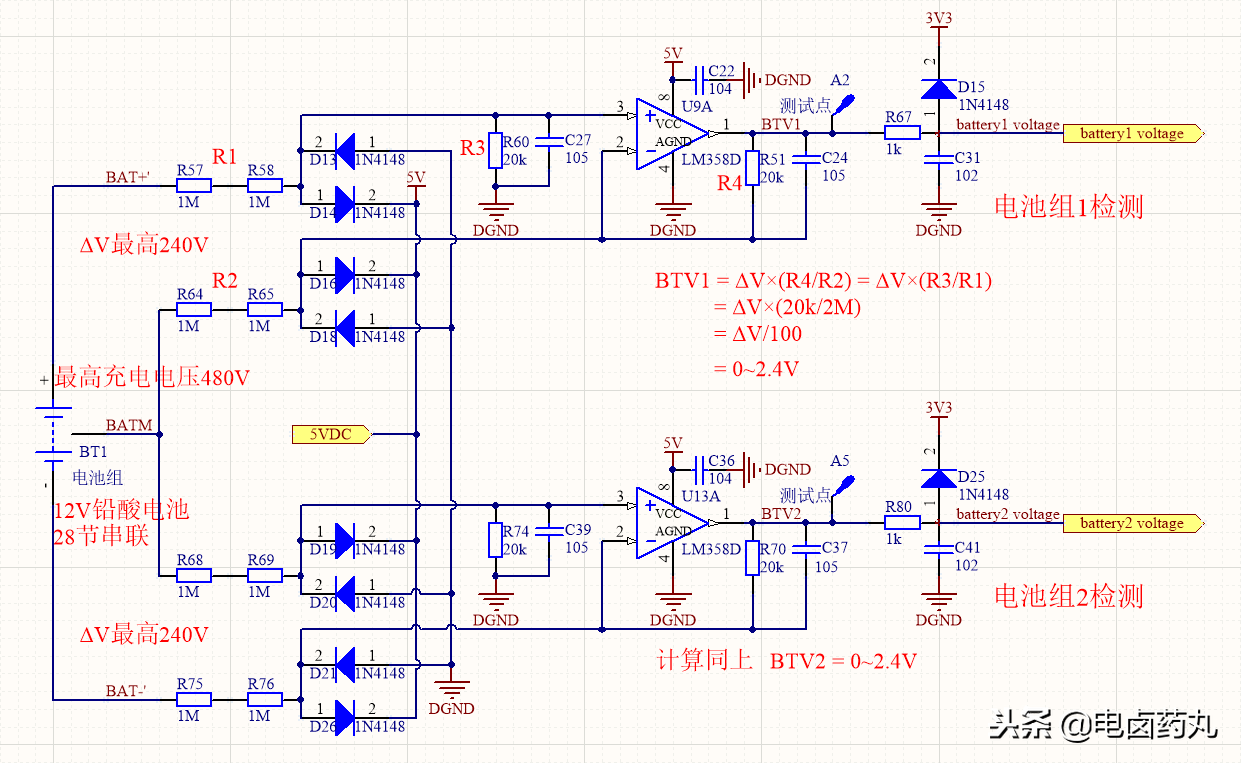

實例講解單片機模擬量采集: 從硬件到程序, 從濾波到實際值轉(zhuǎn)換,有多少人懂了?

2023-10-17 14:28:06 2228

2228

我們將使用實例講解MATLAB / Simulink HDL 使用入門。

2023-11-06 09:12:47 537

537

CNN模型的輸出信息進(jìn)行負(fù)荷預(yù)測,最終得到預(yù)測結(jié)果。選取西班牙公開的電力數(shù)據(jù)為實驗數(shù)據(jù),運用Python語言搭建預(yù)測模型,分別與CNN和LSTM單一模型進(jìn)行對比,驗證了所提組合預(yù)測模型的可靠性,其在電力短期負(fù)荷預(yù)測領(lǐng)域應(yīng)用效果較好,可為供電部門電力規(guī)劃提供理論依據(jù)。

2023-11-09 14:13:59 977

977

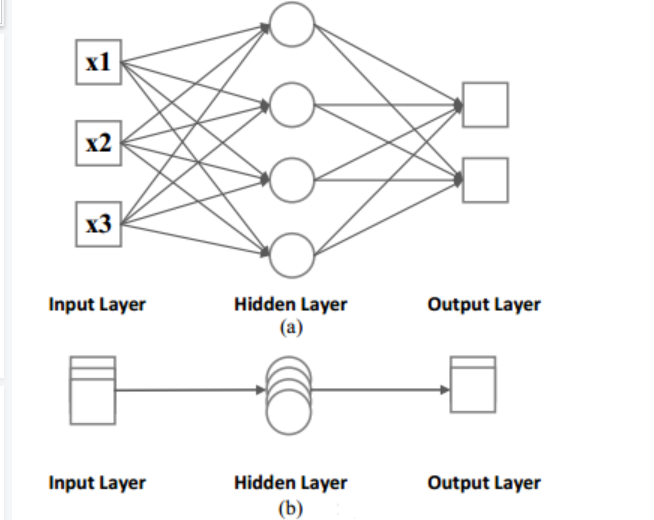

循環(huán)神經(jīng)網(wǎng)絡(luò) (RNN) 是一種深度學(xué)習(xí)結(jié)構(gòu),它使用過去的信息來提高網(wǎng)絡(luò)處理當(dāng)前和將來輸入的性能。RNN 的獨特之處在于該網(wǎng)絡(luò)包含隱藏狀態(tài)和循環(huán)。

2024-02-29 14:56:10 291

291

2602型數(shù)字源表數(shù)模轉(zhuǎn)換器的測試實例講解

2021-05-11 07:03:22

;quot;X"圖案。而且即便未知圖案可能有一些平移或稍稍變形,依然能辨別出它是一個X圖案。如此,CNN是把未知圖案和標(biāo)準(zhǔn)X圖案一個局部一個局部的對比,如下圖所示未知圖案的局部和標(biāo)準(zhǔn)X圖案

2018-10-17 10:15:50

RNN中支持的一些基本算子,如何對序列數(shù)據(jù)進(jìn)行組織

2022-08-31 10:01:30

DL之RNN:RNN算法相關(guān)論文、相關(guān)思路、關(guān)鍵步驟、配圖集合+TF代碼定義

2018-12-28 14:20:33

本帖最后由 eehome 于 2013-1-5 10:08 編輯

AVR單片機C語言實例講解帶你輕松從入門到精通

2012-11-05 14:22:39

Altium Designer高清視頻教程,已實例講解,貼近工程實際,拿出來跟大家共享。鏈接:http://pan.baidu.com/s/1qWFTx1M 密碼:0rvx

2015-06-02 10:53:26

AutoCAD與MATLAB的結(jié)合(1)實現(xiàn)原理(Matlab源代碼)(2)轉(zhuǎn)換實例2 基于DXF文件實現(xiàn)AutoCAD與Matlab的結(jié)合(1)實現(xiàn)原理(2)轉(zhuǎn)換實例3 結(jié)束語 ``

2011-08-02 16:08:00

作者:琥珀導(dǎo)言:循環(huán)神經(jīng)網(wǎng)絡(luò)(RNNs)具有保留記憶和學(xué)習(xí)數(shù)據(jù)序列的能力。由于RNN的循環(huán)性質(zhì),難以將其所有計算在傳統(tǒng)硬件上實現(xiàn)并行化。當(dāng)前CPU不具有大規(guī)模并行性,而由于RNN模型的順序組件

2018-07-31 10:11:00

FastCV實例cornerApp講解 cornerApp是一個使用了aDSP加速的基本用例,其在Hexagon SDK中的目錄內(nèi)容如下: glue:包含依賴Hexagon SDK的其他模塊的構(gòu)建

2018-09-21 10:29:43

前言:本系列教程將 對應(yīng)外設(shè)原理,HAL庫與STM32CubeMX結(jié)合在一起講解,使您可以更快速的學(xué)會各個模塊的使用所用工具:1、芯片:STM32F407ZET6/STM32F103ZET62

2021-08-19 06:00:51

PCB布線設(shè)計、技巧和實例講解

2023-09-21 06:02:22

為方便學(xué)習(xí)與交流,根據(jù)自己的理解與經(jīng)驗寫了這份教程,有錯誤之處請各位讀者予以指出,具體包含以下三部分內(nèi)容: (1)PID數(shù)字化的推導(dǎo)過程(實質(zhì):微積分的近似計算); (2)程序風(fēng)格介紹(程序風(fēng)格來源于TI官方案例); (3)C有關(guān)語法簡述(語法會結(jié)合實例進(jìn)行講解)。

2018-12-13 16:31:26

Protel DXP設(shè)計實例講解。點擊下載

2019-05-06 17:17:31

TF之CNN:CNN實現(xiàn)mnist數(shù)據(jù)集預(yù)測 96%采用placeholder用法+2層C及其max_pool法+隱藏層dropout法+輸出層softmax法+目標(biāo)函數(shù)cross_entropy法+

2018-12-19 17:02:40

TF之CNN:Tensorflow構(gòu)建卷積神經(jīng)網(wǎng)絡(luò)CNN的嘻嘻哈哈事之詳細(xì)攻略

2018-12-19 17:03:10

在TensorFlow中實現(xiàn)CNN進(jìn)行文本分類(譯)

2019-10-31 09:27:55

原文鏈接:http://tecdat.cn/?p=6585本文介紹了用于渦輪槳距角控制的永磁同步發(fā)電機(PMSG)和高性能在線訓(xùn)練遞歸神經(jīng)網(wǎng)絡(luò)(RNN)的混合模糊滑模損失最小化控制的設(shè)計。反向傳播學(xué)

2021-07-12 07:55:17

把proteus的仿真實例做成一個單獨的程序,點開后就能看仿真結(jié)果,不需要安裝軟件求大神指導(dǎo)

2013-05-09 09:40:16

重要提示38.2 官方WM_Redraw.c實例講解38.3官方WM_Sample.c實例講解(含大量窗口API操作)38.4 官方WM_LateClipping.c實例講解38.5 官方WM_Video.c實例講解38.6 總結(jié)

2017-02-19 12:10:41

`內(nèi)容簡介《IGBT驅(qū)動與保護電路設(shè)計及應(yīng)用電路實例》結(jié)合國內(nèi)外IGBT的發(fā)展和最新應(yīng)用技術(shù),以從事IGBT應(yīng)用電路設(shè)計人員為《IGBT驅(qū)動與保護電路設(shè)計及應(yīng)用電路實例》的讀者對象,系統(tǒng)、全面地講解

2021-07-24 17:13:18

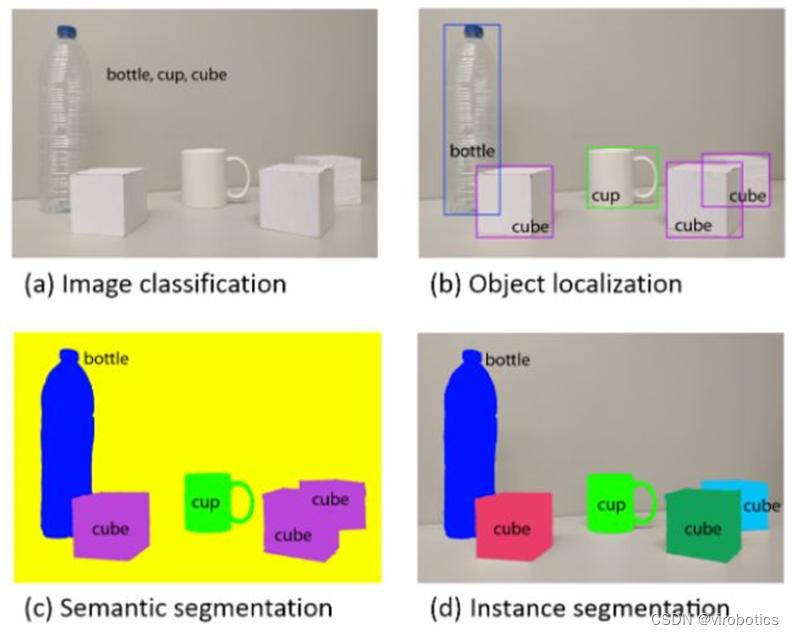

1 CNN簡介

CNN即卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks),是一類包含卷積計算的神經(jīng)網(wǎng)絡(luò),是深度學(xué)習(xí)(deep learning)的代表算法之一,在圖像識別

2023-08-18 06:56:34

DMA是什么?串口直接收發(fā)和DMA結(jié)合串口收發(fā)對比分析哪個好?

2021-12-13 06:39:53

本帖最后由 eehome 于 2013-1-5 10:02 編輯

從設(shè)計實例講解單片機C語言高階編程

2012-08-17 16:17:43

利用RNN進(jìn)行文章生成

2019-05-24 08:35:12

【深度學(xué)習(xí)】卷積神經(jīng)網(wǎng)絡(luò)CNN

2020-06-14 18:55:37

本視頻是自己本人錄制的視頻分享,PADS9.5-實例講解布局技巧方法視頻,希望對新手有所幫助!!!PADS9.5—入門到高QQ級:369929234PADS9.5初級至高級QQ群:252549288目錄:

2014-11-25 10:15:37

1、基于SARIMA、XGBoost和CNN-LSTM的時間序列預(yù)測對比 時間序列預(yù)測是一個經(jīng)常被研究的話題,我們這里使用使用兩個太陽能電站的數(shù)據(jù),研究其規(guī)律進(jìn)行建模。首先將它們歸納為兩個問題來

2022-12-20 16:34:57

基于數(shù)字CNN與生物視覺的仿生眼設(shè)計在充分研究第一代視覺假體功能的基礎(chǔ)上,利用細(xì)胞神經(jīng)網(wǎng)絡(luò)(CNN)的圖像處理能力,結(jié)合生物視覺中信息加工與編碼的原理,設(shè)計了一款符合第一代視覺假體功能的仿生眼

2009-09-19 09:35:15

基礎(chǔ)模擬電路實例講解.pdf

2014-08-20 11:25:08

【技術(shù)綜述】為了壓榨CNN模型,這幾年大家都干了什么

2019-05-29 14:49:27

很多人對于卷積神經(jīng)網(wǎng)絡(luò)(CNN)并不了解,卷積神經(jīng)網(wǎng)絡(luò)是一種前饋神經(jīng)網(wǎng)絡(luò),它包括卷積計算并具有很深的結(jié)構(gòu),卷積神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)的代表性算法之一。那么如何利用PyTorch API構(gòu)建CNN

2020-07-16 18:13:11

MIMRTX1064(SDK2.13.0)的KWS demo中放置了ds_cnn_s.tflite文件,提供demo中使用的模型示例。在 read.me 中,聲明我可以找到腳本,但是,該文檔中的腳本

2023-04-19 06:11:51

學(xué)習(xí)、卷積神經(jīng)網(wǎng)絡(luò)(CNN)和循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)等技術(shù)。這些技術(shù)能夠在本地設(shè)備上實現(xiàn)高效運算,使得離線語音識別成為可能。

1.深度學(xué)習(xí)

深度學(xué)習(xí)在語音識別領(lǐng)域具有廣泛的應(yīng)用。其中,循環(huán)

2023-11-07 18:01:32

轉(zhuǎn)stemwin教程本期教程主要是通過三個官方的抗鋸齒實例跟大家講解下抗鋸齒的使用。 27. 1例子一:AA_HiResAntialiasing 27. 2 例子二:AA_HiResPixels

2016-10-14 12:52:25

設(shè)計實例講解單片機C語言高階編程書籍資料分享

2018-12-29 14:32:15

戰(zhàn)艦板的最后綜合實例很強大,老板,有源程序講解嗎?最后的uCos實例程序只給出來示看,沒有像前面的裸機程序一樣先講原理,再講代碼。給我們講一下ucos那些應(yīng)用程序像游戲呀、播放器呀那些是怎么做

2019-08-12 04:35:52

本文介紹了用于渦輪槳距角控制的永磁同步發(fā)電機(PMSG)和高性能在線訓(xùn)練遞歸神經(jīng)網(wǎng)絡(luò)(RNN)的混合模糊滑模損失最小化控制的設(shè)計。反向傳播學(xué)習(xí)算法用于調(diào)節(jié)RNN控制器。PMSG速度使用低于額定速度

2021-07-12 06:46:57

遞歸神經(jīng)網(wǎng)絡(luò)(RNN)RNN是最強大的模型之一,它使我們能夠開發(fā)如分類、序列數(shù)據(jù)標(biāo)注、生成文本序列(例如預(yù)測下一輸入詞的SwiftKey keyboard應(yīng)用程序),以及將一個序列轉(zhuǎn)換為另一個序列

2022-07-20 09:27:59

本文主要針對的是三菱FX系列PLC遠(yuǎn)程維護實例講解。

2009-04-09 16:34:50 132

132 創(chuàng)維液晶電視各種機芯維修實例講解手冊。

2015-12-03 17:54:04 51

51 基于KSDK的KDS PE工程實例新建至運行講解

2015-12-15 13:50:26 0

0 LCD操作,及其菜單編寫的基礎(chǔ)知識,并有實例講解

2016-01-11 16:48:14 6

6 2G-4G通信技術(shù)的講解,對比通信發(fā)展的過程與原理

2016-03-10 10:42:35 35

35 PIC單片機之I2C(從模式)實例講解

2017-01-24 17:21:04 30

30 循環(huán)神經(jīng)網(wǎng)絡(luò)(RNNs)具有保留記憶和學(xué)習(xí)數(shù)據(jù)序列的能力。由于RNN的循環(huán)性質(zhì),難以將其所有計算在傳統(tǒng)硬件上實現(xiàn)并行化。當(dāng)前CPU不具有大規(guī)模并行性,而由于RNN模型的順序組件,GPU只能提供有

2017-11-15 13:30:06 1974

1974

將神經(jīng)網(wǎng)絡(luò)模型訓(xùn)練好之后,在輸入層給定一個x,通過網(wǎng)絡(luò)之后就能夠在輸出層得到特定的y,那么既然有了這么強大的模型,為什么還需要RNN(循環(huán)神經(jīng)網(wǎng)絡(luò))呢?

2018-05-05 10:51:00 5037

5037

本文的主要內(nèi)容介紹的是TI的DDR3的配置流程使用實例講解

2018-04-24 10:16:22 9

9 2014 年 RNN/LSTM 起死回生。自此,RNN/LSTM 及其變種逐漸被廣大用戶接受和認(rèn)可。起初,LSTM 和 RNN 只是一種解決序列學(xué)習(xí)和序列翻譯問題的方法(seq2seq),隨后被用于語音識別并有很好的效果。

2018-04-25 09:43:56 20289

20289 懂原理俠:抱歉我起了個這么蠢的名字。但是,進(jìn)階到這一步,已經(jīng)可以算是入門了,可以找一份能養(yǎng)活自己的工作了。CNN,RNN,LSTM信手拈來,原理講的溜的飛起,對于不同的參數(shù)對模型的影響也是說的有理有據(jù),然而,如果你要問,你可以手動寫一個CNN嗎?不用調(diào)包,實現(xiàn)一個最基礎(chǔ)的網(wǎng)絡(luò)結(jié)構(gòu)即可,又gg了。

2018-05-08 16:24:11 6806

6806

基于成本和效率考慮的PFC設(shè)計(五)—PFC設(shè)計實例講解

2018-08-21 00:38:00 5431

5431 運用遷移學(xué)習(xí),CNN特征,語句特征應(yīng)用已有模型2. 最終的輸出模型是LSTM,訓(xùn)練過程的參數(shù)設(shè)定:梯度上限(gradient clipping), 學(xué)習(xí)率調(diào)整(adaptivelearning)3. 訓(xùn)練時間很長。

2018-09-13 15:22:42 52086

52086 卷積神經(jīng)網(wǎng)絡(luò)( CNN)和循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)在自然語言處理,上得到廣泛應(yīng)用,但由于自然語言在結(jié)構(gòu)上存在著前后依賴關(guān)系,僅依靠卷積神經(jīng)網(wǎng)絡(luò)實現(xiàn)文本分類將忽略詞的上下文含義,且傳統(tǒng)的循環(huán)神經(jīng)網(wǎng)絡(luò)存在梯度消失或梯度爆炸問題,限制了文本分類的準(zhǔn)確率。

2018-11-22 16:01:45 9

9 很多“長相相似”的專有名詞,比如我們今天要說的“三胞胎”DNN(深度神經(jīng)網(wǎng)絡(luò))、CNN(卷積神經(jīng)網(wǎng)絡(luò))、RNN(遞歸神經(jīng)網(wǎng)絡(luò)),就讓許許多多的AI初學(xué)者們傻傻分不清楚。而今天,就讓我們一起擦亮眼睛,好好

2019-03-13 14:32:34 3080

3080 Mask R-CNN是承繼于Faster R-CNN,Mask R-CNN只是在Faster R-CNN上面增加了一個Mask Prediction Branch(Mask預(yù)測分支),并且在ROI

2019-04-04 16:32:07 12856

12856 本文檔的主要內(nèi)容詳細(xì)介紹的是使用單片機實現(xiàn)Modbus通訊協(xié)議的實例程序和講解分析。

2019-09-06 17:26:00 45

45 本文檔的主要內(nèi)容詳細(xì)介紹的是C51語言的18個基礎(chǔ)知識點實例講解包括了:C51控制語句和C51數(shù)組和指針

2019-06-04 17:52:00 12

12 采樣的主動學(xué)習(xí)算法(DBC-AL)選擇對分類模型貢獻(xiàn)率較高的樣本進(jìn)行標(biāo)注,以低標(biāo)注代價獲得高質(zhì)量模型訓(xùn)練集;然后,結(jié)合SVD算法建立SVD-CNN彈幕文本分類模型,使用奇異值分解的方法代替?zhèn)鹘y(tǒng)CNN模型池化層進(jìn)行特征提取和降維,并在此基礎(chǔ)上完成彈幕文

2019-05-06 11:42:47 6

6 本文檔的主要內(nèi)容詳細(xì)介紹的是電路設(shè)計教程之電路原理圖的設(shè)計步驟與實例講解。

2019-09-20 16:45:37 215

215 本文檔的主要內(nèi)容詳細(xì)介紹的是FreeRTOS plus的用法實例講解。

2019-11-07 17:31:45 19

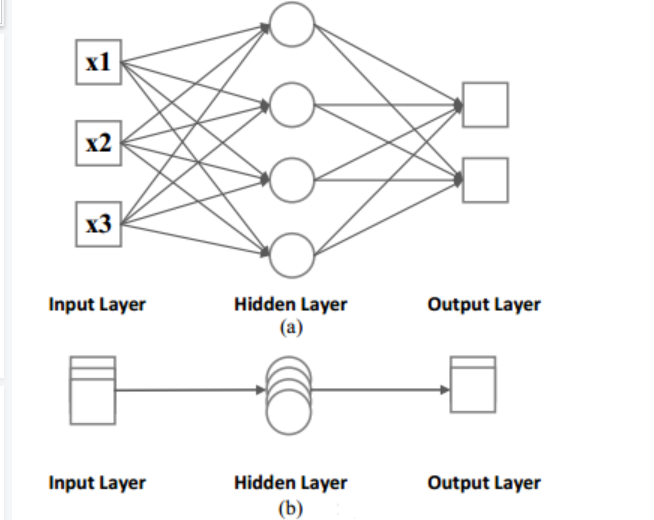

19 相同點:

傳統(tǒng)神經(jīng)網(wǎng)絡(luò)的擴展。

前向計算產(chǎn)生結(jié)果,反向計算模型更新。

每層神經(jīng)網(wǎng)絡(luò)橫向可以多個神經(jīng)元共存,縱向可以有多層神經(jīng)網(wǎng)絡(luò)連接。

2020-02-08 19:07:56 7209

7209 遞歸神經(jīng)網(wǎng)絡(luò)(RNN)被提出用來處理80年代的輸入序列時間信息。1993年,神經(jīng)歷史壓縮器系統(tǒng)解決了“非常深度學(xué)習(xí)”任務(wù),該任務(wù)需要及時展開RNN中的1000多個后續(xù)層。

2020-03-22 10:23:00 6492

6492

單片機的實例總結(jié)合集包括了:1. 閃爍燈, 00 -99 計數(shù)器,00 -59 秒計時器,按鍵識別方法等等

2020-08-13 17:43:27 23

23 使用的是 CNN 而不是 RNN(常用來處理時序數(shù)據(jù)),是因為每次的重復(fù)運動練習(xí)(如舉啞鈴)是花費的時間是非常短的少于 4 秒,訓(xùn)練時不需要長時間的記憶。

2020-12-25 03:39:00 15

15 本文檔的主要內(nèi)容詳細(xì)介紹的是python的經(jīng)典實例相關(guān)講解。

2021-03-02 15:33:47 9

9 本文檔的主要內(nèi)容詳細(xì)介紹的是ProE機構(gòu)仿真基礎(chǔ)教程實例講解實踐免費下載。

2021-03-21 11:04:32 10

10 遠(yuǎn)控木馬作為一種高級形態(tài)的惡意代碼,不僅能收集用戶敏感信息,而且可以通過命令控制引發(fā)大規(guī)模的攻擊。為高效準(zhǔn)確地識別遠(yuǎn)控木馬,通過結(jié)合靜態(tài)分析和動態(tài)行為分析方法提取文件特征,利用深度學(xué)習(xí)對樣本特征

2021-03-30 09:21:44 15

15 PLC實例講解之加法指令寫流水燈資源下載

2021-04-01 16:49:50 10

10 PLC實例講解之計數(shù)器值以二進(jìn)制輸出資源下載

2021-04-01 16:59:27 22

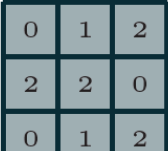

22 概述 深度學(xué)習(xí)中CNN網(wǎng)絡(luò)是核心,對CNN網(wǎng)絡(luò)來說卷積層與池化層的計算至關(guān)重要,不同的步長、填充方式、卷積核大小、

2021-04-06 15:13:25 2453

2453

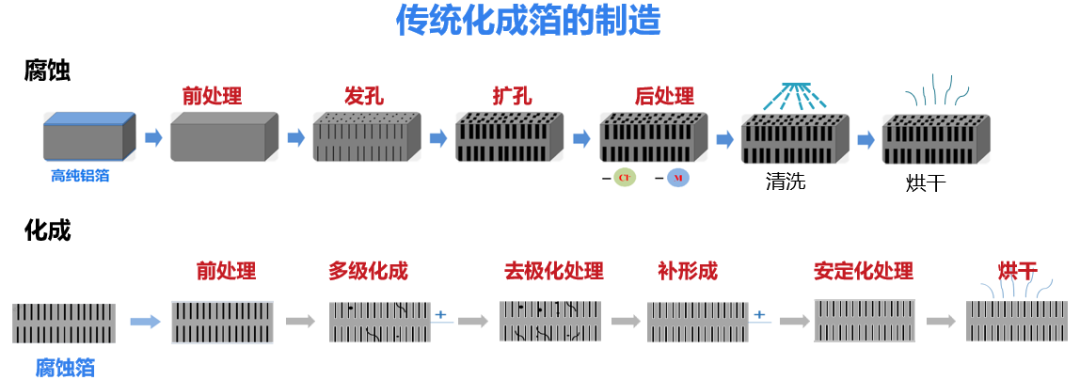

電子發(fā)燒友網(wǎng)為你提供實例講解電容資料下載的電子資料下載,更有其他相關(guān)的電路圖、源代碼、課件教程、中文資料、英文資料、參考設(shè)計、用戶指南、解決方案等資料,希望可以幫助到廣大的電子工程師們。

2021-04-28 08:53:57 10

10 神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)的載體,而神經(jīng)網(wǎng)絡(luò)模型中,最經(jīng)典非RNN模型所屬,盡管它不完美,但它具有學(xué)習(xí)歷史信息的能力。后面不管是encode-decode 框架,還是注意力模型,以及自注意力模型,以及更加

2021-05-10 10:22:45 10993

10993

神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)的載體,而神經(jīng)網(wǎng)絡(luò)模型中,最經(jīng)典非RNN模型所屬,盡管它不完美,但它具有學(xué)習(xí)歷史信息的能力。后面不管是encode-decode 框架,還是注意力模型,以及自注意力模型,以及更加

2021-05-13 10:47:46 22436

22436

基于CNN和LSTM的蛋白質(zhì)亞細(xì)胞定位研究對比

2021-06-11 14:16:11 15

15 基于RNN的GIS故障預(yù)測算法及系統(tǒng)設(shè)計

2021-07-01 15:38:37 30

30 實例制作一個51單片機連接PS2鍵盤講解(單片機原理及應(yīng)用技術(shù))-該文檔為實例制作一個51單片機連接PS2鍵盤講解資料,講解的還不錯,感興趣的可以下載看看…………………………

2021-07-22 12:11:41 35

35 導(dǎo)讀本文主要介紹OpenCV在低對比度缺陷檢測中的應(yīng)用實例。 實例一(LCD屏幕臟污檢測) 參考實例來源: https://stackoverflow.com/questions/27281884

2021-08-26 15:52:40 4215

4215

Oracle數(shù)據(jù)庫鏈接建立技巧與實例講解(電源技術(shù)圖解大全)-該文檔為Oracle數(shù)據(jù)庫鏈接建立技巧與實例講解文檔,是一份不錯的參考資料,感興趣的可以下載看看,,,,,,,,,,,,,,,,,

2021-09-22 13:43:43 7

7 OLED顯示模塊(原理講解、STM32實例操作)

2021-11-30 14:51:06 67

67 循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,RNN)是一種用于處理序列數(shù)據(jù)的神經(jīng)網(wǎng)絡(luò)。相比一般的神經(jīng)網(wǎng)絡(luò)來說,他能夠處理序列變化的數(shù)據(jù)。比如某個單詞的意思會因為上文提到的內(nèi)容不同而有不同的含義,RNN就能夠很好地解決這類問題。

2022-03-15 10:44:42 1544

1544 經(jīng)過了前面的開胃菜,項目正式開始。一步步講解這個模型怎么玩起來的。從C 到 matlab 到 FPGA ,三個平臺聯(lián)合起來完成這個 由 RTL 實現(xiàn) CNN 的項目。

2022-03-15 17:13:24 2069

2069 我們的方法稱為 Mask R-CNN,擴展了 Faster RCNN ,方法是在每個感興趣區(qū)域 (RoI) 上添加一個用于預(yù)測分割掩碼的分支,與用于分類和邊界框回歸的現(xiàn)有分支并行(圖 1)。掩碼分支

2022-04-13 10:40:50 2132

2132 應(yīng)用卷積濾波器生成的輸入圖像的表示。 理解卷積層 1、卷積操作 卷積的概念是CNN操作的核心。卷積是一種數(shù)學(xué)運算,它把兩個函數(shù)結(jié)合起來產(chǎn)生第三個函數(shù)。在cnn的上下文中,這兩個函數(shù)是輸入圖像和濾波器,而得到的結(jié)果就是特征圖。 2、卷積的層 卷積層包括在輸入圖像上滑動濾波器

2023-04-12 10:25:05 517

517 電子發(fā)燒友網(wǎng)站提供《PyTorch教程14.8之基于區(qū)域的CNN(R-CNN).pdf》資料免費下載

2023-06-05 11:09:06 0

0 14.8。基于區(qū)域的 CNN (R-CNN)? Colab [火炬]在 Colab 中打開筆記本 Colab [mxnet] Open the notebook in Colab

2023-06-05 15:44:37 339

339

生成的輸入圖像的表示。理解卷積層1、卷積操作卷積的概念是CNN操作的核心。卷積是一種數(shù)學(xué)運算,它把兩個函數(shù)結(jié)合起來產(chǎn)生第三個函數(shù)。在cnn的上下文中,這兩個函數(shù)是輸

2023-04-19 10:33:09 430

430

以解決圖像識別問題為主要目標(biāo),但它的應(yīng)用已經(jīng)滲透到了各種領(lǐng)域,從自然語言處理、語音識別、到物體標(biāo)記以及醫(yī)療影像分析等。在此,本文將對CNN的原理、結(jié)構(gòu)以及基礎(chǔ)代碼進(jìn)行講解。 1. CNN的原理 CNN是一種能夠自動提取特征的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),它的每個層次在進(jìn)行特征提取時會自動適應(yīng)輸入數(shù)據(jù)

2023-08-21 17:16:13 1616

1616 Vitis AI 遞歸神經(jīng)網(wǎng)絡(luò) (RNN) 工具是 Vitis? AI 開發(fā)環(huán)境的一個子模塊,專注于在 Xilinx? 硬件平臺(包括 Alveo? 加速器卡)上實現(xiàn) RNN。這些工具由優(yōu)化的 IP

2023-09-13 17:32:53 0

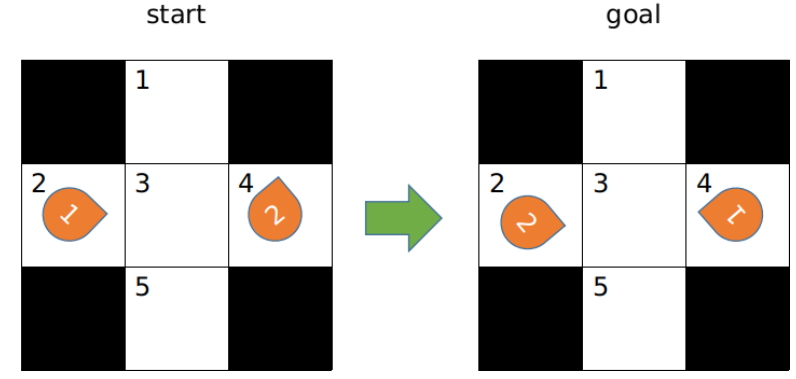

0 實例講解 以下將通過一個簡單的實例講解CBS的基本過程,實例如圖2所示。 圖2 初始和目標(biāo)狀態(tài) CBS的搜索過程如圖3所示。 圖3 CBS搜索過程 CBS開始時沒有沖突約束,每個機器人按照各自的路徑

2023-11-17 16:44:10 216

216

電解電容在SVG產(chǎn)品中應(yīng)用實例及計算實例講解

2023-11-23 09:04:45 408

408

,非常適合RNN。與其他神經(jīng)網(wǎng)絡(luò)不同,RNN具有內(nèi)部存儲器,允許它們保留來自先前輸入的信息,并根據(jù)整個序列的上下文做出預(yù)測或決策。在本文中,我們將探討RNN的架構(gòu)、它

2023-12-15 08:28:11 217

217

電子發(fā)燒友App

電子發(fā)燒友App

評論