簡介

本文主要基于ARM嵌入式模塊系統展示在嵌入式Linux中使用攝像頭示例,所采用的模塊為Toradex VF61,是一款性價比極高但不包含硬件視頻編解碼加速的模塊,核心處理器為NXP/Freescale Vybrid,Cortex-A5和M4異構雙核架構。

1)。 目前越來越多的嵌入式系統采用攝像頭應用,其中主要有下面幾種方式

遠程監控:如閉路電視系統,操作人員通過攝像頭遠程監控某個特定區域,小到一個小區,達到市政公共場所,都可能有這樣的應用。

監控視頻錄制:另外一些監控系統不一定有操作人員一直監控,則會通過錄制監控視頻的方式在需要的時候調出相關視頻進行查閱。

嵌入式視覺系統:嵌入式視覺系統會對視頻圖片進行處理并提取更多復雜信息,如雷達和城市智能交通應用。

視頻傳感器:如臨床診斷設備會對采集的視頻圖像進行分析來診斷,智能購物設備通過采集視頻圖像分析使用者特征來定向推廣銷售等等。

2)。 環境配置

。/ ARM嵌入式模塊系統:Toradex VF61 以及 Colibri Eva board,詳細的配置使用手冊請見這里

。/ 攝像頭

D-Link DCS-930L IP 攝像頭

。/ 軟件:

Toradex 標準Embedded Linux發布版本V2.4(已預裝),詳細介紹請見這里

GStreamer框架,廣泛應用于各種多媒體應用開發,可以實現如視頻編輯,媒體流以及媒體播放等多媒體應用,同時配合各種插件(包含輸入輸出單元,過濾器,編解碼器等),GStreamer可以支持多種不同媒體庫如MP3,FFmpeg等。所需安裝包如下:

$ opkg update

$ opkg install gst-plugins-base-meta gst-plugins-good-meta gst-ffmpeg

查看目前已經安裝的插件和單元

$ gst-inspect

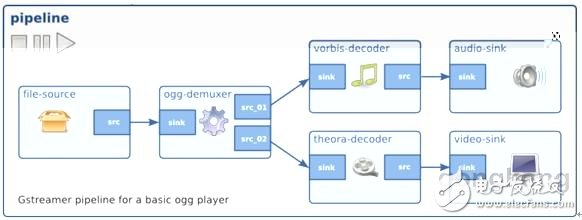

GStreamer元件(element)和管道(Pipeline)簡介

根據《GStreamer Application Development Manual》章節3所述,元件是GStreamer最重要的對象類,它可以被讀取,解碼以及顯示。管道為多個元件互聯一起形成的元件鏈,可以用于一些特定的任務,如視頻播放或捕捉。默認情況下GStreamer 包含大量的元件集以便于開發各種各樣的多媒體應用。本文中我們會使用一些管道去展示一些元件的使用。

下圖是一個基本的用于Ogg播放的管道示例,使用一個分流器和兩個分支,一個處理音頻,另一個處理視頻。可以看到一些元件只有src 襯墊 (pad),另一些只有sink襯墊或者兩者都有。

在連接一個管道前,我們同樣需要通過 “gst-inspect” 命令查看所需的插件是否兼容,如下示例查看ffmpegcolorspace 插件。

$ gst-inspect ffmpegcolorspace

基本信息描述

-----------------------------------------------------------

Factory Details:

Long name: FFMPEG Colorspace converter

Class: Filter/Converter/Video

Description: Converts video from one colorspace to another

Author(s): GStreamer maintainers gstreamer-devel@lists.sourceforge.net

-----------------------------------------------------------

Src 和 sink 功能描述

-----------------------------------------------------------

SRC template: ‘src’

Availability: Always

Capabilities:

video/x-raw-yuv

video/x-raw-rgb

video/x-raw-gray

SINK template: ‘sink’

Availability: Always

Capabilities:

video/x-raw-yuv

video/x-raw-rgb

video/x-raw-gray

-----------------------------------------------------------

另如v4l2src元件,它只含有src襯墊功能,所以可以source一個視頻流到另一個元件;再有ximagesink元件,它含有rgb格式sink襯墊功能。關于這部分更多詳細介紹請關注這里。

顯示一個視頻測試圖案

使用下面管道來顯示一個視頻測試圖案

$ gst-launch videotestsrc ! autovideosink

其中autovideosink元件自動檢測視頻輸出,videotestsrc元件可利用“pattern”屬性生成多種格式的測試視頻,如下面為雪花圖案測試視頻

$ gst-launch videotestsrc pattern=snow ! autovideosink

USB 攝像頭

1)。 從USB攝像頭顯示視頻

攝像頭接入系統后,會在/dev目錄下面顯示對應的設備videox,x可以是0,1,2等等,取決于接入的攝像頭數量。

請使用下面管道來全屏顯示對應的攝像頭視頻

$ gst-launch v4l2src device=/dev/videox ! ffmpegcolorspace ! ximagesink

// Video4Linux2插件是一個用于捕捉和播放視頻的API和驅動框架,它支持多種USB攝像頭以及其他設備;元件v4l2src屬于 Video4Linux2插件,用于讀取Video4Linux2設備的視頻幀,這里即為USB攝像頭。Ffmpegcolorspace元件是一個用于轉換多種顏色格式的過濾器,攝像頭設備視頻數據通常使用YUV顏色格式,而顯示器通常使用RGB顏色格式。Ximagesink元件是一個X桌面標準的 videosink元件。

在當前情況下,我們可以通過“top”命令看到目前CPU占有率為77.9%

另外,也可以通過設置一些參數來設定顯示效果如尺寸,幀率等,如下面示例限定顯示尺寸為320x240,此時CPU占有率下降為28.2%

$ gst-launch v4l2src device=/dev/videox ! ‘video/x-raw-yuv,width=320,height=240,framerate=30/1’ ! ffmpegcolorspace ! ximagesink

2)。 同時顯示兩路USB攝像頭

使用下面通道來同時顯示兩路攝像頭,這里我們使用Logitech HD 720P攝像頭和另外一種普通的MJPEG攝像頭,在這種情況下CPU占用率為64.8%。

$ gst-launch v4l2src device=/dev/videox ! ‘video/x-raw-yuv,width=320,height=240,framerate=30/1’ ! ffmpegcolorspace ! ximagesink v4l2src device=/dev/video1 ‘video/x-raw-yuv,width=320,height=240,framerate=30/1’ ! ffmpegcolorspace ! ximagesink

3)。 錄制USB攝像頭視頻

使用下面管道來錄制MP4格式攝像頭視頻

$ gst-launch --eos-on-shutdown v4l2src device=/dev/videox ! ffenc_mjpeg ! ffmux_mp4 ! filesink location=video.mp4

//--eos- on-shutdown參數用于正確關閉文件。ffenc_mjpeg元件是MJPEG格式編碼器。ffmux_mp4是MP4格式合成器。 filesink元件聲明來自v4l2的源數據會被存儲為文件而不是顯示于ximagesink元件,另外也可以任意指定文件存儲位置。

在這種情況下錄制攝像頭視頻CPU占有率8%左右。

4)。 視頻播放

使用下面管道來播放上面錄制的視頻

$ gst-launch filesrc location=video.mp4 ! qtdemux name=demux demux.video_00 ! queue ! ffdec_mjpeg ! ffmpegcolorspace ! ximagesink

//filesrc元件聲明視頻源數據來自于一個文件而不是視頻設備如攝像頭。ffdec_mjpeg元件為MJPEG格式解碼器。

在這種情況下,由于所錄制視頻為攝像頭最高分辨率,因此CPU占有率為95%左右。

5)。 通過HTTP播放視頻

使用下面管道播放特定URL視頻

$ gst-launch souphttpsrc location=http://upload.wikimedia.org/wikipedia/commons/4/4b/MS_Diana_genom_Bergs_slussar_16_maj_2014.webm ! matroskademux name=demux demux.video_00 ! queue ! ffdec_vp8 ! ffmpegcolorspace ! ximagesink

// souphttpsrc元件用于通過HTTP接收網絡數據。和播放本地視頻不同,一個存放視頻文件的網絡地址制定給了location參數。ffdec_vp8元件是webm格式解碼器。

在這種情況下,CPU占用率為40%左右。

6)。 通過TCP串流攝像頭視頻

這里配置串流VF61攝像頭視頻到另外一臺運行Ubuntu Linux主機

VF61 IP = 192.168.0.8

Ubuntu IP = 192.168.0.7

在VF61上面運行下面管道

$ gst-launch v4l2src device=/dev/video1 ! video/x-raw-yuv,width=320,height=240 ! ffmpegcolorspace ! ffenc_mjpeg ! tcpserversink host=192.168.0.7 port=5000

然后在Ubuntu上面運行下面管道來查看視頻流

$ gst-launch tcpclientsrc host=192.168.0.8 port=5000 ! jpegdec ! autovideosink

這里使用Logitech HD 720P攝像頭,CPU占有率為65%左右。

在VF61上面使用D-Link IP 攝像頭

1)。 顯示攝像頭視頻

這里使用D-Link DSC-930L 攝像頭,并設置視頻流為average quality JPEG格式,320x240分辨率,幀率為15/1‘,IP = 192.168.0.200

使用下面管道來顯示攝像頭視頻

$ gst-launch -v souphttpsrc location=’http://192.168.0.200/video.cgi‘ is-live=true ! multipartdemux ! decodebin2 ! ffmpegcolorspace ! ximagesink

2)。 視頻錄制

使用下面管道來錄制視頻

$ gst-launch --eos-on-shutdown –v souphttpsrc location=’http://192.168.0.200/video.cgi‘ is-live=true ! multipartdemux ! decodebin2 ! ffmpegcolorspace ! ffenc_mjpeg ! ffmux_mp4 ! filesink location=stream.mp4

在這種情況下,CPU占有率為40% 左右。

3)。 通過TCP串流視頻到另一個IP地址

這里配置串流IP攝像頭視頻到VF61,然后再到另外一臺運行Ubuntu Linux主機

Ubuntu IP = 192.168.0.12

在VF61上面運行下面管道

$ gst-launch --eos-on-shutdown –v souphttpsrc location=’http://192.168.0.200/video.cgi‘ is-live=true ! multipartdemux ! decodebin2 ! ffmpegcolorspace ! ffenc_mjpeg ! Tcpserversink host=192.168.0.12 port 5000

然后在Ubuntu上面運行下面管道來查看視頻流

$ gst-launch tcpclientsrc host=192.168.0.8 port=5000 ! jpegdec ! autovideosink

在這種情況下,VF61 CPU占用率為95% 左右。

總結

本文著重展示了通過GStreamer 元件,管道在Embedded Linux設備上面應用USB或IP攝像頭,相關的更多管理使用示例還可以從網絡上面找到很多,可以結合本文一起來充分理解相關應用。

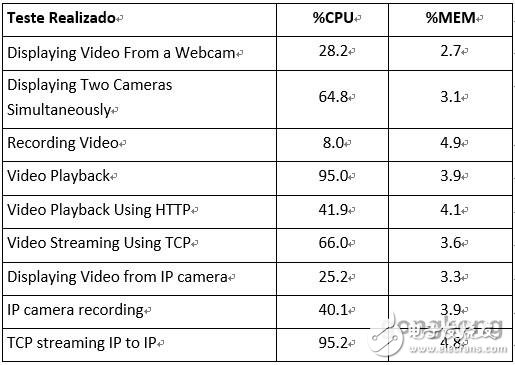

本文所做示例下VF61 CPU和MEM占用率比較請見下圖,可見NXP/Freescale Vybrid VF61 處理器盡管沒有獨立的硬件視頻處理單元也基本上可以勝任基本的攝像頭視頻應用,結合其非常有競爭力的成本,使其成為性價比非常高的產品。但是如果對視頻處理有更高的要求如嵌入式視覺系統,則建議考慮處理能力更強勁并含有獨立GPU的基于NXP/Freescale i.MX6處理器的產品,如Toradex Colibri/Apalis i.MX6 模塊。

電子發燒友App

電子發燒友App

評論