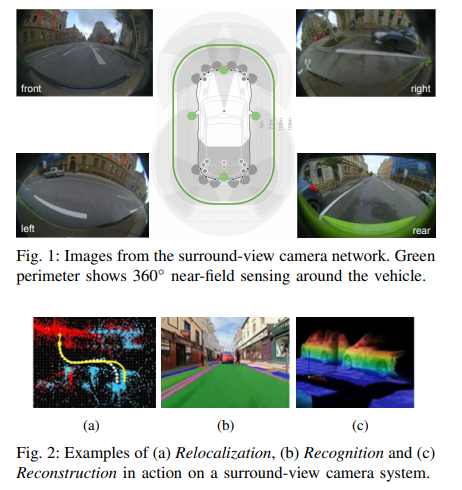

Camera是自動駕駛系統中的主要傳感器,它們提供高信息密度,最適合檢測為人類視覺而設置的道路基礎設施。全景相機系統通常包括四個魚眼攝像頭,190°+視野覆蓋車輛周圍的整個360°,聚焦于近場感知。它們是低速、高精度和近距離傳感應用的主要傳感器,如自動泊車、交通堵塞輔助和低速緊急制動。

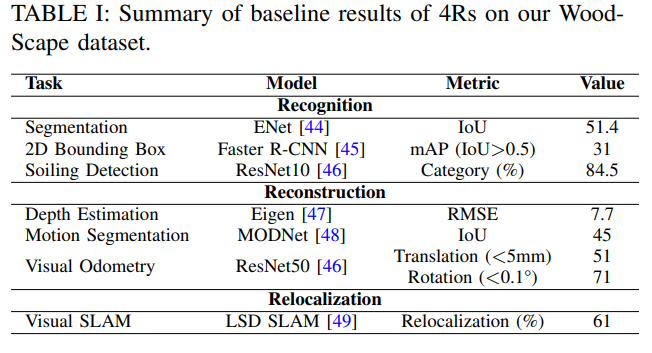

在這項工作中,論文對此類視覺系統進行了詳細的調查,并在可分解為四個模塊組件(即識別、重建、重新定位和重組)的架構背景下進行了調查,共同稱之為4R架構。論文討論了每個組件如何完成一個特定方面,并提供了一個位置論證(即它們可以協同作用),形成一個完整的低速自動化感知系統。

本文的工作部分受到了Malik等人在[5]中的工作的啟發。這項工作的作者提出,計算機視覺的核心問題是重建、識別和重組,他們稱之為計算機視覺的3R。在此,論文建議將計算機視覺的3R擴展并專門化為自動駕駛計算機視覺的4R:重建、識別、重組和重新定位。

重建意味著從視頻序列推斷場景幾何體,包括車輛在場景中的位置。這一點的重要性應該是顯而易見的,因為它對于場景繪制、障礙物避免、機動和車輛控制等問題至關重要。Malik等人將此擴展到幾何推斷之外,以包括反射和照明等特性。然而,這些附加屬性(至少目前)在自動駕駛計算機視覺環境中并不重要,因此論文將重建定義為更傳統意義上的三維幾何恢復。

識別是一個術語,用于將語義標簽附加到視頻圖像或場景的各個方面,識別中包括層次結構。例如,自行車手有一個空間層次結構,因為它可以分為自行車和騎手的子集,而車輛類別可以有汽車、卡車、自行車等分類子類別。只要對自動駕駛系統有用,這種情況就可以繼續下去。燈可以按類型(車燈、路燈、剎車燈等)、顏色(紅、黃、綠)以及它們對自動駕駛車輛的重要性(需要響應,可以忽略)進行分類,從而完成系統的高級推理。

重新定位是指車輛相對于其周圍環境的位置識別和度量定位。可以針對宿主車輛中預先記錄的軌跡進行,例如,經過訓練的停車場,也可以針對從基礎設施傳輸的地圖進行,例如HD Maps。它與SLAM中的環路閉合高度相關,盡管不只是考慮環路閉合問題,而是考慮根據一個或多個預定義地圖定位車輛的更廣泛問題。

重組是將計算機視覺前三個組成部分的信息組合成統一表示的方法。在本文中,使用這個術語來等同于“后期融合”,這是自動駕駛的重要步驟,因為車輛控制需要傳感器輸出的統一表示,這也允許在后期融合多個攝像頭的輸出。

近域感知系統介紹

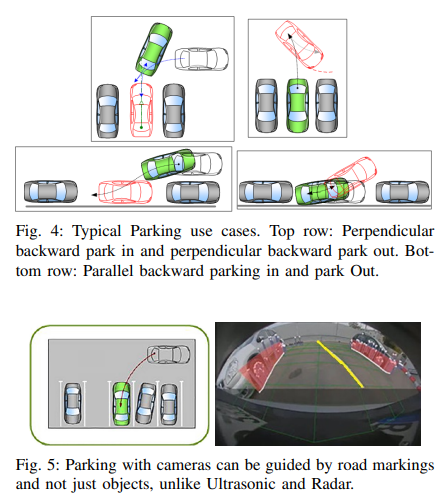

自動停車系統

自動停車系統是短距離傳感的主要用例之一,圖4描述了一些典型的停車用例。早期商業半自動泊車系統采用超聲波傳感器或radar,然而,最近,全景攝像頭正成為自動停車的主要傳感器之一。超聲波和毫米波雷達傳感器用于自動停車的一個主要限制是,只能根據存在的其他障礙物來識別停車位(圖5)。此外,環視相機系統允許在存在可視停車標記(如涂漆線標記)的情況下停車,同時也被視為實現代客泊車系統的關鍵技術。

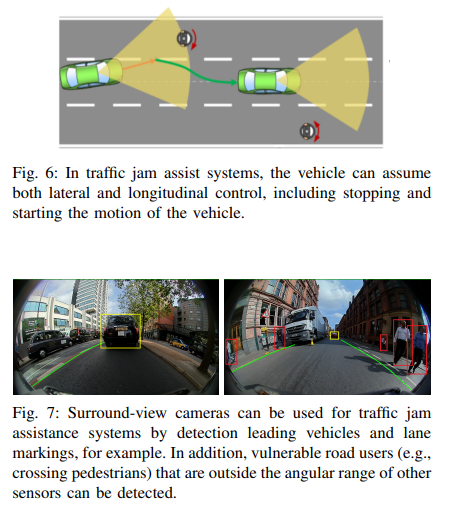

交通擁堵輔助系統

由于大部分事故都是低速追尾碰撞,交通擁堵情況被認為是短期內可以帶來好處的駕駛領域之一,盡管目前的系統可能缺乏魯棒性。在自動交通擁堵輔助系統中,車輛在交通擁堵情況下控制縱向和橫向位置(圖6)。此功能通常用于低速環境,最高速度為~60kph,但建議更低的最高速度為40kph。

雖然交通擁堵援助通常考慮高速公路場景,但已經對城市交通擁堵救援系統進行了調查。鑒于此應用的低速特性,全景攝像頭是理想的傳感器,尤其是在城市環境中,例如,行人可以嘗試從傳統前向攝像頭或radar系統視野之外的區域穿過。圖7顯示了使用全景相機進行交通堵塞輔助的示例。除了檢測其他道路使用者和標記外,深度估計和SLAM等特征對于推斷到物體的距離和控制車輛位置也很重要。

低速制動

一項研究表明,自動后向制動顯著降低了碰撞索賠率,配備后攝像頭、駐車輔助和自動制動的車輛報告碰撞減少了78%。全景相機系統對于低速制動非常有用,因為深度估計和目標檢測的組合是實現此功能的基礎。

魚眼相機

魚眼相機為自動駕駛應用提供了明顯的優勢,由于視野極廣,可以用最少的傳感器觀察車輛的整個周圍。通常,360°范圍只需要四個攝像頭覆蓋。然而,考慮到更為復雜的投影幾何體,這一優勢帶來了成本。過去的幾篇論文綜述了如何建模魚眼幾何形狀,例如[34]。論文不打算在此重復這一點,而是關注魚眼相機技術的使用給自動駕駛視覺帶來的問題。

在標準視場相機中,直線投影和透視的原理非常接近,具有常見的透視特性,即現實世界中的直線在圖像平面上投影為直線。平行的直線組被投影為一組直線,這些直線在圖像平面上的一個消失點上會聚。通過光學畸變的偏離很容易糾正。許多汽車數據集提供的圖像數據消除了光學畸變,具有簡單的校正方法,或幾乎不可察覺的光學畸變。

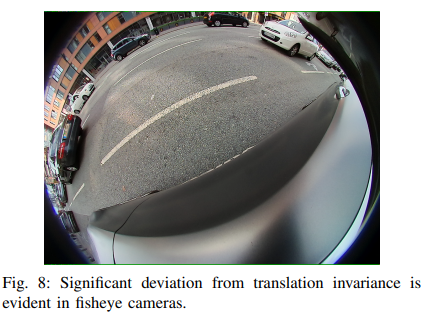

因此,大多數汽車視覺研究都隱含了直線投影的假設,魚眼透視圖與直線透視圖有很大不同。相機場景中的一條直線被投影為魚眼圖像平面上的一條曲線,平行線集被投影為一組在兩個消失點處會聚的曲線[38]。然而,失真并不是唯一的影響,圖8顯示了環視系統中安裝在鏡子上的典型攝像頭的圖像。在

魚眼相機中,物體圖像中的方向取決于它們在圖像中的位置。在本例中,左側的車輛旋轉了近90? 與右側車輛相比,這對目標檢測卷積方法中假定的平移不變性有影響。在標準相機中,平移不變性是可以接受的假設。然而,如圖8所示,魚眼圖像并非如此,在任何計算機視覺算法設計中,必須仔細考慮如何處理這一點。

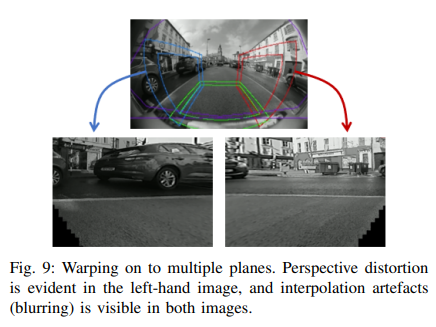

解決這些問題的自然方法是以某種方式糾正圖像。可以立即放棄對單個平面圖像的校正,因為首先,過多的視野必然會丟失,從而抵消魚眼圖像的優勢,其次,插值和透視偽影將很快占據校正輸出的主導地位。一種常見的方法是使用多平面校正,即魚眼圖像的不同部分被扭曲成不同的平面圖像。例如可以定義一個立方體,并將圖像扭曲到立方體的曲面上。圖9顯示了兩個此類表面上的翹曲。即使在這里,插值和透視效果也是可見的,必須處理曲面過渡的復雜性。

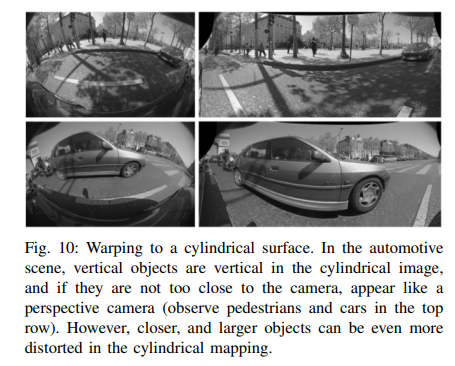

另一種校正方法是考慮圓柱表面的warping ,如圖10所示,在這種warping 中,圓柱軸線的配置使其垂直于地面。觀察結果表明,汽車場景中的大多數感興趣對象都位于近似水平的平面上,即路面上。因此希望保留水平視野,同時允許犧牲一些垂直視野,這帶來了有趣的幾何組合。

垂直是通過線性透視投影,因此場景中的垂直線在圖像中投影為垂直線。圖像中較遠或較小的對象在視覺上類似于透視相機,甚至有人建議,通過這種變形,可以使用標準透視相機訓練網絡,并在魚眼圖像上直接使用它們,而無需訓練[39]。然而,在水平方向上,新圖像中存在失真,大型近景物體表現出強烈的失真,有時甚至比原始魚眼圖像中的失真還要大。

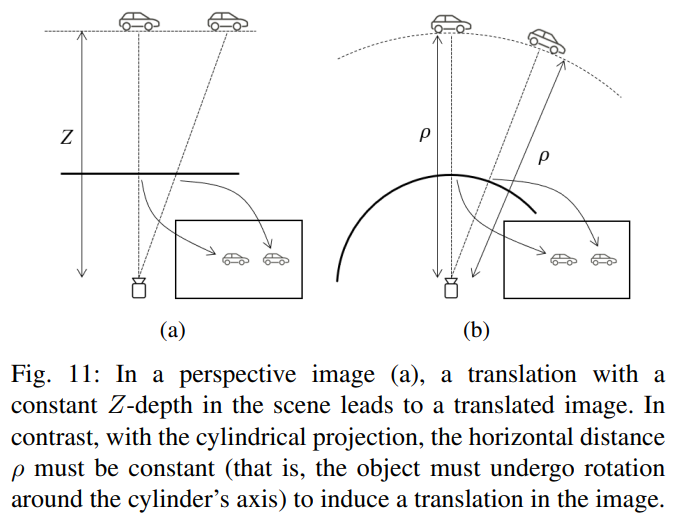

如圖11所示,當我們處理透視相機時,當物體與相機以恒定的Z距離移動時,就會產生平移,也就是說,在與圖像平面平行的平面上。然而,在圓柱形圖像中,水平面上的距離必須保持不變,才能進行圖像平移(對象必須繞圓柱體軸旋轉)。相比之下,在原始魚眼圖像中,不清楚什么對象運動會導致圖像平移。

WoodScape dataset

WoodScape全景數據集在兩個不同的地理位置采集的:美國和歐洲。雖然大多數數據是從轎車中獲得的,但運動型多用途車中有很大一部分數據可確保傳感器機械配置的強大組合,駕駛場景分為高速公路、城市駕駛和停車用例。數據集中為所有傳感器以及時間戳文件提供內部和外部校準,以實現數據同步,包括相關車輛的機械數據(例如,車輪周長、軸距)。為該數據集記錄的傳感器如下所示:

1)4x 1MPx RGB魚眼攝像頭(190? 水平視野)

2)1x激光雷達,20Hz旋轉(Velodyne HDL-64E)

3)1x全球導航衛星系統/慣性測量裝置(NovAtel Propak6和SPAN-IGM-A1)

4)1x帶SPS的GNSS定位(Garmin 18x)

5)來自車輛總線的里程表信號

系統架構注意事項

在自動駕駛計算機視覺設計中,尤其是pipelines設計中,一個重要的考慮因素是嵌入式系統的約束,其中多個攝像頭和多個計算機視覺算法必須并行運行。由于計算機視覺算法是計算密集型的,汽車SoC有許多專用硬件加速器用于圖像信號處理、鏡頭畸變校正、密集光流、立體視差等。在計算機視覺中,深度學習在各種識別任務中發揮著主導作用,并逐漸用于幾何任務,如深度和運動估計。

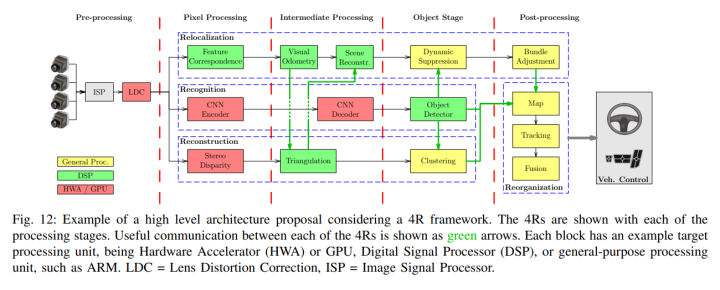

為了最大限度地提高處理硬件的性能,最好從處理階段的角度考慮嵌入式視覺,并在每個處理階段考慮共享處理,pipelines如圖12所示。

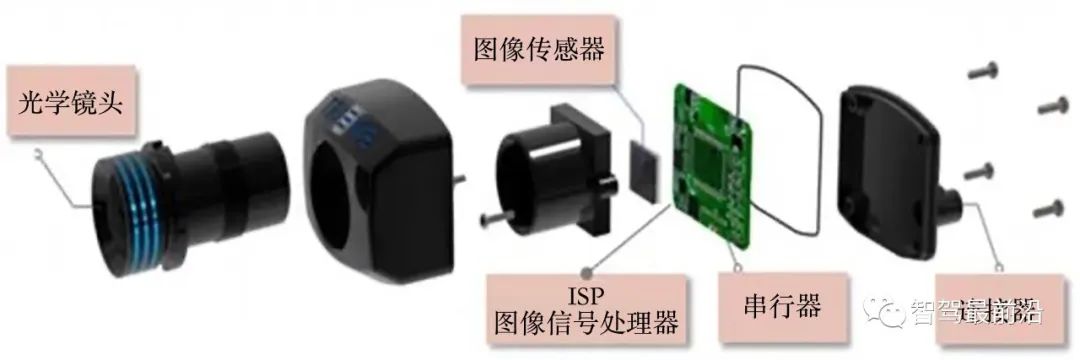

1) 預處理:pipelines的預處理階段可以看作是為計算機視覺準備數據的處理。這包括圖像信號處理(ISP)步驟,如白平衡、去噪、顏色校正和顏色空間轉換。關于ISP和ISP在汽車環境中用于計算機視覺任務的調整的詳細討論,請參考[52]。ISP通常由硬件引擎完成,例如作為主要SoC的一部分。很少在軟件中完成,因為需要完成大量像素級處理。正在提出一些方法來自動將ISP管道的超參數調整為優化計算機視覺算法的性能[52]、[53]。值得注意的是,目前正在提出簡化ISP視覺感知pipelines的方法,可以參考[54]。

2) 像素處理階段:像素處理可以被視為計算機視覺體系結構中直接接觸圖像的部分。在經典的計算機視覺中,這些算法包括邊緣檢測、特征檢測、描述符、形態運算、圖像配準、立體視差等。在神經網絡中,這等同于CNN編碼器的早期層。這一階段的處理主要由相對簡單的算法控制,這些算法必須每秒多次在數百萬像素上運行。也就是說,計算成本與這些算法每秒可能運行數百萬次的事實有關,而不是與算法本身的復雜性有關。這一階段的處理硬件通常由硬件加速器和GPU主導,盡管有些元素可能適合DSP。

3) 中間處理階段:顧名思義,中間處理階段是從像素到對象檢測階段之間的橋梁。在這里,要處理的數據量仍然很高,但大大低于像素處理階段。這可能包括通過視覺里程表估計車輛運動、視差圖的立體三角測量和場景的一般特征重建等步驟,在pipelines的這個階段包括CNN解碼器。這個階段的處理硬件通常是數字信號處理器。

4) 目標處理階段:對象處理階段是整合更高層次推理的階段,在這里可以聚類點云來創建目標,對對象進行分類,并且通過上述推理,可以應用算法來抑制移動目標的重縮放。此階段的處理主要由更復雜的算法控制,但操作的數據點較少。就硬件而言,通常適合在ARM等通用處理單元上運行這些處理器,盡管通常也會使用數字信號處理器。

5) 后處理:最后后處理階段,也可以稱為全局處理階段。在時間和空間上持久化數據。由于可以擁有長時間持久性和大空間地圖,因此前幾個階段的總體目標是最小化到達此階段的數據量,同時維護最終用于車輛控制的所有相關信息。在此階段,將包括 bundle adjustment、地圖構建、高級目標跟蹤和預測以及各種計算機視覺輸入的融合等步驟。由于處理的是系統中最高級別的推理,并且理想情況下處理的是最少的數據點,因此這里通常需要通用處理單元。

4R部件介紹

識別

識別任務通過模式識別識別場景的語義。在汽車領域,第一個成功的應用是行人檢測,它結合了手工設計的特征,如定向梯度直方圖和機器學習分類器,如支持向量機。最近CNN在目標識別應用程序中的各種計算機視覺任務中表現出顯著的性能飛躍,然而,這是有代價的。

首先,汽車場景非常多樣化,預計該系統將在不同國家以及不同的天氣和照明條件下工作,因此,主要挑戰之一是建立一個涵蓋不同方面的有效數據集。其次,CNN是計算密集型的,通常需要專用硬件加速器或GPU(與在通用計算核心上可行的經典機器學習方法相比)。因此,有效的設計技術對于任何設計都至關重要,最后,雖然對正常圖像的CNN進行了很好的研究,但如前所述,魚眼圖像的平移不變性假設被打破,這帶來了額外的挑戰。

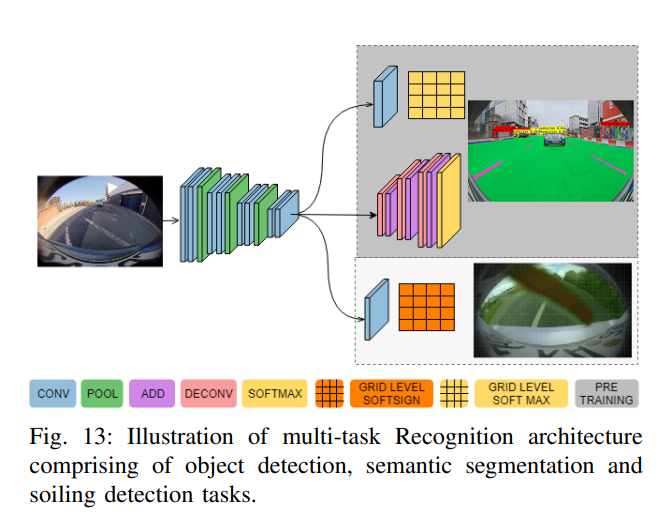

本文的識別pipelines中,提出了一種基于外觀模式識別對象的多任務深度學習網絡。它包括三個任務,即目標檢測(行人、車輛和騎車人)、語義分割(道路、路緣和道路標記)和透鏡污染檢測(不透明、半透明、透明、透明)。目標檢測和語義分割是標準任務,有關更多實現細節,請參閱FisheyeMultiNet論文。其中一個挑戰是在訓練階段平衡三個任務的權重,因為一個任務可能比其他任務收斂得更快。

魚眼攝像頭安裝在車輛上相對較低的位置(~地面以上0.5至1.2米),容易因其它車輛的道路噴霧或道路水而導致透鏡臟污。因此,檢測攝像頭上的污物至關重要 鏡頭提醒駕駛員清潔攝像頭或觸發清潔系統。SoilingNet中詳細討論了污垢檢測任務及其在清潔和算法降級中的使用,與此密切相關的一項任務是通過修補修復受污染區域的去污,但這些去污技術目前仍屬于可視化改進領域,而不是用于感知。

這是一個定義不清的問題,因為不可能預測遮擋的背后(盡管這可以通過利用時間信息來改善)。由于低功耗汽車ECU的CNN處理能力有限,本文使用多任務架構,其中大部分計算在編碼器中共享,如圖13所示。

重建

如前所述,重建意味著從視頻序列推斷場景幾何體。例如,這通常意味著估算場景的點云或體素化表示。靜態對象的重建,傳統上是使用諸如運動立體[56]或多視圖幾何中的三角剖分[73]等方法來完成的。在設計深度估計算法的背景下,[74]中簡要概述了人類如何推斷深度,并提供了有用的進一步參考。推斷深度有四種基本方法:單目視覺線索、運動視差、立體視覺和focus深度。

每種方法在計算機視覺方面都有其等效性,根據Marr&Poggio早期的理論工作[75],Grimson在20世紀80年代早期提供了立體視覺的計算實現[76],自那時以來立體視覺方面的工作一直在繼續。然而,立體視覺系統并沒有普遍在車輛上實現部署,因此,單目運動視差方法在汽車研究中仍然很流行。從計算上看,運動視差的深度傳統上是通過特征三角剖分完成的[78],但運動立體也被證明很流行[79]。

考慮魚眼圖像會增加重建任務的復雜性,多視圖幾何、立體視覺和深度估計中的大多數工作通常假設場景的平面透視圖像。傳統的立體方法進一步限制了圖像中的極線必須是水平的,然而,真實相機很少出現這種情況,因為存在鏡頭畸變,從而破壞了平面投影模型。它通常通過圖像的校準和校正來解決。然而,對于鏡頭畸變非常嚴重的魚眼圖像,在校正過程中保持寬視場是不可行的。領域已經提出了幾種魚眼立體深度估計方法,常見的方法是多平面校正,其中魚眼圖像映射到多個透視平面[82]。

然而,如前所述,任何平面校正(即使有多個平面)都會遭受嚴重的重采樣失真。要最小化此重采樣提出了對非平面圖像進行畸變、校正的方法,有些方法會扭曲不同的圖像幾何形狀,以保持極線筆直和水平的立體要求[83]。還有一些方法繞過了極線水平的要求,例如,最近將平面掃描法[84]、[85]應用于魚眼[86]。魚眼圖像重采樣的一個相關問題是,噪聲函數被重采樣過程扭曲,這對于任何試圖最小化重投影誤差的方法來說都是一個問題。Kukelova等人[73]使用標準視場相機的迭代技術解決了這一問題,該技術在避免失真的同時最小化了重投影誤差。然而,這種方法取決于特定的相機型號,因此不直接適用于魚眼相機。

重建的第二個方面是從視頻序列中提取運動對象(運動分割)。由于三角剖分假設被打破,動態對象的三維重建會導致全局意義上的位置不精確。重建運動物體幾何結構的典型嘗試需要圖像運動分割、相對基本矩陣估計和重建(具有比例/投影模糊性)。例如,使用Multi-X[88],前兩步基本上可以結合起來,因為分割可以基于基本矩陣估計進行。然而,對于嵌入式自動駕駛應用來說,這種方法要么計算成本太高,要么不夠健壯。此外,這種重建必須解決比例問題,可變形物體(如行人)可以針對身體的不同部位使用不同的基本矩陣。因此,動態目標檢測的任務通常只是簡單的運動分割。

Klappstein等人[89]描述了汽車背景下運動分割的幾何方法,Mariotti和Hughes[90]將這項工作擴展到了環視攝像頭外殼。然而,在這兩種情況下,幾何圖形都無法完全區分所有類型的移動特征。也就是說,有一類對象運動使關聯特征與靜態特征無法區分,因此,必須采取全局或半全局辦法。在傳統方法中,這是通過將具有與被歸類為運動中的光流矢量相似特性的光流向量分組來實現的。

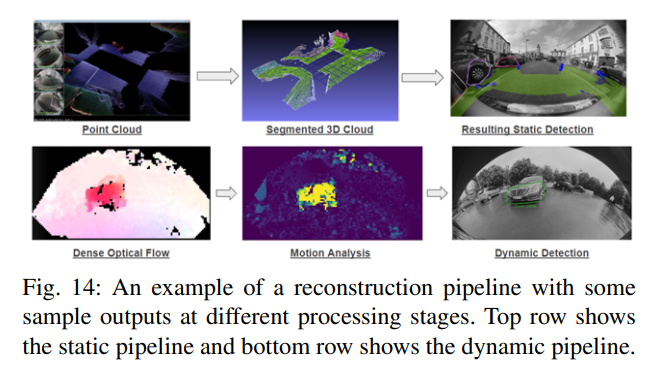

通常,運動分割的關鍵輸入是攝像機運動的知識。也就是說,必須知道相機的基本矩陣(或未校準情況下的基本矩陣)。[89]和[90]中假設了這一點,可以通過兩種方式實現。首先,可以直接使用車輛網絡上的信號,例如轉向角和車輪速度,來估計車輛的運動,從而估計攝像機的運動。或者,可以使用視覺方法直接從圖像序列估計運動。除了明確估計相機的運動外,另一種方法是在圖像中建模背景運動。有人建議使用背景運動的仿射模型,然而,這假設背景是遙遠或近似的平面,徑向變形不存在或可忽略不計。圖14顯示了不同重建階段的示例,包括密集運動立體、3D點云和靜態障礙物集群,以及基于密集光流的運動分割。雖然魚眼圖像的使用肯定會影響設計決策,從理論角度來看,這是一個尚未完全解決的問題。

重定位

視覺同步定位與映射(VSLAM)是機器人技術和自動駕駛領域的一個研究熱點。主要有三種方法,即(1)基于特征的方法,(2)直接SLAM方法和(3)CNN方法。基于特征的方法利用描述性圖像特征進行跟蹤和深度估計,從而生成稀疏的地圖。MonoSLAM、Parallel Tracking and Mapping(PTAM)和ORBSLAM是這類算法中的開創性算法。直接SLAM方法適用于整個圖像,而不是稀疏特征,以幫助構建密集的地圖。密集跟蹤和映射(DTAM)和大規模半密集SLAM(LSD-SLAM)是基于光度誤差最小化的常用直接方法。對于Visual SLAM問題,基于CNN的方法相對不太成熟,在[101]中對此進行了詳細討論。

mapping是自動駕駛的關鍵支柱之一,許多首次成功的自動駕駛演示(如谷歌)主要依賴于對預先繪制區域的定位。TomTom RoadDNA等高清地圖為大多數歐洲城市提供了高度密集的語義3D點云地圖和定位服務,典型的定位精度為10 cm。當有準確的定位時,高清地圖可以被視為主要線索,因為已經有了強大的先驗語義分割,并且可以通過在線分割算法進行細化。然而,這項服務很昂貴,因為它需要世界各地的定期維護和升級。

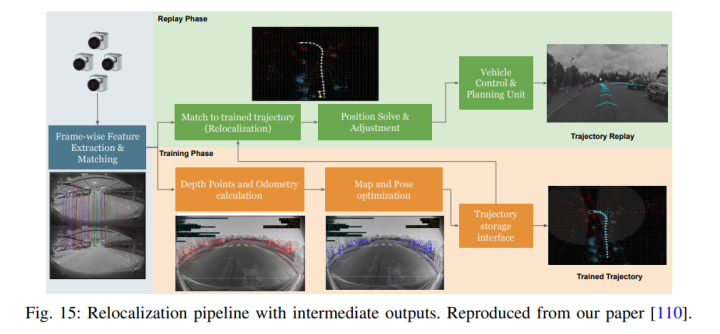

在自動駕駛視覺環境中,視覺SLAM(VSLAM)包括繪制車輛周圍環境的地圖,同時在地圖中估計車輛的當前姿態。VSLAM的關鍵任務之一是根據之前記錄的車輛定位軌跡。圖15顯示了一個經典的基于特征的重定位pipelines。在基于特征的SLAM中,第一步是提取顯著特征。圖像中的一個顯著特征可能是像素區域,其中強度以特定方式變化,例如邊緣、角落或斑點。

要估計世界上的地標,需要執行跟蹤,其中可以匹配相同特征的兩個或多個視圖。一旦車輛移動足夠遠,VSLAM會拍攝另一張圖像并提取特征。重建相應的特征,以獲得它們在真實世界中的坐標和姿態。然后,這些檢測到的、描述的和定位的地標被存儲在永久存儲器中,以描述車輛軌跡的相對位置。如果車輛返回相同的一般位置,實時特征檢測將與存儲的地標匹配,以恢復車輛相對于存儲軌跡的姿態。

重組

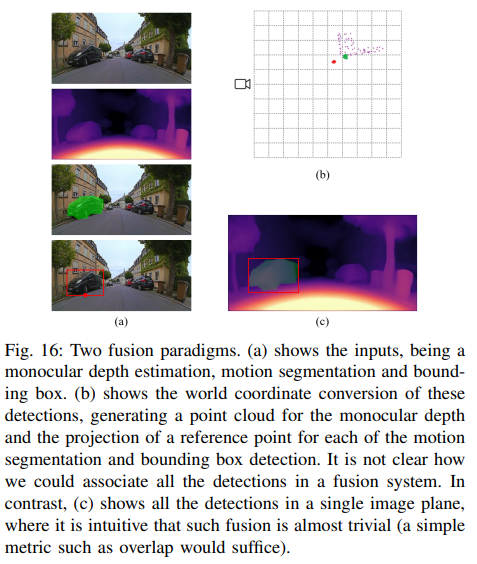

重組執行三個功能:1)融合識別和重建,2)通過相機在世界坐標系統中繪制目標地圖,3)時空物體跟蹤。雖然識別和重組模塊可以直接輸入到環境圖中,但我們認為在視覺層實現某些融合有明顯的優勢。先用一個例子來考慮這一點,如圖16所示,假設有一個具有單目深度估計、運動分割和車輛檢測的系統。融合這些信息的經典方法是將所有數據轉換為世界坐標系,然后關聯和融合數據,這種方法具有優勢。

一些汽車傳感器,如激光雷達,提供本地歐幾里德數據,基于這種歐幾里得地圖的融合系統使得包含這些附加傳感器變得容易。然而,在轉換為歐氏圖時,基于相機的檢測精度將始終受到影響。眾所周知,從圖像域到世界域的投影容易出錯,因為它們會受到校準不良、平地假設、檢測變化、像素密度和不完美相機模型的影響。如果目標在感興趣的點上沒有實際接觸地面,那么對于投影到世界坐標系的平地假設將存在重大錯誤。

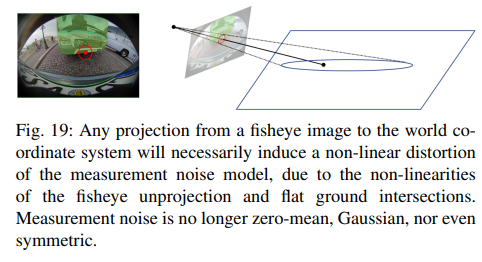

然而,在向世界投影之前,圖像域中的檢測不受此類錯誤的影響,因此,圖像域不同視覺算法的檢測關聯更為穩健,事實上,簡單的檢測重疊措施通常證明是穩健的。圖18顯示了基于CNN的車輛檢測和基于光流的運動分割的基于圖像的融合的實現,盡管運動分割存在顯著誤差,但融合成功地將檢測到的目標分為車輛和動態兩類。除此之外,還必須考慮失真校正如何影響測量噪聲,許多常用的融合和跟蹤算法,如卡爾曼濾波或粒子濾波,都是從平均零假設開始的(高斯噪聲)。

對于計算機視覺中的感興趣點測量(例如,圖像特征或邊界框足跡估計),通常認為這是一個有效的假設。然而,魚眼畸變和地平面投影過程扭曲了該噪聲模型(圖19)。此外,由于測量噪聲的失真取決于圖像中感興趣點的位置以及相機相對于路面的位置,因此解決這一問題變得更加復雜。

系統同步協同

本節將討論系統協同效應,主要研究重定位、重建和識別任務如何相互支持,并描述雙檢測源在安全關鍵應用中提供冗余的重要性。

識別和重建

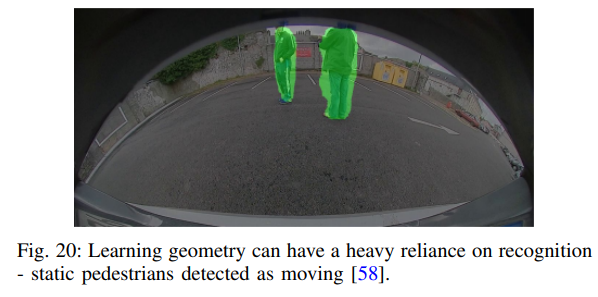

如前所述,深度估計在幾何感知應用中非常重要。除了前面已經討論過的內容外,目前最先進的是基于神經網絡的方法[115]、[116],可以通過重投影損失以自我監督的方式學習[117]。研究表明,單目深度估計的最新單幀嘗試通常會引發識別任務,然后使用圖像中的垂直位置等線索推斷深度,運動目標檢測似乎也嚴重依賴于識別。事實證明,[48]和[58]都對通常移動的靜態物體(例如行人,見圖20)顯示出誤報,但這并沒有降低這種嘗試的重要性。相反,它指出了識別和重建之間的一種非常深刻的聯系,從一種聯系中,可以推斷出另一種。

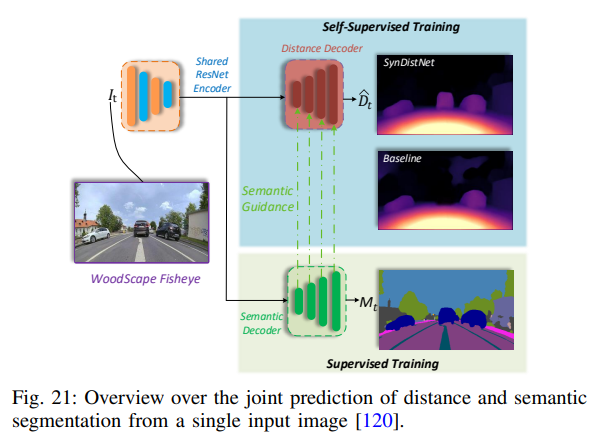

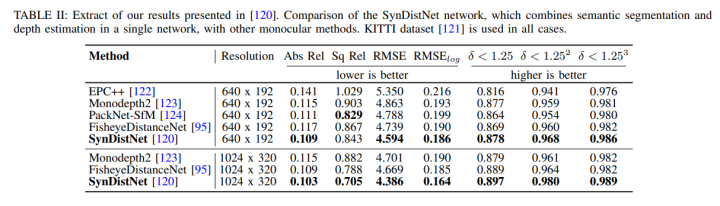

當行人檢測處于最先進水平時,在語義和實例分割之前,大多數汽車行人檢測研究人員都會考慮根據邊界框的高度或行人在圖像中的垂直位置編碼深度。[81]對此進行了詳細討論。然而,基于深度神經網絡的識別可以產生物體深度,這是有點直觀的,特別是當神經網絡的精度提高時。最近的工作證明了聯合學習語義標簽和深度的有效性[119]。例如,在[120]中顯示,對于單目深度估計,在每個距離解碼器層中添加語義指導(如圖21所示)可以提高對象邊緣的性能,甚至可以為動態目標返回合理的距離估計。

重定位和識別

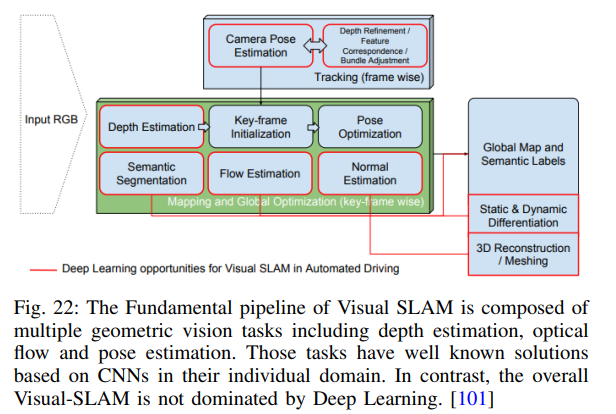

重定位是車輛識別先前學習的位置或路徑的過程,如前所述。然而,在現實的自動駕駛視覺中,很多事情都會干擾這一點。例如,場景可能會因可移動對象而改變,例如,停放的車輛可能會在場景學習時間和請求重定位時間之間移動。在這種情況下,語義分割方法可用于識別可能移動的對象(車輛、自行車、行人),并刪除與此類對象相關的映射特征。如[101]中詳細描述的,利用深度學習技術支持傳統的Visual SLAM pipelines還有更多的機會(圖22)。

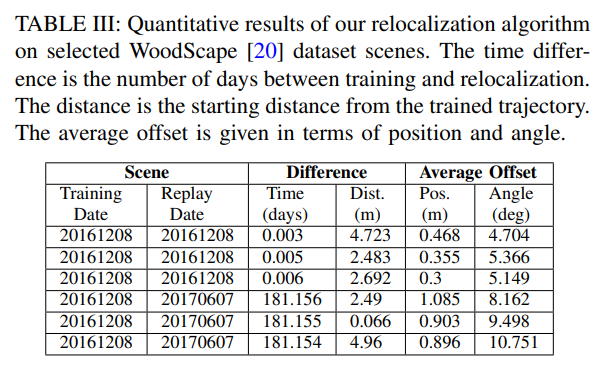

Visual SLAM中的地點識別有幾個應用程序。首先,它允許循環閉合以糾正累積漂移,其次,它允許從同一場景的多個過程中創建和維護地圖。使用單詞袋的經典方法(如[128])被證明是相當成功的,盡管可能缺乏穩健性。基于CNN的方法被證明更為穩健,外觀不變的方法顯示出有希望的初步結果[129]。當重要的時間過去時,對地點的識別是一個重要的話題。表III顯示了Visual SLAM pipelines的一小組結果,并表明隨著訓練和重定位之間的六個月時間差的增加,錯誤顯著增加。最后,可以考慮視圖不變的定位。當重定位的camera視點與訓練時的camera視角顯著不同時,這一點很重要,例如,由于以大角度接近訓練軌跡而導致車輛旋轉,基于特征描述符的傳統Visual SLAM方法失敗了。研究表明,將語義標簽附加到場景地標(通過bounding box分類)可以顯著提高視點不變性的性能。

重定位和重建

重定位和視覺SLAM通常可以被視為場景重建(即構建地圖)的存儲,以及通過bundle adjustment調整對所述地圖的迭代細化(見圖15)。這樣,重建和視覺里程表就成為傳統Visual SLAM方法的種子。有一些直接的方法可以繞過這種seed方法,例如LSD-SLAM(及其全向相機擴展[100]),其中光度誤差相對于重投影誤差被最小化。然而,如果考慮bundle adjustment調整地圖的時間切片,也可以看出,Visual SLAM可用于優化重建(場景結構和視覺里程計)。此外,移動目標會導致任何Visual SLAM管道的性能顯著下降。因此,動態對象檢測(例如[90]、[48]、[58])可以用作Visual SLAM pipelines的輸入,以抑制所述移動目標引起的異常值。

討論下冗余

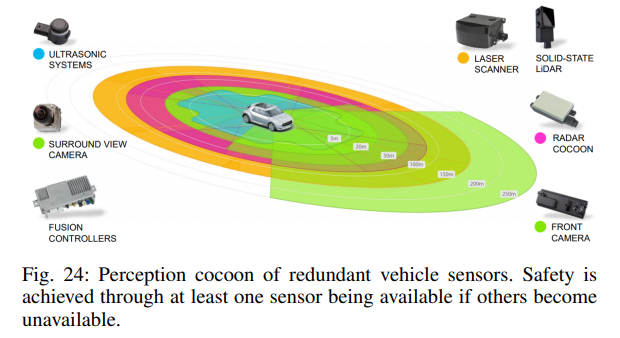

還有另一個首要的協同考慮:冗余。在自動化車輛中,冗余對應用程序的安全性起著重要作用。當系統部件發生故障時,必須提供另一個部件,以確保車輛保持安全狀態。例如,FuseModNet展示了提供密集信息的相機與在弱光下表現良好的激光雷達的協同融合。在傳感方面,這通常是通過使用多種傳感器類型來實現的,例如計算機視覺系統、radar和激光雷達。對于近場傳感,超聲波傳感器陣列是一種成熟的低成本傳感器,可在車輛周圍提供強大的安全性。

論文認為,通過并行使用不同的計算機視覺算法類型,可以實現更高的安全性。也就是說,可以配置計算機視覺系統架構以最大限度地提高冗余度。這一點尤其正確,因為數據源是完全不同的處理類型。例如,識別pipelines的統計處理和重建管道的幾何pipelines。此外,這種處理通常會在SoC內的不同硅組件上運行。然而,必須意識到,如果你最大限度地發揮其他協同作用,冗余的可能性就會降低。例如,如果使用基于CNN的深度作為Visual SLAM算法的種子,則不能將CNN聲明為Visual SLAM的冗余,因為Visual SLAM現在依賴于CNN處理。還必須注意,這兩個處理元件可能使用相同的視頻饋送,因此相機本身和相關硬件/軟件的安全性也可能是一個限制因素。

審核編輯:劉清

電子發燒友App

電子發燒友App

評論