目前,學術圈還是用“打榜”來對自動駕駛算法評分。所謂“打榜”就是在某一數據集上利用其訓練數據集來測試算法的優劣,目前自動駕駛圈內最常用的打榜數據集是安波福Aptiv旗下的nuScenes。嚴格意義上的自動駕駛算法評分對比幾乎是不可能的,單獨對比算法不夠公允,此外還必須考慮算法的效率和落地可行性。訓練數據集的數據結構也會影響算法的發揮。同時由于深度學習的不可解釋性,在nuScenes數據集上表現好不代表在其他數據集也會表現好,也許會表現得很差,同樣道理在nuScenes數據集上表現不好不代表在其他數據集也表現不好。當然算力大小無關算法的準確度。

nuScenes數據集的任務包括六大類,分別是3D目標檢測detection、目標追蹤tracking、目標軌跡預測prediction、激光雷達目標分割lidar segmentation、全景panoptic、決策planning。其中,3D目標檢測是自動駕駛最基礎的任務,全球有近300個團隊或企業參加了比試,也是全球自動駕駛數據集參賽者最多的,足見其權威性。決策任務的榜單還沒有公布,因為打榜的人太少了。目標追蹤、目標軌跡預測參與熱度相對還比較高,而激光雷達目標分割和全景參與熱度就很低了,不到20家參與。

近期打榜的基本都是中國企業或高校,除了中國,其他地區對自動駕駛缺乏興趣,即便在美國,研究自動駕駛的基本都是華人。很少有車企會參與打榜,早期還有奔馳、博世等企業參加,奔馳的成績慘不忍睹,博世還不錯。車企不參加打榜的原因很簡單,成績好消費者也不知情,成績差的話就會被競爭對手拿來攻擊,干脆不參與,要參與就是對自己的能力非常自信,就比如零跑和上汽。

前15名如下:

nuScenes數據集的靈感來自開創性的KITTI數據集(豐田與德國KIT于2012年完成)。nuScenes是首個提供自動駕駛汽車整個傳感器套件(6個攝像頭、1個LiDAR、5個Radar、GPS、IMU)數據的大規模數據集。與KITTI相比,nuScenes包含了7倍多的對象注釋。完整的數據集包括大約1.4M相機圖像(camera images),390k激光雷達掃描(LiDAR sweeps),1.4M雷達掃描(Radar sweeps)和1.4M物體邊界框(objectbounding boxes)在40k關鍵幀。為方便常見的計算機視覺任務,如對象檢測和跟蹤,在整個數據集上以2Hz的速度用精確的3D包圍框注釋了23個對象類;還注釋了對象級屬性,如可見性、活動和姿勢。

如果只用相機也就是純視覺,地平線的Sparse4D包攬第一名和第二名。曠視的FAR3D是第三名,商湯和香港大學、哈爾濱工業大學等聯合的HOP第四名,豐田排名第五。純視覺的效果比視覺和激光雷達融合的效果落后不少,但純激光雷達的效果與視覺和激光雷達融合后的效果相差甚微。

3D目標檢測的得分共六項(見下表)。

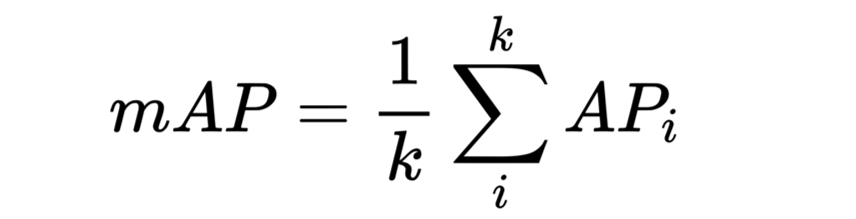

mAP平均精確度,mean of Average Precision的縮寫。

mATE,Average Translation Error,平均平移誤差(ATE) 是二維歐幾里德中心距離(單位為米)。

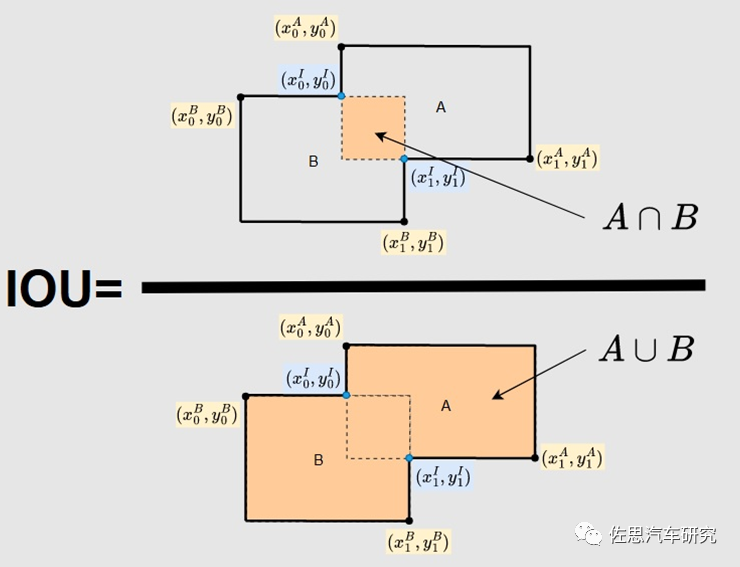

mASE,Average Scale Error, 平均尺度誤差(ASE) 是1 - IoU, 其中IoU 是角度對齊后的三維交并比。

mAOE, Average Orientation Error平均角度誤差(AOE) 是預測值和真實值之間最小的偏航角差。(所有的類別角度偏差都在360°度內, 除了障礙物這個類別的角度偏差在180° 內)。

mAVE,Average Velocity Error平均速度誤差(AVE) 是二維速度差的L2 范數(m/s)。

mAAE,Average Attribute Error,平均屬性錯誤(AAE) 被定義為1?acc, 其中acc 為類別分類準確度。

其中,mAP是最核心指標。

資料來源:公開信息整理

mAP意思是平均精確度(averageprecision)的平均(mean),是object detection中模型性能的衡量標準。object detection中,因為有物體定位框,分類中的accuracy并不適用,因此才提出了object detection獨有的mAP指標,上汽在這個單項中是第一名。

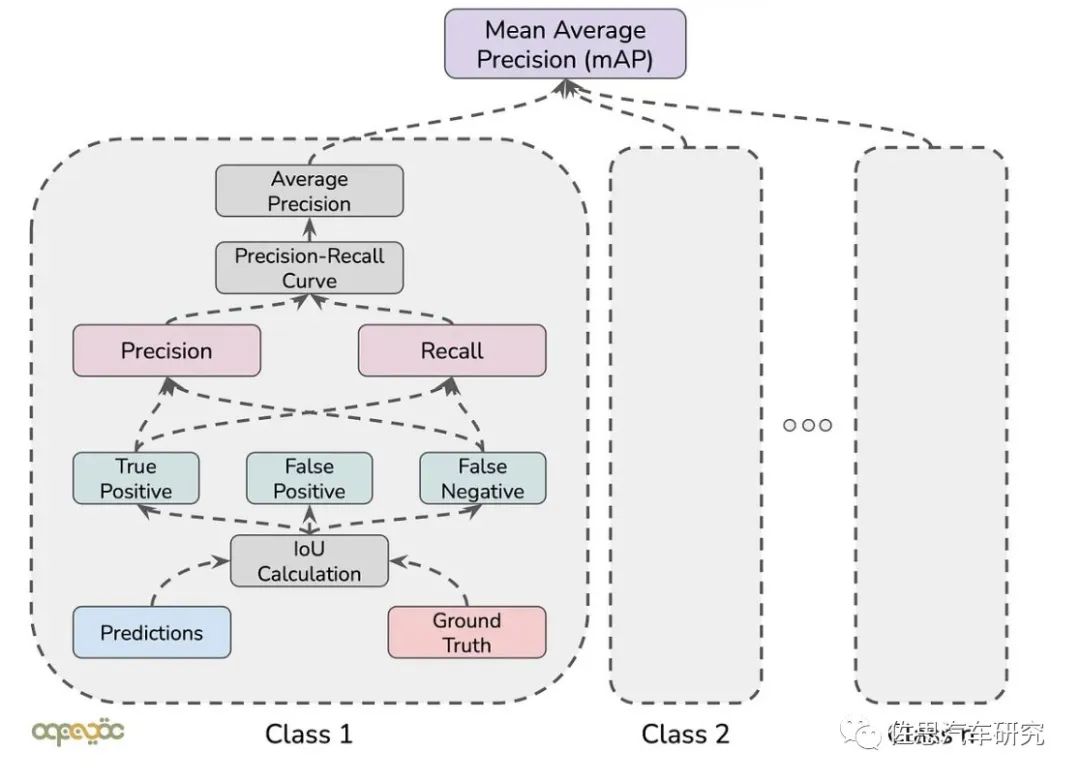

mAP計算流程圖,非常復雜,這里的class就是分類,nuScenes有23個分類。Ground truth就是人工標注的真值,當然也可以電腦自動標注,但人工標注是不可或缺的,只是比例多少,一般來說精細標注都是人工標注,電腦自動標注是稀疏標注。Prediction預測就是深度學習模型根據訓練數據集給出的答案。

要理解平均精確度的概念,要先熟悉幾個基本概念:

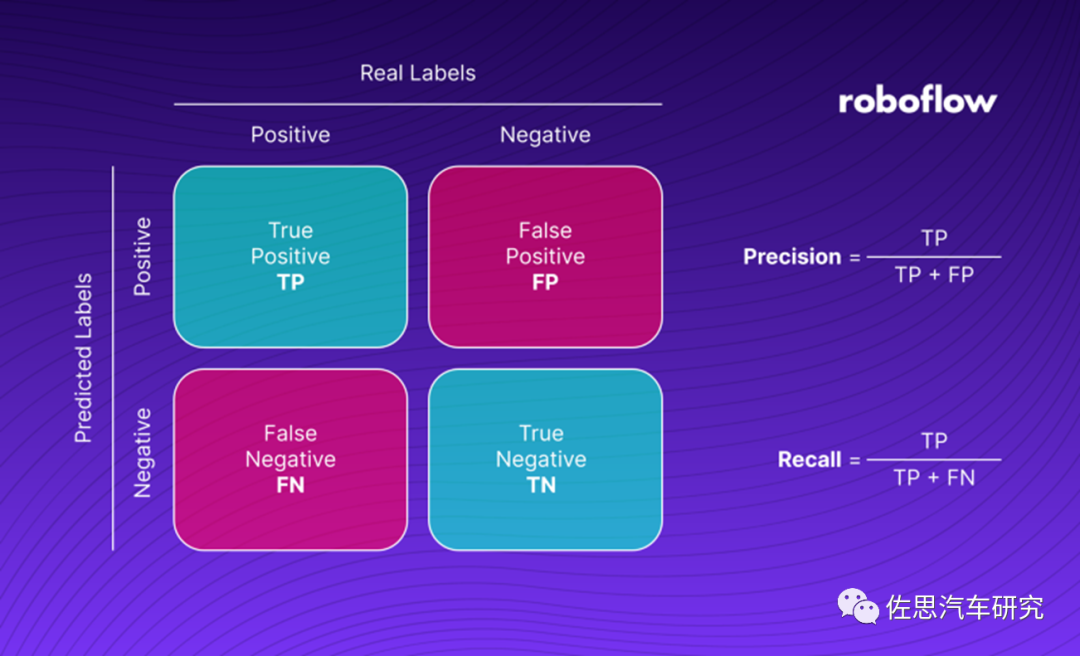

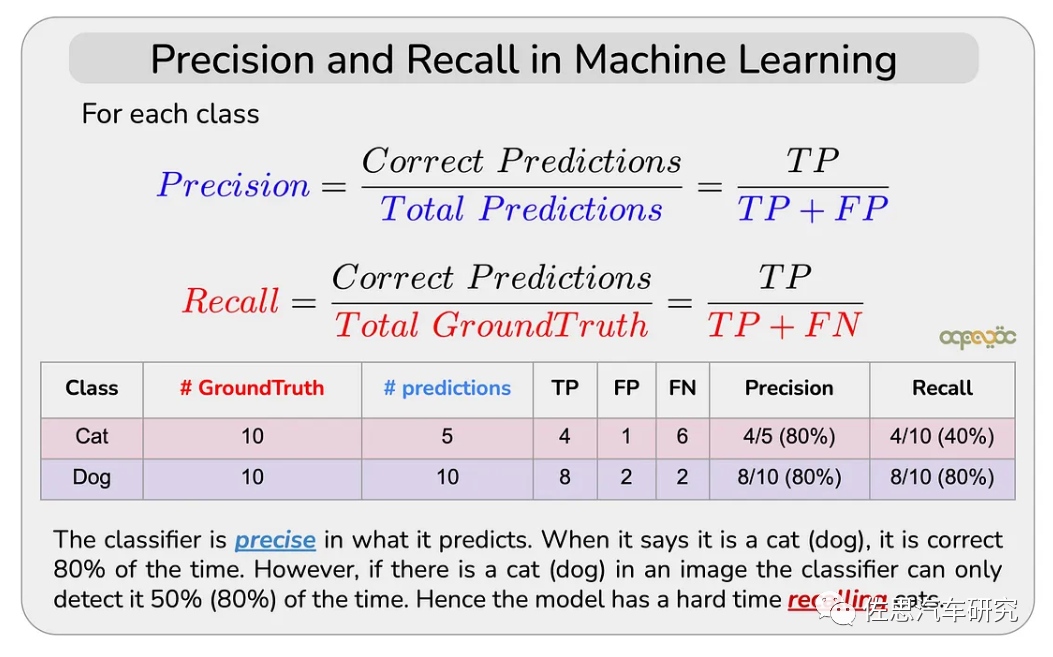

查準率(Precision)是指在所有預測為正例中真正例的比率,也即預測的準確性。

查全率(Recall)是指在所有正例中被正確預測的比率,也即預測正確的覆蓋率。

真正率為TP,真反率為TN,假正率是FP,假反率為FN。

查準率是TP/TP+FP,查全率是TP/FP+FN。

單一類別的AP計算,物體檢測中的每一個預測結果包含兩部分:預測框(boundingbox)和置信概率(PC)。bounding box通常以矩形預測框的左上角和右下角的坐標表示,即x_min, y_min, x_max, y_max。 紅框為真值也就是groundtruth,真值也就是準確答案;綠框為算法預測值,88%是置信度,簡單說就是有88%的可能是狗。

Intersection over Union (IoU),中文一般叫交并比。交并比IoU衡量的是兩個區域的重疊程度,是兩個區域重疊部分面積占二者總面積(重疊部分只計算一次)的比例。如上圖,兩個矩形框的IoU是交叉面積與合并面積之比。

假設測試數據集中的某一類如“貓”的真值有10個,此算法預測到了5個,“狗”分類真值也有10個,此算法也預測到了10個,那么有如下值。

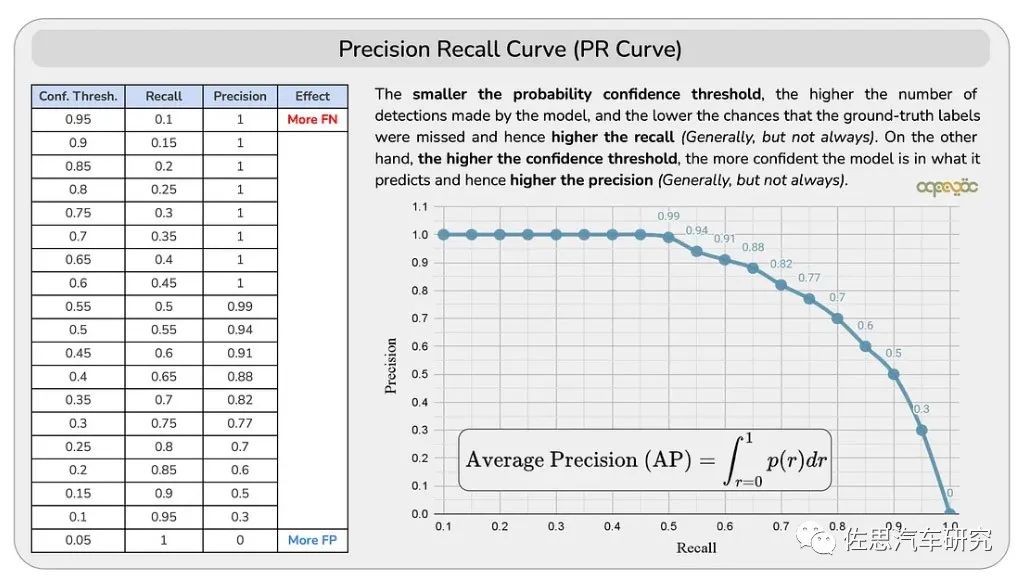

根據查準率和查全率,按置信度的不同閾值,我們繪制出一條曲線。

Conf.Thresh.就是置信度閾值的縮寫。根據表格,可以得到一條查準率和查全率的曲線。

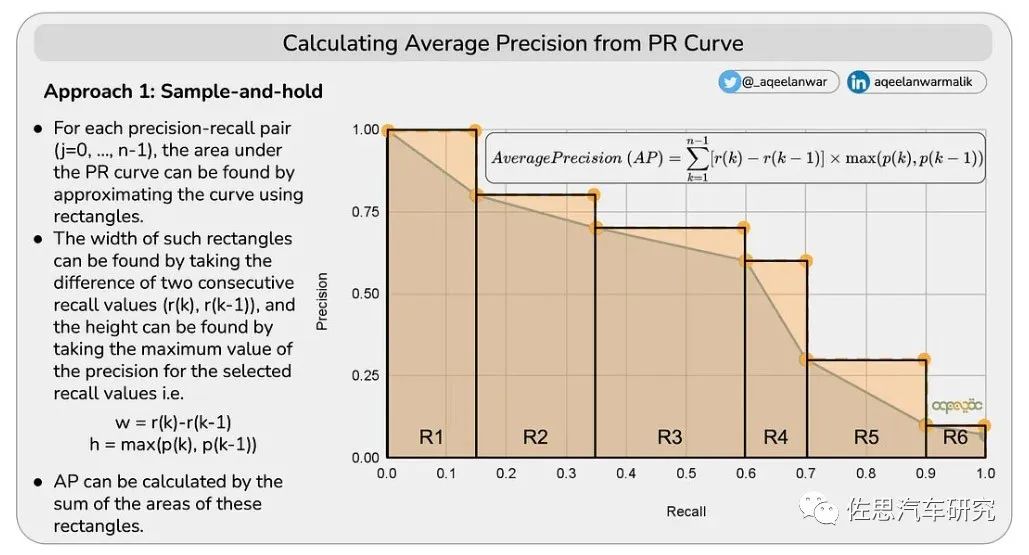

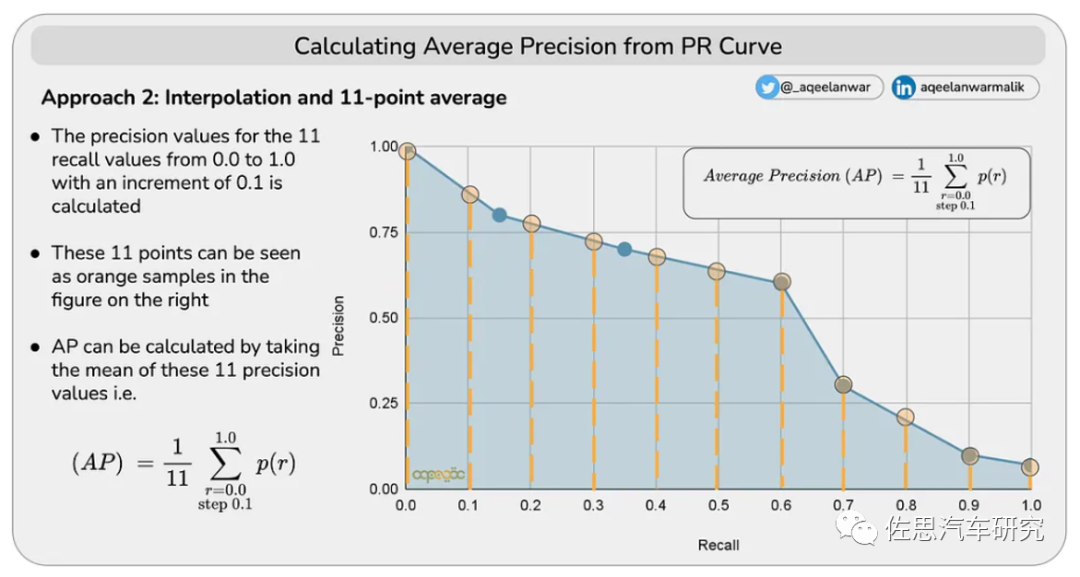

AP是一個標量,可以通過兩種辦法計算得到。

1)通過矩形累加得到AP

2)通過內插10點值計算AP

K為分類的數量,即23。

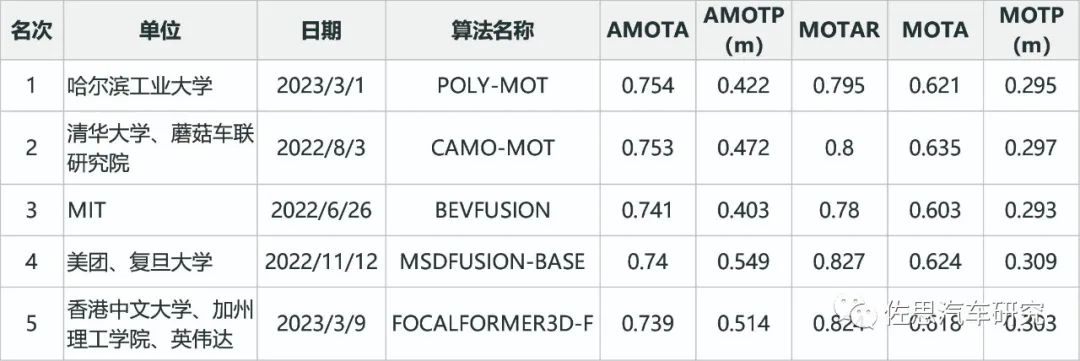

目標追蹤榜單如下,只取前五名。

資料來源:公開資料整理

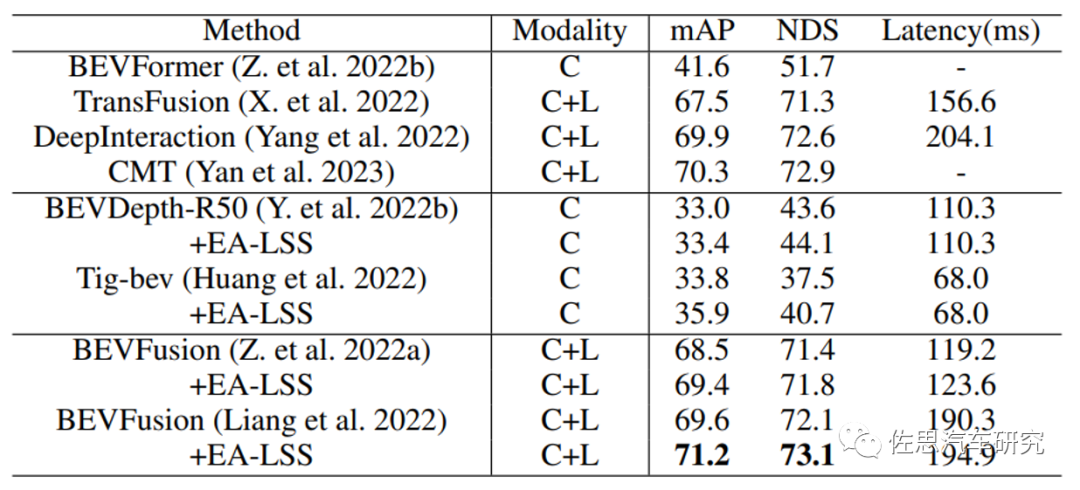

這些打榜的算法主要考慮性能,很少考慮落地性,不過也有考慮到實際落地的算法,如安波福的純激光雷達的PointPillars,早在2019年3月就有了,mAP只有0.305,但使用1080ti顯卡就有每秒61.2的幀率,放寬損失函數最高可達150Hz,資源消耗最小,也是目前最常見的激光雷達算法。 零跑EA-LSS算法延遲

? 零跑的EA-LSS算法模型是基于英偉達DGX-A100來做的,也就是8張A100顯卡,每秒幀率不到15,顯然是無法落地的。

自動駕駛的發展面臨困境,算法越來越復雜,參數越來越多,對算力的需求越來越高,而高算力芯片價格越來越高。不僅是算力還有存儲帶寬,transformer對存儲帶寬遠高于CNN,而高帶寬的HBM價格是主流的LPDDR4/5的十倍以上。不僅是芯片,計算系統的其他芯片或部件亦是如此,這導致自動駕駛系統成本越來越高,最終可能L4級計算系統的價格超過3萬美元乃至更高。

編輯:黃飛

電子發燒友App

電子發燒友App

評論