英偉達發布了一款突破性的推理軟件,借助于這款軟件,全球各地的開發者都可以實現會話式AI應用,大幅減少推理延遲。而此前,巨大的推理延遲一直都是實現真正交互式互動的一大阻礙。

NVIDIA TensorRT 7作為NVIDIA第七代推理軟件開發套件,為實現更加智能的AI人機交互打開了新大門,從而能夠實現與語音代理、聊天機器人和推薦引擎等應用進行實時互動。

NVIDIA加速計算產品管理總監Paresh Kharya、NVIDIA企業邊緣計算總經理Justin Boitano、NVIDIA TensorRT產品市場負責人Siddarth Sharma接受媒體的采訪,對NVIDIA深度學習產品進行了詳細解讀。

Paresh Kharya表示,會話式AI是一個非常復雜的任務,因為它需要理解語音、文本、語言并且還要把這些東西轉化為語言再次說回去。

“這里最關鍵的一個挑戰就是要想真正的實現會話式AI,我們需要在毫秒級的時間段來完成我剛剛提到的整個非常復雜的過程,因為只有這樣,會話式AI才會顯得比較自然。隨著TensorRT 7的發布,我們可以將這一系列的復雜模型進行加速計算,這也是我們第一次真正的實現實時會話式AI,并且可以準確的處理中間復雜的流程”。

對于如何看待深度學習當中多種處理器的共存,Paresh Kharya提到,AI的變化速度是非常快的,甚至更新是以分鐘來計的,所以必須要在軟件端實現高度靈活的可編程。GPU是AI領域的專用芯片,它的指令集是非常有優勢的,是全可編程,并且是軟件定義的。

另外,GPU架構向前兼容,硬件更迭隨著軟件不斷更新適應,且軟件庫內就能進行直接更新。無論是臺式機、筆記本、服務器,還是很大型的外設,在數據中心、邊緣或者是物聯網上,均可使用NVIDIA的平臺。

有些公司通過去掉GPU的圖形處理部分來提升AI算力和減少成本,Paresh Kharya認為,NVIDIA在圖象處理方面本身基礎就比較好,比如說其RT Core能夠加速圖象處理,Tensor Core做AI加速計算。

以下為采訪實錄:

問:在推薦系統這一塊,一方面是面臨海量的數據,還有AI模型也在每天不完善更新,這個挑戰對于NVIDIA來說,算力和軟件哪一個是當前更為重要的難題?

Paresh Kharya:這兩個其實也是相關聯的,您說的沒錯,AI模型確實每天都在發生變化,甚至百度的模型可能隔幾分鐘就要發生變化。如果要是模型行之有效,必須要不斷訓練模型并對模型進行更新。

因為無論是你在網上的信息包括產品信息、視頻信息等等都在不斷發生變化,整個推理過程也在不斷變化,只有不斷對這些模型進行訓練,才可以進行有效的推薦。

所以訓練模型確實需要大量算力,這也是NVIDIA解決方案能夠解決的問題,現在已經不是跑在一個服務器上了,而是需要多個服務器來同時解決同一個問題,去訓練這些大量的模型。

因為這些模型其實越來越復雜,所以當你部署這些模型的時候,在某些APP當中做推理的話,這些模型的規模是非常大的,它也確實需要大量的算力才能讓這些模型真正的跑起來。

所以,我們也是提供了不斷更新的各種各樣工具和軟件,比如說用我們最新的軟件Tensor RT來支持各種各樣的模型在各種情景下的部署,并且支持上百萬的用戶在每秒內做數十億的搜索。

如果說想大規模的讓這些模型跑起來,沒有我們的GPU是非常困難的。比如說還是以阿里為例,他們的邊緣系統如果說在GPU上跑,每秒可以做780次查詢,但是如果說用CPU,每秒只能做3次查詢。

問:您如何看待深度學習當中多種處理器的共存,因為在加速這一塊有FPGA,但是FPGA開發周期也在不斷縮短,它也是可編程的,另外還有其他的一些處理器,比如說TPU、NPU等等,GPU在未來場景的下其優勢是什么?

Paresh Kharya:FPGA從設計的時候就是為模擬而用的,但是如果說這個東西是專門為模擬而用的,你反過來想,在真正實際應用過程當中,它的表現反而可能沒有那么好。

實際上首先做好一個FPGA,整個編程的時間就要幾個月,然后還要做再編程,而且還在硬件層面對它進行編程。現在AI就是我們之前討論過的,變化速度是非常快的,甚至更新是以分鐘來計的,所以必須要在軟件端實現高度靈活的可編程。

GPU是AI領域的專用芯片,他的指令集是非常有優勢的,是全可編程,并且是軟件定義的。

另外一個優勢,我們的架構是向前兼容的,當你使用了一個編程框架之后,在未來如果說你使用新的硬件,可以幫助你縮短整個開發周期,也就是說整個硬件是可以隨著軟件不斷更新適應的,而且在軟件庫里就可以進行直接更新。

而且我們的平臺在使用上是幾乎可以在任何設備上使用的,無論是臺式機、筆記本、服務器,還是很大型的外設,在數據中心、邊緣或者是物聯網上都可以使用。

問:我們看到今天宣布了對ARM架構的支持,NVIDIA這方面的考慮是什么?今天上午的演講當中,更多強調軟件的作用,NVIDIA在提升加速計算性能表現方面做了哪些工作?

Paresh Kharya:首先ARM本身就是一個非常重要的,并且被廣為使用的架構。在全球范圍內,共有1500億臺設備是基于ARM架構的。之所以ARM架構如此成功,就是因為它是一個開放平臺,各種各樣的公司都可以在ARM架構上進行他們想要的創新。

所以ARM所提供的各種各樣的功能,包括互聯、內存、CPU內核、計算能力,包括多元化的支持,都使得ARM成為了現如今世界上非常重要的架構之一的重要原因。

這也給了客戶更多選擇,無論在數據中心還是在邊緣設備上都可以選擇ARM架構,這也是我們為什么選擇兼容ARM做加速計算。我們通過將CUDA平臺和ARM架構進行兼容,在整個加速計算領域,無論是AI、高性能計算還是我們進入的所有的領域都可以給到客戶更多選擇。

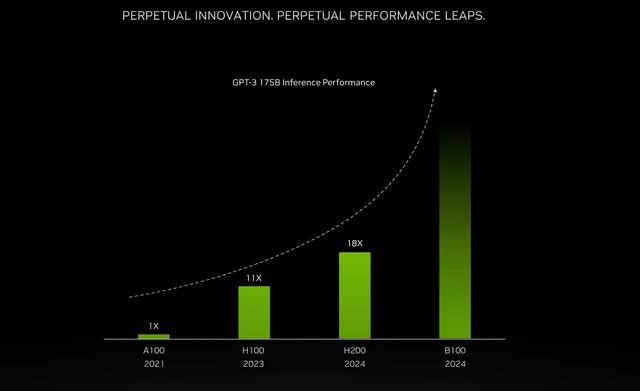

因為加速計算和過去以CPU為基礎的計算是非常不一樣的,它使得高性能計算達到更高的提升,這種性能提升是20、30甚至是100倍的,之所以有這么大的性能提升,不僅是在架構上進行了設計,更重要的是我們通過軟件的方式使得性能進一步提升。

比如說我們有各種各樣的平臺,像應用在醫療領域的Clara平臺,應用在自動駕駛領域的Drive以及Isaac,所以是硬件和軟件的相互結合讓計算性能得以大幅度提升。

包括黃仁勛在演講當中也提到,我們僅僅通過軟件就使我們AI計算性能在兩年之間提升了4倍,所以軟件對加速計算的性能提升是非常重要的,未來我們會繼續在我們各個平臺上對軟件進行完善以提升性能。

Justin Boitano:我補充一下關于軟件定義的事情,我們在全世界范圍內和很多電信公司合作,電信公司正在建設5G,在邊緣計算方面投入了很多資源,然首先要加速5G信號處理,除了5G信號處理他們也希望利用同樣的技術架構加速他們自己的AI、游戲或者是VR應用,所以整個工作負載都是發生了一些變化的,取決于接入網絡的設備和用戶發生了很多變化。

Paresh Kharya:因為最終客戶最在乎的,是他們能不能用各種各樣的計算平臺來幫助他們降低成本,處理各種各樣的工作負載。

而且,非常重要的一點就是,不僅可以在今天利用這些硬件處理這些工作負載,并且在未來也能夠持續,要實現這一點,軟件定義平臺就非常重要了。

問:我想問一個有關TensorRT的問題,上一個版本的TensorRT 6是在3個月前發布的,在這么短的時間內就發布TensorRT 7是出于什么樣的考慮?Tensor RT整個研發升級的路線是怎么樣的?

Siddarth Sharma:實際上這一點涉及到會話式AI的問題,我們做會話式AI的加速方面已經有好幾個月的時間了,其實最開始的第一個版本只涵蓋了會話式AI當中的一部分,也就是語言理解的部分。

整個過程是需要三個部分的,第一個是語音識別的部分,識別你所說的,你要識別所說的話轉化為文字,然后要理解這些文字,然后再轉化成的文字轉化成語言再說出來。

隨著我們不斷發布新的版本,TensorRT 7基本上可以完成整個三個流程計算。從語音識別到語義理解再到語音輸出。會話式AI是非常難的領域,要想把會話式AI做得比較有用,你要符合兩個條件,首先是要在300毫秒內將整個三個部分完成,而且要完成的非常智能。

在這個過程當中,有非常多復雜的模型需要計算,所以我們Tensor RT也是在不完善,現在可以覆蓋整個流程。

問:第一個問題,我聽到有一種說法,硬件每提升一倍性能,軟件可以帶來幾倍甚至是幾十倍的提升,NVIDIA的GPU是否也有這樣的提升,有沒有相關的數據?

Paresh Kharya:其實在加速計算平臺當中,首先要做好硬件架構,在硬件架構基礎之上開發相應的現在軟件來利用這個硬件平臺,有了軟件再去開發各種各樣的應用。

舉一個例子,現在我們的GPU光線追蹤的技術,在最新的GPU平臺上,它可以帶來50倍以上的性能提升。在硬件性能提升基礎上,我們開發軟件去利用硬件帶來的更優越的性能,讓做渲染的開發者可以更好利用硬件加上軟件的性能提升。

問:今天還提到推薦的案例,相比CPU來說提升的性能非常多,在新的應用領域是否依賴于我們的軟件平臺優化才可以實現相對CPU性能更大的提升?

Paresh Kharya:這么來說,站在開發者的角度來說,如果說是那些做AI開發的開發者,他們會用各種各樣的AI開發框架,比如TensorFlow,我們其實主要做的是盡可能的做更多的軟件庫整合到TensorFlow當中。

這樣,這些開發者在做開發的時候就可以充分利用這些庫來基于各種各樣的平臺,包括GPU去做開發,這樣開發者就不用再去擔心自己要去寫很多底層的東西,這樣他們會直接利用我們寫出來的庫或者是新的功能直接去開發他們想要的東西,并且之后可以在任何的硬件平臺上進行使用。

問:NVIDIA能滿足多用戶函數做深度學習的條件,所以它在深度學習的硬件平臺選擇上還是很占優勢的,我們注意到Tesla V100升級的時候,有很多深度學習的模型主動做出了一些調整來發揮NVIDIA硬件的優勢。

但是我隨便列了一下深度學習模型的主要類型,我們可以列出20個以上,對它的支持其實是很復雜的工程,我們想了解一下,對于主流深度學習模型的支持,我們是被動的,還是說我們在硬件進入更新之前和他們就做溝通然后共同做出調整?

Paresh Kharya:實際上現在在市面上你如果去看的話可能有成百上千各種各樣的深度學習模型,基本上每一個用戶用例,包括每個客戶旗下都有自己的模型,他們用自己的數據來做訓練,所以整個深度學習模型是高度多元化的,這也是為什么我們在做硬件的時候要做成可編程程度非常高的,這樣才可以促進加速計算在這個領域的應用。

我們在做硬件設計的時候,也考慮了深度學習過程當中可能會出現一些共性的東西來做改善,包括從Tensor Core支持多元化的深度學習模型。

今天上午講了很多軟件,我們一直在不斷更新完善我們的軟件堆棧,比如說我們也是很快推出了Tensor RT新的版本,能夠進一步提升推理的速度。

當然有一些客戶他們也希望提供一些現成的深度學習模型供他們使用,我們也有一些預訓練好的模型供客戶直接部署,或者他們通過轉移學習的方式定制化自己想要的模型。我們也在不斷更新和提供各種各樣的堆棧讓用戶去創建訓練和優化自己的模型。

Siddarth Sharma:補充一點,我們其實也是和開發者保持非常緊密的溝通和合作,比如說TensorFlow等,以保證這些開發框架和我們硬件緊密兼容,與此同時我們在各種軟件功能和庫上做溝通,以保證一些外部開發者可以充分利用這些東西。所以我們在內部也有一個很大的團隊去做主動溝通。

問:剛剛提到與ARM的合作,在數據中心、邊緣計算給客戶以更多選擇,我們知道ARM架構在邊緣計算方面更有優勢,市占率更高,未來在邊緣計算會有更多設備,甚至是AI服務器,是不是我們也看到了前景很大的市場是合作的主因?

Justin Boitano:有關邊緣計算,因為NVIDIA是有ARM架構許可的,所以我們開發很多產品都是基于ARM架構的,包括今天介紹的用于汽車平臺的產品,所以我們有很ARM架構的硬件。關于邊緣計算的需求,我們看到很多客戶想用ARM的架構,最主要的是因為他有一些低功耗的應用,并且應用起來也比較靈活,包括應用在倉庫里或者是路邊的一些設備應用ARM架構會比較好。

問:怎么看待現在一些企業去砍掉GPU當中的圖形處理部分,去做純AI加速的通用GPU,以這樣的一種方式去達到更快的AI加速能力更低的成本?

Paresh Kharya:NVIDIA在圖象處理方面本身基礎就比較好,比如說我們的RT Core能夠加速圖象處理,Tensor Core做AI加速計算。我們業提供了各種各樣的產品來滿足客戶各種各樣的需求,比如說應用于數據中心的GPU沒有圖像處理的部分,但是它有Tensor Core能夠做AI加速計算。

像我們一些新的產品比如說RTX6000、RTX8000,圖像加速和AI加速的功能都是有的。我們比較大的優勢是我們有統一的架構可以應用于各種工作負載當中來實現加速計算。這對我們來說都是各種各樣的商業機會,可以應用在不同市場和行業當中。

像游戲、圖像是一個很大的業務,高性能計算和AI對我們來說都是比較大的業務板塊。所以各個業務板塊我們都可以有很好的營收,這樣我們可以進一步投入到我們的統一架構平臺的研發當中。

問:今天上午談到了NVIDIA AI和云計算廠商的合作,能不能詳細介紹一下NVIDIA和國外的云計算公司以及國內的云廠商合作的情況和進展?

Paresh Kharya:云計算是一個非常重要的計算方式,并且增長勢頭也是非常迅猛的。

我們的計算平臺幾乎和全球所有的云服務提供者都有合作,比如說AWS、Azure、谷歌云,包括中國的百度、滴滴、阿里的云平臺,我們和各個云供應商都保持了非常緊密的合作,我們在開發下一代產品時都會保證到無論是開發者還是客戶都用到我們的產品。

電子發燒友App

電子發燒友App

評論