深度學(xué)習(xí)在這十年,甚至是未來(lái)幾十年內(nèi)都有可能是最熱門的話題。雖然深度學(xué)習(xí)已是廣為人知了,但它并不僅僅包含數(shù)學(xué)、建模、學(xué)習(xí)和優(yōu)化。算法必須在優(yōu)化后的硬件上運(yùn)行,因?yàn)?b class="flag-6" style="color: red">學(xué)習(xí)成千上萬(wàn)的數(shù)據(jù)可能需要長(zhǎng)達(dá)幾周的時(shí)間。因此,深度學(xué)習(xí)網(wǎng)絡(luò)亟需更快、更高效的硬件。接下來(lái),讓我們重點(diǎn)來(lái)看深度學(xué)習(xí)的硬件架構(gòu)。

2016-11-18 16:00:37 5544

5544 深度學(xué)習(xí)的發(fā)展趨勢(shì)做了一個(gè)預(yù)測(cè),主要是研究領(lǐng)域的趨勢(shì)預(yù)測(cè),而不是工業(yè)界的應(yīng)用。

2016-12-13 09:54:48 1424

1424 這款加速卡主力服務(wù)于深度學(xué)習(xí)領(lǐng)域,16位半精度浮點(diǎn)25TFLOPs,32位單精度浮點(diǎn)12.5 TFLOPs,熱設(shè)計(jì)功耗低于300W。

2016-12-13 16:33:37 904

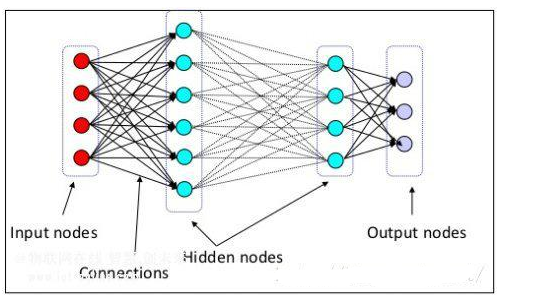

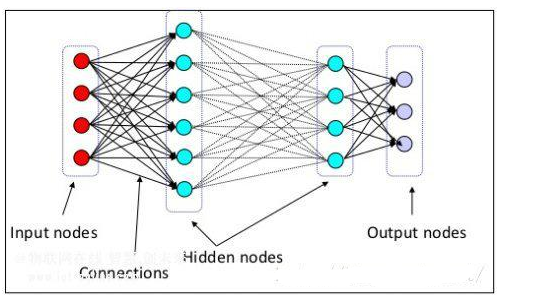

904 神經(jīng)網(wǎng)絡(luò)包括現(xiàn)代深度構(gòu)架重要的一部分是反向傳播算法的錯(cuò)誤,使用離輸入更近的神經(jīng)元通過(guò)網(wǎng)絡(luò)更新權(quán)重。非常坦率的說(shuō),這就是神經(jīng)網(wǎng)絡(luò)繼承他們”力量“(缺乏更好的術(shù)語(yǔ))的地方。反向傳播和一個(gè)隨后分布式的最小化權(quán)重的優(yōu)化方法,為了最小化損失函數(shù)。在深度學(xué)習(xí)中一個(gè)常見(jiàn)的優(yōu)化方法是梯度下降。

2018-12-14 16:01:44 19379

19379

RNN(循環(huán)神經(jīng)網(wǎng)絡(luò))是一種強(qiáng)大的深度學(xué)習(xí)模型,經(jīng)常被用于時(shí)間序列預(yù)測(cè)。RNN通過(guò)在時(shí)間上展開(kāi)神經(jīng)網(wǎng)絡(luò),將歷史信息傳遞到未來(lái),從而能夠處理時(shí)間序列數(shù)據(jù)中的時(shí)序依賴性和動(dòng)態(tài)變化。

2023-06-16 16:15:59 1085

1085

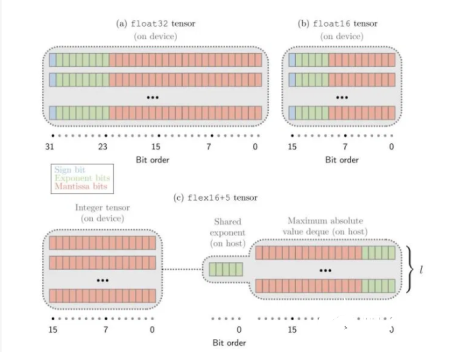

InferX 支持INT8,INT16,BF16并可以在不同的算法層混合使用,方便客戶根據(jù)自己的需求來(lái)優(yōu)化吞吐量和算法精度。InferX還內(nèi)置有Winograd變換來(lái)加速INT8計(jì)算卷積,芯片

2019-04-11 08:50:24 1559

1559 ` 深度學(xué)習(xí)不但使得機(jī)器學(xué)習(xí)能夠?qū)崿F(xiàn)眾多的應(yīng)用,而且拓展了人工智能的領(lǐng)域范圍,并使得機(jī)器輔助功能都變?yōu)榭赡堋F鋺?yīng)用領(lǐng)域正在加速滲透到很多領(lǐng)域,也催生了深度學(xué)習(xí)與其它應(yīng)用技術(shù)的加速融合,為提升一線

2017-03-22 17:16:00

ifi給你科普如何優(yōu)化SPDIF數(shù)字信號(hào),數(shù)字音頻信號(hào)差或者劣,這是大多數(shù)數(shù)碼產(chǎn)品存在的問(wèn)題,而iPurifier SPDIF可達(dá)到優(yōu)化效果。我們的電腦機(jī)箱內(nèi)存在著嚴(yán)重的電磁波,D/A、A/D轉(zhuǎn)換

2016-08-16 11:04:18

;而深度學(xué)習(xí)使用獨(dú)立的層、連接,還有數(shù)據(jù)傳播方向,比如最近大火的卷積神經(jīng)網(wǎng)絡(luò)是第一個(gè)真正多層結(jié)構(gòu)學(xué)習(xí)算法,它利用空間相對(duì)關(guān)系減少參數(shù)數(shù)目以提高訓(xùn)練性能,讓機(jī)器認(rèn)知過(guò)程逐層進(jìn)行,逐步抽象,從而大幅度提升

2018-07-04 16:07:53

利用ML構(gòu)建無(wú)線環(huán)境地圖及其在無(wú)線通信中的應(yīng)用?使用深度學(xué)習(xí)的收發(fā)機(jī)設(shè)計(jì)和信道解碼基于ML的混合學(xué)習(xí)方法,用于信道估計(jì)、建模、預(yù)測(cè)和壓縮 使用自動(dòng)編碼器等ML技術(shù)的端到端通信?無(wú)線電資源管理深度強(qiáng)化學(xué)習(xí)

2021-07-01 10:49:03

深度學(xué)習(xí)在預(yù)測(cè)和健康管理中的應(yīng)用綜述摘要深度學(xué)習(xí)對(duì)預(yù)測(cè)和健康管理(PHM)引起了濃厚的興趣,因?yàn)樗哂袕?qiáng)大的表示能力,自動(dòng)化的功能學(xué)習(xí)能力以及解決復(fù)雜問(wèn)題的一流性能。本文調(diào)查了使用深度學(xué)習(xí)在PHM

2021-07-12 06:46:47

深度學(xué)習(xí)常用模型有哪些?深度學(xué)習(xí)常用軟件工具及平臺(tái)有哪些?深度學(xué)習(xí)存在哪些問(wèn)題?

2021-10-14 08:20:47

時(shí)間安排大綱具體內(nèi)容實(shí)操案例三天關(guān)鍵點(diǎn)1.強(qiáng)化學(xué)習(xí)的發(fā)展歷程2.馬爾可夫決策過(guò)程3.動(dòng)態(tài)規(guī)劃4.無(wú)模型預(yù)測(cè)學(xué)習(xí)5.無(wú)模型控制學(xué)習(xí)6.價(jià)值函數(shù)逼近7.策略梯度方法8.深度強(qiáng)化學(xué)習(xí)-DQN算法系列9.

2022-04-21 14:57:39

CPU優(yōu)化深度學(xué)習(xí)框架和函數(shù)庫(kù)機(jī)器學(xué)***器

2021-02-22 06:01:02

具有深度學(xué)習(xí)模型的嵌入式系統(tǒng)應(yīng)用程序帶來(lái)了巨大的好處。深度學(xué)習(xí)嵌入式系統(tǒng)已經(jīng)改變了各個(gè)行業(yè)的企業(yè)和組織。深度學(xué)習(xí)模型可以幫助實(shí)現(xiàn)工業(yè)流程自動(dòng)化,進(jìn)行實(shí)時(shí)分析以做出決策,甚至可以預(yù)測(cè)預(yù)警。這些AI

2021-10-27 06:34:15

案列為你深度解析降低EMI的辦法。EMI噪聲源和耦合路勁的基本概念圖1所示是離線反激變換器的傳導(dǎo)電磁干擾測(cè)量電路圖。測(cè)量中使用的是標(biāo)準(zhǔn)的傳導(dǎo)測(cè)量?jī)x器LISN,由電感,電容以及兩個(gè)50ohm電阻組成

2018-06-11 09:36:41

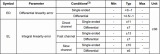

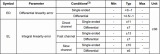

我用adas1000 2K數(shù)據(jù)速率時(shí),手冊(cè)上說(shuō)ADC的精度是19位,我配置的是模擬導(dǎo)聯(lián)的模式,但是ECG數(shù)據(jù)是24位的,LSB的算法也是按24位來(lái)算的,手冊(cè)上內(nèi)容如下:電極格式和模擬導(dǎo)聯(lián)格式:最小

2018-11-09 09:09:40

比如一個(gè)16位的ADC,參考電壓為2.5V,最大可以輸入一個(gè)峰峰值為2.5V的正弦信號(hào),能正常采集,沒(méi)有問(wèn)題。那怎么估算能采樣的最小正弦波幅度呢,如果信號(hào)幅度太小,采樣出來(lái)的不就不對(duì)了嗎?

2023-12-04 07:00:12

快速學(xué)習(xí)獲得較好的權(quán)重,并在后期對(duì)權(quán)重進(jìn)行微調(diào)。兩個(gè)流行而簡(jiǎn)單的學(xué)習(xí)率衰減方法如下:線性地逐步降低學(xué)習(xí)率在特定時(shí)點(diǎn)大幅降低學(xué)習(xí)率4、Dropout擁有大量參數(shù)的深度神經(jīng)網(wǎng)絡(luò)是非常強(qiáng)大的機(jī)器學(xué)習(xí)系統(tǒng)。然而

2019-03-07 20:17:28

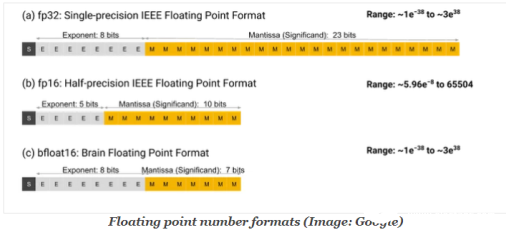

非常適合加速深度學(xué)習(xí)矩陣乘法運(yùn)算,其中使用 BF16 浮點(diǎn)數(shù)格式進(jìn)行乘法運(yùn)算并使用 32 位 IEEE 浮點(diǎn)數(shù)進(jìn)行累加。[Arm 在2019 年 Arm 架構(gòu)更新]中引入了新的 BF16 指令,以提高

2022-08-31 15:03:46

3 計(jì)算4x4 塊的結(jié)果NEON和SVE里加入BF16和有符號(hào)/無(wú)符號(hào) 8-bit整型矩陣乘指令。SVE額外加入了對(duì)單精度和雙精度矩陣乘的支持。BFloat16BFloat16(BF16)是最近特別

2022-07-29 15:29:42

本帖最后由 wcl86 于 2021-5-14 15:26 編輯

概述這個(gè)例子演示了在Vision開(kāi)發(fā)模塊中使用Model Importer API來(lái)使用深度學(xué)習(xí)為缺陷檢查應(yīng)用程序執(zhí)行對(duì)象檢測(cè)

2020-07-29 17:41:31

學(xué)習(xí),也就是現(xiàn)在最流行的深度學(xué)習(xí)領(lǐng)域,關(guān)注論壇的朋友應(yīng)該看到了,開(kāi)發(fā)板試用活動(dòng)中有【NanoPi K1 Plus試用】的申請(qǐng),介紹中NanopiK1plus的高大上優(yōu)點(diǎn)之一就是“可運(yùn)行深度學(xué)習(xí)算法的智能

2018-06-04 22:32:12

模型,訓(xùn)練時(shí)往往需要至少百萬(wàn)級(jí)別的訓(xùn)練圖片。 但是,華為云深度學(xué)習(xí)服務(wù)平臺(tái),對(duì)企業(yè)場(chǎng)景的算法模型進(jìn)行了大量的優(yōu)化,使得針對(duì)企業(yè)特定場(chǎng)景的模型訓(xùn)練數(shù)據(jù)需求大大降低。以企業(yè)特定場(chǎng)景的圖像識(shí)別業(yè)務(wù)為例

2018-08-02 20:44:09

的通用性和可擴(kuò)展性;二是權(quán)衡計(jì)算延時(shí)和精度損失,從目標(biāo)檢測(cè)處理速度的要求出發(fā),以檢測(cè)吞吐量(FPS)為表征速度的核心指標(biāo),協(xié)同考慮算法準(zhǔn)確率等要求設(shè)計(jì)相應(yīng)的量化訓(xùn)練方案降低權(quán)重的精度損失;三是構(gòu)建目標(biāo)

2020-09-25 10:11:49

Keras。 Keras是一種高度模塊化,使用簡(jiǎn)單上手快,合適深度學(xué)習(xí)初學(xué)者使用的深度學(xué)習(xí)框架。Keras由純Python編寫(xiě)而成并以Tensorflow、Theano以及CNTK為后端。Keras為支持

2018-07-17 11:40:31

本帖最后由 卿小小_9e6 于 2021-4-11 16:16 編輯

【米爾百度大腦EdgeBoard邊緣AI計(jì)算盒試用連載】III. 板載深度學(xué)習(xí)DEMO-detection測(cè)試-下(ZMJ

2021-04-11 16:17:13

,F(xiàn)PGA架構(gòu)是為應(yīng)用程序?qū)iT定制的。在開(kāi)發(fā)FPGA的深度學(xué)習(xí)技術(shù)時(shí),較少?gòu)?qiáng)調(diào)使算法適應(yīng)某固定計(jì)算結(jié)構(gòu),從而留出更多的自由去探索算法層面的優(yōu)化。需要很多復(fù)雜的下層硬件控制操作的技術(shù)很難在上層軟件語(yǔ)言中實(shí)現(xiàn)

2018-08-13 09:33:30

深度學(xué)習(xí)是什么意思

2020-11-11 06:58:03

為深度學(xué)習(xí)計(jì)算而優(yōu)化的 ASIC 被推向市場(chǎng),GPU 配備了專門用于深度學(xué)習(xí)的電路。基于這些,不得不說(shuō)用FPGA做深度學(xué)習(xí)的好處并不多。然而,與 DNN 權(quán)重降低相關(guān)的技術(shù),如參數(shù)量化(或精度降低

2023-02-17 16:56:59

指令。SVE額外加入了對(duì)單精度和雙精度矩陣乘的支持。BFloat16BFloat16(BF16)是最近特別針對(duì)神經(jīng)網(wǎng)絡(luò)高性能處理引進(jìn)的浮點(diǎn)數(shù)格式。Armv8.6-A增加了利用BF16浮點(diǎn)數(shù)格式加速特定

2022-08-08 14:16:17

Operator 的計(jì)算 kernel,執(zhí)行完成之后就可以獲得最終推理的結(jié)果。傳統(tǒng)深度學(xué)習(xí)推理框架在運(yùn)行時(shí)會(huì)做以下幾件事情:計(jì)算圖優(yōu)化 ----- 主要和模型相關(guān)。Kernel 選擇 ----- 為

2023-02-09 16:35:34

本文使用keras搭建神經(jīng)網(wǎng)絡(luò),實(shí)現(xiàn)基于深度學(xué)習(xí)算法的股票價(jià)格預(yù)測(cè)。本文使用的數(shù)據(jù)來(lái)源為tushare,一個(gè)免費(fèi)開(kāi)源接口;且只取開(kāi)票價(jià)進(jìn)行預(yù)測(cè)。import numpy as npimport

2022-02-08 06:40:03

下一個(gè)元件在片上放置,同時(shí)優(yōu)化最小功耗、性能和面積(PPA)。強(qiáng)化學(xué)習(xí)可用于實(shí)現(xiàn)這一目標(biāo)。它采用迭代方法并獎(jiǎng)勵(lì)導(dǎo)致最低 PPA的placements,同時(shí)懲罰增加PPA的建議。模型測(cè)試和部署模型訓(xùn)練后

2022-11-22 15:02:21

選擇能夠優(yōu)化傳導(dǎo)損耗與開(kāi)關(guān)損耗之間的平衡,有利于基站電源設(shè)計(jì)。 MAX15301數(shù)字負(fù)載點(diǎn)(PoL)控制器采用先進(jìn)的算法,在整個(gè)工作范圍內(nèi)實(shí)現(xiàn)最高水平的轉(zhuǎn)換效率和瞬態(tài)響應(yīng)。器件為外部MOSFET提供

2018-09-26 17:27:09

使得實(shí)現(xiàn)復(fù)雜的 DNN 結(jié)構(gòu)成為可能,而不需要深入復(fù)雜的數(shù)學(xué)細(xì)節(jié),大數(shù)據(jù)集的可用性為 DNN 提供了必要的數(shù)據(jù)來(lái)源。TensorFlow 成為最受歡迎的深度學(xué)習(xí)庫(kù),原因如下:TensorFlow 是一個(gè)

2020-07-28 14:34:04

位浮點(diǎn)數(shù),BF16 擁有和 FP32 一樣的取值范圍,但是精度較差。但對(duì)于深度學(xué)習(xí)來(lái)說(shuō),較低的精度并不顯著影響結(jié)果,而較低的表示范圍則會(huì)顯著影響模型訓(xùn)練的好壞。此外,BF16 還具有轉(zhuǎn)換方便的特點(diǎn)

2022-12-23 16:02:46

怎樣從傳統(tǒng)機(jī)器學(xué)習(xí)方法過(guò)渡到深度學(xué)習(xí)?

2021-10-14 06:51:23

在BF518BF16頁(yè)面下找到的硬件參考手冊(cè)當(dāng)中,封面上寫(xiě)的是Includes ADSP-BF512, ADSP-BF514,ADSP-BF516, DSP-BF518,沒(méi)有包含518F16 ,也沒(méi)有勘誤表

請(qǐng)問(wèn)BF518的硬件參考手冊(cè)和BF518F16有區(qū)別嗎?

硬件參考手冊(cè)能使用同一個(gè)嗎?

2024-01-12 06:51:41

在BF518BF16頁(yè)面下找到的硬件參考手冊(cè)當(dāng)中,封面上寫(xiě)的是Includes ADSP-BF512, ADSP-BF514,ADSP-BF516, DSP-BF518,沒(méi)有包含518F16 ,也沒(méi)有勘誤表請(qǐng)問(wèn)BF518的硬件參考手冊(cè)和BF518F16有區(qū)別嗎?硬件參考手冊(cè)能使用同一個(gè)嗎?

2018-08-15 07:04:27

為深度和原格式代表什么意思?

2022-02-22 14:09:34

投影系統(tǒng)中的電源設(shè)計(jì)優(yōu)化體現(xiàn)在高強(qiáng)度放電 (HID) 或 LED 要求、功率因數(shù)校正以及能效方面。 TI 開(kāi)發(fā)的數(shù)字光投影儀 (DLP) 顯示技術(shù)采用光半導(dǎo)體來(lái)進(jìn)行數(shù)字化光處理。DLP 芯片

2011-09-26 16:29:25

應(yīng)該是最便于集成使用的深度學(xué)習(xí)框架庫(kù)。 tensorflow和mxnet據(jù)說(shuō)也有對(duì)應(yīng)的android庫(kù),因時(shí)間原因暫未。 CNNdroid,網(wǎng)址,這個(gè)是用 render 作優(yōu)化的深度學(xué)習(xí)框架,不過(guò)就代碼實(shí)現(xiàn)和實(shí)際測(cè)試結(jié)果來(lái)看,性能一般。 工程定位 實(shí)現(xiàn)可實(shí)時(shí)、體積小、通用的深度學(xué)習(xí)預(yù)測(cè)框架。

2017-09-28 20:02:26 0

0 超參數(shù)優(yōu)化是深度學(xué)習(xí)中的重要組成部分。其原因在于,神經(jīng)網(wǎng)絡(luò)是公認(rèn)的難以配置,而又有很多參數(shù)需要設(shè)置。最重要的是,個(gè)別模型的訓(xùn)練非常緩慢。 在這篇文章中,你會(huì)了解到如何使用scikit-learn

2017-09-30 16:22:16 2

2 學(xué)習(xí)每秒運(yùn)算次數(shù) (OPS) 上相比其它 FPGA,能實(shí)現(xiàn) 1.75 倍的峰值解決方案級(jí)性能。由于深度學(xué)習(xí)推斷可以在不犧牲準(zhǔn)確性的情況下使用較低位精度,因此需要高效的 INT8 實(shí)現(xiàn)方案

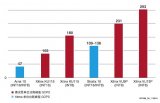

2017-11-16 14:23:01 14244

14244

為提高光伏出力的預(yù)測(cè)精度,提出了一種改進(jìn)深度學(xué)習(xí)算法的光伏出力預(yù)測(cè)方法。首先,針對(duì)傳統(tǒng)的深度學(xué)習(xí)算法采用批量梯度下降(batch gradient descent,BGD)法訓(xùn)練模型參數(shù)速度慢

2017-12-17 10:42:45 8

8 隨時(shí)間動(dòng)態(tài)變化的相似性指標(biāo)W_Katz;利用信息熵確定受限玻爾茲曼機(jī)的隱含層神經(jīng)元數(shù)量,構(gòu)建用于特征提取的深度學(xué)習(xí)模型,采用自適應(yīng)學(xué)習(xí)率縮短其收斂時(shí)間;采用高斯核函數(shù)、K折交叉驗(yàn)證構(gòu)造基于最小二乘支持向量回歸機(jī)的預(yù)測(cè)

2018-01-04 15:53:57 0

0 確定最佳深度可以降低運(yùn)算成本,同時(shí)可以進(jìn)一步提高精度。針對(duì)深度置信網(wǎng)絡(luò)深度選擇的問(wèn)題,文章分析了通過(guò)設(shè)定閾值方法選擇最佳深度的不足之處。

2018-04-04 15:46:00 3602

3602

使用電子健康記錄(EHR)數(shù)據(jù)的預(yù)測(cè)建模預(yù)計(jì)將推動(dòng)個(gè)人化醫(yī)療并提高醫(yī)療質(zhì)量。谷歌發(fā)布消息稱已經(jīng)開(kāi)源該協(xié)議緩沖區(qū)工具。谷歌FHIR標(biāo)準(zhǔn)協(xié)議利用深度學(xué)習(xí)預(yù)測(cè)醫(yī)療事件發(fā)生

2018-03-07 17:14:00 7819

7819

短期負(fù)荷預(yù)測(cè)的精度直接影響電力系統(tǒng)運(yùn)行的可靠性和供電質(zhì)量。提出一種基于粒子群優(yōu)化算法的最小二乘支持向量機(jī)短期負(fù)荷預(yù)測(cè)的模型和算法,對(duì)最小二乘支持向量機(jī)的參數(shù)尋優(yōu),再以測(cè)試集誤差作為判決依據(jù),對(duì)模型

2018-03-30 14:55:00 4

4 預(yù)測(cè)精度是電力負(fù)荷預(yù)測(cè)的重要指標(biāo)。為增強(qiáng)預(yù)測(cè)精度,提出基于小波變異果蠅優(yōu)化的支持向量機(jī)預(yù)測(cè)模型(WFOAAM-LSSVM)。利用小波對(duì)負(fù)荷數(shù)據(jù)進(jìn)行預(yù)處理,分解成不同尺度的負(fù)荷曲線,加強(qiáng)歷史數(shù)據(jù)規(guī)律性

2018-04-13 14:56:18 0

0 在本文中文小編將為大家詳細(xì)介紹16種GitHub中最受歡迎的深度學(xué)習(xí)開(kāi)源平臺(tái)和開(kāi)源庫(kù),除此之外,還有些比較不錯(cuò)的平臺(tái)和框架雖然沒(méi)有進(jìn)入榜單,文小編也列了出來(lái),供大家參考。

2018-05-10 12:13:00 1443

1443

華盛頓大學(xué)計(jì)算機(jī)系博士生陳天奇、以及上海交通大學(xué)和復(fù)旦大學(xué)的研究團(tuán)隊(duì)提出一個(gè)基于學(xué)習(xí)的框架,以優(yōu)化用于深度學(xué)習(xí)工作負(fù)載的張量程序。

2018-05-23 15:32:12 2204

2204

很多機(jī)器學(xué)習(xí)問(wèn)題是深度為2的子案例,例如,輸入層和輸出層之間的一個(gè)隱含層。通常假設(shè)網(wǎng)絡(luò)的結(jié)構(gòu)、數(shù)據(jù)分布,等等。比起GD/SGD,可以使用不同算法,例如張量分解、最小化交替以及凸優(yōu)化等等。

2018-07-12 09:25:28 7997

7997

bfloat16的主要想法是提供動(dòng)態(tài)范圍與標(biāo)準(zhǔn)IEEE-FP32相同的16位浮點(diǎn)格式,精度較低。相當(dāng)于將8位的FP32指數(shù)字段的大小匹配,并將FP32分數(shù)字段的大小縮小到7位。

2019-09-20 10:32:40 3905

3905 與計(jì)算機(jī)圖形不同,神經(jīng)網(wǎng)絡(luò)和其他深度學(xué)習(xí)模型不需要高精度浮點(diǎn)結(jié)果,并且通常由新一代人工智能優(yōu)化的GPU和支持低精度8位和16位矩陣計(jì)算的CPU進(jìn)一步加速,這種優(yōu)化可以將存儲(chǔ)系統(tǒng)轉(zhuǎn)變?yōu)楦蟮男阅芷款i。

2019-11-20 10:56:57 1977

1977 晶心科技今日宣布將攜手合作,在基于AndeStar? V5架構(gòu)的晶心RISC-V CPU核心上配置高度優(yōu)化的深度學(xué)習(xí)模型,使AI深度學(xué)習(xí)模型變得更輕巧、快速和節(jié)能。

2019-12-31 16:30:11 1002

1002 全新的數(shù)字格式——‘BF16’,專為人工智能(AI)/深度學(xué)習(xí)(DL)應(yīng)用優(yōu)化發(fā)展而來(lái),有時(shí)也稱為‘BFloat16’或‘Brain Float 16’。它一開(kāi)始是由Google Brain團(tuán)隊(duì)發(fā)明

2020-07-03 14:51:25 3374

3374 機(jī)器學(xué)習(xí)主要作用是分類、回歸、降維和聚類。在開(kāi)發(fā)指標(biāo)預(yù)測(cè)中主要是回歸和降維。機(jī)器學(xué)習(xí)的主要理論基礎(chǔ)就是使目標(biāo)函數(shù)最小化,而目標(biāo)函數(shù)主要由經(jīng)驗(yàn)風(fēng)險(xiǎn)和結(jié)構(gòu)風(fēng)險(xiǎn)組成。經(jīng)驗(yàn)風(fēng)險(xiǎn)就是預(yù)測(cè)值和真實(shí)觀測(cè)值的差異

2020-07-28 09:37:08 1099

1099 在深度學(xué)習(xí)中,有很多種優(yōu)化算法,這些算法需要在極高維度(通常參數(shù)有數(shù)百萬(wàn)個(gè)以上)也即數(shù)百萬(wàn)維的空間進(jìn)行梯度下降,從最開(kāi)始的初始點(diǎn)開(kāi)始,尋找最優(yōu)化的參數(shù),通常這一過(guò)程可能會(huì)遇到多種的情況

2020-08-28 09:52:45 2268

2268

深度學(xué)習(xí)是機(jī)器學(xué)習(xí)與神經(jīng)網(wǎng)絡(luò)、人工智能、圖形化建模、優(yōu)化、模式識(shí)別和信號(hào)處理等技術(shù)融合后產(chǎn)生的一個(gè)領(lǐng)域。

2020-11-05 09:31:19 4711

4711 決這個(gè)問(wèn)題,愛(ài)奇藝深度學(xué)習(xí)平臺(tái)團(tuán)隊(duì)經(jīng)過(guò)多個(gè)階段的優(yōu)化實(shí)踐,最后對(duì) TF Serving 和 TensorFlow 的源碼進(jìn)行深入優(yōu)化,將模型熱更新時(shí)的毛刺現(xiàn)象解決,本文將分享 TensorFlow

2020-12-17 16:48:47 3930

3930 早期的機(jī)器學(xué)習(xí)以搜索為基礎(chǔ),主要依靠進(jìn)行過(guò)一定優(yōu)化的暴力方法。但是隨著機(jī)器學(xué)習(xí)逐漸成熟,它開(kāi)始專注于加速技術(shù)已經(jīng)很成熟的統(tǒng)計(jì)方法和優(yōu)化問(wèn)題。同時(shí)深度學(xué)習(xí)的問(wèn)世更是帶來(lái)原本可能無(wú)法實(shí)現(xiàn)的優(yōu)化方法。本文

2021-02-26 06:11:43 5

5 深度模型中的優(yōu)化與學(xué)習(xí)課件下載

2021-04-07 16:21:01 3

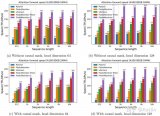

3 在線社交媒體極大地促進(jìn)了信息的產(chǎn)生和傳遞,加速了海量信息之間的傳播與交互,使預(yù)測(cè)信息級(jí)聯(lián)的重要性逐漸突顯。近年來(lái),深度學(xué)習(xí)已經(jīng)被廣泛用于信息級(jí)聯(lián)預(yù)測(cè)( Information Cascade

2021-05-18 15:28:21 9

9 具有深度學(xué)習(xí)模型的嵌入式系統(tǒng)應(yīng)用程序帶來(lái)了巨大的好處。深度學(xué)習(xí)嵌入式系統(tǒng)已經(jīng)改變了各個(gè)行業(yè)的企業(yè)和組織。深度學(xué)習(xí)模型可以幫助實(shí)現(xiàn)工業(yè)流程自動(dòng)化,進(jìn)行實(shí)時(shí)分析以做出決策,甚至可以預(yù)測(cè)預(yù)警。這些AI

2021-10-20 19:05:58 42

42 , GBRT)等簡(jiǎn)單機(jī)器學(xué)習(xí)模型,而且增強(qiáng)了這樣一種預(yù)期,即機(jī)器學(xué)習(xí)領(lǐng)域的時(shí)間序列預(yù)測(cè)模型需要以深度學(xué)習(xí)工作為基礎(chǔ),才能得到 SOTA 結(jié)果。

2022-03-24 13:59:24 1450

1450 學(xué)習(xí)中的“深度”一詞表示用于識(shí)別數(shù)據(jù)模式的多層算法或神經(jīng)網(wǎng)絡(luò)。DL 高度靈活的架構(gòu)可以直接從原始數(shù)據(jù)中學(xué)習(xí),這類似于人腦的運(yùn)作方式,獲得更多數(shù)據(jù)后,其預(yù)測(cè)準(zhǔn)確度也將隨之提升。? ? 此外,深度學(xué)習(xí)是在語(yǔ)音識(shí)別、語(yǔ)言翻譯和

2022-04-01 10:34:10 8694

8694 深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一個(gè)子集,它使用神經(jīng)網(wǎng)絡(luò)來(lái)執(zhí)行學(xué)習(xí)和預(yù)測(cè)。深度學(xué)習(xí)在各種任務(wù)中都表現(xiàn)出了驚人的表現(xiàn),無(wú)論是文本、時(shí)間序列還是計(jì)算機(jī)視覺(jué)。

2022-04-07 10:17:05 1380

1380 DeepRec 集成了英特爾開(kāi)源的跨平臺(tái)深度學(xué)習(xí)性能加速庫(kù)oneDNN (oneAPI Deep Neural Network Library),該程序庫(kù)已經(jīng)針對(duì)大量主流算子實(shí)現(xiàn)了性能優(yōu)化。與搭載 BF16 指令的第三代英特爾 至強(qiáng) 可擴(kuò)展處理器同時(shí)使用,可顯著提高模型訓(xùn)練和推理性能。

2022-07-10 10:56:19 864

864 摘要:針對(duì)在氣液兩相流中難以進(jìn)行穩(wěn)態(tài)分析,無(wú)法對(duì)氣泡末速度進(jìn)行精準(zhǔn)預(yù)測(cè)的問(wèn)題,提出一種基于深度學(xué)習(xí)的氣泡末速度預(yù)測(cè)方法。首先,搭建了一套高速相機(jī)采集系統(tǒng)獲取氣泡圖像,利用圖像處理技術(shù)和橢圓擬合

2022-11-08 17:01:48 616

616 ,尤其是深度學(xué)習(xí)的推理,將會(huì)成為優(yōu)化的重點(diǎn)。在此因素影響下,阿里云平頭哥團(tuán)隊(duì)推出了全球首個(gè)5nm 制程的 ARM Server 芯片倚天710。該芯片基于 ARM Neoverse N2 架構(gòu),支持最新的 ARMv9 指令集,其中包括 i8mm,bf16等擴(kuò)展指令集,能在科學(xué)/AI計(jì)算領(lǐng)域獲得性能優(yōu)勢(shì)。

2022-11-25 10:33:31 1097

1097 電子發(fā)燒友網(wǎng)站提供《癲癇發(fā)作預(yù)測(cè)可穿戴設(shè)備的深度學(xué)習(xí).zip》資料免費(fèi)下載

2022-12-12 14:01:44 0

0 先大致講一下什么是深度學(xué)習(xí)中優(yōu)化算法吧,我們可以把模型比作函數(shù),一種很復(fù)雜的函數(shù):h(f(g(k(x)))),函數(shù)有參數(shù),這些參數(shù)是未知的,深度學(xué)習(xí)中的“學(xué)習(xí)”就是通過(guò)訓(xùn)練數(shù)據(jù)求解這些未知的參數(shù)。

2023-02-13 15:31:48 1019

1019

深度學(xué)習(xí)可以學(xué)習(xí)視覺(jué)輸入的模式,以預(yù)測(cè)組成圖像的對(duì)象類。用于圖像處理的主要深度學(xué)習(xí)架構(gòu)是卷積神經(jīng)網(wǎng)絡(luò)(CNN),或者是特定的CNN框架,如AlexNet、VGG、Inception和ResNet。計(jì)算機(jī)視覺(jué)的深度學(xué)習(xí)模型通常在專門的圖形處理單元(GPU)上訓(xùn)練和執(zhí)行,以減少計(jì)算時(shí)間。

2023-05-05 11:35:28 729

729 早期的機(jī)器學(xué)習(xí)以搜索為基礎(chǔ),主要依靠進(jìn)行過(guò)一定優(yōu)化的暴力方法。但是隨著機(jī)器學(xué)習(xí)逐漸成熟,它開(kāi)始專注于加速技術(shù)已經(jīng)很成熟的統(tǒng)計(jì)方法和優(yōu)化問(wèn)題。同時(shí)深度學(xué)習(xí)的問(wèn)世更是帶來(lái)原本可能無(wú)法實(shí)現(xiàn)的優(yōu)化方法。本文將介紹現(xiàn)代機(jī)器學(xué)習(xí)如何找到兼顧規(guī)模和速度的新方法。

2023-05-09 09:58:33 540

540 繼續(xù)深度學(xué)習(xí)編譯器的優(yōu)化工作解讀,本篇文章要介紹的是OneFlow系統(tǒng)中如何基于MLIR實(shí)現(xiàn)Layerout Transform。

2023-05-18 17:32:42 389

389 電子發(fā)燒友網(wǎng)站提供《PyTorch教程12.1之優(yōu)化和深度學(xué)習(xí).pdf》資料免費(fèi)下載

2023-06-05 15:08:41 0

0 目標(biāo)上的標(biāo)志。

12.1.1。優(yōu)化目標(biāo)?

盡管優(yōu)化為深度學(xué)習(xí)提供了一種最小化損失函數(shù)的方法,但從本質(zhì)上講,優(yōu)化和深度學(xué)習(xí)的目標(biāo)是根本不同的。前

2023-06-05 15:44:30 327

327

優(yōu)化算法一直以來(lái)是機(jī)器學(xué)習(xí)能根據(jù)數(shù)據(jù)學(xué)到知識(shí)的核心技術(shù)。而好的優(yōu)化算法可以大大提高學(xué)習(xí)速度,加快算法的收斂速度和效果。該論文從淺層模型到深度模型縱覽監(jiān)督學(xué)習(xí)中常用的優(yōu)化算法,并指出了每一種優(yōu)化算法

2023-06-15 11:20:22 395

395

深度學(xué)習(xí)是什么領(lǐng)域? 深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一種子集,由多層神經(jīng)網(wǎng)絡(luò)組成。它是一種自動(dòng)學(xué)習(xí)技術(shù),可以從數(shù)據(jù)中學(xué)習(xí)高層次的抽象模型,以進(jìn)行推斷和預(yù)測(cè)。深度學(xué)習(xí)廣泛應(yīng)用于計(jì)算機(jī)視覺(jué)、語(yǔ)音識(shí)別、自然語(yǔ)言處理

2023-08-17 16:02:59 995

995 什么是深度學(xué)習(xí)算法?深度學(xué)習(xí)算法的應(yīng)用 深度學(xué)習(xí)算法被認(rèn)為是人工智能的核心,它是一種模仿人類大腦神經(jīng)元的計(jì)算模型。深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一種變體,主要通過(guò)變換各種架構(gòu)來(lái)對(duì)大量數(shù)據(jù)進(jìn)行學(xué)習(xí)以及分類處理

2023-08-17 16:03:04 1305

1305 高模型的精度和性能。隨著人工智能和機(jī)器學(xué)習(xí)的迅猛發(fā)展,深度學(xué)習(xí)框架已成為了研究和開(kāi)發(fā)人員們必備的工具之一。 目前,市場(chǎng)上存在許多深度學(xué)習(xí)框架可供選擇。本文將為您介紹一些較為常見(jiàn)的深度學(xué)習(xí)框架,并探究它們的特點(diǎn)

2023-08-17 16:03:09 1589

1589 深度學(xué)習(xí)框架的作用是什么 深度學(xué)習(xí)是一種計(jì)算機(jī)技術(shù),它利用人工神經(jīng)網(wǎng)絡(luò)來(lái)模擬人類的學(xué)習(xí)過(guò)程。由于其高度的精確性和精度,深度學(xué)習(xí)已成為現(xiàn)代計(jì)算機(jī)科學(xué)領(lǐng)域的重要工具。然而,要在深度學(xué)習(xí)中實(shí)現(xiàn)高度復(fù)雜

2023-08-17 16:10:57 1072

1072 深度學(xué)習(xí)框架連接技術(shù) 深度學(xué)習(xí)框架是一個(gè)能夠幫助機(jī)器學(xué)習(xí)和人工智能開(kāi)發(fā)人員輕松進(jìn)行模型訓(xùn)練、優(yōu)化及評(píng)估的軟件庫(kù)。深度學(xué)習(xí)框架連接技術(shù)則是需要使用深度學(xué)習(xí)模型的應(yīng)用程序必不可少的技術(shù),通過(guò)連接技術(shù)

2023-08-17 16:11:16 443

443 了基于神經(jīng)網(wǎng)絡(luò)的機(jī)器學(xué)習(xí)方法。 深度學(xué)習(xí)算法可以分為兩大類:監(jiān)督學(xué)習(xí)和無(wú)監(jiān)督學(xué)習(xí)。監(jiān)督學(xué)習(xí)的基本任務(wù)是訓(xùn)練模型去學(xué)習(xí)輸入數(shù)據(jù)的特征和其對(duì)應(yīng)的標(biāo)簽,然后用于新數(shù)據(jù)的預(yù)測(cè)。而無(wú)監(jiān)督學(xué)習(xí)通常用于聚類、降維和生成模型等任務(wù)中

2023-08-17 16:11:26 638

638 機(jī)器學(xué)習(xí)和深度學(xué)習(xí)的區(qū)別 隨著人工智能技術(shù)的不斷發(fā)展,機(jī)器學(xué)習(xí)和深度學(xué)習(xí)已經(jīng)成為大家熟知的兩個(gè)術(shù)語(yǔ)。雖然它們都屬于人工智能技術(shù)的研究領(lǐng)域,但它們之間有很大的差異。本文將詳細(xì)介紹機(jī)器學(xué)習(xí)和深度學(xué)習(xí)

2023-08-17 16:11:40 2734

2734 機(jī)器學(xué)習(xí)和深度學(xué)習(xí)是當(dāng)今最流行的人工智能(AI)技術(shù)之一。這兩種技術(shù)都有助于在不需要人類干預(yù)的情況下讓計(jì)算機(jī)自主學(xué)習(xí)和改進(jìn)預(yù)測(cè)模型。本文將探討機(jī)器學(xué)習(xí)和深度學(xué)習(xí)的概念以及二者之間的區(qū)別。

2023-08-28 17:31:09 891

891 【深度測(cè)評(píng)】HPM6750 MCU片內(nèi)16位ADC精度測(cè)試

2023-10-30 17:43:18 1654

1654

一、引言 隨著深度學(xué)習(xí)技術(shù)的快速發(fā)展,其在語(yǔ)音識(shí)別領(lǐng)域的應(yīng)用也日益廣泛。深度學(xué)習(xí)技術(shù)可以有效地提高語(yǔ)音識(shí)別的精度和效率,并且被廣泛應(yīng)用于各種應(yīng)用場(chǎng)景。本文將探討深度學(xué)習(xí)在語(yǔ)音識(shí)別中的應(yīng)用及所面臨

2023-10-10 18:14:53 449

449 基于深度學(xué)習(xí)的情感語(yǔ)音識(shí)別模型的優(yōu)化策略,包括數(shù)據(jù)預(yù)處理、模型結(jié)構(gòu)優(yōu)化、損失函數(shù)改進(jìn)、訓(xùn)練策略調(diào)整以及集成學(xué)習(xí)等方面的內(nèi)容。

2023-11-09 16:34:14 227

227 GPU performance characteristics. GPU主要計(jì)算單元(如浮點(diǎn)運(yùn)算單元)和內(nèi)存層次結(jié)構(gòu)。大多數(shù)現(xiàn)代GPU包含專用的低精度矩陣乘法單元(如Nvidia GPU的Tensor Core用于FP16/BF16矩陣乘法)。

2023-11-24 16:21:07 423

423

Hello大家好,今天給大家分享一下如何基于深度學(xué)習(xí)模型訓(xùn)練實(shí)現(xiàn)圓檢測(cè)與圓心位置預(yù)測(cè),主要是通過(guò)對(duì)YOLOv8姿態(tài)評(píng)估模型在自定義的數(shù)據(jù)集上訓(xùn)練,生成一個(gè)自定義的圓檢測(cè)與圓心定位預(yù)測(cè)模型

2023-12-21 10:50:05 529

529

Hello大家好,今天給大家分享一下如何基于深度學(xué)習(xí)模型訓(xùn)練實(shí)現(xiàn)工件切割點(diǎn)位置預(yù)測(cè),主要是通過(guò)對(duì)YOLOv8姿態(tài)評(píng)估模型在自定義的數(shù)據(jù)集上訓(xùn)練,生成一個(gè)工件切割分離點(diǎn)預(yù)測(cè)模型

2023-12-22 11:07:46 259

259

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論