據(jù)科技博客TechCrunch北京時(shí)間8月17日?qǐng)?bào)道,英特爾公司想要把更多人工智能(AI)技術(shù)整合到各項(xiàng)業(yè)務(wù)中,該公司在周四宣布收購(gòu)深度學(xué)習(xí)創(chuàng)業(yè)公司Vertex.AI。Vertex.AI的使命

2018-08-17 09:31:42 3874

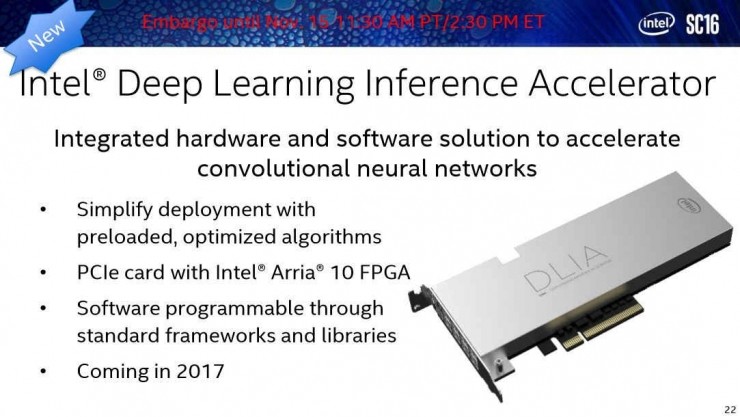

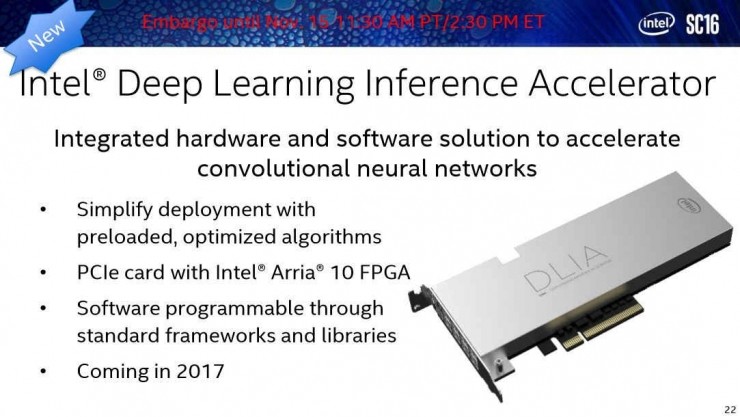

3874 在今年的世界超算大會(huì) SC16 上, Intel 發(fā)布了針對(duì) AI 開發(fā)者的深度學(xué)習(xí)推理加速器,對(duì)卷積神經(jīng)網(wǎng)絡(luò)的計(jì)算提供更強(qiáng)大支持。

2016-11-18 14:17:23 610

610

這款加速卡主力服務(wù)于深度學(xué)習(xí)領(lǐng)域,16位半精度浮點(diǎn)25TFLOPs,32位單精度浮點(diǎn)12.5 TFLOPs,熱設(shè)計(jì)功耗低于300W。

2016-12-13 16:33:37 904

904 的關(guān)注度也隨之下降。二十一世紀(jì)初期,計(jì)算機(jī)的運(yùn)算能力呈指數(shù)級(jí)增長(zhǎng),業(yè)界也見證了計(jì)算機(jī)技術(shù)發(fā)展的“寒武紀(jì)爆炸”——這在之前都是無法想象的。深度學(xué)習(xí)以一個(gè)競(jìng)爭(zhēng)者的姿態(tài)出現(xiàn),在計(jì)算能力爆炸式增長(zhǎng)的十年

2019-03-07 20:17:28

一:深度學(xué)習(xí)DeepLearning實(shí)戰(zhàn)時(shí)間地點(diǎn):1 月 15日— 1 月18 日二:深度強(qiáng)化學(xué)習(xí)核心技術(shù)實(shí)戰(zhàn)時(shí)間地點(diǎn): 1 月 27 日— 1 月30 日(第一天報(bào)到 授課三天;提前環(huán)境部署 電腦

2021-01-09 17:01:54

未來的某個(gè)時(shí)候,人們必定能夠相對(duì)自如地運(yùn)用人工智能,安全地駕車出行。這個(gè)時(shí)刻何時(shí)到來我無法預(yù)見;但我相信,彼時(shí)“智能”會(huì)顯現(xiàn)出更“切實(shí)”的意義。與此同時(shí),通過深度學(xué)習(xí)方法,人工智能的實(shí)際應(yīng)用能夠在汽車

2019-03-13 06:45:03

簡(jiǎn)單的回顧的話,2006年Geoffrey Hinton的論文點(diǎn)燃了“這把火”,現(xiàn)在已經(jīng)有不少人開始潑“冷水”了,主要是AI泡沫太大,而且深度學(xué)習(xí)不是包治百病的藥方。計(jì)算機(jī)視覺不是深度學(xué)習(xí)最早看到

2021-07-28 08:22:12

深度學(xué)習(xí)常用模型有哪些?深度學(xué)習(xí)常用軟件工具及平臺(tái)有哪些?深度學(xué)習(xí)存在哪些問題?

2021-10-14 08:20:47

摘要與深度學(xué)習(xí)算法的進(jìn)步超越硬件的進(jìn)步,你如何確保算法明天是一個(gè)很好的適合現(xiàn)有的人工智能芯片下發(fā)展?,這些人工智能芯片大多是為今天的人工智能算法算法進(jìn)化,這些人工智能芯片的許多設(shè)計(jì)都可能成為甚至在

2020-11-01 09:28:57

CPU優(yōu)化深度學(xué)習(xí)框架和函數(shù)庫(kù)機(jī)器學(xué)***器

2021-02-22 06:01:02

具有深度學(xué)習(xí)模型的嵌入式系統(tǒng)應(yīng)用程序帶來了巨大的好處。深度學(xué)習(xí)嵌入式系統(tǒng)已經(jīng)改變了各個(gè)行業(yè)的企業(yè)和組織。深度學(xué)習(xí)模型可以幫助實(shí)現(xiàn)工業(yè)流程自動(dòng)化,進(jìn)行實(shí)時(shí)分析以做出決策,甚至可以預(yù)測(cè)預(yù)警。這些AI

2021-10-27 06:34:15

非常適合加速深度學(xué)習(xí)矩陣乘法運(yùn)算,其中使用 BF16 浮點(diǎn)數(shù)格式進(jìn)行乘法運(yùn)算并使用 32 位 IEEE 浮點(diǎn)數(shù)進(jìn)行累加。[Arm 在2019 年 Arm 架構(gòu)更新]中引入了新的 BF16 指令,以提高

2022-08-31 15:03:46

針對(duì)神經(jīng)網(wǎng)絡(luò)高性能處理引進(jìn)的浮點(diǎn)數(shù)格式。Armv8.6-A增加了利用BF16浮點(diǎn)數(shù)格式加速特定運(yùn)算的指令。更多有關(guān)arm BF16支持的信息可以在這個(gè)神經(jīng)網(wǎng)絡(luò)的帖子找到。虛擬化和系統(tǒng)管理相關(guān)的增強(qiáng)虛擬化

2022-07-29 15:29:42

基礎(chǔ)設(shè)施,人們?nèi)匀粵]有定論。如果 Mipsology 成功完成了研究實(shí)驗(yàn),許多正受 GPU 折磨的 AI 開發(fā)者將從中受益。

GPU 深度學(xué)習(xí)面臨的挑戰(zhàn)

三維圖形是 GPU 擁有如此大的內(nèi)存和計(jì)算能力

2024-03-21 15:19:45

MCU中雙精度浮點(diǎn)數(shù)是用什么格式存儲(chǔ)的

2023-10-11 06:24:11

在此附上NVIDIA深度學(xué)習(xí)亞太區(qū)相關(guān)職位的招聘信息,有意向或想查看詳細(xì)工作說明的朋友歡迎發(fā)送英文簡(jiǎn)歷或來信至 allelin@nvidia.com Wechat :hrallenlin 目前熱招

2017-08-25 17:04:24

學(xué)習(xí),也就是現(xiàn)在最流行的深度學(xué)習(xí)領(lǐng)域,關(guān)注論壇的朋友應(yīng)該看到了,開發(fā)板試用活動(dòng)中有【NanoPi K1 Plus試用】的申請(qǐng),介紹中NanopiK1plus的高大上優(yōu)點(diǎn)之一就是“可運(yùn)行深度學(xué)習(xí)算法的智能

2018-06-04 22:32:12

Tir-RK3399+movidius是什么呢?Tir-RK3399+movidius AI深度學(xué)習(xí)評(píng)估板有哪些性能呢?RK3399的板卡配置主要有哪幾點(diǎn)呢?

2022-03-07 07:51:05

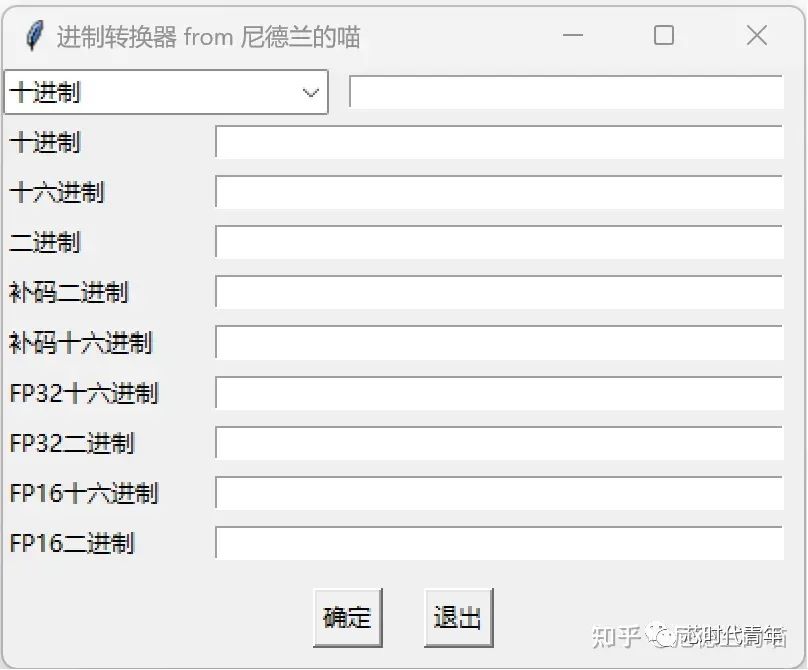

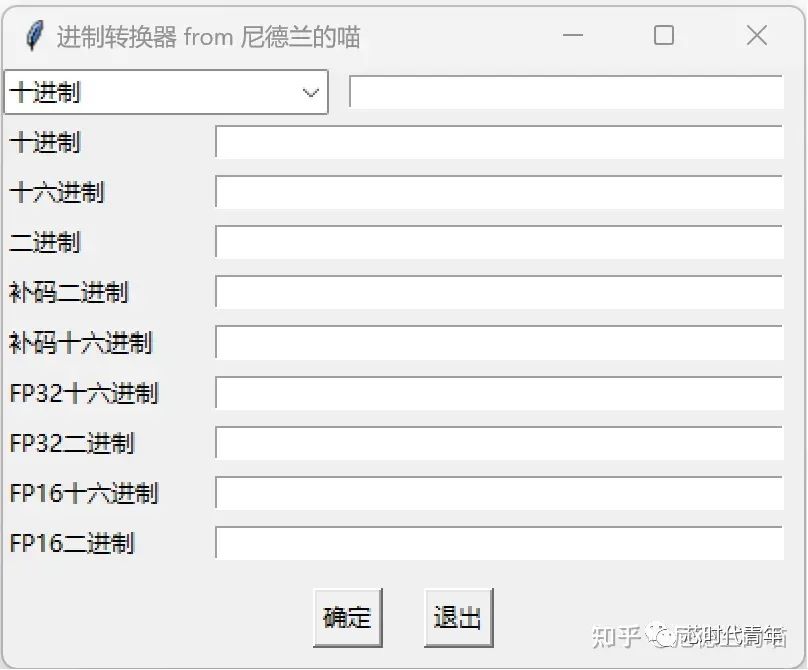

在下現(xiàn)在在用labview做一個(gè)通訊協(xié)議,在發(fā)送命令時(shí)需要將單精度浮點(diǎn)型轉(zhuǎn)化為16進(jìn)制,在接收命令時(shí)需要將16進(jìn)制轉(zhuǎn)換成單精度浮點(diǎn)數(shù),想了好久都不對(duì),請(qǐng)大神幫忙寫兩份子vi供在下參考,謝謝

2018-03-12 22:46:37

算法。其編程特點(diǎn)是上手快,開發(fā)效率高,兼容性強(qiáng),能快速調(diào)用c++,c#等平臺(tái)的dll類庫(kù)。如何將labview與深度學(xué)習(xí)結(jié)合起來,來解決視覺行業(yè)越來越復(fù)雜的應(yīng)用場(chǎng)景所遇到的困難。下面以開關(guān)面板為例講解

2020-07-23 20:33:10

AI系統(tǒng)基礎(chǔ)上擴(kuò)展接口1 擴(kuò)展的必要性FZ3深度學(xué)習(xí)板卡裝載了AI系統(tǒng),但是其數(shù)據(jù)僅僅只能在該系統(tǒng)內(nèi)部,缺乏與外界交流的媒介,無法將自身寶貴的數(shù)據(jù)傳遞給外界,盡管現(xiàn)有的系統(tǒng)以及百度AI系統(tǒng)自身已經(jīng)

2020-12-29 09:58:07

本帖最后由 卿小小_9e6 于 2021-4-11 16:16 編輯

【米爾百度大腦EdgeBoard邊緣AI計(jì)算盒試用連載】III. 板載深度學(xué)習(xí)DEMO-detection測(cè)試-下(ZMJ

2021-04-11 16:17:13

不斷變化的,因此深度學(xué)習(xí)是人工智能AI的重要組成部分。可以說人腦視覺系統(tǒng)和神經(jīng)網(wǎng)絡(luò)。2、目標(biāo)檢測(cè)、目標(biāo)跟蹤、圖像增強(qiáng)、強(qiáng)化學(xué)習(xí)、模型壓縮、視頻理解、人臉技術(shù)、三維視覺、SLAM、GAN、GNN等。

2020-11-27 11:54:42

介紹:人工智能AI到來,工業(yè)上很多學(xué)員不了解C#中l(wèi)abview中如何調(diào)用tensorflow進(jìn)行深度學(xué)習(xí)模型的訓(xùn)練和調(diào)用,推出一整套完整的簡(jiǎn)易學(xué)的視頻課程,使學(xué)員能在沒有任何深度學(xué)習(xí)理論基礎(chǔ),不懂

2020-11-27 11:19:37

深度學(xué)習(xí)是什么意思

2020-11-11 06:58:03

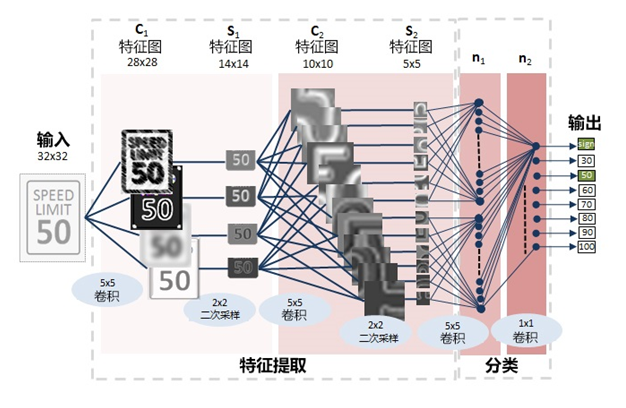

什么是深度學(xué)習(xí)為了解釋深度學(xué)習(xí),有必要了解神經(jīng)網(wǎng)絡(luò)。神經(jīng)網(wǎng)絡(luò)是一種模擬人腦的神經(jīng)元和神經(jīng)網(wǎng)絡(luò)的計(jì)算模型。作為具體示例,讓我們考慮一個(gè)輸入圖像并識(shí)別圖像中對(duì)象類別的示例。這個(gè)例子對(duì)應(yīng)機(jī)器學(xué)習(xí)中的分類

2023-02-17 16:56:59

學(xué)習(xí)訓(xùn)練平臺(tái)思路編寫獲取目錄子vi16.labview深度學(xué)習(xí)訓(xùn)練平臺(tái)-創(chuàng)建目錄子vi17.labview深度學(xué)習(xí)訓(xùn)練平臺(tái)-生成csv和生成bat文件18.labview深度學(xué)習(xí)訓(xùn)練平臺(tái)

2020-08-10 10:38:12

行業(yè)圍繞一種 8 位浮點(diǎn)格式合并的好處,使開發(fā)人員能夠?qū)W⒂谡嬲匾膭?chuàng)新和差異化。我們很高興看到 FP8 在未來如何推動(dòng) AI 開發(fā)。原作者:尼爾·伯吉斯、Sangwon Ha

2022-09-15 15:15:46

語言使用,數(shù)學(xué)庫(kù)、數(shù)據(jù)結(jié)構(gòu)及相關(guān)算法,深入學(xué)習(xí)AI算法模型訓(xùn)練、分析,神經(jīng)網(wǎng)絡(luò)、機(jī)器學(xué)習(xí)、深度學(xué)習(xí)等因此,為了幫助大家更好的入門學(xué)習(xí)AI人工智能,包括:Python語法編程、數(shù)據(jù)結(jié)構(gòu)與算法、機(jī)器學(xué)習(xí)

2019-11-27 12:10:39

。K510是嘉楠公司推出的第二代AI加速芯片,它采用雙核RISC-V CPU@800Mhz,內(nèi)置DSP協(xié)處理器和強(qiáng)大的AI運(yùn)算單元KPU,支持 BF16浮點(diǎn)數(shù)據(jù)格式,可在邊緣端進(jìn)行高精度推理,是國(guó)內(nèi)少有

2022-11-22 15:52:15

傳統(tǒng)認(rèn)知中,人工智能(AI)相關(guān)的深度學(xué)習(xí)應(yīng)用,只有算力充沛的MPU或者是PC才能玩得轉(zhuǎn)。可你是否想過,在一顆通用MCU上也能暢玩深度學(xué)習(xí)?這不是天方夜譚,NXP的工程師就在一個(gè)用例中,...

2021-07-20 06:51:32

Python之GUI:基于Python的GUI界面設(shè)計(jì)的一套AI課程學(xué)習(xí)(機(jī)器學(xué)習(xí)、深度學(xué)習(xí)、大數(shù)據(jù)、云計(jì)算等)推薦系統(tǒng)(包括語音生成、識(shí)別等前沿黑科技)

2018-12-28 10:08:31

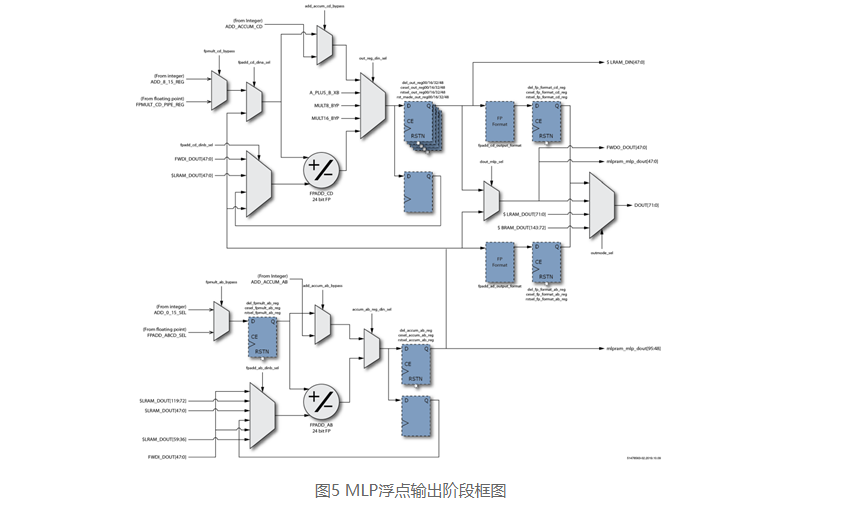

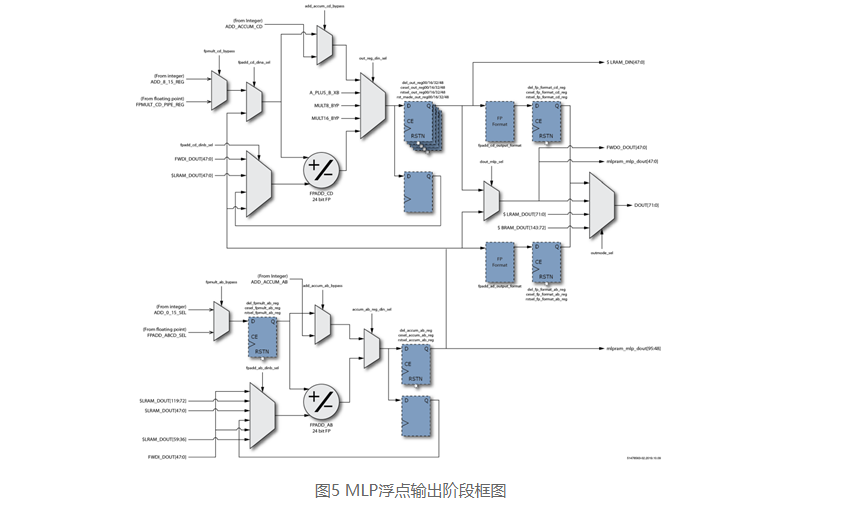

MLP72,使用MLP內(nèi)部的級(jí)聯(lián)路徑連接。每個(gè)MLP72將兩個(gè)并行乘法的結(jié)果相加(即aibi+ai+1bi+1),每個(gè)乘法都是i_a輸入乘以i_b輸入(均為FP16格式)的結(jié)果。來自每個(gè)MLP72的總和沿著

2020-08-18 10:58:30

本文由回映電子整理分享,歡迎工程老獅們參與學(xué)習(xí)與評(píng)論內(nèi)容? 射頻系統(tǒng)中的深度學(xué)習(xí)? Deepwave Digital技術(shù)? 信號(hào)檢測(cè)和分類示例? GPU的實(shí)時(shí)DSP基準(zhǔn)測(cè)試? 總結(jié)回映電子是一家

2022-01-05 10:00:58

如果在沒有嵌入式處理器供應(yīng)商提供的合適工具和軟件的支持下,既想設(shè)計(jì)高能效的邊緣人工智能(AI)系統(tǒng),同時(shí)又要加快產(chǎn)品上市時(shí)間,這項(xiàng)工作難免會(huì)冗長(zhǎng)乏味。面臨的一系列挑戰(zhàn)包括選擇恰當(dāng)?shù)?b class="flag-6" style="color: red">深度學(xué)習(xí)模型

2022-11-03 06:53:28

。 Achronix為了解決這一大困境,創(chuàng)新地設(shè)計(jì)了機(jī)器學(xué)習(xí)處理器(MLP)單元,不僅支持浮點(diǎn)的乘加運(yùn)算,還可以支持對(duì)多種定浮點(diǎn)數(shù)格式進(jìn)行拆分。

2020-11-26 06:42:00

FZ3 深度學(xué)習(xí)計(jì)算卡是米爾電子推出的一款以 Xilinx XCZU3EG 作為核心的嵌入式智能 AI 開發(fā)平臺(tái)。采用了 Xilinx 最新的基于 16nm 工藝的 Xilinx Zynq

2020-10-09 10:21:45

的 AI 推理算力呢?我們首先要了解 BF16 數(shù)據(jù)類型。BF16(全稱 Brain Floating Point),是由 Google Brain 開發(fā)設(shè)計(jì)的 16 位浮點(diǎn)數(shù)格式。相比傳統(tǒng)的 FP16

2022-12-23 16:02:46

怎樣從傳統(tǒng)機(jī)器學(xué)習(xí)方法過渡到深度學(xué)習(xí)?

2021-10-14 06:51:23

28335支持浮點(diǎn)運(yùn)算,我想既然支持,那么浮點(diǎn)的運(yùn)算速度至少應(yīng)該和定點(diǎn)的運(yùn)算速度差不多,可是經(jīng)過測(cè)試,浮點(diǎn)的除法運(yùn)算速度大概只有定點(diǎn)運(yùn)算速度的一半,乘法基本上一樣。問:運(yùn)行浮點(diǎn)格式時(shí)是不是需要某些

2018-11-15 09:43:37

在BF518BF16頁(yè)面下找到的硬件參考手冊(cè)當(dāng)中,封面上寫的是Includes ADSP-BF512, ADSP-BF514,ADSP-BF516, DSP-BF518,沒有包含518F16 ,也沒有勘誤表

請(qǐng)問BF518的硬件參考手冊(cè)和BF518F16有區(qū)別嗎?

硬件參考手冊(cè)能使用同一個(gè)嗎?

2024-01-12 06:51:41

在BF518BF16頁(yè)面下找到的硬件參考手冊(cè)當(dāng)中,封面上寫的是Includes ADSP-BF512, ADSP-BF514,ADSP-BF516, DSP-BF518,沒有包含518F16 ,也沒有勘誤表請(qǐng)問BF518的硬件參考手冊(cè)和BF518F16有區(qū)別嗎?硬件參考手冊(cè)能使用同一個(gè)嗎?

2018-08-15 07:04:27

請(qǐng)問一下什么是深度學(xué)習(xí)?

2021-08-30 07:35:21

為深度和原格式代表什么意思?

2022-02-22 14:09:34

功能:浮點(diǎn)BCD碼轉(zhuǎn)換成格式化浮點(diǎn)數(shù)

入口條件:浮點(diǎn)BCD碼操作數(shù)在[R0]中。出口信息:轉(zhuǎn)換成的格式化浮點(diǎn)數(shù)仍在[R0]中。影響資

2009-01-19 22:51:54 2194

2194 浮點(diǎn)DSP,浮點(diǎn)DSP是什么意思

浮點(diǎn)DSP可以完成整數(shù)和實(shí)數(shù)運(yùn)算,它的數(shù)據(jù)格式分為階碼和尾數(shù)(有一位可以設(shè)為符號(hào)位)。通常浮點(diǎn)DSP的

2010-03-26 14:57:01 2269

2269 在了解阿里云人工智能機(jī)器人小Ai的基本運(yùn)作過程后,筆者認(rèn)為小Ai的算法其實(shí)已經(jīng)不僅是深度學(xué)習(xí),而是在深度學(xué)習(xí)之上的更高階算法,并就此向阿里云人工智能科學(xué)家閔萬里求證,得到的回復(fù):是的。

2016-08-12 17:56:12 1856

1856 深度學(xué)習(xí)技術(shù) 這一輪AI的技術(shù)突破,主要源于深度學(xué)習(xí)技術(shù),而關(guān)于AI和深度學(xué)習(xí)的發(fā)展歷史我們這里不重復(fù)講述,可自行查閱。我用了一個(gè)多月的業(yè)務(wù)時(shí)間,去了解和學(xué)習(xí)了深度學(xué)習(xí)技術(shù),在這里,我嘗試以一名業(yè)務(wù)

2017-09-30 14:35:19 2

2 如今,人工智能的應(yīng)用越來越廣泛。機(jī)器學(xué)習(xí)和深度學(xué)習(xí)這兩個(gè)術(shù)語也隨之出現(xiàn),而機(jī)器學(xué)習(xí)與深度學(xué)習(xí)并不是非此即彼的排斥關(guān)系。深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一個(gè)子集,而這兩者都是人工智能(AI)的子集。

2018-01-18 16:23:18 5569

5569 在本文中文小編將為大家詳細(xì)介紹16種GitHub中最受歡迎的深度學(xué)習(xí)開源平臺(tái)和開源庫(kù),除此之外,還有些比較不錯(cuò)的平臺(tái)和框架雖然沒有進(jìn)入榜單,文小編也列了出來,供大家參考。

2018-05-10 12:13:00 1443

1443

MACE,是指小米公司自研的移動(dòng)端深度學(xué)習(xí)框架Mobile AI Compute Engine。2017年12月,這一深度學(xué)習(xí)框架就在小米公司內(nèi)部正式發(fā)布了。

2018-07-26 14:06:46 3502

3502 MACE,是指小米公司自研的移動(dòng)端深度學(xué)習(xí)框架Mobile AI Compute Engine。2017年12月,這一深度學(xué)習(xí)框架就在小米公司內(nèi)部正式發(fā)布了。

2018-07-26 14:06:46 4715

4715 本深度學(xué)習(xí)是什么?了解深度學(xué)習(xí)難嗎?讓你快速了解深度學(xué)習(xí)的視頻講解本文檔視頻讓你4分鐘快速了解深度學(xué)習(xí)

深度學(xué)習(xí)的概念源于人工智能的人工神經(jīng)網(wǎng)絡(luò)的研究。含多隱層的多層感知器就是一種深度學(xué)習(xí)結(jié)構(gòu)。深度學(xué)習(xí)通過組合低層特征形成更加抽象的高層表示屬性類別或特征,以發(fā)現(xiàn)數(shù)據(jù)的分布式特征表示。

2018-08-23 14:36:16 16

16 AGX-5專為解決當(dāng)前AI深度學(xué)習(xí)和高性能計(jì)算的性能擴(kuò)展難題而設(shè)計(jì),單機(jī)在8U空間配置16顆目前性能最強(qiáng)的NVIDIA Tesla V100 Tensor Core 32GB GPUs,擁有10,240個(gè)張量計(jì)算核心,AI計(jì)算性能高達(dá)2PFlops。

2018-11-18 10:30:34 2106

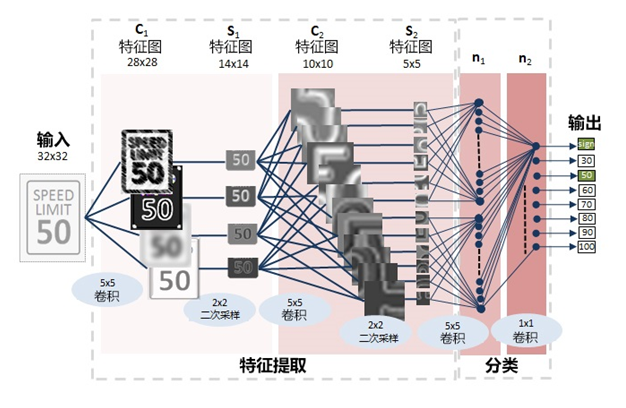

2106 Zerotech Dobby AI是一款口袋大小的無人機(jī),它使用深度學(xué)習(xí)來檢測(cè)由Xilinx Zynq SoC器件驅(qū)動(dòng)的人體手勢(shì)。

該演示還將展示DeePhi的深度學(xué)習(xí)推理技術(shù)。

2018-11-26 06:21:00 2086

2086 美國(guó)芝加哥—RSNA—2018 年 11 月 28 日—基于深度學(xué)習(xí)的注釋和分割可以大幅加快模型開發(fā)和醫(yī)學(xué)影像分析的速度。然而,從零開始開發(fā)高性能且精確的深度神經(jīng)網(wǎng)絡(luò)非常具有挑戰(zhàn)性,而且很耗費(fèi)

2018-11-29 10:40:17 1457

1457 電子發(fā)燒友網(wǎng)為你提供ADI(ti)ADSP-BF514F16相關(guān)產(chǎn)品參數(shù)、數(shù)據(jù)手冊(cè),更有ADSP-BF514F16的引腳圖、接線圖、封裝手冊(cè)、中文資料、英文資料,ADSP-BF514F16真值表,ADSP-BF514F16管腳等資料,希望可以幫助到廣大的電子工程師們。

2019-02-22 14:50:39

電子發(fā)燒友網(wǎng)為你提供ADI(ti)ADSP-BF518F16相關(guān)產(chǎn)品參數(shù)、數(shù)據(jù)手冊(cè),更有ADSP-BF518F16的引腳圖、接線圖、封裝手冊(cè)、中文資料、英文資料,ADSP-BF518F16真值表,ADSP-BF518F16管腳等資料,希望可以幫助到廣大的電子工程師們。

2019-02-22 14:49:34

, 利用GPU加快DNN計(jì)算效率。GSi本身是一臺(tái)統(tǒng)一存儲(chǔ)系統(tǒng),支持SAN與NAS服務(wù),可達(dá)到PB級(jí)的存儲(chǔ)空間。GSi自帶Linux的Docker平臺(tái),因此搭建AI深度學(xué)習(xí)的環(huán)境相當(dāng)便利,只要選好深度

2019-05-20 20:34:17 868

868 bfloat16的主要想法是提供動(dòng)態(tài)范圍與標(biāo)準(zhǔn)IEEE-FP32相同的16位浮點(diǎn)格式,精度較低。相當(dāng)于將8位的FP32指數(shù)字段的大小匹配,并將FP32分?jǐn)?shù)字段的大小縮小到7位。

2019-09-20 10:32:40 3905

3905 說到深度學(xué)習(xí)與人工智能的關(guān)系,簡(jiǎn)單來說就是:將海量數(shù)據(jù)通過深度學(xué)習(xí)進(jìn)行處理后形成一個(gè)模型,再將模型應(yīng)用到具體的業(yè)務(wù)環(huán)境中,這就是人工智能。可以說,深度學(xué)習(xí)是人工智能的重要推動(dòng)力量。

2019-09-20 15:29:38 2355

2355 深度學(xué)習(xí)平臺(tái)在AI時(shí)代下一定要對(duì)接芯片,要做軟硬一體的優(yōu)化,一定程度上相當(dāng)于芯片里面的指令集。

2019-10-21 10:04:16 2009

2009 AI(人工智能)是當(dāng)今科技圈的熱門話題,深度學(xué)習(xí)則是AI訓(xùn)練的重要手段之一。如何學(xué)習(xí)要靠硬件和算法支撐,這方面,Intel力挺CPU,NVIDIA則力挺GPU。

2020-03-06 08:53:13 2645

2645 及10nm Ice Lake處理器中就加入了BFlota16指令集(簡(jiǎn)稱BF16),AI性能達(dá)到了前代的2.5倍以上。

2020-03-11 15:00:40 11544

11544 毫不客氣地說,人工智能(AI)和機(jī)器學(xué)習(xí)(ML)已然“滲透”到了各行各業(yè),企業(yè)們期待通過機(jī)器學(xué)習(xí)基礎(chǔ)架構(gòu)平臺(tái),以推動(dòng)人工智能在業(yè)務(wù)中的利用。在機(jī)器學(xué)習(xí)加快推進(jìn)的過程中,卻是有喜也有憂。

2020-07-03 11:45:52 2615

2615 目前,整個(gè)AI芯片市場(chǎng)都圍繞著深度學(xué)習(xí)而展開。深度學(xué)習(xí)(DL),則正是讓AI應(yīng)用程序在現(xiàn)實(shí)世界中真正發(fā)揮作用的最成功的機(jī)器學(xué)習(xí)技術(shù)范例。

2020-08-13 10:46:40 1967

1967

通過使用Achronix Speedster7t FPGA中的機(jī)器學(xué)習(xí)加速器MLP72,開發(fā)人員可以輕松選擇浮點(diǎn)/定點(diǎn)格式和多種位寬,或快速應(yīng)用塊浮點(diǎn),并通過內(nèi)部級(jí)聯(lián)可以達(dá)到理想性能。

2020-08-15 11:25:55 1850

1850

將AI和機(jī)器學(xué)習(xí)與能源相結(jié)合將有助于加快可再生能源的采用。

2020-11-19 09:18:37 2437

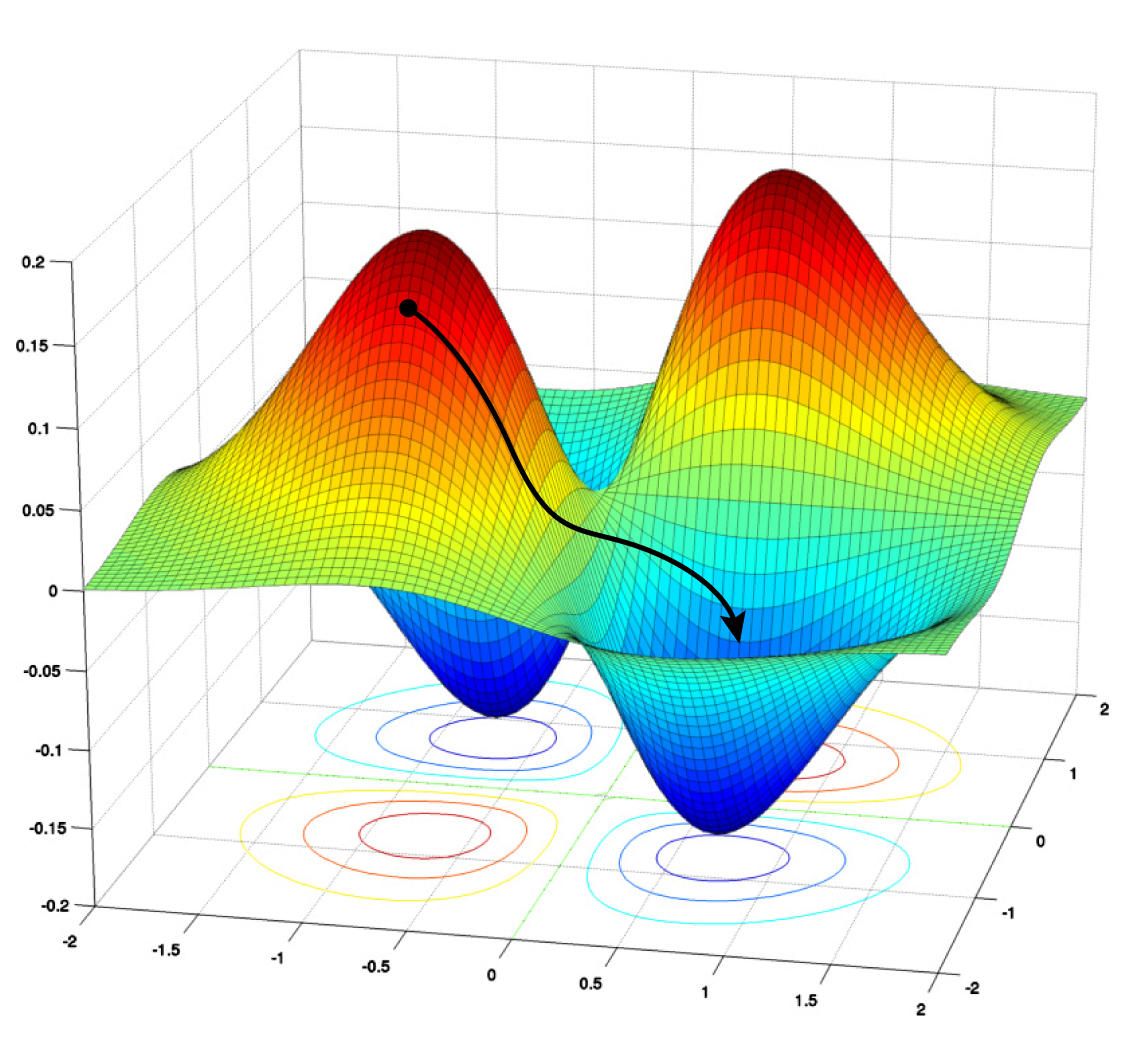

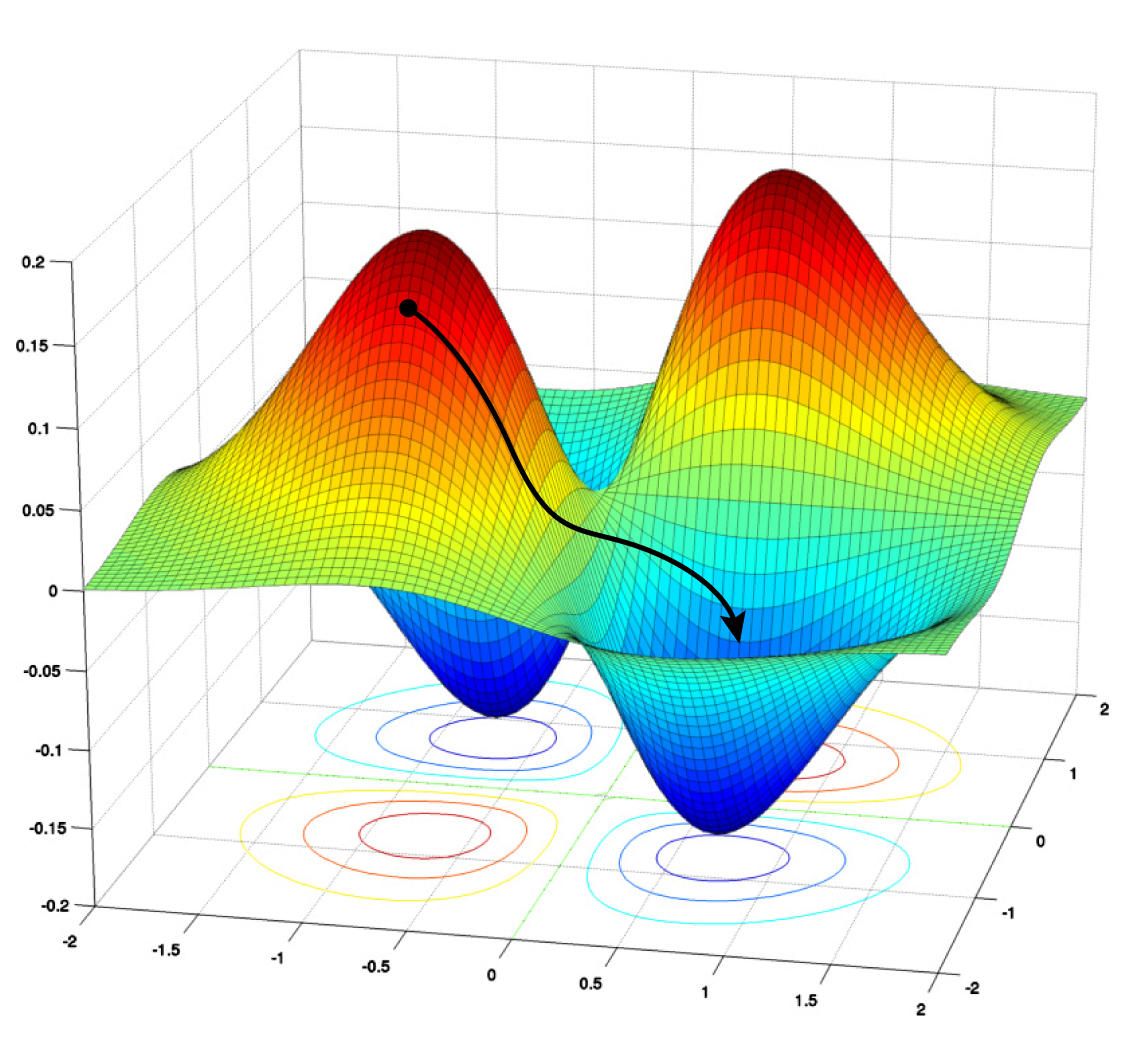

2437 將介紹現(xiàn)代機(jī)器學(xué)習(xí)如何找到兼顧規(guī)模和速度的新方法。

AI領(lǐng)域的轉(zhuǎn)變

在本系列的第1部分中,我們探討了AI的一些歷史,以及從Lisp到現(xiàn)代編程語言以及深度學(xué)習(xí)等新型計(jì)算智能范式的歷程。...

2021-02-26 06:11:43 5

5 采用IEEE745格式的浮點(diǎn)+ROM RAM的方式成功實(shí)現(xiàn)FFT的設(shè)計(jì)(嵌入式開發(fā)要學(xué)什么知乎)-采用IEEE745格式的浮點(diǎn)+ROM RAM的方式成功實(shí)現(xiàn)FFT,含有設(shè)計(jì)報(bào)告和設(shè)計(jì)源代碼.

2021-07-30 16:21:40 7

7 。

與此同時(shí),通過深度學(xué)習(xí)方法,人工智能的實(shí)際應(yīng)用能夠在汽車安全系統(tǒng)的發(fā)展進(jìn)步中發(fā)揮重要的作用。而這些系統(tǒng)遠(yuǎn)不止僅供典型消費(fèi)者群體掌握和使用。

深度學(xué)習(xí)這一概念在幾十年前就已提出,但如今它與特定

2022-01-12 14:42:05 1312

1312

本文大致介紹將深度學(xué)習(xí)算法模型移植到海思AI芯片的總體流程和一些需要注意的細(xì)節(jié)。海思芯片移植深度學(xué)習(xí)算法模型,大致分為模型轉(zhuǎn)換,...

2022-01-26 19:42:35 11

11 深度學(xué)習(xí)是推動(dòng)當(dāng)前人工智能大趨勢(shì)的關(guān)鍵技術(shù)。在 MATLAB 中可以實(shí)現(xiàn)深度學(xué)習(xí)的數(shù)據(jù)準(zhǔn)備、網(wǎng)絡(luò)設(shè)計(jì)、訓(xùn)練和部署全流程開發(fā)和應(yīng)用。聯(lián)合高性能 NVIDIA GPU 加快深度神經(jīng)網(wǎng)絡(luò)訓(xùn)練和推斷。

2022-02-18 13:31:44 1714

1714 DeepRec 集成了英特爾開源的跨平臺(tái)深度學(xué)習(xí)性能加速庫(kù)oneDNN (oneAPI Deep Neural Network Library),該程序庫(kù)已經(jīng)針對(duì)大量主流算子實(shí)現(xiàn)了性能優(yōu)化。與搭載 BF16 指令的第三代英特爾 至強(qiáng) 可擴(kuò)展處理器同時(shí)使用,可顯著提高模型訓(xùn)練和推理性能。

2022-07-10 10:56:19 864

864 因此,處理的劃分帶來了兩種技術(shù)的最佳效果。因此,它可能是 AI 應(yīng)用程序的更好選擇。但是,大多數(shù)應(yīng)用程序都需要更快的實(shí)時(shí)更新訓(xùn)練,因此 Edge AI 比 Cloud AI 技術(shù)壽命更長(zhǎng)。因此,Edge AI 在深度學(xué)習(xí)應(yīng)用方面正在超越 Cloud AI。

2022-07-10 11:07:49 1752

1752 會(huì)開發(fā)AI的AI:超網(wǎng)絡(luò)有望讓深度學(xué)習(xí)大眾化 超網(wǎng)絡(luò)(hypernetwork)可以加快訓(xùn)練AI的過程。 編者按:在執(zhí)行特定類型任務(wù),如圖像識(shí)別、語音識(shí)別等方面,AI已經(jīng)可以與人類相媲美了,甚至有

2022-10-13 09:30:23 404

404

AI在汽車中的應(yīng)用:實(shí)用深度學(xué)習(xí)

2022-11-01 08:26:19 0

0 ,尤其是深度學(xué)習(xí)的推理,將會(huì)成為優(yōu)化的重點(diǎn)。在此因素影響下,阿里云平頭哥團(tuán)隊(duì)推出了全球首個(gè)5nm 制程的 ARM Server 芯片倚天710。該芯片基于 ARM Neoverse N2 架構(gòu),支持最新的 ARMv9 指令集,其中包括 i8mm,bf16等擴(kuò)展指令集,能在科學(xué)/AI計(jì)算領(lǐng)域獲得性能優(yōu)勢(shì)。

2022-11-25 10:33:31 1097

1097 再輸出結(jié)果,讓AI學(xué)會(huì)通過特征對(duì)數(shù)據(jù)進(jìn)行判斷。深度學(xué)習(xí)之所以更加有效,是因?yàn)橛泻A康臄?shù)據(jù)輸入、更多層的神經(jīng)網(wǎng)絡(luò)和帶有權(quán)重的特征學(xué)習(xí)機(jī)制。這也意味著應(yīng)用深度學(xué)習(xí)并不容易。一直探索深度學(xué)習(xí)的百度,提出了全新的"深度學(xué)習(xí)+

2023-01-14 23:34:43 588

588

深度學(xué)習(xí)和神經(jīng)網(wǎng)絡(luò)的區(qū)別在于隱藏層的深度。一般來說,神經(jīng)網(wǎng)絡(luò)的隱藏層要比實(shí)現(xiàn)深度學(xué)習(xí)的系統(tǒng)淺得多,而深度學(xué)習(xí)的在隱藏層可以有很多層。

2023-07-28 10:44:27 296

296

EE標(biāo)準(zhǔn)754規(guī)定了三種浮點(diǎn)數(shù)格式:?jiǎn)尉取㈦p精度、擴(kuò)展精度。前兩者正好對(duì)應(yīng)C語言里頭的float、double或者FORTRAN里頭的real、double精度類型。本文設(shè)計(jì)實(shí)現(xiàn)的為單精度。

2023-07-29 16:42:32 539

539

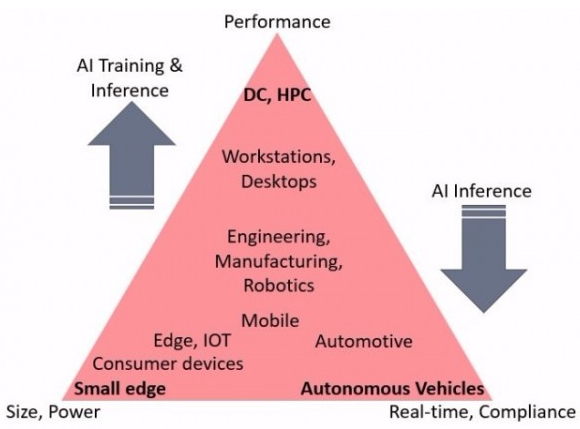

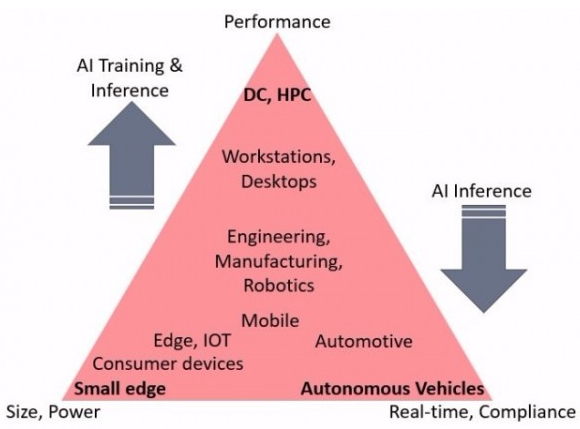

深度學(xué)習(xí) AI 應(yīng)用是解鎖生產(chǎn)力新時(shí)代的關(guān)鍵,人類的創(chuàng)造力能夠通過機(jī)器得到提高與增強(qiáng)。我們致力于將大量培訓(xùn)數(shù)據(jù)和海量數(shù)學(xué)運(yùn)算用于全面訓(xùn)練每個(gè)神經(jīng)網(wǎng)絡(luò)。訓(xùn)練可使用大規(guī)模批處理功能離線進(jìn)行,歷時(shí)數(shù)天。經(jīng)過訓(xùn)練的網(wǎng)絡(luò)要投入部署,那就面臨嚴(yán)格得多的時(shí)限要求。

2023-08-04 11:29:35 372

372 深度學(xué)習(xí)基本概念? 深度學(xué)習(xí)是人工智能(AI)領(lǐng)域的一個(gè)重要分支,它模仿人類神經(jīng)系統(tǒng)的工作方式,使用大量數(shù)據(jù)訓(xùn)練神經(jīng)網(wǎng)絡(luò),從而實(shí)現(xiàn)自動(dòng)化的模式識(shí)別和決策。在科技發(fā)展的今天,深度學(xué)習(xí)已經(jīng)成為了計(jì)算機(jī)

2023-08-17 16:02:49 982

982 深度學(xué)習(xí)算法簡(jiǎn)介 深度學(xué)習(xí)算法是什么?深度學(xué)習(xí)算法有哪些?? 作為一種現(xiàn)代化、前沿化的技術(shù),深度學(xué)習(xí)已經(jīng)在很多領(lǐng)域得到了廣泛的應(yīng)用,其能夠不斷地從數(shù)據(jù)中提取最基本的特征,從而對(duì)大量的信息進(jìn)行機(jī)器學(xué)習(xí)

2023-08-17 16:02:56 6010

6010 什么是深度學(xué)習(xí)算法?深度學(xué)習(xí)算法的應(yīng)用 深度學(xué)習(xí)算法被認(rèn)為是人工智能的核心,它是一種模仿人類大腦神經(jīng)元的計(jì)算模型。深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的一種變體,主要通過變換各種架構(gòu)來對(duì)大量數(shù)據(jù)進(jìn)行學(xué)習(xí)以及分類處理

2023-08-17 16:03:04 1305

1305 深度學(xué)習(xí)框架是什么?深度學(xué)習(xí)框架有哪些?? 深度學(xué)習(xí)框架是一種軟件工具,它可以幫助開發(fā)者輕松快速地構(gòu)建和訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)模型。與手動(dòng)編寫代碼相比,深度學(xué)習(xí)框架可以大大減少開發(fā)和調(diào)試的時(shí)間和精力,并提

2023-08-17 16:03:09 1589

1589 深度學(xué)習(xí)框架和深度學(xué)習(xí)算法教程 深度學(xué)習(xí)是機(jī)器學(xué)習(xí)領(lǐng)域中的一個(gè)重要分支,多年來深度學(xué)習(xí)一直在各個(gè)領(lǐng)域的應(yīng)用中發(fā)揮著極其重要的作用,成為了人工智能技術(shù)的重要組成部分。許多深度學(xué)習(xí)算法和框架提供

2023-08-17 16:11:26 638

638 機(jī)器學(xué)習(xí)和深度學(xué)習(xí)是當(dāng)今最流行的人工智能(AI)技術(shù)之一。這兩種技術(shù)都有助于在不需要人類干預(yù)的情況下讓計(jì)算機(jī)自主學(xué)習(xí)和改進(jìn)預(yù)測(cè)模型。本文將探討機(jī)器學(xué)習(xí)和深度學(xué)習(xí)的概念以及二者之間的區(qū)別。

2023-08-28 17:31:09 891

891 GPU performance characteristics. GPU主要計(jì)算單元(如浮點(diǎn)運(yùn)算單元)和內(nèi)存層次結(jié)構(gòu)。大多數(shù)現(xiàn)代GPU包含專用的低精度矩陣乘法單元(如Nvidia GPU的Tensor Core用于FP16/BF16矩陣乘法)。

2023-11-24 16:21:07 423

423

深度學(xué)習(xí)簡(jiǎn)介深度學(xué)習(xí)是人工智能(AI)的一個(gè)分支,它教神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)和推理。近年來,它解決復(fù)雜問題并在各個(gè)領(lǐng)域提供尖端性能的能力引起了極大的興趣和吸引力。深度學(xué)習(xí)算法通過允許機(jī)器處理和理解大量數(shù)據(jù)

2023-12-01 08:27:44 737

737

[浮點(diǎn)數(shù)]()在計(jì)算機(jī)科學(xué)中是一種重要的數(shù)據(jù)類型,用于表示實(shí)數(shù)。其中,F(xiàn)P32和FP16是兩種常見的浮點(diǎn)數(shù)格式,分別占用32位和16位。

2023-12-04 14:00:27 316

316

本文介紹了TC3xx單片機(jī)雷達(dá)信號(hào)處理單元SPU支持的半精度浮點(diǎn)格式,將其和32bit整型數(shù)格式進(jìn)行比較,分析了兩者的動(dòng)態(tài)范圍及實(shí)際處理誤差,發(fā)現(xiàn)半精度浮點(diǎn)格式是“性價(jià)比”較高的存儲(chǔ)方式。

2024-02-20 08:26:27 81

81

VisionBank Ai 深度學(xué)習(xí)視覺解決方案VisionBank Ai是專為生產(chǎn)加工制造業(yè)設(shè)計(jì)的深度學(xué)習(xí)視覺解決方案,它是將傳統(tǒng)算法工具庫(kù)和深度學(xué)習(xí)相融合。傳統(tǒng)算法工具庫(kù)作為標(biāo)準(zhǔn)算法工具,使用者

2021-04-02 14:07:08

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論