如今,第三次人工智能浪潮的興起已經是一個不爭的事實。我們知道這一次的人工智能浪潮不僅僅是一次技術的創新,更是一場產業的變革。機器學習,特別是深度學習等算法的突破、算力和數據的井噴,讓 AI 技術已經廣泛應用在社會生產生活的眾多領域。

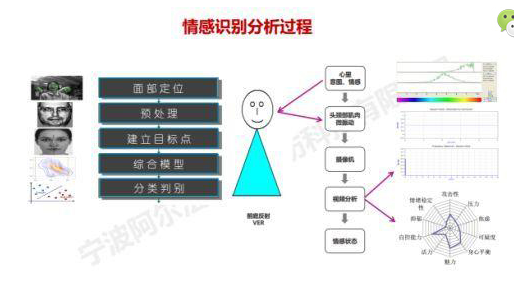

不過從這一輪 AI 變革的實質來看,深度學習算法依然是一種數據驅動的一種模擬計算,目前僅僅在語音、圖像、文字識別等感知領域有著較強的應用,距離人類更加復雜的因果推理、假設聯想等高級認知能力還有很遠距離,甚至有著本質的差別。

在從當前弱人工智能通向強人工智能,以致于通用人工智能的道路上,學術界正在推動以類腦智能和類腦計算為方向的新的研究方向,來實現由弱到強的人工智能的升級。

剛剛結束的 2020 世界人工智能大會(WAIC)上,來自復旦大學類腦智能科學與技術研究院的林偉教授在“認知智能,改變世界”行業論壇中提到,“類腦智能已成為人工智能跨越式發展的突破口。”

類腦智能和類腦計算到底是什么,與現有經典計算和當前的 AI 技術有哪些不同,是否真的能夠擔此“跨越式”的重任?面對如此多問題,這次我們就來一探“類腦智能”的究竟。

類腦計算:打破馮·諾依曼架構禁錮

實現類腦智能的前提的實現類腦計算。在了解類腦計算之前,我們簡單聊下現在主流的計算機架構——馮·諾依曼架構。

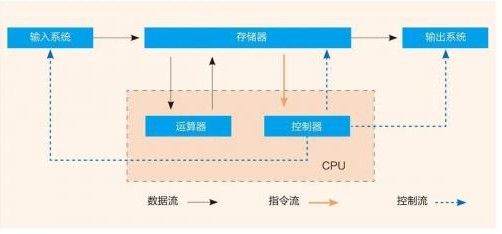

眾所周知,現有計算機都是基于“馮·諾依曼”架構實現的,其處理器工作原理就是按分時復用的方式,將高維信息的處理過程轉換成時間序列的一維處理過程。這一計算架構的特點是計算與存儲分離,結構簡潔、易于實現高速數值計算。

不過,馮·諾依曼架構在處理包含非結構化、時空關聯信息的感知、認知以及決策等相關問題時,表現出效率低、能耗高、實時性差等問題,甚至無法構造合適的算法。比如當今最先進的計算機,也難以完成一只昆蟲能夠輕易實現的環境感知與適應等相關任務。

而人類大腦卻是一個與馮·諾依曼架構正好相反的“計算器”,雖然人腦不擅長高速率大規模數值計算,但是人腦可以在有限尺寸和極低能耗下,完成復雜環境下的信息關聯記憶、自主識別、自主學習等認知處理,實現這一“計算”的基礎正是腦神經網絡的多層次復雜空間結構和腦神經的高度可塑性。

基于人腦的這些特點,科學家們提出非馮·諾依曼架構的類腦計算,就是借鑒大腦神經網絡,存儲計算一體化,將高維信息放在多層、多粒度、高可塑性的復雜網絡空間中進行處理,使其具有低功耗、高魯棒性、高效并行、自適應等特點。

類腦計算既適用于處理復雜環境下非結構化信息,又有利于發展自主學習機制,甚至最終有望模擬出大腦的創造性,實現類腦智能,這種更具通用性的人工智能。

我們回過頭來再看推動當前產業智能變革的 AI 技術。深度學習是在一定程度上對人類神經網絡結構進行的模擬,但其過程要依靠現有的經典“馮·諾依曼”架構的計算方式,使用優化問題建模并求解,其實質仍然是按照分時序列的計算,所以會呈現出算力要求高、數據計算量大的特點。

現有的人工智能技術大多數能夠處理的問題具有以下特點:1、充足的數據;2、單一、確定的問題;3、完備的知識;4、靜態。因此為一個問題提供一個解決方案,使得現有的人工智能仍然屬于弱人工智能的范疇。

當我們要處理超出這些條件的復雜問題的時候,現有 AI 技術就會遇到困難,而我們就需要更具人類智能特點的通用人工智能(AGI)。

類腦計算以及由此產生的類腦智能,就是人們為實現 AGI 的方法之一。

“舊神退散,新神未立”:類腦智能正在路上

2017 年計算機圖靈獎的得主大衛·帕特森和約翰·軒尼詩表示說,“未來十年是計算架構發展的黃金十年。”

當前,傳統計算架構的“舊神”正迎來挑戰,全新計算架構的“新神”尚未確立,而類腦計算正是試圖爭奪全新計算架構的“新神”之一。

馮·諾依曼和圖靈當時已經提到計算機要實現對于人腦的模仿,但由于經典計算更加易于實現,因此朝著“摩爾定律”規定的方向一路狂奔。而麥卡洛克等人在 1943 年提出單個神經元計算模型,可被認為是最早的仿腦研究,而到了七八十年代,部分學者開始關注采用更接近于生物大腦系統的計算機制的研究方法。

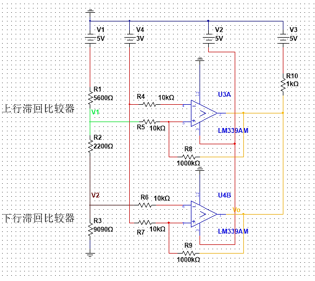

1990 年,美國加州理工大學卡弗·米德教授嘗試用硬件電路來模擬神經網絡,提出了“神經擬態計算”的概念,并將其定義為“采用以模擬器件仿真生物神經系統的 VLSI 來實現大規模并行的自適應計算系統”。

“神經擬態計算”正式開啟了類腦計算的研究和實踐。類腦計算主要以“人造超級大腦”為目標,借鑒人腦的信息處理方式,模擬大腦神經系統,構建以計算為基礎的“虛擬人腦”。

Nature在 2016 年提到,類腦計算成為后摩爾定律時代極具潛力的發展方向之一,成為繼第一階段的 GPU,第二階段的 ASIC 加速器之后,在推動 AI 的計算上面發揮巨大潛力。

現在,全球主要發達地區的國家、高校和技術公司都已經摩拳擦掌,紛紛開始類腦計算和類腦智能的研究。

日本在 2008 年就提出了“腦科學戰略研究項目”,重點開展腦機接口、腦計算機研發和神經信息相關的理論構建;歐盟在 2013 年提出“人類腦計劃”(HBP),重點開展人腦模擬、神經形態計算、神經機器人等領域研究;美國也同時啟動了“BRAIN 計劃”,將大腦結構圖建立、類腦相關理論建模、腦機接口等列為研發重點;韓國在 2016 年發布《腦科學研究戰略》,重視腦神經信息學、腦工程學、人工神經網絡、大腦仿真計算機等領域的研發。

全球頂尖高校和技術公司也加入了類腦計算和類腦智能的布局。IBM 推出了 TrueNorth 類腦芯片,試圖搶先打造類腦計算系統;受歐盟腦計劃支持的英國曼徹斯特大學和德國海德堡大學研發的神經擬態計算系統,分別推出了 SpiNNaker 芯片和 BrainScaleS 芯片。

此外,像微軟提出了意識網絡架構,聲稱是具備可解釋性的新型類腦系統;谷歌在現有谷歌大腦基礎上結合醫學、生物學積極布局人工智能。

我國積極加速類腦智能計劃。比如我國在 2016 年《“十三五”國家科技創新規劃》也將腦科學與類腦研究列入科技創新 2030 重大項目。2017 年國務院《新一代人工智能發展規劃》提出,2030 年類腦智能領域取得重大突破的發展目標。在 2017、2018 年,我國分別成立了類腦智能技術及應用國家工程實驗室、北京腦科學與類腦研究中心,形成了“南腦北腦”共同快速發展的格局。

當然,現在類腦計算的發展仍然處在初期的探索階段。

正如我們上面提到的歐洲“人類腦計劃”,就在去年曝出耗盡 10 億歐元之后,試圖“完全模擬人腦”的計劃并沒有取得計劃中的進展,并沒有做出突破性的研究成果。

不過,這一通過傳統計算方式來還原大腦結構的方式的失敗并不能證明類腦計算行不通,反而更加說明了通過全新的計算架構來模擬神經網絡的計算方式的根本性轉向的重要性。

邁向 AGI,類腦智能提供新可能

在通向通用人工智能的道路上,類腦智能已經被認為是最有希望的方案之一。

與經典技術中,將多維度信息轉化為一維的數值計算的信息流,以提高單位時間的運算速度這一提高時間復雜性的計算方向不同,類腦計算更強調模擬人腦的復雜的神經元連接架構(不是直接還原神經元的連接),把多維世界中的信息擴展到更復雜的空間中去,利用空間的復雜性來解決計算問題,甚至同時利用時空的復雜性,來解決計算問題。

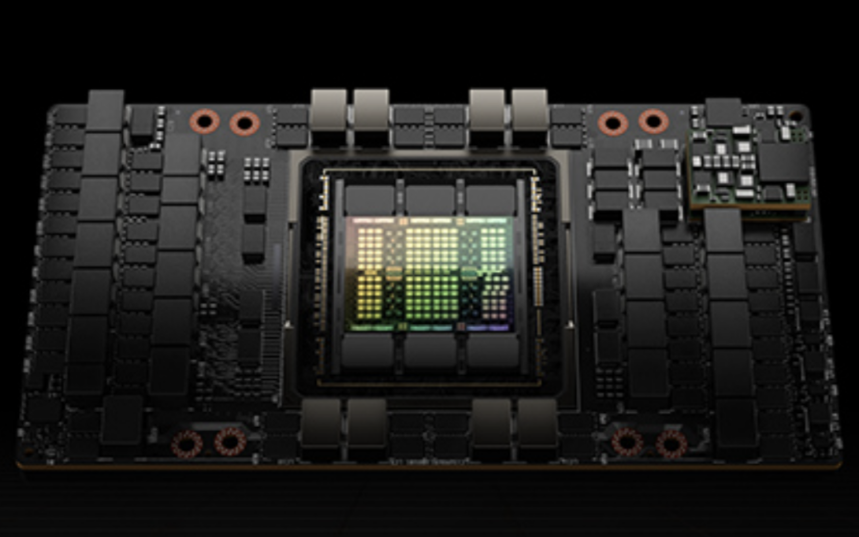

所以,集成眾多神經元數量、突觸數量以及存算一體的神經元處理單元數量的類腦芯片,為完成仿真或模擬提供計算、存儲、通信等基礎硬件支持,是實現類腦計算的關鍵因素。而構建類腦計算芯片的陣列集成系統,是目前國際通行的大規模類腦計算系統的技術路線。

比如,今年 3 月,英特爾用 768 個 Loihi 芯片構造了一個新的神經擬態研究系統 Pohoiki Springs,達到了 1 億個神經元的規模,比上一次構建的系統 Pohoiki Beach 的 64 個芯片 800 萬個神經元,擴大了 12 倍的規模。

類腦計算芯片作為實現類腦通用人工智能的硬件基礎,既是神經科學模型的仿真平臺,又是新計算范式、新體系結構的原型。這一點從清華大學的天機芯片的研究成果中,也得以清晰的體現。

去年 8 月,清華大學開發出全球首款異構融合類腦芯片,被命名為“天機芯”(Tianjic),相關論文《面向通用人工智能的異構天機芯片架構》作為封面文章登上了Nature。

這一異構融合芯片配置有多個高度可重構的功能性核,可以同時支持機器學習算法和現有類腦計算的算法。相比于當前 IBM 推出的 TrueNorth 芯片,新一代“天機芯”功能更全、靈活性和擴展性更好,密度提升 20%,速度提高至少 10 倍,帶寬提高至少 100 倍。

去年,在清華大學操場上,由這一類腦芯片支持,實現自動駕駛的一輛自行車更是成為 AI 圈“刷屏”的網紅車。這輛車僅用一個芯片,就可以在無人駕駛自行車系統中同時處理多種算法和模型,實現實時目標檢測、跟蹤、語音控制、避障和平衡控制。

從天機芯片結合計算機科學和神經科學兩個主要方向,發展而成的融合計算平臺,成為現在實現類腦計算的較好的解決方案,為學術界貢獻了一種通向 AGI 的新發展思路。

現在,類腦計算目前還沒有統一的技術方案。在當前學術界提供的實現方案中,有采用數模混合實現的 Neurogrid 和 BrianScaleS;有異步純數字實現的 TrueNorth、Loihi;有采用同步純數字實現的天機等等解決方案。

在實現通用人工智能(AGI)的道路上,主要有計算機科學導向和神經科學兩大方向而將二者緊密結合可能是當下來看的最佳實現方案。

超級計算機的發展能夠帶給科學家更好推進計算模擬的進程;互聯網、大數據和云計算的發展可以構造一個無比復雜的數字世界,可以形成與數字大腦類比的復雜鏡像世界。而由于新的測量技術和納米材料等基礎技術的發展,又正在逐步揭開人類大腦的結構和運行原理,并且為我們開發出高效能、高密度的芯片器件提供了基礎。

而這些正在構成發展類腦智能的基礎條件,也是未來通向通用人工智能的有利契機。

? ? ? ?責任編輯:pj

電子發燒友App

電子發燒友App

評論