院解釋,單純的深度學習已經成熟,而結合了深度學習的圖神經網絡將端到端學習與歸納推理相結合,有望解決深度學習無法處理的關系推理、可解釋性等一系列問題。

2019-01-02 13:49:08 1994

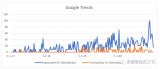

1994 模型的可解釋性是機器學習領域的一個重要分支,隨著 AI 應用范圍的不斷擴大,人們越來越不滿足于模型的黑盒特性,與此同時,金融、自動駕駛等領域的法律法規也對模型的可解釋性提出了更高的要求,在可解釋

2023-09-28 10:17:15 437

437

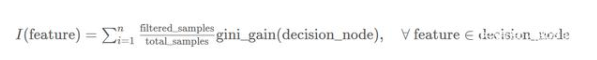

通過建立既可解釋又準確的模型來改良這種錯誤的二分法。關鍵是將神經網絡與決策樹相結合,在使用神經網絡進行低級決策時保留高級的可解釋性。

2020-05-31 10:51:44 7986

7986 人工智能、AI智能大模型已經孵化;繁衍過程將突飛猛進,ChatGPT已經上線。

世界首富馬斯克認為AI對人類是一種威脅;谷歌前CEO施密特認為AI和機器學習對人類有很大益處。

每個國家對核武器的運用有兩面性,可造可控;但AI智能他具備學習能力,如果他自裝意識形態,自己衍生,人類是否可控?

2023-06-27 10:48:14

1 個 AI 模型 = 5 輛汽車終身碳排量,AI 為何如此耗能?

2021-01-22 06:35:03

AI算法中比較常用的模型都有什么

2022-08-27 09:19:06

【資源下載】《可解釋的機器學習》,打開機器學習黑匣子

2020-05-20 14:16:57

cubemx ai導入onnx模型后壓縮失敗。請問我怎么解決

2024-03-19 07:58:47

FFT運算(Vivado)

四、硬件加速之—使用PL加速矩陣乘法運算(Vitis HLS)

五、Vitis AI 構建開發環境,并使用inspector檢查模型

六、Vitis AI 進行模型校準和來

2023-10-14 15:34:26

語義網絡。圖譜構建中會面臨較大的挑戰,但構建之后,可在數據分析、推薦計算、可解釋性等多個場景中展現出豐富的應用價值。 其中,構建挑戰包括: Schema 難定義。目前尚無統一成熟的本體構建流程,且特定

2022-11-22 15:37:08

介紹在STM32cubeIDE上部署AI模型的系列教程,開發板型號STM32H747I-disco,值得一看。MCUAI原文鏈接:【嵌入式AI開發】篇四|部署篇:STM32cubeIDE上部署神經網絡之模型部署

2021-12-14 09:05:03

使用cube-AI分析模型時報錯,該模型是pytorch的cnn轉化成onnx

```

Neural Network Tools for STM32AI v1.7.0 (STM.ai v8.0.0-19389)

INTERNAL ERROR: list index out of range

```

2024-03-14 07:09:26

你好, 我試圖在 X-CUBE-AI.7.1.0 中導入由在線 AI 平臺生成的 .h5 模型,收到錯誤:E010(InvalidModelError): Model saved with Keras 2.7.0 but

2022-12-27 06:10:35

將AI推向邊緣的影響通過在邊緣運行ML模型可以使哪些具體的AI項目更容易運行?

2021-02-23 06:21:10

訓練好的ai模型導入cubemx不成功咋辦,試了好幾個模型壓縮了也不行,ram占用過大,有無解決方案?

2023-08-04 09:16:28

在設計防止AI大模型被黑客病毒入侵時,需要考慮到復雜的加密和解密算法以及模型的實現細節,首先需要了解模型的結構和實現細節。

以下是我使用Python和TensorFlow 2.x實現深度學習模型

2024-03-19 11:18:16

1) 非常完美地將各種side information融入到一個統一的模型;

2)利用meta-path,可以設計出各種各樣的推薦策略,除了推薦準確性提升之外,還能提供「可解釋性」。

2017-10-10 11:47:09 2645

2645 深度學習的熱潮還在不斷涌動,神經網絡再次成為業界人士特別關注的問題,AI 的未來大有可期,而深度學習正在影響我們的日常生活。近日斯坦福大學給我們分享咯一則他對深度神經網絡可解釋性的探索的論文,我們去看看他是如理解的吧!

2018-01-10 16:06:30 4032

4032

而對于自底向上的模式,將商業模型中的一部分委派給機器學習,甚至從機器學習中得到全新的商業想法。自底向上的數據科學一般與手工勞作的自動化過程相關。例如制造業公司可將傳感器放置在設備上收集數據并預測

2018-04-11 15:48:04 13151

13151

關于紅外檢測技術的解釋性論文

2018-05-21 11:15:58 2

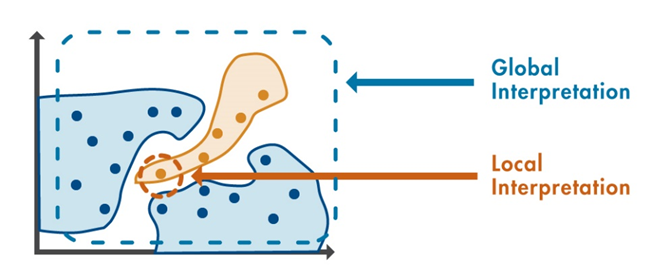

2 廣義上的可解釋性指在我們需要了解或解決一件事情的時候,我們可以獲得我們所需要的足夠的可以理解的信息。

2018-06-25 10:21:11 5608

5608

如果考察某些類型的“事后可解釋性”(post-hoc interpretable),深度神經網絡具有明顯的優勢。深度神經網絡能夠學習豐富的表示,這些表示能夠可視化、用語言表達或用于聚類。如果考慮對可解釋性的需求,似乎線性模型在研究自然世界上的表現更好,但這似乎沒有理論上的原因。

2018-07-24 09:58:20 19321

19321 所以網絡學習特征向量,和未見分類一起保存于可微記憶塊之中。這一表示不斷發展,給了神經網絡學習“如何快速學習”的能力,這正是我們將其稱為元學習的原因。就這樣,神經網絡的行為開始變得更像人類了。人類聯系過去和現在的能力極強。例如,即使我沒見過這一奇異的外星生物,我仍然可以說它像是一個長著牛角的狒狒或者大猩猩。

2018-11-10 10:07:55 4777

4777 正如Xavier Amatriain說的那樣,深度學習的寒冬不會到來——這項技術已經用到產業里并帶來了收益,現實讓人們收起了一部分對AI的期望和恐懼,業界開始思考數據的公平性、模型的可解釋性等更本質的問題。

2018-12-26 08:59:52 3600

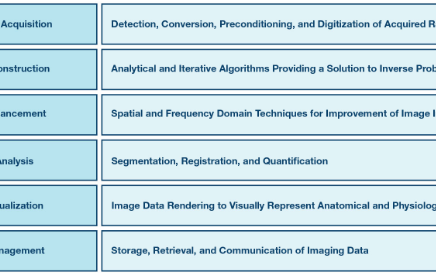

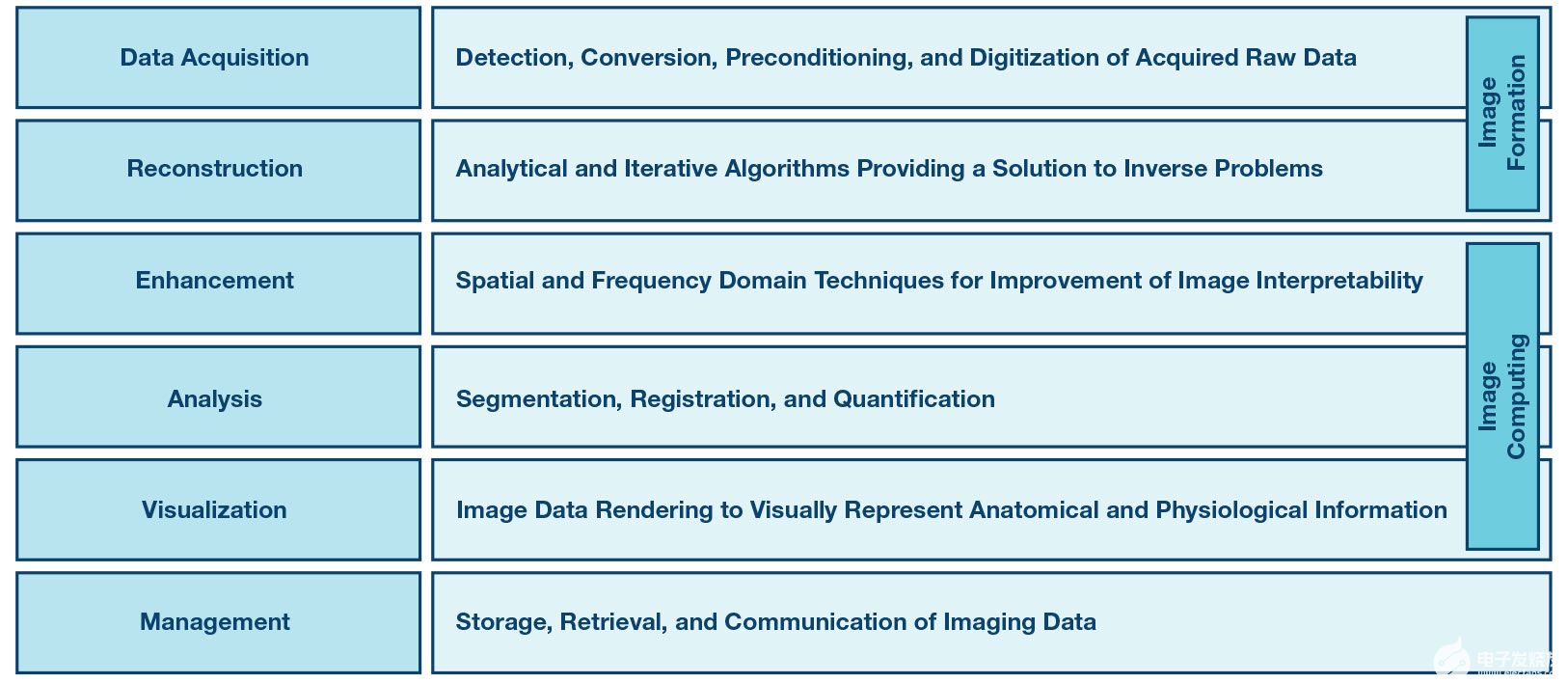

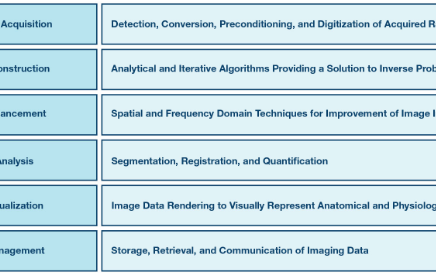

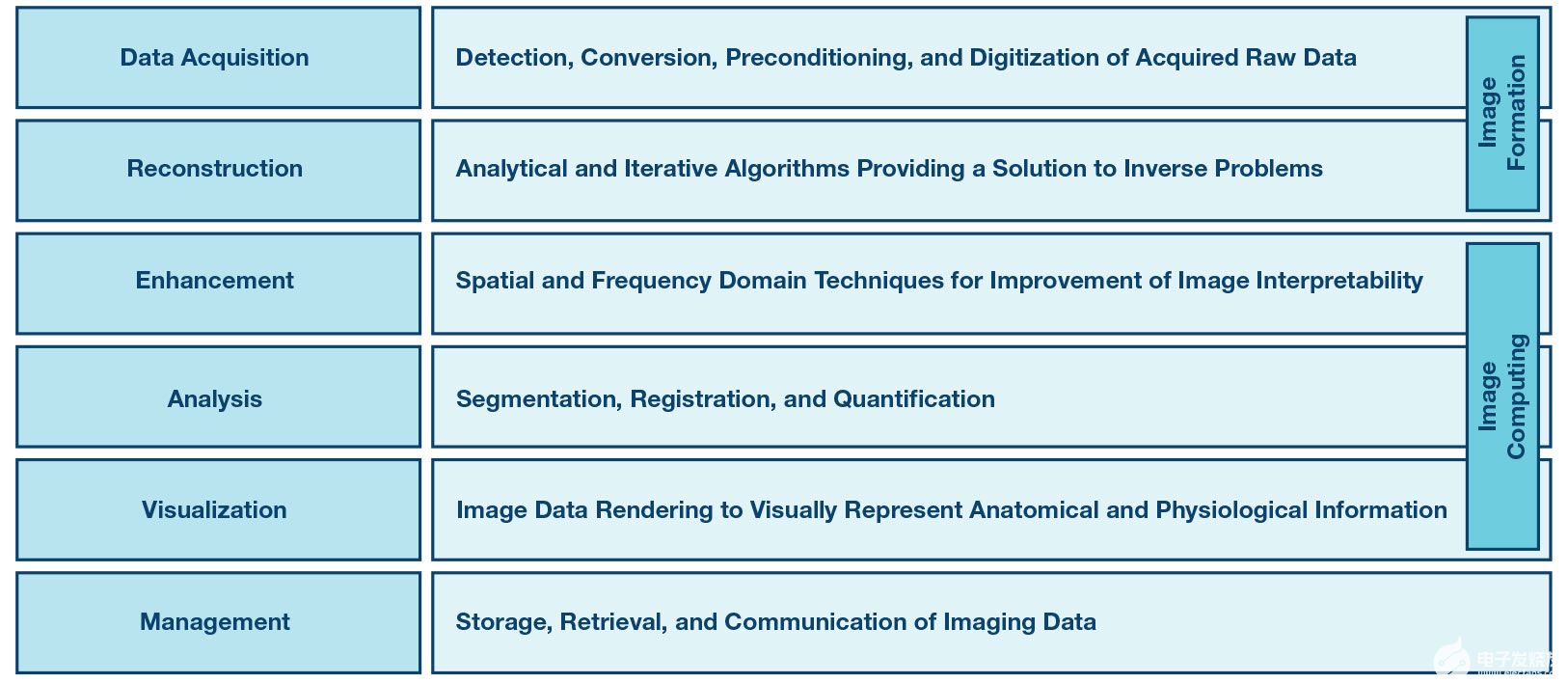

3600 圖像形成過程包括數據采集和圖像重建步驟,為數學逆問題提供解決方案。圖像計算的目的是改善重建圖像的可解釋性并從中提取臨床相關信息。

2019-04-15 16:29:09 6752

6752

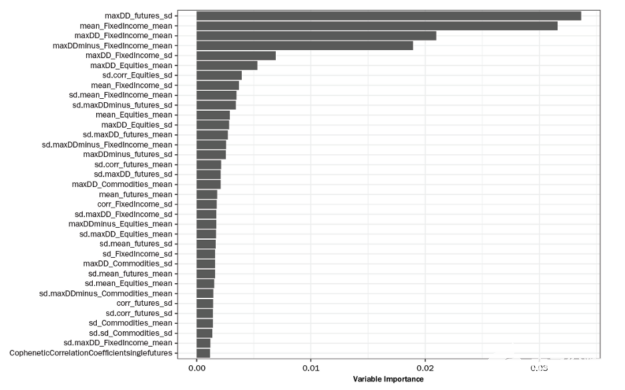

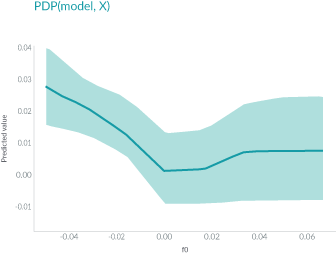

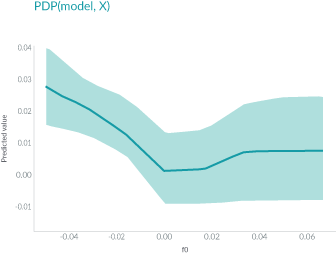

下圖則闡述了在需要清晰簡單的模型可解釋性時,通常首選白盒模型 (具有線性和單調函數) 的原因。圖的上半部顯示,隨著年齡的增長,購買數量會增加,模型的響應函數在全局范圍內具有線性和單調關系,易于解釋模型。

2019-04-04 17:30:23 2470

2470

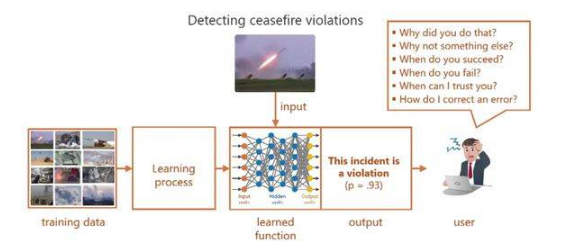

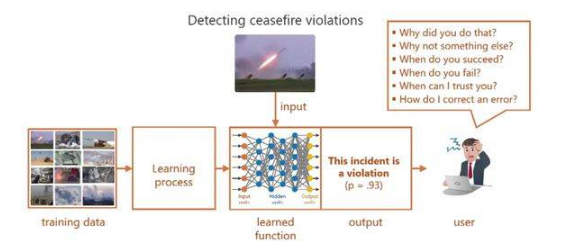

人工智能(AI)的能力無疑令人震驚,這讓許多人想知道它是如何做到的?,而這個問題的答案推動了可解釋人工智能的概念,有時候稱為XAI。

2019-05-09 16:33:45 420

420 在現實生活中,我們經常會為朋友做推薦或者讓別人幫我們推薦,比如推薦旅游地、推薦電影、推薦書籍、推薦餐廳等。現實生活中的推薦,大家都會給出推薦原因的,比如推薦餐廳,我們會說這家環境好、好吃、衛生等等。

2019-06-07 16:19:00 3199

3199 神經網絡的可解釋性,從經驗主義到數學建模

2019-06-27 10:54:20 4942

4942 最近,Google Brain團隊的研究人員發表了一篇論文,提出了一種名為概念激活向量(Concept Activation Vectors, CAV)的新方法,它為深度學習模型的可解釋性提供了一個新的視角。

2019-07-31 14:11:46 2702

2702 雖然神經網絡在近年來 AI 領域取得的成就中發揮了關鍵作用,但它們依舊只是有限可解釋性的黑盒函數近似器。

2019-08-15 09:17:34 12652

12652 語言是人類智能的重要標志,在人類文明中的地位與作用毋庸置疑,自然語言處理,通俗地解釋就是“讓計算機學習人類語言”。

2019-08-15 09:41:46 2540

2540 “因此,可解釋性對機器學習,特別是深度學習是一個很大的挑戰。只有人類理解了AI的決策過程,才能將其應用在更廣泛的社會場景中。”徐飛玉表示。

2019-09-27 11:24:01 2230

2230 Google LLC已在其云平臺上推出了一項新的“可解釋AI”服務,旨在使機器學習模型做出決策的過程更加透明。

2019-11-30 11:06:51 882

882 可解釋的人工智能意味著人類可以理解IT系統做出決定的路徑。人們可以通過分解這個概念來探究人工智能如此重要的原因。

2020-01-30 08:50:00 6437

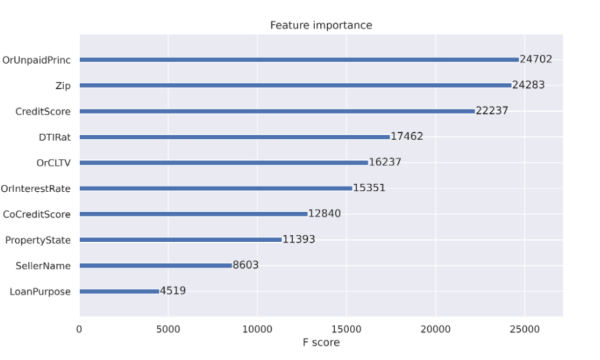

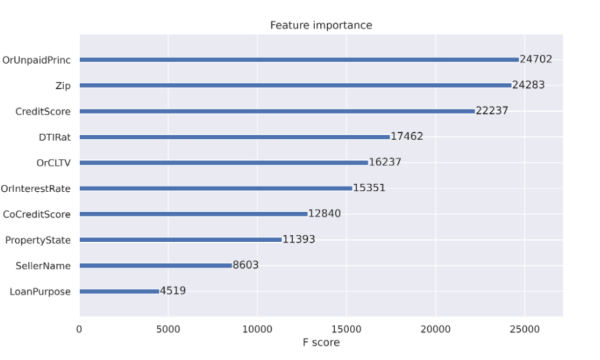

6437 Google Cloud AI戰略總監Tracy Frey在 今天的博客中解釋說,Explainable AI旨在提高機器學習模型的可解釋性。她說,這項新服務的工作原理是量化每個數據因素對模型產生的結果的貢獻,幫助用戶了解其做出決定的原因。

2020-03-24 15:14:21 2655

2655 人工智能系統所面臨的兩大安全問題的根源在于深度神經網絡的不可解釋性。深度神經網絡可解釋性定義為可判讀(interpretability)和可理解(explainability)兩方面的內容。可判讀性,即深度神經網絡輸出可判讀

2020-03-27 15:56:18 2632

2632 可解釋AI(X AI)近年來一直是一個積極的研究課題,受到DARPA2016年倡議的推動。 計算機視覺和自然語言處理等“感知”問題的機器學習的廣泛采用,導致了分類器的可解釋性技術的發展,包括LIME和AllenNLP解釋技術。

2020-04-03 14:57:48 2620

2620 今年秋天,Facebook發布了帶有量化和TPU支持的PyTorch 1.3,以及深度學習可解釋性工具Captum和PyTorch Mobile。還有諸如PyRobot和PyTorch Hub之類的東西,用于共享代碼并鼓勵機器學習(ML)實踐者實現可重復性。

2020-04-15 16:40:00 1703

1703 透明度和可解釋性:應該有透明性和負責任的披露,以確保人們知道他們何時受到AI系統的重大影響,并可以找出AI系統何時與他們互動。

2020-04-20 15:52:47 1513

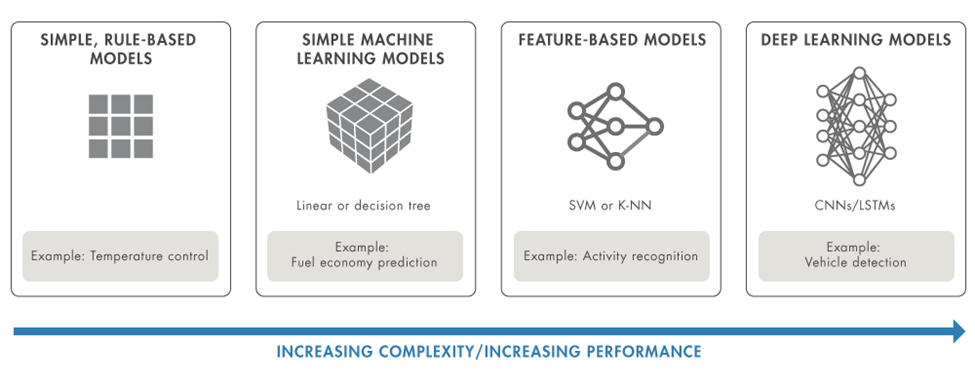

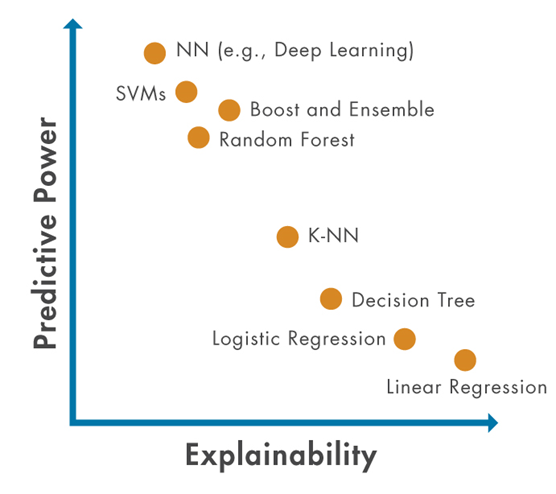

1513 一般來說,效能(正確率)與可解釋性呈現負相關的關系,也就是說,可解釋性越高,效能就越差;效能越高,可解釋性就越低。

2020-05-17 09:49:08 641

641 針對人工智能安全問題,他提出四大對策。第一方面對策是可解釋性,即我們了解或者解決一件事情的時候,可以獲得我們所需要的足夠可以理解的信息。比如說過去算法是黑盒算法,缺乏透明性、可解釋性,一旦發生問題,難以分析和驗證到底問題出處。

2020-07-04 13:00:20 2783

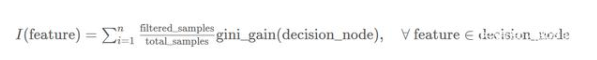

2783 決策樹模型是白盒模型的一種,其預測結果可以由人來解釋。我們把機器學習模型的這一特性稱為可解釋性,但并不是所有的機器學習模型都具有可解釋性。

2020-07-06 09:49:06 3073

3073

以深度學習為代表的人工智能技術在信息領域的應用,極大地提高了信息的利用效率和挖掘價值,深刻的影響了各領域的業務形態,同時也引發了監管部門和用戶對這一新技術運用中出現的 “算法黑箱”問題關切和疑慮。如何對相關算法、模型、及其給出的結果進行合理的解釋成為數據科學家亟需解決的問題

2020-07-15 17:28:11 1166

1166 AutoML中準確性和可解釋性的自動平衡 -除了追求最高準確性的模型外,還使過程自動化,以最小的準確性變化探索更簡單的ML模型。這使用戶可以根據他們的業務需求來平衡準確性和可解釋性。

2020-09-11 10:32:04 1085

1085 性,涵蓋了可解釋AI的多學科性質,包括計算機科學、工程學和心理學領域。可解釋性是可信AI的主要特征之一,不同的AI用戶需要不同類型的解釋,因此并不存在唯一的解釋。“草案”提出了五類解釋,總結了可解釋AI理論

2020-09-15 11:09:36 3539

3539 一旦人們對一項技術失去了信任,就很難再獲得回報。因此,開發和使用人工智能的組織要想提高人工智能應用程序的可信度和透明度,就必須超越負責任的人工智能。解決方案是實現可解釋人工智能(XAI),即以普通人能夠理解的方式描述人工智能解決方案的目的、原理和決策過程。

2020-09-20 10:19:04 3276

3276 對于機器學習模型來說,我們常常會提到2個概念:模型準確性(accuracy)和模型復雜度(complexity)。

2021-01-05 14:02:28 2825

2825

Al應用平臺RealBox憑借在魯棒性、可解釋性方面的強大性能順利通過可信AI認證,RealAI也成為首批通過該項評估的十家企業之一。 伴隨日新月異的飛速發展,人工智能的不可解釋、偏見歧視、存在攻擊漏洞等安全問題正日益對法律、倫理、社會等方面不斷提出挑戰。 在

2020-09-29 12:29:56 852

852 在過去的十年里,深度學習在一系列的應用中取得了巨大的成功。然而,為了驗證和可解釋性,我們不僅需要模型做出的預測,還需要知道它在...

2020-12-08 22:14:02 262

262 模型可解釋性方面的研究,在近兩年的科研會議上成為關注熱點,因為大家不僅僅滿足于模型的效果,更對模型效果的原因產生更多的思考,這...

2020-12-10 20:19:43 533

533 與問題文本特征進行3種注意力加權,利用MASK屏蔽與問題無關的答案,從而增強模型的可解釋性。實驗結果表明,該模型在視頻問答任務中的準確率達到61%,與ⅤQA+、SA+等視頻問答模型相比,其具有更快的預測速度以及更好的預測效果。

2021-03-11 11:43:28 2

2 深度神經網絡具有非線性非凸、多層隱藏結構、特征矢量化、海量模型參數等特點,但弱解釋性是限制其理論發展和實際應用的巨大障礙,因此,深度神經網絡解釋方法成為當前人工智能領域研究的前沿熱點。針對軍事金融

2021-03-21 09:48:23 18

18 安全性得到重視,傳統融合策略可解釋性差的冋題凸顯。夲文基于心理學中的知識線記憶理論進行建模參考人類決策過程,提出了一種擁有較好可解釋性的啟發式多分類器集成算法,稱為知識線集成算法。該算法模擬人類學習與推斷的

2021-03-24 11:41:33 13

13 圖神經網絡的可解釋性是目前比較值得探索的方向,今天解讀的2021最新綜述,其針對近期提出的 GNN 解釋技術進行了系統的總結和分析,歸納對比了該問題的解決思路。

2021-03-27 11:45:32 5583

5583

:https://arxiv.org/pdf/2012.15445.pdf 參考文獻 0.Abstract近年來,深度學習模型的可解釋性研究在圖像和文本領域取得了顯著進展

2021-04-09 11:42:06 2440

2440

設計。傳統的可視化任務需要使用大量的數據,而聯邦學習的隱私性決定了其無法獲取用戶數據。因此,可用的數據主要來自服務器端的訓練過程,包括服務器端模型參數和用戶訓練狀態。基于對聯邦學習可解釋性的挑戰的分析,文

2021-04-29 11:13:59 3

3 ,以提升其可解釋性。此外,對高斯混合模型的推理過程進行優化,給出一種基于批次處理方式的可擴展變分推理算法,求解圖像去噪中所有隱變量的變分后驗分布,實現先驗學習。實驗結果表明,該模型在圖像去噪任務中較巸PLL等傳

2021-04-29 11:17:49 7

7 為了提高駕駛分心識別的應用性及識別模型的可解釋性,利用遷移學習方法硏究構建駕駛人駕駛分心行為識別模型并采用神經網絡可視化技術硏究對模型進行解釋。以ⅤGσ-6模型為基礎,對原模型全連接層進行修改以適應

2021-04-30 13:46:51 10

10 伴隨著模型復雜度的增加,機器學習算法的可解釋性越差,至今,機器學習的可解釋性依舊是個難題.通過算法訓練出的模型被看作成黑盒子,嚴重阻礙了機器學習在某些特定領域的使用,譬如醫學、金融等領域.目前針對機器學習的可解釋性綜

2022-01-25 08:35:36 790

790

本文介紹目前常見的幾種可以提高機器學習模型的可解釋性的技術。

2022-02-26 17:20:19 1831

1831

本文介紹目前常見的幾種可以提高機器學習模型的可解釋性的技術,包括它們的相對優點和缺點。

2022-02-16 16:21:31 3986

3986

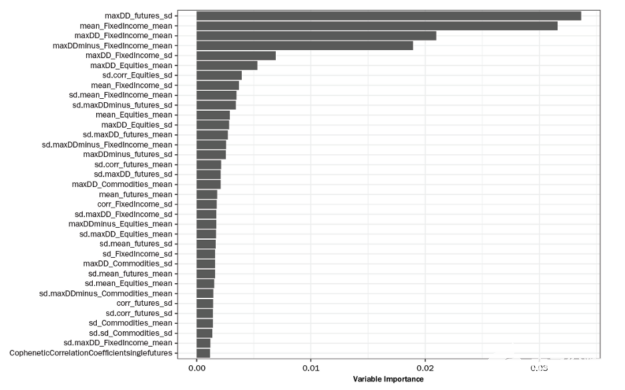

在本文中,我們將演示如何檢查相互競爭的模型(稱為 challenger models ),并使用 GPU 加速,通過簡單、經濟高效且可理解的模型可解釋性應用程序獲得成功。當 GPU 加速在模型開發過程中被多次使用時,建模者的時間將通過在數十次模型迭代中攤銷培訓時間和降低成本而得到更有效的利用。

2022-04-06 17:33:41 988

988

SHAP 聚類提供了機器學習模型的局部、全局和組級決策的解釋。這里提供的擴展允許對解釋進行進一步分析。這允許從業者為基于機器學習的決策構建一個敘述和解釋,以滿足業務、監管和客戶需求。

2022-04-07 09:12:23 2275

2275

對形狀值進行聚類的想法基于 EU Horizon 項目FIN-TECH中最成功的 AI 用例,發布為可解釋機器學習在信用風險管理中的應用。它

2022-04-07 09:20:48 1296

1296

模型解釋性 幫助開發人員和其他利益相關者理解模型特征和決策的根本原因,從而使流程更加透明。能夠解釋模型可以幫助數據科學家解釋他們的模型做出決策的原因,為模型增加價值和信任。在本文中,我們將討論:

2022-04-21 09:25:56 1922

1922 ./oschina_soft/interpret.zip

2022-06-16 09:51:54 1

1 可解釋機器學習

2022-06-17 14:41:05 1

1 在實踐中,人工智能的規模化應用推廣,在很大程度上依賴于用戶能否充分理解、合理信任并且有效管理人工智能這一新型伙伴。為此,確保人工智能產品、服務和系統具有透明性(Transparency)與可解釋性(Explainability)是至關重要的。

2022-08-09 10:04:01 1132

1132 這一代人工智能浪潮也許到終點還是沒有推理能力,沒有可解釋能力。而下一波人工智能浪潮的興起,就是實現具有推理、具有可解釋性、具有認知的人工智能。

2022-09-22 10:58:34 1289

1289 隨著信息技術的不斷發展,人工智能實現了 從能存會算的“計算智能”,到能聽會說、能看會 認的“感知智能”[1-3],再到下一階段具備理解、 推理和解釋能力的“認知智能”[4-6]的逐漸演變, 這 3 個階段的實現難度和價值同時逐次提升。

2022-12-21 10:50:46 428

428 一是自動駕駛高度依賴不具備可解釋性的深度學習神經網絡,不具備可解釋性就意味著無法真正迭代升級。公認自動駕駛技術霸主的Waymo研發自動駕駛已經14年,但近10年來都沒有取得顯著進展原因就是如此。

2022-12-21 11:44:10 728

728 圖像形成過程由數據采集和圖像重建步驟組成,為數學逆問題提供了解決方案。圖像計算的目的是提高重建圖像的可解釋性,并從中提取臨床相關信息。最后,圖像管理處理采集的圖像和衍生信息的壓縮、存檔、檢索和通信。

2022-12-22 14:35:03 1297

1297

自主性挑戰的動機是需要有效管理AI合作伙伴。例如,國防部尋求半自主系統來增強作戰人員的能力。操作員需要了解它們的行為,以便確定在未來任務中如何以及何時最好地使用它們。有效的解釋將更好地促成這種決定

2023-01-30 11:40:47 407

407 目前很多機器學習模型可以做出非常好的預測,但是它們并不能很好地解釋他們是如何進行預測的,很多數據科學家都很難知曉為什么該算法會得到這樣的預測結果。這是非常致命的,因為如果我們無法知道某個算法是如何進行預測,那么我們將很難將其前一道其它的問題中,很難進行算法的debug。

2023-02-03 11:34:06 1038

1038

本文介紹目前常見的幾種可以提高機器學習模型的可解釋性的技術,包括它們的相對優點和缺點。

2023-02-08 14:08:52 861

861 最近圖靈獎得主Yann LeCun參與撰寫了一篇關于「增強語言模型」的綜述,回顧了語言模型與推理技能和使用工具的能力相結合的工作,并得出結論,這個新的研究方向有可能解決傳統語言模型的局限性,如可解釋性、一致性和可擴展性問題。

2023-03-03 11:03:20 673

673 本文對數據起源、可解釋AI(XAI)和可信賴AI(TAI)進行系統的文獻綜述,以解釋基本概念,說明數據起源文件可以用來提升基于人工智能系統實現可解釋性。此外,文中還討論了這個領域近期的發展模式,并對未來的研究進行展望。

2023-04-28 15:55:48 905

905

可解釋性研究的一種簡單方法是首先了解 AI 模型各個組件(神經元和注意力頭)在做什么。傳統的方法是需要人類手動檢查神經元,以確定它們代表數據的哪些特征。這個過程很難擴展,將它應用于具有數百或數千億個參數的神經網絡的成本過于高昂。

2023-05-15 09:40:29 310

310 這就使得,原本深度學習被詬病可解釋性問題,其實不再是問題。因為從業務頂層已經被拆分,拆分成一個個可以被人理解的因子,無法被合理解釋的因子,項目啟動的評審都無法通過。

2023-05-19 10:09:40 244

244

為了建立可信、可控、安全的人工智能,學術界與工業界致力于增強人工智能系統與算法的可解釋性。具體地,可信人工智能旨在增強人工智能系統在知識表征、表達能力、優化與學習能力等方面的可解釋性與可量化性以及增強人工智能算法內在機理的可解釋性。

2023-05-24 10:02:16 363

363

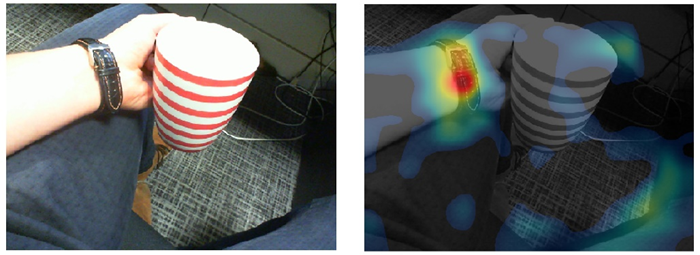

當使用神經網絡時,我們可以通過它的準確性來評估模型的性能,但是當涉及到計算機視覺問題時,不僅要有最好的準確性,還要有可解釋性和對哪些特征/數據點有助于做出決策的理解。模型專注于正確的特征比模型的準確性更重要。

2023-06-09 16:53:54 613

613

為了找到NMT模型的潛在缺陷,構建更加可解釋的知識庫,我們提出以局部準確性這一新概念作為分析角度。其中,局部準確性又包含兩個子概念:條目準確性(entry correctness)和鄰域準確性(neighborhood correctness)。

2023-06-13 15:25:19 390

390

本文旨在更好地理解基于 Transformer 的大型語言模型(LLM)的內部機制,以提高它們的可靠性和可解釋性。 隨著大型語言模型(LLM)在使用和部署方面的不斷增加,打開黑箱并了解它們的內部

2023-06-25 15:08:49 991

991

LLM 是黑箱模型,缺乏可解釋性,因此備受批評。LLM 通過參數隱含地表示知識。因此,我們難以解釋和驗證 LLM 獲得的知識。此外,LLM 是通過概率模型執行推理,而這是一個非決斷性的過程。對于 LLM 用以得出預測結果和決策的具體模式和功能,人類難以直接獲得詳情和解釋。

2023-07-10 11:35:00 1354

1354

隨著人工智能的不斷發展和應用,機器學習模型的大小越來越成為一個重要的問題。在機器學習中,我們通常將模型分為兩類:大模型和小模型。本文將介紹AI大模型和小模型是什么,并分析它們各自的優缺點以及區別。

2023-08-08 16:55:33 4555

4555 非常重要。本文將詳細探討AI算法和模型的區別,并解釋它們在AI應用中的作用。 AI算法 人工智能算法是一組定義和實現任務的計算機指令。例如,許多AI算法用于分類和預測。這些算法可以從數據中提取有用的信息,并根據其他變量預測結果。AI算法適用于處

2023-08-08 17:35:39 2264

2264 咨詢大中華區高級合伙人, 中國區金融行業總經理 范斌 以下為范斌演講內容: IBM 作為一家專注于云計算和 AI 的公司,在金融科技方面有很多的投入和經驗,在中國市場過去幾十年的歷史中,IBM

2023-09-07 18:15:08 294

294

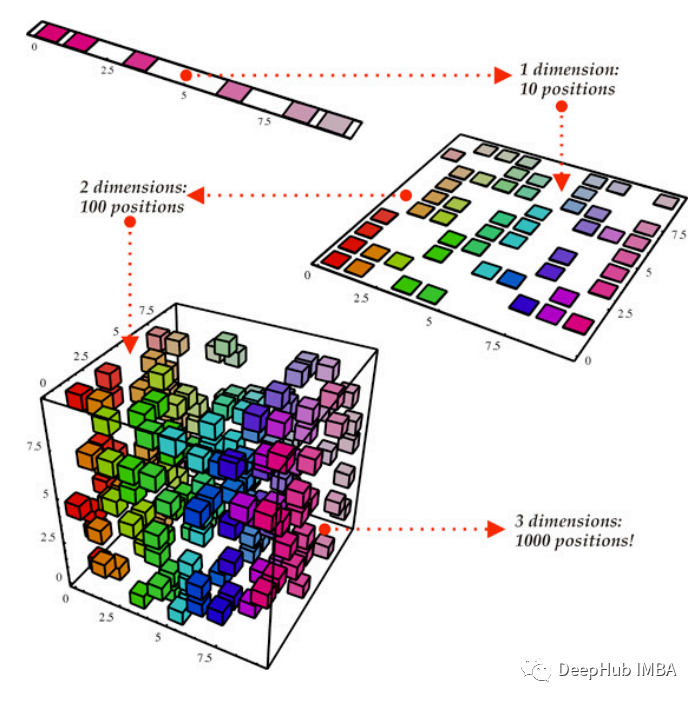

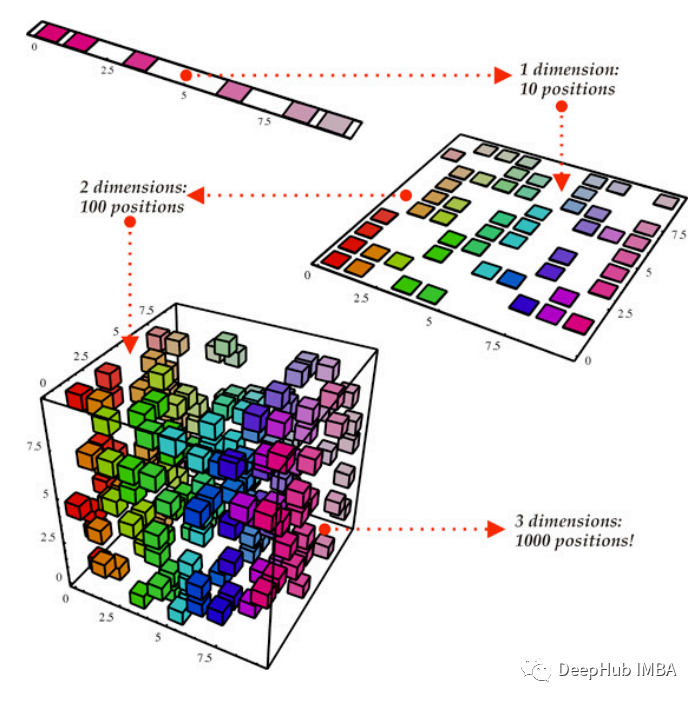

隨著數據集的規模和復雜性的增長,特征或維度的數量往往變得難以處理,導致計算需求增加,潛在的過擬合和模型可解釋性降低。

2023-10-09 10:13:47 422

422

是可解釋AI。比爾.蓋茨預測,未來10年(2030年-2039年),AI領域的主角將成為可解釋AI。 ? 大部分人預判:GPT-5將明顯優于GPT-4,成為生成式AI領域天花板。 盡管OpenAI還沒有對外界公布GPT-5的確切上線時間,甚至還曾遭到馬斯克等人的反對,被其“聯名上

2023-12-06 10:36:01 499

499

除此之外,還存在行業訓練數據安全控制、大模型幻覺緩解消除及可解釋性、構建具有強大邏輯推理規劃能力的大模型、基于圖數據的知識增強技術、通用結構化數據特性對齊和預訓練,以及視覺領域下一個token預測任務建模等挑戰。

2023-12-25 10:33:53 436

436 Density-based方法:基于密度的方法通常采用預訓練的模型來提取輸入圖像的有意義嵌入向量,測試圖像時通過計算嵌入表示與參考表示分布之間的相似度以得到異常分數。這種方法在MVTec AD等數據集上取得了較高的指標分數,但需要預訓練模型加持且可解釋性不足。

2024-01-11 16:02:35 188

188

日前,愛立信宣布在其專為運營商設計的認知軟件組合中,新增采用“可解釋性人工智能(Explainable AI,XAI)”的新功能,進一步加速在網絡設計和優化中采用人工智能后的價值轉化。

2024-02-22 09:22:19 570

570

電子發燒友App

電子發燒友App

評論