人工智能 (AI) 可以追溯到古代,當時的哲學家們編造出了許多關于人造實體如何被賦予人類智能或意識的寓言、神話和謠言。隨著大數據、機器學習、神經網絡技術的不斷演進,AI 技術逐漸從遙遠的寓言和神話中走入真實世界。

近幾十年來,AI 一直處于技術進步的前沿,它被廣泛應用于安防監控、自動駕駛、金融預測、醫療診斷、視頻游戲等領域。

一些 AI 成果包括人臉識別、自然語言處理、語音識別、文本生成、語言翻譯、藥物開發等已經深刻改變了人們對健康、生活、學習和其他方面的看法。毫無疑問,在未來,許多企業將依靠人工智能來提高效率和工作流程。

但是,在 AI 推動生產效率的提升和產業的數字化轉型升級的同時,它所帶來的技術風險和隱私倫理問題同樣值得警惕,黑客也在利用 AI 技術開發軟件程序并執行隱形攻擊。

更重要的是,AI 技術本身也存在安全漏洞。當前主流的深度神經網絡等技術具有的“黑箱屬性”,導致 AI 算法存在不可解釋性。這也就意味著 AI 技術在算法安全性上存在著不確定因素,可能會在產業應用落地中出現各種安全隱患和風險。

當身處數字化轉型升級的各個產業正在享受這一波新的智能化技術紅利的時候,AI 安全問題,就如同網絡安全、信息安全一樣,被提上產業數字化建設的日程表了。

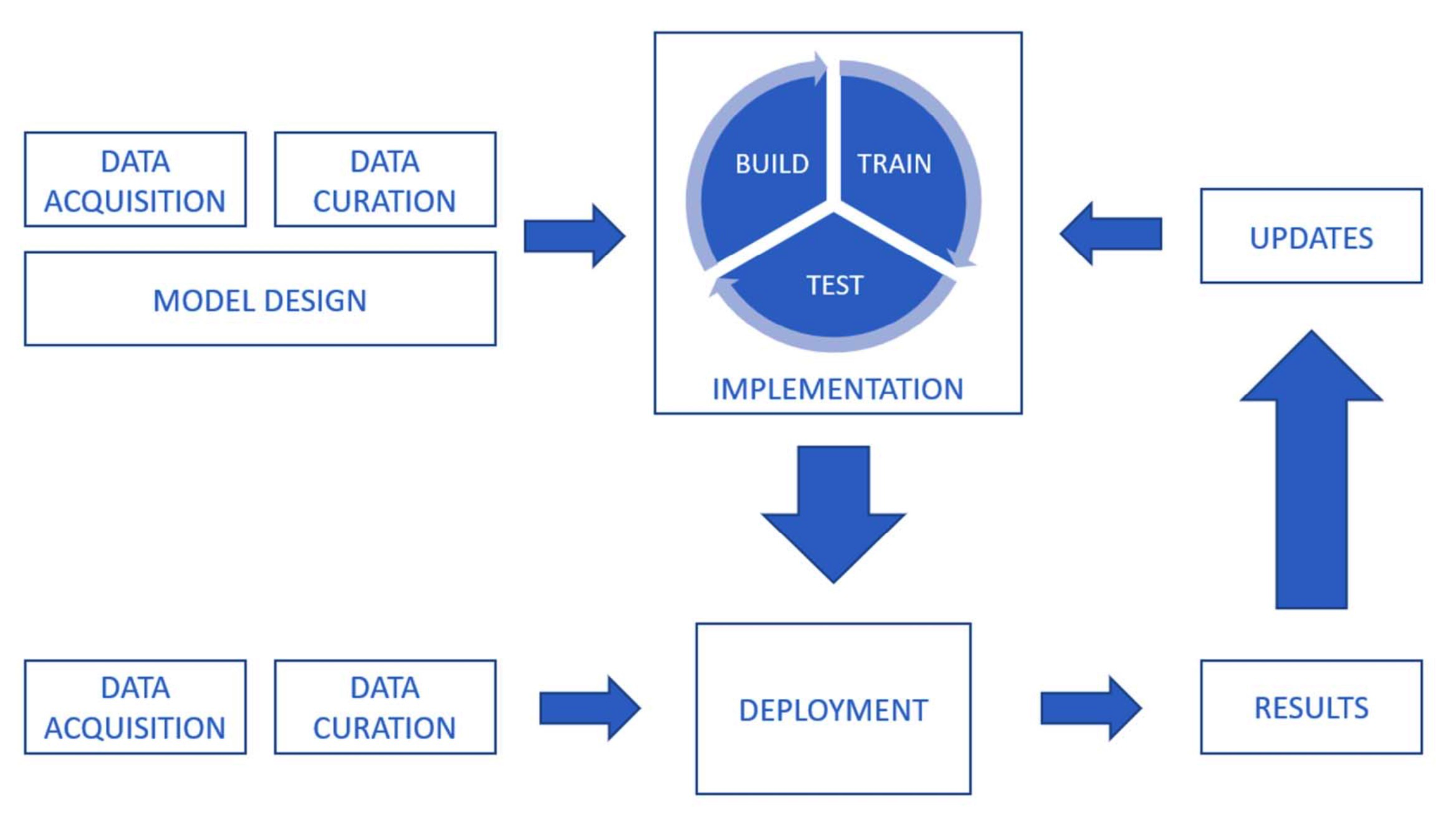

那么,如何部署 AI 技術才會更安全?我們該如何防范利用算法漏洞對 AI 系統進行的惡意攻擊?在訓練 AI 模型時,如何保障數據的隱私和安全?帶著這些問題,我們采訪到了瑞萊智慧 RealAI 公司首席執行官田天,請他來與我們聊一聊 AI 安全領域面臨的挑戰以及應對之策。

以下為訪談實錄,經編輯:

InfoQ:目前 AI 領域面臨的安全威脅都有哪些?

田天:前幾年大家更多關注的是,人工智能如何在場景中應用起來,去提升生活質量以及生產效率等等。但是近年來隨著人工智能開始應用在很多高價值關鍵場景,比如金融、交通等領域,很多安全隱患開始逐步體現出來。我們關注到至少有三方面存在比較重大的安全隱患:

第一,模型算法本身的安全性、可靠性問題。現階段人工智能的發展很多都是基于深度學習、深度神經網絡。隨著神經網絡模型結構越來越復雜,模型越來越大,參數越來越多。其實反過來講,神經網絡模型也是一個越來越復雜、越來越難以理解的黑盒模型。然而黑盒模型就有可能存在一些難以被發現的錯誤邏輯,或者說結構性的算法漏洞、算法后門,黑客可以利用這些漏洞發起攻擊。

以目前大規模落地的人臉識別系統為例,人臉識別系統依靠海量人臉數據進行特征提取、訓練,進而進行識別,整個過程為黑箱模式,缺乏可解釋性,黑產分子可利用漏洞進行多種模式的繞過與攻擊。例如對抗樣本攻擊,在人臉照片上添加少量干擾或將對抗補丁打印制作后由真人佩戴,就能欺騙人臉識別系統。除了人臉識別系統,自動駕駛汽車搭載的感知系統也同樣能夠被攻擊,比如障礙物上加裝干擾因素,改變表面顏色、修改形狀,就可能誤導感知算法,讓車輛無法感知到障礙物,這些都是算法層的安全漏洞,存在巨大的安全隱患。

第二,數據安全。人工智能的發展離不開大數據,要構造能力更強的人工智能,需要更多、更關鍵以及更高價值的數據。但是高價值數據往往與個人隱私信息,甚至商業機密信息相綁定。那么在落地 AI 的過程中,就可能在數據應用或者流通環節造成信息泄露。比如近些年愈演愈烈的電信詐騙,源頭就來自于個人信息泄露,詐騙分子利用非法渠道獲取的隱私數據偽造身份信息實行欺詐。所以,如何在保證發揮人工智能作用的同時,確保數據使用的安全,這是非常關鍵的問題。

第三,技術的應用可控問題,簡單來講就是 AI 濫用問題。因為人工智能是一個能力非常強的工具,但是工具就具有兩面性質,可以被用于造福人類的場景,反過來也可能被不正當的利用。比如最典型的深度合成技術,也就是我們熟知的“AI 換臉”,這項技術能夠升級影視制作、廣告營銷等場景中的內容制作效率和質量,并為一些全新場景提供了技術可能,例如虛擬主播。但這項技術目前卻被大規模的濫用,比如通過“AI 換臉”技術進行色情視頻生成、編造虛假新聞等。一些黑產分子甚至通過使用軟件程序低成本地合成帶有各種動作的人臉視頻,結合注入攻擊手段后便可以輕易欺騙線上人臉識別系統,進而從事詐騙行為。我們認為防范 AI 濫用,也是整個人工智能應用環節必須要關注到的安全風險。

InfoQ:現在大家對抗性機器學習的受關注熱度比較高,什么是對抗性機器學習,常見的對抗性機器學習的場景有哪些?

田天:對抗性機器學習最典型的是針對深度學習、深度神經網絡的對抗,也就是上個問題中算法安全部分我們提到的。深度神經網絡其實是非常復雜的模型,而復雜模型本身就是一個黑盒,黑盒的設計者、開發者也不知道模型內部結構、算法的運算邏輯是怎樣的。對抗機器學習包含攻擊手段與防御手段。攻擊端就是利用攻擊手段去尋找模型設計過程中存在的缺陷或漏洞,相當于找模型什么時候會出錯。防御側則是在發現隱患或漏洞后,通過對抗訓練、外部接入保護措施等方式,來提升整個模型的安全性,保證模型在受到攻擊后的安全運行。

其實,在人工智能應用的各個場景中,廣泛存在著對抗機器學習的問題。典型的比如圖像領域的人臉識別、圖像分類以及目標檢測,都存在算法安全問題,像上面提到的通過特定的攻擊方式能夠讓模型失效,因此需要通過對抗學習的方式來提升安全性。除此,語音識別、推薦系統,甚至自然語言處理等等,各個場景都存在著對抗。另外按照攻擊類型來分,可分為有目標攻擊和無目標攻擊等不同類型。所以整個對抗機器學習是一個非常大的技術體系,需要進行專門研究。

InfoQ:我們花費大量的人力、物力研發出了一個模型以后,是不是攻擊者也要付出很大的代價來攻擊它?

田天:對于攻擊者來說,如果要做白盒攻擊,就需要獲得被攻擊模型的所有信息,包括網絡結構、參數等等,這其實是非常難、成本很高的一件事情。退而求其次,如果去做黑盒攻擊,實施起來相對就會容易一些,一類被稱為查詢攻擊的方法是需要去持續請求被攻擊模型,獲得該模型在特定樣本上給出來的反饋結果,另一類被稱為遷移攻擊的方法,甚至可以不用在實施真正的攻擊前去請求被攻擊模型。所以攻擊技術也在演化,相當于是很多人在嘗試去降低攻擊的成本,而且隨著技術的開源化、工具化,攻擊的難度和成本肯定是逐步降低的。

InfoQ:目前對抗性機器學習對于 AI 和機器學習系統造成的主要危害有哪些?

田天:主要危害在于讓算法出錯,使 AI 系統無法給出正確的結果。以人臉識別為例,比如刷臉閘機,正常情況下,只有存有身份信息獲得授權的人員才能通過。但是利用算法漏洞,我作為一個未授權人員通過在面部添加特定干擾,就能讓系統出錯通過閘機。這相當于產品的基本功能失效了,存在明顯的危害。

InfoQ:在自動駕駛領域,比如很多車企之前就曝光因自動駕駛系統失控發生多起安全事故,威脅到駕駛員的人身安全,對于這種現象您怎么看?

田天:自動駕駛的很多安全問題也源自于算法本身的不可靠、魯棒性差。一方面在于,自動駕駛系統本身的魯棒性就比較差,在特殊的場景下,或者一些極端情況下很容易出錯另外,還有可能被人利用算法漏洞惡意發起攻擊,與上面人臉識別的問題類似,攻擊者修改目標物體的顏色、形狀等,就能讓自動駕駛車輛的攝像頭,甚至激光雷達失效,目前這類攻擊成功率是非常高的。

InfoQ:針對這樣的安全隱患,我們有哪些防范措施?

田天:針對這個問題,我們在做兩方面的工作。以網絡安全作為對比,隨著互聯網的發展,互聯網領域存在很多網絡安全隱患,因此出現了一系列工具來增強網絡系統的安全性,比如大家比較熟悉的殺毒軟件、防火墻。

類似的,我們在做針對 AI 系統的殺毒軟件和防火墻。這里的“殺毒軟件”是我們推出的業內首個人工智能安全平臺 RealSafe,通過內置一系列攻擊算法和防御算法,提供從模型安全測試到模型安全加固一站式能力。例如一套人臉識別系統,接入到平臺后,可以調用攻擊算法模塊對系統自動進行模擬攻擊,平臺會輸出安全性評分報告,借此得知系統模型在什么樣的情況下容易受到攻擊。在發現安全隱患之后,針對每一種漏洞或攻擊風險,平臺搭載了對應的防御模塊,通過對抗訓練或者其他方式來增強模型的安全性。

另外,我們也開發標準化的 AI 安全防火墻。比如現階段的人臉識別系統存在一系列的模型和算法漏洞,容易受到攻擊,我們在現有人臉識別流程中前置防火墻模塊,識別請求先過防火墻,防火墻來判斷里面輸入數據中是否存在攻擊。如果沒有攻擊,正常進入后面的識別環節,如果有攻擊就直接拒絕,保證系統不受攻擊,更加安全。

InfoQ:您說的 AI 安全平臺以及防火墻這樣的工具,目前的效果是怎么樣的,如果要給這個效果從 1-10 打分,您會打幾分?

田天:安全問題進入 AI 時代,最明顯的特征就是深度神經網絡增強了 AI 的自我學習和升級迭代能力,而這種能力自然也被攻擊者所掌握。所以,AI 時代談安全,其實不僅僅是談“魔高一尺道高一丈”的問題,更是談“魔”和“道”誰對誰的感知能力更強,誰更有預見性和主動權的問題。針對這樣的新特點,瑞萊智慧人臉識別防火墻 RealGuard 具備兩個最主要的優勢:一是對人臉識別物理和數字世界的全景式安全態勢感知能力,始終力爭讓“道”走在“魔”的前面,這其中的底氣來源于瑞萊智慧依托清華多年來對人工智能安全算法、對構建第三代人工智能的科研攻堅。二是對攻擊防御的高準確率,目前,RealGuard 可以針對對抗樣本攻擊、面部替換攻擊、表情操縱攻擊等新型人臉識別安全風險,做到全覆蓋防御。如果說要對效果進行打分,那我更愿意用產品的客觀運行數據說話,RealGuard 目前針對攻擊的拒絕率達到 98% 以上。

InfoQ:這兩款產品目前的應用進展如何,有取得哪些成效?

田天:目前這兩款產品已經在金融、政府等領域落地。比如在金融領域,我們與多家國有行、股份制銀行合作,提供人臉識別系統的安全檢測與加固服務;在政府領域,我們與公安部門合作,提供監控視頻智能化方案,基于攻防加固提升監控系統的安全性;包括我們與多家整車廠商合作,提供自動駕駛安全解決方案。

InfoQ:經過多年的發展,您認為人工智能安全的研究發展到了哪個階段?

田天:現在這個領域已經走出實驗室,進入到產業化的階段。隨著近年來安全事件的層出不窮,以及政策監管的重視,市場迫切需要針對 AI 應用的安全產品。其實包括我們在內,國內外近年來也陸續出現一些團隊開始從事這一領域,布局商業化的 AI 安全產品,推出相關的軟件、系統、硬件等等。尤其今年來看,產業已經開始進入快速發展的落地期,金融、公安等重點領域都開始落地。

InfoQ:您覺得未來 AI 安全將會朝哪個方向發展,有哪些技術值得關注?

田天:第一,AI 對抗攻防技術必須要持續研究。因為攻擊和防御是一個持續升級的過程,新的攻擊手段會不斷地產生,因此也需要不斷研究新的防御手段;

第二,對合成技術的安全問題需要加大關注。因為隨著技術的不斷成熟,合成類內容在清晰度、流暢度、逼真度等各方面都有大幅提升,已經超越了人眼分辨的極限,真假難辨的背后是對社會信任的沖擊,危害性在不斷增強,因此必須依靠技術手段對這類偽造內容進行判別以及溯源;

第三,需要去發展與人工智能相適應的隱私保護技術,確保人工智能應用過程中,對敏感數據的保護,不泄露數據。并且,這三方面需要去并行發展。

編輯:黃飛

?

電子發燒友App

電子發燒友App

評論