ChatGPT發(fā)布之后,引發(fā)了全球范圍的關(guān)注和討論,國(guó)內(nèi)各大廠商相繼宣布GPT模型開發(fā)計(jì)劃。據(jù)各公司官網(wǎng),2023年2月7日,百度宣布將推出ChatGPT類似產(chǎn)品“文心一言”,預(yù)計(jì)今年3月展開內(nèi)測(cè);2月8日阿里宣布阿里版ChatGPT正在研發(fā)中,目前處于內(nèi)測(cè)階段;2月9日,字節(jié)跳動(dòng)旗下AI Lab宣布正在開展ChatGPT和AIGC相關(guān)研發(fā),未來將為PICO提供技術(shù)支持;2月10日,京東旗下言犀人工智能平臺(tái)推出產(chǎn)業(yè)版ChatGPT—“ ChatJD”。 ?

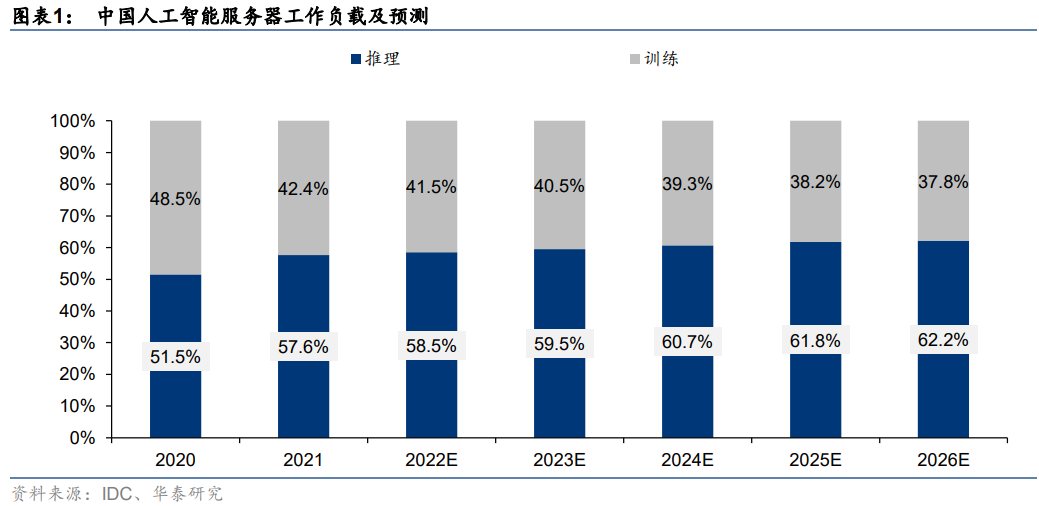

AI模型對(duì)算力的需求主要體現(xiàn)在訓(xùn)練和推理兩個(gè)層面。當(dāng)前主流的人工智能算法通常可分為“訓(xùn)練”和“推理”兩個(gè)階段。據(jù)IDC數(shù)據(jù),2021年中國(guó)人工智能服務(wù)器工作負(fù)載中,57.6%的負(fù)載用于推理,42.4%用于模型訓(xùn)練。據(jù)IDC預(yù)計(jì),到2026年AI推理的負(fù)載比例將進(jìn)一步提升至62.2%。具體來看:

1)訓(xùn)練階段:基于充裕的數(shù)據(jù)來調(diào)整和優(yōu)化人工智能模型的參數(shù),使模型的準(zhǔn)確度達(dá)到預(yù)期。對(duì)于圖像識(shí)別、語音識(shí)別與自然語言處理等領(lǐng)域的復(fù)雜問題,為了獲得更準(zhǔn)確的人工智能模型,訓(xùn)練階段常常需要處理大量數(shù)據(jù)集、做反復(fù)的迭代計(jì)算,耗費(fèi)巨大的運(yùn)算量。

2)推理階段:訓(xùn)練階段結(jié)束以后,人工智能模型已經(jīng)建立完畢,已可用于推理或預(yù)測(cè)待處理輸入數(shù)據(jù)對(duì)應(yīng)的輸出(例如給定一張圖片,識(shí)別該圖片中的物體),此過程被稱為推理階段。推理階段對(duì)單個(gè)任務(wù)的計(jì)算能力要求不如訓(xùn)練那么大,但是由于訓(xùn)練出來的模型會(huì)多次用于推理,因此推理運(yùn)算的總計(jì)算量也相當(dāng)可觀。

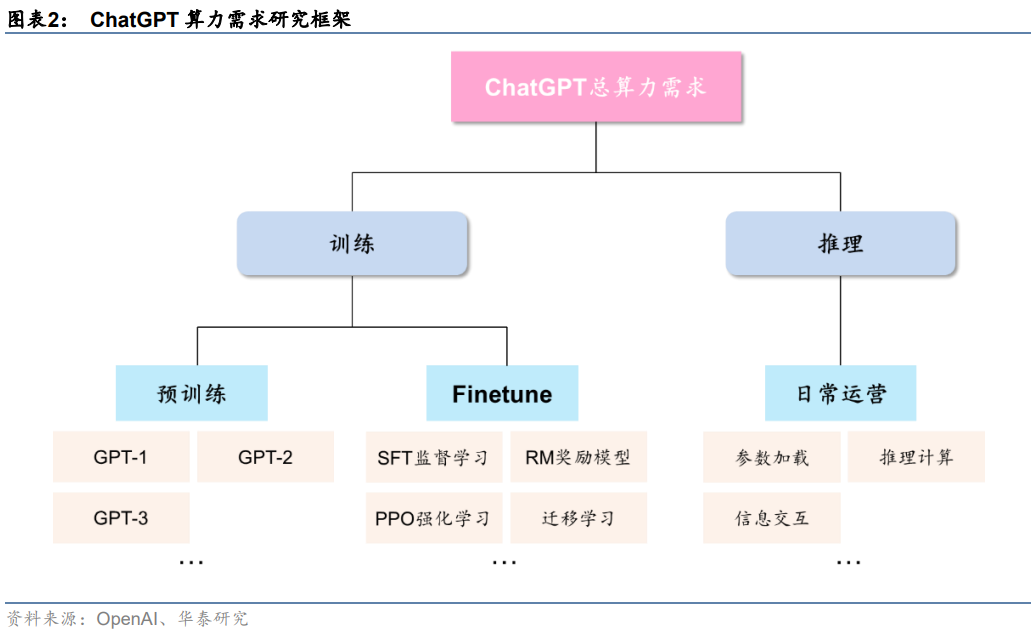

ChatGPT算力需求場(chǎng)景包括預(yù)訓(xùn)練、Finetune及日常運(yùn)營(yíng)。從ChatGPT實(shí)際應(yīng)用情況來看,從訓(xùn)練+推理的框架出發(fā),我們可以將ChatGPT的算力需求按場(chǎng)景進(jìn)一步拆分為預(yù)訓(xùn)練、Finetune及日常運(yùn)營(yíng)三個(gè)部分:

1)預(yù)訓(xùn)練:主要通過大量無標(biāo)注的純文本數(shù)據(jù),訓(xùn)練模型基礎(chǔ)語言能力,得到類似GPT-1/2/3這樣的基礎(chǔ)大模型;

2)Finetune:在完成預(yù)訓(xùn)練的大模型基礎(chǔ)上,進(jìn)行監(jiān)督學(xué)習(xí)、強(qiáng)化學(xué)習(xí)、遷移學(xué)習(xí)等二次或多次訓(xùn)練,實(shí)現(xiàn)對(duì)模型參數(shù)量的優(yōu)化調(diào)整;

3)日常運(yùn)營(yíng):基于用戶輸入信息,加載模型參數(shù)進(jìn)行推理計(jì)算,并實(shí)現(xiàn)最終結(jié)果的反饋輸出。

預(yù)訓(xùn)練階段:?jiǎn)未嗡懔π枨笕Q于模型參數(shù)量,最高可達(dá)3640 PFlop/s-day

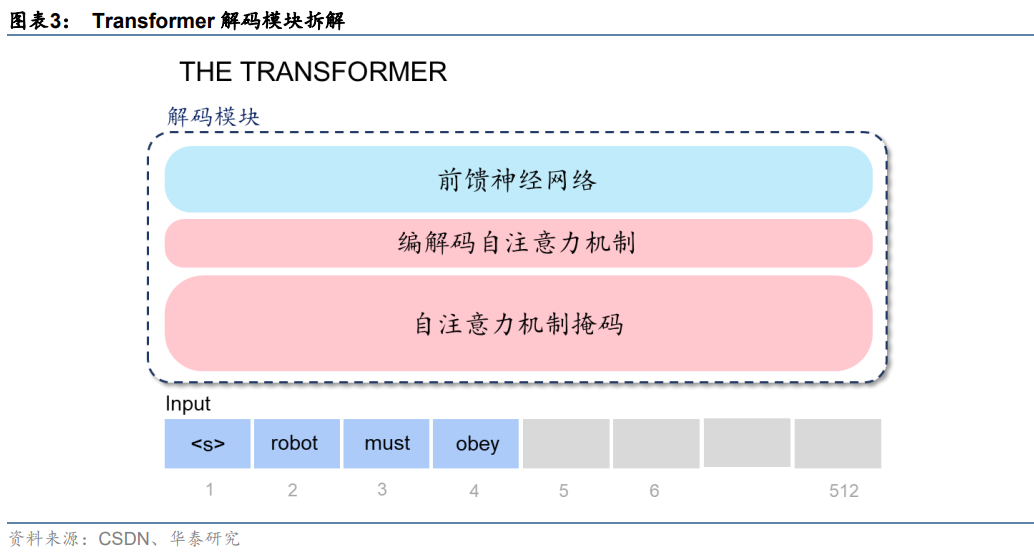

ChatGPT基于Transformer架構(gòu),進(jìn)行語言模型預(yù)訓(xùn)練。GPT模型之所以能夠高效地完成大規(guī)模參數(shù)計(jì)算,我們認(rèn)為離不開Transformer架構(gòu)的加持。拆解Transformer架構(gòu)來看,核心是由編碼模塊和解碼模塊構(gòu)成,而GPT模型只用到了解碼模塊。拆解模塊來看,大致分為三層:前饋神經(jīng)網(wǎng)絡(luò)層、編碼/解碼自注意力機(jī)制層(Self-Attention)、自注意力機(jī)制掩碼層,其中:

1)注意力機(jī)制層主要作用在于計(jì)算某個(gè)單詞對(duì)于全部單詞的權(quán)重(即Attention),從而能夠更好地去學(xué)習(xí)所有輸入之間的關(guān)系,實(shí)現(xiàn)對(duì)文本內(nèi)在關(guān)系的理解和更大規(guī)模的并行計(jì)算;

2)前饋神經(jīng)網(wǎng)絡(luò)提供了對(duì)數(shù)據(jù)信息的高效存儲(chǔ)及檢索;3)掩碼層在這一過程中幫助模型屏蔽位于計(jì)算位置右側(cè)尚未出現(xiàn)的單詞。因此,相較于前代深度學(xué)習(xí)架構(gòu)RNN,Transformer架構(gòu)可以實(shí)現(xiàn)更大規(guī)模的并行計(jì)算,大大提升了計(jì)算效率。

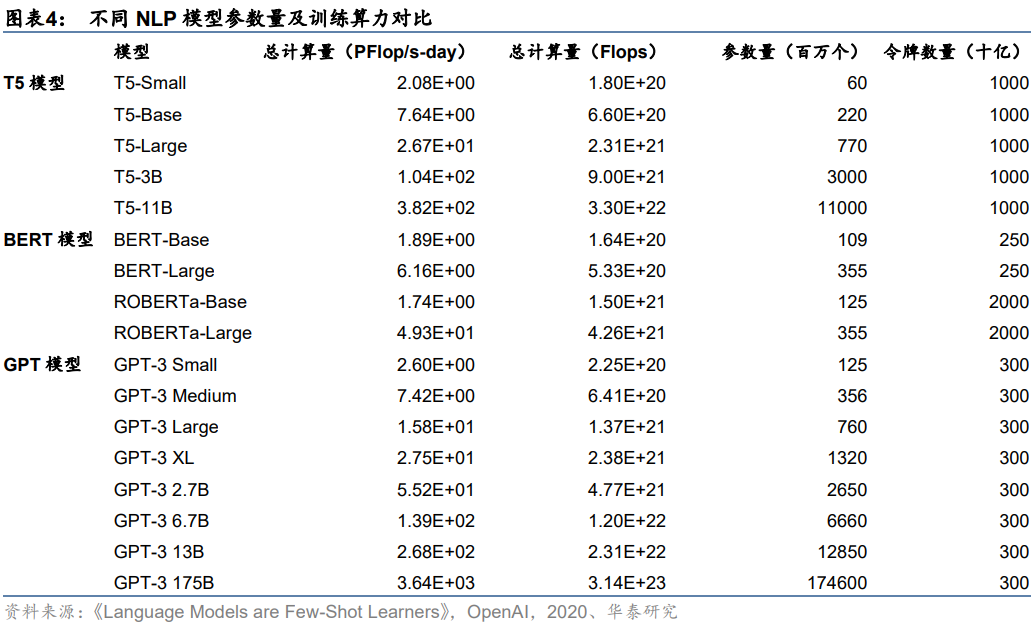

單一大模型路線下,需要完成大規(guī)模參數(shù)計(jì)算。以GPT-3模型為例,隨著模型朝更大體量的方向演進(jìn),參數(shù)量從GPT-3 Small的1.25億個(gè)增長(zhǎng)到GPT-3 175B的1746億個(gè),一次訓(xùn)練所需的計(jì)算量從2.6PFlop/s-day增至3640PFlop/s-day。與此同時(shí),在不同學(xué)習(xí)樣本(包括小樣本、單一樣本、零樣本)條件下的模型,隨著參數(shù)量的提升均實(shí)現(xiàn)不同幅度的上下文學(xué)習(xí)能力改善,外在表現(xiàn)為語言準(zhǔn)確率的提升。我們認(rèn)為,隨著大模型訓(xùn)練表現(xiàn)出越來越強(qiáng)大的實(shí)戰(zhàn)能力,未來或?qū)⒊蔀镹LP訓(xùn)練的主流選擇。

推理階段:預(yù)計(jì)單月運(yùn)營(yíng)算力需求約7034.7 PFlop/s-day

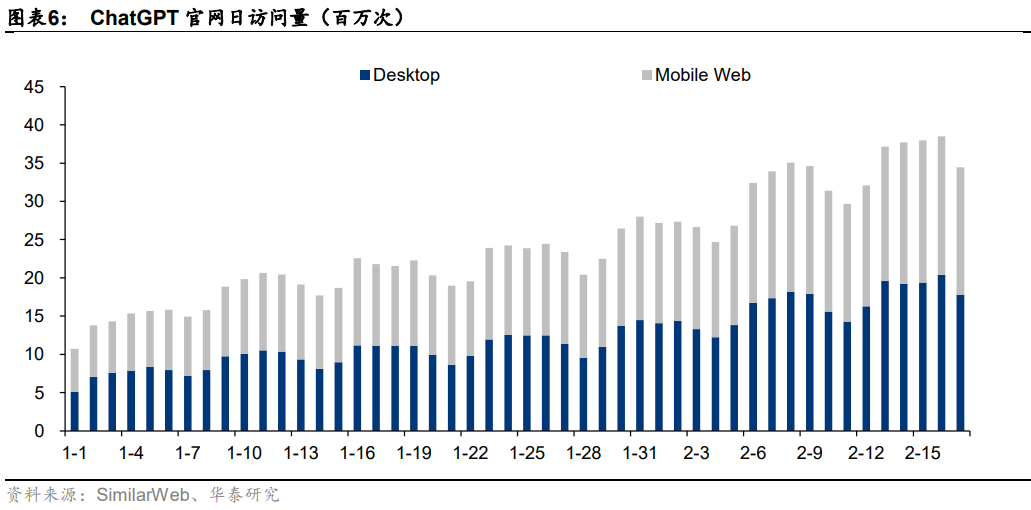

ChatGPT近一月訪問量為8.89億次。據(jù)SimilarWeb數(shù)據(jù),2023年1月以來ChatGPT官網(wǎng)日訪問量持續(xù)攀升,從1月初的日均千萬次級(jí)別,到1月底日均兩千萬次,再到2月中旬的三千萬次級(jí)別,隨著軟件效果的廣泛傳播,用戶訪問次數(shù)愈發(fā)頻繁。加總近一月(2023/1/17-2023/2/17)ChatGPT官網(wǎng)訪問量數(shù)據(jù)來看,可得ChatGPT月訪問量為8.89億次。

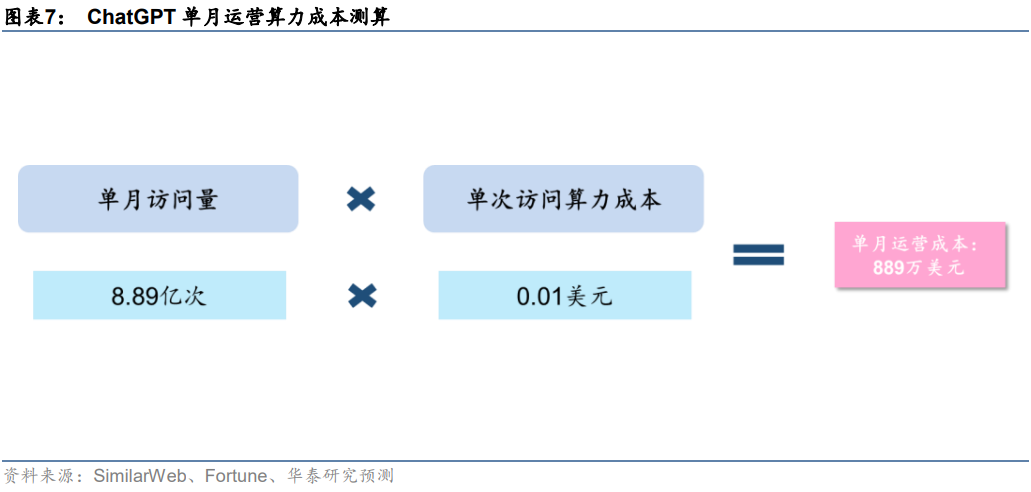

預(yù)計(jì)日常運(yùn)營(yíng)單月所需算力約7034.7 PFlop/s-day。日常運(yùn)營(yíng)過程中,用戶交互帶來的數(shù)據(jù)處理需求同樣也是一筆不小的算力開支。據(jù)前文,近一個(gè)月(2023/1/17-2023/2/17)ChatGPT官網(wǎng)總訪問量為8.89億次。據(jù)Fortune雜志,每次用戶與ChatGPT互動(dòng),產(chǎn)生的算力云服務(wù)成本約0.01美元。基于此,我們測(cè)算得2023年1月OpenAI為ChatGPT支付的運(yùn)營(yíng)算力成本約889萬美元。此外,據(jù)Lambda,使用訓(xùn)練一次1746億參數(shù)的GPT-3模型所需花費(fèi)的算力成本超過460萬美元;據(jù)OpenAI,訓(xùn)練一次1746億參數(shù)的GPT-3模型需要的算力約為3640 PFlop/s-day。我們假設(shè)單位算力成本固定,測(cè)算得ChatGPT單月運(yùn)營(yíng)所需算力約7034.7PFlop/s-day。

Finetune階段:預(yù)計(jì)ChatGPT單月Finetune的算力需求至少為1350.4PFlop/s-day

模型迭代帶來Finetune算力需求。從模型迭代的角度來看,ChatGPT模型并不是靜態(tài)的,而是需要不斷進(jìn)行Finetune模型調(diào)優(yōu),以確保模型處于最佳應(yīng)用狀態(tài)。這一過程中,一方面是需要開發(fā)者對(duì)模型參數(shù)進(jìn)行調(diào)整,確保輸出內(nèi)容不是有害和失真的;另一方面,需要基于用戶反饋和PPO策略,對(duì)模型進(jìn)行大規(guī)模或小規(guī)模的迭代訓(xùn)練。因此,模型調(diào)優(yōu)同樣會(huì)為OpenAI帶來算力成本,具體算力需求和成本金額取決于模型的迭代速度。

預(yù)計(jì)ChatGPT單月Finetune算力需求至少為1350.4PFlop/s-day。據(jù)IDC預(yù)計(jì),2022年中國(guó)人工智能服務(wù)器負(fù)載中,推理和訓(xùn)練的比例分別為58.5%、41.5%。我們假設(shè),ChatGPT對(duì)推理和訓(xùn)練的算力需求分布與之保持一致,且已知單月運(yùn)營(yíng)需要算力7034.7 PFlop/s-day、一次預(yù)訓(xùn)練需要算力3640 PFlop/s-day。基于此,我們進(jìn)一步假設(shè):1)考慮到AI大模型預(yù)訓(xùn)練主要通過巨量數(shù)據(jù)喂養(yǎng)完成,模型底層架構(gòu)變化頻率不高,故我們假設(shè)每月最多進(jìn)行一次預(yù)訓(xùn)練;2)人類反饋機(jī)制下,模型需要不斷獲得人類指導(dǎo)以實(shí)現(xiàn)參數(shù)調(diào)優(yōu),以月為單位可能多次進(jìn)行。由此我們計(jì)算得ChatGPT單月Finetune算力成本至少為1350.4PFlop/s-day。

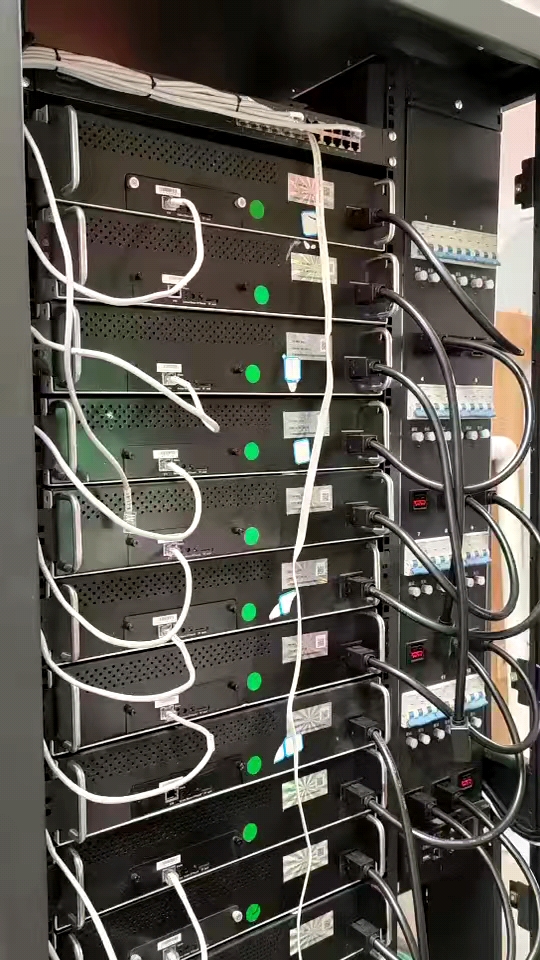

1、ChatGPT需要的服務(wù)器:AI訓(xùn)練型服務(wù)器+AI推理型服務(wù)器

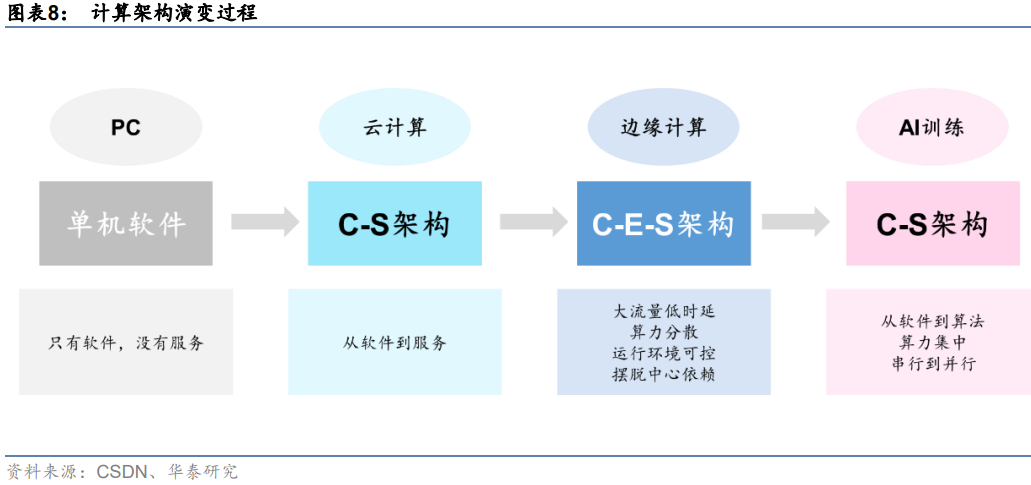

隨著計(jì)算場(chǎng)景擴(kuò)展,算力硬件也在發(fā)生變化。在傳統(tǒng)軟件架構(gòu)下,主要的模式都是CS模式,服務(wù)端大多是單機(jī)處理幾千個(gè)輕量請(qǐng)求。而在邊緣計(jì)算場(chǎng)景下,需要數(shù)萬臺(tái)服務(wù)器處理上億個(gè)重負(fù)載請(qǐng)求。邊緣計(jì)算機(jī)本質(zhì)上是用CES模式取代CS模式,當(dāng)前的互聯(lián)網(wǎng)IT架構(gòu)已經(jīng)從CS模式,逐步向CDN服務(wù)為核心的CES模式轉(zhuǎn)變。但當(dāng)前的CDN模式比較大的局限性在于缺乏靈活性,不能解決邊緣上非結(jié)構(gòu)化數(shù)據(jù)存儲(chǔ)和處理的需求,引入Edge端(邊緣端)就是為了解決CS模式下無法處理的業(yè)務(wù)。而在AI訓(xùn)練場(chǎng)景下,計(jì)算量及數(shù)據(jù)類型的變化導(dǎo)致C-E-S又無法滿足集中大算力需求,計(jì)算架構(gòu)回歸C-S,并向高效率并行計(jì)算演變。

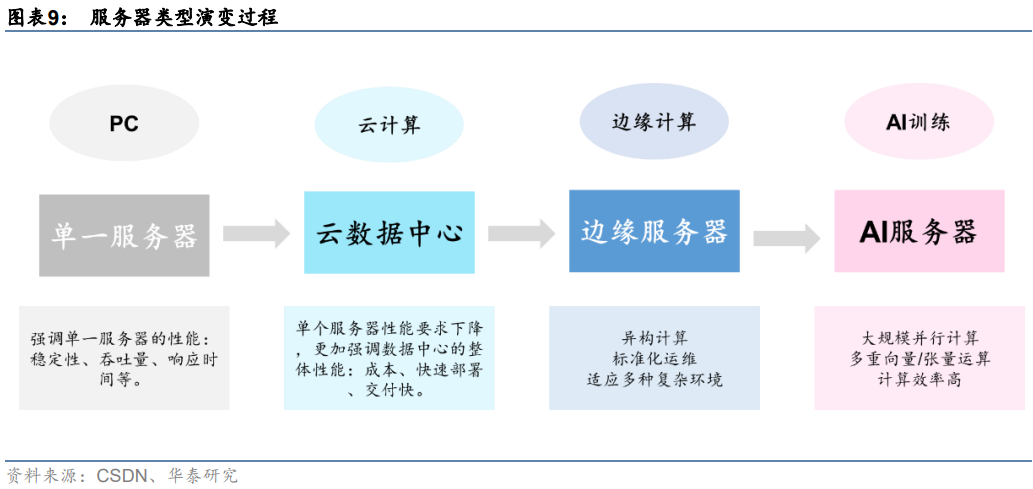

服務(wù)器作為算力硬件核心,面向不同計(jì)算場(chǎng)景分化演進(jìn)。我們認(rèn)為,計(jì)算架構(gòu)的變化是推動(dòng)服務(wù)器技術(shù)演進(jìn)的關(guān)鍵變量。從計(jì)算場(chǎng)景來看,隨著計(jì)算架構(gòu)從PC到云計(jì)算,到邊緣計(jì)算,再到AI訓(xùn)練,服務(wù)器需求也在發(fā)生相應(yīng)變化。從單一服務(wù)器更加強(qiáng)調(diào)服務(wù)個(gè)體性能,如穩(wěn)定性、吞吐量、響應(yīng)時(shí)間等。云數(shù)據(jù)中心服務(wù)器對(duì)單個(gè)服務(wù)器性能要求下降,但更強(qiáng)調(diào)數(shù)據(jù)中心整體性能,如成本、快速部署和交付。邊緣計(jì)算場(chǎng)景下,開始出現(xiàn)異構(gòu)計(jì)算等復(fù)雜環(huán)境計(jì)算,對(duì)數(shù)據(jù)交互實(shí)時(shí)性要求有所提升,需要在邊緣端設(shè)立單獨(dú)的服務(wù)器設(shè)施。而AI服務(wù)器主要專為人工智能訓(xùn)練設(shè)計(jì),數(shù)據(jù)類型以向量/張量為主,多采用大規(guī)模并行計(jì)算以提升運(yùn)算效率。

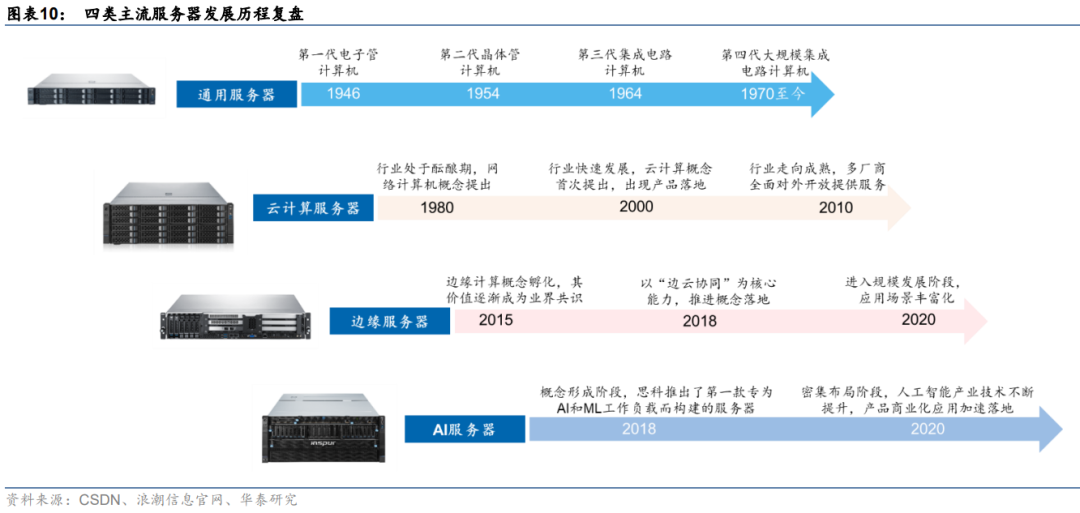

同一技術(shù)路線下,服務(wù)器面向數(shù)據(jù)處理需求持續(xù)迭代。復(fù)盤主流服務(wù)器發(fā)展歷程來看,隨著數(shù)據(jù)量激增、數(shù)據(jù)場(chǎng)景復(fù)雜化,不同類型服務(wù)器發(fā)展驅(qū)動(dòng)力也有所差異。具體來看:

1)通用服務(wù)器:傳統(tǒng)通用服務(wù)器的發(fā)展與計(jì)算機(jī)架構(gòu)發(fā)展同步,通過處理器的時(shí)鐘頻率、指令集并行度、核數(shù)等硬件指標(biāo)的提升優(yōu)化自身性能,發(fā)展較為緩慢。

2)云計(jì)算服務(wù)器:云計(jì)算的概念于20世紀(jì)80年代提出,僅20年后就有較為成熟的產(chǎn)品推出,如VMware的VMware Workstation和亞馬遜AWS等。2010年隨著OpenStack開源,阿里云、華為云等項(xiàng)目相繼布局,云計(jì)算行業(yè)快速走向成熟。

3)邊緣計(jì)算服務(wù)器:邊緣計(jì)算概念孵化于2015年,僅2年后就有諸如亞馬遜AWS Greengrass、谷歌GMEC等邊緣計(jì)算平臺(tái)產(chǎn)生,并在微軟的帶領(lǐng)下提前進(jìn)入技術(shù)并購期。

4)AI服務(wù)器:AI服務(wù)器最早由思科在2018推出,專為人工智能、機(jī)器學(xué)習(xí)的工作服務(wù)而設(shè)計(jì),硬件架構(gòu)更加適合AI訓(xùn)練場(chǎng)景下的算力需求。

2、云計(jì)算服務(wù)器:大規(guī)模數(shù)據(jù)處理需求下的商業(yè)模式變革

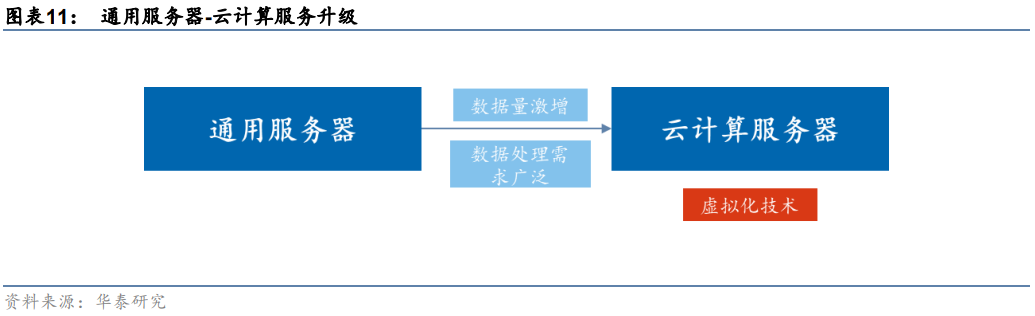

數(shù)據(jù)量激增帶來大算力需求,云計(jì)算服務(wù)器應(yīng)運(yùn)而生。通用服務(wù)器通過提高硬件指標(biāo)提升性能,而隨著CPU的工藝和單個(gè)CPU的核心數(shù)量接近極限,通用服務(wù)器性能難以支持?jǐn)?shù)據(jù)量激增帶來的性能需求。云計(jì)算服務(wù)器則通過虛擬化技術(shù),將計(jì)算和存儲(chǔ)資源進(jìn)行池化,把原來物理隔離的單臺(tái)計(jì)算資源進(jìn)行虛擬化和集中化。最終以集群化處理來達(dá)到單臺(tái)服務(wù)器所難以實(shí)現(xiàn)的高性能計(jì)算。同時(shí),云計(jì)算服務(wù)器集群的計(jì)算能力可以通過不斷增加虛擬化服務(wù)器的數(shù)量來進(jìn)行擴(kuò)展,突破單個(gè)服務(wù)器硬件限制,應(yīng)對(duì)數(shù)據(jù)量激增帶來的性能需求。

云計(jì)算服務(wù)器節(jié)約部分硬件成本,降低算力采購門檻。早期大規(guī)模數(shù)據(jù)處理成本極高,原因在于通用服務(wù)器的購置和運(yùn)維成本居高不下。傳統(tǒng)服務(wù)器中均包含處理器摸塊、存儲(chǔ)模塊、網(wǎng)絡(luò)模塊、電源、風(fēng)扇等全套設(shè)備,而云計(jì)算服務(wù)器體系架構(gòu)精簡(jiǎn),省去重復(fù)的模塊,提高了利用率。同時(shí)云計(jì)算服務(wù)器針對(duì)節(jié)能需求,將存儲(chǔ)模塊進(jìn)行虛擬化,并去除了主板上的非必要硬件,降低了整體計(jì)算成本,并通過流量計(jì)費(fèi)模式,使得更多廠商可以負(fù)擔(dān)算力開支,降低了算力采購門檻。

3、邊緣服務(wù)器:高數(shù)據(jù)密度和帶寬限制下保證低時(shí)延

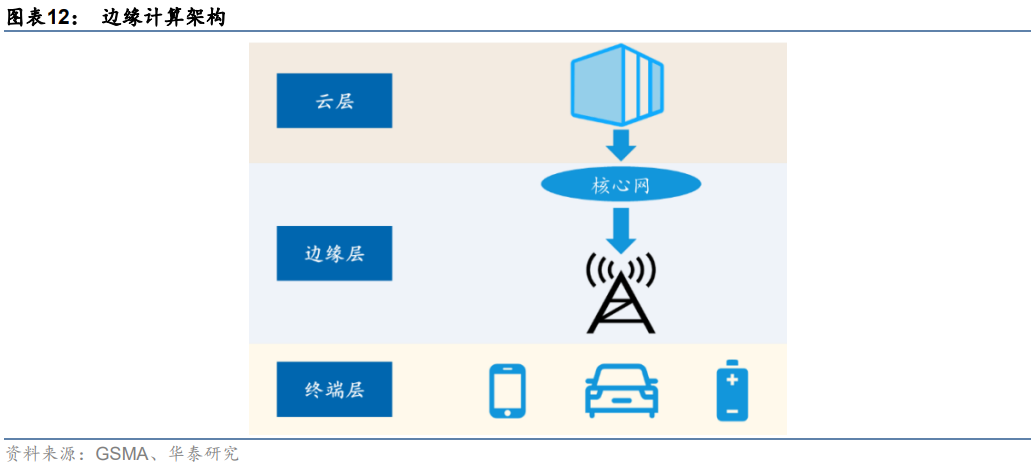

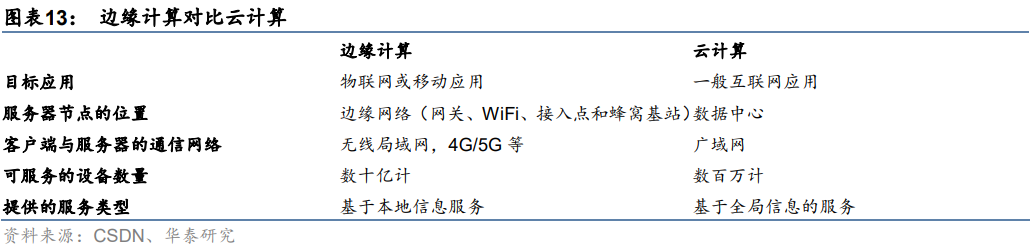

邊緣計(jì)算在云計(jì)算的基礎(chǔ)上引入邊緣層。邊緣計(jì)算是在靠近物或數(shù)據(jù)源頭的網(wǎng)絡(luò)邊緣側(cè),為應(yīng)用提供融合計(jì)算、存儲(chǔ)和網(wǎng)絡(luò)等資源。在體系架構(gòu)上,邊緣計(jì)算在終端層和云層之間引入邊緣層,從而將云服務(wù)擴(kuò)展到網(wǎng)絡(luò)邊緣。其中終端層由物聯(lián)網(wǎng)設(shè)備構(gòu)成,最靠近用戶,負(fù)責(zé)收集原始數(shù)據(jù)并上傳至上層進(jìn)行計(jì)算;邊緣層由路由器、網(wǎng)關(guān)、邊緣服務(wù)器等組成,由于距離用戶較近,可以運(yùn)行延遲敏感應(yīng)用,滿足用戶對(duì)低時(shí)延的要求;云層由高性能服務(wù)器等組成,可以執(zhí)行復(fù)雜計(jì)算任務(wù)。

邊緣計(jì)算較云計(jì)算在實(shí)時(shí)性、低成本和安全性等方面有優(yōu)勢(shì):

1)實(shí)時(shí)性:邊緣計(jì)算將原有云計(jì)算中心的計(jì)算任務(wù)部分或全部遷移到與用戶距離更近的網(wǎng)絡(luò)邊緣進(jìn)行處理,而不是在外部數(shù)據(jù)中心或云端進(jìn)行,因此提高了數(shù)據(jù)傳輸性能,保證了處理的實(shí)時(shí)性。

2)低帶寬成本:終端產(chǎn)生的數(shù)據(jù)無需遠(yuǎn)距離傳輸至云端,避免帶寬成本。同時(shí),邊緣計(jì)算機(jī)制中,邊緣層可對(duì)終端產(chǎn)生數(shù)據(jù)進(jìn)行預(yù)處理,從而降低云計(jì)算中心的計(jì)算負(fù)載。

3)安全性:邊緣計(jì)算在本地設(shè)備和邊緣層設(shè)備中處理大部分?jǐn)?shù)據(jù)而不是將其上傳至云端,減少實(shí)際存在風(fēng)險(xiǎn)的數(shù)據(jù)量,避免數(shù)據(jù)泄露危險(xiǎn)。

4、AI服務(wù)器:更適合深度學(xué)習(xí)等AI訓(xùn)練場(chǎng)景

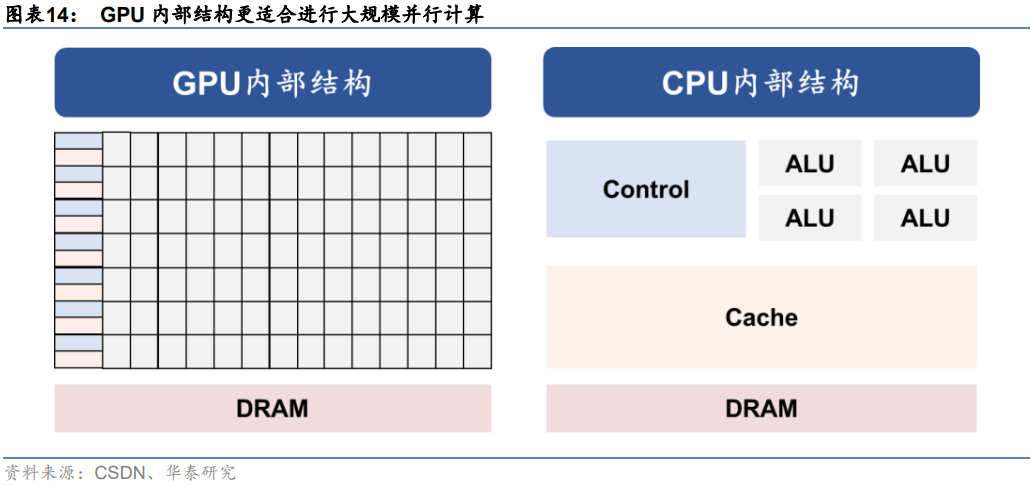

AI服務(wù)器采取GPU架構(gòu),相較CPU更適合進(jìn)行大規(guī)模并行計(jì)算。通用服務(wù)器采用CPU作為計(jì)算能力來源,而AI服務(wù)器為異構(gòu)服務(wù)器,可以根據(jù)應(yīng)用范圍采用不同的組合方式,如CPUGPU、CPUTPU、CPU其他加速卡等,主要以GPU提供計(jì)算能力。從ChatGPT模型計(jì)算方式來看,主要特征是采用了并行計(jì)算。對(duì)比上一代深度學(xué)習(xí)模型RNN來看,Transformer架構(gòu)下,AI模型可以為輸入序列中的任何字符提供上下文,因此可以一次處理所有輸入,而不是一次只處理一個(gè)詞,從而使得更大規(guī)模的參數(shù)計(jì)算成為可能。而從GPU的計(jì)算方式來看,由于GPU采用了數(shù)量眾多的計(jì)算單元和超長(zhǎng)的流水線,因此其架構(gòu)設(shè)計(jì)較CPU而言,更適合進(jìn)行大吞吐量的AI并行計(jì)算。

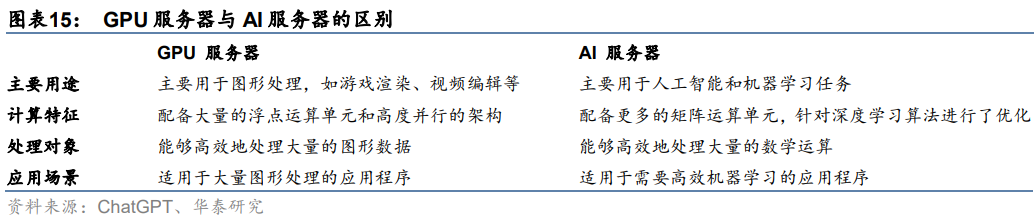

深度學(xué)習(xí)主要進(jìn)行矩陣向量計(jì)算,AI服務(wù)器處理效率更高。從ChatGPT模型結(jié)構(gòu)來看,基于Transformer架構(gòu),ChatGPT模型采用注意力機(jī)制進(jìn)行文本單詞權(quán)重賦值,并向前饋神經(jīng)網(wǎng)絡(luò)輸出數(shù)值結(jié)果,這一過程需要進(jìn)行大量向量及張量運(yùn)算。而AI服務(wù)器中往往集成多個(gè)AI GPU,AI GPU通常支持多重矩陣運(yùn)算,例如卷積、池化和激活函數(shù),以加速深度學(xué)習(xí)算法的運(yùn)算。因此在人工智能場(chǎng)景下,AI服務(wù)器往往較GPU服務(wù)器計(jì)算效率更高,具備一定應(yīng)用優(yōu)勢(shì)。

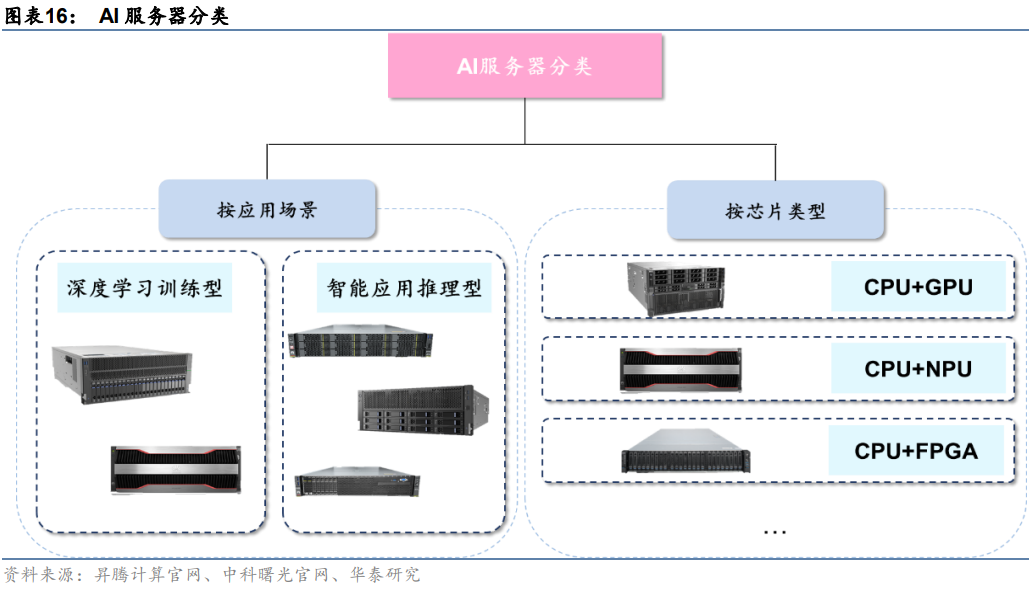

AI服務(wù)器分類方式有兩種:

1)按應(yīng)用場(chǎng)景:AI服務(wù)器按照應(yīng)用場(chǎng)景可以分為深度學(xué)習(xí)訓(xùn)練型和智能應(yīng)用推理型。訓(xùn)練任務(wù)對(duì)服務(wù)器算力要求較高,需要訓(xùn)練型服務(wù)器提供高密度算力支持,典型產(chǎn)品有中科曙光X785-G30和華為昇騰Atlas 800(型號(hào)9000、型號(hào)9010)。推理任務(wù)則是利用訓(xùn)練后的模型提供服務(wù),對(duì)算力無較高要求,典型產(chǎn)品有中科曙光X785-G40和華為昇騰Atlas 800(型號(hào)3000、型號(hào)3010)。

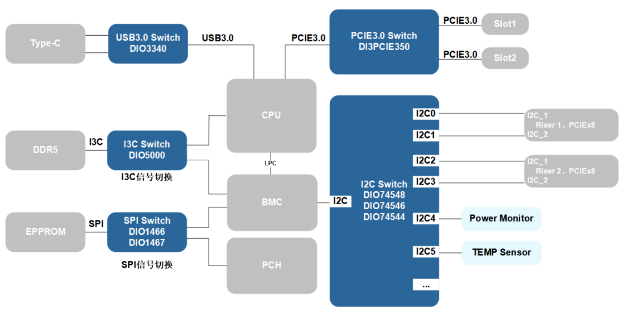

2)按芯片類型:AI服務(wù)器為異構(gòu)服務(wù)器,可以根據(jù)應(yīng)用范圍調(diào)整計(jì)算模塊結(jié)構(gòu),可采用CPU+GPU、CPU+FPGA、CPU+TPU、CPU+ASIC或CPU+多種加速卡等組合形式。目前,產(chǎn)品中最常見的是CPU+多塊GPU的方式。

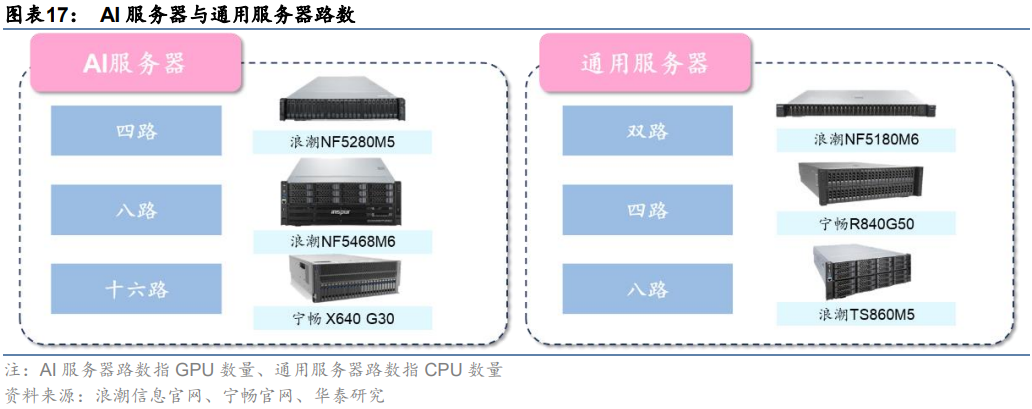

常見的AI服務(wù)器分為四路、八路、十六路。一般來說,通用服務(wù)器主要采用以CPU為主導(dǎo)的串行架構(gòu),更擅長(zhǎng)邏輯運(yùn)算;而AI服務(wù)器主要采用加速卡為主導(dǎo)的異構(gòu)形式,更擅長(zhǎng)做大吞吐量的并行計(jì)算。按CPU數(shù)量,通用服務(wù)器可分為雙路、四路和八路等。雖然AI服務(wù)器一般僅搭載1-2塊CPU,但GPU數(shù)量顯著占優(yōu)。按GPU數(shù)量,AI服務(wù)器可以分為四路、八路和十六路服務(wù)器,其中搭載8塊GPU的八路AI服務(wù)器最常見。

AI服務(wù)器采用多芯片組合,算力硬件成本更高。我們以典型服務(wù)器產(chǎn)品為例拆解硬件構(gòu)成,可以更清晰地理解兩類服務(wù)器硬件架構(gòu)區(qū)別:以浪潮通用服務(wù)器NF5280M6為例,該服務(wù)器采用1~2顆第三代Intel Xeon可擴(kuò)展處理器,據(jù)英特爾官網(wǎng),每顆CPU售價(jià)約64000萬元,故該服務(wù)器芯片成本約64000~128000;以浪潮AI服務(wù)器NF5688M6為例,該服務(wù)器采用2顆第三代Intel Xeon可擴(kuò)展處理器+8顆英偉達(dá)A800 GPU的組合,據(jù)英偉達(dá)官網(wǎng),每顆A800售價(jià)104000元,故該服務(wù)器芯片成本約96萬元。

5、ChatGPT需要的芯片:CPU+GPU、FPGA、ASIC

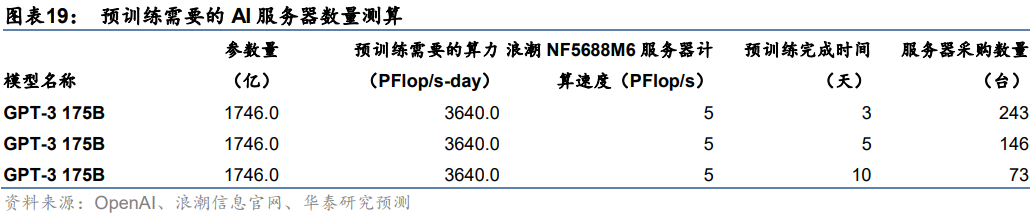

GPT模型訓(xùn)練需要大算力支持,或?qū)鞟I服務(wù)器建設(shè)需求。我們認(rèn)為,隨著國(guó)內(nèi)廠商陸續(xù)布局ChatGPT類似產(chǎn)品,GPT大模型預(yù)訓(xùn)練、調(diào)優(yōu)及日常運(yùn)營(yíng)或?qū)泶罅克懔π枨螅M(jìn)而帶動(dòng)國(guó)內(nèi)AI服務(wù)器市場(chǎng)放量。以GPT-3 175B模型預(yù)訓(xùn)練過程為例,據(jù)OpenAI,進(jìn)行一次GPT-3 175B模型的預(yù)訓(xùn)練需要的算力約3640 PFlop/s-day。我們假設(shè)以浪潮信息目前算力最強(qiáng)的AI服務(wù)器NF5688M6(PFlop/s)進(jìn)行計(jì)算,在預(yù)訓(xùn)練期限分別為3、5、10天的假設(shè)下,單一廠商需采購的AI服務(wù)器數(shù)量分別為243、146、73臺(tái)。

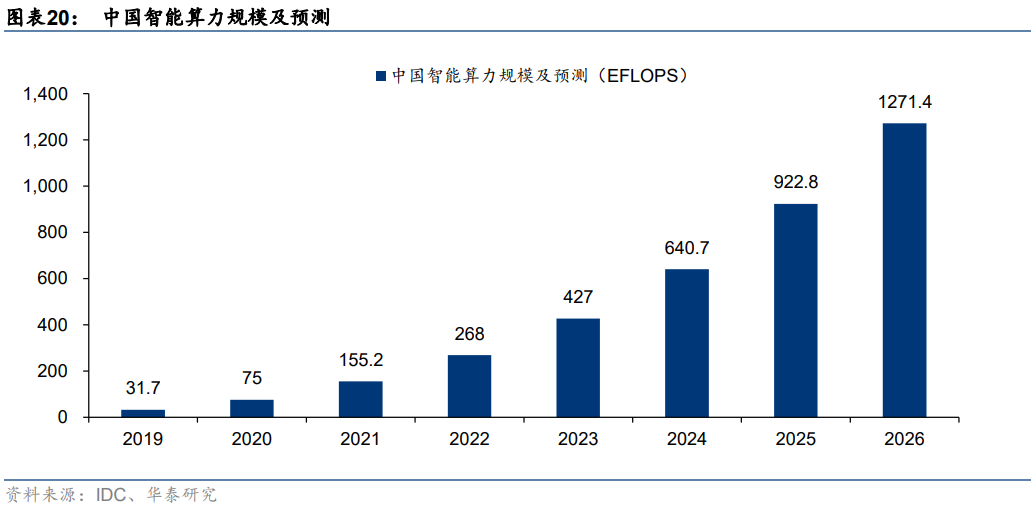

AI大模型訓(xùn)練需求火熱,智能算力規(guī)模增長(zhǎng)有望帶動(dòng)AI服務(wù)器放量。據(jù)IDC數(shù)據(jù),以半精度(FP16)運(yùn)算能力換算,2021年中國(guó)智能算力規(guī)模約155.2EFLOPS。隨著AI模型日益復(fù)雜、計(jì)算數(shù)據(jù)量快速增長(zhǎng)、人工智能應(yīng)用場(chǎng)景不斷深化,未來國(guó)內(nèi)智能算力規(guī)模有望實(shí)現(xiàn)快速增長(zhǎng)。IDC預(yù)計(jì)2022年國(guó)內(nèi)智能算力規(guī)模將同比增長(zhǎng)72.7%至268.0 EFLOPS,預(yù)計(jì)2026年智能算力規(guī)模將達(dá)1271.4 EFLOPS,2022-2026年算力規(guī)模CAGR將達(dá)69.2%。我們認(rèn)為,AI服務(wù)器作為承載智能算力運(yùn)算的主要基礎(chǔ)設(shè)施,有望受益于下游需求放量。

編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論