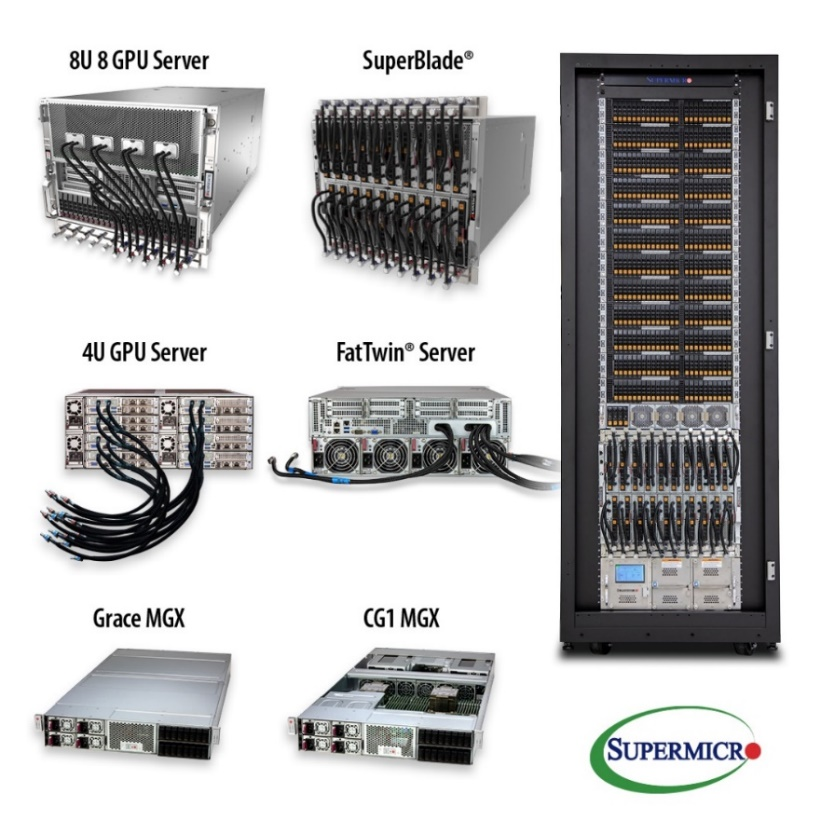

從云端到邊緣完善的系統組合,支持NVIDIA HGX H100系統、L40和L4 GPU及OVX 3.0系統

【2023 年 3 月 21 日美國加州圣何塞訊】Super Micro Computer, Inc. (NASDAQ:SMCI) 為AI/ML、云端、存儲和5G/智能邊緣應用的全方位IT解決方案供應商,宣布其配備最新NVIDIA HGX H100 8-GPU系統的頂級全新GPU服務器開始出貨。該服務器整合了最新的NVIDIA L4 Tensor Core GPU至從邊緣到數據中心的各種應用優化服務器中。

Supermicro總裁暨首席執行官梁見后(Charles Liang)表示:“Supermicro提供業界最全面的 GPU系統產品組合,包含 8U、6U、5U、4U、2U 和 1U 外形尺寸的服務器,并支持全系列新NVIDIA H100 GPU的工作站和SuperBlade系統。 通過這款NVIDIA HGX H100 Delta-Next 服務器,客戶將獲得相較上一代 AI 訓練應用9倍的性能提升。 我們的GPU服務器采用創新的氣流設計,能全面降低風扇轉速、噪音和功耗,進而降低總擁有成本(TCO)。 此外,對于正在尋找符合未來需求的數據中心的客戶,我們也為其提供完整的機柜級(rack-scale)液冷選項。 ”

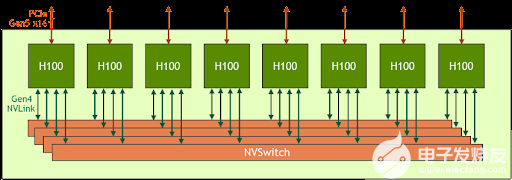

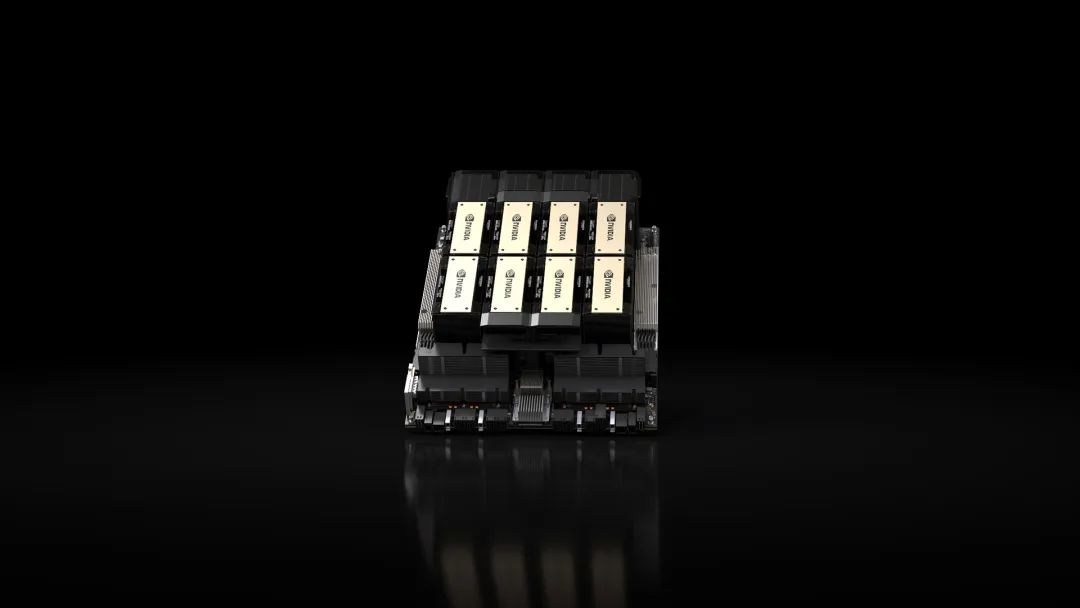

Supermicro的高性能新型8U GPU服務器現已大量出貨。 這款全新 Supermicro 8U 服務器特別針對AI、DL、ML和HPC工作負載進行了優化,搭載能達到高GPU-to-GPU通信的NVIDIA HGX H100 8-GPU,使用高速NVIDIA NVLink? 4.0技術、NVSwitch 互連,以及 NVIDIA Quantum-2 InfiniBand 和 Spectrum-4 以太網,從而大幅突破 AI 的障礙。 此外,Supermicro還提供多種性能優化的GPU服務器配置,包括直連/單根(single-root)/ 雙根(dual-root) CPU-to-GPU,另外還有前置或后置 I/O 機型,在標準和OCP DC機柜 配置中使用AC與DC 電源。 Supermicro X13 SuperBlade? 機殼可在一個 8U 機殼內放入 20 個 NVIDIA H100 Tensor Core PCIe GPU 或 40 個 NVIDIA L40 GPU,6U機殼則最多可使用10個NVIDIA H100 PCIe GPU或20個NVIDIA L4 TensorCore GPU。 這些新系統為運行NVIDIA AI 平臺軟件層 NVIDIA AI Enterprise提供理想的優化加速功能。

此類服務器內置的液冷系統也適用于其他眾多GPU 服務器。 此外,Supermicro 發布了一款液冷式 AI 開發系統 (塔式或機架式配置皆可),內含兩個 CPU 和四個NVIDIA A100 Tensor Core GPU,適合辦公室和家庭辦公環境,并能部署在部門和企業集群中。

Supermicro系統支持新的 NVIDIA L4 GPU,與前幾代產品相比,加速和能效均提升數倍。 此系統同樣適用于企業、云和邊緣的 AI 推理、視頻流、虛擬工作站和圖形應用程序。 L4 采用NVIDIA的AI平臺和全堆疊方法,經過優化調整,適合進行各種 AI 應用程序的大規模推理,包括推薦、語音型 AI 虛擬人物助理、聊天機器人、視覺搜索和客服中心自動化等,能提供出色的個性化體驗。 L4是適用于主流服務器的高效NVIDIA加速器,擁有高達4倍的AI性能、更高的能源使用效率,還有3倍以上的視頻流容量與效率,因此能支持 AV1 編碼/解碼。 L4 GPU擁有多樣化的推理和可視化功能,加上輕巧、節能、單插槽、薄型、72W的低功耗規格,是包括邊緣位置在內全局部署的理想選擇。

NVIDIA 加速計算產品主管Dave Salvator 表示:“Supermicro 服務器配備新的 NVIDIA L4 Tensor Core GPU,擁有無與倫比的強大性能,讓客戶能高效且可持續地加快工作負載速度。 NVIDIA L4經過優化,適合用于主流部署,加上外型輕薄,可在72W的低功耗范圍內作業,將邊緣AI性能和效率提升至全新境界。”

Supermicro最新的PCIe加速解決方案支持打造3D世界、數字孿生、3D模擬模型和工業元宇宙。 除了支持前幾代NVIDIA OVX?系統,Supermicro也提供OVX 3.0 配置,配備四個NVIDIA L40 GPU、兩個NVIDIA ConnectX-7? SmartNIC、一個NVIDIA BlueField-3? DPU及新的NVIDIA Omniverse Enterprise?軟件。

?

深入了解所有 Supermicro 先進的新GPU系統,請訪問:https://www.supermicro.com/en/accelerators/nvidia

歡迎至2023 NVIDIA GTC深入了解Supermicro:- https://register.nvidia.com/events/widget/nvidia/gtcspring2023/sponsorcatalog/exhibitor/1564778120132001ghs2/?ncid=ref-spo-128510

?

?

Supermicro推出配備NVIDIA HGX及PCIe型H100 8-GPU尖端服務器系統,適用于AI 訓練、深度學習、HPC和生成式AI,加速AI和

- AI(263628)

- Supermicro(9217)

- H100(187)

- 生成式AI(160)

相關推薦

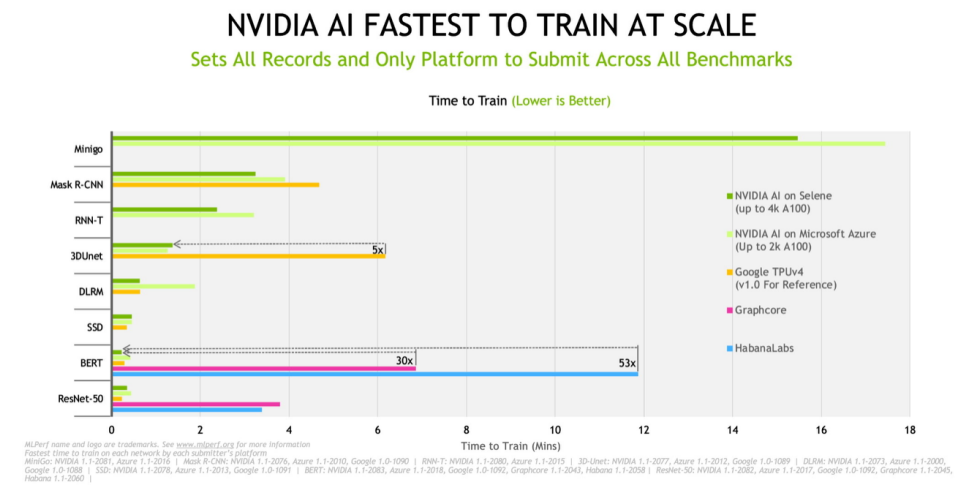

云服務、OEM 借助 NVIDIA AI讓AI訓練更上層樓

借助 NVIDIA AI,戴爾、浪潮、Microsoft Azure 和 Supermicro 在今天發布的新 MLPerf 基準測試中創下快速訓練 AI 模型的記錄。

2021-12-03 10:19:52 1469

1469

1469

1469

深度學習模型部署與優化:策略與實踐;L40S與A100、H100的對比分析

隨著生成式AI應用的迅猛發展,我們正處在前所未有的大爆發時代。在這個時代,深度學習模型的部署成為一個亟待解決的問題。盡管GPU在訓練和推理中扮演著關鍵角色,但關于它在生成式AI領域的誤解仍然存在。近期英偉達L40S GPU架構成為了熱門話題,那么與A100和H100相比,L40S有哪些優勢呢?

2023-10-07 09:43:18 1112

1112

1112

1112

基于NVIDIA GPU的加速服務 為AI、機器學習和AI工作負載提速

2019年8月26日 ——NVIDIA和VMware今日宣布將為VMware Cloud on AWS推出基于NVIDIA GPU的加速服務,為AI、機器學習和數據分析工作流程等現代化企業應用提供支持。

2019-08-30 09:36:37 1170

1170

1170

1170華碩推出最新一代支持11路PCIe 4.0的2U單插槽GPU服務器

華碩這個服務器適用于數據中心,適合執行AI、數據分析及HPC運算,因為它同時支持AMD及NVIDIA最新產品,包括EYPC 7002系列CPU及NVIDIA A100加速卡,這兩款都是最新的7nm工藝芯片。

2020-09-15 16:23:44 3359

3359

3359

3359ChatGPT熱潮引發AI服務器爆單

、FPGA、ASIC等加速芯片,利用CPU與加速芯片的組合可以滿足高吞吐量互聯的需求,為自然語言處理、計算機視覺、機器學習等AI應用場景提供強大的算力支持,支撐AI算法訓練和推理。 ? AI 服務器與普通服務器的區別 ? 服務器是一種高性能計算機,作為網絡的節點,存儲、處理網絡

2023-02-22 01:13:00 1737

1737

1737

1737AI-ESTATE標準(適用于所有測試環境的人工智能信息交換與服務)與ATML(自動測試標注語言)

AI-ESTATE標準(適用于所有測試環境的人工智能信息交換與服務)與ATML(自動測試標注語言)隨著被測對象的日益復雜,以數據處理為基礎的傳統測試診斷制方法已經無法適應復雜設備的維護需要,應用以

2016-04-16 14:51:52

AI開發者福音!阿里云推出國內首個基于英偉達NGC的GPU優化容器

云計算服務異構加速平臺,為人工智能產業提供多場景化的全球加速能力。2017年11月,阿里云發布了國內首個支持 NVIDIA ?Tesla ?V100 GPU 的實例GN6,可帶來數倍的深度學習性能提升

2018-04-04 14:39:24

AI是什么呢?AI應用又會給人們帶來哪些改變

Intelligence的縮寫,即人工智能。它是研究、開發用于模擬、延伸和擴展人的智能的理論、方法、技術及應用系統的一門新的技術科學。AI的研究工作已取得驚人進展,經過學習后,機器在操作某些環節時比人類更快、更精

2021-12-20 06:42:13

AI芯片界的領頭羊進軍機器人行業

戰略合作,共同設計開發新型超級計算機系統和服務器。英偉達開發的圖形處理單元芯片(GPU),很好適用于浮點計算,表現勝于英特爾的傳統CPU Xeon和AMD的Opteron。排名第二位的“泰坦”也搭載了

2018-06-11 08:20:23

AI視覺檢測在工業領域的應用

的產品圖像。

2.圖像處理:系統將采集到的圖像數據進行預處理、過濾、降噪等操作,以便更好地提取特征信息。

3.特征提取:系統采用深度學習等技術,對圖像數據進行深度學習訓練,提取出產品的特征向量。

4.特征

2023-06-15 16:21:56

AI運算核心,FPGA領域前程遠大

發展的芯片。云端運算已在深度學習訓練的效能表現相當顯著,然而若要運用到終端產品上,除了功耗與芯片體積的限制,加上云端運算有數據存取、實時性與安全性的考慮,預期將會催生AI芯片向終端的「 邊緣運算」邁進

2017-12-05 08:09:38

NVIDIA Jetson的相關資料分享

。Jetson是以機器學習應用為目的而設計的,具有GPU的并行處理用的嵌入式計算板,用于高速執行圖像識別、機器學習和自動駕駛等。爆炸式增長的AI模型的復雜性近年來,由于傳感器技術的革新,IoT設備比以往發揮

2021-11-09 08:26:45

NVIDIA 在首個AI推理基準測試中大放異彩

分為四個場景:與數據中心應用關聯性最高的服務器和離線場景,以及用于滿足邊緣設備地芯片系統需求的單流和多流場景。 NVIDIA在兩個數據中心場景(離線和服務器)的全部五項基準測試中均排在第一位

2019-11-08 19:44:51

深度學習推理和計算-通用AI核心

商業發行之前就已經過時了。算法明天需要對架構、內存/數據進行徹底改革資源和能力。推理的夢幻建筑重新定義重寫在計算和交付突破性的人工智能加速和靈活的計算能力超越了服務器級CPU和比GPU/ASIC通用

2020-11-01 09:28:57

Arm Neoverse NVIDIA Grace CPU 超級芯片:為人工智能的未來設定步伐

和數據吞吐量進行優化的服務器和數據中心人工智能和機器學習 (ML) 的需求。否則,人工智能所需的成本、電力和碳將開始超過收益。NVIDIA 率先使用 GPU 來提高數據中心中 HPC 和 AI 的性能

2022-03-29 14:40:21

EdgeBoard FZ5 邊緣AI計算盒及計算卡

,實現模型的訓練、部署、推理等一站式服務,降低AI開發門檻。5 卓越品質與可靠性設計,直面工業場景高效開發寬溫設計,適應-40度到+70度環境溫度;整體式無風扇被動散熱,適應工業場景的惡劣環境;此外

2020-08-31 14:12:48

FPGA在深度學習應用中或將取代GPU

、筆記本電腦或機架式服務器上訓練神經網絡時,這不是什么大問題。但是,許多部署深度學習模型的環境對 GPU 并不友好,比如自動駕駛汽車、工廠、機器人和許多智慧城市環境,在這些環境中硬件必須忍受熱、灰塵、濕度

2024-03-21 15:19:45

ST MCU邊緣AI開發者云 - STM32Cube.AI

STM32微控制器生成優化的C代碼,無需事先安裝軟件。數據科學家和開發人員受益于STM32Cube.AI久經考驗的神經網絡優化性能,以開發邊緣AI項目。? 訪問STM32模型庫,這是一個可訓練的深度學習

2023-02-02 09:52:43

STM32Cube.AI工具包使用初探

STM32近日推出了Cube.AI人工智能神經網絡開發工具包,目標是將AI引入微控制器供電的智能設備,位于節點邊緣,以及物聯網,智能建筑,工業和醫療應用中的深度嵌入式設備。 簡而言之,以后就可以在

2022-02-22 06:50:34

TB-96AI是什么?TB-96AI核心板有哪些核心功能

LPDDR3+16GB eMMC(可選6GB LPDDR3+16GB eMMC或8GB LPDDR3+16GB eMMC),內置千兆以太網PHY芯片。TB-96AI設計為通過4個100Pin的松下高速板對板連接器

2022-06-20 16:28:28

Xeon處理器和FPGA卡窺見其AI策略

學習中的推理任務,而英特爾的目標則是利用結合Altera Arria FPGA的新型PCIe卡;Facebook利用Nvidia的芯片設計了自己的GPU服務器,以支持訓練神經網絡的運算密集任務。 至于

2016-12-23 16:50:37

[轉]AI芯片已然存在,與既往的嵌入式處理器不可混淆!

使用最多的是GPU,因為它適用于單指令、多數據處理,可用于深度學習的訓練和推理。英偉達AI技術中心亞太首席技術官Simon See接受第一財經采訪時表示,英偉達要做通用性的芯片,“通用是我們的優勢

2018-06-14 11:44:13

【CC3200AI實驗教程11】瘋殼·AI語音人臉識別-AI語音系統架構

傳送到CC3200,CC3200通過wifi把采集到的語音信號發送給服務器,服務器再使用百度AI語音識別的API把語音信號傳送到百度AI的服務器上;當語音識別成功后,百度AI返回識別后的字符串給到服務器

2022-08-30 14:54:38

【CC3200AI實驗教程14】瘋殼·AI語音人臉識別-AI人臉系統架構

CC3200AI實驗教程——瘋殼·開發板系列AI人臉系統架構AI人臉識別系統由7大塊組成,分別是攝像頭、CC3200、串口調試助手、路由器、公網、服務器、數據庫以及百度AI組成。AI人臉識別系統

2022-08-31 16:35:59

【產品活動】阿里云GPU云服務器年付5折!阿里云異構計算助推行業發展!

用于搭建深度學習訓練加速平臺的云端利器。GN5采用了NVIDIA Pascal架構P100 GPU,可在云端按需構建敏捷彈性、高性能和高性價比的深度學習平臺,讓用戶以最簡便地方式享用阿里云遍布全球的高效

2017-12-26 11:22:09

【免費直播】AI芯片專家陳小柏博士,帶你解析AI算法及其芯片操作系統。

仿真的優勢?3、國產AI芯片如何突圍,和傳統SOC設計上設計差別?4、為什么選擇ZYNQ做AI 深度學習?目錄(主要大綱):1、AI應用場景介紹(人臉識別,物體識別/分類)2、AI算法設計、訓練

2019-11-07 14:03:20

【免費直播】讓AI芯片擁有最強大腦—AI芯片的操作系統設計介紹.

、深度學習推斷處理器(DPU)運行時設計介紹3、如何加速優化,提高系統并行執行效率1、AI芯片中的操作系統管理原則2、操作系統運行時設計準則3、多核多線程加速計算效率方法主講老師:陳小柏,男,中山大學

2019-11-07 14:18:45

【米爾FZ3深度學習計算卡試用體驗】搭建Vitis Ai系統平臺并測試

1 Vitis AiVitis? AI 開發環境是 Xilinx 的開發平臺,適用于在 Xilinx 硬件平臺(包括邊緣器件和 Alveo 卡)上進行人工智能推斷。它由優化的 IP、工具、庫、模型

2020-12-03 19:22:13

人工智能AI-卷積神經網絡LabVIEW之Yolov3+tensorflow深度學習有用嗎?

python編程語言的前提下,使用labview訓練和部署深度學習模型,并配備相關案例視頻以及源碼。適用人群:1、適用于工業自動化行業從業者利用labview或者C#進行深度學習應用;2、適用于plc

2020-11-27 11:19:37

利用設計網關的 IP 內核在 Xilinx VCK190 評估套件上加速人工智能應用

XCVC1902 量產芯片AI 和 DSP 引擎的計算性能比當今的服務器級 CPU 高 100 倍用于快速原型設計的預構建合作伙伴參考設計用于前沿應用開發的最新連接技術內置 PCIe 第 4 代硬 IP,用于高性能

2022-11-25 16:29:20

可以在同一臺服務器上混合使用不同的NVIDIA GPU

擁有相同的(Dell R740xd)服務器是否可能(或甚至有意義):1. P40- 用于VMWare Horizo??n VDI圖形2. V100- 用于深度學習/ HPC開發或者是否需要/建議在

2018-10-10 16:11:04

在X-CUBE-AI.7.1.0中導入由在線AI平臺生成的.h5模型報錯怎么解決?

你好, 我試圖在 X-CUBE-AI.7.1.0 中導入由在線 AI 平臺生成的 .h5 模型,收到錯誤:E010(InvalidModelError): Model saved with Keras 2.7.0 but

2022-12-27 06:10:35

基于Python的GUI界面設計的AI學習

Python之GUI:基于Python的GUI界面設計的一套AI課程學習(機器學習、深度學習、大數據、云計算等)推薦系統(包括語音生成、識別等前沿黑科技)

2018-12-28 10:08:31

如何加速電信領域AI開發?

在即將開展的“中國移動全球合作伙伴大會”上,華為將發布一款面向運營商電信領域的一站式AI開發平臺——SoftCOM AI平臺,幫助電信領域開發者解決AI開發在數據準備、模型訓練、模型發布以及部署驗證

2021-02-25 06:53:41

嵌入式AI的相關資料下載

,小網絡是一個學生讓小網絡逐漸學習到大網絡的能力三、邊緣側的訓練方法傳統的機器學習訓練方法是把數據在服務器上訓練好,然后使用聯邦學習是用戶不把數據上傳,而是把模型下發到對應的用戶那里用戶訓練以后用戶會把訓練好的模型上傳到服務器,服務器再把訓練的模型進行合成,

2021-12-14 06:57:15

嵌入式邊緣AI應用開發指南

、PyTorch和MXNet框架中常用的開源深度學習模型。這些模型在公共數據集上經過預訓練和優化,可以在TI適用于邊緣AI的處理器上高效運行。TI會定期使用開源社區中的新模型以及TI設計的模型對Model Zoo

2022-11-03 06:53:28

當AI遇上FPGA會產生怎樣的反應

、LSTM以及強化學習網絡等算法在內的應用加速平臺和完整的生態系統。深度學習包含兩個計算環節,即線下訓練和線上推理環節。GPU在深度學習算法模型訓練上非常高效,但在推理時,一次性只能對于一個輸入項進行

2021-09-17 17:08:32

微型微控制器與強大的人工智能(AI)世界有什么關系

嵌入式應用可能的極限,嵌入式設計已經能夠提高網絡攻擊的實時響應能力和設備安全性。支持AI的MCU云計算推動了對具有AI功能的MCU的需求;它減少了數據傳輸所需的帶寬,并節省了云服務器的處理能力,如下圖。配備AI算法的MCU正在應用包含對象識別,啟用語音服務和自然語言處理等功能的應用程序..

2021-11-01 08:55:02

新思科技發布業界首款全棧式AI驅動型EDA解決方案Synopsys.ai

技(Synopsys, Inc.,納斯達克股票代碼:SNPS)隆重推出了業界首款全棧式AI驅動型EDA解決方案Synopsys.ai,覆蓋了先進數字與模擬芯片的設計、驗證、測試和制造環節。基于此,開發者第一次

2023-04-03 16:03:26

智能網卡簡介及其在高性能計算中的作用

最高性能。SmartNIC 通過提供高級網絡功能以及專門的硬件加速,在 HPC 應用中表現出色。提高人工智能系統的效率當前的機器學習趨勢涉及分布式學習,它通常采用并行數據訓練,其中每個節點在不同的數據

2023-07-28 10:10:17

硬件幫助將AI移動到邊緣

工廠中,機器學習技術可能適用于工業過程控制中的復雜傳感器融合,或工業機器中的異常檢測和預測性維護方案。AspenCore Media深入研究了人工智能在邊緣的應用,超越了收集大部分媒體的語音和視覺系統

2019-05-29 10:38:09

請問FP_AI_VISION1工程是否可以適用于stm32f746 discovery開發板?

FP_AI_VISION1工程是否可以適用于stm32f746discovery開發板?使用STM32CUBEIDE打開FP_AI_VISION1工程為什么沒有stm32可運行文件,不能編譯?

2023-08-07 08:37:02

通用型AI語音識別芯片音旋風611如何?

近日,國產原生芯片品牌探境科技宣布全球首款通用型AI語音識別芯片——音旋風611(英文名稱:Voitist611)目前正式進入批量供貨量產并已獲得大量客戶的認可和采用。這款芯片將適用于各種需要語音

2019-09-11 11:52:12

閑談客服中心AI應用及挑戰

的新鮮事物。上個世紀90年代出現的洗衣機模糊邏輯控制系統其實就是某種形式的AI。語音識別和語義識別本身也是AI的一部分。在數據分析與挖掘領域,我們利用很多傳統的機器學習算法,比如決策樹、邏輯引擎等,進行預測

2018-04-10 10:48:40

阿里云CPFS在人工智能/深度學習領域的實踐

眾多的計算核心可以大量并行的運行更多的AI訓練/推理線程,使得AI訓練/推理在更短的時間內完成更多的計算任務。簡單的說,GPU讓AI更快,更準。這種變化使得服務器的形態發生了很大的變化,用于AI/DL

2018-08-23 17:39:35

英偉達 GPU 算力 服務器 電信運營商 數據中心 云服務 顯卡 IDC NVIDIA NVLINK

;VFG-SYS-821GE-TNHR 1 Base Configuration 8UX13HGX H100 8GPU(Rear I/O),X13DEG-OAD*12 CPU P4X-S

2024-01-02 09:35:32

英偉達HGX-2 GPU加速平臺構建更強大的AI服務

百度、騰訊借助 HGX-2 構建更強大的AI服務;浪潮、聯想、華為和曙光推出基于全新 HGX-2 的服務器。

2018-11-23 09:23:24 3411

3411

3411

3411NVIDIA發布了首款基于NVIDIA Ampere架構的GPU ——NVIDIA A100 GPU

了全球超強大的AI和HPC服務器平臺HGX A100,最大可組成AI算力達10 PFLOPS的超大型服務器。

2020-06-02 17:11:45 3709

3709

3709

3709NVIDIA GPU加速AI推理洞察,推動跨行業創新

這些AI模型被運行在裝載了V100Tensor Core GPU的NVIDIADGX系統上的數據中心服務器上,以及裝載了JetsonAGX Xavier模塊的邊緣計算網絡中。該硬件運行NVIDIA

2020-07-02 15:00:54 1819

1819

1819

1819NVIDIA公布通過NVIDIA認證系統測試的全球首批加速服務器 企業 AI 使用量倍增

芯東西1月27日報道,剛剛,NVIDIA公布通過NVIDIA認證系統測試的全球首批加速服務器,它們是目前業內唯一通過現代工作負載測試的服務器,可用于機器學習和分析。 通過NVIDIA認證系統的產品

2021-01-27 16:25:59 1716

1716

1716

1716VIDIA宣布在AI超級計算平臺中加入融合了AI與高性能計算的新技術

NVIDIA A100 80G PCIe、NVIDIA NDR 400G InfiniBand和NVIDIA Magnum IO三箭齊發!超強HGX助力廣大HPC系統和云服務 NVIDIA宣布

2021-06-29 09:50:06 2027

2027

2027

2027NVIDIA為需要加速計算的企業客戶運行測試服務器

借助 NVIDIA AI,戴爾、浪潮、Microsoft Azure 和 Supermicro 在今天發布的新 MLPerf 基準測試中創下快速訓練 AI 模型的記錄

2021-12-15 15:35:44 1269

1269

1269

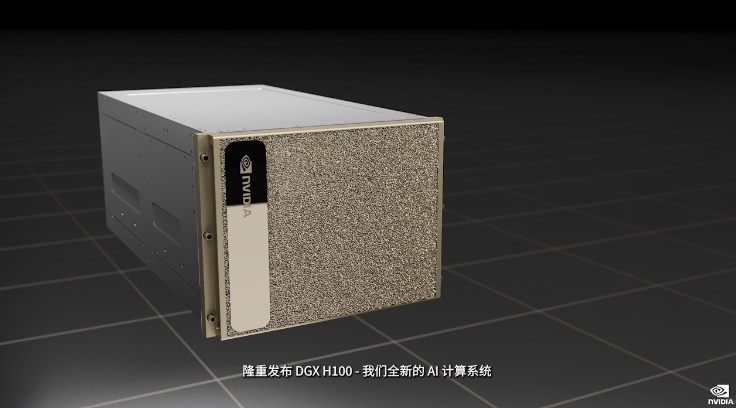

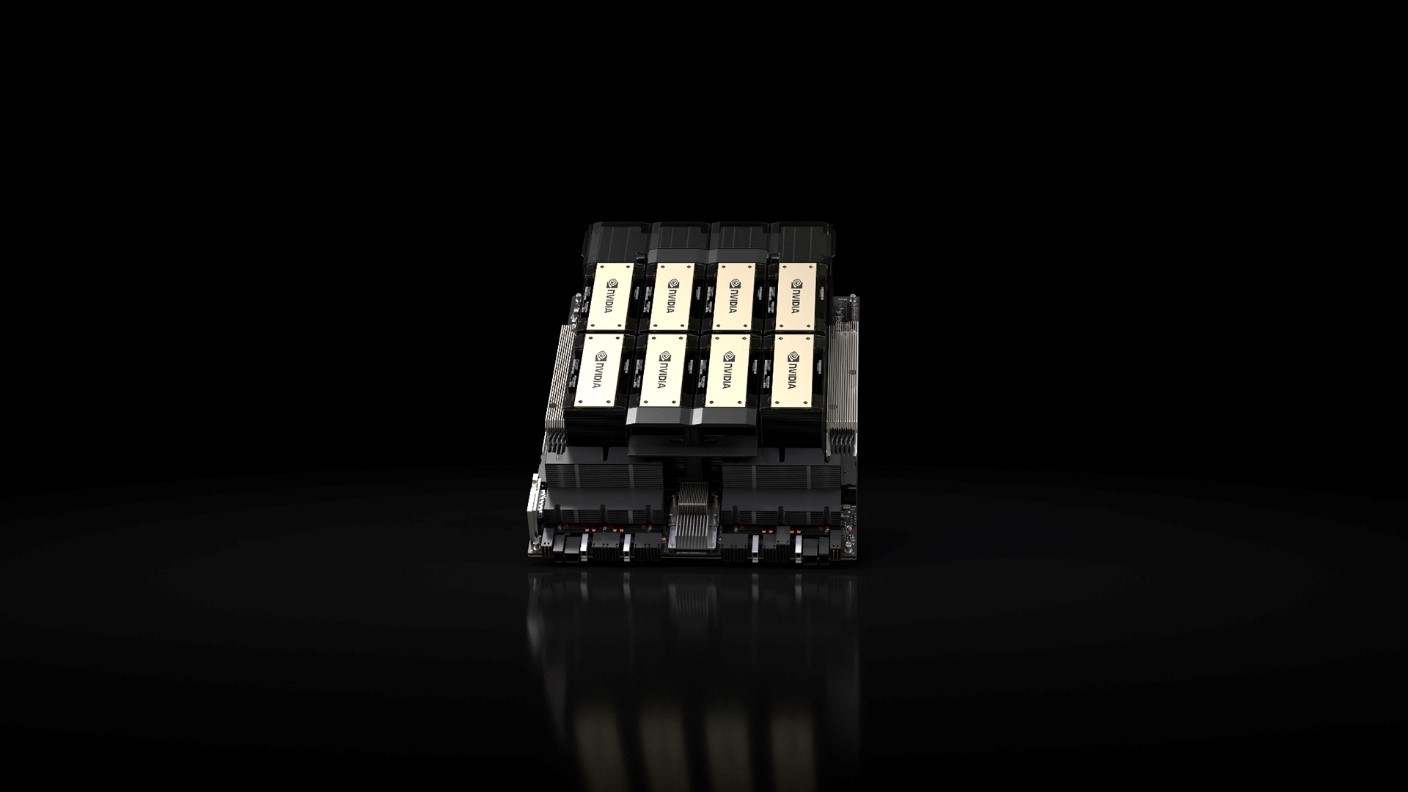

1269GTC2022大會亮點:NVIDIA發布全新AI計算系統—DGX H100

GTC2022大會亮點:NVIDIA發布全新AI計算系統—DGX H100,借助NVLink連接,DGX使八塊H100成為了一個巨型GPU。

2022-03-24 15:06:31 1574

1574

1574

1574

NVIDIA發布DGX H100系統 羅德與施瓦茨提供O-RAN無線電單元方案

NVIDIA 近日宣布推出第四代 NVIDIA? DGX? 系統,這是世界上第一個使用全新NVIDIA H100 Tensor Core GPU 構建的 AI 平臺。

2022-03-25 11:44:23 4525

4525

4525

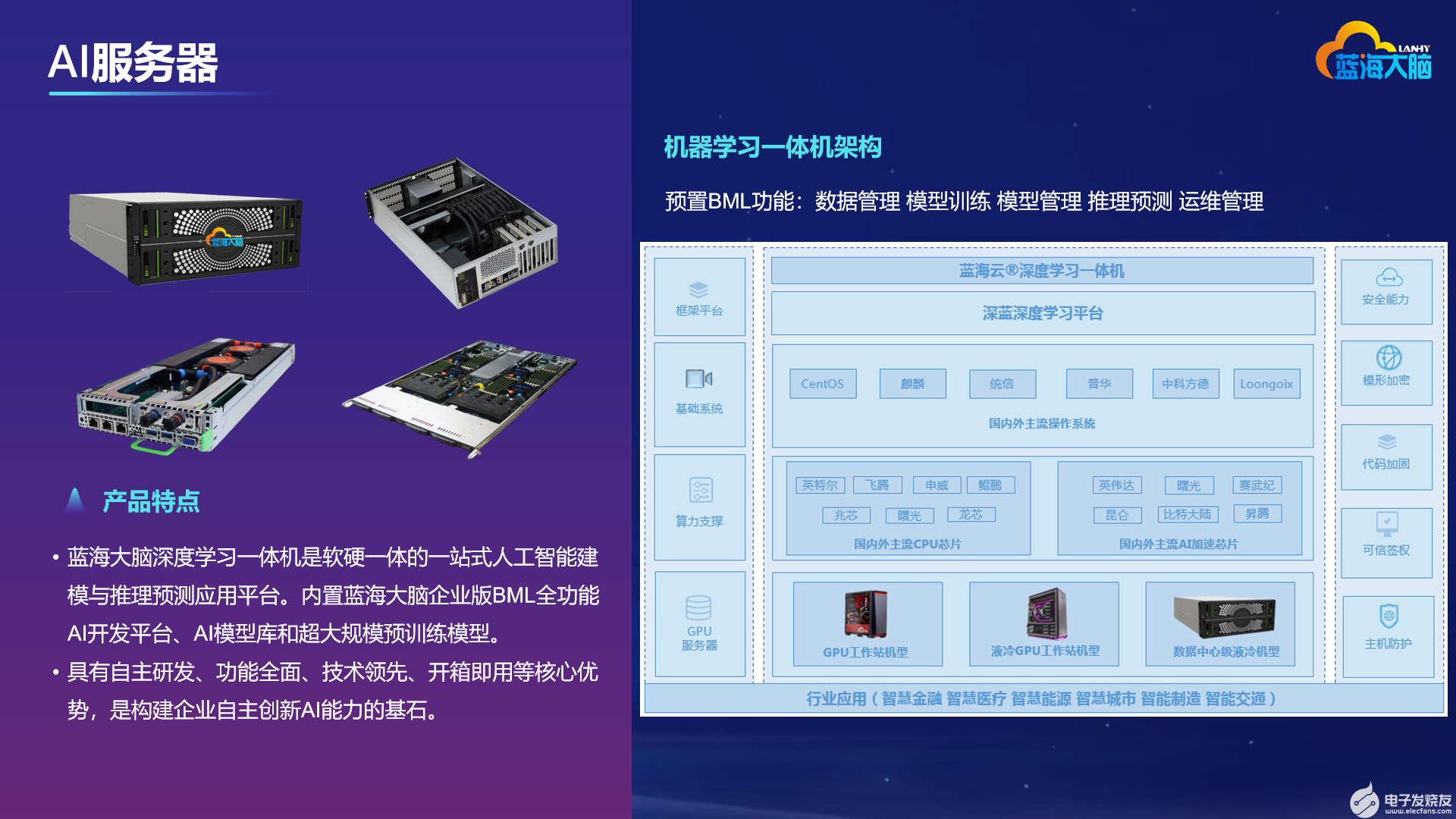

4525藍海大腦服務器全力支持NVIDIA H100 GPU

藍海大腦宣布服務器產品線全力支持最新的 NVIDIA H100 GPU。藍海大腦服務器產品在單機上最多可支持4、8甚至9個H100 GPU,可為多種人工智能場景提供超強算力、靈活的資源調度和成熟的生態支持。

2022-03-31 11:47:09 1067

1067

1067

1067基于Arm服務器系統架構的NVIDIA HPC SDK v21.7軟件開發工具包

英偉達 ARM HPC 開發工具包是第一個步驟,使 AR-HPC 生態系統 GPU 加速。 NVIDIA 致力于全面支持 Arm 的 HPC 和 AI 應用。

2022-04-14 14:51:08 1268

1268

1268

1268利用NVIDIA HGX H100加速計算數據中心平臺應用

HGX H100 8- GPU 是新一代 Hopper GPU 服務器的關鍵組成部分。它擁有八個 H100 張量核 GPU 和四個第三代 NV 交換機。每個 H100 GPU 都有多個第四代

2022-04-20 10:54:19 2109

2109

2109

2109

NVIDIA Riva可快速開發出GPU加速對話式AI應用

為了加快生產級、高精度 AI 模型的開發,NVIDIA 提供多種工具用于生成訓練數據、訓練和優化模型以及快速創建可立即部署的 AI 模型。

2022-04-29 14:33:04 1537

1537

1537

1537NVIDIA GPU加速潞晨科技Colossal-AI大模型開發進程

通過 NVIDIA GPU 加速平臺,Colossal-AI 實現了通過高效多維并行、異構內存管理、大規模優化庫、自適應任務調度等方式,更高效快速部署 AI 大模型訓練與推理。

2022-10-19 09:39:39 1149

1149

1149

1149AI服務器的應用場景有哪些?

關鍵詞:人工智能、高性能計算、HPC、GPU、CPU、服務器、人工智能服務器、人工智能工作站、深度學習、機器學習、液冷散熱、冷板式液冷、水冷工作站、液冷服務器、AI服務器 如今,市場上有越來越多熟悉

2023-01-30 10:06:42 1625

1625

1625

1625

NVIDIA 推出用于邊緣 AI、5G 和 Omniverse 數字孿生的 GPU 加速 AI-on-5G 系統

上運行 5G、AI 應用和沉浸式圖形工作負載的行業標準解決方案,以用于計算機視覺和元宇宙等領域。 為了滿足這一需求,NVIDIA 正在開發一款新的 AI-on-5G 解決方案, 它將 5G vRAN、邊緣 AI 和數字孿生工作負載整合于同一個一體化、超融合的 GPU 加速系統上。 該系統的較低擁

2023-03-13 09:25:02 503

503

503

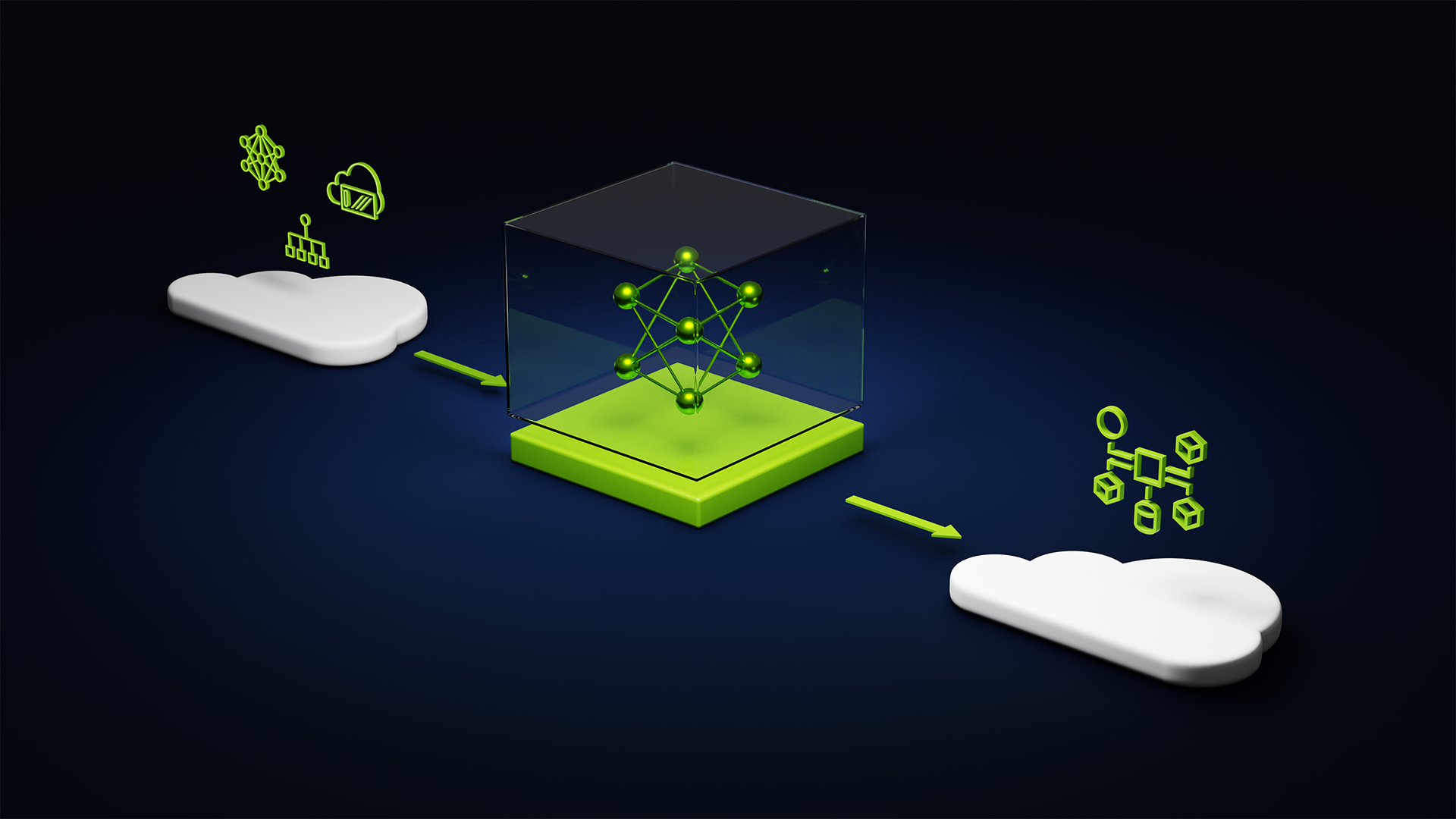

503NVIDIA 為全球企業帶來生成式 AI 推出用于創建大型語言模型和視覺模型的云服務

為AI驅動的應用構建自定義模型 ? 加利福尼亞州圣克拉拉 – GTC – 太平洋時間 2023年3月21日 – 為了加速企業應用生成式AI,NVIDIA今日宣布推出一套云服務,使企業能夠構建、完善

2023-03-22 13:45:40 261

261

261

261

NVIDIA推出用于大型語言模型和生成式AI工作負載的推理平臺

日 – NVIDIA于今日推出四款推理平臺。這些平臺針對各種快速興起的生成式AI應用進行了優化,能夠幫助開發人員快速構建用于提供新服務和洞察的AI驅動的專業應用。 ? 這些平臺將NVIDIA的全棧推理

2023-03-22 14:48:39 256

256

256

256

NVIDIA GTC 2023:GPU算力是AI的必需品

從OpenAI發布GPT-4,到百度發布文心一言;AI開始了爆走模式,現在我們來看看 NVIDIA GTC 2023 。 手握GPU算力的NVIDIA是AI的必需品。 圖源? NVIDIA官網直播

2023-03-22 15:23:28 2900

2900

2900

2900

GTC23 | NVIDIA 推出用于大型語言模型和生成式 AI 工作負載的推理平臺

日 – NVIDIA 于今日推出四款推理平臺。這些平臺針對各種快速興起的生成式 AI 應用進行了優化,能夠幫助開發人員快速構建用于提供新服務和洞察的 AI 驅動的專業應用。 這些平臺將 NVIDIA

2023-03-23 06:55:02 654

654

654

654GTC23 | NVIDIA 攜手谷歌云提供強大的全新生成式 AI 平臺,基于新款 L4 GPU 和 Vertex AI 構建

NVIDIA 生成式 AI 推理平臺將集成至谷歌云 Vertex AI 中;谷歌云成為首家提供 NVIDIA L4 GPU 實例的云服務商 加利福尼亞州圣克拉拉 – GTC – 太平洋時間 2023

2023-03-23 06:55:02 438

438

438

438GTC23 | NVIDIA 發布大型語言模型和生成式 AI 服務以推動生命科學研發

年 3 月 21 日 – NVIDIA 今日推出一整套用于自定義 AI 基礎模型的生成式 AI 云服務。這些服務將加速新蛋白質和治療方法的創建以及基因組學、化學、生物學和分子動力學等領域的研究。 作為

2023-03-23 06:55:03 328

328

328

328NVIDIA 與微軟合作加速企業就緒的生成式 AI

年 5 月 23 日——? NVIDIA 今天宣布將 NVIDIA AI Enterprise 軟件套件 集成到微軟的 Azure 機器學習中,以幫助企業加速推進 AI 計劃。 此次集成將創建一個安全、企業

2023-05-25 09:15:02 347

347

347

347

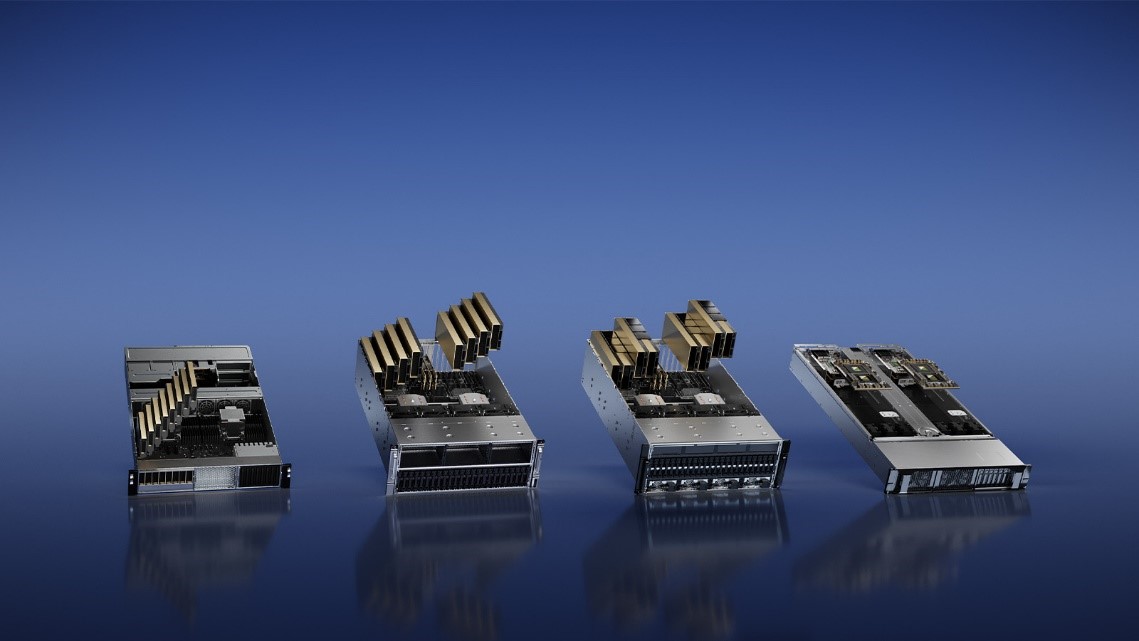

COMPUTEX2023 | NVIDIA MGX 為系統制造商提供模塊化架構,以滿足全球數據中心多樣化加速計算需求

多樣化的加速計算需求,NVIDIA 今天在 COMPUTEX 發布了 NVIDIA MGX 服務器規范 。該規范為系統制造商提供了一個模塊化參考架構,以快速、經濟高效地制造 100 多種服務器機型,適用于

2023-05-30 01:40:02 586

586

586

586

AI算力與能耗兼具,Supermicro梁見后暢談服務器的綠色計算

隨著生成式AI等人工智能席卷全球,服務器市場將作為產業先鋒迎來巨大的發展機會。在日前舉辦的臺北電腦展上,Supermicro總裁兼首席執行官梁見后(Charles Liang)接受電子發燒友網等媒體

2023-05-31 18:30:25 2206

2206

2206

2206

AI服務器與傳統服務器的區別是什么?

AI 服務器確實是整個服務器市場的一部分,但它們是專門為基于云的 AI 模型訓練或推理而設計的。在規格方面,廣義的AI服務器是指搭載AI芯片(如前面提到的GPU、FPGA、ASIC)的服務器,而狹義的定義則包括至少搭載一塊GPU的服務器。

2023-06-21 12:40:02 1208

1208

1208

1208大模型算力新選擇——寶德AI服務器采用8顆英特爾Gaudi?2加速器

近日,英特爾專門針對中國市場推出深度學習加速器Habana? Gaudi?2.以領先的性價比優勢,加速AI訓練及推理,提高深度學習性能和效率,從而成為大規模部署AI的更優解。作為英特爾在中國最重

2023-07-19 14:43:32 468

468

468

468SIGGRAPH 2023 | NVIDIA 與全球數據中心系統制造商大力推動 AI 與工業數字化的發展

OVX 服務器采用全新 NVIDIA GPU 以加速訓練和推理以及圖形密集型工作負載,將通過戴爾科技、慧與、聯想、超微等公司提供。 洛杉磯 — SIGGRAPH — 太平洋時間 2023

2023-08-09 19:10:06 264

264

264

264AI服務器架構的五大硬件拆解

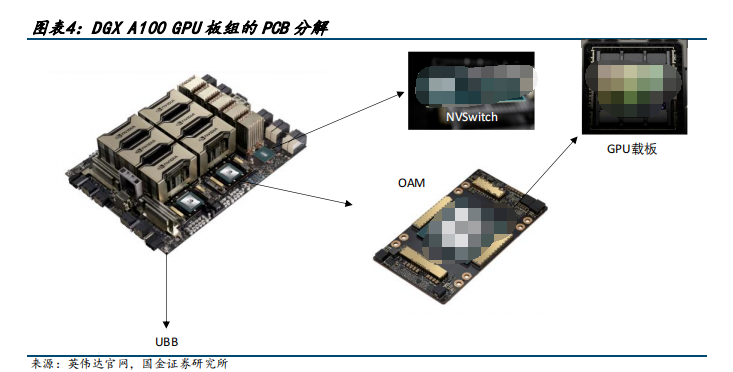

AI 服務器我們瞄準英偉達 DGX A100 和 DGX H100 兩款具有標桿性產品力的產品進行分析,鑒于 H100 發布時間較短、資料詳盡度不夠,我們首先從 DGX A100 出發來觀測具有產品力的 AI 服務器的基本架構。

2023-08-11 09:24:59 3121

3121

3121

3121

《開放加速規范AI服務器設計指南》發布,應對生成式AI算力挑戰

》面向生成式AI應用場景,進一步發展和完善了開放加速規范AI服務器的設計理論和設計方法,將助力社區成員高效開發符合開放加速規范的AI加速卡,并大幅縮短與AI服務器的適配周期,為用戶提供最佳匹配應用場景的AI算力產品方案,把握生成式AI爆發帶來的算力產業巨大機遇。 當前,生成式A

2023-08-14 09:49:31 471

471

471

471AI新品 | 兆瀚RA5900-B AI訓練服務器

END 原文標題:AI新品 | 兆瀚RA5900-B AI訓練服務器 文章出處:【微信公眾號:拓維信息】歡迎添加關注!文章轉載請注明出處。

2023-08-14 17:25:02 567

567

567

567全球領先系統制造商推出 NVIDIA AI 就緒型服務器,為企業大幅提升生成式 AI 性能

戴爾科技、慧與和聯想即將推出采用 NVIDIA L40S GPU 和 NVIDIA BlueField 的服務器,以支持 VMware Private AI Foundation

2023-08-23 19:10:09 350

350

350

350AI芯片CoWoS封裝產能受限,中介層不足成關鍵

大語言模型訓練和推理生成式AI(Generative AI)應用,帶動高端AI服務器和高性能計算(HPC)數據中心市場,內置集成高帶寬內存(HBM)的通用繪圖處理器(GPGPU)供不應求,主要大廠英偉達(Nvidia)A100和H100繪圖芯片更是嚴重缺貨。

2023-08-30 17:09:49 600

600

600

600Apple 預定 3 納米芯片,谷歌云 A3 虛擬機將改變 AI 訓練

GPU 的 A3 GPU 虛擬機,加速 AI 模型訓練速度 谷歌云近日宣布,他們將在下個月正式推出搭載 Nvidia H100 GPU 的 A3 GPU 虛擬機。這款 A3 虛擬機結合

2023-08-31 13:00:07 377

377

377

377

Oracle 云基礎設施提供新的 NVIDIA GPU 加速計算實例

也即將在 OCI Compute 上推出。 OCI 上的 NVIDIA? H100 Tensor Core GPU 實例 OCI Co mpute 裸機實例配備了具有? NVIDIA Hopper ? 架構 的 NVIDIA H

2023-09-25 20:40:02 269

269

269

269

傳英偉達新AI芯片H20綜合算力比H100降80%

但據悉,三種新型AI芯片不是“改良型”,而是“縮小型”。用于ai模型教育的hgx h20的帶寬和計算速度是有限的。整體計算能力理論上比nvidia的h100 gpu芯片低80%左右。h20是h100的20%的綜合計算性能。

2023-11-13 09:41:58 747

747

747

747英偉達確認為中國推三款改良AI芯片 性能暴降80%

據報道,nvidia的3種ai芯片不是“改良版”,而是“縮水版”,分別是hgx h20、l20 pcle和l2 pcle。用于ai模型訓練的hgx h20雖然帶寬和計算速度有限,但整體計算能力理論上比英偉達h100 gpu芯片低80%左右。

2023-11-13 10:46:07 410

410

410

410NVIDIA 為全球領先的 AI 計算平臺 Hopper 再添新動力

世界頂級服務器制造商和云服務提供商即將推出 HGX H200 系統與云實例 ? ? 丹佛 - SC23 - 太平洋 時間 2023 年 11 月 13 日 - NVIDIA 于今日宣布推出

2023-11-14 14:30:01 85

85

85

85

SC23 | NVIDIA 為全球領先的 AI 計算平臺 Hopper 再添新動力

世界頂級服務器制造商和云服務提供商即將推出 HGX H200 系統與云實例。 11月13日,NVIDIA 宣布推出 NVIDIA HGX H200 ,為 Hopper 這一全球領先的 AI 計算平臺

2023-11-14 20:05:01 269

269

269

269

NVIDIA 在 Microsoft Azure 上推出面向全球企業和初創公司的 生成式 AI Foundry 服務

AI Enterprise 軟件進行部署 ? ? ? Microsoft Ignite — 2023 年 11 月 15 日 — NVIDIA 于今日推出一項 AI foundry 服務,助力企業

2023-11-16 14:13:08 116

116

116

116

NVIDIA 在 Microsoft Azure 上推出面向全球企業和初創公司的生成式 AI Foundry 服務

AI Enterprise 軟件進行部署 NVIDIA 于今日推出一項 AI foundry 服務,助力企業和初創公司在 Microsoft Azure 上開發、調優和部署其自定義生成式 AI

2023-11-16 21:15:02 270

270

270

270AI服務器的內存接口芯片技術

DXG 服務器配備 8 塊 H100 GPU,6400億個晶體管,在全新的 FP8 精度下 AI 性能比上一代高 6 倍,可提供 900GB/s 的帶寬。

2023-12-13 09:23:54 335

335

335

335

Supermicro推出適用于AI存儲的機柜級全方位解決方案 加速高性能AI訓練和推理的數據存取

【2024年2月1日,美國圣何塞訊】Supermicro, Inc.(納斯達克股票代碼:SMCI)作為AI、云端、存儲和5G/邊緣領域的全方位IT解決方案制造商,推出適用于人工智能(AI)和機器學習

2024-02-01 17:56:09 271

271

271

271Supermicro推新AI存儲方案,助力AI和ML應用加速

Supermicro首席執行官梁見后先生高瞻遠矚地指出:針對AI和ML應用的加速處理,我們推薦配置以每機柜20 PB高速閃存為主,配備四個NVIDIA HGX H100系列優化版8-GPU氣冷服務器或者八個同款液冷服務器。

2024-02-03 14:46:40 337

337

337

337使用NVIDIA Triton推理服務器來加速AI預測

這家云計算巨頭的計算機視覺和數據科學服務使用 NVIDIA Triton 推理服務器來加速 AI 預測。

2024-02-29 14:04:40 162

162

162

162NVIDIA 推出 Blackwell 架構 DGX SuperPOD,適用于萬億參數級的生成式 AI 超級計算

塊 Blackwell GPU 連成一個整體,由NVIDIA 系統專家加速即時 AI 基礎設施的部署 ? ? ? 美國加利福尼亞州圣何塞 —— GTC —— 太平洋時間 2024 年 3 月 18

2024-03-19 10:56:35 57

57

57

57

英偉達發布超強AI加速卡,性能大幅提升,可支持1.8萬億參數模的訓練

得益于NVIDIA每兩年進行一次GPU架構升級以提高性能的策略,全新的基于Blackwell的加速卡比之前的H100更為強大,尤其適用于AI相關任務。

2024-03-19 12:04:04 72

72

72

72 電子發燒友App

電子發燒友App

評論