作者:PCIPG-HAY

?

現有的 3D 實例分割方法以自下而上的設計為主——手動微調算法將點分組為簇,然后是細化網絡。然而,由于依賴于聚類的質量,當(1)具有相同語義類的附近對象被打包在一起,或(2)具有松散連接區域的大型對象時,這些方法會產生容易受到影響的結果。為了解決這些限制,我們引入了 ISBNet,這是一種新穎的cluster-free方法,它將實例表示為內核并通過動態卷積解碼實例掩碼。為了有效地生成高召回率和判別力的內核,我們提出了一種名為“實例感知最遠點采樣”的簡單策略來對候選進行采樣,并利用受 PointNet++ 啟發的本地聚合層對候選特征進行編碼。此外,我們還表明,在動態卷積中預測和利用 3D 軸對齊邊界框可以進一步提高性能。我們的方法在 ScanNetV2 (55.9)、S3DIS (60.8) 和 STPLS3D (49.2) 上的 AP 上設置了新的最先進結果,并保留了快速推理時間(ScanNetV2 上每個場景 237 毫秒)。

1.引言

3D實例分割(3DIS)是3D領域深度學習的核心問題。給定由點云表示的 3D 場景,我們尋求為每個點分配語義類和唯一的實例標簽。 3DIS 是一項重要的 3D 感知任務,在自動駕駛、增強現實和機器人導航等領域有著廣泛的應用,其中可以利用點云數據來補充 2D 圖像提供的信息。與 2D 圖像實例分割 (2DIS) 相比,3DIS 可以說更難,因為外觀和空間范圍的變化更大,而且點云分布不均勻,即靠近物體表面密集而其他地方稀疏。因此,將 2DIS 方法應用于 3DIS 并非易事。

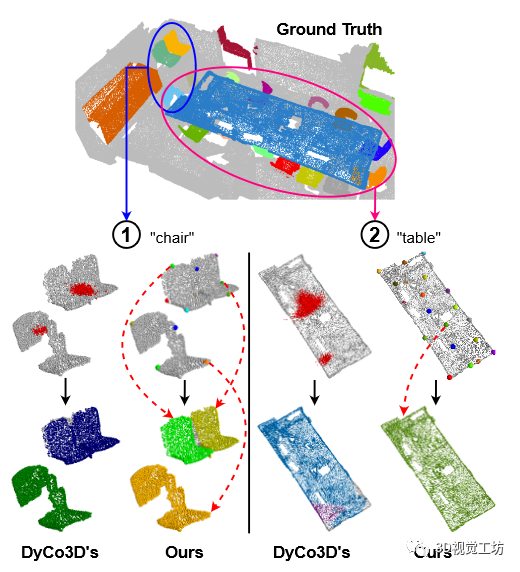

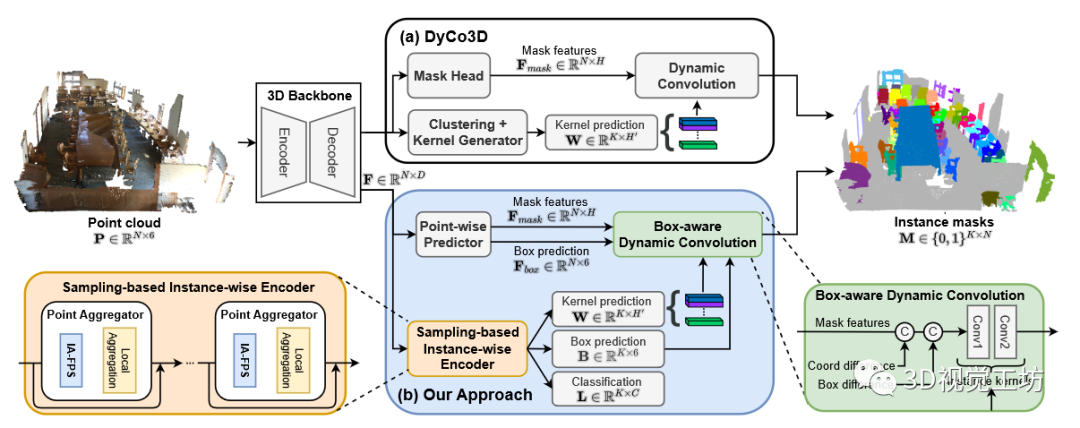

3DIS 的典型方法是 DyCo3D,采用動態卷積來預測實例掩碼。具體來說,點被聚類、體素化,并通過 3D Unet 生成實例內核,用于與場景中所有點的特征進行動態卷積。這種方法如圖 2 (a) 所示。然而,這種方法有一些局限性。首先,聚類算法嚴重依賴質心偏移預測,其質量在以下情況下顯著惡化:(1) 對象密集,導致兩個對象可能被錯誤地組合在一起作為一個對象,或 (2) 各部分連接松散的大型對象結果聚類在不同的對象中。這兩種情況如圖 1 所示。其次,點的特征主要編碼對象外觀,其不足以區分不同的實例,特別是在具有相同語義類的對象之間。這里也推薦「3D視覺工坊」新課程《三維點云處理:算法與實戰匯總》。

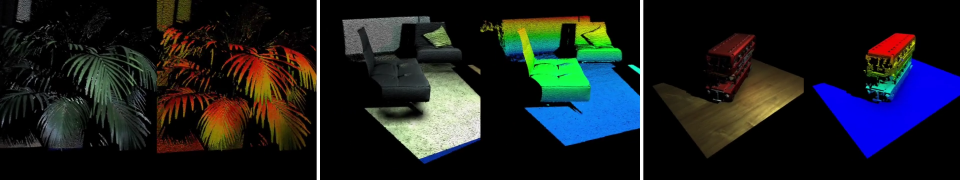

圖 1. 在 DyCo3D中,內核預測質量很大程度上受到基于質心的聚類算法的影響,該算法有兩個問題:1 對附近實例進行錯誤分組,2 將大對象過度分割成多個片段。我們的方法通過實例感知點采樣解決了這些問題,取得了更好的結果。每個樣本點都會聚合來自其本地上下文的信息,以生成用于預測其自己的對象掩碼的內核,并且最終實例將由 NMS 進行過濾和選擇。

為了解決 DyCo3D 的局限性,我們提出了 ISBNet,這是一種用于 3DIS 的無集群框架,具有實例感知最遠點采樣和框感知動態卷積。首先,我們重新審視最遠點采樣(FPS)和大量聚類方法,發現這些算法產生的實例召回率相當低。結果,在后續階段遺漏了許多對象,導致性能不佳。受此啟發,我們提出了實例感知最遠點采樣(IA-FPS),其目的是在具有高實例召回率的 3D 場景中對查詢候選進行采樣。然后,我們介紹點聚合器,將 IA-FPS 與本地聚合層結合起來,將實例的語義特征、形狀和大小編碼為實例特征。

此外,對象的 3D 邊界框是現有的監督,但尚未在 3D 實例分割任務中進行探索。因此,我們在模型中添加一個輔助分支來聯合預測每個實例的軸對齊邊界框和二進制掩碼。地面實況軸對齊邊界框是從現有實例掩碼標簽推導出來的。與 Mask-DINO和 CondInst不同,輔助邊界框預測僅用作學習過程的正則化,我們將其用作動態卷積中的額外幾何線索,從而進一步提高了實例分割任務。

為了評估我們方法的性能,我們對三個具有挑戰性的數據集進行了廣泛的實驗:ScanNetV2 、S3DIS和 STPLS3D。 ISBNet 不僅在這三個數據集中實現了最高的準確率,在 ScanNetV2、S3DIS 和 STPLS3D 上超過了最強的方法 +2.7/3.4/3.0,而且還表現出很高的效率,在 ScanNetV2 上每個場景的運行時間為 237ms。總而言之,我們的工作貢獻如下:

(i) 我們提出了 ISBNet,一種 3DIS 的cluster-free范例,它利用實例感知的最遠點采樣和點聚合器來生成實例特征集。

(ii) 我們首先介紹使用軸對齊邊界框作為輔助監督,并提出框感知動態卷積來解碼實例二進制掩碼。

(iii) ?ISBNet 在三個不同數據集上實現了最先進的性能:ScanNetV2、S3DIS 和 STPLS3D,無需對每個數據集的模型架構和超參數調整進行全面修改。

2.相關工作

**2D 圖像實例分割 (2DIS) **涉及為圖像中的每個像素分配實例標簽和語義標簽之一。它的方法可以分為三組:基于提案的方法、無提案的方法和基于 DETR 的方法。對于基于提案的方法 ,利用對象檢測器(例如 Faster-RCNN)來預測對象邊界框,以分割檢測到的框內的前景區域。對于無提議方法,SOLO 和 CondInst 使用特征圖預測動態卷積的實例內核以生成實例掩碼。對于基于 DETR 的方法 ,Mask2Former和 Mask-DINO采用帶有實例查詢的轉換器架構來獲取每個實例的分割。與 3DIS 相比,由于 2D 圖像的結構化、基于網格和密集的特性,2DIS 可以說更容易。因此,將 2DIS 方法應用于 3DIS 并非易事。

3D 點云實例分割 (3DIS) 方法

感興趣的是使用語義類和唯一實例 ID 來標記 3D 點云中的每個點。它們可以分為基于提議的方法、基于聚類的方法和基于動態卷積的方法。

基于提案的方法首先檢測 3D 邊界框,然后分割每個框內的前景區域以形成實例。 3D-SIS 將 Mask R-CNN 架構應用于 3D 實例分割,并聯合學習 RGB 圖像和 3D 點云兩種模式的特征。 3D-BoNet從總結場景內容的全局特征向量中預測固定數量的 3D 邊界框,然后分割每個框內的前景點。這種方法的局限性在于,實例掩模的性能很大程度上取決于 3D 邊界框的質量,由于 3D 點云的巨大變化和不均勻分布,3D 邊界框非常不穩定。

基于聚類的方法學習潛在嵌入,有助于將點分組到實例中。 PointGroup預測從每個點到其實例質心的 3D 偏移,并從兩個點云獲取簇:原始點和質心偏移點。 HAIS提出了一種層次聚類方法,其中小簇可以被較大的簇過濾掉或吸收。 SoftGroup提出了一種軟分組策略,其中每個點可以屬于具有不同語義類別的多個簇,以減輕語義預測誤差。基于聚類的方法的局限性之一是實例掩模的質量很大程度上取決于聚類的質量,即質心預測,這是非常不可靠的,特別是當測試對象在空間范圍上與訓練對象有很大不同時。

基于動態卷積的方法通過生成內核,然后使用它們與點特征進行卷積來生成實例掩碼,來克服基于提案和基于聚類的方法的局限性。 DyCo3D采用中的聚類算法來生成動態卷積的內核。 PointInst3D使用最遠點采樣來代替中的聚類來生成內核。 DKNet [38]引入候選挖掘和候選聚合來為動態卷積生成更具辨別力的實例內核。

我們的方法是一種基于動態卷積的方法,在內核生成和動態卷積方面有兩個重要的改進。特別是,在前者中,我們提出了一種新的實例編碼器,將實例感知的最遠點采樣與點聚合層相結合,以生成內核來取代 DyCo3D 中的聚類。在后者中,我們不僅使用動態卷積的外觀特征,還使用幾何提示(即邊界框預測)增強了該特征。

3.本文方法

?

圖 2. DyCo3D 的總體架構(塊 (a))和我們的 3DIS 方法(塊 (b))。給定點云,使用 3D 主干來提取每點特征。對于 DyCo3D,它首先根據每個點的預測對象質心將點分組為簇,為每個簇生成一個內核。同時,掩模頭將每點特征轉換為掩模特征以進行動態卷積。對于我們的 ISBNet 方法,我們用一種新穎的基于采樣的實例編碼器替換了聚類算法,以獲得更快、更魯棒的內核、框和類預測。此外,逐點預測器取代了 DyCo3D 的掩碼頭,以輸出掩碼和框特征,用于新的框感知動態卷積,以生成更準確的實例掩碼。

問題陳述:給定一個 3D 點云,其中 N 是點的數量,每個點由 3D 位置和 RGB 顏色向量表示。我們的目標是將點云分割成 K 個實例,這些實例由一組二進制掩碼 和一組語義標簽表示,其中 C 是語義類別的數量。

我們的方法由四個主要組件組成:3D 主干網絡、逐點預測器、基于采樣的實例編碼器和盒感知動態卷積。 3D 主干網采用 3D 點云作為輸入來提取每個點特征。我們的主干網絡提取特征其中 i = 1,... ?, N 為輸入點云的每個點。我們遵循之前的方法,采用帶有稀疏卷積 的 U-Net 作為主干。逐點預測器從主干網絡獲取每點特征并將其轉換為逐點語義預測、軸對齊邊界框預測 和用于框感知動態卷積的掩模特征。基于采樣的實例級編碼器(第 3.1 節)處理逐點特征以生成實例內核、實例類標簽和邊界框參數。最后,盒子感知動態卷積(第 3.2 節)獲取實例內核和掩碼特征以及互補框預測,以生成每個實例的最終二進制掩碼。我們的方法的概述如圖 2 所示。

3.1基于采樣的實例編碼器

給定主干網輸出的每點特征 ,我們的目標是產生實例特征,其中 K ? N 。實例特征E被用于預測實例分類分數 、實例框和實例內核,其中 H′ 由動態卷積中卷積層的大小決定。

通常,可以采用最遠點采樣 (FPS)對一組 K 個候選進行采樣,以生成實例內核。 FPS 通過使用成對距離選擇距先前采樣點最遠的下一個點來貪婪地采樣 3D 坐標中的點。然而,這種采樣技術較差。首先,FPS采樣的K個候選點中有很多屬于背景類別的點,浪費了計算資源。其次,大物體在采樣點的數量中占主導地位,因此不會從小物體中采樣任何點。第三,逐點特征無法捕獲本地上下文來創建實例內核。我們在選項卡中提供分析。 1 來驗證這一觀察結果。特別是,我們計算了內核預測的實例數量相對于總的真實實例的召回率。召回值應該很大,因為我們期望對真實實例上的聚類或采樣點進行良好的覆蓋。然而,可以看出,以前的方法的召回率較低,這可以解釋為這些方法沒有考慮點聚類或采樣的實例。

為了解決這個問題,我們提出了一種新穎的基于采樣的實例編碼器,它在點采樣步驟中考慮了實例。受 PointNet++中的Set Abstraction的啟發,我們指定實例編碼器包含一系列點聚合器 (PA) 塊,其組件是實例感知 FPS (IA-FPS),以對覆蓋盡可能多的前景對象的候選點進行采樣,并且本地聚合層捕獲本地上下文,從而單獨豐富候選特征。我們將圖 2 中橙色塊中的 PA 可視化,并在下面詳細介紹我們的采樣。

實例感知 FPS。我們的采樣策略是對前景點進行采樣,以最大程度地覆蓋所有實例,無論其大小如何。為了實現這一目標,我們選擇如下迭代采樣技術。具體來說,候選者是從一組點中采樣的,這些點既不是背景也不是先前采樣的候選者選擇的。我們使用逐點語義預測來估計每個點成為背景的概率。我們還使用由前 k 個候選生成的實例掩碼。利用 FPS 從點集 P′ ? P 中采樣點:

(1)

其中 K′ 是已選擇的候選者的數量,τ 是超參數閾值。

實際上,在訓練中,由于實例掩碼預測不足以指導實例采樣,因此從預測的前景掩碼中一次性采樣 K 個候選者。另一方面,在測試中,我們迭代地采樣較小的塊 一個接一個地使得后續塊既不會從背景點采樣,也不會從屬于先前塊的預測掩模的點采樣。通過這樣做,IA-FPS 的召回率提高了很多,如表 1 所示。

本地聚合層。對于每個候選 k,本地聚合層將本地上下文編碼并轉換為其實例特征。具體來說,采用 Ball-query [29] 來收集其 Q 個局部鄰居作為局部特征。此外,計算候選者 k 與其鄰居 q 之間的相對坐標,并用鄰域半徑 r 進行歸一化以形成局部坐標,或。接下來,我們使用 MLP 層將局部特征和局部坐標 轉換為候選 k 的實例特征。我們還添加了與原始特征的殘差連接以避免梯度消失。具體來說,實例級特征可以計算為:

(2)

在哪里 [·; ·]表示串聯運算。從 E 開始,使用線性層來預測實例分類分數 L、實例框 B 和實例內核 W。

值得注意的是,為了獲得實例級特征 E,我們不使用單個 PA 塊,而是提出了一種漸進的方法,即順序應用多個 PA 塊。這樣,后續塊將從前一個塊采樣的較少數量的點中進行采樣。這樣做與在 2D 圖像中堆疊多個卷積層以增加感受野具有相同的效果。

3.2包絡盒感知的動態卷積

在[16,17,38]的動態卷積中,對于每個候選k,所有點w.r.t k的相對位置,和逐點掩碼特征被連接起來與實例核進行卷積,得到實例二進制掩碼,其中 Conv 被實現為多個卷積層。然而,我們認為僅使用掩模特征和位置并不是最優的。例如,當僅使用 3D 中的掩模特征和位置時,類相同的相鄰對象邊界附近的點彼此無法區分。

另一方面,3D 邊界框描繪了對象的形狀和大小,這為實例分割中對象掩模的預測提供了重要的幾何線索。我們的方法使用邊界框預測作為規范化實例分割的輔助任務訓練。特別是,對于每個點,我們建議回歸從對象掩模推導出來的軸對齊邊界框。然后使用預測框來調節掩模特征,以生成框感知動態卷積的內核(參見圖 2 中的綠色塊)。每個邊界框由 6D 向量參數化,表示實例點坐標的最小和最大邊界。值得注意的是,我們選擇使用軸對齊的邊界框,因為地面實況框基本上是免費的,因為它們可以很容易地從地面實況實例注釋構建。

因此,我們建議使用預測框作為動態卷積中的附加幾何線索,給出我們提出的框感知動態卷積的名稱。直觀上,如果兩個點的預測框相似,則它們將屬于同一對象。我們的最終實例掩碼 第 k 個候選者獲得為:

(3)

幾何特征可以根據第 k 個候選實例預測的邊界框與輸入點云 P 中的 N 個點的絕對差計算得出,即。

3.3網絡訓練

我們使用 Pointwise Loss 和 Instance-wise Loss 來訓練我們的方法。前者是在逐點預測中產生的,即語義分割的交叉熵損失,以及邊界框回歸的L1損失和gIoU損失[31]。后者是在每個實例預測中發生的,即分類、框預測和掩模預測,使用[20]提出的用于 2D 對象檢測的一對多匹配損失。具體來說,匹配成本是實例分類和實例掩碼的組合:

(4)

其中 是兩個掩模之間的骰子損失。準確地說,通過在匈牙利匹配中復制地面實況 S 次,將 S 個預測掩碼與一個地面實況掩碼進行匹配。這樣,訓練收斂速度要快得多,并且掩模預測性能比 DETR提出的一對一匹配要好。然后,真實掩碼與其匹配的預測掩碼之間產生的實例損失定義為:

(5)

其中Lcls是交叉熵損失,是dice損失和BCE損失的組合,是L1損失和gIoU損失的組合,是Mask-Scoring損失。

4.實驗

4.1實驗設計

數據集。我們在三個數據集上評估我們的方法:ScanNetV2 [8]、S3DIS [1] 和 STPLS3D [4]。 ScanNetV2 數據集由 1201、312 和 100 個掃描組成,分別具有 18 個對象類,用于訓練、驗證和測試。與之前的工作一樣,我們報告了 ScanNetV2 驗證集和測試集的評估結果。 S3DIS數據集包含來自6個區域、13個類別的271個場景。我們報告了區域 5 和區域 6 交叉驗證的評估。 STPLS3D 數據集是來自真實世界和合成環境的航空攝影測量點云數據集。它包括25個總面積為6平方公里的城市場景和14個實例類別。繼[5, 34]之后,我們使用場景 5、10、15、20 和 25 進行驗證,其余部分進行訓練。

評估指標。采用物體檢測和實例分割任務常用的平均精度,即AP50和AP25分別是IoU閾值50%和25%時的分數,AP是IoU閾值50%到95%時的平均分數,步長為 5%。 Box AP 表示 3D 軸對齊邊界框預測的平均精度。此外,還使用平均覆蓋率 (mCov)、平均加權覆蓋率 (mWCov)、平均精度 (mPrec50) 和平均召回率 (mRec50) 進行評估,IoU 閾值為 50%。

實施細節。我們使用 PyTorch 深度學習框架 [27] 實現我們的模型,并在單個 V100 GPU 上使用 AdamW 優化器對其進行 320 個時期的訓練。批量大小設置為 16。學習率初始化為 0.004,并通過余弦退火進行調度 [41]。根據[34],我們將 ScanNetV2 和 S3DIS 的體素大小設置為 0.02m,將 STPLS3D 的體素大小設置為 0.3m,因為它的稀疏性和更大的規模。在訓練中,場景被隨機裁剪,最大數量為 250,000 個點。在測試中,整個場景都被輸入網絡而不進行裁剪。我們使用與[34]中相同的主干設計,輸出 32 個通道的特征圖。基于采樣的實例感知編碼器中使用了兩層 PA 的堆棧。 τ 設置為 0.5。我們將這兩層的球查詢半徑 r 設置為 0.2 和 0.4,并將兩層的鄰居數量 Q = 32。我們還實現了具有隱藏維度為 32 的兩層的盒感知動態卷積。γmask 設置為 5。λbox、λmask 和 λms 分別設置為 1、5 和 1。在訓練中,我們設置 S = 4 和 K = 256。在推理中,我們設置 K = 384 并使用非極大值抑制來刪除閾值為 0.2 的冗余掩模預測。遵循[14,26,38],我們利用超級點[23,24]來對齊ScanNetV2數據集上的最終預測掩模。

4.2主要結果

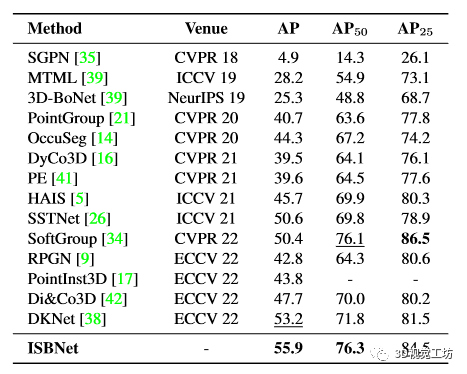

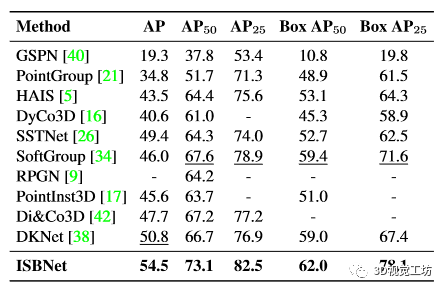

ScanNetV2。我們在表2中報告隱藏測試集的實例分割結果,在表3中的驗證集上報告了目標檢測和實例分割的結果。 ?在隱藏測試集上,ISBNet 在 AP/AP50 中取得了 55.9/76.6 的成績,在 ScanNetV2 基準上創下了新的 state-of-the-art 性能。在驗證集上,我們提出的方法以較大的優勢超越了第二好的方法,在 AP/AP50/AP25 中為 +3.7/5.5/3.6,在 Box AP50/Box AP25 中為 +2.6/6.5。

表 2. ScanNetV2 隱藏測試集上的 3D 實例分割結果(以 AP 分數表示)。最好的結果以粗體顯示,次好的結果以下劃線顯示。我們提出的方法實現了最高的 AP,優于之前最強的方法。

表 3. ScanNetV2 驗證集上的 3D 實例分割和 3D 對象檢測結果。

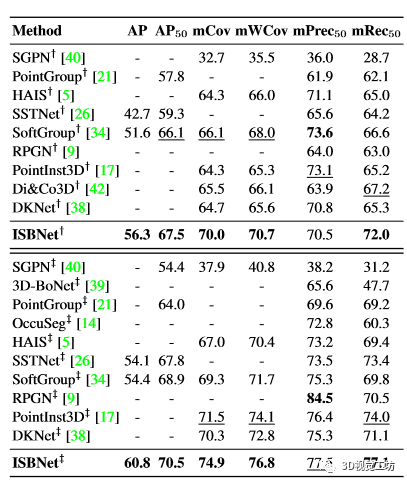

S3DIS。表 4 總結了 S3DIS 數據集的 5 區和 6 倍交叉驗證的結果。在 Area 5 和交叉驗證評估中,我們提出的方法在幾乎所有指標上都大幅超越了最強的方法。在6倍交叉驗證評估中,我們在mCov/mWCov/mRec50中取得了74.9/76.8/77.1,與第二強的方法相比提高了+3.5/2.7/3.1。

表 4. S3DIS 數據集上的 3D 實例分割結果。標有 ? 的方法在區域 5 上進行評估,標有 ? 的方法在 6 倍交叉驗證中進行評估。

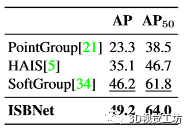

STPLS3D。表5顯示了STPLS3D數據集的驗證集上的結果。我們的方法在所有指標中實現了最高的性能,并且在 AP/AP50 中超過了第二好的方法 +3.0/2.2。

表 5. STPLS3D 驗證集上的 3D 實例分割結果。

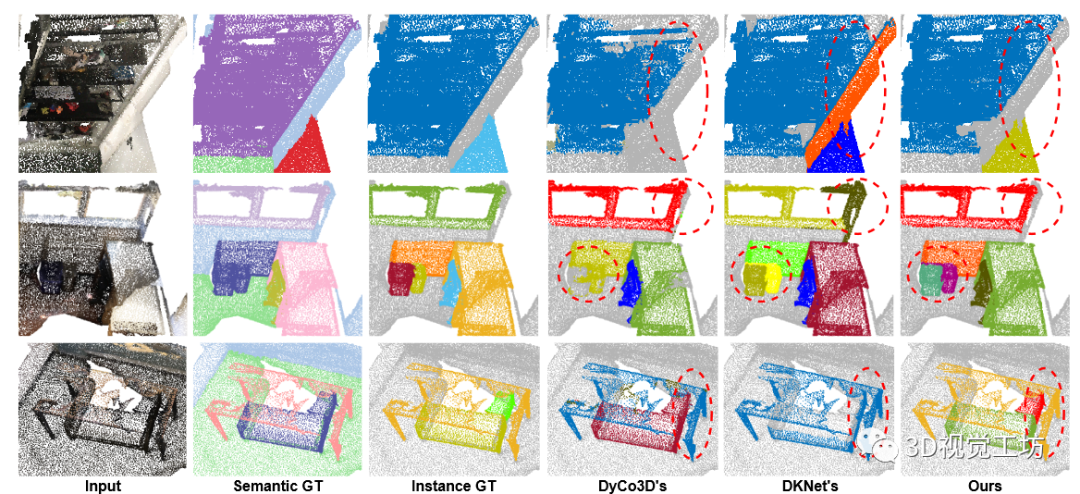

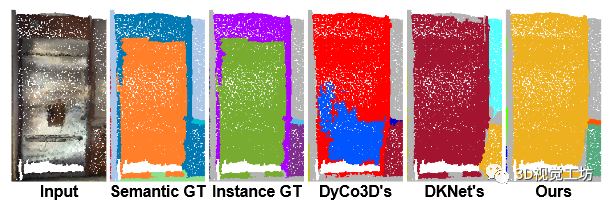

4.3定性結果

我們在圖 3 中可視化我們的方法 DyCo3D [16] 和 DKNet [38] 在 ScanNetV2 驗證集上的定性結果。可以看出,我們的方法成功區分了具有相同語義類的附近實例。由于聚類的限制,DyCo3D [16] 錯誤分割了書架的部分(第 1 行)并合并了附近的沙發(第 2、3 行)。 DKNet [38] 過度分割了第 2 行中的窗口,并且還錯誤地合并了附近的沙發和桌子(第 3 行)。

?

圖 3. ScanNetV2 驗證集的代表性示例。每行顯示一個示例,前三列中包含輸入、語義基本事實和實例基本事實。我們的方法(最后一列)生成更精確的實例掩碼,特別是在具有相同語義標簽的多個實例位于在一起的區域。

4.4消融實驗

我們對 ScanNetV2 數據集的驗證集進行了一系列消融研究,以研究 ISBNet。

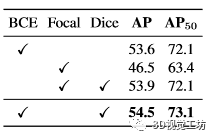

掩模損耗的不同組合的影響如表6所示。值得注意的是,結合使用二元交叉熵和骰子損失會產生最佳結果,AP 為 54.5。

表 6. ScanNetV2 驗證集上掩模損失的不同組合的消融研究。

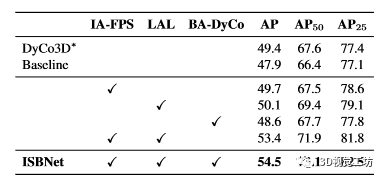

各個組件對整體性能的影響

如表7所示。第 1 行中的 DyCo3D* 是我們對 DyCo3D 的重新實現,其主干與 [5,34,38] 相同,并且使用一對多匹配損失進行訓練。第 2 行中的基線是具有標準最遠點采樣 (FPS)、標準動態卷積(如 [16,17,38] 中所示)且沒有本地聚合層 (LAL) 的模型。可以看出,替換 DyCo3D* 中的聚類和微小 Unet 使 AP 中的性能從 49.4 降低到 47.9。當基線中的標準 FPS 替換為實例感知最遠點采樣 (IAFPS) 時,第 3 行的性能提高到 49.7。當將 LAL 添加到基線模型時,第 4 行的 AP 分數提高到 50.1,并且優于DyCo3D* 的 AP 增加 0.7。只需將標準動態卷積替換為 Box-aware Dynamic Convolution (BA-DyCo),第 5 行的 AP 即可獲得 +0.7。特別是,結合 IA-FPS 和 PA 可顯著提高性能,AP/AP50 中的 +5.5/+6.8第 6 行。最后,第 7 行的完整方法,ISBNet 在 AP/AP50 中實現了最佳性能 54.5/73.1。

表 7. ISBNet 每個組件對 ScanNetV2 驗證集的影響。 IA-FPS:實例感知最遠點采樣,LAL:本地聚合層,BA-DyCo:盒子感知動態卷積。 *:我們的 DyCo3D 改進版本 [16]。

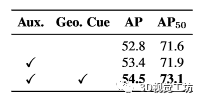

軸對齊邊界框回歸的影響

如表 8所示。在不使用邊界框作為輔助監督(Aux.)的情況下,我們的方法在 AP/AP50 中達到了 52.8/71.6。在訓練過程中添加邊界框損失可以使 AP 提高 0.6。特別是,當在動態卷積中使用邊界框作為額外的幾何線索(Geo.Cue)時,AP/AP50 中的結果顯著增加到 54.5/73.1。這證明了我們的主張,即 3D 邊界框是區分3D 點云中的實例的關鍵幾何線索。

表 8. 3D 軸對齊邊界框回歸的影響。

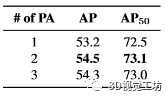

點聚合器 (PA) 塊數量的影響

如表 9所示。使用單塊 PA,我們的方法在 AP/AP50 中達到 53.2/72.5。堆疊兩個 PA 塊可在這些指標中帶來 1.3/0.6 的增益。然而,當我們添加更多塊時,AP/AP50 中的結果略有下降至 54.3/73.0。

表 9. 點聚合器 (PA) 塊的數量。

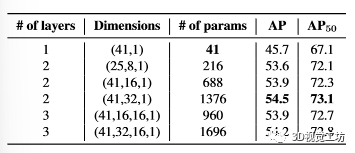

動態卷積不同設計的影響

如表 10 所示。這里,使用兩層具有 32 個隱藏通道的動態卷積給出了最好的結果。僅使用單層動態卷積會導致性能顯著下降。另一方面,添加太多層(即三層)會產生更差的結果。減少隱藏通道的數量會稍微降低性能。由于額外的幾何線索,即使只有 216 個動態卷積參數,我們的模型也可以在 AP/AP50 中達到 53.6/72.1,證明了盒子感知動態卷積的魯棒性。這里也推薦「3D視覺工坊」新課程《三維點云處理:算法與實戰匯總》。

表 10. Box-aware 動態卷積的消融。

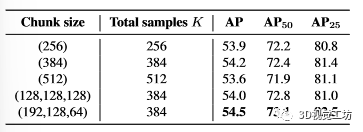

IA-FPS 塊大小的消融。我們研究了表 11 中推理中 IA-FPS 采樣塊大小的不同設計。 11. 前三行顯示我們一次對 K 個候選樣本進行采樣時的結果。將樣本數量從 256 增加到 384 會稍微提高整體性能,但在樣本數為 512 時,AP 結果下降到 53.6。當將 K 分割為較小的大小塊 (192,128,64) 并根據式(192,128,64)采樣點時: (1),最后一行的AP/AP50性能進一步提升至54.5/73.1。

?

表 11. 迭代采樣的樣本塊大小的消融。

運行時分析。

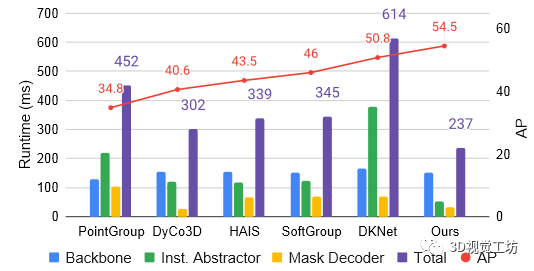

圖 4 報告了同一 Titan X GPU 上 ISBNet 的組件和總運行時間以及 3DIS 的 5 種最新方法。所有方法都可以大致分為三個主要階段:主干、實例抽象器和掩碼解碼器。我們的方法是最快的方法,總運行時間僅為 237 毫秒,主干/實例抽象器/掩碼解碼器階段為 152/53/32 毫秒。與PointGroup [21]、DyCo3D [16]和SoftGroup [34]中基于聚類的實例抽象器相比,我們基于Point Aggregator的實例抽象器顯著減少了運行時間。我們的掩模解碼器是通過動態卷積實現的,是這些方法中第二快的。這證明了我們提出的方法的有效性。

圖 4. 組件和總運行時間(以毫秒為單位)以及之前五種方法的 AP 和 ScanNetV2 驗證集上的 ISBNet 的結果。

5.結論

在這項工作中,我們引入了 ISBNet,一種簡潔的基于動態卷積的方法來解決 3D 點云實例分割的任務。考慮到實例分割模型的性能依賴于候選查詢的召回,我們提出了實例感知最遠點采樣和點聚合器來有效地對 3D 點云中的候選進行采樣。此外,利用 3D 邊界框作為輔助監督和動態卷積的幾何提示進一步提高了模型的準確性。在 ScanNetV2、S3DIS 和 STPLS3D 數據集上進行的大量實驗表明,我們的方法在所有數據集上都實現了穩健且顯著的性能提升,大幅超越了 3D 實例分割中最先進的方法,即 +2.7、+2.4、+ 3.0 在 ScanNetV2、S3DIS 和 STPLS3D 上的 AP 中。

我們的方法并非沒有局限性。例如,我們的實例感知 FPS 不能保證覆蓋所有實例,因為它依賴于當前實例預測來做出點采樣決策。我們提出的軸對齊邊界框可能無法緊密貼合復雜實例的形狀。圖 5 顯示了一個硬箱,其中冰箱以柜臺為界。我們的模型無法區分這些點,因為它們共享相似的邊界框。解決這些限制可能會導致未來工作的改進。此外,通過利用對象的幾何結構(例如形狀和大小)來改進動態卷積的新研究將是一個有趣的研究課題。

圖 5. ScanNetV2 驗證集的一個硬案例,其中冰箱被柜臺包圍。 ISBNet 和以前的方法錯誤地將這些實例中的點合并到單個對象中。

編輯:黃飛

?

電子發燒友App

電子發燒友App

評論