【導(dǎo)讀】前段時(shí)間,LeCun轉(zhuǎn)發(fā)了2篇長(zhǎng)文,集中討論了LLM的規(guī)劃推理能力和涌現(xiàn)能力的來(lái)源。作者認(rèn)為,LLM本身不具有規(guī)劃推理能力,而涌現(xiàn)出來(lái)的能力,根源應(yīng)該都是上下文學(xué)習(xí)的結(jié)果。

大語(yǔ)言模型到底會(huì)不會(huì)推理?涌現(xiàn)出來(lái)的各種能力到底來(lái)源是什么?

前段時(shí)間,LeCun在自己推特上轉(zhuǎn)發(fā)了好幾篇文章,集中討論了這個(gè)問(wèn)題:

「自回歸LLM無(wú)法制定計(jì)劃(并且無(wú)法真正推理)」。

而LeCun轉(zhuǎn)發(fā)第二篇論文,則討論了LLM涌現(xiàn)能力。

原推表示,不管大伙相不相信LLM的涌現(xiàn)能力,這篇文章都值得一讀:

「經(jīng)過(guò)了超過(guò)1000次的系列實(shí)驗(yàn),我們證明了大語(yǔ)言模型所謂的涌現(xiàn)能力,其實(shí)僅僅是上下文學(xué)習(xí)而已。」

LLM真的能推理和規(guī)劃嗎?

Subbarao Kambhampat的文章認(rèn)為,網(wǎng)上對(duì)于LLM能夠推理和規(guī)劃的說(shuō)法,本身不太站得住腳,但是學(xué)界對(duì)于這個(gè)問(wèn)題,也開(kāi)始進(jìn)行了很?chē)?yán)肅地研究。

至少以他之前針對(duì)GPT-3的研究看來(lái),認(rèn)為大語(yǔ)言模型行能夠推理和規(guī)劃的說(shuō)法是有很大問(wèn)題的。

https://arxiv.org/pdf/2206.10498.pdf

我們提出了一個(gè)可擴(kuò)展的評(píng)估框架來(lái)測(cè)試LLM推理行動(dòng)和變化的能力,這是人類(lèi)智力的一個(gè)核心方面。我們提供了多個(gè)測(cè)試用例,這些測(cè)試用例比之前建立的任何基準(zhǔn)都更加復(fù)雜,并且每個(gè)測(cè)試用例都會(huì)評(píng)估有關(guān)操作和更改的推理的不同方面。GPT-3 (davinci)、Instruct-GPT-3 (text-davinci-002) 和 BLOOM (176B) 的結(jié)果顯示此類(lèi)推理任務(wù)的表現(xiàn)不佳。

針對(duì)新推出的GPT-4,教授的團(tuán)隊(duì)也將之前的研究進(jìn)行了進(jìn)一步的拓展,試圖發(fā)現(xiàn)新的最先進(jìn)的大語(yǔ)言模型是否對(duì)于推理和規(guī)劃能力有了新的進(jìn)展。

https://arxiv.org/pdf/2206.10498.pdf

我們通過(guò)在類(lèi)似于國(guó)際規(guī)劃競(jìng)賽中使用的方式,生成一組實(shí)例來(lái)進(jìn)行系統(tǒng)研究,并以?xún)煞N不同的模式評(píng)估LLM:自主模式和啟發(fā)式模式。我們的研究結(jié)果表明,法學(xué)碩士自主生成可執(zhí)行計(jì)劃的能力相當(dāng)有限,GPT-4在各個(gè)領(lǐng)域的平均成功率為 ~12%。

然而,啟發(fā)式模式的結(jié)果顯示出更多的希望。在啟發(fā)式模式中,我們證明了LLM生成的計(jì)劃可以改進(jìn)底層合理規(guī)劃器的搜索過(guò)程,并且還表明外部驗(yàn)證者可以幫助提供對(duì)生成的計(jì)劃的反饋,并反向提示 LLM 以更好地生成計(jì)劃。

文章用一張很有意思的圖向讀者說(shuō)明,似乎LLM表現(xiàn)出來(lái)的推理能力,主要的原因還是在于任務(wù)比較簡(jiǎn)單,提問(wèn)題的人已經(jīng)知道了問(wèn)題的答案。

而針對(duì)競(jìng)賽級(jí)別的規(guī)劃和推理任務(wù),比如國(guó)際規(guī)劃大賽(IPC)中的積木世界(Blocks World)問(wèn)題,LLM的表現(xiàn)就不盡如人意。

初步結(jié)果表明,從GPT-3到GPT3.5再到GPT-4,生成的平面圖的精度有一定的提高,GPT-4在Blocks World中達(dá)到30%的經(jīng)驗(yàn)精度(empirical accuracy)(盡管在其他領(lǐng)域仍然較低)。

教授的研究團(tuán)隊(duì)認(rèn)為,對(duì)于很多規(guī)劃任務(wù)的表現(xiàn),LLM的能力可能只是因?yàn)樗谔貏e大的范圍內(nèi)進(jìn)行了訓(xùn)練,從而「記住」規(guī)劃的內(nèi)容。

于是研究團(tuán)隊(duì)通過(guò)混淆規(guī)劃問(wèn)題中的動(dòng)作和對(duì)象的名稱(chēng)來(lái)降低近似檢索的有效性,阻止大語(yǔ)言模型檢索自己記住的「規(guī)劃內(nèi)容」。

在這樣的挑戰(zhàn)面前,GPT-4的經(jīng)驗(yàn)表現(xiàn)急劇下降。

對(duì)于LLM不能直接自主地進(jìn)行規(guī)劃的局限,研究團(tuán)隊(duì)通過(guò)兩種方式進(jìn)行改進(jìn):

首先是對(duì)模型進(jìn)行微調(diào),不過(guò)教授的團(tuán)隊(duì)在對(duì)模型進(jìn)行了微調(diào)之后,還是沒(méi)有發(fā)現(xiàn)模型的規(guī)劃能力有提升。

而且認(rèn)為,即便通過(guò)微調(diào)模型使得模型的規(guī)劃能力提高了,但是也是將規(guī)劃任務(wù)轉(zhuǎn)化為基于內(nèi)存的檢索,而不能證明大語(yǔ)言模型能夠進(jìn)行自主規(guī)劃。

第二種提高模型規(guī)劃能力的方法是不斷提示LLM,改進(jìn)它初始的計(jì)劃。

但是對(duì)于這種方法,特別是不斷讓模型自己生成改進(jìn)意見(jiàn)的提示,本質(zhì)上都是讓模型生成猜測(cè),或者是提示的人決定哪些猜測(cè)能更好地改進(jìn)規(guī)劃,都不是模型自己提升了計(jì)劃能力。

那些頂會(huì)上聲稱(chēng)展示了LLM規(guī)劃能力的論文問(wèn)題出在哪里?

持懷疑態(tài)度的讀者現(xiàn)在可能會(huì)問(wèn),但那些在高調(diào)的人工智能會(huì)議上聲稱(chēng)展示了LLM規(guī)劃能力的論文是怎么回事?

要分析這些說(shuō)法,首先需要明白,解決規(guī)劃任務(wù)需要:

1. 擁有必要的規(guī)劃領(lǐng)域知識(shí)

2. 能夠?qū)⑦@些計(jì)劃知識(shí)組裝成一個(gè)可執(zhí)行的計(jì)劃,該計(jì)劃負(fù)責(zé)完成子目標(biāo),或者進(jìn)行資源交互。

第一個(gè)要素可以稱(chēng)為知識(shí)獲取,第二個(gè)要素可以稱(chēng)為推理/計(jì)劃。

許多聲稱(chēng)LLM具有規(guī)劃能力的論文,在仔細(xì)檢查后,都混淆了從LLM中提取的可執(zhí)行計(jì)劃的一般規(guī)劃知識(shí)。

如果研究人員所尋找的都是抽象的計(jì)劃,例如「婚禮計(jì)劃」,而沒(méi)有實(shí)際執(zhí)行計(jì)劃的意圖時(shí),很容易將它們與完整的可執(zhí)行計(jì)劃混淆,從而沒(méi)法準(zhǔn)確地評(píng)估LLM的計(jì)劃能力。

教授團(tuán)隊(duì)對(duì)幾篇聲稱(chēng)LLM具有規(guī)劃能力的論文的仔細(xì)研究后發(fā)現(xiàn),LLM要么在子目標(biāo)交互可以被安全地忽略的領(lǐng)域/任務(wù)中進(jìn)行計(jì)劃工作(規(guī)劃沒(méi)有意義的任務(wù)或者不重要的任務(wù)),要么將推理問(wèn)題委托給循環(huán)過(guò)程中的人類(lèi)來(lái)完成(通過(guò)反復(fù)提示,「糾正」計(jì)劃)。

如果沒(méi)有這些假設(shè)或者緩沖措施,從LLM中得出的計(jì)劃在外行用戶(hù)看來(lái)可能是合理的,但會(huì)導(dǎo)致執(zhí)行時(shí)出現(xiàn)各種各樣的問(wèn)題。

比如,旅行計(jì)劃書(shū)籍的大量出現(xiàn),這些書(shū)籍內(nèi)容基本都是由LLM自動(dòng)生成出來(lái)的,而購(gòu)買(mǎi)這些書(shū)籍的讀者卻把它們誤認(rèn)為是可以執(zhí)行的計(jì)劃,最后會(huì)導(dǎo)致結(jié)果非常令讀者失望。

LLM并不存在計(jì)劃和推理能力

總而言之,教授認(rèn)為,他所讀過(guò)、驗(yàn)證過(guò)或做過(guò)的任何事情都沒(méi)有給他任何令人信服的理由,讓他相信LLM會(huì)像通常理解的那樣進(jìn)行推理/計(jì)劃。

認(rèn)為L(zhǎng)LM具有推理/規(guī)劃能力的研究所做的內(nèi)容,在大規(guī)模的訓(xùn)練下,其實(shí)都相當(dāng)于是檢索,有時(shí)會(huì)被誤認(rèn)為是推理能力。

LLM確實(shí)擅長(zhǎng)為任何任務(wù)產(chǎn)生想法,包括那些涉及推理的任務(wù),這可以有效地用于支持推理/計(jì)劃。?換句話(huà)說(shuō),LLM已經(jīng)擁有足夠驚人的近似檢索的能力,我們可以充分利用這種能力,不需要將虛假的推理/計(jì)劃能力歸在LLM身上。

如果對(duì)于這個(gè)問(wèn)題感興趣,還可以參考教授的一場(chǎng)演講。

而另一篇關(guān)于大語(yǔ)言模型涌現(xiàn)的能力的文章,針對(duì)的是上下文學(xué)習(xí)的能力。

涌現(xiàn)能力?不存在!

https://arxiv.org/pdf/2309.01809.pdf

簡(jiǎn)單來(lái)說(shuō),研究人員發(fā)現(xiàn),LLM在執(zhí)行一些沒(méi)有經(jīng)過(guò)明確訓(xùn)練的、且需要復(fù)雜推理能力的任務(wù)時(shí),表現(xiàn)不是一般的好。

這種能力對(duì)未來(lái)NLP的研究方向產(chǎn)生了重大影響。隨著LLMs的不斷壯大,在可預(yù)見(jiàn)的未來(lái),應(yīng)用的場(chǎng)合會(huì)越來(lái)越普遍。

但問(wèn)題在于,在研究人員評(píng)估LLMs的能力時(shí),會(huì)被一些因素所干擾,導(dǎo)致混淆。

比方說(shuō),有些能力可能是由prompt技術(shù)帶來(lái)的。上下文學(xué)習(xí)(in-context learning)和指令跟隨(instruction following)都是其中的例子。

這些情況也會(huì)隨著模型規(guī)模的不斷變大而增多。

因此,本文的研究團(tuán)隊(duì)全面考察了這些能力,考慮到了一些可能影響模型評(píng)估的潛在偏差因素。

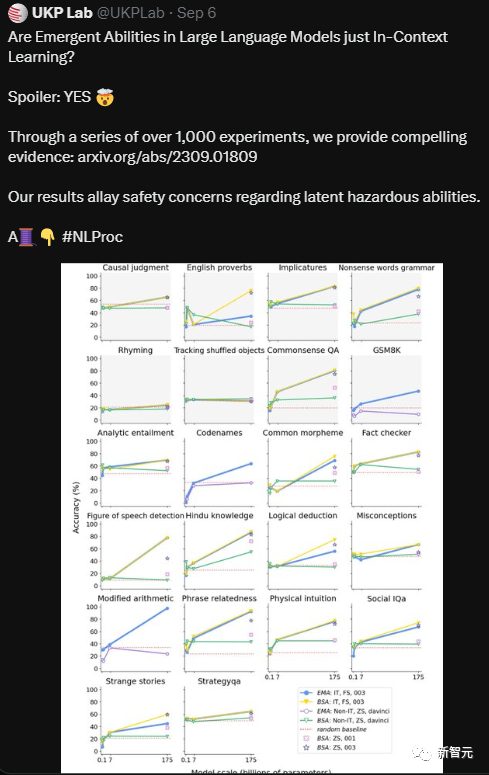

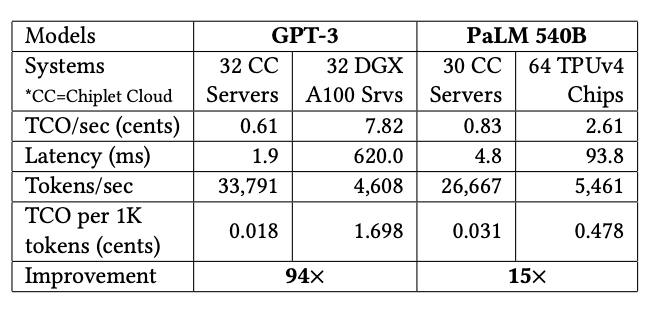

研究人員對(duì)一組18個(gè)模型進(jìn)行了嚴(yán)密的測(cè)試,這些LLM的參數(shù)范圍從6000萬(wàn)到1750億不等,測(cè)試包含22項(xiàng)任務(wù)。

在經(jīng)過(guò)了1000多次實(shí)驗(yàn)后,研究人員給出了充足的證據(jù),證明了所謂的涌現(xiàn)能力,主要就是上下文學(xué)習(xí)帶來(lái)的。

研究人員還表示,并沒(méi)有找到能證明LLM有推理能力的證據(jù)。

實(shí)驗(yàn)方法

具體來(lái)看,研究人員逐一研究了以下問(wèn)題:

·為了消除上下文學(xué)習(xí)和指令微調(diào)可能會(huì)帶來(lái)的影響,研究人員選擇了零樣本條件,并使用了非指令微調(diào)的模型。

·探究上下文學(xué)習(xí)能力和指令微調(diào)之間的相互作用,搞明白是不是該用推理能力來(lái)解釋指令微調(diào)模型的一些額外能力。為此,研究人員比較了沒(méi)有指令微調(diào)的模型和在不同程度上經(jīng)過(guò)指令微調(diào)的不同規(guī)模模型的能力。

·通過(guò)人工來(lái)檢查L(zhǎng)LM的功能性語(yǔ)言能力、形式語(yǔ)言能力,以及是否可以記住任務(wù)。

為了評(píng)估LLMs能力的真實(shí)程度,研究人員精心設(shè)計(jì)了實(shí)驗(yàn)結(jié)構(gòu),盡可能減少誤導(dǎo)因素。

此外,該團(tuán)隊(duì)的實(shí)驗(yàn)設(shè)計(jì)特別注重不能觸發(fā)模型的上下文學(xué)習(xí)能力。比如,指令微調(diào)會(huì)將訓(xùn)練模型的指令轉(zhuǎn)化為示例(exemplar),這就可能導(dǎo)致上下文學(xué)習(xí)。

因此,實(shí)驗(yàn)團(tuán)隊(duì)使用了非指令微調(diào)的模型來(lái)避免這種可能。

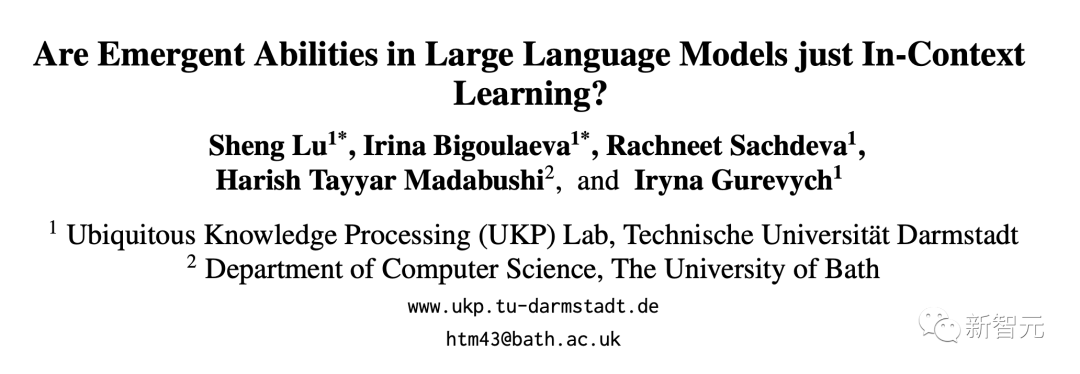

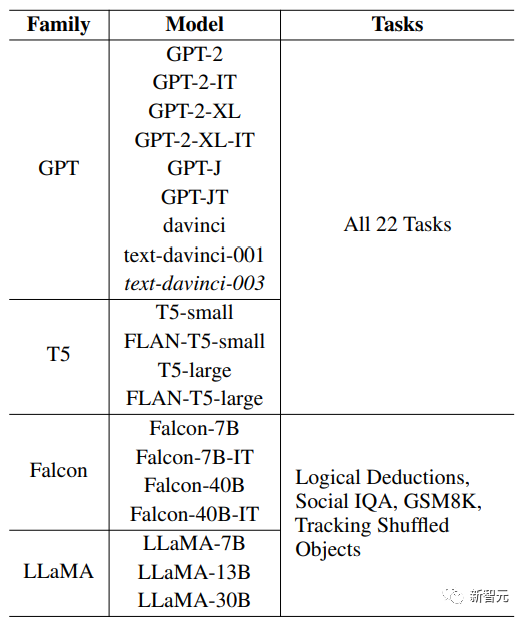

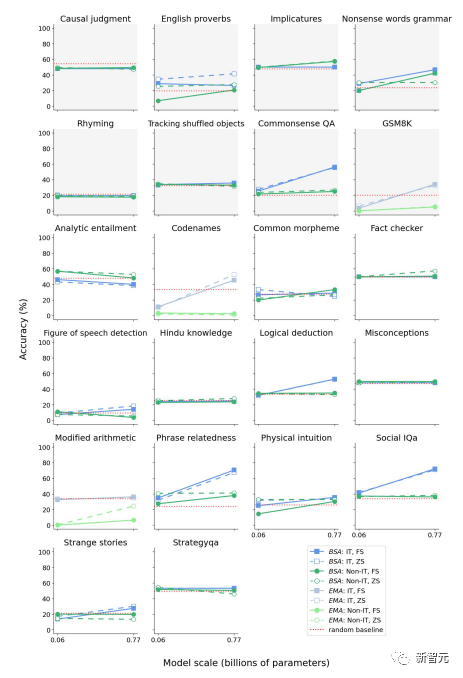

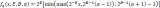

下圖是研究人員所選用的模型。

研究人員對(duì)來(lái)自四個(gè)模型系列的一些不同規(guī)模的模型進(jìn)行了評(píng)估,包括GPT、T5、Falcon和LLaMA。

之所以選擇這些模型,是因?yàn)镚PT和LLaMA之前就被發(fā)現(xiàn)有涌現(xiàn)能力,而Falcon處于LLM排行榜的前列。

研究人員還選擇了T5,因?yàn)樗且粋€(gè)編碼器——解碼器模型(encoder-decoder model),其指令微調(diào)版本(Flan)是使用大量指令微調(diào)數(shù)據(jù)集訓(xùn)練出來(lái)的。

而在GPT系列中,研究人員使用了GPT-2和GPT-3的指令微調(diào)和非指令微調(diào)版本;在T5系列中,研究人員使用了T5及其指令微調(diào)的對(duì)應(yīng)版本FLAN-T5。

同樣,研究人員使用了Falcon3的指令微調(diào)版本和非指令微調(diào)版本。至于LLaMA,由于它沒(méi)有經(jīng)過(guò)指令微調(diào),研究人員無(wú)法獲得該模型的指令微調(diào)版本。

此外,研究人員還評(píng)估了GPT-3 text-davinci-003,這是一個(gè)InstructGPT模型。InstructGPT模型最初是根據(jù)注釋者編寫(xiě)的prompt和相應(yīng)的預(yù)期行為進(jìn)行微調(diào)的,然后再使用該模型收集其它模型輸出的排序數(shù)據(jù)集,利用人類(lèi)反饋強(qiáng)化學(xué)習(xí)(RLHF)對(duì)其進(jìn)行進(jìn)一步微調(diào)。

事實(shí)證明,這種訓(xùn)練方法可以提高模型的性能。

其中,研究人員選的T5模型特意低于1B的參數(shù)量,因?yàn)樵谶@么小的模型中還沒(méi)有觀察到涌現(xiàn)能力,這在研究人員的實(shí)驗(yàn)中起到了關(guān)鍵的控制作用。

在研究人員選擇的模型中,GPT-3 davinci(非指令微調(diào))、GPT-3 textdavinci-001(指令微調(diào))和GPT-3 textdavinci-003(InstructGPT)都是以前觀察到過(guò)涌現(xiàn)能力的模型。這一選擇主要是出于模型可用性的考慮。

其它已證明具有涌現(xiàn)能力的模型系列包括PaLM、Chinchilla、Gopher和LaMDA,但由于沒(méi)有相應(yīng)的應(yīng)用程序接口,所以研究人員沒(méi)有對(duì)其進(jìn)行評(píng)估。

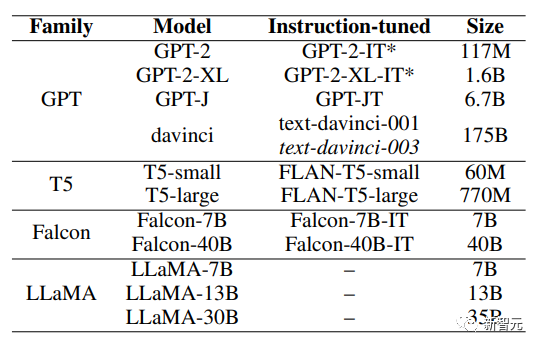

上圖為實(shí)驗(yàn)中使用的任務(wù)清單,以及這些任務(wù)在之前是否被識(shí)別為涌現(xiàn)的情況,并附有解決任務(wù)所需能力的性質(zhì)分類(lèi)。

這種分類(lèi)是通過(guò)人工檢查數(shù)據(jù),并采用Mahowald等人提供的分類(lèi)框架確定。研究人員評(píng)估了每個(gè)任務(wù)中50個(gè)示例的記憶情況,假定任務(wù)數(shù)據(jù)沒(méi)有泄露。

上表詳細(xì)列出了整體的實(shí)驗(yàn)設(shè)置,包括測(cè)試的不同模型、實(shí)驗(yàn)中使用的不同任務(wù)以及采用的評(píng)估設(shè)置。

鑒于團(tuán)隊(duì)的目標(biāo)是評(píng)估不受其他因素影響的LLM的涌現(xiàn)能力,研究人員對(duì)從T5和GPT系列中選出的12個(gè)模型中的每個(gè)模型在所有22個(gè)選定任務(wù)上進(jìn)行了評(píng)估。

對(duì)于每種情況,研究人員都采用了相同的prompt策略:封閉式和封閉式對(duì)抗。為考慮反應(yīng)的可變性,研究人員將每個(gè)實(shí)驗(yàn)進(jìn)行三次,計(jì)算平均結(jié)果。其中運(yùn)行的所有實(shí)驗(yàn)都是在英偉達(dá)A100 GPU上進(jìn)行的,溫度為0.01,批量大小為16。

對(duì)于GPT-3 175B參數(shù)模型(davinci、text-davinci-001 和 text-davinci003),團(tuán)隊(duì)使用官方的API進(jìn)行評(píng)估,只進(jìn)行一次,溫度為0。這是因?yàn)楸疚牡难芯咳藛T也將溫度設(shè)為了0,保證了結(jié)果的可重復(fù)性,并將出現(xiàn)幻覺(jué)的可能性降至最低。

此外,他們還從LLaMA和Falcon系列中選擇了六個(gè)模型,在前面選擇的22個(gè)任務(wù)中的4個(gè)上進(jìn)行了評(píng)估。

研究人員在選擇這4個(gè)任務(wù)時(shí),要確保其中兩個(gè)任務(wù)先前已被確定為突發(fā)任務(wù),另外兩個(gè)任務(wù)已被確定為非突發(fā)任務(wù)。之后,團(tuán)隊(duì)再次使用封閉式和對(duì)抗式的prompt策略對(duì)它們進(jìn)行了測(cè)試,并對(duì)每個(gè)實(shí)驗(yàn)運(yùn)行三次以考慮到可能存在的差異。

鑒于某些評(píng)估任務(wù)的相關(guān)選項(xiàng)數(shù)量不固定,研究人員通過(guò)多次隨機(jī)選擇該任務(wù)中的問(wèn)題選項(xiàng)并求得平均分,來(lái)構(gòu)建每項(xiàng)任務(wù)的基線。

實(shí)驗(yàn)結(jié)果

對(duì)于第一個(gè)研究問(wèn)題:?鑒于上下文學(xué)習(xí)對(duì)LLMs中涌現(xiàn)能力存在一定的潛在影響,在沒(méi)有上下文學(xué)習(xí)(包括指令微調(diào))的情況下,哪些能力是真正的涌現(xiàn)能力?

研究團(tuán)隊(duì)首先展示了在零樣本條件下未經(jīng)指令微調(diào)的175B參數(shù)的GPT-3模型的表現(xiàn)。

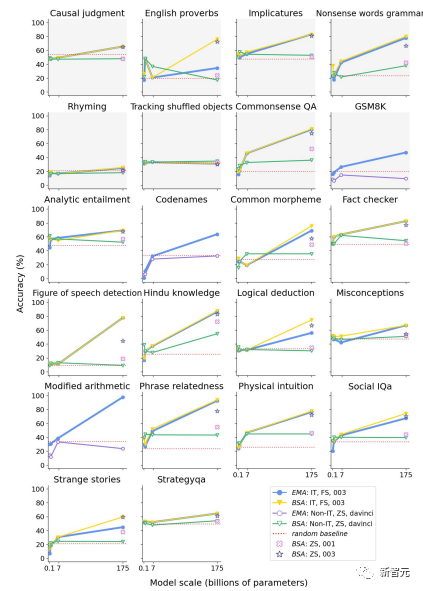

上圖是在封閉式prompt策略下,GPT系列模型在各種任務(wù)上的表現(xiàn)。

研究團(tuán)隊(duì)使用的是BERTScore精確度 (BSA) 和匹配精確度 (EMA),在少樣本 (FS)、零樣本 (ZS) 設(shè)置下對(duì)指令調(diào)整(IT)模型和非指令調(diào)整(non-IT)模型進(jìn)行了評(píng)估。

藍(lán)色表示指令微調(diào)模型在少樣本條件下的結(jié)果,與之前文獻(xiàn)報(bào)道的結(jié)果相當(dāng)。

黃色表示在相同設(shè)置下使用BSA測(cè)得的性能,紅色表示在非指令微調(diào)模型的零樣本條件下的BSA結(jié)果,換句話(huà)說(shuō),這種條件就代表著沒(méi)有上下文學(xué)習(xí)的影響下的結(jié)果。

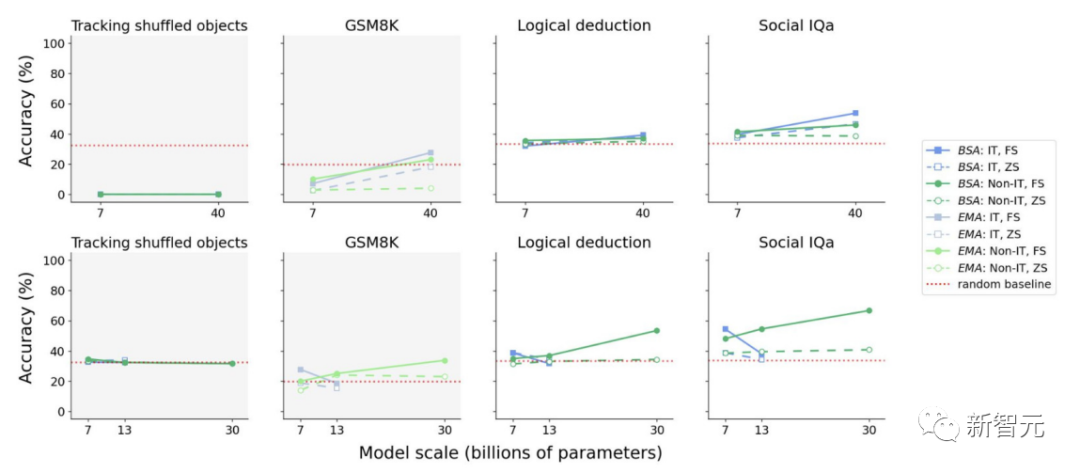

上圖為Falcon(上部)和LLaMA(下部)模型在非指令調(diào)整零樣本條件下對(duì)所選任務(wù)子集的性能表現(xiàn)示意圖,表明在沒(méi)有上下文學(xué)習(xí)的情況下,模型始終缺乏所謂的涌現(xiàn)能力。

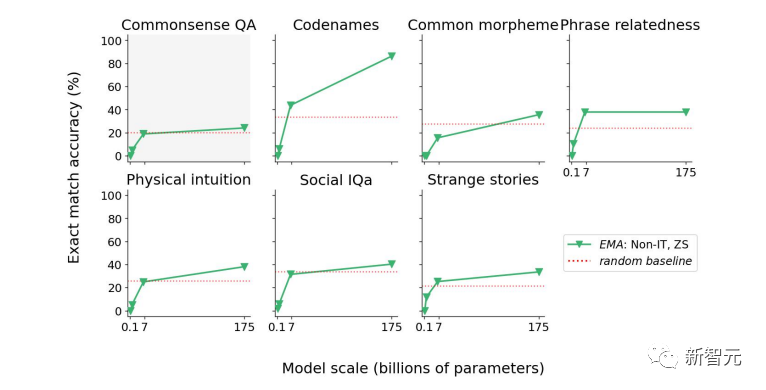

上圖為非指令微調(diào)的GPT模型在對(duì)抗環(huán)境下的表現(xiàn),在這些任務(wù)子集上,GPT的表現(xiàn)高于隨機(jī)基線。在一些任務(wù)上的表現(xiàn)是可預(yù)測(cè)的,因此不算是涌現(xiàn)能力。

在其余任務(wù)中,與隨機(jī)基線相比,成績(jī)的提高幅度相對(duì)較小。

而針對(duì)第二個(gè)問(wèn)題:經(jīng)過(guò)指令微調(diào)的模型是否表現(xiàn)出了推理能力,還是說(shuō)指令微整更有可能使這些模型更有效、更高效地進(jìn)行上下文學(xué)習(xí)?

需要注意的是,指令微調(diào)的本質(zhì)是在指令和范例之間建立映射關(guān)系,而這正是上下文學(xué)習(xí)的特征,因此這一過(guò)程很可能確實(shí)觸發(fā)了上下文學(xué)習(xí)。

研究人員的假設(shè)意味著,指令微調(diào)為L(zhǎng)LMs提供了將指令轉(zhuǎn)化為范例的能力,而范例隨后又調(diào)動(dòng)了它們的上下文學(xué)習(xí)能力。

下圖是T5系列模型在不同環(huán)境下的性能表現(xiàn)。

審核編輯:黃飛

?

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論