作者:Xnhyacinth

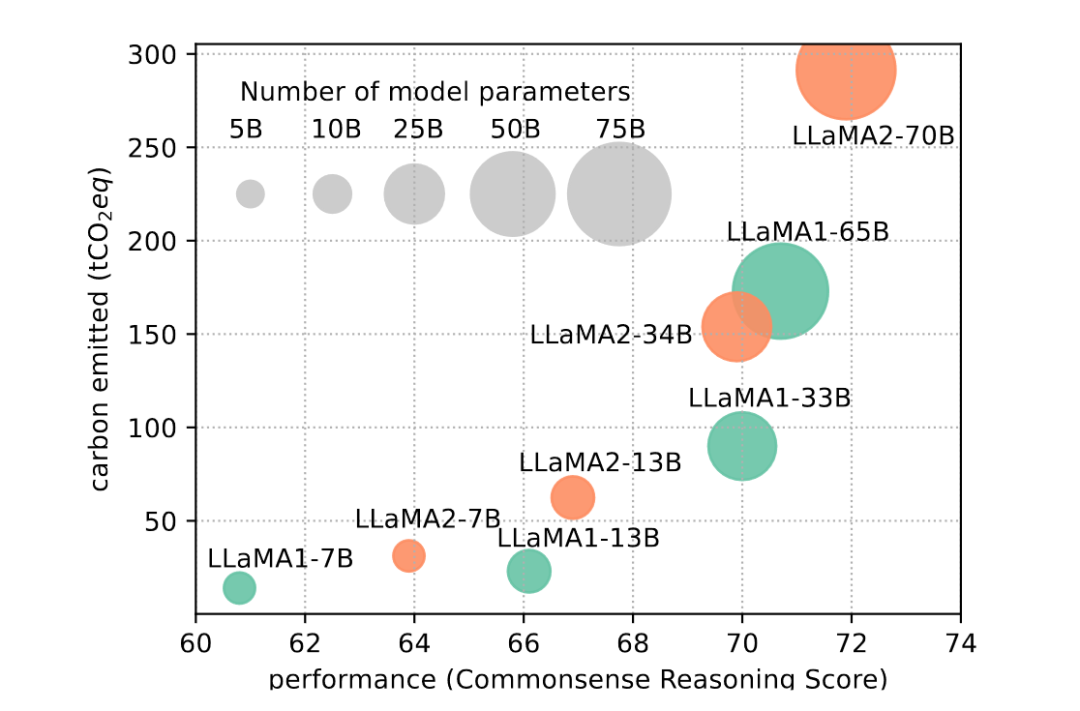

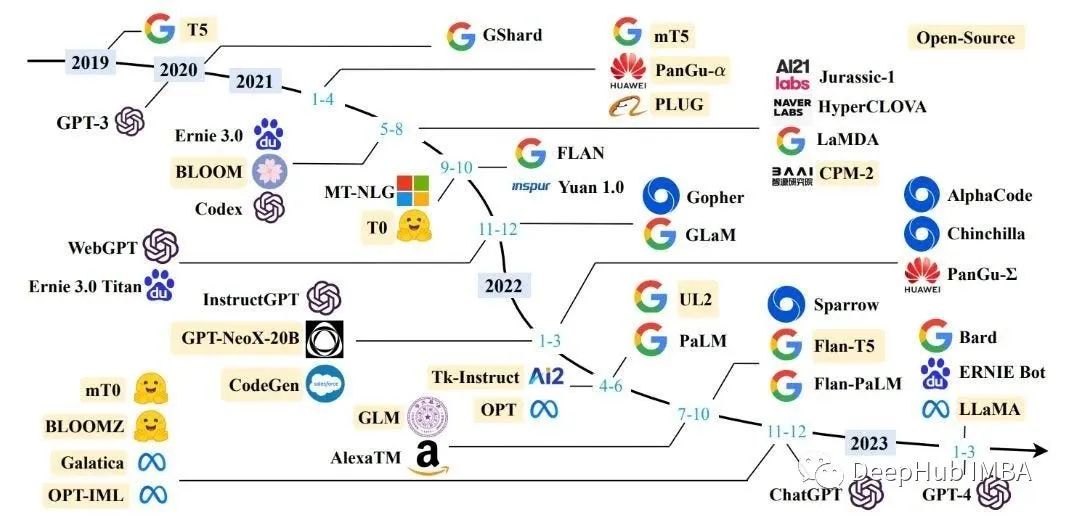

近年來,大型語言模型(LLMs)在自然語言處理領域取得了顯著的進展,如GPT-series(GPT-3, GPT-4)、Google-series(Gemini, PaLM), Meta-series(LLAMA1&2), BLOOM, GLM等模型在各種任務中展現出驚人的能力。然而,隨著模型規模的不斷增大和參數數量的劇增,這些模型的成功往往伴隨著巨大的計算和存儲資源消耗,給其訓練和推理帶來了巨大挑戰,也在很大程度上限制了它們的廣泛應用。因此,研究如何提高LLMs的效率和資源利用,使其在保持高性能的同時降低資源需求,成為了當前領域的熱點問題。

今天這篇工作是一篇survey,旨在全面調查和總結提高LLMs效率的最新研究進展。工作首先概述了LLMs面臨的挑戰,隨著模型規模的增大,傳統的訓練方法難以適應龐大的模型參數和計算資源需求。接下來,詳細介紹了從模型為中心、數據為中心和框架為中心三個角度出發的一系列高效技術。這些技術涵蓋了量化、參數修剪、低秩逼近、知識蒸餾等模型壓縮方法,推理加速、混合專家訓練等高效結構以及數據選擇、提示工程等數據為中心策略。最后,討論了支持高效訓練和推理的LLM框架,為實際應用提供了有力支持。

該工作的目的是為研究人員和從業者提供一個關于高效LLMs技術的全面了解,以期激發更多關于這一重要領域的研究和創新。在這個信息爆炸的時代,提高LLMs的效率對于推動自然語言處理技術的發展具有重大意義,同時也將為人工智能的廣泛應用奠定堅實基礎。接下來就讓我們一起探索高效的大型語言模型!

下面將從以模型為中心,包括模型壓縮,高效預訓練,高效微調,高效推理,高效結構設計五個部分;以數據為中心,包括數據選擇,提示工程兩個部分;以框架為中心介紹該篇工作。

模型為中心

模型壓縮

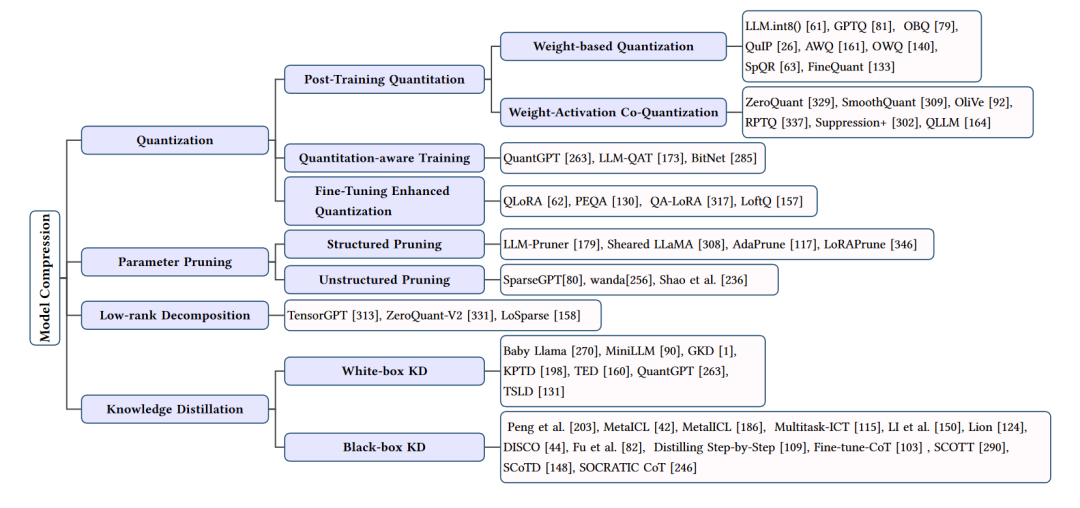

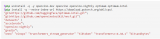

模型壓縮方法的總結

模型壓縮部分主要關注于減少大型語言模型(LLMs)的計算和存儲需求,同時盡量保持其性能。這部分的技術主要包括量化、參數修剪、低秩逼近和知識蒸餾等方法。下面我們將詳細介紹這些技術。

量化

量化是一種通過減少模型權重和激活的位寬來壓縮模型的技術。常見的量化方法包括權重量化、激活量化和權重-激活共量化。量化可以降低計算和存儲需求,但可能會帶來一定的性能損失。為了解決這個問題,研究者們提出了多種量化技術,如動態范圍量化(DRQ)、知識蒸餾量化(KDQ)等,它們在保持模型性能的同時實現了高效的壓縮。

參數修剪

參數修剪是一種通過移除模型中不重要的參數來減小模型大小的方法。參數修剪可以分為結構化修剪和非結構化修剪。結構化修剪關注于移除模型中的整個子結構,如行、列或子塊;非結構化修剪則關注于移除單個參數。參數修剪可以在一定程度上降低模型復雜度,但過度修剪可能導致性能下降。為了解決這個問題,研究者們提出了一些策略,如基于敏感度的修剪、低秩分解修剪等,以實現性能和壓縮之間的平衡。

低秩逼近

低秩逼近通過將模型權重矩陣近似表示為低秩矩陣來減小模型大小。這種方法可以顯著降低模型的計算和存儲需求。常見的低秩逼近技術包括矩陣分解、核方法和秩限制等。為了保持模型性能,研究者們還提出了一些優化策略,如迭代訓練、低秩補償等。

知識蒸餾

知識蒸餾是一種通過訓練一個較小的學生模型來模仿大型教師模型的行為,從而實現模型壓縮的方法。知識蒸餾可以分為白盒知識蒸餾和黑盒知識蒸餾。白盒知識蒸餾利用教師模型的內部信息進行訓練,而黑盒知識蒸餾僅依賴于教師模型的輸入輸出。為了提高蒸餾效果,研究者們提出了一些改進策略,如多任務學習、多階段訓練等。

模型壓縮技術通過各種方法降低大型語言模型的計算和存儲需求,使其在實際應用中更具可行性。然而,這些技術在壓縮模型的同時也需要權衡性能損失。未來的研究將繼續探索更高效、更精確的模型壓縮方法,以實現性能與壓縮之間的最佳平衡。

高效預訓練

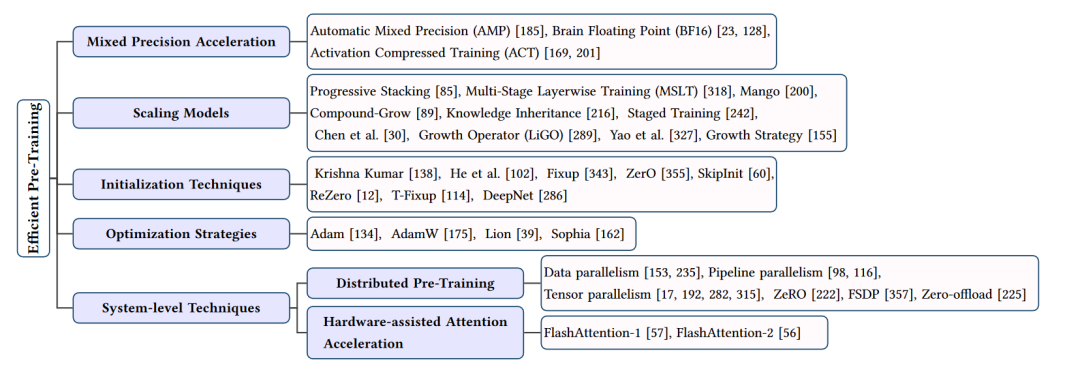

高效預訓練技術的總結

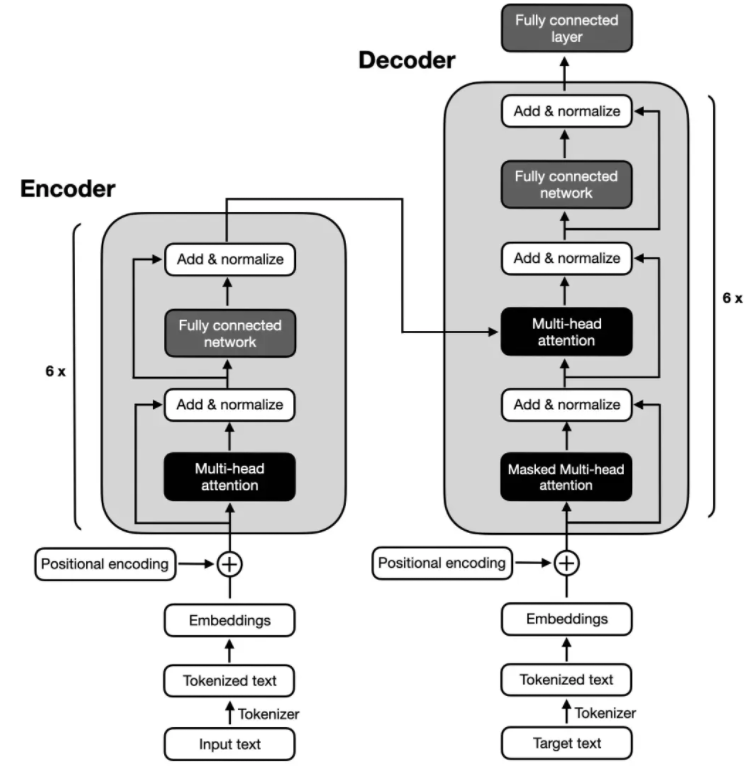

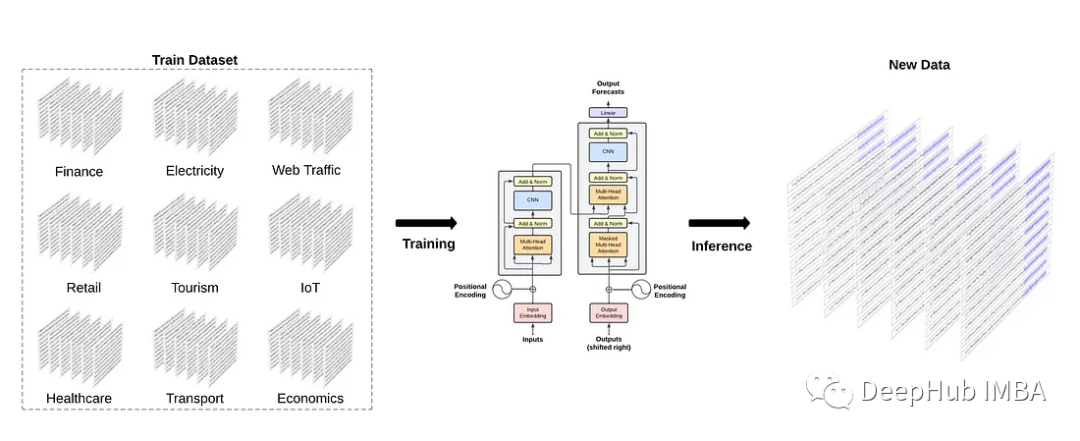

在大型語言模型(LLMs)的研究中,預訓練是一個至關重要的步驟,它為模型提供了豐富的知識和表示能力。然而,預訓練過程通常需要大量的計算資源和時間,這對于許多研究者和從業者來說是一個巨大的挑戰。因此,研究者們提出了許多高效預訓練技術,以降低預訓練的成本和復雜性。下面將從四個方面介紹這些技術:混合精度加速、模型縮放、初始化技術和優化策略。

混合精度加速

混合精度加速是一種利用低精度數據類型(如16位或32位浮點數)進行計算,同時保持模型的高性能的方法。這種技術通過減少數據類型的位寬來降低計算和存儲需求,從而提高預訓練效率。常見的混合精度加速方法包括自動混合精度(AMP)、BF16等。這些方法在保持模型性能的同時,顯著降低了預訓練過程中的計算和內存開銷。

模型縮放

模型縮放技術通過利用較小模型的信息來指導較大模型的預訓練,從而提高預訓練效率。這些方法包括漸進式堆疊、多階段層訓練(MSLT)、復合增長等。它們通過在預訓練過程中逐步增加模型的規模、深度和寬度,實現了更快的收斂速度和更高的性能。此外,一些研究還利用知識繼承等技術,通過教師模型的知識來加速學生模型的預訓練。

初始化技術

合適的初始化方法對于預訓練過程的收斂速度和模型性能至關重要。一些研究者提出了特定的初始化技術,如函數保留初始化(FPI)和高級知識初始化(AKI),以提高大型模型預訓練的效率。這些方法通過在預訓練初期為大型模型提供良好的初始狀態,有助于加快收斂速度并提高最終性能。

優化策略

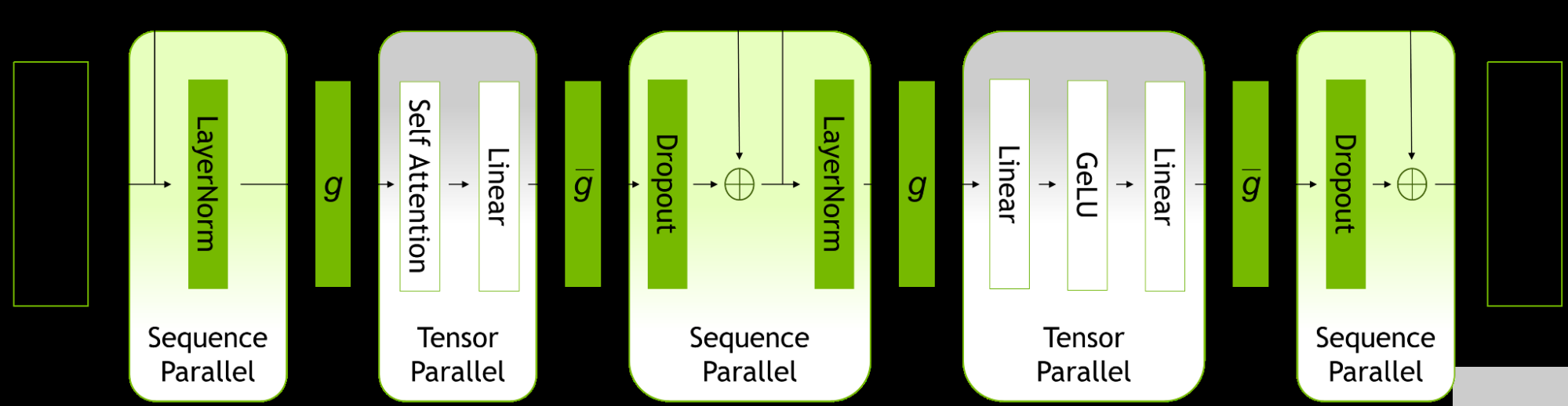

優化策略在預訓練過程中起到了關鍵作用。一些研究者提出了新的優化器,如Lion和Sophia,以提高預訓練效率。這些優化器通過調整學習率、動量等超參數,以及引入第二階信息,實現了更快的收斂速度和更高的內存利用率。此外,一些研究還探討了分布式預訓練技術,如數據并行、流水線并行和張量并行等,以利用多設備并行計算來加速預訓練過程。

高效預訓練技術通過混合精度加速、模型縮放、初始化技術和優化策略等方法,顯著降低了大型語言模型預訓練過程中的計算和時間成本。這些技術為LLMs的研究和應用提供了有力支持,有助于推動自然語言處理領域的發展。然而,這些技術仍然存在一定的局限性,未來的研究應該繼續探索更高效、更實用的預訓練方法。

高效微調

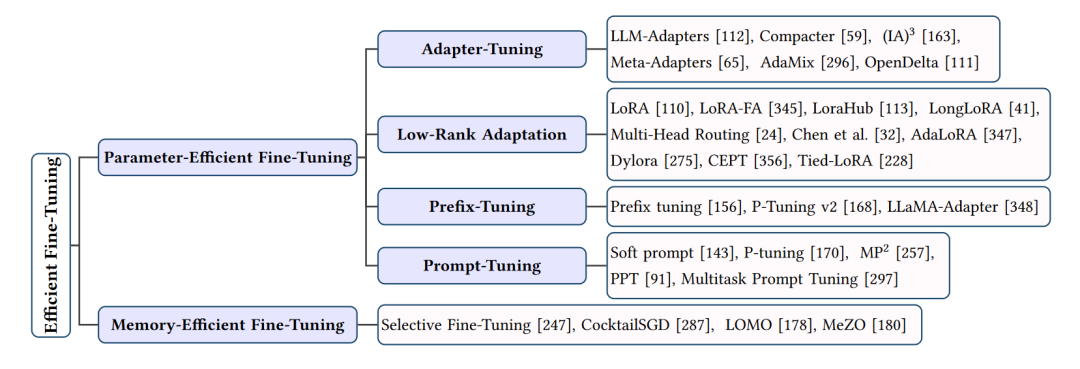

高效微調方法的總結

在大型語言模型(LLMs)的應用中,微調是一個關鍵步驟,它使模型能夠適應特定的任務和領域。然而,微調過程可能會消耗大量計算資源和時間。為了提高微調效率,研究者們提出了許多高效微調方法。接下來將從兩個方面介紹這些技術:參數高效微調和內存高效微調。

參數高效微調

參數高效微調方法旨在通過減少模型參數的更新來提高微調效率。這些方法主要包括適配器調優、低秩適應和前綴調優等。

1.1 適配器調優(Adapter-Tuning)

適配器調優是一種將適配器模塊集成到LLMs中的方法,這些適配器模塊可以在微調過程中更新,而模型的其他部分保持不變。適配器可以是串聯適配器,每個LLM層都添加一個適配器模塊;也可以是并聯適配器,每個適配器模塊與LLM層并行。適配器調優的典型技術包括LLM-Adapters、Compacter、(IA)3、Meta-Adapters等。

1.2 低秩適應(Low-Rank Adaptation)

低秩適應(LoRA)是一種通過引入兩個低秩矩陣來更新模型參數的方法。在微調過程中,原始模型參數保持不變,而是更新這兩個低秩矩陣。LoRA及其變體(如LoRA-FA、LongLoRA等)在保持較高性能的同時,顯著降低了微調過程中的計算和內存需求。

1.3 前綴調優(Prefix-Tuning)

前綴調優在LLMs的每一層添加一系列可訓練的前綴令牌,這些令牌針對特定任務進行定制。前綴調優的典型技術包括Prefix Tuning、P-Tuning v2和LLaMA-Adapter。通過使用前綴令牌,這些方法可以在微調過程中實現參數效率和性能提升。

內存高效微調

內存高效微調方法關注于降低微調過程中的內存消耗。這些方法主要包括選擇性微調和分階段微調等。

2.1 選擇性微調

選擇性微調通過僅更新模型的部分中間激活來降低內存需求。典型的選擇性微調技術包括Selective Fine-Tuning、CocktailSGD和LOMO。這些方法在保持較高性能的同時,顯著降低了微調過程中的內存消耗。

2.2 分階段微調

分階段微調將微調過程分為多個階段,每個階段僅更新部分模型參數。這種方法可以降低內存需求,同時保持模型性能。典型的分階段微調技術包括Staged Training和MeZO。

高效微調方法通過參數高效微調和內存高效微調等技術,顯著降低了大型語言模型在微調過程中的計算、時間和內存成本。

高效推理

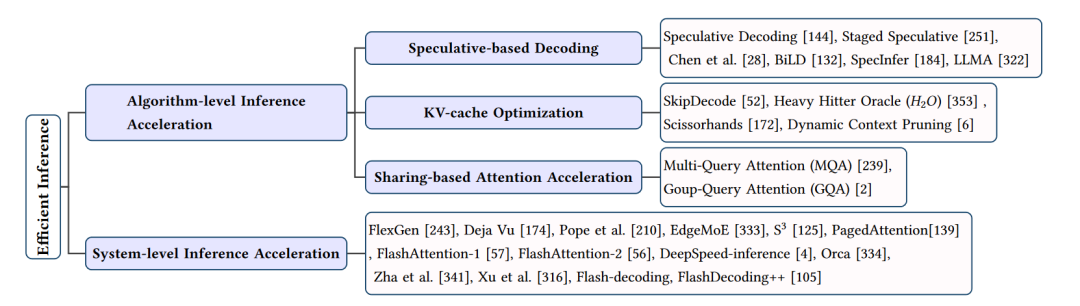

高效推理技巧的總結

在大型語言模型(LLMs)的應用中,高效的推理技巧對于實現實時響應和降低計算成本至關重要。接下來將從算法層面和系統層面兩個方面介紹高效推理技巧。

一、算法層面的高效推理技巧

投機解碼

投機解碼(Speculative Decoding)是一種在解碼過程中采用多個候選模型并行計算的技術。通過使用較小的草稿模型創建投機前綴,然后評估這些前綴與大型目標模型的初步輸出,可以加速解碼過程。典型的投機解碼方法包括Chen等人提出的快速自回歸模型(Faster Autoregressive Model) 和BiLD,它們分別采用不同的策略來提高投機解碼的性能。

KV-Cache優化

KV-Cache優化旨在減少LLMs推理過程中Key-Value(KV)緩存的計算和存儲開銷。一些方法如SkipDecode和Heavy Hitter Oracle(A^2A)通過跳過較低層和中間層的計算來加速推理過程。而Dynamic Context Pruning和Scissorhands則利用可學習機制來識別和移除非信息性的KV-Cache tokens,從而提高計算效率和模型可解釋性。

分享式注意力加速

分享式注意力加速通過不同KV頭共享方案來加速注意力計算。例如,多查詢注意力(MQA)和分組查詢注意力(GQA) 分別共享一組KV或多個KV頭的線性變換,從而減少計算復雜度。這些方法在保持較高性能的同時,顯著降低了計算和內存需求。

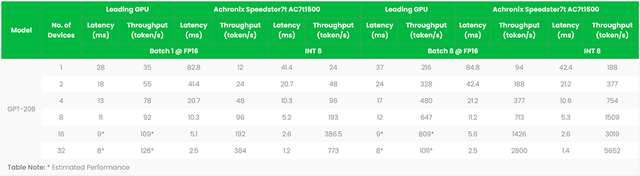

二、系統層面的高效推理技巧

FlexGen

FlexGen是一個針對內存受限GPU的高吞吐量推理引擎。通過集成CPU、GPU和磁盤的計算資源,以及采用線性編程搜索策略來管理硬件組件,FlexGen能夠在有限的硬件資源下實現高效的LLM推理。

Deja Vu

Deja Vu定義了一種上下文稀疏性概念,并利用預測器預測這種稀疏性。通過使用內核融合、內存合并等技術,Deja Vu能夠在推理過程中實現高效的計算和內存優化。

EdgeMoE

EdgeMoE是一種針對LLMs的設備端處理系統,基于Mixture-of-Experts(MoE)結構進行內存和計算管理。通過將模型劃分為不同部分并分配到不同存儲級別,EdgeMoE能夠在推理過程中實現高效的資源利用。

S3

S3系統通過預測輸出序列的長度并根據預測結果規劃生成請求,以優化設備資源的使用。同時,S3能夠處理任何不正確的預測,實現高效的推理過程。

PagedAttention

PagedAttention受到傳統虛擬內存和分頁方法的啟發,為LLMs設計了一個允許在請求之間高效共享KV-Cache的系統。這種方法有助于降低內存消耗并加速高吞吐量推理。

FlashAttention

FlashAttention通過融合矩陣乘法和softmax操作,以及采用張量核心自動調整和調度策略,實現高效的注意力計算。FlashAttention-1和FlashAttention-2分別針對不同硬件平臺進行了優化,以實現更快速的推理過程。

高效結構

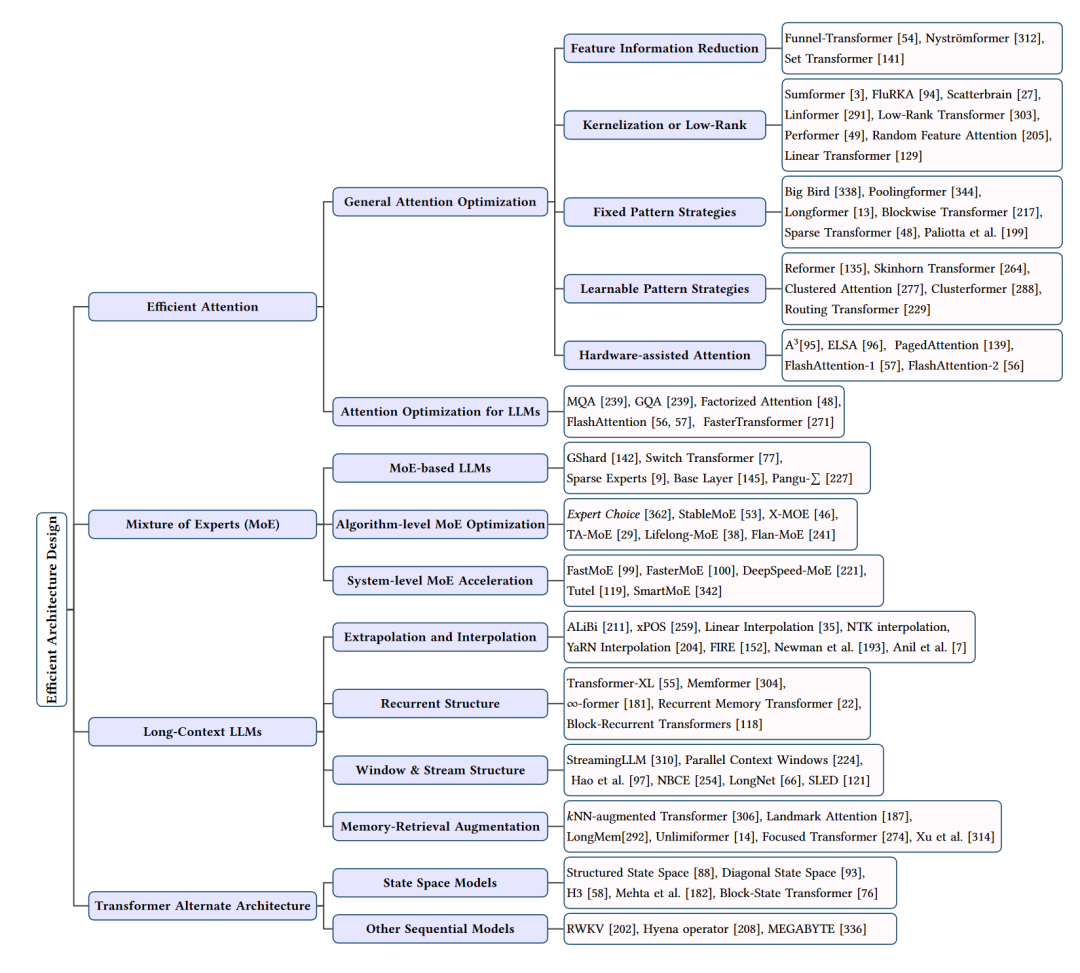

高效架構設計總結

在大型語言模型(LLMs)的研究中,高效的結構設計對于提高模型性能和降低計算成本具有重要意義。接下來將從四個方面介紹高效結構設計:注意力優化、混合專家(Mixture of Experts, MoE)模型、長上下文LLMs和Transformer替代結構。

注意力優化

注意力優化主要關注于降低自注意力機制的計算復雜度。這些方法包括:

特征信息縮減:通過減少序列中的特征信息,如Funnel-Transformer、Nystr?mformer和Set Transformer等,降低計算需求。

核化或低秩:利用低秩表示或注意力核化技術,如Sumformer、FluRKA、Scatterbrain等,提高計算效率。

固定模式策略:通過局部窗口或固定步長塊模式,如Paliotta等人的方法、Big Bird、Poolingformer等,實現注意力矩陣的稀疏化。

可學習模式策略:通過學習序列的組織方式,如Reformer、Skinhorn Transformer、Clustered Attention等,實現更高效的注意力計算。

硬件輔助注意力:通過定制硬件實現,如A3、ELSA、PagedAttention等,進一步提高注意力計算的效率。

混合專家(Mixture of Experts, MoE)模型

MoE模型將任務劃分為多個子任務,并為每個子任務訓練一個專家模型。這些專家模型共同為輸入生成輸出。MoE模型可以有效地管理大量參數,降低計算和內存需求。典型的MoE模型包括GShard、Switch Transformer、Sparse Experts等。此外,還有一系列算法層面和系統層面的MoE優化技術,如Expert Choice、StableMoE、FastMoE等。

長上下文LLMs

長上下文LLMs關注于處理長序列輸入。為解決這個問題,研究者們提出了一系列方法,如:

外推和插值:通過優化位置嵌入,實現對更長序列的泛化,如ALiBi、xPOS等。

循環結構:通過引入記憶單元和循環機制,實現長序列建模,如∞-former、Recurrent Memory Transformer等。

窗口和流結構:通過設計新的窗口機制和流式處理,降低固定窗口的限制,如StreamingLLM、Parallel Context Windows等。

記憶檢索增強:利用最近鄰查找和內存增強技術,實現長序列的高效處理,如NN-Augmented Transformer、Landmark Attention等。

Transformer替代結構

除了優化現有的Transformer結構,研究者們還提出了一些替代結構,如:

狀態空間模型:通過將注意力機制替換為狀態空間模型,實現近線性的計算復雜度,如Structured State Space(S4)、Diagonal State Space(DSS)等。

其他序列模型:結合循環神經網絡和Transformer的優點,如RWKV、Hyena Operator等,實現高效的長序列處理。

以數據為中心

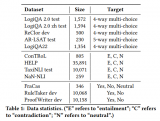

數據選擇

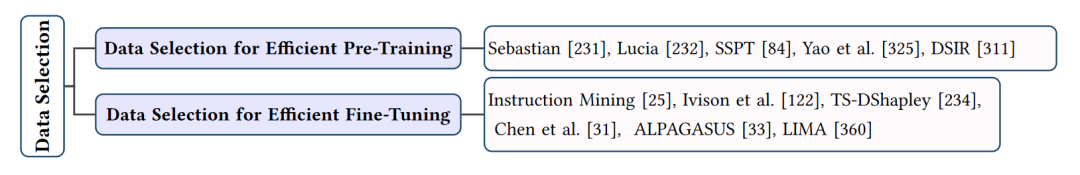

數據選擇技巧的總結

在大型語言模型(LLMs)的研究和應用中,數據選擇對于提高模型性能和效率具有重要意義。合適的數據選擇可以降低訓練成本、提高泛化能力,并使模型更適應特定任務。加下來將從兩個方面介紹數據選擇技巧:高效預訓練數據選擇和高效微調數據選擇。

高效預訓練數據選擇

預訓練數據的選擇對LLMs的性能至關重要。高質量的預訓練數據可以幫助模型學習通用的知識表示,從而提高在各種任務上的表現。高效預訓練數據選擇技巧包括:

數據清洗:通過去除無關、重復或低質量的數據,降低噪聲對模型學習的影響。

數據平衡:確保數據集中各類樣本的比例均衡,避免模型在某些類別上過擬合。

數據增強:通過對原始數據進行擴充,如同義詞替換、句子重組等,增加模型的泛化能力。

領域自適應:選擇與目標任務相關的數據,使預訓練模型更適應特定領域的任務。

高效微調數據選擇

微調數據選擇關注于為特定任務選取合適的訓練數據。高效的微調數據選擇可以降低微調成本,提高模型在目標任務上的性能。高效微調數據選擇技巧包括:

任務相關性:選擇與目標任務緊密相關的數據,以便模型能快速學習任務特定的知識。

數據篩選:通過評估數據與目標任務的相似性,篩選出最具代表性和價值的樣本。

在線學習:利用在線學習策略,根據模型在驗證集上的表現動態調整微調數據。

少樣本學習:通過元學習、遷移學習等技術,利用少量標注數據實現高效的微調。

其他數據選擇技巧

除了預訓練和微調階段的數據選擇,還有一些其他技巧可以提高LLMs的效率:

示范選擇:通過選擇與目標任務相似的示范數據,引導模型更快地學習任務。

示范組織:合理組織示范數據,使其更符合模型的學習規律,提高學習效果。

模板格式化:設計合適的輸入模板,以便模型能更好地理解任務需求。

提示工程

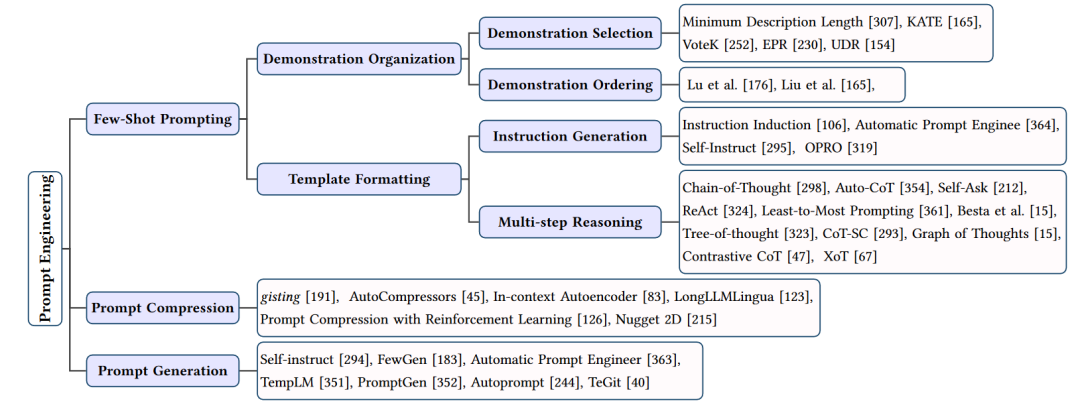

提示工程的總結

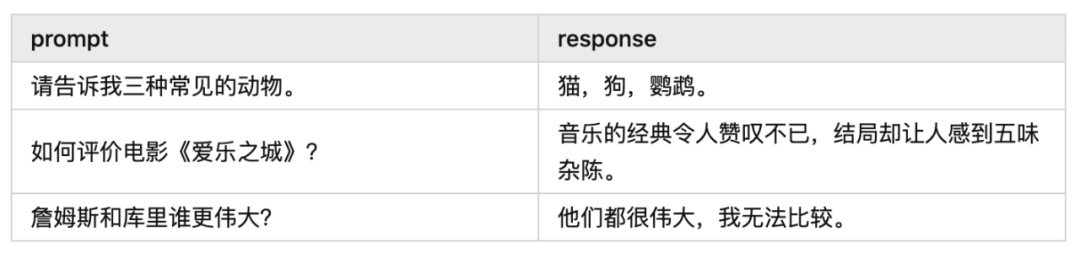

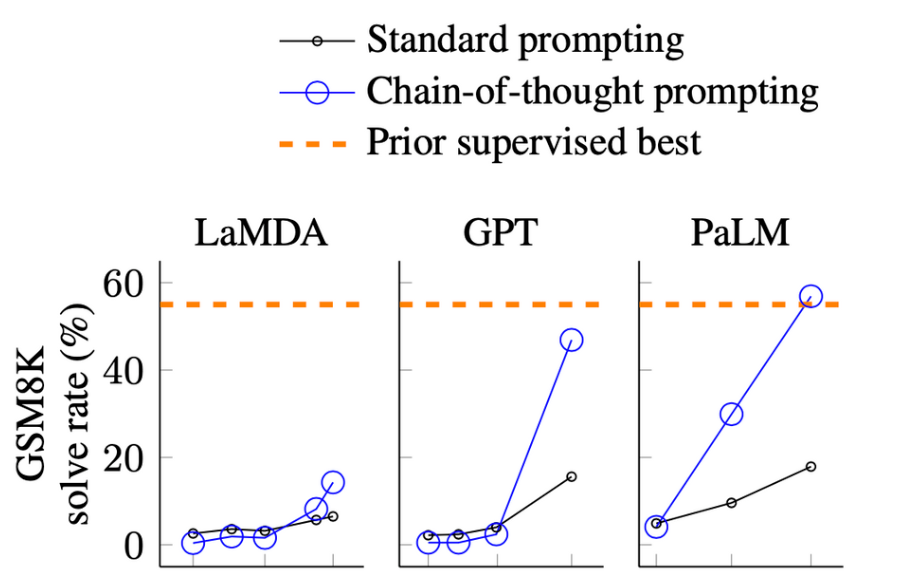

在大型語言模型(LLMs)的應用中,提示工程(Prompt Engineering)是一種關鍵技術,用于引導模型生成特定輸出或執行特定任務。通過精心設計的提示,可以顯著提高LLMs的性能和適用性。本文將介紹提示工程的主要方法和技巧,包括少樣本提示、提示壓縮和提示生成。

少樣本提示

少樣本提示是一種使用有限的示例來引導LLMs執行特定任務的方法。這些示例被稱為“示范”(Demonstrations)。少樣本提示技術主要包括:

示范選擇:從訓練數據中挑選與目標任務最相關的示例。這些示例應該具有代表性,以便模型能夠從中學習到任務的關鍵特征。

示范組織:合理地組織示范,以便模型能夠更好地理解任務。這可能包括調整示范的順序、分組或格式化。

模板格式化:設計一個合適的輸入模板,以便模型能夠清楚地理解任務需求。模板應該簡潔明了,同時包含足夠的信息來引導模型生成正確輸出。

提示壓縮

提示壓縮旨在通過壓縮提示輸入來降低LLMs的計算和存儲需求。主要方法包括:

概要:將長文本概要為較短的表示,如提取關鍵信息或使用句子級別的概要。

壓縮向量:將提示轉換為緊湊的向量表示,如使用BERT等模型生成的句子嵌入。

結構化提示:設計結構化的提示格式,以便模型能夠更高效地處理輸入。這可能包括使用特定的語法規則或標記。

提示生成

提示生成旨在自動創建有效提示,以引導LLMs執行特定任務,而無需人工標注數據。主要方法包括:

自我指導:讓LLMs根據自己的輸出生成提示,從而實現自我學習和優化。

強化學習:使用強化學習技術訓練LLMs生成高質量的提示。這通常涉及與環境(如用戶或其他LLMs)的交互,以便根據反饋優化提示。

生成模型:利用生成模型(如GPT系列)為特定任務創建提示。這些模型可以根據輸入的上下文生成合適的提示。

提示工程通過少樣本提示、提示壓縮和提示生成等技術,提高了LLMs的性能和適用性。這些方法使LLMs能夠在各種任務中更好地理解和執行用戶需求,同時降低了計算和存儲成本。然而,提示工程仍然面臨一些挑戰,如如何平衡提示的簡潔性和有效性,以及如何處理多樣化和復雜的任務需求。未來的研究將繼續探索更高效、更實用的提示工程技術。

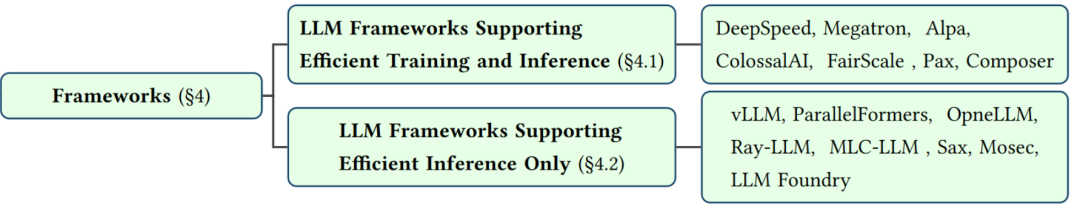

以框架為中心

在大型語言模型(LLMs)的研究和應用中,以框架為中心的方法關注于構建和優化支持LLMs的軟件框架。這些框架旨在簡化LLMs的開發、訓練和部署過程,提高計算資源的利用率,并支持各種高效算法和技術。接下來將介紹幾個主要的以框架為中心的LLM框架,以及它們的特點和優勢。

DeepSpeed

DeepSpeed是由微軟開發的一個集成框架,用于訓練和部署LLMs。它提供了諸如數據并行、模型并行、流水線并行、提示批處理、量化和內核優化等功能。DeepSpeed Inference模塊是其關鍵組件之一,其中的ZeRO-Inference技術可以解決GPU內存約束問題。DeepSpeed還支持混合精度訓練、梯度累積、動態并行和分布式訓練等技術,以提高訓練效率。

Megatron

Megatron是一個面向訓練和部署LLMs的框架,由NVIDIA和微軟共同開發。它支持數據并行、模型并行、流水線并行等技術,并提供了自動混合精度、選擇性激活重計算等優化方法。Megatron的核心技術是戰略性地分解模型張量操作,將它們分布式到多個GPU上,以提高處理速度和內存利用率。Megatron還支持BERT、GPT和T5等模型。

Alpa

Alpa是一個用于訓練和部署大型神經網絡的庫,它通過自動并行化技術來解決LLMs的計算和內存挑戰。Alpa支持數據并行、模型并行、流水線并行等技術,并提供了自動調諧框架,以找到最佳的并行策略。Alpa還可以與流行的深度學習框架(如PyTorch和TensorFlow)無縫集成,簡化LLMs的開發和訓練過程。

ColossalAI

ColossalAI是一個面向大規模并行訓練的集成深度學習系統,支持LLMs的訓練和部署。它提供了數據并行、模型并行、流水線并行等技術,并采用了一種模塊化設計,以實現高效的算法和資源管理。ColossalAI還支持混合精度訓練、梯度累積、動態并行等優化方法,以提高訓練效率。此外,它還具有設備原生AI和用戶友好的工具,以降低AI模型開發的門檻。

Hugging Face Transformers

Hugging Face Transformers是一個流行的開源庫,提供了大量預訓練的LLMs,如GPT、BERT和T5等。它支持各種高效的推理技術,如令牌級并行、流水線并行和模型并行。Hugging Face Transformers庫簡化了LLMs的部署過程,使開發者能夠輕松地將這些模型集成到各種應用中。

以框架為中心的方法通過構建和優化支持LLMs的軟件框架,提高了LLMs的開發、訓練和部署效率。這些框架通常提供了一系列并行化技術、優化方法和易用的工具,以滿足不同場景和任務的需求。隨著LLMs領域的不斷發展,我們可以期待更多創新的框架和技術來支持這些模型的廣泛應用。

結語

本文綜述了大型語言模型(LLMs)的高效學習方法,主要包括模型壓縮、高效微調和推理、數據選擇、提示工程和框架優化等方面。這些技術旨在降低LLMs的計算和存儲需求,提高訓練和推理效率,同時保持或甚至提高模型性能。

模型壓縮部分涵蓋了量化、參數修剪、低秩逼近和知識蒸餾等方法,可以有效減小模型大小和計算復雜度。數據中心方法則關注數據選擇和提示工程,通過精選訓練數據和設計有效的輸入提示,降低訓練成本并提高模型泛化能力。提示工程通過設計合適的輸入提示,引導LLMs更專注于任務關鍵信息,從而提高推理效果。最后,框架優化部分介紹了支持LLMs的軟件框架,如DeepSpeed、Megatron和Alpa等,它們提供了并行計算、內存管理和優化技術,簡化了LLMs的開發和部署過程。

這些高效學習方法為LLMs的研究和應用提供了有力支持,使這些模型能夠在各種場景中發揮更大價值。然而,這些技術仍然面臨一些挑戰,如如何在壓縮和加速過程中保持模型性能,以及如何適應多樣化和復雜的任務需求。未來的研究將繼續探索更高效、更實用的技術,以推動LLMs領域的發展。

審核編輯:黃飛

?

電子發燒友App

電子發燒友App

評論