將模型稱為 “視覺語言” 模型是什么意思?一個結(jié)合了視覺和語言模態(tài)的模型?但這到底是什么意思呢?

2023-03-03 09:49:37 665

665

新階段,此次發(fā)布的一系列成果包括“悟道·天鷹”(Aquila)語言大模型系列、天秤(FlagEval)開源大模型評測體系與開放平臺、“悟道 · 視界”視覺大模型系列,以及一系列多模態(tài)模型成果。 ? 悟道3.0 全面開源意味著什么 ? 悟道·天鷹語言大模型是首

2023-06-14 00:06:00 1457

1457

、文本、圖像等單模態(tài)大模型研究和應(yīng)用的基礎(chǔ)上,向多模態(tài)大模型攻關(guān),并于2021年7月正式發(fā)布了全球首個千億參數(shù)多模態(tài)大模型紫東太初。 ? 2023年6月16日,中國科學(xué)院自動化研究所和武漢人工智能研究院發(fā)布紫東太初2.0。2023年8月,中科院

2023-12-08 00:09:00 1202

1202 有沒有開源的Labview(類似的圖形語言),而且跨平臺的???

2013-11-03 10:40:36

會議程如下:發(fā)布會將邀請來自業(yè)界的專家將分享 OSS Compass 綜述起源、社區(qū)概況、治理結(jié)構(gòu)、評估模型等,全面介紹 OSS Compass。南京大學(xué)教授學(xué)者將深入解讀項(xiàng)目模型依據(jù),剖析開源生態(tài)評估體系

2023-02-17 16:15:44

`蘋果公司在周一的發(fā)布會上低調(diào)曝光了他們研制的第一款機(jī)器人—— Liam。這款機(jī)器人,主要是用于 iPhone 手機(jī)的回收。這是具體怎么做到的的?`

2016-09-02 10:53:45

英國一家游戲網(wǎng)站PocketGamer今日放出一條令人為之一振的消息:蘋果正在準(zhǔn)備一場發(fā)布會,iPhone 5似乎要比預(yù)期提前到來。 PocketGamer聲稱,他們收到內(nèi)部消息,10月5日將會

2011-09-18 23:27:39

蘋果已經(jīng)在考慮如何向視障人士提供幫助,它將利用多種傳感器制作本地環(huán)境模型,然后利用觸覺反饋告訴用戶他們周圍存在哪些物體。

2020-08-03 07:14:49

蘋果每年都會在秋季發(fā)布新產(chǎn)品,不過蘋果以后可能會增加一個春季發(fā)布會。12月9日消息,據(jù)外媒報道,蘋果在明年3月舉行的發(fā)布會上將發(fā)布4英寸大小的iPhone 6c。此前一直流傳蘋果公司將回歸小屏?xí)r代

2015-12-12 16:24:23

LMS Virtual Lab 流固模態(tài)分析的主要步驟:1、設(shè)置材料、屬性、約束條件,進(jìn)行結(jié)構(gòu)有限元模態(tài)分析。注意:模態(tài)計算的頻率范圍不要太小,否則可能計算錯誤!2、對流體進(jìn)行模態(tài)分析3、建立結(jié)構(gòu)網(wǎng)格到流體網(wǎng)格的映射,再利用結(jié)構(gòu)模態(tài)和流體模態(tài)進(jìn)行流固耦合模態(tài)分析

2019-05-29 06:59:58

倒計時!就在明天!大咖打call 第二彈!OpenHarmony開源大師兄新品發(fā)布會,6月30日10:00重磅開啟。立即報名:OpenHarmony開源大師兄新品發(fā)布會

2022-06-29 13:59:54

用labview進(jìn)行模態(tài)分析,有很多問題,望高手指點(diǎn)一二力錘激勵信號+加速度傳感器信號,請問下,labview什么控件可以計算系統(tǒng)的模態(tài)還是說僅僅兩路信號是分析不了模態(tài)的。

2016-06-24 11:50:49

基于芯片的版圖數(shù)據(jù),準(zhǔn)確高效地仿真芯片的電磁輻射情況,為芯片的硅前電磁泄漏評估提供新的方法和手段。4、ALSO開源發(fā)布:基于多邏輯域的開源邏輯綜合工具儲著飛: 寧波大學(xué)發(fā)布摘要:邏輯優(yōu)化方法與邏輯函數(shù)

2022-08-15 14:11:17

器件模型&參數(shù)提取SIG組長,介紹了SIG總體情況,包括四個方面內(nèi)容:SIG研究方向介紹技術(shù)趨勢和相關(guān)業(yè)界產(chǎn)品開源目標(biāo)與計劃開源版本發(fā)布最后代表中國科學(xué)院微電子研究所,發(fā)布

2022-07-06 09:57:44

的不穩(wěn)定性及其對蘋果產(chǎn)品開發(fā)的影響,蘋果芯片發(fā)布的時間可能會改變。 在此次大會上,蘋果還準(zhǔn)備對iOS、iPadOS、tvOS和watchOS等其他操作系統(tǒng)進(jìn)行更新,同時推出改進(jìn)后的增強(qiáng)現(xiàn)實(shí)功能、與外部

2013-12-21 09:05:01

摘要:多模型目標(biāo)跟蹤算法由于其獨(dú)特的處理未知結(jié)構(gòu)和可變參數(shù)的優(yōu)點(diǎn),已成為當(dāng)前目標(biāo)跟蹤研究領(lǐng)域的一個重要方向。然而當(dāng)今的多模型目標(biāo)跟蹤方法大都停留在理論層面,因此在實(shí)際應(yīng)用層面上研究并設(shè)計多模型

2018-12-05 15:16:23

一些傳感器信號調(diào)節(jié)器用于處理多個傳感元件的輸出。這種處理過程通常由多模態(tài)、混合信號調(diào)節(jié)器完成,它可以同時處理數(shù)個傳感元件的輸出。本文對這類傳感器信號調(diào)節(jié)器中抗混淆濾波器的工作情況進(jìn)行詳細(xì)分析。

2020-04-21 06:59:01

本次分享,對一個簡單的模型進(jìn)行流固耦合的模態(tài)分析,有限元科技小編主要給大家演示如何使用Hypermesh與Nastran對流固耦合的結(jié)構(gòu)進(jìn)行模態(tài)分析,以及了解聲腔對結(jié)構(gòu)模態(tài)的影響。 深圳市

2020-07-07 17:15:39

自然語言處理——53 語言模型(數(shù)據(jù)平滑)

2020-04-16 11:11:25

,本文試圖采用有限元分析(FEA)與實(shí)驗(yàn)模態(tài)分析(EMA)相結(jié)合的預(yù)試驗(yàn)分析技術(shù)來進(jìn)行某航電設(shè)備PCB 組件(圖1 所示)的動態(tài)特性分析,并建立了該P(yáng)CB 組件的有限元動力學(xué)分析模型。 1 有限元模態(tài)

2018-09-13 16:40:12

AI視野·今日CS.CV 計算機(jī)視覺論文速覽transformer、新模型、視覺語言模型、多模態(tài)、clip、視角合成

2021-08-31 08:46:46

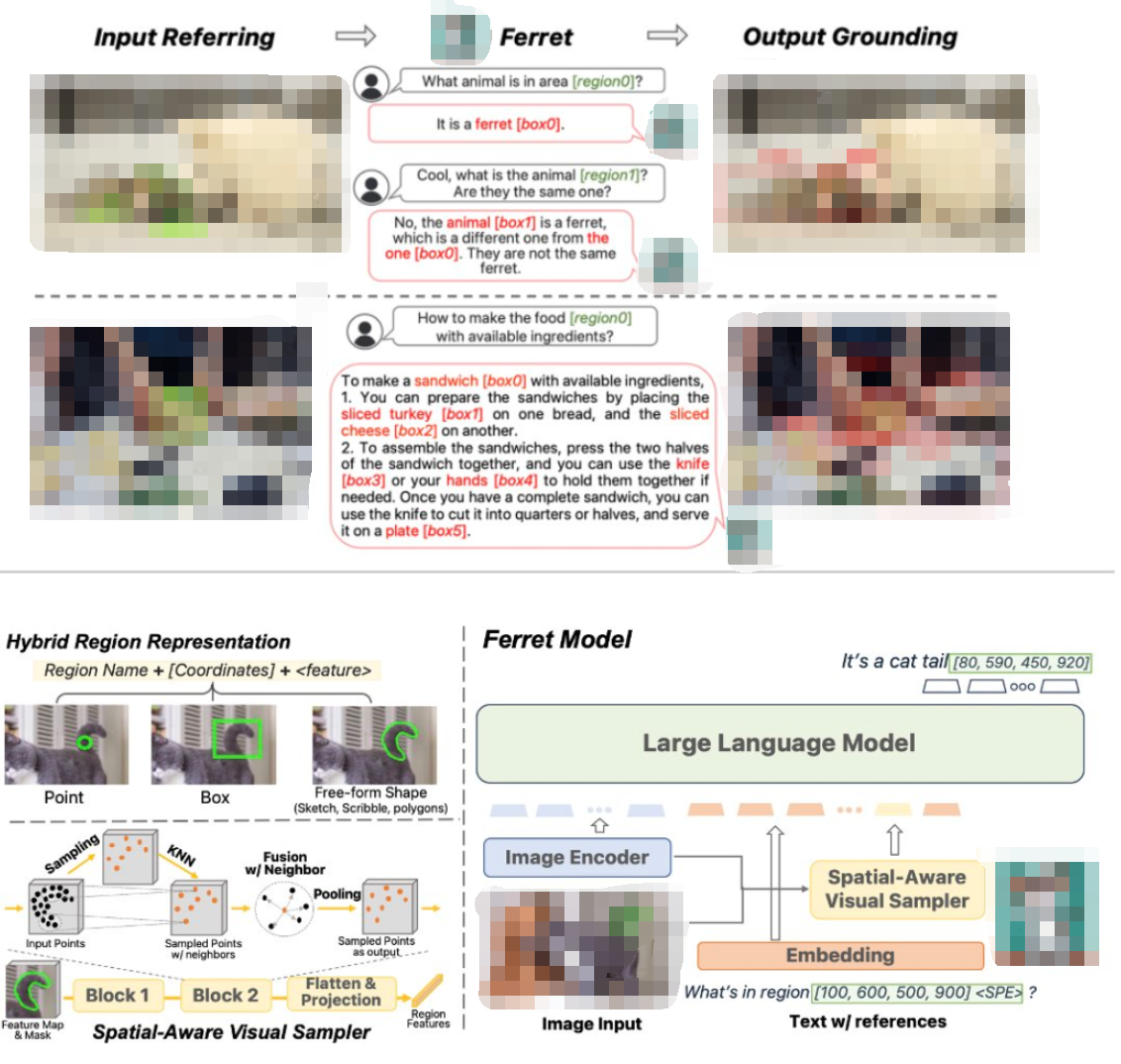

數(shù)字圖像處理原理是什么?簡單Ferret算法原理是什么?改進(jìn)的Ferret算法原理有哪些步驟?改進(jìn)的Ferret算法和目前常用的測量算法有哪些不同?

2021-04-15 06:58:37

在可公開可獲取DevEco Studio最新版本,Stage模型ArkTSAPI9開發(fā)元服務(wù)HarmonyOS4現(xiàn)不支持平板等;但是元服務(wù)在發(fā)布時是可選平板、智慧屏電視設(shè)備發(fā)布。

如果開發(fā)人員與上架

2024-02-21 10:22:10

利用有限元理論,對某承受動態(tài)載荷產(chǎn)品中的關(guān)鍵支撐件——支架建立了有限元模型,并進(jìn)行模態(tài)分析,計算了前六階模態(tài)參數(shù)(固有頻率和模態(tài)振型)。通過與試驗(yàn)模態(tài)分析的方法

2009-02-22 01:21:37 24

24 自然語言處理常用模型使用方法一、N元模型二、馬爾可夫模型以及隱馬爾可夫模型及目前常用的自然語言處理開源項(xiàng)目/開發(fā)包有哪些?

2017-12-28 15:42:30 5382

5382

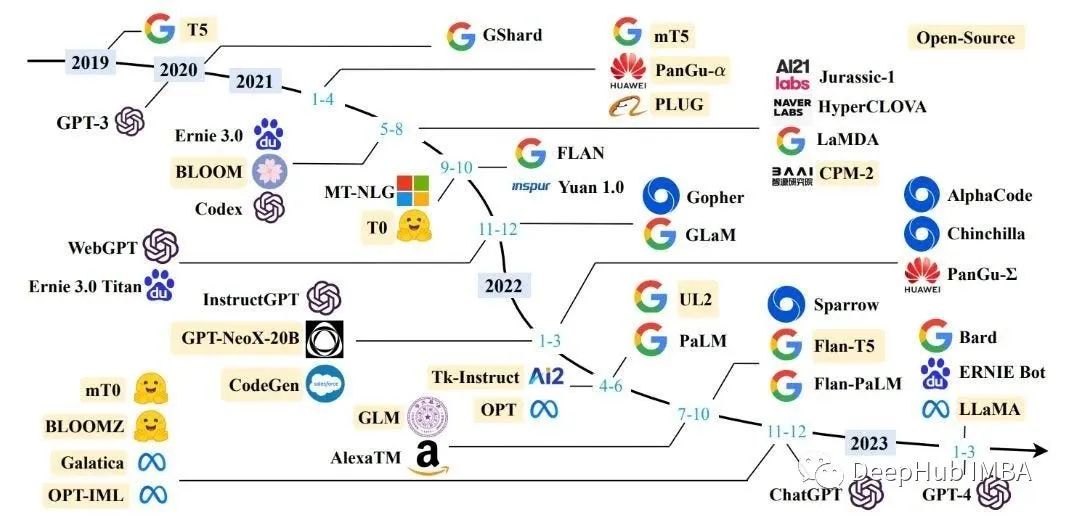

就在本周,OpenAI宣布,發(fā)布了7.74億參數(shù)GPT-2語言模型,15.58億的完整模型也有望于幾個月內(nèi)發(fā)布,并將GPT-2這6個月的進(jìn)展情況在博客上和大家做了介紹,本文將為大家梳理。

2019-09-01 09:10:44 2704

2704 同時,百度還研制了知識增強(qiáng)的跨模態(tài)深度語義理解方法,通過知識關(guān)聯(lián)跨模態(tài)信息,運(yùn)用語言描述不同模態(tài)信息的語義,進(jìn)而讓機(jī)器實(shí)現(xiàn)從看清到看懂、從聽清到聽懂,即圖像和語言、語音和語言的一體化理解。

2020-09-16 14:48:00 2005

2005 據(jù)外媒,知名機(jī)器學(xué)習(xí)公司OpenAI近日推出兩套多模態(tài)人工智能系統(tǒng)模型DALL-E和CLIP,DALL-E可以基于文本直接生成圖像,CLIP能夠完成圖像與文本類別的匹配。DALL-E可以將以自然語言

2021-01-07 11:13:55 2487

2487 隨著Transformer在視覺中的崛起,Transformer在多模態(tài)中應(yīng)用也是合情合理的事情,甚至以后可能會有更多的類似的paper。

2021-03-25 09:29:59 9836

9836

識別模型。在音頻模態(tài)中加人頻率注意力機(jī)制學(xué)習(xí)頻域上下文信息,利用多模態(tài)注意力機(jī)制將視頻特征與音頻特征進(jìn)行融合,依據(jù)改進(jìn)的損失函數(shù)對模態(tài)缺失問題進(jìn)行優(yōu)化,提高模型的魯棒性以及情感識別的性能。在公開數(shù)據(jù)集上的實(shí)

2021-04-01 11:20:51 8

8 化的問題,設(shè)計了模態(tài)間三元組損失及模態(tài)內(nèi)三元組損失,以配合全局三元組損失進(jìn)行模型訓(xùn)練。在改進(jìn)困難三元組損失的基礎(chǔ)上,首次在跨模態(tài)行人重識別模型中設(shè)計屬性特征來提高模型的特征提取能力。最后,針對跨模態(tài)行亼重

2021-05-10 11:06:14 9

9 模型中的幾個分支角度,簡述文本與圖像領(lǐng)域的多模態(tài)學(xué)習(xí)有關(guān)問題。 1. 引言 近年來,計算機(jī)視覺和自然語言處理方向均取得了很大進(jìn)展。而融合二者的多模態(tài)深度學(xué)習(xí)也越來越受到關(guān)注,在基于圖像和視頻的字幕生成、視覺問答(VQA)、

2021-08-26 16:29:52 6343

6343 、新加坡國立大學(xué) 鏈接:https://arxiv.org/pdf/2109.11797.pdf 提取摘要 預(yù)訓(xùn)練的視覺語言模型 (VL-PTMs) 在將自然語言融入圖像數(shù)據(jù)中顯示出有前景的能力,促進(jìn)

2021-10-09 15:10:42 2926

2926

來自:復(fù)旦DISC 引言 本次分享我們將介紹三篇來自ACL2021的跨視覺語言模態(tài)的論文。這三篇文章分別介紹了如何在圖像描述任務(wù)中生成契合用戶意圖的圖像描述、端對端的視覺語言預(yù)訓(xùn)練模型和如何生成包含

2021-10-13 10:48:27 2230

2230

BigCode 是一個開放的科學(xué)合作組織,致力于開發(fā)大型語言模型。近日他們開源了一個名為 SantaCoder 的語言模型,該模型擁有 11 億個參數(shù)

2023-01-17 14:29:53 692

692 PaLI 使用單獨(dú) “Image-and-text to text” 接口執(zhí)行很多圖像、語言以及 "圖像 + 語言" 任務(wù)。PaLI 的關(guān)鍵結(jié)構(gòu)之一是重復(fù)使用大型單模態(tài) backbone 進(jìn)行語言和視覺建模,以遷移現(xiàn)有能力并降低訓(xùn)練成本。

2023-01-29 11:25:57 665

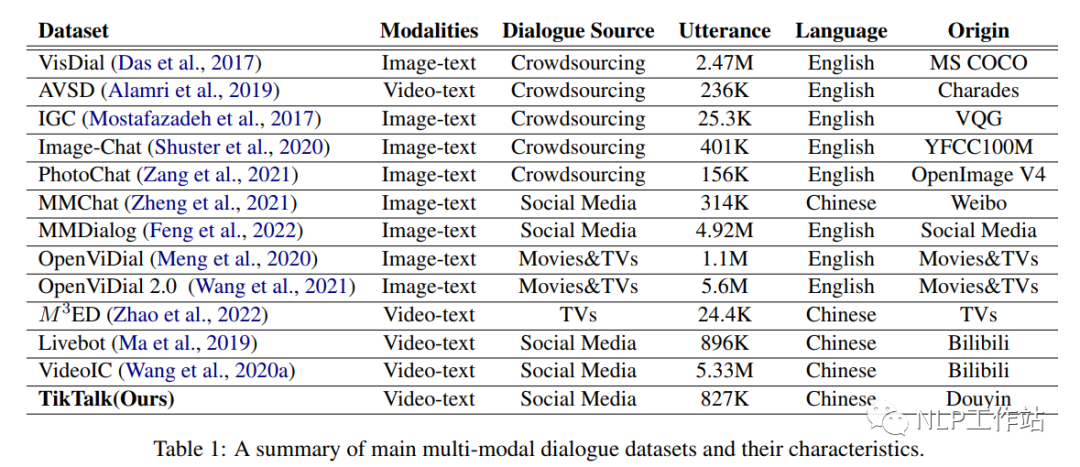

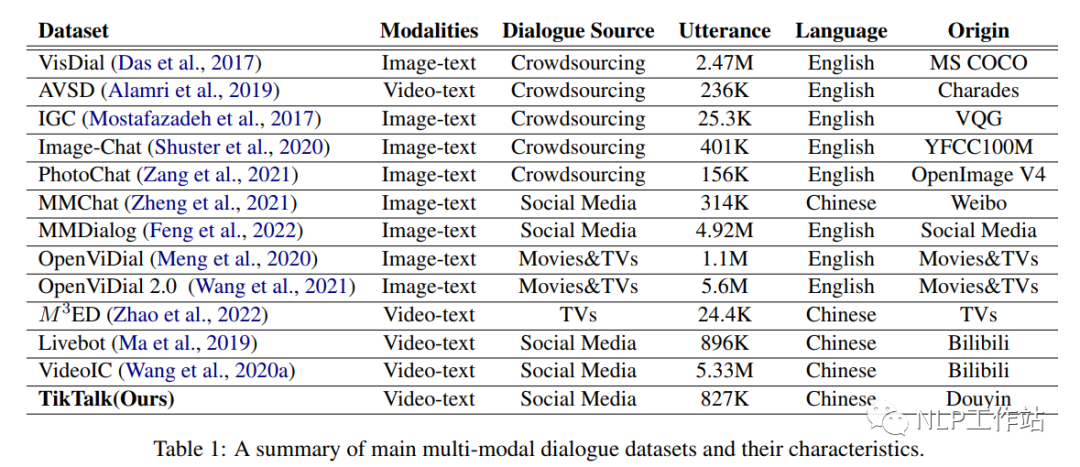

665 隨著大量預(yù)訓(xùn)練語言模型在文本對話任務(wù)中的出色表現(xiàn),以及多模態(tài)的發(fā)展,在對話中引入多模態(tài)信息已經(jīng)引起了大量學(xué)者的關(guān)注。

2023-02-09 09:31:26 1166

1166 隨著大量預(yù)訓(xùn)練語言模型在文本對話任務(wù)中的出色表現(xiàn),以及多模態(tài)的發(fā)展,在對話中引入多模態(tài)信息已經(jīng)引起了大量學(xué)者的關(guān)注。目前已經(jīng)提出了各種各樣的多模態(tài)對話數(shù)據(jù)集,主要來自電影、電視劇、社交媒體平臺等

2023-02-22 11:03:01 842

842

研究者將一個基于 Transformer 的語言模型作為通用接口,并將其與感知模塊對接。他們在網(wǎng)頁規(guī)模的多模態(tài)語料庫上訓(xùn)練模型,語料庫包括了文本數(shù)據(jù)、任意交錯的圖像和文本、以及圖像字幕對。

2023-03-13 11:23:00 697

697 而且 GPT-4 是多模態(tài)的,同時支持文本和圖像輸入功能。此外,GPT-4 比以前的版本“更大”,這意味著其已經(jīng)在更多的數(shù)據(jù)上進(jìn)行了訓(xùn)練,并且在模型文件中有更多的權(quán)重,這也使得它的運(yùn)行成本更高。

2023-03-17 10:31:07 2930

2930 對于任何沒有額外微調(diào)和強(qiáng)化學(xué)習(xí)的預(yù)訓(xùn)練大型語言模型來說,用戶得到的回應(yīng)質(zhì)量可能參差不齊,并且可能包括冒犯性的語言和觀點(diǎn)。這有望隨著規(guī)模、更好的數(shù)據(jù)、社區(qū)反饋和優(yōu)化而得到改善。

2023-04-24 10:07:06 2168

2168

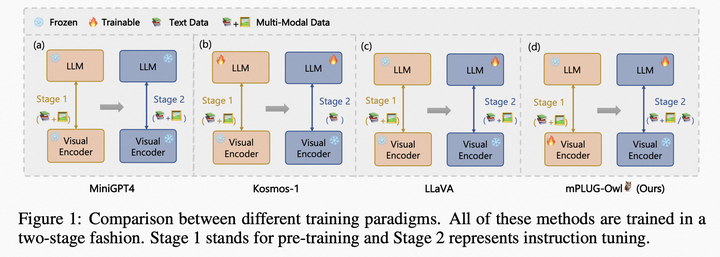

大型語言模型LLM(Large Language Model)具有很強(qiáng)的通用知識理解以及較強(qiáng)的邏輯推理能力,但其只能處理文本數(shù)據(jù)。

2023-05-10 16:53:15 701

701

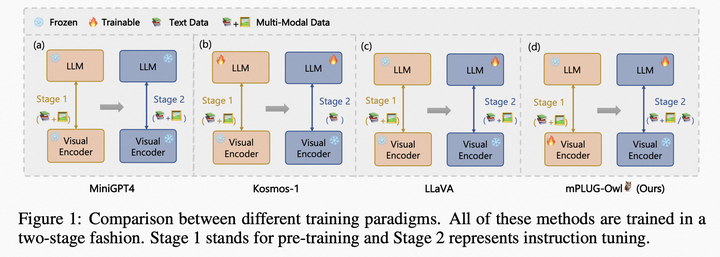

大型語言模型LLM(Large Language Model)具有很強(qiáng)的通用知識理解以及較強(qiáng)的邏輯推理能力,但其只能處理文本數(shù)據(jù)。雖然已經(jīng)發(fā)布的GPT4具備圖片理解能力,但目前還未開放多模態(tài)輸入接口并且不會透露任何模型上技術(shù)細(xì)節(jié)。因此,現(xiàn)階段,如何利用LLM做一些多模態(tài)任務(wù)還是有一定的研究價值的。

2023-05-11 17:09:16 648

648

基于開源多模態(tài)模型 OpenFlamingo,作者使用公開數(shù)據(jù)集創(chuàng)建了各種視覺指令數(shù)據(jù),包括視覺問答、圖像字幕、視覺推理、文本 OCR 和視覺對話。此外,還使用僅包含語言指令數(shù)據(jù)的語言模型組件進(jìn)行了訓(xùn)練。

2023-05-12 09:55:03 834

834

雖然現(xiàn)有的級聯(lián)方法或口語語言模型能夠感知和生成語音,但仍存在一些限制。首先,在級聯(lián)模型中,LLM 僅充當(dāng)內(nèi)容生成器。由于語音和文本的表示沒有對齊,LLM 的知識無法遷移到語音模態(tài)中。

2023-05-22 10:19:29 382

382

大型語言模型(LLM)在各種自然語言處理任務(wù)上表現(xiàn)出驚人的能力。與此同時,多模態(tài)大型語言模型,如 GPT-4、PALM-E 和 LLaVA,已經(jīng)探索了 LLM 理解多模態(tài)信息的能力。然而,當(dāng)前

2023-05-22 14:38:06 417

417

大型語言模型LLM(Large Language Model)具有很強(qiáng)的通用知識理解以及較強(qiáng)的邏輯推理能力,但其只能處理文本數(shù)據(jù)。雖然已經(jīng)發(fā)布的GPT4具備圖片理解能力,但目前還未開放多模態(tài)輸入接口

2023-05-22 15:57:33 466

466

最近,很多方法學(xué)習(xí)與文本、音頻等對齊的圖像特征。這些方法使用單對模態(tài)或者最多幾種視覺模態(tài)。最終嵌入僅限于用于訓(xùn)練的模態(tài)對。因此,視頻 - 音頻嵌入無法直接用于圖像 - 文本任務(wù),反之亦然。學(xué)習(xí)真正的聯(lián)合嵌入面臨的一個主要障礙是缺乏所有模態(tài)融合在一起的大量多模態(tài)數(shù)據(jù)。

2023-05-26 15:45:07 531

531

5月30日,“多模態(tài)大模型產(chǎn)業(yè)高峰論壇”在軟通動力總部舉行。近百位專家學(xué)者、行業(yè)大咖和產(chǎn)業(yè)精英齊聚一堂,共同探討多模態(tài)大模型的產(chǎn)業(yè)機(jī)遇和未來發(fā)展。論壇上,元乘象 ChatImg2.0、軟通天璇2.0 MaaS平臺重磅發(fā)布。同時,進(jìn)行了多項(xiàng)產(chǎn)業(yè)合作簽約,共同推動多模態(tài)大模型產(chǎn)業(yè)落地。

2023-05-31 10:14:43 379

379

現(xiàn)有的可控圖片生成模型都是針對單一的模態(tài)進(jìn)行設(shè)計,然而 Taskonomy [3] 等工作證明不同的視覺模態(tài)之間共享特征和信息,因此本文認(rèn)為統(tǒng)一的多模態(tài)模型具有巨大的潛力。

2023-06-08 15:01:16 353

353

在一些非自然圖像中要比傳統(tǒng)模型表現(xiàn)更好 CoOp 增加一些 prompt 會讓模型能力進(jìn)一步提升 怎么讓能力更好?可以引入其他知識,即其他的預(yù)訓(xùn)練模型,包括大語言模型、多模態(tài)模型 也包括

2023-06-15 16:36:11 277

277

把大模型的訓(xùn)練門檻打下來!我們在單張消費(fèi)級顯卡上實(shí)現(xiàn)了多模態(tài)大模型(LaVIN-7B, LaVIN-13B)的適配和訓(xùn)練

2023-06-30 10:43:28 1173

1173

AI大模型可分為自然語言處理大模型,CV大模型、科學(xué)計算大模型等。AI大模型支持的模態(tài)更加多樣,從支持文本、圖片、圖像、語音單一模態(tài)下的單一任務(wù),逐漸發(fā)展為支持多種模態(tài)下的多種任務(wù)。

2023-07-06 12:31:56 1386

1386

三層架構(gòu),L0層包括自然語言、視覺、多模態(tài)、預(yù)測、科學(xué)計算五個基礎(chǔ)大模型;L1層是N個行業(yè)大模型;L2層為客戶提供了更多細(xì)化場景的模型,更加專注于政務(wù)熱線、網(wǎng)點(diǎn)助手、先導(dǎo)藥物篩選、傳送帶異物檢測、臺風(fēng)路徑預(yù)測等具體行業(yè)應(yīng)用或特定業(yè)務(wù)場景,為客戶提供“開箱即用”的模型服務(wù)。

2023-07-07 16:30:31 1298

1298 隨著 GPT-4 和 Stable Diffusion 等模型多模態(tài)能力的突飛猛進(jìn),多模態(tài)大模型已經(jīng)成為大模型邁向通用人工智能(AGI)目標(biāo)的下一個前沿焦點(diǎn)。總體而言,面向圖像和文本的多模態(tài)生成能力

2023-07-10 10:05:01 409

409

據(jù)華為常務(wù)董事、華為云 CEO 張平安介紹,盤古大模型 3.0 是面向行業(yè)的大模型系列,包括“5+N+X”三層架構(gòu):L0 層是 5 個基礎(chǔ)大模型,包括自然語言、視覺、多模態(tài)、預(yù)測、科學(xué)計算,提供滿足行業(yè)場景中的多種技能需求。

2023-07-10 14:19:20 967

967 7月12日,【東風(fēng)生萬物】思必馳DFM-2大模型及創(chuàng)新技術(shù)應(yīng)用成果發(fā)布會在蘇州成功舉行。

2023-07-13 09:44:26 278

278 簡單來說,語言模型能夠以某種方式生成文本。它的應(yīng)用十分廣泛,例如,可以用語言模型進(jìn)行情感分析、標(biāo)記有害內(nèi)容、回答問題、概述文檔等等。但理論上,語言模型的潛力遠(yuǎn)超以上常見任務(wù)。

2023-07-14 11:45:40 454

454

當(dāng)前學(xué)界和工業(yè)界都對多模態(tài)大模型研究熱情高漲。去年,谷歌的 Deepmind 發(fā)布了多模態(tài)視覺語言模型 Flamingo ,它使用單一視覺語言模型處理多項(xiàng)任務(wù),在多模態(tài)大模型領(lǐng)域保持較高

2023-07-16 20:45:02 379

379

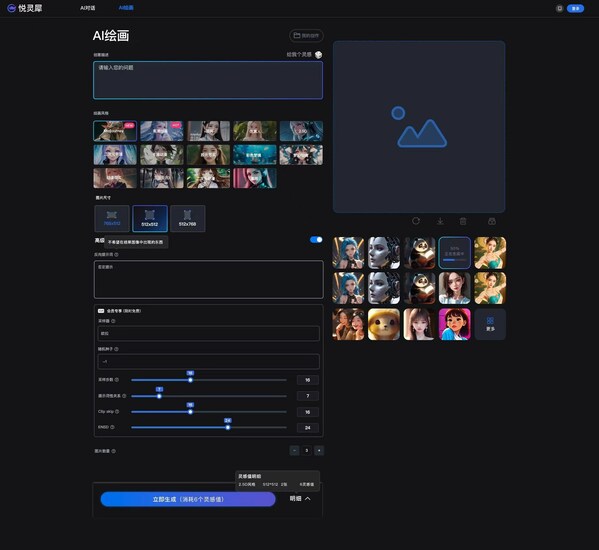

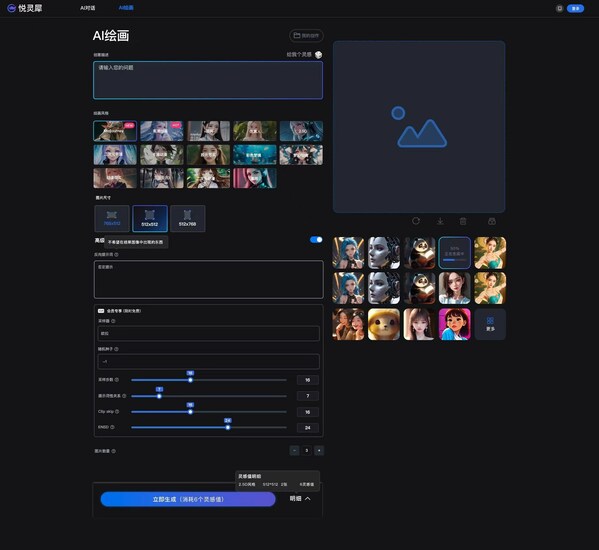

多模態(tài)模型AI創(chuàng)作平臺悅靈犀。悅靈犀是一款多模態(tài)模型的AGI創(chuàng)作平臺,依托悅享人工智能大模型"北辰星悅"智能云服務(wù),提供企業(yè)級穩(wěn)定可靠的AI創(chuàng)作與繪畫服務(wù)。 作為新一代移動互聯(lián)網(wǎng)基礎(chǔ)設(shè)施生態(tài)服務(wù)商,耀世星輝始終圍繞 "平臺+ 內(nèi)容 + 場景+AI +產(chǎn)業(yè)" 的發(fā)展戰(zhàn)略

2023-07-18 21:17:38 400

400

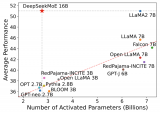

,人們對開源LLM越來越感興趣。這些模型是在開源許可下發(fā)布的,這意味著任何人都可以使用、修改和分發(fā)它們。這使得研究人員、開發(fā)人員和企業(yè)都可以嘗試LLM,并為它們開發(fā)新的應(yīng)用程序。 使用開源llm有很多好處。首先它們通常比專業(yè)的LLM更價便宜。并且它們更加透明

2023-07-28 12:20:02 440

440

大型語言模型(llm)是一種人工智能(AI),在大量文本和代碼數(shù)據(jù)集上進(jìn)行訓(xùn)練。它們可以用于各種任務(wù),包括生成文本、翻譯語言和編寫不同類型的創(chuàng)意內(nèi)容。今年開始,人們對開源LLM越來越感興趣。這些模型

2023-08-01 00:21:27 554

554

“書生·萬卷”1.0將集中語言資料數(shù)據(jù)聯(lián)盟會員們豐富的內(nèi)容積累和上海人工智能實(shí)驗(yàn)室的數(shù)據(jù)處理能力等優(yōu)勢,為學(xué)術(shù)界及產(chǎn)業(yè)界提供高品質(zhì)的大規(guī)模模型多模態(tài)事前訓(xùn)練語言資料。開放源代碼提供2tb以上的數(shù)據(jù),多種融合,精細(xì)處理,價值排序,使用方便高效。

2023-08-17 10:17:43 312

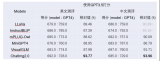

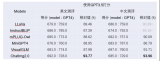

312 近日,清華大學(xué)新聞與傳播學(xué)院發(fā)布了《大語言模型綜合性能評估報告》,該報告對目前市場上的7個大型語言模型進(jìn)行了全面的綜合評估。近年,大語言模型以其強(qiáng)大的自然語言處理能力,成為AI領(lǐng)域的一大熱點(diǎn)。它們

2023-08-10 08:32:01 607

607

據(jù)介紹,Qwen-VL 是支持中英文等多種語言的視覺語言(Vision Language,VL)模型。相較于此前的 VL 模型,Qwen-VL 除了具備基本的圖文識別、描述、問答及對話能力之外,還新增了視覺定位、圖像中文字理解等能力。

2023-08-25 15:12:10 634

634

如上圖所示,UniDoc基于預(yù)訓(xùn)練的視覺大模型及大語言模型,將文字的檢測、識別、spotting(圖中未畫出)、多模態(tài)理解等四個任務(wù),通過多模態(tài)指令微調(diào)的方式,統(tǒng)一到一個框架中。具體地,輸入一張圖像以及一條指令(可以是檢測、識別、spotting、語義理解)

2023-08-31 15:29:19 987

987

騰訊發(fā)布混元大語言模型 騰訊全球數(shù)字生態(tài)大會上騰訊正式發(fā)布了混元大語言模型,參數(shù)規(guī)模超千億,預(yù)訓(xùn)練語料超2萬億tokens。 作為騰訊自研的通用大語言模型,混元大語言模型具有中文創(chuàng)作能力、任務(wù)執(zhí)行

2023-09-07 10:23:54 815

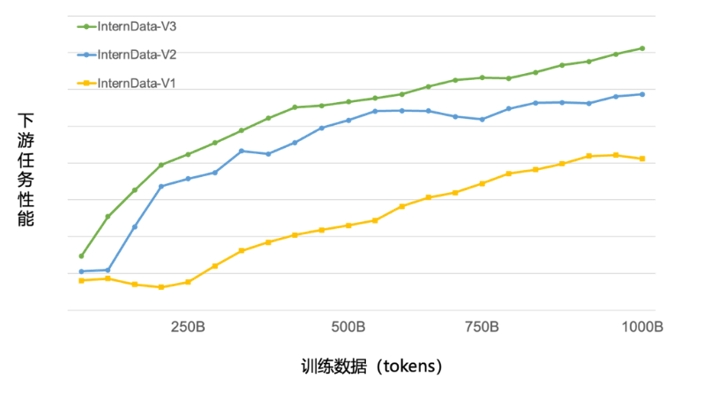

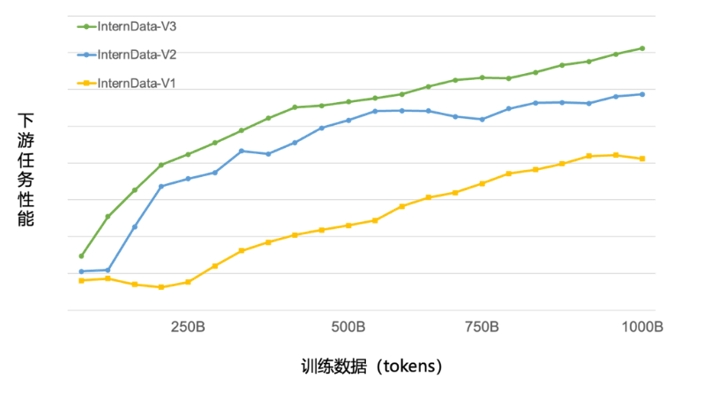

815 ) 開源首發(fā)。 同時,書生·浦語面向大模型研發(fā)與應(yīng)用的全鏈條工具鏈全線升級,與InternLM-20B一同繼續(xù)全面開放,向企業(yè)和開發(fā)者提供 免費(fèi)商用授權(quán) 。 今年6月首次發(fā)布以來,書生·浦語歷多輪升級,在開源社區(qū)和產(chǎn)業(yè)界產(chǎn)生廣泛影響。 InternLM-20B模型性能先進(jìn)且應(yīng)用便捷,以不足三分之一的參

2023-09-20 16:45:02 644

644

目前為止,OpenAI還沒有對爆料中的傳聞做出回應(yīng),但此前發(fā)布過多模態(tài)模型測試。CEO奧特曼在回應(yīng)有關(guān)GPT-5的傳聞時,也暗示過GPT-4“正在增強(qiáng)”。

2023-09-20 17:34:41 799

799

由于固有的模態(tài)缺口,如CLIP語義主要關(guān)注模態(tài)共享信息,往往忽略了可以增強(qiáng)多模態(tài)理解的模態(tài)特定知識。因此,這些研究并沒有充分認(rèn)識到多模式創(chuàng)造和理解之間潛在的學(xué)習(xí)協(xié)同作用,只顯示出創(chuàng)造力的微小提高,并且在多模式理解方面仍然存在不足。

2023-09-25 17:26:43 361

361

NVIDIA 于 2023 年 10 月 19 日公開發(fā)布 TensorRT-LLM ,可在 NVIDIA GPU 上加速和優(yōu)化最新的大語言模型(Large Language Models)的推理性

2023-10-27 20:05:02 478

478

深度學(xué)習(xí)的大模型時代已經(jīng)來臨,越來越多的大規(guī)模預(yù)訓(xùn)練模型在文本、視覺和多模態(tài)領(lǐng)域展示出杰出的生成和推理能力。然而大模型巨大的參數(shù)量有兩個明顯缺點(diǎn)

2023-11-08 16:20:25 274

274

不同于單模態(tài)模型編輯,多模態(tài)模型編輯需要考慮更多的模態(tài)信息。文章出發(fā)點(diǎn)依然從單模態(tài)模型編輯入手,將單模態(tài)模型編輯拓展到多模態(tài)模型編輯,主要從以下三個方面:可靠性(Reliability),穩(wěn)定性(Locality)和泛化性(Generality)。

2023-11-09 14:53:22 215

215

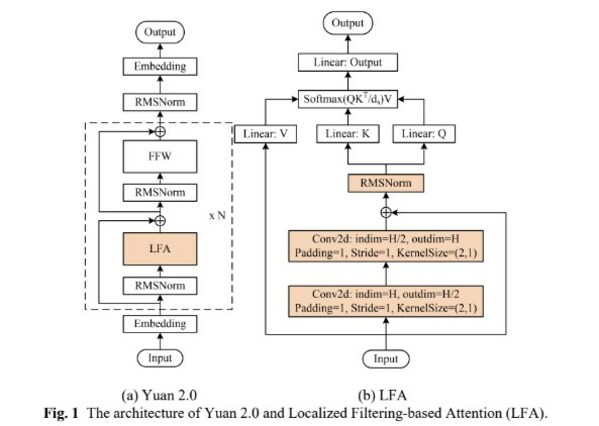

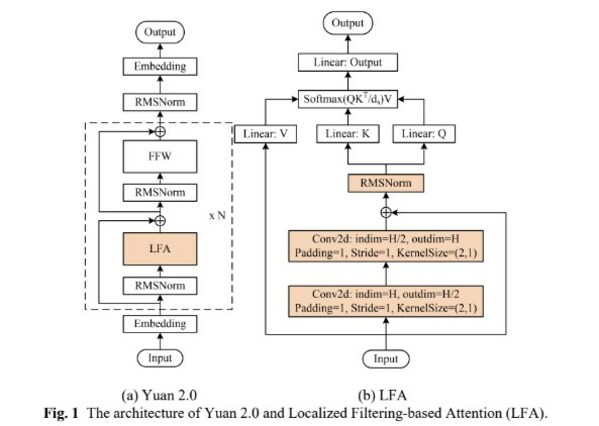

11月27日,浪潮信息發(fā)布"源2.0"基礎(chǔ)大模型,并宣布全面開源。源2.0基礎(chǔ)大模型包括1026億、518億、21億等三種參數(shù)規(guī)模的模型,在編程、推理、邏輯等方面展示出了先進(jìn)的能力。

2023-11-28 09:10:14 417

417

本文基于亞馬遜云科技推出的大語言模型與生成式AI的全家桶:Bedrock對大語言模型進(jìn)行介紹。大語言模型指的是具有數(shù)十億參數(shù)(B+)的預(yù)訓(xùn)練語言模型(例如:GPT-3, Bloom, LLaMA)。這種模型可以用于各種自然語言處理任務(wù),如文本生成、機(jī)器翻譯和自然語言理解等。

2023-12-04 15:51:46 356

356 我們知道,預(yù)訓(xùn)練LLM已經(jīng)取得了諸多驚人的成就, 然而其明顯的劣勢是不支持其他模態(tài)(包括圖像、語音、視頻模態(tài))的輸入和輸出,那么如何在預(yù)訓(xùn)練LLM的基礎(chǔ)上引入跨模態(tài)的信息,讓其變得更強(qiáng)大、更通用呢?本節(jié)將介紹“大模型+多模態(tài)”的3種實(shí)現(xiàn)方法。

2023-12-13 13:55:04 530

530

Gemini 是一款新型的多模態(tài)大語言模型,此前多模態(tài)大模型在處理視頻、文字、圖像等多維度輸入信息時是采用分別訓(xùn)練分別輸出再進(jìn)行拼接的方式,這種方式的缺點(diǎn)在于面對復(fù)雜邏輯問題時,大模型的回復(fù)略顯遲鈍。

2023-12-14 09:55:17 436

436

在科技飛速發(fā)展的當(dāng)今時代,人工智能技術(shù)成為社會進(jìn)步的關(guān)鍵推動力之一。在廣泛關(guān)注的人工智能領(lǐng)域中,大語言模型以其引人注目的特性備受矚目。 大語言模型的定義及發(fā)展歷史 大語言模型是一類基于深度學(xué)習(xí)技術(shù)

2023-12-21 17:53:59 555

555 前段時間Google推出Gemini多模態(tài)大模型,展示了不凡的對話能力和多模態(tài)能力,其表現(xiàn)究竟如何呢?

2023-12-28 11:19:52 361

361

多模態(tài)大語言模型(MLLM) 最近引起了廣泛的關(guān)注,其將 LLM 的推理能力與圖像、視頻和音頻數(shù)據(jù)相結(jié)合,通過多模態(tài)對齊使它們能夠更高效地執(zhí)行各種任務(wù),包括圖像分類、將文本與相應(yīng)的視頻對齊以及語音檢測。

2023-12-28 11:45:21 151

151

隨著開源預(yù)訓(xùn)練大型語言模型(Large Language Model, LLM )變得更加強(qiáng)大和開放,越來越多的開發(fā)者將大語言模型納入到他們的項(xiàng)目中。其中一個關(guān)鍵的適應(yīng)步驟是將領(lǐng)域特定的文檔集成到預(yù)訓(xùn)練模型中,這被稱為微調(diào)。

2024-01-04 12:32:39 228

228

1月17日,商湯科技與上海AI實(shí)驗(yàn)室聯(lián)合香港中文大學(xué)和復(fù)旦大學(xué)正式發(fā)布新一代大語言模型書?·浦語2.0(InternLM2)。

2024-01-17 15:03:57 332

332

ByteDance Research 基于開源的多模態(tài)語言視覺大模型 OpenFlamingo 開發(fā)了開源、易用的 RoboFlamingo 機(jī)器人操作模型,只用單機(jī)就可以訓(xùn)練。

2024-01-19 11:43:08 106

106

韓國互聯(lián)網(wǎng)巨頭Kakao最近宣布開發(fā)了一種名為“蜜蜂”(Honeybee)的多模態(tài)大型語言模型。這種創(chuàng)新模型能夠同時理解和處理圖像和文本數(shù)據(jù),為更豐富的交互和查詢響應(yīng)提供了可能性。

2024-01-19 16:11:20 221

221 2024年1月30日14:00訊飛星火再升級;這一次首個基于全國產(chǎn)化算力平臺訓(xùn)練的全民開放大模型 訊飛星火V3.5正式發(fā)布邏輯推理、語言理解、文本生成、 數(shù)學(xué)答題、多模態(tài)等核心能力均實(shí)現(xiàn)大幅提升

2024-01-23 09:06:05 508

508 幻方量化旗下組織深度求索發(fā)布了國內(nèi)首個開源 MoE 大模型 —— DeepSeekMoE,全新架構(gòu),免費(fèi)商用。

2024-01-23 11:28:48 427

427

對此,ByteDance Research 基于開源的多模態(tài)語言視覺大模型 OpenFlamingo 開發(fā)了開源、易用的 RoboFlamingo 機(jī)器人操作模型,只用單機(jī)就可以訓(xùn)練。使用簡單、少量的微調(diào)就可以把 VLM 變成 Robotics VLM,從而適用于語言交互的機(jī)器人操作任務(wù)。

2024-01-23 16:02:17 169

169

Meta發(fā)布CodeLlama70B開源大模型 Meta發(fā)布了開源大模型CodeLlama70B,號稱是CodeLlama系列體量最大、性能最強(qiáng)的大模型。 Code Llama 70B 有一個很出色

2024-01-31 10:30:18 879

879 商湯科技近日發(fā)布了新版的日日新·商量大語言模型-通用版本(SenseChat V4)。這一版本的模型在知識理解、閱讀理解、綜合推理、數(shù)理、代碼和長文本理解等領(lǐng)域的通用能力得到了顯著提升。

2024-02-04 10:30:41 426

426 近日,大模型開源開放評測體系司南(OpenCompass2.0)正式發(fā)布,旨在為大語言模型、多模態(tài)模型等各類模型提供一站式評測服務(wù)。OpenCompass2.0的發(fā)布,將為模型技術(shù)創(chuàng)新提供重要的技術(shù)支撐。

2024-02-05 11:28:12 526

526 昆侖萬維科技今日震撼發(fā)布全新升級的「天工2.0」MoE大語言模型以及配套的新版「天工AI智能助手」APP。此次更新標(biāo)志著國內(nèi)首個搭載MoE架構(gòu)的千億級參數(shù)大語言模型AI應(yīng)用正式面向廣大C端用戶免費(fèi)

2024-02-06 16:19:51 756

756 “大語言模型為 AI 產(chǎn)業(yè)帶來新的生機(jī),然而語言模型的應(yīng)用場景有限。要全面打開生成式 AI 的想象力,還是要依托多模態(tài)大模型。”IDC 中國研究總監(jiān)盧言霞近日表示。Sora在文生視頻領(lǐng)域真正邁出

2024-02-20 16:13:26 159

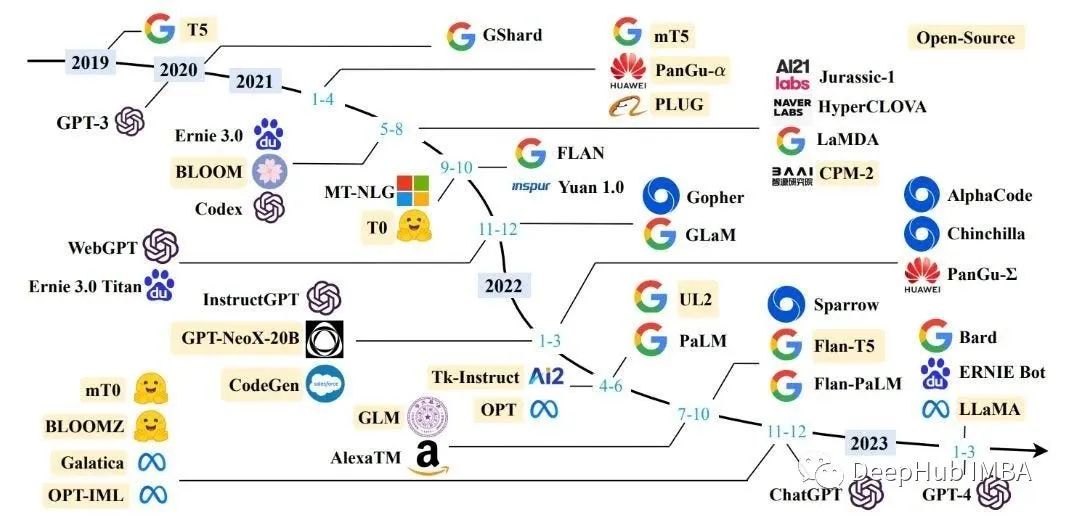

159 在人工智能領(lǐng)域,谷歌可以算是開源的鼻祖。今天幾乎所有的大語言模型,都基于谷歌在 2017 年發(fā)布的 Transformer 論文;谷歌的發(fā)布的 BERT、T5,都是最早的一批開源 AI 模型。

2024-02-22 18:14:34 143

143

谷歌近日宣布推出開源人工智能(AI)模型系列Gemma,旨在為開發(fā)人員和研究人員提供一個負(fù)責(zé)任的AI構(gòu)建平臺。這一舉措標(biāo)志著自2022年OpenAI的ChatGPT引領(lǐng)AI聊天機(jī)器人熱潮后,谷歌首次發(fā)布重要的開源大型語言模型(LLM),直接與ChatGPT展開競爭。

2024-02-23 11:38:33 345

345 2024年世界移動通信大會(MWC)上,高通再次展現(xiàn)其技術(shù)領(lǐng)導(dǎo)力,通過發(fā)布全新的高通AI Hub和展示前沿的多模態(tài)大模型技術(shù),推動了5G和AI技術(shù)的融合創(chuàng)新。

2024-02-26 16:59:50 667

667 近日,零一萬物正式發(fā)布Yi大模型API開放平臺,為開發(fā)者提供通用Chat、200k超長上下文、多模態(tài)交互等模型。

2024-03-17 09:55:41 483

483 近日,科技巨頭蘋果公司在一篇由多位專家共同撰寫的論文中,正式公布了其最新的多模態(tài)大模型研究成果——MM1。這款具有高達(dá)300億參數(shù)的多模態(tài)模型系列,由密集模型和混合專家(MoE)變體組成,標(biāo)志著蘋果在人工智能領(lǐng)域的又一重大突破。

2024-03-19 11:19:30 196

196

電子發(fā)燒友App

電子發(fā)燒友App

評論