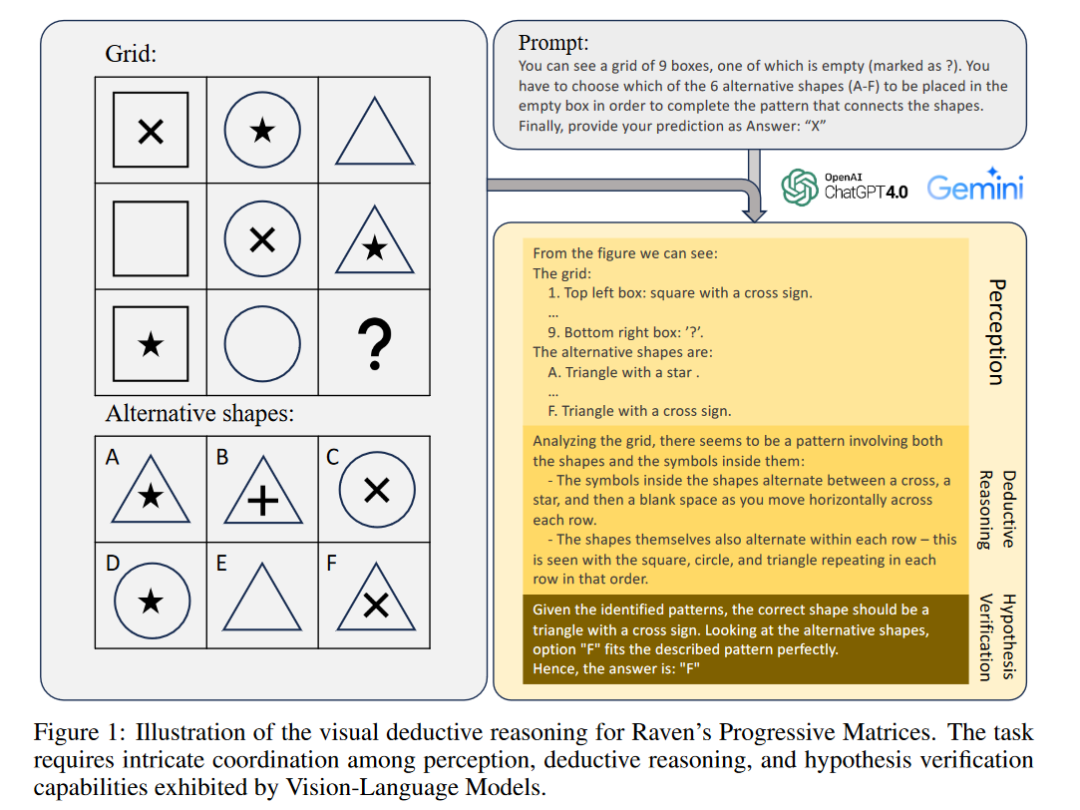

最近,GPT-4V 等視覺語言模型(VLM)在各種視覺語言任務中取得了令人難以置信的進步。我們深入研究了基于視覺的演繹推理這一更為復雜但探索較少的領域,并發現了當前 SOTA 視覺語言模型中尚未暴露的盲點。具體來說,我們利用Raven's Progressive Matrices(RPM)來評估 VLM 僅依靠視覺線索進行多跳multi-hop關系和演繹推理的能力。

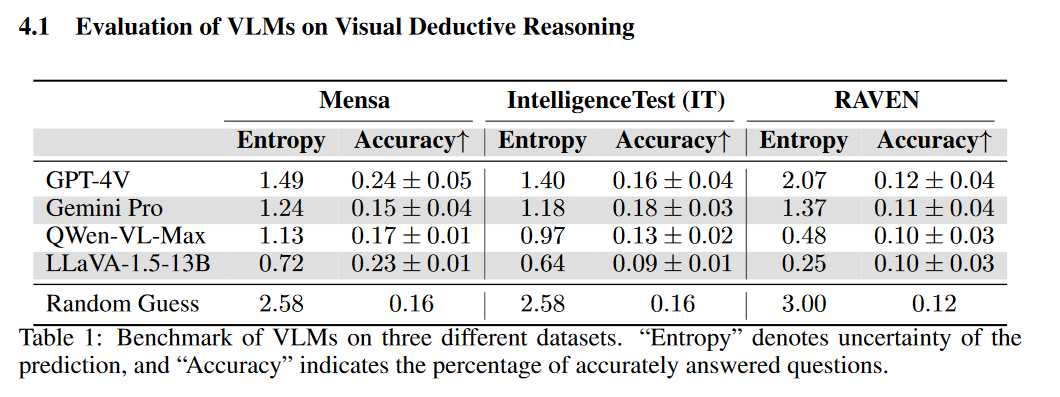

我們在三個不同的數據集(包括 Mensa IQ 測試、IntelligenceTest 和 RAVEN)上對幾種流行的 VLM 進行了全面評估,這些 VLM 采用了標準策略,如上下文學習、自我一致性(SC)和思維鏈(CoT)。結果表明,盡管 LLM 在文本推理方面的能力令人印象深刻,但我們在視覺演繹推理方面仍遠未達到可比的熟練程度。我們發現,某些在 LLMs 中有效的標準策略并不能完美地應對視覺推理任務帶來的挑戰。此外,詳細的分析表明,VLMs 在解決這些任務時之所以舉步維艱,主要是因為他們無法感知和理解 RPM 示例中多種混淆的抽象模式。

https://arxiv.org/abs/2403.04732

Q1: 這篇論文試圖解決什么問題?

A:這篇論文試圖解決的問題是評估和理解當前最先進的視覺-語言模型(Vision-Language Models, VLMs)在視覺推理任務上的性能,特別是在需要復雜視覺推理能力的挑戰性任務上。具體來說,研究者們通過使用Raven's Progressive Matrices(RPMs)問題來測試VLMs在僅依賴視覺線索進行多跳關系和演繹推理的能力。這些任務要求模型能夠理解給定的模式、推導出潛在的規則,并使用這些規則來選擇缺失模式的正確選項。論文的目標是揭示VLMs在視覺演繹推理方面的局限性,并探討如何提高它們在這一領域的性能。

Q2: 有哪些相關研究?

A:相關研究包括以下幾個方面:

通用大型語言模型(LLM)推理基準:研究者們介紹了多種基于文本的推理任務和基準,用于評估LLMs在不同領域(如常識、數學推理、常識推理、事實推理和編程)的性能。這些研究包括BIG-bench、HELM、SuperGLUE和LAMA等。

視覺推理評估:先前的工作主要集中在視覺問答(VQA)和圖像描述等任務上,這些任務涉及回答有關圖像的問題或生成視覺內容的自然語言描述。研究人員還檢查了模型理解圖像中對象的關系和組合方面的能力。CLEVR和SHAPES等數據集評估了計數、比較、邏輯推理和記憶存儲等視覺推理能力。

演繹推理:在文本和視覺領域都進行了演繹推理評估和基準測試。例如,GuessWhat?!和ReferIt評估了模型的視覺推理能力。最近,LMRL Gym和Entity Deduction Arena被引入作為評估LLMs執行多輪演繹推理任務的能力的方法。ARC任務與RPMs相似,都需要根據給定的例子正確推斷未見的輸出。

視覺-語言模型(VLMs)的發展:隨著VLMs在視覺推理方面的能力發展,基準測試也在不斷進步。新的基準測試,如MMMU和MathVista,測試了模型在圖像和視頻中模擬人類對場景和對象理解的能力,包括場景文本理解、公式、圖表解釋、視覺刺激理解、幾何推理、空間推理和面部表情理解與推理。

這些研究為評估VLMs在視覺演繹推理任務上的性能提供了背景和基礎,同時也指出了當前模型在這一領域的局限性。

Q3: 論文如何解決這個問題?

A:論文通過以下步驟來解決視覺演繹推理的問題:

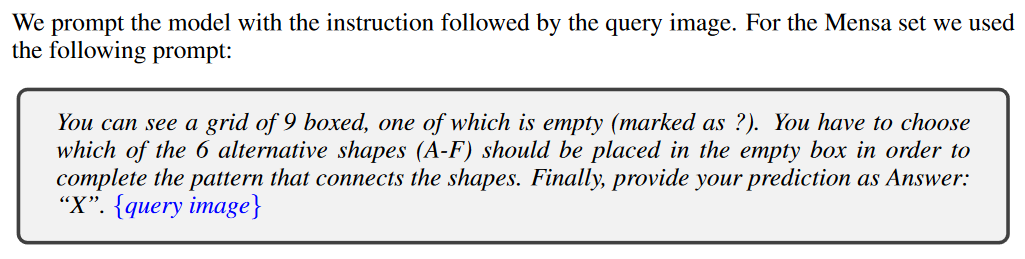

建立評估框架:研究者們建立了一個系統性的評估框架,用于評估VLMs在RPM問題上的性能。他們選擇了包括Mensa IQ測試、IntelligenceTest和RAVEN在內的多樣化數據集,并在這些數據集上評估了多個流行的開源和閉源VLMs。

應用標準策略:研究者們嘗試了在大型語言模型(LLMs)中有效的標準推理時策略,**如上下文學習(in-context learning)和自我一致性(self-consistency),以探索這些策略在VLMs中的潛力。**

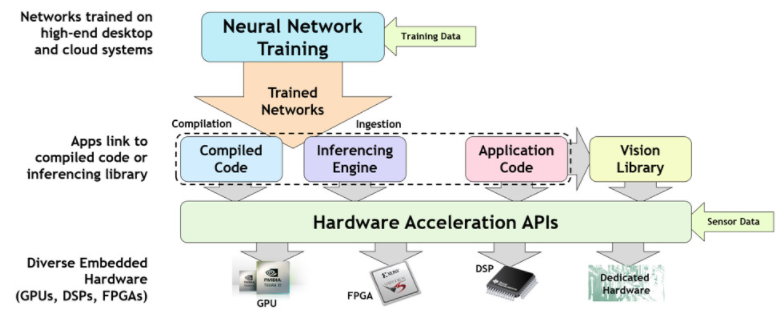

性能瓶頸分析:通過將VLMs的能力分解為感知、演繹推理和假設驗證三個部分,研究者們詳細診斷了VLMs在RPM任務中的性能瓶頸。他們發現感知是當前VLMs的限制因素,并提供了一個案例研究來突出強VLMs(如GPT-4V)中的特定“盲點”。

問題識別與分析:研究者們識別并檢查了當前VLMs在這項任務中的幾個問題,包括過度自信、對提示設計的敏感性以及無法有效利用上下文示例。他們通過消融實驗研究了不同提示對模型整體性能的影響,并發現模型可以從更結構化的提示中受益。

實驗設置:研究者們詳細描述了實驗設置,包括使用的數據集、比較的模型以及用于生成響應的提示方法。

結果評估:研究者們展示了不同VLMs在各個數據集上的表現,并分析了模型預測的不確定性。他們還探討了標準策略在視覺演繹推理中的有效性,并討論了VLMs在感知、推理和假設驗證方面的表現。

結論與未來工作:最后,研究者們總結了VLMs在視覺演繹推理任務上的局限性,并提出了未來工作的方向,包括驗證VLMs在描述模式時的盲點,以及探索對比學習或強化學習算法來提高模型的視覺演繹推理能力。

通過這些步驟,論文不僅揭示了VLMs在視覺演繹推理方面的當前能力,還為如何改進這些模型提供了見解和建議。

Q4: 論文做了哪些實驗?

?

A:論文中進行的實驗主要包括以下幾個方面:

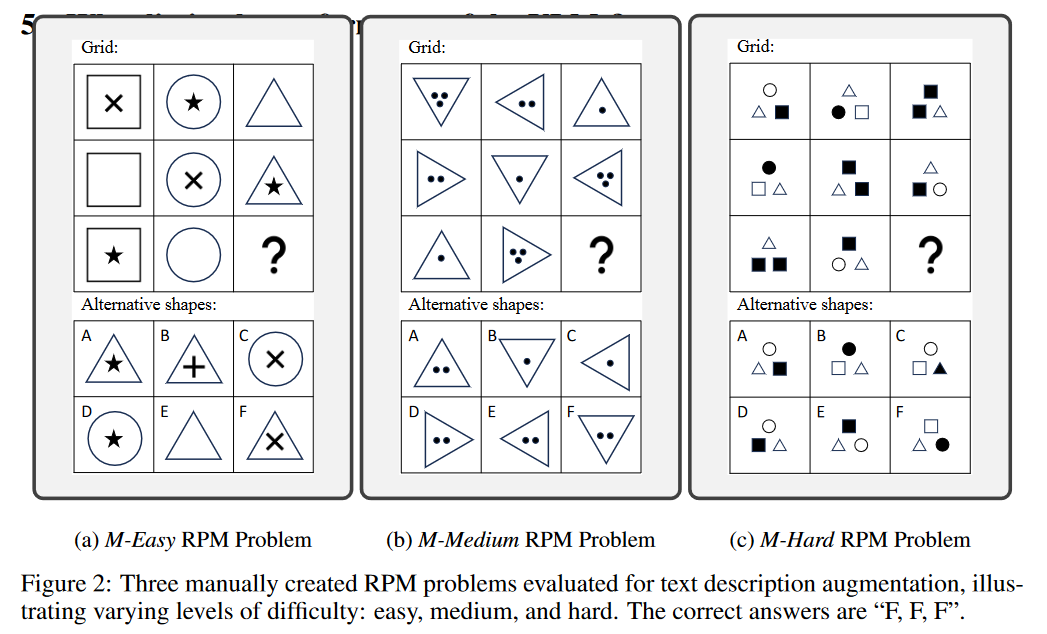

數據集評估:研究者們使用了三個不同的Raven's Progressive Matrices (RPMs) 數據集,包括Mensa IQ測試、IntelligenceTest和RAVEN,來評估多個流行的視覺-語言模型(VLMs)的性能。這些數據集涵蓋了不同的難度級別和視覺模式。

模型比較:比較了多種代表最先進水平的VLMs,包括GPT-4V、Gemini-pro、Qwen-VL-Max和LLaVA-1.5-13B。這些模型在不同的數據集上進行了性能測試,以評估它們在視覺推理任務上的能力。

推理策略測試:嘗試了在大型語言模型(LLMs)中有效的標準推理策略,如上下文學習(in-context learning)和自我一致性(self-consistency),以探究這些策略在VLMs中的效果。

性能瓶頸分析:通過將VLMs的能力分解為感知、演繹推理和假設驗證三個部分,研究者們對VLMs在RPM任務中的性能瓶頸進行了詳細分析。

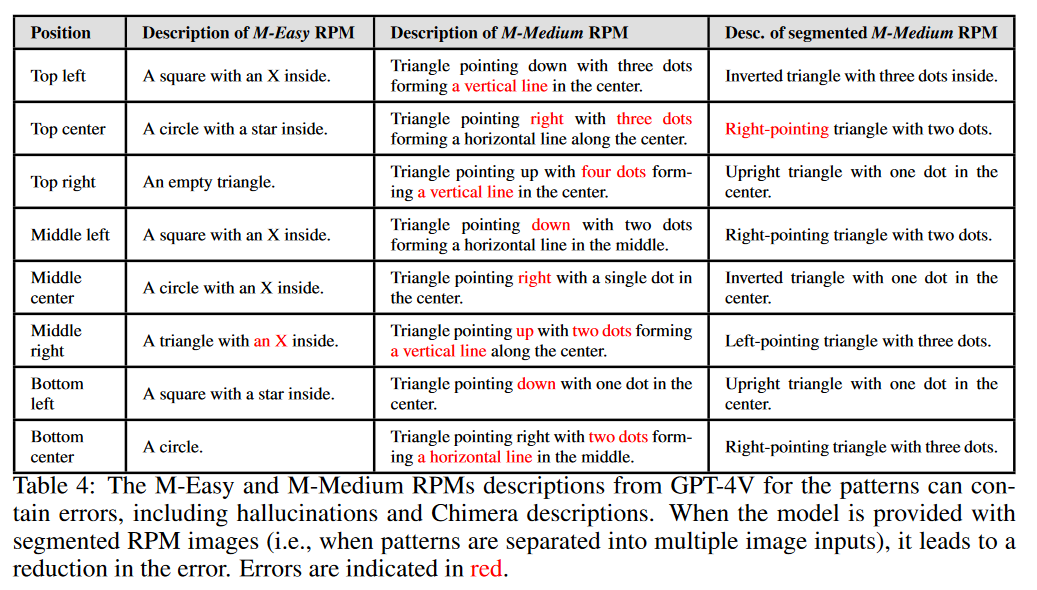

感知能力測試:評估了VLMs在理解RPM圖像模式方面的能力,包括對圖像的描述準確性和對模式的識別。

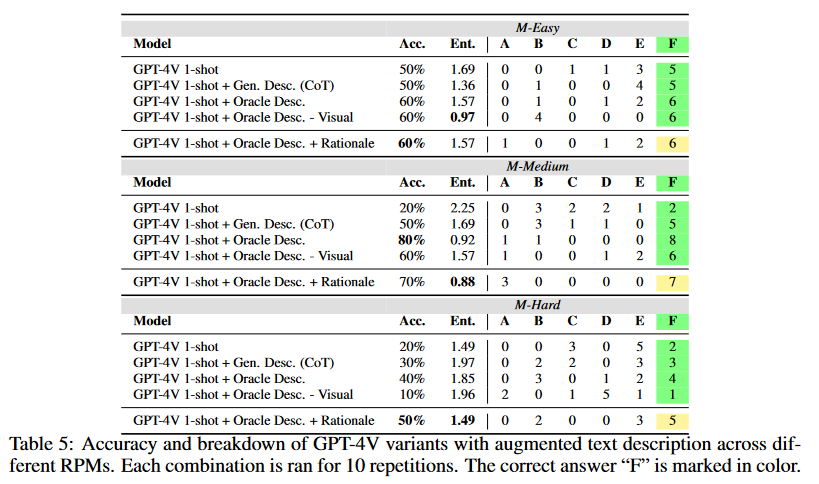

演繹推理能力測試:通過提供正確的文本描述(oracle descriptions)來測試模型在給定正確信息的情況下的推理能力。

假設驗證能力測試:測試了模型在接收到正確的描述和推理(oracle rationale)后,能否有效地生成假設并驗證這些假設。

提示格式影響測試:研究了提示的結構(如圖像和文本的順序)如何影響模型的預測性能。

錯誤描述處理:測試了模型在接收到自身生成的錯誤文本描述時,是否能夠進行有效的推理。

?

這些實驗旨在全面評估VLMs在視覺演繹推理任務上的能力,并識別它們在這一領域的局限性。通過這些實驗,研究者們能夠深入了解VLMs在視覺推理方面的性能,并為未來的改進提供了方向。

Q5: 有什么可以進一步探索的點?

A:論文提出了幾個可以進一步探索的點:

模型訓練數據的改進:研究者們提到,VLMs可能主要在真實世界圖像上進行訓練,這可能導致它們對抽象模式的敏感性降低。未來的工作可以探索在更多樣化的RPM數據上進行微調,以提高模型對抽象模式的識別能力。

對比學習和強化學習算法:為了提高VLMs的視覺演繹推理能力,可以探索開發對比學習或強化學習算法,這些算法可能有助于模型更好地理解和推理視覺模式。

感知和推理的結合:研究者們發現,當任務涉及復雜的空間布局和關系推理時,文本信息可能不足以提供最佳性能,而視覺線索可能提供額外的對齊和更好的比較注意力。未來的研究可以探索如何更有效地結合視覺信息和文本線索。

提示結構的優化:論文中提到,VLMs對提示的結構非常敏感。未來的工作可以進一步研究如何設計更有效的提示結構,以提高模型在視覺推理任務上的性能。

模型的不確定性校準:研究者們觀察到,即使在預測不確定性較高時,模型也傾向于提供確定性的答案,而不是表達不確定性。未來的研究可以探索如何改進模型的不確定性校準,使其在面對不確定性時能夠更準確地表達其置信度。

模型的泛化能力:RPM任務要求模型具有強大的泛化能力,因為每個問題可能有不同的潛在規則。未來的工作可以探索如何提高VLMs在這種少樣本學習任務中的泛化能力。

模型的解釋能力:研究者們發現,模型在生成解釋時可能會產生錯誤,特別是在復雜任務中。未來的研究可以探索如何提高模型的解釋能力,使其能夠更準確地生成與視覺線索相匹配的解釋。

這些探索點為VLMs在視覺演繹推理領域的未來發展提供了潛在的研究方向。

Q6: 總結一下論文的主要內容?

A:這篇論文的主要內容可以總結如下:

研究背景:論文探討了視覺-語言模型(VLMs)在視覺推理任務上的性能,特別是Raven's Progressive Matrices(RPMs)這類需要復雜視覺演繹推理的任務。

研究目標:旨在評估VLMs在視覺演繹推理任務上的能力,并識別當前模型的局限性。

實驗設計:使用Mensa IQ測試、IntelligenceTest和RAVEN數據集,對多個流行的VLMs進行了全面評估。實驗包括了標準策略的應用,如上下文學習和自我一致性。

主要發現:

**VLMs在文本推理任務上表現出色,但在視覺推理任務上仍有顯著差距。**

某些在LLMs中有效的策略在VLMs中并不總是有效。

VLMs在感知、演繹推理和假設驗證方面存在性能瓶頸,尤其是感知能力。

問題分析:通過詳細分析,研究者們發現VLMs在處理RPM任務時,主要問題在于無法準確感知和理解多個復雜的抽象模式。

策略測試:測試了在LLMs中有效的策略在VLMs中的有效性,發現這些策略并不總是能夠提高VLMs的性能。

性能提升:研究者們提出了一些可能的改進方向,包括在更多樣化的RPM數據上進行微調,以及開發對比學習和強化學習算法。

結論:盡管VLMs在視覺推理任務上取得了一定的進展,但與人類水平相比仍有較大差距。未來的研究需要進一步探索如何提高VLMs在這一領域的性能。

總的來說,這篇論文提供了對VLMs在視覺演繹推理任務上性能的深入分析,并為未來的研究方向提供了指導。

審核編輯:黃飛

?

電子發燒友App

電子發燒友App

評論