內(nèi)容涵蓋神經(jīng)網(wǎng)絡(luò)定義、損失函數(shù)、前向傳播、反向傳播、梯度下降算法,對(duì)于想要了解深度學(xué)習(xí)運(yùn)作原理的各位來說,內(nèi)容精彩不可錯(cuò)過。

2018-05-30 08:54:56 10373

10373

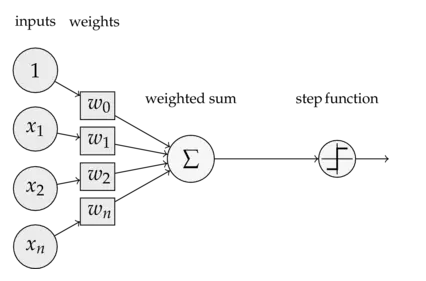

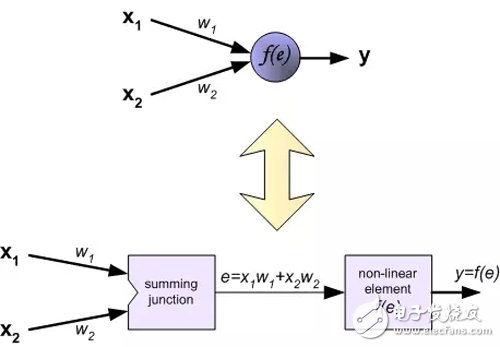

感知機(jī)算法中包含了前向傳播(FP)和反向傳播(BP)算法,但在介紹它們之前,我們先來了解一下深度神經(jīng)網(wǎng)絡(luò)的激活函數(shù)。

2020-02-08 19:03:54 2606

2606

神經(jīng)網(wǎng)絡(luò)50例

2012-11-28 16:49:56

神經(jīng)網(wǎng)絡(luò)Matlab程序

2009-09-15 12:52:24

大家有知道labview中神經(jīng)網(wǎng)絡(luò)和SVM的工具包是哪個(gè)嗎?求分享一下,有做這方面的朋友也可以交流一下,大家共同進(jìn)步

2017-10-13 11:41:43

03_深度學(xué)習(xí)入門_神經(jīng)網(wǎng)絡(luò)和反向傳播算法

2019-09-12 07:08:05

神經(jīng)網(wǎng)絡(luò)基本介紹

2018-01-04 13:41:23

神經(jīng)元 第3章 EBP網(wǎng)絡(luò)(反向傳播算法) 3.1 含隱層的前饋網(wǎng)絡(luò)的學(xué)習(xí)規(guī)則 3.2 Sigmoid激發(fā)函數(shù)下的BP算法 3.3 BP網(wǎng)絡(luò)的訓(xùn)練與測(cè)試 3.4 BP算法的改進(jìn) 3.5 多層

2012-03-20 11:32:43

將神經(jīng)網(wǎng)絡(luò)移植到STM32最近在做的一個(gè)項(xiàng)目需要用到網(wǎng)絡(luò)進(jìn)行擬合,并且將擬合得到的結(jié)果用作控制,就在想能不能直接在單片機(jī)上做神經(jīng)網(wǎng)絡(luò)計(jì)算,這樣就可以實(shí)時(shí)計(jì)算,不依賴于上位機(jī)。所以要解決的主要是兩個(gè)

2022-01-11 06:20:53

神經(jīng)網(wǎng)絡(luò)簡(jiǎn)介

2012-08-05 21:01:08

基于深度學(xué)習(xí)的神經(jīng)網(wǎng)絡(luò)算法

2019-05-16 17:25:05

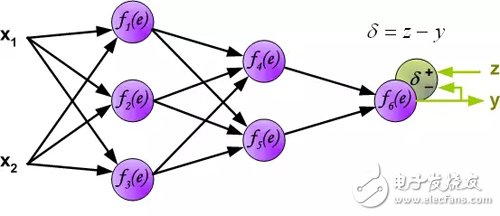

誤差反向傳播算法的學(xué)習(xí)過程,由信息的正向傳播和誤差的反向傳播兩個(gè)過程組成,是一種應(yīng)用最為廣泛的神經(jīng)網(wǎng)絡(luò)。先來看一下BP神經(jīng)網(wǎng)絡(luò)的流程圖:由BP神經(jīng)網(wǎng)絡(luò)流程圖可以看出,正向傳播處理過程和人工神經(jīng)網(wǎng)絡(luò)的流程

2018-06-05 10:11:50

MATLAB神經(jīng)網(wǎng)絡(luò)

2013-07-08 15:17:13

MATLAB神經(jīng)網(wǎng)絡(luò)工具箱函數(shù)說明:本文檔中所列出的函數(shù)適用于MATLAB5.3以上版本,為了簡(jiǎn)明起見,只列出了函數(shù)名,若需要進(jìn)一步的說明,請(qǐng)參閱MATLAB的幫助文檔。1. 網(wǎng)絡(luò)創(chuàng)建函數(shù)newp

2009-09-22 16:10:08

Matlab神經(jīng)網(wǎng)絡(luò)工具箱是什么?Matlab神經(jīng)網(wǎng)絡(luò)工具箱在同步中的應(yīng)用有哪些?

2021-04-26 06:42:29

請(qǐng)問:我在用labview做BP神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)故障診斷,在NI官網(wǎng)找到了機(jī)器學(xué)習(xí)工具包(MLT),但是里面沒有關(guān)于這部分VI的幫助文檔,對(duì)于”BP神經(jīng)網(wǎng)絡(luò)分類“這個(gè)范例有很多不懂的地方,比如

2017-02-22 16:08:08

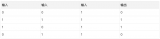

習(xí)神經(jīng)神經(jīng)網(wǎng)絡(luò),對(duì)于神經(jīng)網(wǎng)絡(luò)的實(shí)現(xiàn)是如何一直沒有具體實(shí)現(xiàn)一下:現(xiàn)看到一個(gè)簡(jiǎn)單的神經(jīng)網(wǎng)絡(luò)模型用于訓(xùn)練的輸入數(shù)據(jù):對(duì)應(yīng)的輸出數(shù)據(jù):我們這里設(shè)置:1:節(jié)點(diǎn)個(gè)數(shù)設(shè)置:輸入層、隱層、輸出層的節(jié)點(diǎn)

2021-08-18 07:25:21

`本篇主要介紹:人工神經(jīng)網(wǎng)絡(luò)的起源、簡(jiǎn)單神經(jīng)網(wǎng)絡(luò)模型、更多神經(jīng)網(wǎng)絡(luò)模型、機(jī)器學(xué)習(xí)的步驟:訓(xùn)練與預(yù)測(cè)、訓(xùn)練的兩階段:正向推演與反向傳播、以TensorFlow + Excel表達(dá)訓(xùn)練流程以及AI普及化教育之路。`

2020-11-05 17:48:39

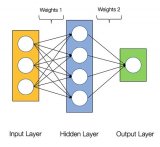

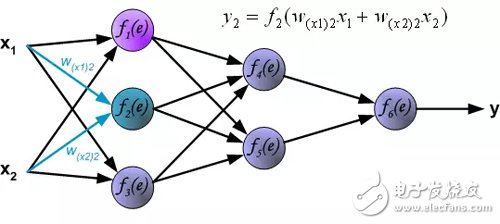

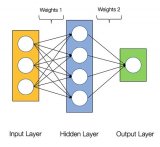

神經(jīng)網(wǎng)絡(luò)的計(jì)算。對(duì)于多層多節(jié)點(diǎn)的神經(jīng)網(wǎng)絡(luò),我們可以使用矩陣乘法來表示。在上面的神經(jīng)網(wǎng)絡(luò)中,我們將權(quán)重作為一個(gè)矩陣,將第一層的輸入作為另一個(gè)矩陣,兩個(gè)矩陣相乘,得到的矩陣恰好為第二層的輸入。對(duì)于python

2019-03-03 22:10:19

今天學(xué)習(xí)了兩個(gè)神經(jīng)網(wǎng)絡(luò),分別是自適應(yīng)諧振(ART)神經(jīng)網(wǎng)絡(luò)與自組織映射(SOM)神經(jīng)網(wǎng)絡(luò)。整體感覺不是很難,只不過一些最基礎(chǔ)的概念容易理解不清。首先ART神經(jīng)網(wǎng)絡(luò)是競(jìng)爭(zhēng)學(xué)習(xí)的一個(gè)代表,競(jìng)爭(zhēng)型學(xué)習(xí)

2019-07-21 04:30:00

傳播的,不會(huì)回流),區(qū)別于循環(huán)神經(jīng)網(wǎng)絡(luò)RNN。BP算法(Back Propagation):誤差反向傳播算法,用于更新網(wǎng)絡(luò)中的權(quán)重。BP神經(jīng)網(wǎng)絡(luò)思想:表面上:1. 數(shù)據(jù)信息的前向傳播,從輸入層到隱含層

2019-07-21 04:00:00

人工神經(jīng)網(wǎng)絡(luò)是根據(jù)人的認(rèn)識(shí)過程而開發(fā)出的一種算法。假如我們現(xiàn)在只有一些輸入和相應(yīng)的輸出,而對(duì)如何由輸入得到輸出的機(jī)理并不清楚,那么我們可以把輸入與輸出之間的未知過程看成是一個(gè)“網(wǎng)絡(luò)”,通過不斷地給

2008-06-19 14:40:42

人工神經(jīng)網(wǎng)絡(luò)(Artificial Neural Network,ANN)是一種類似生物神經(jīng)網(wǎng)絡(luò)的信息處理結(jié)構(gòu),它的提出是為了解決一些非線性,非平穩(wěn),復(fù)雜的實(shí)際問題。那有哪些辦法能實(shí)現(xiàn)人工神經(jīng)網(wǎng)絡(luò)呢?

2019-08-01 08:06:21

人工神經(jīng)網(wǎng)絡(luò)課件

2016-06-19 10:15:48

簡(jiǎn)單理解LSTM神經(jīng)網(wǎng)絡(luò)

2021-01-28 07:16:57

圖卷積神經(jīng)網(wǎng)絡(luò)

2019-08-20 12:05:29

優(yōu)化神經(jīng)網(wǎng)絡(luò)訓(xùn)練方法有哪些?

2022-09-06 09:52:36

全連接神經(jīng)網(wǎng)絡(luò)和卷積神經(jīng)網(wǎng)絡(luò)的區(qū)別

2019-06-06 14:21:42

以前的神經(jīng)網(wǎng)絡(luò)幾乎都是部署在云端(服務(wù)器上),設(shè)備端采集到數(shù)據(jù)通過網(wǎng)絡(luò)發(fā)送給服務(wù)器做inference(推理),結(jié)果再通過網(wǎng)絡(luò)返回給設(shè)備端。如今越來越多的神經(jīng)網(wǎng)絡(luò)部署在嵌入式設(shè)備端上,即

2021-12-23 06:16:40

卷積神經(jīng)網(wǎng)絡(luò)為什么適合圖像處理?

2022-09-08 10:23:10

卷積神經(jīng)網(wǎng)絡(luò)(CNN)究竟是什么,鑒于神經(jīng)網(wǎng)絡(luò)在工程上經(jīng)歷了曲折的歷史,您為什么還會(huì)在意它呢? 對(duì)于這些非常中肯的問題,我們似乎可以給出相對(duì)簡(jiǎn)明的答案。

2019-07-17 07:21:50

陷入了近二十年的停滯。1986 年到 1988 年是神經(jīng)網(wǎng)絡(luò)模型發(fā)展的第二階段,稱為第二 代神經(jīng)網(wǎng)絡(luò)模型。1986 年 Rumelhart 等人提出了誤 差反向傳播算法(back

2022-08-02 10:39:39

卷積神經(jīng)網(wǎng)絡(luò)的優(yōu)點(diǎn)

2020-05-05 18:12:50

卷積神經(jīng)網(wǎng)絡(luò)的層級(jí)結(jié)構(gòu) 卷積神經(jīng)網(wǎng)絡(luò)的常用框架

2020-12-29 06:16:44

什么是卷積神經(jīng)網(wǎng)絡(luò)?ImageNet-2010網(wǎng)絡(luò)結(jié)構(gòu)是如何構(gòu)成的?有哪些基本參數(shù)?

2021-06-17 11:48:22

反饋神經(jīng)網(wǎng)絡(luò)算法

2020-04-28 08:36:58

為提升識(shí)別準(zhǔn)確率,采用改進(jìn)神經(jīng)網(wǎng)絡(luò),通過Mnist數(shù)據(jù)集進(jìn)行訓(xùn)練。整體處理過程分為兩步:圖像預(yù)處理和改進(jìn)神經(jīng)網(wǎng)絡(luò)推理。圖像預(yù)處理主要根據(jù)圖像的特征,將數(shù)據(jù)處理成規(guī)范的格式,而改進(jìn)神經(jīng)網(wǎng)絡(luò)推理主要用于輸出結(jié)果。 整個(gè)過程分為兩個(gè)步驟:圖像預(yù)處理和神經(jīng)網(wǎng)絡(luò)推理。需要提前安裝Tengine框架,

2021-12-23 08:07:33

最近在學(xué)習(xí)電機(jī)的智能控制,上周學(xué)習(xí)了基于單神經(jīng)元的PID控制,這周研究基于BP神經(jīng)網(wǎng)絡(luò)的PID控制。神經(jīng)網(wǎng)絡(luò)具有任意非線性表達(dá)能力,可以通過對(duì)系統(tǒng)性能的學(xué)習(xí)來實(shí)現(xiàn)具有最佳組合的PID控制。利用BP

2021-09-07 07:43:47

網(wǎng)絡(luò)。 BP 網(wǎng)絡(luò)的學(xué)習(xí)規(guī)則是使用最速下降法,通過反向傳播來不斷調(diào)整網(wǎng)絡(luò)的權(quán)值和閾值,使網(wǎng)絡(luò)的誤差平方和最小。 3 BP 算法 BP 神經(jīng)網(wǎng)絡(luò)是一種前向傳播的多層網(wǎng)絡(luò),網(wǎng)絡(luò)除了輸入節(jié)點(diǎn)以外,還有

2018-11-13 16:04:45

基于BP神經(jīng)網(wǎng)絡(luò)的辨識(shí)

2018-01-04 13:37:27

FPGA實(shí)現(xiàn)神經(jīng)網(wǎng)絡(luò)關(guān)鍵問題分析基于FPGA的ANN實(shí)現(xiàn)方法基于FPGA的神經(jīng)網(wǎng)絡(luò)的性能評(píng)估及局限性

2021-04-30 06:58:13

基于RBF神經(jīng)網(wǎng)絡(luò)的辨識(shí)

2018-01-04 13:38:52

本文介紹了如何使用Keras框架,搭建一個(gè)小型的神經(jīng)網(wǎng)絡(luò)-多層感知器,并通過給定數(shù)據(jù)進(jìn)行計(jì)算訓(xùn)練,最好將訓(xùn)練得到的模型提取出參數(shù),放在51單片機(jī)上進(jìn)行運(yùn)行。

2021-11-22 07:00:41

如何用stm32cube.ai簡(jiǎn)化人工神經(jīng)網(wǎng)絡(luò)映射?如何使用stm32cube.ai部署神經(jīng)網(wǎng)絡(luò)?

2021-10-11 08:05:42

原文鏈接:http://tecdat.cn/?p=5725 神經(jīng)網(wǎng)絡(luò)是一種基于現(xiàn)有數(shù)據(jù)創(chuàng)建預(yù)測(cè)的計(jì)算系統(tǒng)。如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?神經(jīng)網(wǎng)絡(luò)包括:輸入層:根據(jù)現(xiàn)有數(shù)據(jù)獲取輸入的層隱藏層:使用反向傳播優(yōu)化輸入變量權(quán)重的層,以提高模型的預(yù)測(cè)能力輸出層:基于輸入和隱藏層的數(shù)據(jù)輸出預(yù)測(cè)

2021-07-12 08:02:11

,并能在腦海中重現(xiàn)這些圖像信息,這不僅與人腦的海量信息存儲(chǔ)能力有關(guān),還與人腦的信息處理能力,包括數(shù)據(jù)壓縮能力有關(guān)。在各種神經(jīng)網(wǎng)絡(luò)中,多層前饋神經(jīng)網(wǎng)絡(luò)具有很強(qiáng)的信息處理能力,由于其采用BP算法,因此也

2019-08-08 06:11:30

譯者|VincentLee來源 |曉飛的算法工程筆記脈沖神經(jīng)網(wǎng)絡(luò)(Spiking neural network, SNN)將脈沖神經(jīng)元作為計(jì)算單...

2021-07-26 06:23:59

有提供編寫神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)程序服務(wù)的嗎?

2011-12-10 13:50:46

吳恩達(dá)機(jī)器學(xué)習(xí)筆記之神經(jīng)網(wǎng)絡(luò)參數(shù)的反向傳播算法

2019-05-22 15:11:21

求助地震波神經(jīng)網(wǎng)絡(luò)程序,共同交流!!

2013-05-11 08:14:19

小女子做基于labview的蒸發(fā)過程中液位的控制,想使用神經(jīng)網(wǎng)絡(luò)pid控制,請(qǐng)問這個(gè)控制方法可以嗎?有誰會(huì)神經(jīng)網(wǎng)絡(luò)pid控制么。。。叩謝

2016-09-23 13:43:16

求助大神 小的現(xiàn)在有個(gè)難題: 一組車重實(shí)時(shí)數(shù)據(jù) 對(duì)應(yīng)一個(gè)車重的最終數(shù)值(一個(gè)一維數(shù)組輸入對(duì)應(yīng)輸出一個(gè)數(shù)值) 這其中可能經(jīng)過均值、方差、去掉N個(gè)最大值、、、等等的計(jì)算 我的目的就是弄清楚這個(gè)中間計(jì)算過程 最近實(shí)在想不出什么好辦法就打算試試神經(jīng)網(wǎng)絡(luò) 請(qǐng)教大神用什么神經(jīng)網(wǎng)絡(luò)好求神經(jīng)網(wǎng)絡(luò)程序

2016-07-14 13:35:44

求高手,基于labview的BP神經(jīng)網(wǎng)絡(luò)算法的實(shí)現(xiàn)過程,最好有程序哈,謝謝!!

2012-12-10 14:55:50

多層感知機(jī) 深度神經(jīng)網(wǎng)絡(luò)in collaboration with Hsu Chung Chuan, Lin Min Htoo, and Quah Jia Yong. 與許忠傳,林敏濤和華佳勇合作

2021-07-12 06:35:22

最簡(jiǎn)單的神經(jīng)網(wǎng)絡(luò)

2019-09-11 11:57:36

脈沖耦合神經(jīng)網(wǎng)絡(luò)(PCNN)在FPGA上的實(shí)現(xiàn),實(shí)現(xiàn)數(shù)據(jù)分類功能,有報(bào)酬。QQ470345140.

2013-08-25 09:57:14

我在matlab中訓(xùn)練好了一個(gè)神經(jīng)網(wǎng)絡(luò)模型,想在labview中調(diào)用,請(qǐng)問應(yīng)該怎么做呢?或者labview有自己的神經(jīng)網(wǎng)絡(luò)工具包嗎?

2018-07-05 17:32:32

為什么要用卷積神經(jīng)網(wǎng)絡(luò)?

2020-06-13 13:11:39

`將非局部計(jì)算作為獲取長(zhǎng)時(shí)記憶的通用模塊,提高神經(jīng)網(wǎng)絡(luò)性能在深度神經(jīng)網(wǎng)絡(luò)中,獲取長(zhǎng)時(shí)記憶(long-range dependency)至關(guān)重要。對(duì)于序列數(shù)據(jù)(例如語(yǔ)音、語(yǔ)言),遞歸運(yùn)算

2018-11-12 14:52:50

為了提高胸癌識(shí)別的識(shí)別精度,提出了應(yīng)用反向傳播網(wǎng)絡(luò)(Back Propagation, BP)建立胸癌診斷。BP 網(wǎng)絡(luò)是一種典型的多層前饋型神經(jīng)網(wǎng)絡(luò),采用有監(jiān)督學(xué)習(xí)模式,利用均方誤差和梯

2010-01-20 16:02:24 21

21 本文給出了利用現(xiàn)場(chǎng)可編程門陣列來實(shí)現(xiàn)多層前向神經(jīng)網(wǎng)絡(luò)(反向傳播-BP 網(wǎng)絡(luò))的方法。首先利用了相關(guān)軟件在理論上作了算法上的仿真,在此基礎(chǔ)上構(gòu)建了前向神經(jīng)網(wǎng)絡(luò)的硬

2010-01-25 11:56:13 6

6 為了減少傳統(tǒng)數(shù)值分析法由于厚度諧振而引起的結(jié)果錯(cuò)誤問題,實(shí)現(xiàn)異向介質(zhì)高分析精度與高效率的共存,建立基于反向傳播多層前饋型神經(jīng)網(wǎng)絡(luò)(BP 神經(jīng)網(wǎng)絡(luò))的異向介質(zhì)電磁特性與

2010-02-09 14:57:45 7

7 提出了一種基于前向?qū)ο?b class="flag-6" style="color: red">傳播神經(jīng)網(wǎng)絡(luò)的信息檢索算法。分析了信息檢索技術(shù)的基本概念、原理、以及檢索方式,研究了科技信息檢索的流程,研究了前向?qū)ο?b class="flag-6" style="color: red">傳播神經(jīng)網(wǎng)絡(luò)的基本模型

2012-10-17 11:19:53 31

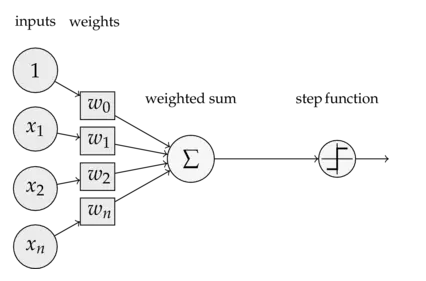

31 本文對(duì)多層感知器和反向傳播進(jìn)行入門級(jí)的介紹。人工神經(jīng)網(wǎng)絡(luò)是一種計(jì)算模型,啟發(fā)自人類大腦處理信息的生物神經(jīng)網(wǎng)絡(luò)。 人工神經(jīng)網(wǎng)絡(luò)是一種計(jì)算模型,啟發(fā)自人類大腦處理信息的生物神經(jīng)網(wǎng)絡(luò)。人工神經(jīng)網(wǎng)絡(luò)在語(yǔ)音識(shí)別、計(jì)算機(jī)視覺和文本處理領(lǐng)域取得了一系列突破,讓機(jī)器學(xué)習(xí)研究和產(chǎn)業(yè)感到了興奮。

2017-11-15 15:26:01 4070

4070 針對(duì)單輸入單輸出非線性系統(tǒng)的不確定性問題,提出了一種新型的基于擴(kuò)展反向傳播(BP)神經(jīng)網(wǎng)絡(luò)的自適應(yīng)控制方法。首先,采用離線數(shù)據(jù)來訓(xùn)練BP神經(jīng)網(wǎng)絡(luò)的權(quán)值向量;然后,通過在線調(diào)節(jié)伸縮因子和逼近精度估計(jì)值

2017-12-01 13:53:31 0

0 基于BP神經(jīng)網(wǎng)絡(luò)的辨識(shí),1986年,Rumelhart等提出了誤差反向傳播神經(jīng)網(wǎng)絡(luò),簡(jiǎn)稱BP網(wǎng)絡(luò)(Back Propagation),該網(wǎng)絡(luò)是一種單向傳播的多層前向網(wǎng)絡(luò)。

誤差反向傳播

2017-12-06 15:11:58 0

0 增益修改的卡爾曼濾波( MGEKF)算法在實(shí)際應(yīng)用時(shí),一般使用帶有誤差的測(cè)量值代替真實(shí)值進(jìn)行增益修正計(jì)算,導(dǎo)致修正結(jié)果也被誤差污染。針對(duì)這一問題,提出一種基于反向傳播神經(jīng)網(wǎng)絡(luò)( BPNN)改進(jìn)

2017-12-18 14:27:13 0

0 我們將純粹用SQL實(shí)現(xiàn)含有一個(gè)隱藏層(以及帶 ReLU 和 softmax 激活函數(shù))的神經(jīng)網(wǎng)絡(luò)。這些神經(jīng)網(wǎng)絡(luò)訓(xùn)練的步驟包含前向傳播和反向傳播,將在 BigQuery 的單個(gè)SQL查詢語(yǔ)句中實(shí)現(xiàn)

2018-05-15 17:48:00 978

978

和DeepMind數(shù)據(jù)科學(xué)家、Udacity深度學(xué)習(xí)導(dǎo)師Andrew Trask一起,基于Numpy手寫神經(jīng)網(wǎng)絡(luò),更深刻地理解反向傳播這一概念。

2018-04-01 09:29:00 4760

4760

本文主要寫卷積神經(jīng)網(wǎng)絡(luò)如何進(jìn)行一次完整的訓(xùn)練,包括前向傳播和反向傳播,并自己手寫一個(gè)卷積神經(jīng)網(wǎng)絡(luò)。

2018-05-28 10:35:20 17482

17482

BP 神經(jīng)網(wǎng)絡(luò)是一類基于誤差逆向傳播 (BackPropagation, 簡(jiǎn)稱 BP) 算法的多層前饋神經(jīng)網(wǎng)絡(luò),BP算法是迄今最成功的神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)算法。現(xiàn)實(shí)任務(wù)中使用神經(jīng)網(wǎng)絡(luò)時(shí),大多是在使用 BP

2018-06-19 15:17:15 42819

42819

反向傳播算法(BP算法)是目前用來訓(xùn)練人工神經(jīng)網(wǎng)絡(luò)的最常用且最有效的算法。作為谷歌機(jī)器學(xué)習(xí)速成課程的配套材料,谷歌推出一個(gè)演示網(wǎng)站,直觀地介紹了反向傳播算法的工作原理。

2018-07-02 16:01:10 9665

9665

內(nèi)容將繼續(xù)秉承之前 DNN 的學(xué)習(xí)路線,在利用Tensorflow搭建神經(jīng)網(wǎng)絡(luò)之前,先嘗試?yán)胣umpy手動(dòng)搭建卷積神經(jīng)網(wǎng)絡(luò),以期對(duì)卷積神經(jīng)網(wǎng)絡(luò)的卷積機(jī)制、前向傳播和反向傳播的原理和過程有更深刻的理解。

2018-10-20 10:55:55 5799

5799 降低了網(wǎng)絡(luò)需要訓(xùn)練的數(shù)量級(jí)。本文以MINST手寫體數(shù)據(jù)庫(kù)為訓(xùn)練樣本,討論卷積神經(jīng)網(wǎng)絡(luò)的權(quán)值反向傳播機(jī)制和MATLAB的實(shí)現(xiàn)方法;對(duì)激活函數(shù)tanh和relu梯度消失問題進(jìn)行分析和優(yōu)化,對(duì)改進(jìn)后的激活函數(shù)進(jìn)行訓(xùn)練,得出最優(yōu)的修正參數(shù)

2018-12-06 15:29:48 14

14 Dropout是在《ImageNet Classification with Deep Convolutional》這篇論文里提出來為了防止神經(jīng)網(wǎng)絡(luò)的過擬合。它的主要思想是讓隱藏層的節(jié)點(diǎn)在每次迭代時(shí)(包括正向和反向傳播)有一定幾率(keep-prob)失效。

2020-01-28 17:44:00 21242

21242 BP神經(jīng)網(wǎng)絡(luò)是一種多層的前饋神經(jīng)網(wǎng)絡(luò),其主要的特點(diǎn)是:信號(hào)是前向傳播的,而誤差是反向傳播的。具體來說,對(duì)于如下的只含一個(gè)隱層的神經(jīng)網(wǎng)絡(luò)模型:輸入向量應(yīng)為n個(gè)特征

2020-09-24 11:51:35 12811

12811

專欄中《零神經(jīng)網(wǎng)絡(luò)實(shí)戰(zhàn)》系列持續(xù)更新介紹神經(jīng)元怎么工作,最后使用python從0到1不調(diào)用任何依賴神經(jīng)網(wǎng)絡(luò)框架(不使用tensorflow等框架)...

2020-12-10 19:27:06 595

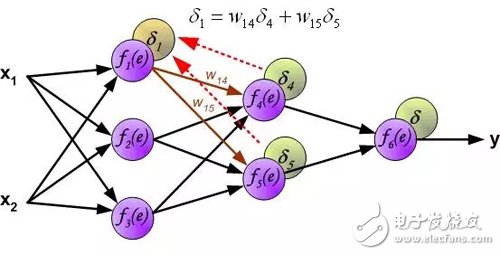

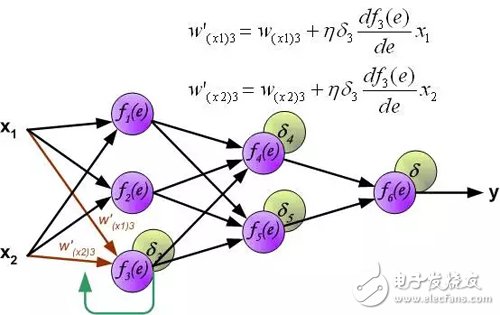

595 在 深度神經(jīng)網(wǎng)絡(luò)(DNN)模型與前向傳播算法 中,我們對(duì)DNN的模型和前向傳播算法做了總結(jié),這里我們更進(jìn)一步,對(duì)DNN的反向傳播算法(Back Propagation,BP)做一個(gè)總結(jié)。 1. DNN反向傳播算法要解決的問題

2021-03-22 16:28:22 3110

3110

使用脈沖序列進(jìn)行數(shù)據(jù)處理的脈沖神經(jīng)網(wǎng)絡(luò)具有優(yōu)異的低功耗特性,但由于學(xué)習(xí)算法不成熟,多層網(wǎng)絡(luò)練存在收斂困難的問題。利用反向傳播網(wǎng)絡(luò)具有學(xué)習(xí)算法成熟和訓(xùn)練速度快的特點(diǎn),設(shè)計(jì)一種遷移學(xué)習(xí)算法。基于反向

2021-05-24 16:03:07 15

15 BP(BackPropagation)反向傳播神經(jīng)網(wǎng)絡(luò)介紹及公式推導(dǎo)(電源和地電氣安全間距)-該文檔為BP(BackPropagation)反向傳播神經(jīng)網(wǎng)絡(luò)介紹及公式推導(dǎo)詳述資料,講解的還不錯(cuò),感興趣的可以下載看看…………………………

2021-07-26 10:31:32 48

48 前面的一篇原理簡(jiǎn)述的文章中,給大家簡(jiǎn)單介紹了神經(jīng)網(wǎng)絡(luò)前(后)傳播的有向圖、反向傳播的計(jì)算和更新。這篇文章跟大家簡(jiǎn)單討論一下神經(jīng)...

2022-02-07 11:33:02 3

3 在介紹卷積神經(jīng)網(wǎng)絡(luò)之前,我們先回顧一下神經(jīng)網(wǎng)絡(luò)的基本知識(shí)。就目前而言,神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)算法的核心,我們所熟知的很多深度學(xué)習(xí)算法的背后其實(shí)都是神經(jīng)網(wǎng)絡(luò)。

2023-02-23 09:14:44 2256

2256 摘要:反向傳播指的是計(jì)算神經(jīng)網(wǎng)絡(luò)參數(shù)梯度的方法。

2023-03-14 11:07:10 589

589 在本文中,我們將了解深度神經(jīng)網(wǎng)絡(luò)的基礎(chǔ)知識(shí)和三個(gè)最流行神經(jīng)網(wǎng)絡(luò):多層神經(jīng)網(wǎng)絡(luò)(MLP),卷積神經(jīng)網(wǎng)絡(luò)(CNN)和遞歸神經(jīng)網(wǎng)絡(luò)(RNN)。

2023-05-15 14:19:18 1096

1096

在練習(xí)二中,手寫數(shù)字識(shí)別使用數(shù)值微分的方式實(shí)現(xiàn)了神經(jīng)網(wǎng)絡(luò),現(xiàn)在用誤差反向傳播法來實(shí)現(xiàn)。兩者的區(qū)別僅僅是使用不同方法求梯度。

2023-06-23 16:57:00 424

424 的卷積操作,將不同層次的特征進(jìn)行提取,從而通過反向傳播算法不斷優(yōu)化網(wǎng)絡(luò)權(quán)重,最終實(shí)現(xiàn)分類和預(yù)測(cè)等任務(wù)。 在本文中,我們將介紹如何使用Python實(shí)現(xiàn)卷積神經(jīng)網(wǎng)絡(luò),并詳細(xì)說明每一個(gè)步驟及其原理。 第一步:導(dǎo)入必要的庫(kù) 在開始編寫代碼前,我們需要先導(dǎo)入一些必要的Python庫(kù)。具體如

2023-08-21 16:41:35 615

615 深度神經(jīng)網(wǎng)絡(luò)是一種基于神經(jīng)網(wǎng)絡(luò)的機(jī)器學(xué)習(xí)算法,其主要特點(diǎn)是由多層神經(jīng)元構(gòu)成,可以根據(jù)數(shù)據(jù)自動(dòng)調(diào)整神經(jīng)元之間的權(quán)重,從而實(shí)現(xiàn)對(duì)大規(guī)模數(shù)據(jù)進(jìn)行預(yù)測(cè)和分類。卷積神經(jīng)網(wǎng)絡(luò)是深度神經(jīng)網(wǎng)絡(luò)的一種,主要應(yīng)用于圖像和視頻處理領(lǐng)域。

2023-08-21 17:07:36 1867

1867 ,其獨(dú)特的卷積結(jié)構(gòu)可以有效地提取圖像和音頻等信息的特征,以用于分類、識(shí)別等任務(wù)。本文將從卷積神經(jīng)網(wǎng)絡(luò)的基本結(jié)構(gòu)、前向傳播算法、反向傳播算法等方面探討其算法流程與模型工作流程,并介紹其在圖像分類、物體檢測(cè)和人臉識(shí)別等領(lǐng)域中的應(yīng)用。 一、卷積神經(jīng)網(wǎng)絡(luò)的基本結(jié)

2023-08-21 16:50:19 1316

1316 著重要作用。BP神經(jīng)網(wǎng)絡(luò)(Back Propagation Neural Network, BPNN)是人工神經(jīng)網(wǎng)絡(luò)中的一種常見的多層前饋神經(jīng)網(wǎng)絡(luò),

2023-08-22 16:45:18 2941

2941 科學(xué)神經(jīng)網(wǎng)絡(luò)模型使用隨機(jī)梯度下降進(jìn)行訓(xùn)練,模型權(quán)重使用反向傳播算法進(jìn)行更新。通過訓(xùn)練神經(jīng)網(wǎng)絡(luò)模型解決的優(yōu)化問題非常具有挑戰(zhàn)性,盡管這些算法在實(shí)踐中表現(xiàn)出色,但不能保證它們會(huì)及時(shí)收斂到一個(gè)良好的模型

2023-12-30 08:27:54 319

319

電子發(fā)燒友App

電子發(fā)燒友App

評(píng)論